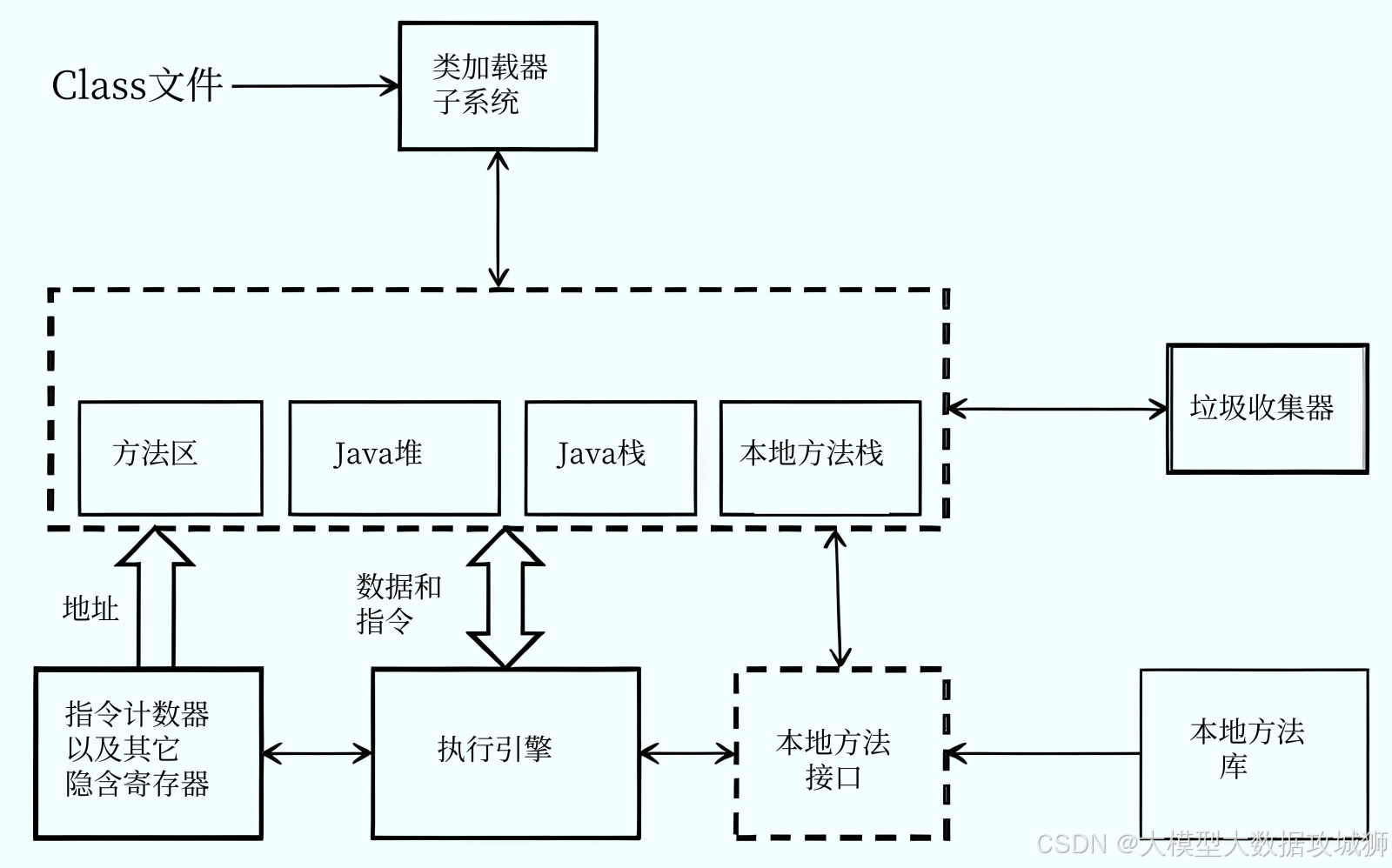

Java 中创建线程时,线程的内存是分配在 JVM 的哪个区域?为什么?

Java 中创建线程时,线程的内存分配在 JVM 的 线程私有区域(包括虚拟机栈、程序计数器、本地方法栈),而非线程共享区域(堆、方法区)。这一设计的核心原因是"保证线程执行的独立性和安全性"------每个线程需独立存储执行状态(如指令进度、局部变量),若共享会导致线程切换时数据冲突,无法正确恢复执行。

一、线程内存的分配区域:线程私有区域

根据《Java 虚拟机规范》,JVM 运行时数据区分为"线程私有"和"线程共享"两类,线程的内存仅存在于私有区域,具体包括以下三部分:

1. 虚拟机栈(VM Stack)

虚拟机栈是线程内存的核心区域,存储线程执行 Java 方法时的栈帧(Stack Frame),每个方法从调用到执行完成,对应一个栈帧的"入栈"和"出栈"。

-

栈帧的核心内容:

- 局部变量表:存储方法的局部变量(如

int a = 10中的a、对象引用User user),变量类型和数量在编译时确定,内存大小固定; - 操作数栈:用于方法执行过程中的临时数据运算(如

a + b时,先将a和b入栈,执行加法后将结果入栈); - 动态链接:将方法的"符号引用"(常量池中的类/方法引用)转换为"直接引用"(内存地址),确保方法能正确调用;

- 方法返回地址:记录方法执行完后,回到调用方的指令地址(如正常返回时指向调用方下一条指令,异常返回时指向异常处理代码)。

- 局部变量表:存储方法的局部变量(如

-

线程私有原因 :每个线程执行的方法不同,局部变量和执行状态独立(如线程 A 的

a=10与线程 B 的a=20无关联),若共享虚拟机栈,线程切换时局部变量会被覆盖,导致执行逻辑混乱。

2. 程序计数器(Program Counter Register)

程序计数器是一块极小的内存区域,存储当前线程执行的字节码指令地址(即"下一条要执行的指令偏移量"),相当于线程的"执行进度条"。

-

核心作用:

- 线程切换时,JVM 通过程序计数器恢复线程的执行进度(如线程 A 执行到指令 100,切换到线程 B 后,再次切回 A 时,从指令 100 继续执行);

- 若线程执行的是 Java 方法,计数器存储指令地址;若执行的是本地方法(

native修饰),计数器值为undefined(因本地方法由操作系统执行,无字节码指令)。

-

线程私有原因:每个线程的执行进度不同(如线程 A 执行到方法开头,线程 B 执行到方法中间),需独立的计数器记录,否则线程切换后无法恢复正确的执行位置。

3. 本地方法栈(Native Method Stack)

本地方法栈与虚拟机栈功能类似,区别是 服务于本地方法(如 System.currentTimeMillis()、Object.hashCode()),而非 Java 方法。

-

实现细节:

- 《Java 虚拟机规范》对本地方法栈的实现无强制要求,不同 JVM 可灵活设计;

- HotSpot 虚拟机(JDK 默认)将本地方法栈与虚拟机栈合并为同一块内存区域,统一管理,避免额外的内存开销。

-

线程私有原因:本地方法的执行状态(如参数、临时数据)需与 Java 方法隔离,且线程执行的本地方法不同,独立存储可避免数据冲突。

二、为什么不分配在线程共享区域?

线程共享区域(堆、方法区)存储的是"所有线程可访问的公共数据",若线程内存分配在此,会导致严重的执行问题,具体原因如下:

1. 堆(Heap):存储对象实例,而非线程执行状态

堆是 JVM 中最大的内存区域,用于存储 new 关键字创建的对象实例(如 User user = new User() 中的 new User())和数组。线程的执行状态(如局部变量、指令地址)与对象实例是"引用与被引用"的关系------线程栈中存储对象的引用(地址),对象本身存储在堆中。

- 若线程内存分配在堆:堆是共享区域,多个线程可修改同一数据,会导致线程安全问题(如线程 A 覆盖线程 B 的局部变量);且堆的 GC 会移动对象地址,若线程指令地址存储在堆,会导致地址失效,无法执行。

2. 方法区(元空间):存储类元数据,与线程执行无关

方法区(JDK 8 后为元空间)存储类的元数据信息(如类名、字段、方法描述)、常量池(如字符串常量 "hello")、静态变量(如 public static int count = 0)。这些数据是"类级别的公共信息",与线程的具体执行状态(如局部变量、指令进度)无关,无需分配线程内存。

三、关键细节与面试加分点

1. 线程内存的生命周期

线程私有区域的内存随线程创建而分配,随线程销毁而释放,无需垃圾回收(GC)------线程结束后,其虚拟机栈、程序计数器的内存会被 JVM 直接回收,避免内存泄漏。

2. HotSpot 虚拟机的特殊实现

HotSpot 合并了本地方法栈和虚拟机栈,统一使用 -Xss 参数配置大小(如 -Xss1MB 表示线程栈总大小为 1MB),简化内存管理;而其他 JVM(如 JRockit)可能将两者分开配置。

3. 线程内存与栈溢出的关系

线程内存不足会触发两种异常:

StackOverflowError:线程栈深度超过-Xss配置(如递归调用无终止条件,栈帧不断入栈);OutOfMemoryError:线程数过多,导致线程私有区域总内存超过系统分配给 JVM 的内存(如-Xss=1MB时,创建 10000 个线程需 10GB 内存,超过 JVM 可用内存)。

关键点

线程内存分配在 JVM 的线程私有区域(虚拟机栈、程序计数器、本地方法栈),核心是保证线程执行的独立性;线程共享区域(堆、方法区)存储公共数据,与线程执行状态无关,不适合分配线程内存。

记忆法

可总结为"线程内存私有藏,栈存帧来计数器忙,本地方法栈帮忙;共享堆区存对象,方法区里类元藏,独立执行不慌张",即线程内存的分配区域及与共享区域的区别。

Spring、Spring Boot、Spring Cloud 的区别是什么?请说明它们的核心细节和适用场景。

Spring、Spring Boot、Spring Cloud 是 Spring 生态中三个核心组件,三者定位不同:Spring 是基础框架,提供 IOC 和 AOP 核心能力;Spring Boot 是 Spring 的"简化工具",通过约定大于配置降低开发成本;Spring Cloud 是基于 Spring Boot 的"微服务治理框架",解决微服务架构的协作问题。三者并非替代关系,而是层层递进、互补的生态体系。

一、三者的核心细节

1. Spring:Java 应用的基础框架

Spring 诞生于 2003 年,核心目标是"解决企业级应用开发的复杂性",核心思想是 IOC(控制反转) 和 AOP(面向切面编程),通过解耦组件依赖和简化横向功能(如日志、事务),提升开发效率。

-

核心功能:

- IOC 容器:管理 Bean 的创建、依赖注入和生命周期(如

@Component标注 Bean,@Autowired注入依赖),避免硬编码依赖(如UserService service = new UserService()); - AOP 切面:将日志、事务、权限等横向功能抽象为"切面",通过

@Aspect标注,在不修改业务代码的情况下植入功能(如@Transactional实现事务管理); - 模块扩展:提供

spring-context(IOC 核心)、spring-orm(ORM 整合,如 MyBatis)、spring-web(Web 开发)等模块,支持多种应用场景。

- IOC 容器:管理 Bean 的创建、依赖注入和生命周期(如

-

配置方式 :早期依赖 XML 配置(如

applicationContext.xml),JDK 5 后支持注解配置(如@Configuration、@ComponentScan),但仍需手动配置 Bean 扫描、依赖引入等。

2. Spring Boot:Spring 的"简化开发工具"

Spring Boot 诞生于 2014 年,核心目标是"简化 Spring 应用的初始化和开发流程",基于"约定大于配置"的理念,减少 XML 配置和依赖管理的复杂度,让开发者"专注业务逻辑,而非框架配置"。

-

核心功能:

- 自动配置(Auto-Configuration):通过

@EnableAutoConfiguration注解,扫描META-INF/spring.factories中的自动配置类,根据依赖自动配置 Bean(如引入spring-boot-starter-web依赖,自动配置 Tomcat 容器、Spring MVC DispatcherServlet); - Starters 依赖:提供"场景化 Starter"(如

spring-boot-starter-web对应 Web 开发,spring-boot-starter-data-jpa对应 JPA 持久化),一键引入所需依赖,避免手动管理版本冲突; - 嵌入式容器:内置 Tomcat、Jetty、Undertow 等 Web 容器,应用可打包为 Jar 包(无需外部容器部署),通过

java -jar app.jar直接运行; - 生产就绪功能:内置健康检查(

/actuator/health)、指标监控(/actuator/metrics)、配置外部化(application.yml/properties)等功能,简化生产环境运维。

- 自动配置(Auto-Configuration):通过

-

与 Spring 的关系 :Spring Boot 是 Spring 的"超集",完全兼容 Spring 的所有功能,且底层依赖 Spring 核心模块(如

spring-context),仅在开发流程上做简化。

3. Spring Cloud:基于 Spring Boot 的微服务治理框架

Spring Cloud 是微服务架构的"全家桶",基于 Spring Boot 开发,核心目标是"解决微服务架构中的服务注册发现、配置管理、负载均衡、熔断降级等治理问题",将多个独立的 Spring Boot 应用(微服务)整合为可协作的系统。

-

核心组件(基于 Spring Cloud Alibaba 或 Spring Cloud Netflix):

- 服务注册与发现:Nacos/Eureka,微服务启动时自动注册到注册中心,其他服务通过服务名(如

order-service)而非 IP 地址调用; - 配置中心:Nacos/Spring Cloud Config,集中管理所有微服务的配置(避免每个服务本地配置),支持动态刷新配置;

- 负载均衡:Ribbon/LoadBalance,客户端侧负载均衡(如调用

order-service时,自动分发请求到多个实例); - 声明式服务调用:OpenFeign,基于 HTTP/REST 的声明式 API(如

@FeignClient("stock-service")调用库存服务),简化跨服务请求; - 熔断与降级:Sentinel/Hystrix,当服务不可用时(如超时、异常),触发熔断(避免级联故障)或返回默认值(降级);

- 网关:Spring Cloud Gateway,统一入口(路由请求到不同微服务),支持认证、限流、日志等全局功能。

- 服务注册与发现:Nacos/Eureka,微服务启动时自动注册到注册中心,其他服务通过服务名(如

-

与 Spring Boot 的关系:Spring Cloud 依赖 Spring Boot 作为"微服务的基础载体"------每个微服务都是一个 Spring Boot 应用,Spring Cloud 通过组件为这些应用提供治理能力,无法脱离 Spring Boot 单独使用。

二、三者的区别与适用场景对比

| 维度 | Spring | Spring Boot | Spring Cloud |

|---|---|---|---|

| 核心定位 | 基础框架(IOC/AOP) | 简化 Spring 开发的工具 | 微服务治理框架 |

| 核心思想 | 解耦依赖、面向切面 | 约定大于配置 | 微服务协作、分布式治理 |

| 依赖关系 | 无依赖(独立使用) | 依赖 Spring(超集) | 依赖 Spring Boot(微服务载体) |

| 配置复杂度 | 高(需手动配置 XML/注解) | 低(自动配置+Starter) | 中(需配置注册中心、网关等组件) |

| 适用场景 | 所有 Java 应用(单体/微服务) | 快速开发单体应用或微服务 | 微服务架构的分布式系统 |

| 典型案例 | 传统企业级单体应用(如 ERP) | 快速开发的 Web 应用(如博客系统) | 电商系统(订单、库存、用户微服务) |

三、关键点与面试加分点

- 生态关系:三者是"基础→简化→扩展"的关系------Spring 是基础,Spring Boot 简化 Spring 开发,Spring Cloud 基于 Spring Boot 扩展微服务治理;

- 加分点 :能说明 Spring Boot 自动配置的原理(

@SpringBootApplication包含@EnableAutoConfiguration,扫描spring.factories中的自动配置类),对比 Spring Cloud 不同组件的选型(如 Nacos 替代 Eureka,Sentinel 替代 Hystrix),解释微服务为何依赖 Spring Boot(嵌入式容器、简化配置适合独立部署)。

记忆法

可总结为"Spring 基础 IOC 强,Boot 简化配容器,Cloud 微服用 Boot 装;单体用 Boot 快,微服用 Cloud 管,基础全靠 Spring 扛",即三者的核心定位和适用场景。

Spring Boot 和 Spring 的区别是什么?Spring Boot 的核心优势有哪些?

Spring Boot 是 Spring 生态的"简化工具",二者并非替代关系------Spring 是提供 IOC/AOP 核心能力的基础框架,配置复杂但灵活;Spring Boot 是 Spring 的超集,通过"约定大于配置"简化开发流程,兼容 Spring 所有功能。二者的区别集中在"配置方式、依赖管理、部署方式、开发效率"四个维度,Spring Boot 的核心优势也围绕"简化"展开。

一、Spring Boot 和 Spring 的区别

1. 配置方式:从"手动配置"到"自动配置+约定"

Spring 的配置依赖"显式声明",需手动定义 Bean 扫描、组件依赖、框架集成等配置,复杂度高;Spring Boot 基于"约定大于配置",通过自动配置减少手动操作。

-

Spring 配置:

-

早期依赖 XML 配置(如

applicationContext.xml),需手动扫描包、注册 Bean:<!-- Spring XML 配置 --> <context:component-scan base-package="com.example.service"/> <bean id="userService" class="com.example.service.UserService"/> <bean id="userDao" class="com.example.dao.UserDao"/> -

JDK 5 后支持注解配置(如

@Configuration),但仍需手动开启功能(如@EnableWebMvc开启 Spring MVC):// Spring 注解配置 @Configuration @ComponentScan("com.example") @EnableWebMvc // 手动开启 Spring MVC public class AppConfig { @Bean public UserDao userDao() { return new UserDao(); } }

-

-

Spring Boot 配置:

-

无需 XML 或

@Configuration手动配置,仅需一个核心注解@SpringBootApplication,该注解包含:@SpringBootConfiguration:替代@Configuration,标记配置类;@ComponentScan:默认扫描当前包及其子包的 Bean(无需指定 base-package);@EnableAutoConfiguration:开启自动配置,根据依赖自动注册 Bean(如引入spring-boot-starter-web,自动配置 Tomcat、Spring MVC);

-

示例(Spring Boot 启动类):

@SpringBootApplication public class SpringBootApp { public static void main(String[] args) { SpringApplication.run(SpringBootApp.class, args); } }

-

2. 依赖管理:从"手动引入"到"Starter 一键集成"

Spring 需手动引入所有依赖(如 Spring MVC、Tomcat、MyBatis),且需手动管理版本兼容性(如 Spring 5 需搭配 Spring MVC 5,避免版本冲突);Spring Boot 通过"Starter 依赖"简化管理。

-

Spring 依赖管理(Maven 示例):

<!-- 手动引入 Spring 核心、Spring MVC、Tomcat 依赖,需匹配版本 --> <dependency> <groupId>org.springframework</groupId> <artifactId>spring-context</artifactId> <version>5.3.20</version> </dependency> <dependency> <groupId>org.springframework</groupId> <artifactId>spring-webmvc</artifactId> <version>5.3.20</version> </dependency> <dependency> <groupId>org.apache.tomcat.embed</groupId> <artifactId>tomcat-embed-core</artifactId> <version>9.0.62</version> </dependency> -

Spring Boot 依赖管理(Maven 示例):

<!-- 父工程继承 Spring Boot 版本管理,无需手动指定版本 --> <parent> <groupId>org.springframework.boot</groupId> <artifactId>spring-boot-starter-parent</artifactId> <version>2.7.0</version> </parent> <!-- 引入 Web 场景 Starter,自动包含 Spring MVC、Tomcat 等依赖 --> <dependency> <groupId>org.springframework.boot</groupId> <artifactId>spring-boot-starter-web</artifactId> </dependency>Spring Boot 父工程已定义所有依赖的兼容版本,引入 Starter 后无需关心版本,避免冲突。

3. 部署方式:从"外部容器"到"嵌入式容器+Jar 包"

Spring 应用需打包为 War 包,部署到外部 Web 容器(如 Tomcat、Jetty);Spring Boot 内置嵌入式容器,应用可打包为 Jar 包,直接通过命令运行,简化部署流程。

-

Spring 部署:

- 打包为 War 包(需配置

pom.xml为war类型); - 将 War 包放入 Tomcat 的

webapps目录; - 启动 Tomcat,访问

http://localhost:8080/应用名。

- 打包为 War 包(需配置

-

Spring Boot 部署:

- 打包为 Jar 包(默认类型,无需额外配置);

- 执行命令

java -jar app.jar启动应用; - 直接访问

http://localhost:8080(无需应用名,默认端口 8080)。

4. 开发效率:从"关注框架配置"到"关注业务逻辑"

Spring 开发需花费大量时间处理框架配置(如 XML 编写、依赖版本匹配);Spring Boot 通过自动配置、Starter 依赖、嵌入式容器,将开发重心转移到业务逻辑,大幅提升效率。

-

示例:开发一个简单的 Web 接口 :

-

Spring:需配置

DispatcherServlet、HandlerMapping、ViewResolver等,再编写 Controller; -

Spring Boot:仅需引入

spring-boot-starter-web,编写 Controller 即可:@RestController public class HelloController { @GetMapping("/hello") public String hello() { return "Hello Spring Boot!"; } }

启动应用后,访问

http://localhost:8080/hello即可返回结果,无需额外配置。 -

二、Spring Boot 的核心优势

1. 自动配置:减少 80% 的手动配置

Spring Boot 的自动配置基于"条件注解"(如 @ConditionalOnClass、@ConditionalOnMissingBean),仅在满足条件时(如引入某依赖、无自定义 Bean)才自动配置组件。例如:

- 引入

spring-boot-starter-data-jpa依赖时,自动配置EntityManagerFactory、JpaTransactionManager; - 若用户自定义了

DataSourceBean,自动配置的默认DataSource会失效(优先使用用户配置)。

2. Starter 依赖:一键集成场景化功能

Spring Boot 提供数十种 Starter 依赖,覆盖 Web 开发、数据持久化、缓存、消息队列等场景。

Feign 的底层原理是什么?

Feign 是 Spring Cloud 生态中基于 REST 的声明式 HTTP 客户端 ,核心作用是简化微服务间的跨服务调用(无需手动拼接 URL、处理 HTTP 请求)。其底层依赖 JDK 动态代理 和 HTTP 客户端(如 OkHttp、Apache HttpClient),通过注解解析、请求模板生成、负载均衡集成等步骤,实现"接口定义即调用"的便捷性。

一、Feign 核心工作流程

Feign 的工作流程可分为"启动初始化"和"运行时调用"两个阶段,每个阶段包含多个关键步骤:

1. 启动时:注解解析与代理类生成

Feign 的核心初始化逻辑由 @EnableFeignClients 注解触发,主要完成"扫描 Feign 客户端接口"和"生成动态代理类":

-

步骤1:扫描 @FeignClient 接口 项目启动时,

@EnableFeignClients注解会触发FeignClientScanner扫描指定包(默认扫描启动类所在包及其子包)中所有被@FeignClient标注的接口(如UserFeignClient)。示例:// 被@FeignClient标注的Feign客户端接口 @FeignClient(name = "user-service") // name指定调用的微服务名 public interface UserFeignClient { // 声明REST接口,对应user-service的/users/{id}接口 @GetMapping("/users/{id}") User getUserById(@PathVariable("id") Long id); } -

步骤2:解析接口元数据 扫描到

@FeignClient接口后,Feign 会解析接口中的注解信息:- 从

@FeignClient中获取目标微服务名(name = "user-service")、 fallback 降级类等; - 从方法注解(

@GetMapping/@PostMapping)中获取 HTTP 方法、请求路径(/users/{id}); - 从参数注解(

@PathVariable/@RequestParam)中获取参数名、参数位置,生成"请求模板"(包含 URL 模板、HTTP 方法、参数占位符)。

- 从

-

步骤3:生成动态代理类 Feign 利用 JDK 动态代理 为每个

@FeignClient接口生成代理类(FeignInvocationHandler为代理类的调用处理器),并将代理类注册到 Spring 容器中。后续业务代码注入UserFeignClient时,实际注入的是该动态代理类,而非接口本身。

2. 运行时:代理类调用与 HTTP 请求执行

当业务代码调用 UserFeignClient.getUserById(1L) 时,实际触发动态代理类的 invoke() 方法,执行 HTTP 请求:

-

步骤1:代理类拦截调用 代理类的

FeignInvocationHandler.invoke()方法拦截接口调用,根据当前调用的方法(getUserById),从初始化阶段缓存的"请求模板"中取出对应的 HTTP 元数据(路径、方法、参数)。 -

**步骤2:拼接完整请求 URL(结合服务发现)**Feign 集成了 Spring Cloud LoadBalancer(或早期的 Ribbon),通过"服务名"获取目标微服务的真实 IP 和端口:

- 向注册中心(如 Nacos/Eureka)查询

user-service的所有可用实例列表; - 基于负载均衡策略(如轮询、随机、加权)选择一个实例(如

192.168.1.100:8080); - 将服务名替换为真实 IP+端口,拼接完整请求 URL(如

http://192.168.1.100:8080/users/1)。

- 向注册中心(如 Nacos/Eureka)查询

-

步骤3:构造 HTTP 请求并发送 Feign 通过内置的 HTTP 客户端(默认是 Spring 的

SimpleClientHttpRequestFactory,可替换为 OkHttp、Apache HttpClient)构造 HTTP 请求:- 将方法参数(如

id=1)填充到 URL 占位符或请求体中; - 设置请求头(如

Content-Type: application/json); - 发送 HTTP 请求到目标微服务实例。

- 将方法参数(如

-

步骤4:响应处理与结果转换 接收目标微服务的 HTTP 响应后,Feign 通过

Decoder(解码器,默认是SpringDecoder)将响应体(如 JSON 字符串)转换为接口方法的返回类型(如User对象),并返回给业务代码。若请求失败(如服务不可用),则触发 fallback 降级逻辑(若配置了fallback属性)。

二、Feign 核心组件

Feign 的灵活性依赖于多个可扩展组件,核心组件如下:

| 组件 | 作用 |

|---|---|

| Contract | 注解解析契约,默认支持 Spring MVC 注解(如 @GetMapping),可自定义支持其他注解 |

| Target | 封装 @FeignClient 接口的元数据(服务名、接口类) |

| FeignClientFactoryBean | 生成 Feign 代理类的工厂 bean,负责初始化 Feign 客户端 |

| FeignInvocationHandler | 动态代理的调用处理器,负责拦截接口调用并执行 HTTP 请求 |

| Encoder/Decoder | 编码器(将请求参数转为 HTTP 请求体)和解码器(将响应体转为返回对象) |

| LoadBalancerClient | 负载均衡客户端,集成 Spring Cloud LoadBalancer/Ribbon 实现服务选择 |

三、面试加分点与记忆法

-

加分点:

- 可说明 Feign 与 OpenFeign 的关系(OpenFeign 是 Spring Cloud 对 Feign 的增强,默认集成了 Spring MVC 注解支持,无需额外配置

Contract); - 解释 Feign 的降级实现(通过

@FeignClient(fallback = UserFeignFallback.class)指定降级类,底层依赖 Hystrix 或 Sentinel); - 提及 Feign 的性能优化(替换为 OkHttp 客户端、开启连接池、配置超时时间)。

- 可说明 Feign 与 OpenFeign 的关系(OpenFeign 是 Spring Cloud 对 Feign 的增强,默认集成了 Spring MVC 注解支持,无需额外配置

-

记忆法:可总结为"启动扫注解,代理动态造;调用拦请求,服务发现找;HTTP 发请求,响应转目标",即 Feign 从初始化到调用的核心流程。

RPC 如何实现服务注册与发现?如何实现负载均衡?

RPC(Remote Procedure Call,远程过程调用)是微服务架构中跨服务通信的核心技术,其"服务注册与发现"解决"如何找到目标服务"的问题,"负载均衡"解决"如何选择目标服务实例"的问题。两者结合确保 RPC 调用的可用性和高效性,常见实现依赖注册中心、客户端/服务端负载均衡组件。

一、RPC 服务注册与发现的实现原理

服务注册与发现的核心是通过 注册中心 维护"服务名-服务实例列表"的映射关系,实现服务提供者与消费者的解耦(消费者无需硬编码提供者的 IP 和端口)。整体流程分为"服务注册""服务心跳""服务发现""服务下线"四个步骤:

1. 核心角色

- 服务提供者(Provider):提供 RPC 服务的应用,如"用户服务"实例;

- 服务消费者(Consumer):调用 RPC 服务的应用,如"订单服务";

- 注册中心(Registry):维护服务注册表的中间组件,如 Zookeeper、Nacos、Eureka、Consul。

2. 实现流程

-

步骤1:服务注册(Provider 向 Registry 注册) 服务提供者启动时,读取自身配置(服务名、IP、端口、协议如 Dubbo/GRPC),通过 RPC 框架的注册接口向注册中心提交注册信息。注册中心将信息存入"服务注册表"(结构通常为

Map<String, List<ServiceInstance>>,key 是服务名,value 是该服务的所有实例列表)。示例:用户服务(服务名user-service)的一个实例(IP192.168.1.100,端口20880)注册后,注册表中user-service对应的列表会新增该实例。 -

**步骤2:服务心跳(Provider 维持在线状态)**注册中心为避免"服务实例已下线但注册表未更新"的问题,要求服务提供者定期发送"心跳包"(如每隔 30 秒)。若注册中心超过指定时间(如 90 秒)未收到某个实例的心跳,会将该实例标记为"下线",并从服务注册表中移除,确保注册表的准确性。

-

步骤3:服务发现(Consumer 从 Registry 获取实例列表) 服务消费者启动时,向注册中心订阅所需的服务(如订阅

user-service):- 注册中心将当前

user-service的所有可用实例列表推送给消费者; - 消费者本地缓存该实例列表(避免每次调用都查询注册中心,减少网络开销);

- 若服务实例列表发生变化(如新增/下线实例),注册中心通过"推送机制"(如 Zookeeper 的 Watcher、Nacos 的订阅回调)主动通知消费者,更新本地缓存。

- 注册中心将当前

-

**步骤4:服务下线(Provider 主动注销或被动清理)**服务提供者正常关闭时,会主动向注册中心发送"注销请求",注册中心删除该实例的注册信息并通知所有订阅者;若提供者异常崩溃(如宕机),注册中心通过心跳超时被动清理该实例,确保消费者不会调用无效实例。

3. 常见注册中心对比

| 注册中心 | 核心特点 | 适用场景 |

|---|---|---|

| Zookeeper | 基于 ZAB 协议保证一致性,支持 Watcher 机制(主动推送),适合强一致性场景 | Dubbo 生态、分布式系统强一致需求 |

| Nacos | 支持 AP/CP 双模式(默认 AP,适合高可用;CP 适合强一致),自带配置中心功能 | Spring Cloud Alibaba 生态、混合云场景 |

| Eureka | 基于 AP 设计(优先保证可用性),支持自我保护机制(网络波动时不轻易下线实例) | Spring Cloud Netflix 生态、微服务高可用需求 |

| Consul | 支持服务发现、配置中心、分段部署,基于 Raft 协议保证一致性 | 跨数据中心、多区域部署场景 |

二、RPC 负载均衡的实现原理

负载均衡的核心是"从服务实例列表中选择一个实例接收请求",避免单个实例过载,提升服务整体吞吐量。RPC 中负载均衡分为 客户端负载均衡 和 服务端负载均衡 两种实现方式,前者更常用(如 Dubbo、Spring Cloud 均默认客户端负载均衡)。

1. 客户端负载均衡(Consumer 侧实现)

-

原理:服务消费者本地缓存服务实例列表,调用 RPC 前,通过负载均衡算法从本地列表中选择一个实例,直接向该实例发送请求(无需经过中间代理)。

-

核心优势:减少网络跳转(消费者直接调用提供者),降低中间代理的压力,适合高并发场景。

-

常见负载均衡算法:

- 轮询(Round Robin):按实例列表顺序依次选择,如实例 A→B→C→A→B...,实现简单,适合实例性能一致的场景;

- 随机(Random):随机选择一个实例,适合实例性能差异小的场景,可通过加权随机(性能高的实例权重高,被选中概率大)优化;

- 最少活跃调用数(Least Active):选择当前活跃调用数最少的实例(活跃数指正在处理的 RPC 请求数),适合实例性能差异大的场景,能动态避开过载实例;

- 一致性哈希(Consistent Hash):将服务实例和请求参数(如用户 ID)映射到哈希环上,相同参数的请求始终路由到同一个实例,适合需要会话粘滞的场景(如分布式缓存)。

-

实现示例 :Dubbo 框架默认使用客户端负载均衡,消费者通过

@Reference(loadbalance = "roundrobin")指定算法,调用时从本地缓存的实例列表中选择实例。

2. 服务端负载均衡(Proxy 侧实现)

-

原理:在服务提供者和消费者之间增加一个"负载均衡代理"(如 Nginx、HAProxy、API Gateway),消费者将请求发送给代理,代理从注册中心获取实例列表,通过算法选择实例并转发请求。

-

核心优势:负载均衡逻辑集中在代理,消费者无需维护实例列表,适合非 RPC 场景(如 HTTP 接口)或消费者无法集成负载均衡组件的场景。

-

缺点:代理成为单点瓶颈(需部署集群),增加一次网络跳转,性能略低于客户端负载均衡。

-

实现示例 :Nginx 作为 RPC 服务的负载均衡代理,配置如下(针对 Dubbo 服务):

upstream user_service { server 192.168.1.100:20880 weight=1; # 权重1 server 192.168.1.101:20880 weight=2; # 权重2(被选中概率更高) } server { listen 80; location / { proxy_pass http://user_service; # 转发请求到 upstream 列表 } }

三、面试加分点与记忆法

-

加分点:

- 解释注册中心的"CAP 权衡"(如 Eureka 选 AP,Zookeeper 选 CP,Nacos 支持双模式);

- 对比客户端与服务端负载均衡的性能差异(客户端少一次网络跳转,性能更高);

- 说明 Dubbo 框架的服务注册与负载均衡实现(基于 Zookeeper/Nacos 注册,默认客户端负载均衡,支持 4 种算法)。

-

记忆法:服务注册发现:"提供者注册,心跳保活;消费者订阅,推送更新";负载均衡:"客户端本地选,服务端代理转;轮询随机易,最少活跃优"。

Redis 的作用是什么?适用于哪些场景?

Redis(Remote Dictionary Server)是一款基于内存的 高性能键值存储数据库,支持多种数据结构,兼具缓存、持久化、分布式能力。其核心作用是"加速数据访问"和"解决分布式系统问题",广泛应用于微服务、电商、社交等高频场景,是当前互联网架构中的核心中间件之一。

一、Redis 的核心作用

Redis 的作用围绕"内存存储"的特性展开,核心可概括为三大类:数据缓存 、分布式协作 、高频场景优化,每类作用对应不同的技术优势:

1. 数据缓存:减轻数据库压力,提升访问速度

Redis 最核心的作用是作为"缓存",将数据库(如 MySQL)中的热点数据加载到内存中,用户请求优先查询 Redis,未命中时再查询数据库并同步到 Redis。

- 核心优势:内存读写速度(约 10 万次/秒)远高于磁盘数据库(MySQL 约 1 万次/秒),可大幅降低数据库的并发压力,提升系统响应速度。

- 关键特性支撑:支持过期时间设置(自动淘汰过期缓存)、内存淘汰机制(内存满时删除低价值数据),确保缓存的有效性和可用性。

2. 分布式协作:解决分布式系统中的一致性问题

Redis 基于原子命令和分布式特性,可实现分布式锁、分布式计数器、分布式会话等功能,解决多服务实例间的协作问题。

- 核心优势 :提供

SET NX EX(原子性设置锁)、INCR(原子自增)等命令,支持跨服务实例共享数据,避免分布式系统中的数据不一致。 - 关键特性支撑:单线程模型确保命令的原子性,支持主从复制和集群,保证分布式场景下的可用性。

3. 高频场景优化:替代数据库实现高性能业务逻辑

对于高频读写、简单逻辑的场景(如排行榜、签到、消息通知),Redis 可直接作为"业务数据库",替代 MySQL 处理请求,避免数据库成为瓶颈。

- 核心优势:支持 List、Sorted Set 等特殊数据结构,可直接实现复杂业务逻辑(如 Sorted Set 实现排行榜排序),无需额外代码处理。

- 关键特性支撑 :支持丰富的命令(如

ZADD/ZRANGE操作 Sorted Set),读写性能高,适合高并发场景。

二、Redis 的典型适用场景

1. 热点数据缓存(最常用场景)

- 场景描述:电商商品详情、新闻列表、用户个人信息等高频访问数据,查询量远大于更新量。

- 实现逻辑 :

- 用户请求"商品详情"时,先查询 Redis(Key 为

product:id:1001); - 若 Redis 命中(存在该 Key),直接返回数据;

- 若未命中,查询 MySQL 并将结果存入 Redis(设置过期时间如 1 小时),再返回数据。

- 用户请求"商品详情"时,先查询 Redis(Key 为

- 优势:减少 MySQL 访问量(如将 90% 的查询拦截在 Redis 层),提升页面加载速度(从秒级降至毫秒级)。

2. 分布式锁(解决并发修改问题)

-

场景描述:微服务架构中,多实例同时修改同一资源(如库存扣减、订单创建),需避免超卖或重复创建。

-

实现逻辑 (基于 Redis 原子命令):

// 获取锁:SET NX(仅当Key不存在时设置)+ EX(过期时间),确保原子性 Boolean lock = redisTemplate.opsForValue().setIfAbsent("lock:order:1001", "1", 30, TimeUnit.SECONDS); if (lock) { try { // 执行业务逻辑(如扣减库存) } finally { // 释放锁(需判断锁持有者,避免误删他人锁,此处简化) redisTemplate.delete("lock:order:1001"); } } else { // 获取锁失败,重试或返回"操作繁忙" } -

优势:相比数据库锁(如悲观锁),Redis 分布式锁性能更高,支持跨实例、跨机房部署。

3. 分布式计数器(高频计数场景)

-

场景描述:商品点赞数、文章阅读量、接口调用次数等需要实时计数的场景,并发计数频率高。

-

实现逻辑 :利用 Redis 的

INCR原子命令实现计数,无需手动处理并发:// 点赞数+1(Key为like:product:1001) Long likeCount = redisTemplate.opsForValue().increment("like:product:1001"); // 获取当前点赞数 Long currentLike = redisTemplate.opsForValue().get("like:product:1001"); -

优势 :

INCR命令是原子操作,避免多线程并发计数导致的"计数丢失"(如 MySQL 的UPDATE count = count + 1需加行锁,性能低)。

4. 排行榜(基于 Sorted Set)

-

场景描述:游戏战力排行榜、电商销量排行榜、直播平台礼物榜等需要按分数排序的场景。

-

实现逻辑 :利用 Redis 的 Sorted Set(有序集合),将"用户 ID"作为 Member,"分数"(如战力、销量)作为 Score,通过命令实现排序和查询:

// 添加用户1001的战力(分数1500)到排行榜 redisTemplate.opsForZSet().add("rank:game:fight", "user:1001", 1500); // 获取Top10用户(按分数降序) Set<String> top10 = redisTemplate.opsForZSet().reverseRange("rank:game:fight", 0, 9); // 获取用户1001的排名 Long rank = redisTemplate.opsForZSet().reverseRank("rank:game:fight", "user:1001"); -

优势 :Sorted Set 自动按分数排序,查询 Top N 或指定用户排名的时间复杂度为 O(log n),性能远高于 MySQL 的

ORDER BY + LIMIT(需全表排序)。

5. 消息队列(基于 List 或 Pub/Sub)

-

场景描述:异步通信场景,如订单创建后发送短信通知、日志异步写入,避免同步调用导致的响应延迟。

-

实现逻辑 (基于 List 的生产者-消费者模式):

// 生产者:发送消息到队列(Key为queue:sms) redisTemplate.opsForList().leftPush("queue:sms", "用户1001的短信内容"); // 消费者:从队列尾部获取消息(阻塞式,避免空轮询) String message = redisTemplate.opsForList().rightPop("queue:sms", 0, TimeUnit.SECONDS); -

优势:实现简单,无需部署专门的消息队列(如 Kafka、RabbitMQ),适合轻量级异步场景;若需广播消息(如系统通知),可使用 Pub/Sub 模式。

6. 分布式会话(跨实例共享用户会话)

-

场景描述:微服务架构中,用户登录后会话信息需在多实例间共享(如用户访问"订单服务"和"支付服务"需保持登录状态)。

-

实现逻辑 :将用户会话(如 Token、用户信息)存入 Redis,设置过期时间(与登录超时时间一致),各服务实例通过 Token 查询 Redis 获取会话:

// 用户登录成功,存储会话(Key为session:token:abc123) redisTemplate.opsForValue().set("session:token:abc123", userInfo, 2, TimeUnit.HOURS); // 后续请求,通过Token查询会话 UserInfo userInfo = redisTemplate.opsForValue().get("session:token:abc123"); -

优势:替代传统的 Tomcat 本地会话(无法跨实例共享),支持服务水平扩展(增加实例无需担心会话丢失)。

三、面试加分点与记忆法

-

加分点:

- 说明 Redis 缓存的"缓存穿透""缓存击穿""缓存雪崩"问题及解决方案(如穿透用布隆过滤器,击穿用互斥锁,雪崩用过期时间随机化);

- 对比 Redis 与其他缓存(如 Memcached)的优势(Redis 支持更多数据结构、持久化、分布式);

- 解释 Redis 作为消息队列的局限性(无消息确认机制、不支持死信队列,复杂场景需用 Kafka)。

-

记忆法:作用:"缓存加速查,分布解并发,高频场景替数据库";场景:"热点缓存用,分布锁防冲,计数排行消息通"。

Redis 支持哪些数据结构?请简述它们的特点和用法。

Redis 作为高性能键值数据库,核心优势之一是支持 丰富的数据结构,而非仅存储简单的"字符串键值对"。官方支持的核心数据结构包括 String(字符串)、Hash(哈希)、List(列表)、Set(集合)、Sorted Set(有序集合),此外还有 BitMap(位图)、HyperLogLog(基数统计)、Geo(地理信息)等扩展结构。每种结构都有独特的存储方式和命令,适配不同业务场景。

一、核心数据结构(5种基础结构)

1. String(字符串)

- 特点:Redis 中最基础的数据结构,存储二进制安全的字符串(可存储文本、JSON、图片二进制等),最大长度为 512MB。支持直接操作字符串的部分内容(如截取、替换),也支持将字符串作为数字进行原子自增/自减。

- 底层实现 :短字符串(长度 < 44 字节)用

embstr编码(内存连续存储),长字符串用raw编码(内存分开存储),数字类型的字符串(如"123")会自动转为整数存储,提升INCR等命令的效率。 - 常用命令 :

SET key value [EX seconds]:设置键值对,可选过期时间;GET key:获取键对应的值;INCR key:将值作为整数自增 1(原子操作);APPEND key value:在字符串末尾追加内容;SUBSTR key start end:截取字符串从 start 到 end 的子串。

- 适用场景 :存储用户信息(JSON 字符串)、验证码、计数器(如接口调用次数)、分布式锁的锁值。示例:

SET user:1001 '{"id":1001,"name":"Alice"}' EX 3600(存储用户 1001 的信息,1 小时过期)。

2. Hash(哈希)

- 特点 :存储"键值对的集合",即一个 Hash 键对应多个"字段(field)-值(value)"映射,类似 Java 中的

HashMap。适合存储结构化数据(如用户属性、商品信息),可单独操作某个字段(无需修改整个结构),节省内存。 - 底层实现 :字段数量少且值较小时,用

ziplist编码(压缩列表,内存连续);字段数量多或值较大时,用hashtable编码(哈希表,类似 Java HashMap)。 - 常用命令 :

HSET key field value:设置 Hash 中的某个字段值;HGET key field:获取 Hash 中某个字段的值;HGETALL key:获取 Hash 中所有字段和值;HDEL key field:删除 Hash 中的某个字段;HLEN key:获取 Hash 中的字段总数。

- 适用场景 :存储用户属性(如

user:1001的name、age、phone字段)、商品详情(如product:1001的price、stock、category字段)。示例:HSET user:1001 name "Alice" age 25(设置用户 1001 的姓名和年龄)。

3. List(列表)

- 特点 :有序的字符串列表,支持从两端(头部和尾部)添加/删除元素,类似 Java 中的

LinkedList(链表结构,两端操作效率高,中间操作效率低)。列表中的元素可重复,长度无上限(受内存限制)。 - 底层实现 :元素数量少且值较小时,用

ziplist编码;元素数量多或值较大时,用linkedlist编码(双向链表)。 - 常用命令 :

LPUSH key value:从列表头部添加元素;RPUSH key value:从列表尾部添加元素;LPOP key:从列表头部删除并返回元素;RPOP key:从列表尾部删除并返回元素;LRANGE key start end:获取列表从 start 到 end 的元素(如LRANGE list 0 -1获取所有元素)。

- 适用场景 :消息队列(生产者

LPUSH发送消息,消费者RPOP接收消息)、最新消息列表(如朋友圈最新动态

为什么要学习 Redis 的持久化机制?它对你的开发工作有什么帮助?

Redis 是基于内存的数据库,所有数据默认存储在内存中。若 Redis 进程退出、服务器宕机或断电,内存中的数据会全部丢失,这在生产环境中是不可接受的(如电商的库存数据、用户会话数据丢失会导致业务异常)。持久化机制是 Redis 保证数据不丢失的核心手段,通过将内存中的数据定期或实时写入磁盘,实现"内存数据持久化"。学习持久化机制不仅能理解 Redis 数据安全的底层逻辑,更能在开发中合理配置策略,平衡性能与数据可靠性,避免因数据丢失导致的业务故障。

一、为什么要学习 Redis 的持久化机制?

1. 理解 Redis 数据安全的底层逻辑

Redis 作为高频使用的缓存或数据库,数据安全性是基础要求。持久化机制的核心目标是"在 Redis 不可用时,能通过磁盘文件恢复数据",其实现涉及两种核心方式:

- RDB(Redis Database) :在指定时间间隔内,将内存中的数据集快照(Snapshot)写入磁盘(如生成

dump.rdb文件); - AOF(Append Only File) :记录所有写命令(如

SET、HSET)到日志文件,重启时通过重新执行这些命令恢复数据。

学习持久化机制能理解:RDB 为何恢复速度快但可能丢失数据,AOF 为何数据更完整但文件体积大,两种方式的优缺点及适用场景,避免因配置不当导致数据丢失(如仅用 RDB 且快照间隔长,宕机可能丢失大量数据)。

2. 应对生产环境的突发故障

生产环境中,Redis 可能因服务器断电、进程崩溃、网络故障等原因宕机。若未配置持久化或机制不合理,会导致数据全部丢失,引发业务中断(如用户购物车清空、订单状态异常)。学习持久化机制能掌握:

- 如何通过 RDB 或 AOF 文件恢复数据;

- 如何配置快照频率(RDB)或刷盘策略(AOF),减少数据丢失量;

- 如何处理 RDB 与 AOF 并存时的恢复优先级(AOF 优先级更高,因数据更完整)。

例如:某电商平台 Redis 因服务器断电宕机,若配置了 AOF 且 appendfsync everysec(每秒刷盘),最多丢失 1 秒内的数据;若仅用 RDB 且 1 小时快照一次,可能丢失 1 小时数据,损失远大于前者。

3. 优化 Redis 性能与资源占用

持久化操作会消耗磁盘 I/O 和 CPU 资源,不合理的配置可能导致 Redis 性能下降(如频繁生成 RDB 快照导致卡顿,AOF 文件过大导致重启恢复缓慢)。学习持久化机制能掌握优化技巧:

- RDB:合理设置

save触发条件(如save 3600 1表示 1 小时内有 1 次修改就快照),避免频繁快照; - AOF:开启

auto-aof-rewrite自动重写(压缩冗余命令,如多次INCR合并为最终值),减少文件体积; - 选择混合持久化(Redis 4.0+ 支持,RDB 作为 AOF 头部,兼顾恢复速度和数据完整性)。

二、持久化机制对开发工作的具体帮助

1. 确保数据可靠性,降低业务风险

开发中,针对不同业务场景选择合适的持久化策略,可显著降低数据丢失风险:

- 核心数据(如交易记录) :采用 AOF 并配置

appendfsync always(每次写命令都刷盘,数据零丢失,性能略低); - 非核心数据(如商品浏览量) :采用 RDB 或 AOF

everysec(允许秒级数据丢失,性能更高); - 双保险场景:同时开启 RDB 和 AOF,重启时优先用 AOF 恢复(数据完整),RDB 作为备份。

例如:开发用户余额系统时,配置 AOF always 确保充值、扣款记录不丢失;开发商品点击量统计时,用 RDB 每 5 分钟快照一次,平衡性能与数据安全性。

2. 简化数据备份与迁移流程

持久化文件(RDB/AOF)是 Redis 数据的"离线副本",开发中可利用其实现:

- 定时备份 :通过脚本定期复制

dump.rdb或appendonly.aof到备份服务器(如每天凌晨 3 点),应对磁盘损坏等灾难; - 跨环境迁移 :将生产环境的 RDB 文件复制到测试环境,通过

redis-server --dbfilename dump.rdb启动,快速同步生产数据用于测试; - 版本回滚:若因代码 bug 导致数据错误,可恢复到之前的 RDB/AOF 备份(如恢复到昨天的快照)。

3. 支撑高可用架构的实现

Redis 的主从复制、哨兵、集群等高可用架构依赖持久化机制:

- 主从同步:从节点首次同步时,主节点会生成 RDB 快照发送给从节点,从节点加载 RDB 初始化数据;

- 哨兵故障转移:主节点宕机后,哨兵选举从节点升级为主节点,新主节点需基于持久化文件恢复数据(或从其他从节点同步);

- 集群扩缩容:新增节点时,需通过持久化文件或主从同步获取全量数据,确保集群数据一致。

开发中配置高可用架构时,需理解持久化与主从的协同逻辑(如主节点 RDB 生成频率影响从节点同步效率),避免架构设计缺陷。

关键点与面试加分点

- 核心价值:持久化是 Redis 数据不丢失的基础,学习它能理解数据安全、性能优化、高可用的底层关联;

- 加分点:能对比 RDB 和 AOF 的优缺点(RDB 恢复快但数据可能丢失,AOF 数据完整但文件大),说明混合持久化的优势(Redis 4.0+ 结合 RDB 和 AOF 优点),举例不同业务场景的持久化配置策略。

记忆法

可总结为"持久化防丢失,RDB 快照快,AOF 日志全;开发选策略,备份易迁移,高可用靠它建",即持久化的核心作用及对开发的帮助。

Redis 如何存储过期键?过期键的删除策略是什么?

Redis 允许为键设置过期时间(如 EXPIRE key 60 表示 60 秒后过期),过期键的管理涉及"存储过期信息"和"删除过期键"两个核心环节。合理的存储方式确保过期时间高效管理,而删除策略则平衡"内存占用"和"CPU 消耗",是 Redis 高性能的关键设计之一。

一、过期键的存储方式

Redis 中,键的"值数据"和"过期时间"是分开存储的,通过两个字典实现:

- 键空间(key space) :存储所有键值对(如

key -> value),与普通键的存储方式一致; - 过期字典(expires) :专门存储键的过期时间(如

key -> 过期时间戳),过期时间戳是从 1970 年 1 月 1 日到过期时刻的秒数(或毫秒数,取决于 Redis 配置)。

核心细节:

- 过期字典的结构:底层是哈希表(hashtable),键是指向键空间中键的指针,值是过期时间戳,避免存储键的副本,节省内存;

- 过期时间的设置命令 :

EXPIRE key seconds:设置键在seconds秒后过期;PEXPIRE key milliseconds:设置键在milliseconds毫秒后过期;EXPIREAT key timestamp:设置键在timestamp秒时间戳时过期;PEXPIREAT key timestamp:设置键在timestamp毫秒时间戳时过期;这些命令最终都会转换为PEXPIREAT操作,将毫秒级过期时间戳存入过期字典。

- 过期键的判断 :当需要检查键是否过期时,Redis 会先在过期字典中查找该键:

- 若不存在,键未设置过期时间(永久有效);

- 若存在,比较当前时间戳与过期时间戳,当前时间戳更大则键已过期。

二、过期键的删除策略

Redis 采用"惰性删除 + 定期删除 "的混合策略删除过期键,同时配合"内存淘汰机制"处理内存不足时的过期键,三者协同平衡内存和 CPU 资源。

1. 惰性删除(Lazy Eviction)

- 原理 :不主动删除过期键,仅在"访问键时"(如

GET key)才检查该键是否过期:- 若未过期,正常返回值;

- 若已过期,删除该键(从键空间和过期字典中移除),返回

nil。

- 优点:CPU 友好,仅在必要时执行删除操作,避免无用的扫描和删除消耗 CPU(适合过期键多但访问少的场景);

- 缺点:内存不友好,若过期键长期未被访问,会一直占用内存(如"僵尸键"),可能导致内存泄漏。

2. 定期删除(Periodic Eviction)

- 原理 :Redis 每隔一段时间(默认 100 毫秒,可通过

hz参数调整)执行一次过期键扫描,主动删除部分过期键,具体流程:- 从过期字典中随机抽取 20 个键;

- 删除这 20 个键中已过期的键;

- 若过期键比例超过 25%,重复步骤 1-2(避免大量过期键未被删除);

- 每次扫描时间上限为 25 毫秒(避免阻塞 Redis 主线程,影响响应速度)。

- 优点:主动删除部分过期键,减少"僵尸键",缓解内存压力;

- 缺点:无法删除所有过期键(受限于扫描数量和时间),仍可能有部分过期键残留。

3. 内存淘汰机制(Memory Eviction)

当 Redis 内存达到 maxmemory 限制时,即使存在未删除的过期键,也会触发内存淘汰机制,删除部分键释放内存。内存淘汰机制不仅针对过期键,也包括未过期键,核心策略有 8 种,常用的包括:

-

volatile-lru:从设置了过期时间的键中,删除最近最少使用(LRU)的键;

-

allkeys-lru:从所有键中,删除最近最少使用的键;

-

volatile-ttl:从设置了过期时间的键中,删除剩余过期时间最短的键;

-

noeviction:默认策略,不删除任何键,内存满时拒绝新写入请求(返回错误)。

-

适用场景:当惰性删除和定期删除未及时释放内存,导致内存达到上限时,内存淘汰机制作为"最后一道防线",确保 Redis 能继续处理请求。

三、三种策略的协同作用

Redis 并非单独使用某一种策略,而是三者结合:

- 日常运行:依赖惰性删除(访问时清理)和定期删除(主动抽查),平衡 CPU 和内存;

- 内存紧张:触发内存淘汰机制,强制释放内存,避免服务不可用;

- 极端情况 :若大量过期键未被访问且定期删除未扫描到,内存淘汰机制(如

volatile-lru)会优先删除这些过期键,避免内存溢出。

例如:某 Redis 实例存储 100 万个键,其中 10 万个已过期但未被访问。惰性删除不会处理这些键,定期删除每次扫描 20 个键,可能仅删除部分;当内存达到上限时,volatile-lru 会优先删除这 10 万个过期键中最久未使用的,释放内存。

关键点与面试加分点

- 核心设计:过期键存储在独立的过期字典,删除策略采用"惰性+定期+内存淘汰",平衡 CPU 和内存资源;

- 加分点 :能解释

hz参数的作用(控制定期删除频率,hz越大扫描越频繁,CPU 消耗越高),说明 LRU 算法的实现(Redis 用近似 LRU,通过随机采样优化性能),对比不同内存淘汰策略的适用场景(如缓存场景用allkeys-lru,会话存储用volatile-ttl)。

记忆法

可总结为"过期键,两字典存;删策略,三结合稳:惰性查时删,定期抽着清,内存满了淘汰顶",即过期键的存储方式和三种删除策略的协同逻辑。

Redis 的定时任务有哪些?如何配置和使用?

Redis 中的定时任务分为"内置定时任务"和"用户自定义定时任务"两类。内置定时任务是 Redis 自身维护的后台任务(如过期键清理、AOF 重写触发),由 Redis 主线程或后台线程自动执行;用户自定义定时任务则是开发者通过外部工具或 Redis 扩展功能,实现按指定时间触发的自定义逻辑(如定时删除缓存、统计数据聚合)。理解并使用这些定时任务,能优化 Redis 性能和扩展业务能力。

一、Redis 内置定时任务

内置定时任务由 Redis 内部调度机制(serverCron 函数)驱动,默认每 100 毫秒执行一次(可通过 hz 参数调整频率,范围 1-500,默认 10),主要包括以下核心任务:

1. 过期键定期删除

- 作用:主动扫描并删除部分过期键(见"过期键删除策略"),减少内存占用;

- 触发机制 :

serverCron每次执行时,调用activeExpireCycle函数,按比例随机扫描过期键并删除; - 配置方式 :通过

hz参数调整执行频率(config set hz 20表示每秒执行 20 次,更频繁地清理过期键,但增加 CPU 消耗)。

2. AOF 日志重写检查

- 作用 :当 AOF 文件体积过大时,触发重写(合并冗余命令,如多次

INCR count合并为SET count 100),减少文件体积; - 触发机制 :

serverCron检查是否满足重写条件(如当前 AOF 大小是上次重写后大小的 100% 以上,且文件大小超过auto-aof-rewrite-min-size),满足则触发后台重写(bgrewriteaof); - 配置方式 :

auto-aof-rewrite-percentage 100:重写触发的增长率(默认 100%);auto-aof-rewrite-min-size 64mb:重写的最小文件大小(默认 64MB);通过config set动态修改:config set auto-aof-rewrite-percentage 150。

3. RDB 快照自动触发

-

作用:按配置的时间间隔自动生成 RDB 快照(如 1 小时内有 1 次修改则生成快照);

-

触发机制 :

serverCron检查save配置的条件是否满足(如save 3600 1表示 3600 秒内有至少 1 次写操作),满足则触发后台快照(bgsave); -

配置方式 :在

redis.conf中配置:save 3600 1 # 3600秒内有1次修改 save 300 100 # 300秒内有100次修改或通过

config set save "3600 1 300 100"动态设置。

4. 主从复制心跳与数据同步

- 作用 :主节点定期向从节点发送心跳(

REPLCONF ACK),检查从节点是否在线;从节点定期确认同步进度,主节点根据需要推送增量数据; - 触发机制 :

serverCron每 10 秒触发一次主从心跳检查,确保主从连接正常; - 配置方式 :无需手动配置,由 Redis 自动维护,可通过

info replication查看同步状态。

二、用户自定义定时任务

Redis 本身未提供直接的定时任务 API,但可通过以下方式实现自定义定时任务,满足业务需求(如定时清理缓存、数据汇总):

1. 基于外部定时工具调用 Redis 命令

利用 Linux 的 crontab 或 Windows 的任务计划程序,定期执行 redis-cli 命令,实现定时任务:

-

示例1:每天凌晨 3 点删除过期的会话缓存 编写 Shell 脚本

clean_session.sh:#!/bin/bash # 删除所有以"session:"开头且已过期的键(利用Redis的KEYS和DEL命令) redis-cli KEYS "session:*" | xargs redis-cli DEL通过

crontab -e添加定时任务:0 3 * * * /path/to/clean_session.sh # 每天凌晨3点执行 -

示例2:每小时统计用户在线数量并存储 编写脚本

count_online.sh:#!/bin/bash # 统计在线用户数(假设在线用户存在"online:user:*"键中) count=$(redis-cli KEYS "online:user:*" | wc -l) # 存储到Redis(带时间戳) redis-cli SET "stat:online:$(date +%Y%m%d%H)" $count添加到

crontab:0 * * * * /path/to/count_online.sh # 每小时0分执行

2. 基于 Redis 的过期事件通知(Keyspace Notifications)

Redis 支持键过期事件通知,通过订阅 __keyevent@0__:expired 频道,可在键过期时触发自定义逻辑(需开启事件通知配置):

-

配置方式 :在

redis.conf中开启事件通知:notify-keyspace-events Ex # E表示键事件,x表示过期事件或动态配置:

config set notify-keyspace-events Ex。 -

使用示例 :用 Python 订阅过期事件,实现定时任务(如订单超时取消):

import redis r = redis.Redis(host='localhost', port=6379, db=0) pubsub = r.pubsub() pubsub.subscribe('__keyevent@0__:expired') # 订阅过期事件频道 for message in pubsub.listen(): if message['type'] == 'message': expired_key = message['data'].decode() if expired_key.startswith('order:'): order_id = expired_key.split(':')[1] print(f"处理超时订单:{order_id}") # 执行取消订单逻辑业务中,创建订单时设置过期键:

SET order:1001 "pending" EX 300(300秒后过期,触发取消逻辑)。

3. 基于 Redis 模块(如 RedisGears)

RedisGears 是 Redis 的扩展模块,支持在 Redis 内部运行 Python 脚本,并提供定时任务功能,适合复杂逻辑:

-

安装与配置 :加载 RedisGears 模块(

loadmodule /path/to/redisgears.so); -

示例:每 5 分钟清理无效数据 :

# 通过RedisGears的定时任务API注册 GearsBuilder().run( lambda x: execute('DEL', x), # 执行删除命令 trigger=Trigger('periodic', every=300000) # 每300000毫秒(5分钟)执行 )

关键点与面试加分点

- 核心分类:定时任务分内置(Redis 自动维护)和自定义(需外部工具或扩展),内置任务保障 Redis 自身运行,自定义任务扩展业务能力;

- 加分点 :能说明

hz参数对内置任务的影响(频率过高消耗 CPU,过低影响清理效率),对比不同自定义任务方式的优缺点(crontab简单但依赖外部,事件通知实时性高但需订阅,RedisGears 功能强但需安装模块)。

记忆法

可总结为"内置任务自维护,过期清理重写备;自定义靠外部调,事件通知齿轮配",即 Redis 定时任务的分类和实现方式。

你配置过 Redis 集群或 Redis 主从架构吗?请简述配置流程和核心注意事项。

在生产环境中,Redis 主从架构和集群是保障高可用、高吞吐的核心方案------主从架构实现读写分离和数据备份,集群则解决单节点内存和并发瓶颈。以下分别介绍两种架构的配置流程,以及需重点关注的注意事项,均基于 Redis 6.x 版本(兼容 5.x 核心逻辑)。

一、Redis 主从架构配置流程

Redis 主从架构(一主多从)的核心是"主节点写入,从节点同步数据并提供读服务",配置步骤简单,无需额外工具,仅需修改配置文件或动态命令即可。

1. 环境准备

- 准备至少 2 台服务器(或同一服务器不同端口,如主节点 6379,从节点 6380);

- 确保主从节点网络互通(关闭防火墙或开放 Redis 端口,如

firewall-cmd --zone=public --add-port=6379/tcp --permanent)。

2. 主节点(Master)配置

主节点无需特殊配置,仅需确保从节点可连接,关键配置项在 redis.conf 中调整:

# 1. 允许外部访问(默认 bind 127.0.0.1,改为服务器内网 IP 或 0.0.0.0)

bind 192.168.1.100 # 主节点服务器内网 IP

# 2. 关闭保护模式(默认 yes,外部节点无法连接)

protected-mode no

# 3. 配置端口(默认 6379,可自定义)

port 6379

# 4. 可选:配置密码(主从同步需一致)

requirepass 123456 # 主节点密码

# 5. 可选:开启持久化(避免主节点宕机后数据丢失)

appendonly yes # 开启 AOF 持久化

appendfsync everysec # 每秒刷盘,平衡性能与数据安全配置完成后启动主节点:redis-server /path/to/redis.conf。

3. 从节点(Slave/Replica)配置

从节点需指定"同步的主节点 IP 和端口",Redis 5.0 后用 replicaof 替代旧的 slaveof,配置方式有两种:

方式1:配置文件(永久生效)

修改从节点 redis.conf:

bind 192.168.1.101 # 从节点 IP

protected-mode no

port 6380 # 从节点端口(与主节点不同)

requirepass 123456 # 从节点密码(需与主节点一致,避免连接失败)

# 关键:指定主节点信息

replicaof 192.168.1.100 6379 # 主节点 IP:端口

# 主节点有密码时,配置认证

masterauth 123456

# 可选:设置从节点只读(默认 yes,避免从节点写入数据)

replica-read-only yes

# 可选:开启持久化

appendonly yes启动从节点:redis-server /path/to/redis.conf。

方式2:动态命令(临时生效,重启后失效)

从节点启动后,通过 redis-cli 执行命令:

redis-cli -h 192.168.1.101 -p 6380 # 连接从节点

192.168.1.101:6380> auth 123456 # 认证(若配置密码)

192.168.1.101:6380> replicaof 192.168.1.100 6379 # 绑定主节点

192.168.1.101:6380> config set masterauth 123456 # 主节点密码4. 验证主从同步

- 主节点执行:

redis-cli -h 192.168.1.100 -p 6379 auth 123456; info replication,查看connected_slaves为 1,确认从节点已连接; - 主节点写入数据:

set test_key "hello master"; - 从节点读取:

redis-cli -h 192.168.1.101 -p 6380 auth 123456; get test_key,返回hello master,说明同步成功。

二、Redis 集群(Redis Cluster)配置流程

Redis 集群(默认 3 主 3 从,共 6 个节点)通过"哈希槽"分配数据,支持水平扩展和自动故障转移,配置需依赖 redis-cli --cluster 工具。

1. 环境准备

- 准备 6 台服务器(或同一服务器 6 个端口,如 7000-7005);

- 每台节点配置相同密码(避免集群通信失败),关闭防火墙。

2. 单个节点基础配置(所有节点一致)

创建集群专用配置文件 redis-cluster-7000.conf(以 7000 端口为例),其他节点仅修改 port 即可:

port 7000

bind 192.168.1.100 # 节点 IP

protected-mode no

daemonize yes # 后台运行

pidfile /var/run/redis-7000.pid

logfile "redis-7000.log"

dir /data/redis/7000 # 数据存储目录(需提前创建)

# 集群核心配置

cluster-enabled yes # 开启集群模式

cluster-config-file nodes-7000.conf # 集群节点信息文件(自动生成)

cluster-node-timeout 15000 # 节点超时时间(毫秒,超时视为下线)

# 密码配置

requirepass 123456

masterauth 123456 # 主从同步密码(与 requirepass 一致)

# 持久化

appendonly yes复制该配置文件到其他节点,修改 port(7001-7005)、pidfile、logfile、dir,然后启动所有节点:

redis-server redis-cluster-7000.conf

redis-server redis-cluster-7001.conf

# ... 启动 7002-7005 节点3. 创建集群

通过 redis-cli --cluster create 命令初始化集群,自动分配主从和哈希槽:

redis-cli --cluster create \

192.168.1.100:7000 192.168.1.100:7001 192.168.1.100:7002 \

192.168.1.100:7003 192.168.1.100:7004 192.168.1.100:7005 \

--cluster-replicas 1 \ # 每个主节点对应 1 个从节点

-a 123456 # 集群密码执行后,工具会自动将 7000-7002 设为主节点,7003-7005 设为从节点,并分配 16384 个哈希槽(每个主节点约 5461 个槽),输入 yes 确认即可。

4. 验证集群状态

- 连接集群:

redis-cli -h 192.168.1.100 -p 7000 -c -a 123456(-c表示集群模式,自动跳转节点); - 查看集群信息:

cluster info,确认cluster_state:ok; - 查看节点槽分配:

cluster slots,可看到每个主节点管理的槽范围; - 测试数据存储:

set cluster_key "hello cluster",工具会自动计算槽并跳转到对应主节点,读取时也会自动跳转。

三、核心注意事项

| 架构类型 | 注意事项 |

|---|---|

| 主从架构 | 1. 主从密码必须一致(requirepass 和 masterauth),否则同步失败;2. 从节点默认只读(replica-read-only yes),避免从节点写入导致数据不一致;3. 主节点需开启持久化(AOF/RDB),否则主节点宕机后从节点数据也会丢失;4. 主从网络延迟需低(建议内网部署),避免同步滞后过多。 |

| 集群架构 | 1. 集群节点数至少 3 主 3 从(少于 3 主无法选举);2. 哈希槽必须全部分配(16384 个槽无遗漏),否则集群状态为 fail;3. 节点超时时间(cluster-node-timeout)不宜过短(建议 15-30 秒),避免网络波动误判节点下线;4. 扩容/缩容时需用 redis-cli --cluster add-node/del-node,并手动迁移哈希槽。 |

通用注意事项

- 持久化必开:无论主从还是集群,均需开启 AOF 或 RDB,避免节点宕机后数据丢失;

- 监控与告警 :通过

info replication/cluster info监控状态,配置告警(如主节点下线、集群状态异常); - 密码管理 :生产环境必须配置密码,避免未授权访问(可通过

config set requirepass动态修改,但需同步所有节点)。

关键点与面试加分点

- 核心差异:主从架构适合读写分离和数据备份,不支持水平扩展;集群架构通过哈希槽支持水平扩展和自动故障转移,适合大规模数据场景;

- 加分点 :能说明主从同步的"全量同步"与"增量同步"(首次同步用全量,后续用增量),解释集群哈希槽迁移的原理(

cluster setslot命令),提及 Redis 集群的"脑裂"问题及解决方案(min-replicas-to-write配置)。

记忆法

主从配置:"主改IP关保护,从绑主节点输密码,同步验证读数据";集群配置:"六节点开集群,create命令分主从,槽全状态ok,连接加-c跳转"。

结尾交付物提议

要不要我帮你整理一份 Redis 主从与集群配置的完整脚本,包含配置文件模板、启动命令、验证步骤,方便你直接在测试环境部署和验证?

Redis 集群中数据是如何存储的?(如哈希槽分配机制)

Redis 集群(Redis Cluster)通过"哈希槽(Hash Slot)"机制实现数据的分布式存储,核心是将数据按键的哈希值分配到固定数量的槽中,再将槽分配给集群节点,从而实现"数据分片"和"水平扩展"。这种机制避免了传统一致性哈希的复杂度,同时支持灵活的节点扩容/缩容,是 Redis 集群存储的核心设计。

一、哈希槽的核心机制

Redis 集群将所有数据映射到 16384 个哈希槽(编号 0-16383),数据存储的核心流程是"键→哈希值→哈希槽→节点",具体逻辑如下:

1. 哈希槽的数量与作用

- 数量固定 :哈希槽总数为 16384(2^14),而非更多(如 65536),原因是:

- 减少节点间通信开销:节点握手时需交换"槽分配表",16384 个槽的表体积小(约 2KB),网络传输快;

- 平衡槽分配粒度:16384 个槽可均匀分配给多个节点(如 3 主节点各分 5461 个槽),避免槽过少导致分配不均。

- 核心作用:作为"数据与节点的中间映射层"------键不直接绑定节点,而是绑定槽,槽再绑定节点,后续节点扩容/缩容时仅需迁移槽,无需修改键与槽的映射关系。

2. 键到哈希槽的映射逻辑

当客户端写入或读取键时,Redis 会通过以下步骤确定键所属的哈希槽:

- 计算键的哈希值 :对键(排除

{}包裹的"哈希标签"部分)执行 CRC16 算法,得到一个 16 位的哈希值(范围 0-65535); - 取模映射到槽 :将 CRC16 哈希值对 16384 取模(

CRC16(key) % 16384),结果即为键所属的哈希槽(0-16383)。

3. 哈希标签(Hash Tag):自定义槽映射

若需将多个键分配到同一槽(如"用户 1001 的订单"和"用户 1001 的购物车"需在同一节点,避免跨节点事务),可通过"哈希标签"指定:

- 规则:键中被

{}包裹的部分作为"哈希计算的依据",而非整个键; - 示例:

- 键

order:{1001}:123和cart:{1001}:456,哈希计算仅用1001,因此会映射到同一槽; - 若键无

{},则用整个键计算哈希值。

- 键

二、哈希槽的分配与管理

Redis 集群中,哈希槽由 主节点(Master) 管理,从节点(Slave)仅同步主节点的槽数据,不直接处理槽的读写请求(故障转移后从节点升级为主节点,才接管槽)。

1. 集群初始化时的槽分配

通过 redis-cli --cluster create 创建集群时,工具会自动将 16384 个槽均匀分配给主节点:

- 示例:3 主节点集群,槽分配如下:

- 主节点 A(7000):0-5460(共 5461 个槽);

- 主节点 B(7001):5461-10922(共 5462 个槽);

- 主节点 C(7002):10923-16383(共 5461 个槽);

- 从节点仅绑定主节点,不分配槽,如从节点 7003 绑定主节点 7000,同步 0-5460 槽的数据。

2. 槽的迁移:支持节点扩容/缩容

当集群需要扩容(新增主节点)或缩容(下线主节点)时,需手动迁移哈希槽,核心步骤如下(以扩容新增主节点 D 为例):

- 新增主节点 :通过

redis-cli --cluster add-node将节点 D 加入集群,此时节点 D 无槽; - 迁移槽规划:确定从现有主节点(如 A、B、C)迁移多少槽到 D(如从 A 迁移 1000 个槽:0-999);

- 槽迁移执行 :

- 源节点(A):将 0-999 槽的所有键迁移到目标节点(D),并标记槽为"迁移中";

- 集群内节点:更新槽分配表,将 0-999 槽的归属改为 D;

- 客户端:后续访问 0-999 槽的键时,会被引导到 D 节点;

- 验证迁移 :通过

cluster slots查看槽分配,确认 0-999 槽已归属 D。

3. 槽的状态标识

集群中每个槽有三种状态,确保数据一致性:

- 已分配(Assigned):槽已绑定到某个主节点,正常处理读写请求;

- 迁移中(Migrating):槽正在从源节点迁移到目标节点,源节点仅处理读请求,写请求会引导到目标节点;

- 导入中(Importing):目标节点正在接收源节点迁移的槽,仅处理该槽的写请求,读请求引导到源节点。

三、集群数据存储的其他关键设计

1. 主从复制与槽的高可用

Redis 集群通过"主从复制"保障槽数据的高可用:

- 每个主节点至少有 1 个从节点,从节点实时同步主节点的槽数据;

- 若主节点宕机(如 A 节点下线),其从节点(如 7003)会通过"选举"升级为主节点,接管 A 节点的槽(0-5460),继续处理请求,避免数据不可用;

- 主节点恢复后,会自动降级为从节点,同步新主节点(7003)的数据。

2. 客户端的槽路由逻辑

客户端连接集群时,无需记录所有槽的分配,而是通过"节点跳转"实现正确路由:

- 客户端首次连接任意节点(如 7000),会获取集群的槽分配表并缓存本地;

- 客户端访问某个键时,本地计算槽,若槽归属当前节点,则直接处理;

- 若槽归属其他节点,当前节点会返回"重定向响应"(包含目标节点 IP 和端口),客户端重新连接目标节点处理请求;

- 若槽处于迁移中,客户端会收到"ASK 响应",临时跳转到目标节点,不更新本地槽表(避免迁移未完成时缓存错误)。

四、哈希槽 vs 传统一致性哈希

传统分布式系统常用"一致性哈希"(如 Memcached),Redis 集群选择哈希槽,核心差异如下:

| 对比维度 | 哈希槽(Redis Cluster) | 一致性哈希(Memcached) |

|---|---|---|

| 映射层 | 键→槽(16384个)→节点 | 键→哈希环→节点 |

| 扩容/缩容复杂度 | 仅需迁移部分槽,操作简单 | 需重新计算部分键的映射,可能导致大量键迁移 |

| 负载均衡 | 槽均匀分配,负载更均衡 | 节点加入/退出时,可能导致部分节点负载过高 |

| 管理成本 | 槽分配表清晰,易监控和维护 | 哈希环状态难监控,需额外工具(如 Ketama) |

关键点与面试加分点

- 核心逻辑:哈希槽是 Redis 集群数据分片的核心,通过"键→CRC16→槽→节点"实现分布式存储,支持灵活扩容;

- 加分点:能解释 16384 个槽的设计原因(通信开销与分配粒度平衡),说明哈希标签的应用场景(跨键事务),对比主从复制在集群与单机主从中的差异(集群中从节点仅同步主节点的槽数据)。

记忆法

可总结为"16384 槽,CRC 取模找;主节点管槽,从节点备份;扩容迁槽不迁键,客户端跳转路由好",即哈希槽的数量、映射逻辑、管理方式和客户端路由。

当 Redis 请求的键不存在时,会返回什么结果?如何处理这种情况?

当 Redis 请求的键不存在时,返回结果取决于具体命令,但核心表现为"无有效数据返回"------最常用的 GET 命令返回 nil,哈希/列表类命令(如 HGET、LPOP)也返回 nil 或空结果。这种"键不存在"的场景在实际开发中频繁出现(如缓存未命中、数据已过期),若处理不当可能导致"缓存穿透"等问题,需结合业务场景选择合理的处理策略。

一、键不存在时的返回结果

Redis 不同类型的命令,对"键不存在"的返回结果有明确定义,核心可分为三类:

1. 字符串类命令:返回 nil

针对字符串类型(String)的命令,键不存在时统一返回 nil(Redis 中的"空值"标识,类似 Java 中的 null):

-

示例:

127.0.0.1:6379> GET non_exist_key # 键不存在 (nil) 127.0.0.1:6379> SETEX temp_key 10 "hello" # 10秒后过期 OK 127.0.0.1:6379> GET temp_key # 10秒后再次请求,键已过期(视为不存在) (nil) -

其他字符串命令:

MGET(多键查询)中不存在的键返回nil(如MGET key1 non_exist_key返回1) "value1" 2) (nil));INCR命令对不存在的键会先初始化为 0 再自增(返回 1,不视为"无结果",需特殊注意)。

2. 集合/哈希类命令:返回 nil 或空集合

针对哈希(Hash)、列表(List)、集合(Set)、有序集合(ZSet)的命令,键不存在时返回 nil 或空结果:

-

哈希命令(

HGET/HMGET):键不存在时返回nil;127.0.0.1:6379> HGET user:1001 name # 键 user:1001 不存在 (nil) -

列表命令(

LPOP/LRANGE):键不存在时,LPOP返回nil,LRANGE返回空列表((empty list or set));127.0.0.1:6379> LPOP queue:order # 键不存在 (nil) 127.0.0.1:6379> LRANGE list:test 0 -1 # 键不存在 (empty list or set) -

集合命令(

SMEMBERS/SISMEMBER):键不存在时,SMEMBERS返回空集合,SISMEMBER返回0(不存在)。

3. 写命令:部分命令自动初始化键

部分写命令对不存在的键会自动初始化,不返回 nil,需特别注意:

INCR non_exist_key:键不存在时,先初始化为 0,再自增 1,返回1;HSET user:1001 name "Alice":键user:1001不存在时,自动创建哈希键并设置字段,返回1(成功设置的字段数);LPUSH list:test "a":键不存在时,自动创建列表并添加元素,返回1(列表长度)。

二、键不存在的处理策略

"键不存在"本身是正常现象(如首次访问缓存、数据过期),但需结合业务场景处理,避免引发"缓存穿透""重复查询数据库"等问题,核心策略分为"业务层处理"和"缓存层优化"两类。

1. 业务层处理:返回默认值或触发数据加载

针对"缓存未命中"的场景(如用户查询商品详情,Redis 中无该商品键),业务层需明确后续逻辑:

策略1:返回默认数据(适用于非核心数据)

若键不存在不影响核心业务,可直接返回默认值,避免额外开销:

-

示例:查询用户的"最近浏览记录",若键不存在,返回空列表而非查询数据库;

-

Java 代码示例:

@Autowired private RedisTemplate<String, List<String>> redisTemplate; public List<String> getRecentViews(Long userId) { String key = "user:recent:views:" + userId; List<String> views = redisTemplate.opsForValue().get(key); // 键不存在,返回默认空列表 return views == null ? Collections.emptyList() : views; }

策略2:触发数据库查询并更新缓存(适用于核心数据)

若键不存在是"首次访问",需查询数据库获取数据,并同步到 Redis,后续请求直接命中缓存:

-

示例:查询商品详情,Redis 中无键时,查询 MySQL 商品表,将结果存入 Redis 并设置过期时间;

-

Java 代码示例(避免缓存穿透,加互斥锁防止并发查库):

@Autowired private RedisTemplate<String, Product> redisTemplate; @Autowired private ProductMapper productMapper; // 互斥锁,防止并发查库 private final Lock lock = new ReentrantLock(); public Product getProductById(Long productId) { String key = "product:info:" + productId;

什么情况会导致 Kafka 消费变慢?如何排查和解决?

Kafka 消费变慢是分布式消息系统中的常见问题,表现为消费者处理消息的速度跟不上生产者发送速度,导致消费滞后量(Consumer Lag)持续增长,可能引发业务延迟(如订单状态更新延迟)或数据积压。消费变慢的原因涉及消费者、Kafka 集群、网络环境等多方面,需通过系统化排查定位根因,并针对性优化。

一、导致 Kafka 消费变慢的常见原因

1. 消费者处理逻辑效率低(最常见原因)

消费者从 Kafka 拉取消息后,若业务处理逻辑耗时过长(如复杂计算、同步数据库操作、远程调用阻塞),会导致消息处理速度低于拉取速度,表现为"单条消息处理时间长"。

- 典型场景:消费消息后同步调用第三方接口(无超时控制)、在消费线程中执行大量数据库事务、JSON 反序列化逻辑复杂。

2. 消费者资源不足

消费者进程依赖的 CPU、内存、I/O 资源不足,会限制处理能力:

- CPU 瓶颈:消费逻辑存在大量计算(如数据聚合、加密解密),导致 CPU 使用率长期高于 80%,线程调度延迟;

- 内存不足:消息体过大(如单条消息 10MB+),消费者内存溢出(OOM)或频繁 GC(垃圾回收),暂停处理;

- 磁盘 I/O 阻塞:消费者将消息写入本地磁盘(如日志文件),磁盘读写速度慢(如机械硬盘)导致阻塞。

3. Kafka 集群配置或状态异常

Kafka 集群本身的问题会导致消息拉取效率低,间接造成消费变慢:

- 分区数过少:消费组的消费者数量超过分区数(Kafka 规定一个分区只能被消费组内一个消费者消费),多余的消费者空闲,无法分担负载;

- 分区分配不均 :通过

range或round-robin策略分配分区时,若分区数与消费者数比例不当(如 5 个分区 2 个消费者,可能导致一个消费者处理 3 个分区,另一个处理 2 个),负载不均; - ** broker 压力大**:broker 节点磁盘 I/O 高(如日志刷盘频繁)、网络带宽满,导致消息传输延迟,消费者拉取消息超时;

- 副本同步延迟:若消费者从 follower 副本拉取消息,而 follower 与 leader 同步滞后,会导致拉取阻塞。

4. 消费配置不合理

消费者客户端参数配置不当,会限制拉取效率:

- 拉取批次过小 :

fetch.min.bytes设得过大(如 1MB),而实际消息量小,消费者需等待凑足批次才拉取,增加延迟;或fetch.max.wait.ms设得过大(如 500ms),即使批次不足也等待太久; - 拉取并发不足 :

max.poll.records设得太小(如默认 500),每次拉取的消息数少,频繁发起拉取请求,增加 overhead; - 会话超时与再平衡频繁 :

session.timeout.ms设得太短(如 10s),消费者因短暂 GC 未发送心跳,触发消费组再平衡(Rebalance),期间无法消费消息,导致滞后量突增。

5. 数据倾斜

部分分区的消息量远高于其他分区(如按用户 ID 哈希分区时,少数用户产生大量消息),导致处理该分区的消费者压力过大,整体消费速度被拖慢。

二、消费变慢的排查步骤

1. 监控消费滞后量(Consumer Lag)

通过 Kafka 监控工具获取消费组的滞后量,确认是否真的消费变慢:

-

工具 :Kafka Manager、Prometheus + Grafana(配合

kafka_exporter)、kafka-consumer-groups.sh命令; -

命令示例 :

# 查看消费组 "order-group" 对主题 "order-topic" 的滞后量 bin/kafka-consumer-groups.sh --bootstrap-server localhost:9092 --group order-group --describe关注

LAG列,若某分区 LAG 持续增长,说明该分区消费滞后。

2. 分析消费者性能指标

- 处理耗时:在消费逻辑中埋点计时(如记录消息从拉取到处理完成的时间),确认是否单条消息处理时间过长(如超过 100ms);

- 资源使用率 :通过

top/jstat查看消费者进程的 CPU 使用率(%CPU)、内存占用(RES)、GC 情况(jstat -gcutil <pid> 1000),若 CPU 长期 > 80% 或 GC 停顿 > 1s,说明资源不足; - 线程状态 :通过

jstack <pid>查看消费线程状态,若大量线程处于BLOCKED或WAITING(如等待数据库连接池),说明处理逻辑阻塞。

3. 检查 Kafka 集群状态

- broker 状态 :通过

kafka-topics.sh查看分区的 leader 分布(是否集中在少数 broker)、kafka-server-start.sh日志(是否有TimeoutException或磁盘满警告); - 网络与 I/O :检查 broker 节点的网络带宽(

iftop)、磁盘读写速度(iostat),若%util接近 100%,说明磁盘 I/O 饱和; - 分区分配:确认消费组的消费者数量与分区数的关系(理想情况:消费者数 ≤ 分区数,且分区均匀分配)。

4. 审查消费配置参数

导出消费者配置(如 Spring Kafka 的 application.yml),重点检查:

fetch.min.bytes、fetch.max.wait.ms(拉取批次参数);max.poll.records(每次拉取消息数);session.timeout.ms、heartbeat.interval.ms(心跳与再平衡参数);auto.offset.reset(偏移量重置策略,避免重复消费导致的二次处理)。

三、消费变慢的解决措施

1. 优化消费者处理逻辑

-

异步化处理 :将耗时操作(如调用第三方接口、写入数据库)异步化(如提交到线程池),避免阻塞消费线程;示例(Java 代码):

// 错误:同步处理,阻塞消费线程 @KafkaListener(topics = "order-topic") public void consume(OrderMessage message) { thirdPartyService.syncCall(message); // 耗时操作,阻塞 } // 优化:异步处理 @Autowired private ExecutorService executorService; @KafkaListener(topics = "order-topic") public void consume(OrderMessage message) { executorService.submit(() -> thirdPartyService.syncCall(message)); // 异步提交 } -

减少不必要操作 :优化序列化/反序列化(如用 Protobuf 替代 JSON)、避免重复计算(缓存中间结果)、批量处理数据库操作(如 MyBatis 的

batch模式)。

2. 扩容与资源调整

- 增加消费者实例:若分区数充足(消费者数 < 分区数),增加消费组内的消费者数量,分担分区负载;

- 提升资源配置:为消费者进程分配更多 CPU/内存(如 JVM 堆内存从 2GB 增至 4GB),使用 SSD 替代机械硬盘(若涉及本地 I/O);

- 优化 GC :调整 JVM 参数(如用 G1 收集器,设置

XX:MaxGCPauseMillis=200),减少 GC 停顿时间。

3. 调整 Kafka 集群与配置

-

增加分区数 :若分区数过少(如 3 个分区处理 10 万 TPS),通过

kafka-topics.sh扩容分区(需注意:分区数只能增不能减):bin/kafka-topics.sh --bootstrap-server localhost:9092 --alter --topic order-topic --partitions 6 -

均衡分区分配 :使用

sticky分区分配策略(Kafka 2.4+ 支持),减少再平衡时的分区移动; -

优化拉取参数 :

- 若消息量小,降低

fetch.min.bytes(如 1024 字节)、减少fetch.max.wait.ms(如 100ms),加快拉取频率; - 若消息量大,增大

max.poll.records(如 2000),减少拉取请求次数;

- 若消息量小,降低

-

避免频繁再平衡 :增大

session.timeout.ms(如 30s),减小heartbeat.interval.ms(如 3s),确保消费者能及时发送心跳。

4. 解决数据倾斜

- 优化分区键:避免用固定值或分布不均的键(如用户 ID 中少数活跃用户)作为分区键,改用哈希值取模或随机数分散分区;

- 二次分区:消费者拉取消息后,在本地按业务键二次分片(如用内存队列),由多个线程并行处理,均衡单分区的消息压力。

关键点与面试加分点

- 核心排查思路:先确认消费滞后量,再从消费者处理逻辑、资源、Kafka 配置、数据分布四方面定位原因;

- 加分点 :能说明消费组再平衡的影响(期间无法消费),解释

sticky分区策略的优势(减少分区移动),举例如何通过批量处理和异步化优化消费逻辑,提及 Kafka 监控工具的具体指标(如consumer_lag、fetch_latency_avg)。

记忆法

可总结为"消费慢,找三点:逻辑慢、资源浅、配置偏;查滞后,看指标,调参数,扩资源,均衡数据最关键",即消费变慢的核心原因、排查方向和解决思路。

消息队列的作用是什么?如何保证消息不丢失?

消息队列(如 Kafka、RabbitMQ、RocketMQ)是分布式系统中实现异步通信的核心组件,通过"生产者-队列-消费者"的模式解耦系统模块,同时具备削峰填谷、顺序保证等能力。在高并发场景中,消息丢失会导致业务数据不一致(如订单支付成功但库存未扣减),因此保证消息不丢失是消息队列使用的核心要求,需从生产、存储、消费三个环节设计保障机制。

一、消息队列的核心作用

1. 系统解耦

传统同步调用中,模块间直接依赖(如订单服务调用库存服务、支付服务),若某模块下线会导致整个链路失败。消息队列作为中间层,生产者只需将消息发送到队列,无需关心消费者是谁及是否在线,降低模块间耦合度。

- 示例:电商下单流程中,订单服务创建订单后,将消息发送到"订单创建队列",库存服务、物流服务、通知服务分别从队列消费,彼此独立升级和扩容。

2. 削峰填谷(应对流量波动)

秒杀、促销等场景中,流量会在短时间内激增(如每秒 10 万请求),直接冲击后端服务(如数据库)导致崩溃。消息队列可暂存峰值流量,消费者按自身处理能力匀速消费,避免服务过载。

- 示例:秒杀系统中,用户请求先进入消息队列,订单服务以每秒 1 万的速度从队列消费,超出队列容量的请求直接返回"活动火爆",保护后端系统。

3. 异步通信(提升响应速度)

同步调用中,每个环节的耗时会累积(如订单创建→库存扣减→支付→通知,总耗时 = 各步骤耗时之和)。消息队列支持异步处理,生产者发送消息后立即返回,消费者后台处理,减少用户等待时间。

- 示例:用户下单后,订单服务发送消息到队列后立即返回"下单成功",库存扣减和短信通知由消费者异步完成,用户无需等待后续步骤。

4. 顺序保证与重试机制

消息队列可保证消息按发送顺序被消费(如 Kafka 的分区内有序、RabbitMQ 的单队列有序),同时支持失败重试(消费者处理失败后,消息重新入队),避免因瞬时故障导致业务中断。

- 示例:物流轨迹更新消息需按时间顺序处理,消息队列确保"已揽收→运输中→派送中"的顺序,若某条消息处理失败,自动重试直至成功。

5. 数据缓冲与分发

在数据传输场景中(如日志收集),消息队列可作为缓冲层,接收大量分散的数据源(如应用服务器日志),再统一分发给下游系统(如 ELK 分析平台),避免数据源与下游系统的直接连接压力。

二、保证消息不丢失的核心机制

消息从生产到消费的全链路包含三个环节:生产者发送消息 →消息队列存储消息 →消费者处理消息,每个环节都可能因故障(如网络中断、服务宕机)导致消息丢失,需针对性设计保障措施。

1. 生产者环节:确保消息成功发送到队列

生产者发送消息时,可能因网络抖动、队列满等原因发送失败,需通过"确认机制"和"重试机制"保证消息不丢失。

-

发送确认(ACK)机制:消息队列返回发送结果,生产者收到成功确认后才视为发送完成,否则重试。

-

Kafka:通过

acks参数配置确认级别,acks=all表示需 leader 和所有 in-sync replica(ISR)都确认接收,才返回成功; -

RabbitMQ:开启

publisher confirms机制,生产者监听队列的确认回调,未收到确认则重试; -

代码示例(Kafka 生产者确认配置):

Properties props = new Properties(); props.put("bootstrap.servers", "localhost:9092"); props.put("key.serializer", "org.apache.kafka.common.serialization.StringSerializer"); props.put("value.serializer", "org.apache.kafka.common.serialization.StringSerializer"); props.put("acks", "all"); // 所有ISR副本确认 props.put("retries", 3); // 发送失败重试3次 KafkaProducer<String, String> producer = new KafkaProducer<>(props);

-

-

失败重试与幂等性 :发送失败时自动重试(如设置

retries=3),但需确保消息幂等(避免重复发送导致消费者重复处理),可通过消息唯一 ID(如 UUID)或 Kafka 的幂等生产者(enable.idempotence=true)实现。

2. 消息队列存储环节:确保消息持久化

消息队列本身需将消息持久化到磁盘,避免节点宕机导致内存中消息丢失,核心机制包括"持久化配置"和"副本机制"。

- 持久化到磁盘 :

- Kafka:消息写入分区日志文件(

.log),并通过log.flush.interval.messages配置刷盘频率(如每收到 1000 条消息刷盘一次); - RabbitMQ:队列需设置

durable=true,消息设置deliveryMode=2(持久化消息),确保消息写入磁盘而非内存;

- Kafka:消息写入分区日志文件(

- 副本机制(高可用) :消息队列通过多副本(Replica)存储消息,避免单节点故障丢失数据:

- Kafka:每个分区有 1 个 leader 和多个 follower,leader 负责读写,follower 同步 leader 数据,若 leader 宕机,follower 升级为新 leader;

- RocketMQ:通过多 master 多 slave 架构,消息同步到 slave 后才返回成功,master 宕机后 slave 可提供服务。

3. 消费者环节:确保消息被正确处理

消费者拉取消息后,可能因处理失败(如业务异常、服务宕机)导致消息未处理完成,需通过"手动确认"机制确保消息处理完成后才从队列删除。

-

手动确认(ACK)机制:消费者处理完消息后,主动向队列发送确认,队列收到确认后才删除消息;若未确认(如消费者宕机),队列会将消息重新分发给其他消费者。

-

Kafka:消费者通过提交偏移量(Offset)确认,处理完成后调用

commitSync()提交当前偏移量,下次从偏移量+1 处拉取; -

RabbitMQ:关闭自动确认(

autoAck=false),处理完成后调用channel.basicAck()手动确认; -

代码示例(RabbitMQ 手动确认):

channel.basicConsume(queueName, false, (consumerTag, delivery) -> { String message = new String(delivery.getBody()); try { processMessage(message); // 处理消息 channel.basicAck(delivery.getEnvelope().getDeliveryTag(), false); // 处理成功,手动确认 } catch (Exception e) { channel.basicNack(delivery.getEnvelope().getDeliveryTag(), false, true); // 处理失败,重新入队 } }, consumerTag -> {});

-

-

避免重复消费:手动确认机制可能导致消息重复(如消费者确认后宕机,队列未收到确认而重发),需在业务层实现幂等处理(如基于消息 ID 做唯一约束、使用分布式锁)。

关键点与面试加分点

- 核心作用:消息队列的核心是解耦、削峰、异步,同时提供顺序和重试保障;

- 消息不丢失:需覆盖生产(确认+重试)、存储(持久化+副本)、消费(手动确认+幂等)三个环节,缺一不可;

- 加分点 :能对比不同消息队列的保障机制差异(如 Kafka 的

acks级别 vs RabbitMQ 的持久化配置),说明幂等性实现的具体方案(如唯一 ID+Redis 去重),提及极端场景(如队列磁盘损坏)的应对措施(定期备份)。

记忆法

消息队列作用:"解耦削峰异步快,顺序重试分发带";消息不丢失:"生产确认加重试,存储持久多副本,消费手动要幂等,三关把控不丢失"。

数据库的 ACID 特性是什么?InnoDB 如何保证 ACID?

ACID 是数据库事务的四大核心特性,是衡量事务可靠性的基础标准。InnoDB 作为 MySQL 的默认存储引擎,通过日志机制、锁机制、MVCC(多版本并发控制)等技术,从底层实现了对 ACID 特性的保障,使其成为支持高并发事务的主流选择。

一、数据库的 ACID 特性

ACID 分别对应原子性(Atomicity)、一致性(Consistency)、隔离性(Isolation)、持久性(Durability),四者相互关联,共同保证事务的可靠性:

1. 原子性(Atomicity)

事务是不可分割的最小操作单元,要么全部执行成功,要么全部失败回滚,不允许部分执行。

- 示例:转账事务(A 账户减 100 元,B 账户加 100 元),若 B 账户加款失败,A 账户的扣款必须回滚,确保两人总金额不变。

2. 一致性(Consistency)

事务执行前后,数据库从一个一致状态转变为另一个一致状态,即数据需满足预设的约束(如主键唯一、外键关联、业务规则)。

- 示例:转账前 A 有 500 元、B 有 300 元(总 800 元),事务执行后无论成功与否,总金额仍为 800 元,不会出现 A 减了但 B 没加(总 700 元)的不一致状态。

3. 隔离性(Isolation)

多个事务并发执行时,每个事务的操作不应被其他事务干扰,事务之间相互"隔离"。隔离性通过隔离级别控制,级别越高,并发干扰越小,但性能消耗越大。

- 示例:事务 T1 正在修改 A 账户余额,事务 T2 此时读取 A 的余额,应看不到 T1 未提交的中间结果(避免脏读)。

4. 持久性(Durability)

事务一旦提交,其对数据的修改是永久性的,即使数据库发生宕机(如断电、崩溃),重启后也能恢复到事务提交后的状态。

- 示例:订单提交事务成功后,即使数据库服务器立即断电,重启后订单记录仍存在。

二、InnoDB 对 ACID 特性的保障机制

InnoDB 通过多层次技术设计,分别实现对四大特性的支持,核心依赖日志系统、锁机制和 MVCC。

1. 原子性(Atomicity):基于 undo 日志实现回滚

InnoDB 通过 undo 日志(撤销日志) 记录事务执行过程中的反向操作,当事务需要回滚(如执行 ROLLBACK 或发生异常)时,通过 undo 日志撤销已执行的修改,恢复到事务开始前的状态。

- undo 日志工作流程 :

- 事务开始时,InnoDB 为每个修改操作(如

INSERT/UPDATE/DELETE)生成对应的 undo 日志:INSERT的 undo 日志记录"删除该记录"的操作;UPDATE的 undo 日志记录"将字段改回原值"的操作;

- 事务执行失败或调用

ROLLBACK时,InnoDB 反向执行 undo 日志中的操作,撤销所有修改; - 事务提交后,undo 日志不会立即删除,而是标记为可回收,供 MVCC 读取历史版本使用。

- 事务开始时,InnoDB 为每个修改操作(如

- 示例 :事务执行

UPDATE account SET balance = 400 WHERE id = 1(原余额 500),undo 日志记录"UPDATE account SET balance = 500 WHERE id = 1",回滚时执行该 undo 操作,恢复余额为 500。

2. 一致性(Consistency):多机制协同保障

一致性是事务的最终目标,由原子性、隔离性、持久性共同支撑,同时依赖数据库的约束机制:

- 原子性保障:确保事务要么全成要么全败,避免部分修改导致的数据不一致;

- 隔离性保障:通过锁和 MVCC 防止并发事务相互干扰(如脏读、幻读),维持中间状态的一致性;

- 持久性保障:确保提交的修改不丢失,维持最终状态的一致性;

- 约束机制:InnoDB 支持主键约束、外键约束、唯一约束、check 约束等,事务执行过程中若违反约束(如插入重复主键),会立即中断并回滚,防止不一致数据写入。

- 示例 :外键约束

orders.user_id REFERENCES users.id确保订单的user_id必须对应存在的用户,若插入不存在的user_id,事务回滚,避免孤儿订单。

3. 隔离性(Isolation):基于锁和 MVCC 实现

InnoDB 提供四种隔离级别(读未提交、读已提交、可重复读、串行化),通过 锁机制 控制并发修改,MVCC 控制并发读取,平衡隔离性和性能:

- 锁机制 :

- 行级锁:对修改的行加锁(如

SELECT ... FOR UPDATE加排他锁),防止其他事务同时修改; - 间隙锁/Next-Key Lock:在可重复读级别下,通过锁定记录间隙防止插入新记录,解决幻读问题;

- 行级锁:对修改的行加锁(如

- MVCC(多版本并发控制) :事务读取数据时,通过 undo 日志获取记录的历史版本(而非直接读取当前版本),实现"读不加锁",避免阻塞写操作:

- 每个记录包含

DB_TRX_ID(最后修改的事务 ID)和DB_ROLL_PTR(指向 undo 日志的指针); - 事务启动时生成

Read View(读视图),通过对比DB_TRX_ID与Read View中的事务 ID,判断记录版本是否可见。

- 每个记录包含

- 示例:事务 T1(ID=100)修改记录 A 为值 200,未提交时,事务 T2(ID=200)读取 A,通过 MVCC 获取 A 的历史版本(值 100),避免脏读,保障隔离性。

4. 持久性(Durability):基于 redo 日志和双写缓冲实现

InnoDB 通过 redo 日志(重做日志) 确保事务提交后修改不丢失,即使数据库崩溃,重启后也能通过 redo 日志恢复数据。

- redo 日志工作流程 :

- 事务执行时,InnoDB 先将修改操作写入 redo 日志缓冲区(内存);

- 事务提交时,调用

fsync()将 redo 日志缓冲区的数据刷入磁盘(redo 日志文件),此过程称为"日志先行(WAL,Write-Ahead Logging)"; - 后台线程定期将内存中的数据页(脏页)刷入磁盘(数据文件);

- 若数据库崩溃,重启时 InnoDB 会重做所有已提交但未刷入数据文件的 redo 日志,恢复数据。

- 双写缓冲(Doublewrite Buffer) :为解决"部分页写入"问题(如刷盘时断电,数据页只写入一半导致损坏),InnoDB 引入双写缓冲:

- 脏页刷盘前,先复制到内存中的双写缓冲;

- 将双写缓冲的数据写入磁盘的双写区域(连续空间);

- 再将脏页数据写入实际数据文件;若步骤 3 失败,重启时可从双写区域恢复完整数据页,避免数据损坏。

关键点与面试加分点

- ACID 核心关联:原子性、隔离性、持久性是手段,一致性是最终目标;

- InnoDB 核心技术:undo 日志保证原子性,redo 日志+双写缓冲保证持久性,锁+MVCC 保证隔离性,四者协同保证一致性;

- 加分点 :能解释 WAL 机制的优势(先写日志再写数据,日志小且顺序写,性能更高),说明 MVCC 中

Read View的生成时机(读已提交级别每次查询生成,可重复读级别事务启动时生成),对比 InnoDB 与 MyISAM(MyISAM 不支持事务和行锁,无法保证 ACID)。

记忆法

ACID 特性:"原子不可拆,一致状态佳,隔离无干扰,持久不丢失";InnoDB 保障:"undo 回滚保原子,redo 双写保持久,锁加 MVCC 保隔离,协同约束保一致"。

在 RR 隔离级别下,事务 T1 开启后执行查询操作;同时事务 T2 插入数据并提交;T1 后续执行更新操作时,能否更新到 T2 插入的数据?为什么?(提示:更新前的查询是否依赖 MVCC)

在 InnoDB 的可重复读(RR)隔离级别下,事务 T1 后续执行更新操作时,能更新到 T2 已提交的数据 。核心原因是:RR 级别下,事务的"查询操作"默认是快照读(Snapshot Read) (依赖 MVCC 机制,读取事务启动时的快照数据),但"更新操作"前会触发当前读(Current Read)(读取最新已提交的数据),因此 T1 能感知到 T2 提交的新数据。

一、事务执行过程复现

为清晰说明,先通过具体 SQL 复现整个场景,假设表 user 结构如下(主键 id,普通字段 name):

CREATE TABLE `user` (

`id` int NOT NULL PRIMARY KEY AUTO_INCREMENT,

`name` varchar(20) NOT NULL

) ENGINE=InnoDB DEFAULT CHARSET=utf8mb4;1. 事务时序流程

| 时间 | 事务 T1(RR 隔离级别) | 事务 T2(RR 隔离级别) |

|---|---|---|

| 1 | START TRANSACTION;(开启事务) |

- |

| 2 | SELECT * FROM user;(查询结果为空) |

- |

| 3 | - | START TRANSACTION; |

| 4 | - | INSERT INTO user (name) VALUES ('Alice');(插入数据,id=1) |

| 5 | - | COMMIT;(提交事务,数据持久化) |

| 6 | SELECT * FROM user;(仍为空,快照读) |

- |

| 7 | UPDATE user SET name='Alice2' WHERE id=1;(更新成功,影响 1 行) |

- |

| 8 | SELECT * FROM user;(查询到 id=1, name='Alice2') |

- |

从流程可见:T1 在步骤 6 的查询(快照读)仍看不到 T2 提交的数据,但步骤 7 的更新操作能成功修改 T2 插入的记录,步骤 8 的查询(此时已基于更新后的快照)能看到结果。

二、核心原因:快照读与当前读的区别

RR 隔离级别的"可重复读"仅针对快照读 (普通 SELECT),而更新、删除、加锁查询等操作会触发当前读,两者的底层机制不同,导致对数据的可见性不同。

1. 快照读(Snapshot Read):依赖 MVCC,看不到新提交数据

快照读是 RR 级别下普通 SELECT 的默认行为,其核心是通过 MVCC(多版本并发控制) 读取事务启动时的"数据快照",而非实时数据:

- 事务 T1 启动时(步骤 1),InnoDB 会生成一个 Read View(读视图),记录当前活跃的事务 ID 范围;

- 步骤 2 和步骤 6 的

SELECT会通过 Read View 筛选数据:仅读取"事务 ID 小于当前 Read View 最小活跃 ID"或"属于当前事务"的版本; - 事务 T2 的提交事务 ID 大于 T1 的 Read View 活跃 ID 范围,因此 T1 的快照读无法看到 T2 插入的新记录(即使 T2 已提交),这就是"可重复读"的实现------同一事务内多次普通查询看到的是同一快照。

2. 当前读(Current Read):读取最新数据,能看到新提交数据

当执行 UPDATE、DELETE、INSERT 或加锁查询(如 SELECT ... FOR UPDATE、SELECT ... LOCK IN SHARE MODE)时,InnoDB 会触发当前读,核心是"读取数据库中最新的已提交数据",而非快照:

- 事务 T1 执行

UPDATE user SET name='Alice2' WHERE id=1时(步骤 7),为确保更新的是最新数据(避免覆盖其他事务的修改),InnoDB 会先对id=1的记录加排他锁(X锁); - 加锁前,会执行一次"当前读",查询

id=1的最新记录------此时 T2 已提交,该记录已存在且状态为"已提交",因此当前读能看到这条记录; - 基于当前读获取的最新记录,执行更新操作,修改后的数据会生成新的版本,后续 T1 内的查询(步骤 8)会读取这个新版本(此时 T1 的快照已更新为当前版本)。

三、关键结论与面试加分点

- 核心结论:RR 级别下,普通查询(快照读)看不到事务启动后其他事务提交的新数据,但更新操作(触发当前读)能看到最新已提交数据,因此 T1 能更新 T2 插入的数据;

- 面试加分点 :

- 能区分"快照读"与"当前读"的适用场景:快照读对应普通

SELECT,当前读对应UPDATE/DELETE/加锁查询; - 解释 Read View 的生成时机:RR 级别下 Read View 在事务第一次快照读时生成(而非事务启动时),若 T1 步骤 1 后未立即查询,步骤 3 再查询,Read View 会在步骤 3 生成,此时若 T2 已提交,步骤 3 的查询能看到 T2 数据;

- 举例说明其他当前读场景:如 T1 执行

SELECT * FROM user WHERE id=1 FOR UPDATE,即使是查询,也会触发当前读,能看到 T2 提交的数据。

- 能区分"快照读"与"当前读"的适用场景:快照读对应普通

记忆法

可总结为"RR快照读,视图定范围;更新当前读,最新数据见;T2提交后,T1更新能改全",即 RR 级别下不同读操作的可见性差异及更新时的逻辑。

什么是 B + 树?为什么 InnoDB 要用 B + 树作为索引的底层结构?

B + 树是一种多路平衡查找树,是在 B 树基础上优化而来的索引结构,其核心特点是"非叶子节点仅存储索引键,叶子节点存储完整数据或主键,并按顺序相连"。InnoDB 选择 B + 树作为索引底层结构,是因为它能高效适配磁盘 IO 特性,平衡查询效率、范围查询能力和数据存储成本,是当前关系型数据库索引的最优选择之一。

一、什么是 B + 树?

B + 树的结构需从"树的层级、节点内容、叶子节点特性"三方面准确描述,其设计核心是"减少磁盘 IO 次数"和"优化范围查询":

1. 基本结构定义

B + 树是"m 阶"多路平衡查找树(m 为阶数,代表每个节点最多有 m 个子节点),结构如下:

- 非叶子节点:仅存储"索引键"和"子节点指针",不存储实际数据;每个非叶子节点的索引键按升序排列,子节点指针对应索引键的区间(如键 [10,20,30] 对应 4 个指针,分别指向键 <10、10≤键<20、20≤键<30、键≥30 的子节点);

- 叶子节点:存储"索引键 + 实际数据"(聚簇索引)或"索引键 + 主键"(非聚簇索引),所有叶子节点按索引键升序排列,且通过"双向链表"相连(便于范围查询时快速遍历相邻叶子节点);

- 平衡性:树的左右子树高度一致,确保任意查询的路径长度相同,避免极端情况下的低效查询。

2. 与 B 树的核心区别

B 树是 B + 树的前身,两者的关键差异决定了 B + 树更适合作为索引结构:

| 对比维度 | B 树 | B + 树 |

|---|---|---|

| 非叶子节点内容 | 存储"索引键 + 部分数据" | 仅存储"索引键 + 子节点指针" |

| 叶子节点特性 | 叶子节点无特殊关联,无序相连 | 叶子节点有序且双向链表相连 |

| 数据存储位置 | 非叶子和叶子节点均可能存数据 | 仅叶子节点存数据 |

| 范围查询效率 | 需遍历多个分支,效率低 | 直接遍历叶子节点链表,效率高 |

二、InnoDB 选择 B + 树的核心原因

InnoDB 作为磁盘存储的数据库引擎,数据读写依赖磁盘 IO(IO 速度远低于内存),B + 树的设计恰好适配磁盘 IO 特性,同时满足高效单点查询、范围查询和排序需求,具体原因如下:

1. 减少磁盘 IO 次数,提升查询效率

磁盘 IO 是数据库查询的主要性能瓶颈,B + 树通过"多路平衡"结构降低树的高度,从而减少每次查询的 IO 次数:

- 树高度低:B + 树是多路树(阶数 m 通常较大,如 m=1000),即使存储千万级数据,树高度仅 3-4 层(如 m=1000 时,3 层可存储 1000×1000×1000=10 亿条数据);

- 单次查询 IO 少:每次查询只需访问 3-4 个节点(非叶子节点 2-3 个 + 叶子节点 1 个),每个节点对应一次磁盘 IO,因此千万级数据查询仅需 3-4 次 IO,远优于二叉查找树(高度可能达 20 层,20 次 IO)和哈希索引(不支持范围查询)。

2. 叶子节点有序相连,优化范围查询

业务中频繁出现范围查询(如 WHERE id BETWEEN 100 AND 200、ORDER BY id DESC),B + 树的叶子节点特性完美适配这类场景:

- 叶子节点有序:所有叶子节点按索引键升序排列,无需额外排序;

- 双向链表相连:范围查询时,找到起始叶子节点后,可通过链表直接遍历后续所有符合条件的叶子节点,无需回溯非叶子节点;

- 对比 B 树:B 树的范围查询需从根节点开始多次遍历不同分支,效率远低于 B + 树;对比哈希索引:哈希索引是无序的,无法支持范围查询,只能做等值查询。

3. 非叶子节点仅存索引键,提升节点存储密度

B + 树非叶子节点不存储数据,仅存储索引键和指针,相同磁盘页大小下,单个节点能存储更多索引键,进一步降低树高度:

- 假设磁盘页大小为 16KB,索引键为 8B(如 bigint 主键),指针为 8B,每个非叶子节点可存储 16×1024/(8+8)=1024 个索引键,对应 1025 个指针(即阶数 m=1025);

- 若用 B 树,非叶子节点需额外存储数据(如 1KB/条),单个节点仅能存储 16 个索引键,树高度会大幅增加,IO 次数增多。

4. 数据集中存储在叶子节点,便于维护和缓存

B + 树的所有数据集中在叶子节点,带来两个优势:

- 维护成本低:插入、删除数据时,仅需修改叶子节点及相邻节点(必要时做平衡调整),非叶子节点无需频繁修改;

- 缓存效率高:数据库缓存(如 InnoDB 的 Buffer Pool)可优先缓存叶子节点数据,而 B 树的非叶子节点也存数据,会占用缓存空间,导致有效数据缓存率降低。

三、面试加分点与记忆法

-

面试加分点:

- 对比哈希索引的不足:哈希索引仅支持等值查询,不支持范围查询和排序,且存在哈希冲突,因此 InnoDB 不将哈希作为默认索引;

- 解释 B + 树的"平衡"机制:插入数据时若节点满,会触发"分裂"(拆分为两个节点,向上合并索引键);删除数据时若节点空,会触发"合并",确保树高度平衡;

- 结合 InnoDB 实际场景:InnoDB 的聚簇索引叶子节点存完整数据行,非聚簇索引叶子存主键,B + 树的结构能高效支持"主键查询"和"二级索引查询"。

-

记忆法:可总结为"B + 多路平衡树,非叶存键叶存数;高度低 IO 少,范围查询链表好;InnoDB 选它因,高效适配磁盘情",即 B + 树的结构特点和 InnoDB 选择它的核心原因。

聚簇索引和非聚簇索引的区别是什么?InnoDB 中聚簇索引的存储结构是怎样的?

聚簇索引(Clustered Index)和非聚簇索引(Non-Clustered Index)是数据库索引的两种核心类型,核心差异在于"数据是否与索引键存储在一起"。InnoDB 以聚簇索引为核心设计,其聚簇索引通常与主键绑定,直接决定数据的物理存储顺序,而非聚簇索引(二级索引)需依赖聚簇索引实现查询,两者的设计直接影响 InnoDB 的查询效率。

一、聚簇索引和非聚簇索引的核心区别

两者的区别需从"数据存储位置、叶子节点内容、主键依赖、查询效率、更新影响"等维度对比,具体如下表所示:

| 对比维度 | 聚簇索引(Clustered Index) | 非聚簇索引(Non-Clustered Index) |

|---|---|---|

| 数据存储位置 | 索引与数据"聚簇"存储,数据物理顺序与索引键顺序一致 | 索引与数据分离存储,数据物理顺序与索引键顺序无关 |

| 叶子节点内容 | 存储完整的数据行(包含所有字段值) | 存储索引键 + 聚簇索引键(通常是主键),不存完整数据 |

| 主键依赖 | 必须依赖主键(InnoDB 中若未显式指定主键,会自动生成隐藏主键) | 依赖聚簇索引,查询时需通过聚簇索引键"回表"获取完整数据 |

| 数量限制 | 一张表仅能有 1 个(数据物理顺序唯一) | 一张表可有多个(如普通索引、联合索引) |

| 单点查询效率 | 高效(直接从叶子节点获取完整数据,无需回表) | 较低(需先查非聚簇索引得主键,再查聚簇索引得数据,两次查询) |

| 范围查询效率 | 极高(数据按索引键有序存储,直接遍历叶子节点即可) | 较高(索引键有序,但需回表,效率低于聚簇索引) |

| 更新影响 | 若更新索引键(如主键),会导致数据物理位置移动,开销大 | 仅更新索引键和主键,不影响数据物理位置,开销小 |

| 典型引擎支持 | InnoDB(默认主键为聚簇索引) | MyISAM(所有索引均为非聚簇索引)、InnoDB(二级索引) |

关键示例:

假设表 user 有主键 id(聚簇索引)和普通索引 name(非聚簇索引),数据如下:

| id(主键) | name(普通索引) | age |

|---|---|---|

| 1 | Alice | 20 |

| 2 | Bob | 25 |

| 3 | Charlie | 30 |

- 聚簇索引(id) :叶子节点存储完整数据行(1,Alice,20)、(2,Bob,25)、(3,Charlie,30),数据物理顺序按

id升序排列; - 非聚簇索引(name) :叶子节点存储(Alice,1)、(Bob,2)、(Charlie,3),查询

name='Bob'时,先拿到主键2,再查聚簇索引获取完整数据(2,Bob,25),这个过程称为"回表"。

二、InnoDB 中聚簇索引的存储结构

InnoDB 的聚簇索引与主键强绑定,其存储结构基于 B + 树实现,核心特点是"索引结构决定数据物理存储顺序",具体结构如下:

1. 聚簇索引的 B + 树结构

InnoDB 聚簇索引的 B + 树分为"非叶子节点"和"叶子节点",层级通常为 3-4 层(适配千万级数据):

- 非叶子节点:仅存储"主键(聚簇索引键)"和"子节点指针",不存储数据;例如,非叶子节点存储主键区间 [1-1000, 1001-2000, ...],每个区间对应一个子节点指针,指向更低层级的索引节点;

- 叶子节点 :存储"完整的数据行",包括主键和所有其他字段(如

name、age、phone等);所有叶子节点按主键升序排列,且通过双向链表相连,支持高效的范围查询(如id BETWEEN 100 AND 200); - 数据物理存储:InnoDB 的数据按"页(Page)"存储(默认页大小 16KB),聚簇索引的叶子节点与数据页一一对应,即一个叶子节点对应一个数据页,数据页内的记录按主键有序排列。

2. 聚簇索引的生成规则

InnoDB 会按以下优先级自动生成聚簇索引,确保每张表有且仅有一个聚簇索引:

- 显式指定主键 :若表定义

PRIMARY KEY id,则id作为聚簇索引键; - 唯一非空索引 :若未显式指定主键,InnoDB 会选择第一个"非空唯一索引"(如

UNIQUE NOT NULL name)作为聚簇索引; - 隐藏主键 :若既无主键也无唯一非空索引,InnoDB 会自动生成一个隐藏的 6 字节主键(

DB_ROW_ID),作为聚簇索引键,该主键自增,用户无法直接访问。

3. 聚簇索引的优势与注意事项

- 优势 :

- 主键查询效率极高:直接通过聚簇索引叶子节点获取完整数据,无需回表;

- 范围查询高效:数据按主键有序存储,范围查询时只需遍历叶子节点链表,无需全表扫描;

- 注意事项 :

- 避免用频繁更新的字段作为主键:若主键更新(如

id从 1 改为 100),会导致数据物理位置移动,触发页分裂,开销大; - 避免用过长字段作为主键:非聚簇索引的叶子节点存储主键,主键过长会导致非聚簇索引体积增大,占用更多磁盘和缓存空间。

- 避免用频繁更新的字段作为主键:若主键更新(如

三、面试加分点与记忆法

-

面试加分点:

- 对比 InnoDB 与 MyISAM 的索引差异:MyISAM 无聚簇索引,所有索引均为非聚簇索引,叶子节点存储数据行的物理地址(而非主键),查询时直接通过地址找数据,无需回表,但范围查询效率低于 InnoDB 聚簇索引;

- 解释"覆盖索引"优化:若查询的字段均在非聚簇索引中(如联合索引

(name, age),查询SELECT name, age FROM user WHERE name='Alice'),无需回表,直接从非聚簇索引叶子节点获取数据,此时非聚簇索引相当于"临时覆盖索引"; - 分析聚簇索引对分页查询的优化:分页查询

LIMIT 10000, 10时,InnoDB 可通过聚簇索引快速定位到第 10000 条记录,效率高于 MyISAM 的全表扫描。

-

记忆法:可总结为"聚簇索引数据随,主键唯一叶子存;非聚簇存主键,回表查数据;InnoDB 主键聚,查询效率高",即两者的核心差异及 InnoDB 聚簇索引的特点。

MySQL 索引为什么查询速度快?

MySQL 索引查询速度快的核心原因是"减少磁盘 IO 次数"------索引通过有序的数据结构(如 B + 树)将"无序的全表扫描"转化为"有序的精准定位",避免遍历所有数据行,同时结合多种优化机制(如范围查询优化、缓存、索引下推)进一步提升效率,从根本上解决了磁盘存储场景下的查询性能瓶颈。

一、核心原因:减少磁盘 IO,避免全表扫描

数据库中的数据存储在磁盘上,磁盘 IO 速度(约毫秒级)远低于内存操作(约纳秒级),全表扫描时需逐行读取磁盘数据,IO 次数多、耗时久;而索引通过以下方式减少 IO,实现快速查询:

1. 索引是"有序结构",支持快速定位

索引基于 B + 树(InnoDB)或 B 树(MyISAM)等有序结构构建,索引键按升序/降序排列,查询时可通过"二分查找"快速定位到目标数据,而非逐行扫描:

- 示例:查询

WHERE id=100,无索引时需从磁盘第 1 行开始,逐行读取直到找到id=100(假设表有 100 万行,需 100 万次 IO); - 有索引时:B + 树高度为 3 层,只需访问非叶子节点 2 次(定位

id=100所在的叶子节点)、叶子节点 1 次(获取数据),共 3 次 IO,效率提升数十万倍。

2. B + 树"多路平衡"特性,降低树高度

InnoDB 采用 B + 树作为索引结构,B + 树是"多路平衡查找树",每个节点可存储多个索引键(阶数高),从而降低树的高度:

- 阶数优势:假设 B + 树阶数为 1000(每个非叶子节点存储 1000 个索引键、1001 个指针),3 层树可存储 1000×1000×1000=10 亿条数据,即使存储千万级数据,树高度仅 3-4 层;

- IO 次数固定:无论查询哪条数据,都只需 3-4 次 IO,与数据量无关,而全表扫描的 IO 次数随数据量线性增长。

二、辅助原因:优化查询流程,减少数据处理成本

除减少 IO 外,MySQL 还通过多种索引优化机制,进一步降低数据处理成本,提升查询速度:

1. 范围查询高效,无需额外排序

B + 树的叶子节点按索引键有序排列且通过双向链表相连,范围查询(如 id BETWEEN 100 AND 200、name LIKE 'A%')时,无需额外排序,直接遍历叶子节点链表即可:

- 无索引时:需全表扫描所有数据,将符合条件的记录放入内存后排序,耗时久(如 100 万行数据排序需秒级);

- 有索引时:找到范围起始点(

id=100)后,通过叶子节点链表依次读取id=101、id=102...id=200,无需排序,耗时毫秒级。

2. 索引缓存(Buffer Pool),减少重复 IO

InnoDB 有"Buffer Pool"(缓冲池),会将频繁访问的索引节点和数据页缓存到内存中,后续查询若命中缓存,无需再次访问磁盘:

- 示例:多次查询

id=100,第一次查询需 3 次磁盘 IO,之后查询直接从 Buffer Pool 读取索引和数据,仅需内存操作,速度提升 1000 倍以上; - 缓存策略:Buffer Pool 采用"LRU(最近最少使用)"算法,优先缓存热点索引和数据,确保高频查询的缓存命中率。

3. 覆盖索引,避免"回表"操作

若查询的字段均包含在索引中(如联合索引 (name, age),查询 SELECT name, age FROM user WHERE name='Alice'),MySQL 无需通过索引键查找完整数据。

建立 MySQL 索引时需要考虑哪些因素?

建立 MySQL 索引是优化查询性能的核心手段,但不合理的索引会导致查询效率下降、磁盘空间浪费、数据更新变慢等问题。建立索引时需综合考虑业务查询场景、数据特征、索引维护成本等多方面因素,确保索引"有用、高效、低成本"。

一、字段选择:优先为高频查询字段建立索引

索引的核心价值是加速查询,因此需优先为"频繁出现在 WHERE、JOIN、ORDER BY、GROUP BY 中的字段"建立索引,避免为"极少查询或从不查询的字段"建索引。

1. 高频查询字段优先

WHERE条件字段 :如用户表中频繁查询WHERE phone = '138xxxx',为phone建索引可避免全表扫描;JOIN关联字段 :如订单表orders.user_id与用户表user.id关联查询,为orders.user_id建索引可加速关联;- 排序/分组字段 :如

ORDER BY create_time DESC或GROUP BY category_id,为create_time或category_id建索引可避免查询时的文件排序(Using filesort),降低 CPU 消耗。

2. 区分度高的字段更适合

字段的区分度( cardinality )是指字段中不同值的比例(如主键区分度为 100%,性别字段区分度约 50%)。区分度越高,索引过滤效果越好,查询时能快速定位到少量数据:

- 适合建索引:如

id(主键)、phone(唯一)、email等,区分度高,索引能过滤掉绝大多数无关数据; - 不适合建索引:如

gender(仅男/女)、status(仅 0/1/2)等,区分度低,即使建索引,也需扫描大量数据(甚至接近全表扫描),效率提升有限,反而浪费空间。

二、索引类型与结构:匹配业务查询场景

MySQL 支持多种索引类型(聚簇索引、非聚簇索引、联合索引、前缀索引等),需根据查询场景选择合适类型,避免"一刀切"用单一索引。

1. 联合索引:适配多字段查询,遵循最左前缀原则

当查询条件包含多个字段(如 WHERE a = 1 AND b = 2 AND c = 3),建立联合索引 (a, b, c) 比单字段索引更高效,但需注意:

- 最左前缀原则 :联合索引仅能匹配"从左到右的连续前缀",如

(a, b, c)可优化a=?、a=? AND b=?、a=? AND b=? AND c=?,但无法优化b=?或b=? AND c=?; - 字段顺序 :将区分度高的字段放左侧(如

a区分度 >b),过滤效果更好;将范围查询字段放右侧(如a=1 AND b>2,b放右侧,避免左侧字段用范围导致后续字段失效)。

2. 前缀索引:优化长字符串字段

对于长字符串字段(如 varchar(255) 的 url、address),直接建索引会导致索引体积过大(占用更多磁盘和缓存),可使用前缀索引:

- 原理:仅对字符串的前 N 个字符建索引(如

ALTER TABLE t ADD INDEX idx_url (url(20))),平衡索引大小和区分度; - 注意:需通过

SELECT COUNT(DISTINCT LEFT(url, N)) / COUNT(*) FROM t计算不同 N 的区分度,选择区分度接近完整字段的最小 N(如 N=20 时区分度达 95%)。

3. 聚簇索引与非聚簇索引:结合存储引擎特性

- InnoDB:主键默认是聚簇索引(数据与索引存储在一起),查询主键时效率极高;非聚簇索引(二级索引)需回表,建议通过"覆盖索引"(查询字段均在二级索引中)避免回表;

- MyISAM:所有索引均为非聚簇索引(索引与数据分离),无回表概念,但范围查询效率低于 InnoDB 聚簇索引,建索引时需更关注联合索引优化。

三、索引数量:并非越多越好,控制总量

索引会占用磁盘空间,且数据更新(INSERT/UPDATE/DELETE)时需同步维护索引(如 B + 树分裂/合并),索引越多,更新成本越高。

1. 避免冗余索引

冗余索引是指"功能上重复的索引",如已建联合索引 (a, b),再建 (a) 就是冗余索引((a, b) 已包含 (a) 的功能),会浪费空间并增加更新开销。

2. 控制单表索引数量

单表索引数量建议不超过 5-6 个,过多索引会导致:

- 磁盘空间占用激增(如 1000 万行表,每个索引可能占用几十 MB 空间);

INSERT语句变慢(需同时更新多个索引的 B + 树);- 优化器选择困难(索引过多时,MySQL 优化器可能选错索引,反而降低查询效率)。

四、避免索引失效:规避破坏索引使用的操作

即使建立索引,若查询语句存在特定操作,可能导致索引失效,需特别注意:

1. 索引字段参与函数操作或计算

如 WHERE SUBSTR(phone, 1, 3) = '138'(对 phone 用函数)、WHERE id + 1 = 100(对 id 计算),会导致索引失效,改为 WHERE phone LIKE '138%' 或 WHERE id = 99 可使用索引。

2. 隐式类型转换

如字段 phone 是 varchar 类型,查询 WHERE phone = 13800000000(传入数字),MySQL 会隐式转换为 WHERE CAST(phone AS UNSIGNED) = 13800000000,导致索引失效,需改为 WHERE phone = '13800000000'(传入字符串)。

3. 范围查询后的字段失效

联合索引中,范围查询(>, <, BETWEEN, LIKE %...)后的字段无法使用索引,如 WHERE a = 1 AND b > 2 AND c = 3,(a, b, c) 索引中,c 会失效,需将范围字段放最后。

4. NOT IN、!=、IS NOT NULL 可能失效

这些操作通常无法有效利用索引(全表扫描可能更快),如 WHERE status != 1 建议改为 WHERE status = 0 OR status = 2(若状态值少)。

五、数据特征与更新频率:索引需适配数据变化

1. 数据量小的表无需建索引

若表数据量极少(如几百行),全表扫描速度可能比索引查询更快(索引查询需额外访问索引结构),无需建索引。

2. 高频更新字段慎用索引

如订单表的 status 字段(频繁从"待支付"改为"已支付"),若建索引,每次更新需维护索引结构(B + 树调整),导致更新变慢,建议仅在该字段频繁查询时建索引。

3. 考虑数据分布的倾斜性

若字段值分布极不均衡(如 99% 的记录 status = 0,1% status = 1),查询 status = 1 时索引有效(快速定位少量数据),但查询 status = 0 时,MySQL 可能选择全表扫描(比索引查询更快),需结合实际查询场景判断。

关键点与面试加分点

- 核心原则:索引是"以空间换时间"的权衡,需结合查询频率、区分度、更新成本综合判断;

- 加分点 :能举例说明联合索引的最左前缀原则,解释前缀索引的区分度计算方法,分析索引失效的具体场景及优化方案,提及

EXPLAIN工具在索引有效性验证中的使用(如type列是否为ref/range,key列是否命中索引)。

记忆法

可总结为"高频高区分,类型要适配;数量别太多,失效要规避;数据特征记,索引才高效",即建立索引时需考虑的核心因素及权衡原则。

请挑选操作系统的一个知识点(如进程调度、内存管理等)进行讲解。

内存管理:从物理内存到虚拟内存的抽象与优化

操作系统的内存管理是核心功能之一,负责对计算机内存(RAM)进行分配、回收、保护和扩展,确保多个进程高效、安全地共享有限的物理内存资源。其核心目标是"提高内存利用率"和"支持多进程并发运行",主要通过物理内存分配 、虚拟内存机制 、内存保护三大技术实现。

一、物理内存分配:如何为进程划分内存空间

物理内存是实际的硬件存储单元(如 DDR 内存),进程运行时需占用物理内存。操作系统需通过合理的分配策略,避免内存碎片,提高利用率。

1. 连续分配方式:早期简单但低效的方案

- 单一连续分配:内存分为"系统区"和"用户区",仅允许一个用户进程占用用户区,适用于单道程序设计(如早期 DOS),缺点是无法支持多进程并发;

- 分区分配 :将用户区划分为多个连续分区,每个分区分配给一个进程,分为:

- 固定分区:分区大小和数量固定,可能导致"内部碎片"(分区未被完全利用,如 100MB 分区只用到 50MB);

- 动态分区:根据进程需求动态划分分区,分配时需查找"大小合适的空闲分区"(算法有首次适应、最佳适应、最坏适应),缺点是频繁分配回收后产生"外部碎片"(多个小空闲分区无法满足大进程需求)。

2. 非连续分配方式:现代操作系统的主流方案

为解决连续分配的碎片问题,现代 OS 采用非连续分配,允许进程的内存空间分散在物理内存的不同区域,主要包括:

- 分页存储管理 :

- 将物理内存划分为大小相等的"页框"(如 4KB),进程逻辑地址划分为"页面"(与页框大小相同);

- 进程的每个页面可装入任意空闲页框,通过"页表"记录页面与页框的映射关系;

- 优点:无外部碎片(页框大小固定),仅可能有少量内部碎片(最后一个页面未装满);

- 分段存储管理 :

- 按进程的逻辑结构(如代码段、数据段、栈段)划分"段"(段大小不固定),每个段有独立的段号;

- 通过"段表"记录段的基地址和长度,实现逻辑地址到物理地址的映射;

- 优点:符合程序逻辑,便于共享(如多个进程共享代码段)和保护(如只读代码段);

- 段页式管理:结合分页和分段的优点,先将进程分段,再将每段分页,既满足逻辑结构需求,又避免碎片问题(如 Linux、Windows 均采用类似机制)。

二、虚拟内存:突破物理内存限制的核心机制

物理内存容量有限(如 16GB),当多进程并发或单个进程内存需求超过物理内存时,虚拟内存通过"磁盘与内存的交换"扩展可用内存,实现"部分装入、按需调页"。

1. 核心原理:局部性原理

程序运行时具有"时间局部性"(近期访问的内存会再次访问,如循环变量)和"空间局部性"(访问某内存地址时,附近地址也可能被访问,如数组遍历),因此无需将进程全部装入内存,仅装入当前活跃部分即可正常运行。

2. 请求分页机制:虚拟内存的实现基础

- 虚拟地址空间:每个进程拥有独立的"虚拟地址空间"(如 64 位系统可达 2^64 字节),与物理内存地址分离,由 OS 负责映射;

- 页表扩展:在分页基础上,页表项增加"状态位"(是否在内存)、"磁盘地址"(不在内存时的磁盘位置)等;

- 缺页中断:当进程访问的页面不在内存时,触发缺页中断,OS 从磁盘换入该页面到内存(若内存已满,需换出部分页面);

- 页面置换算法 :内存满时,选择哪个页面换出到磁盘,直接影响性能,常见算法:

- LRU(最近最少使用):换出最近最久未使用的页面,符合局部性原理,但实现成本高(需记录访问时间);

- FIFO(先进先出):换出最早进入内存的页面,简单但可能换出常用页面(Belady 异常);

- Clock(时钟算法):通过"访问位"标记页面是否被访问,循环扫描,未被访问的页面优先换出,平衡性能与实现复杂度(Linux 采用改进版 Clock 算法)。

3. 虚拟内存的优势与代价

- 优势 :

- 突破物理内存限制,支持大进程运行(如 32GB 内存可运行 64GB 进程);

- 实现进程地址空间隔离(每个进程虚拟地址独立),提高安全性;

- 简化程序开发(无需关心物理内存分配细节);

- 代价 :

- 磁盘 IO 开销:缺页时需从磁盘换入页面,速度比内存慢 10^6 倍;

- 内存 overhead:需维护页表、虚拟地址映射等数据结构。

三、内存保护:确保进程安全隔离

多进程共享物理内存时,需防止进程越界访问(如进程 A 修改进程 B 的内存),主要通过硬件与软件协同实现:

- 地址越界检查:分页/分段中,通过页表/段表记录页面/段的大小,访问地址超过范围时触发中断;

- 权限保护:页表/段表项记录内存权限(读/写/执行),如代码段设为"只读",防止被意外修改;

- 内存隔离:通过 MMU(内存管理单元)硬件,将进程的虚拟地址映射到物理地址,确保进程只能访问自身的虚拟地址空间。

关键点与面试加分点

- 核心逻辑:内存管理的核心是"高效分配、扩展容量、安全隔离",虚拟内存是突破物理限制的关键;

- 加分点:能解释分页与分段的本质区别(分页是物理划分,分段是逻辑划分),说明 LRU 算法的实现难点(如用双向链表 + 哈希表优化),结合 Linux 的伙伴系统(解决物理内存分配碎片问题)举例,分析虚拟内存带来的"抖动"问题(频繁缺页换入换出)及解决措施(调整工作集大小)。

记忆法

可总结为"内存管理分三块,分配保护加扩展;分页分段解碎片,虚拟内存靠换页;局部性是基础,隔离安全不能忘",即内存管理的核心模块及关键技术。

常见的进程调度算法有哪些?请简述它们的原理和适用场景。

进程调度是操作系统核心功能,负责按一定策略从就绪队列中选择进程分配 CPU 资源,直接影响系统的吞吐量、响应时间和公平性。常见的进程调度算法可分为"批处理系统算法""交互式系统算法"和"通用算法",每种算法有其独特的原理和适用场景。

一、批处理系统常用调度算法:注重吞吐量和效率

批处理系统(如早期大型机)中,进程多为后台任务(无交互),调度算法优先考虑"吞吐量"(单位时间完成的进程数)和"CPU 利用率"。

1. 先来先服务(FCFS,First-Come, First-Served)

- 原理:按进程到达就绪队列的先后顺序调度,先到的进程先获得 CPU,一旦开始执行,直到完成或阻塞才释放 CPU(非抢占式)。

- 优点:实现简单(只需队列),公平性好(按顺序执行);

- 缺点:对短作业不利(长作业先执行会导致短作业等待时间过长,即"护航效应"),吞吐量低;

- 适用场景:早期批处理系统,或进程运行时间相近的场景(如大型科学计算任务)。

2. 短作业优先(SJF,Shortest Job First)

- 原理:优先调度"估计运行时间最短"的进程(非抢占式);若新到达的短作业比当前运行的进程更短,也可抢占 CPU(抢占式 SJF,又称最短剩余时间优先 SRTF)。

- 优点:能有效降低平均等待时间,提高吞吐量(短作业快速完成);

- 缺点:需要预先知道进程的运行时间(实际中难精确估计),对长作业不利(可能饥饿,永远得不到调度);

- 适用场景:进程运行时间可预估的批处理系统(如编译任务、打印任务)。

二、交互式系统常用调度算法:注重响应时间

交互式系统(如桌面 OS、服务器)中,用户与进程频繁交互(如点击鼠标、输入命令),调度算法需优先保证"响应时间短"(用户操作后快速反馈)。

1. 时间片轮转(RR,Round-Robin)

- 原理:将 CPU 时间划分为固定长度的"时间片"(如 10ms),就绪队列中的进程轮流获得一个时间片,若时间片用完未完成,则回到队列尾部等待下一轮调度(抢占式)。

- 优点:响应时间均匀,适合交互场景(每个进程都能在短时间内得到响应);

- 缺点:时间片大小影响性能(过大→退化为 FCFS,过小→上下文切换频繁,开销大);

- 适用场景:分时系统(如 Linux、Windows 桌面系统),多用户共享 CPU 的场景。

2. 优先级调度(Priority Scheduling)

- 原理:为每个进程分配优先级(数值表示,如 0-127),调度器总是选择优先级最高的就绪进程运行;优先级可动态调整(如长时间未运行的进程优先级提升,避免饥饿)。

- 优点:能区分进程重要性(如系统进程优先级高于用户进程);

- 缺点:低优先级进程可能饥饿(需"老化"机制缓解,即随时间提升优先级);

- 适用场景:需要区分任务紧急程度的系统(如实时系统中的紧急任务、服务器中的核心服务进程)。

三、通用调度算法:兼顾多种需求

1. 多级反馈队列调度(Multilevel Feedback Queue)

- 原理 :结合 RR 和优先级调度的优点,设置多个就绪队列,每个队列对应不同优先级和时间片(优先级越高,时间片越小,如 Q1 优先级最高,时间片 10ms;Q2 次之,时间片 20ms,以此类推):

- 新进程进入最高优先级队列 Q1,按 RR 调度;

- 若时间片用完未完成,降入 Q2;

- Q2 中按 RR 调度,时间片用完未完成则降入 Q3,以此类推;

- 仅当高优先级队列空时,才调度低优先级队列的进程。

- 优点 :

- 短作业在高优先级队列快速完成(响应快);

- 长作业逐渐降入低优先级队列,不会饥饿(最终会被调度);

- 无需预估进程运行时间,适应性强;

- 缺点:实现复杂(需维护多个队列和优先级调整逻辑);

- 适用场景:通用操作系统(如 Unix、Linux 早期版本),兼顾交互式和批处理任务。

四、实时系统调度算法:注重 deadlines 保证

实时系统(如工业控制、自动驾驶)中,进程需在严格的"截止时间(deadline)"前完成,调度算法需确保时间约束。

1. 最早截止时间优先(EDF,Earliest Deadline First)

- 原理:优先调度"截止时间最早"的实时进程,可抢占(若新进程截止时间更早,立即抢占当前进程)。

- 适用场景:软实时系统(如视频播放,偶尔超时可接受)。

2. 速率单调调度(RMS,Rate Monotonic Scheduling)

- 原理:根据进程的周期(两次运行的间隔)分配优先级,周期越短,优先级越高(假设进程运行时间小于周期)。

- 适用场景:硬实时系统(如航天器控制,必须严格按周期执行)。

关键点与面试加分点

- 核心差异:不同算法的核心目标不同(吞吐量、响应时间、截止时间),需根据系统类型选择;

- 加分点:能分析时间片轮转中时间片大小的选择依据(通常为上下文切换时间的 10 倍左右),解释优先级调度中的"老化"机制(如每等待 1s 优先级 +1),对比多级反馈队列与其他算法的优势(无需预估运行时间,自适应各类进程)。

记忆法

可总结为"批处理用 FCFS 和 SJF,吞吐效率优先;交互用 RR 和优先级,响应时间关键;多级反馈队列全兼顾,实时系统靠截止时间",即不同场景下的算法选择及核心目标。

解释 IO 多路复用的原理,以及同步 / 异步、阻塞 / 非阻塞的区别。

IO 多路复用是解决"单进程/线程高效处理多个 IO 流"的核心技术,广泛应用于高并发网络编程(如 Nginx、Redis)。要理解其原理,需先明确同步/异步、阻塞/非阻塞的概念差异,这些概念描述了 IO 操作中进程与内核的交互方式。

一、同步 / 异步、阻塞 / 非阻塞的区别

这两组概念描述 IO 操作的不同维度:"同步/异步"关注"结果通知方式","阻塞/非阻塞"关注"等待过程中进程状态"。

1. 阻塞(Blocking)与非阻塞(Non-Blocking)

描述进程在等待 IO 就绪(如数据到达、连接建立)时的状态:

- 阻塞 IO :进程发起 IO 操作后,若 IO 未就绪,进程会进入"阻塞态"(暂停运行,释放 CPU),直到 IO 就绪并完成操作后才唤醒。例如,

recvfrom系统调用在无数据时会阻塞进程。 - 非阻塞 IO :进程发起 IO 操作后,若 IO 未就绪,内核立即返回"未就绪"状态(如

-1并设置EAGAIN),进程可继续执行其他任务,无需等待。需通过轮询(如反复调用recvfrom)检查 IO 是否就绪。

2. 同步(Synchronous)与异步(Asynchronous)

描述 IO 操作完成后,结果通知进程的方式:

- 同步 IO:进程需主动等待或轮询 IO 操作的完成,IO 结果由进程自己获取。例如,阻塞 IO、非阻塞 IO、IO 多路复用均属于同步 IO(即使非阻塞,进程仍需主动检查结果)。

- 异步 IO :进程发起 IO 操作后,内核负责完成整个 IO 过程(包括数据拷贝),完成后通过信号或回调通知进程,进程无需主动等待。例如,Linux 的

aio_*系列系统调用、Windows 的 IOCP。

关键对比示例:

以"读取网络数据"为例:

- 阻塞同步 IO:调用

recvfrom后,进程阻塞,直到数据接收完成才返回; - 非阻塞同步 IO:调用

recvfrom后,若无数据立即返回,进程循环调用检查,有数据时处理; - 异步 IO:调用

aio_read后,进程继续执行,内核接收数据并拷贝到用户空间后,通过信号通知进程处理结果。

二、IO 多路复用的原理

IO 多路复用允许单进程/线程同时监控多个 IO 流(如 socket),当某个 IO 流就绪时(如数据到达),通知进程处理,从而避免为每个 IO 流创建独立进程/线程(减少资源开销)。

1. 核心问题:解决多 IO 流的低效监控

传统多 IO 处理方式的缺陷:

- 多进程/线程模型:为每个 IO 流创建进程/线程,阻塞等待 IO,内存和上下文切换开销大(如 1 万个连接需 1 万个线程,内存占用达 GB 级);

- 非阻塞轮询:单进程轮询所有 IO 流,无数据时也需频繁系统调用,CPU 浪费严重。

IO 多路复用的解决方案:由内核协助监控多个 IO 流,仅在 IO 就绪时通知进程,减少无效等待和系统调用。

2. 常见实现:select、poll、epoll

三者均是 Linux 下的 IO 多路复用机制,核心逻辑相同,但效率不同:

| 机制 | 原理 | 优点 | 缺点 |

|---|---|---|---|

| select | 进程将需监控的 IO 描述符(fd)放入集合,调用 select 后阻塞;内核遍历集合,返回就绪的 fd 数量,进程需轮询集合判断哪些 fd 就绪。 |

跨平台支持好(Windows、Linux 均实现) | 集合大小有限(默认 1024);轮询效率低(O(n));需重复拷贝 fd 集合到内核。 |

| poll | 用动态数组(struct pollfd)替代固定大小集合,其他逻辑与 select 类似。 |

无 fd 数量限制 | 仍需轮询判断就绪 fd(O(n));重复拷贝数组开销大。 |

| epoll | 进程通过 epoll_ctl 向内核注册 fd 及事件(如读/写),内核维护"就绪列表";调用 epoll_wait 时,直接返回就绪列表中的 fd,无需轮询。 |

效率高(O(1) 获取就绪 fd);无数量限制;fd 只需注册一次,无需重复拷贝。 | 仅 Linux 支持,跨平台性差。 |

3. 工作流程(以 epoll 为例)

- 创建 epoll 实例 :调用

epoll_create创建内核数据结构(维护监控的 fd 和就绪列表); - 注册 IO 事件 :通过

epoll_ctl向实例注册需监控的 fd 及事件(如EPOLLIN表示读就绪); - 等待就绪事件 :调用

epoll_wait阻塞进程,内核监控注册的 fd,当有 IO 就绪时,将其加入就绪列表; - **处理

IP 地址如何从内网转换到公网?(如 NAT 技术)

内网IP地址(如192.168.x.x、10.x.x.x)是局域网内的私有地址,无法直接在互联网中通信;公网IP地址是全球唯一的互联网地址,由ISP(网络服务提供商)分配。实现内网IP到公网IP转换的核心技术是NAT(网络地址转换),其本质是通过路由器或网关对IP数据包的源/目的地址进行修改,使内网设备能借助少量公网IP访问互联网,解决IPv4地址资源不足的问题。

一、NAT技术的核心作用与场景

IPv4地址总数约43亿,无法满足全球设备联网需求,因此引入"私有地址段"(RFC 1918规定:10.0.0.0-10.255.255.255、172.16.0.0-172.31.255.255、192.168.0.0-192.168.255.255),这些地址仅在局域网内有效,不占用公网地址资源。但内网设备需访问互联网时,必须通过NAT将私有地址转换为ISP分配的公网地址,否则公网设备无法回传数据。

二、NAT的转换原理与主要类型

NAT由位于内网与公网边界的设备(如家用路由器、企业网关)实现,核心是维护"内网IP:端口"与"公网IP:端口"的映射关系,通过修改数据包的IP头部和端口信息完成转换。主要类型包括:

1. 静态NAT(Static NAT)

- 原理:将内网中固定的私有IP地址与公网IP地址一对一绑定(如内网192.168.1.100固定映射到公网202.100.1.1),转换规则是静态配置的。

- 特点:转换关系固定,公网设备可通过绑定的公网IP直接访问内网设备(需配合端口开放)。

- 适用场景:内网中有需要被公网访问的服务器(如企业网站服务器、FTP服务器)。

2. 动态NAT(Dynamic NAT)

- 原理:配置一个公网IP地址池(如202.100.1.2-202.100.1.10),当内网设备访问公网时,NAT设备从地址池动态分配一个公网IP与其绑定,会话结束后释放该公网IP供其他设备使用。

- 特点:多对多映射(内网设备数 ≤ 公网IP池大小),节省公网IP但仍需一定数量的公网地址。

- 适用场景:内网设备数量较少,且需要临时访问公网的场景(如小型企业网络)。

3. 端口地址转换(PAT,Port Address Translation)

- 原理 :最常用的NAT类型,又称"网络地址端口转换(NAPT)"。所有内网设备共享一个或少量公网IP,通过"公网IP + 端口号"区分不同的内网设备。例如:

- 内网设备A(192.168.1.100:5000)访问公网服务器(203.0.113.1:80)时,NAT设备将源地址转换为(公网IP 202.100.1.1:30000);

- 内网设备B(192.168.1.101:5001)访问同一服务器时,转换为(202.100.1.1:30001);

- 公网服务器回传数据时,NAT设备根据目标端口(30000或30001)反向映射到对应的内网设备。

- 特点:一对多映射(多个内网设备共享一个公网IP),极大节省公网IP,是家用路由器和大型企业的默认选择。

- 转换过程 :

- 内网设备发送数据包(源IP:内网IP,源端口:随机端口);

- NAT设备接收后,在映射表中记录"内网IP:端口 → 公网IP:新端口"的对应关系;

- 修改数据包的源IP为对公网IP,源端口为新端口,发送到公网;

- 公网回传数据包(目标IP:公网IP,目标端口:新端口);

- NAT设备根据映射表,将目标IP和端口修改为对应的内网IP和端口,转发给内网设备。

三、NAT的局限性与补充方案

- 局限性 :

- 破坏端到端通信:公网设备无法主动访问内网设备(需端口映射配置);

- 影响部分协议:依赖IP地址或端口的协议(如FTP主动模式、IPsec)可能因地址转换失效,需NAT穿透技术(如UPnP);

- 增加延迟:NAT设备需处理每个数据包的地址转换,增加网络延迟。

- 补充方案:IPv6通过128位地址空间(约3.4×10³⁸个地址)从根本上解决地址不足问题,无需NAT即可实现每个设备拥有公网地址,目前正逐步替代IPv4。

关键点与面试加分点

- 核心逻辑:NAT通过地址/端口映射实现内网到公网的通信,PAT是最常用的类型,通过端口区分内网设备;

- 加分点:能解释PAT中端口的作用(唯一标识内网设备的会话),说明NAT与防火墙的协同(NAT设备常集成防火墙功能,控制内外网访问),对比IPv6对NAT的替代意义。

记忆法

可总结为"内网转公网,NAT来帮忙;静态一对一,动态池共享;PAT最常用,端口辨设备;解决地址少,通信靠映射",即NAT的核心功能和主要类型。

TCP 和 UDP 的区别是什么?各自的适用场景有哪些?

TCP(传输控制协议)和UDP(用户数据报协议)是TCP/IP协议栈中传输层的两大核心协议,分别面向"可靠传输"和"高效传输"设计,在连接性、可靠性、性能等方面存在显著差异,适用场景也因此不同。理解两者的区别是网络编程的基础,直接影响系统设计的合理性。

一、TCP 和 UDP 的核心区别

从协议设计目标出发,两者的差异体现在连接性、可靠性保障、传输效率等多个维度,具体如下:

1. 连接性:面向连接 vs 无连接

- TCP:面向连接的协议。通信前必须通过"三次握手"建立连接,通信结束后需"四次挥手"释放连接,整个过程像"打电话"(先拨号接通,再通话,最后挂断)。

- UDP:无连接协议。通信前无需建立连接,发送方直接封装数据报并发送,接收方收到后直接处理,类似"发短信"(无需确认对方是否在线,直接发送)。

2. 可靠性:确保送达 vs 尽力而为

TCP 通过多层次机制保证数据可靠传输,而 UDP 不提供可靠性保障:

- TCP 的可靠性机制 :

- 确认与重传:接收方收到数据后发送确认(ACK),发送方未收到确认则重传数据;

- 序列号与有序交付:为每个字节分配序列号,接收方按序列号重组数据,丢弃重复数据;

- 流量控制:通过滑动窗口机制,控制发送方速率,避免接收方缓冲区溢出;

- 拥塞控制:通过慢启动、拥塞避免等算法,感知网络拥塞并降低发送速率,避免网络崩溃。

- UDP 的无可靠性 :

- 不保证数据到达:发送方发送后不等待确认,数据可能丢失(如网络拥堵时);

- 不保证有序:数据报可能乱序到达,接收方不处理排序;

- 无流量/拥塞控制:发送方按自身速率发送,可能导致接收方过载或网络拥塞。

3. 传输效率:低开销 vs 高开销

- TCP:头部开销大(固定20字节,可选扩展字段),且因确认、重传、拥塞控制等机制,传输延迟较高,实时性差。

- UDP:头部开销小(固定8字节),无额外控制机制,数据发送延迟低,实时性好,但可能因丢失数据影响业务。

4. 数据边界:无边界 vs 有边界

- TCP:面向字节流,不保留数据边界。发送方多次发送的数据可能被接收方合并为一个数据流(如发送"Hello"和"World",接收方可能一次收到"HelloWorld"),需应用层自行处理边界(如定义分隔符)。

- UDP:面向数据报,保留数据边界。发送方一次发送一个数据报,接收方一次接收一个完整数据报(如发送"Hello"和"World",接收方会分开收到两个数据报)。

二、TCP 和 UDP 的适用场景

协议的选择取决于业务对"可靠性"和"实时性"的优先级:

1. TCP 的适用场景:需确保数据可靠、完整

- 文件传输:如FTP、SFTP,文件传输需保证数据无丢失、无错误,否则文件损坏无法使用;

- 网页浏览:HTTP/HTTPS基于TCP,网页内容(HTML、图片)的丢失或乱序会导致显示异常;

- 邮件发送:SMTP协议依赖TCP,邮件内容(尤其是附件)必须完整送达;

- 支付交易:金融交易数据(如订单信息、支付指令)的丢失可能导致业务异常,需TCP保障可靠性。

2. UDP 的适用场景:需实时性,可容忍少量数据丢失

- 实时音视频:如视频通话(Zoom)、直播(抖音),少量数据包丢失仅导致短暂花屏或杂音,不影响整体体验,但延迟过高会导致卡顿;

- 实时游戏:如王者荣耀、CSGO,玩家操作指令需快速传输(延迟需<100ms),少量指令丢失可通过预测补偿,TCP的重传会导致延迟累积,影响操作体验;

- DNS查询:域名解析(如将www.baidu.com转为IP)请求小、频率高,需快速响应,即使少量请求失败,客户端可重试,无需TCP的复杂机制;

- 物联网通信:如传感器数据上报(温度、湿度),数据实时性优先,少量丢失可通过后续上报弥补,且设备资源有限(如低功耗传感器),难以处理TCP的复杂逻辑。

关键点与面试加分点

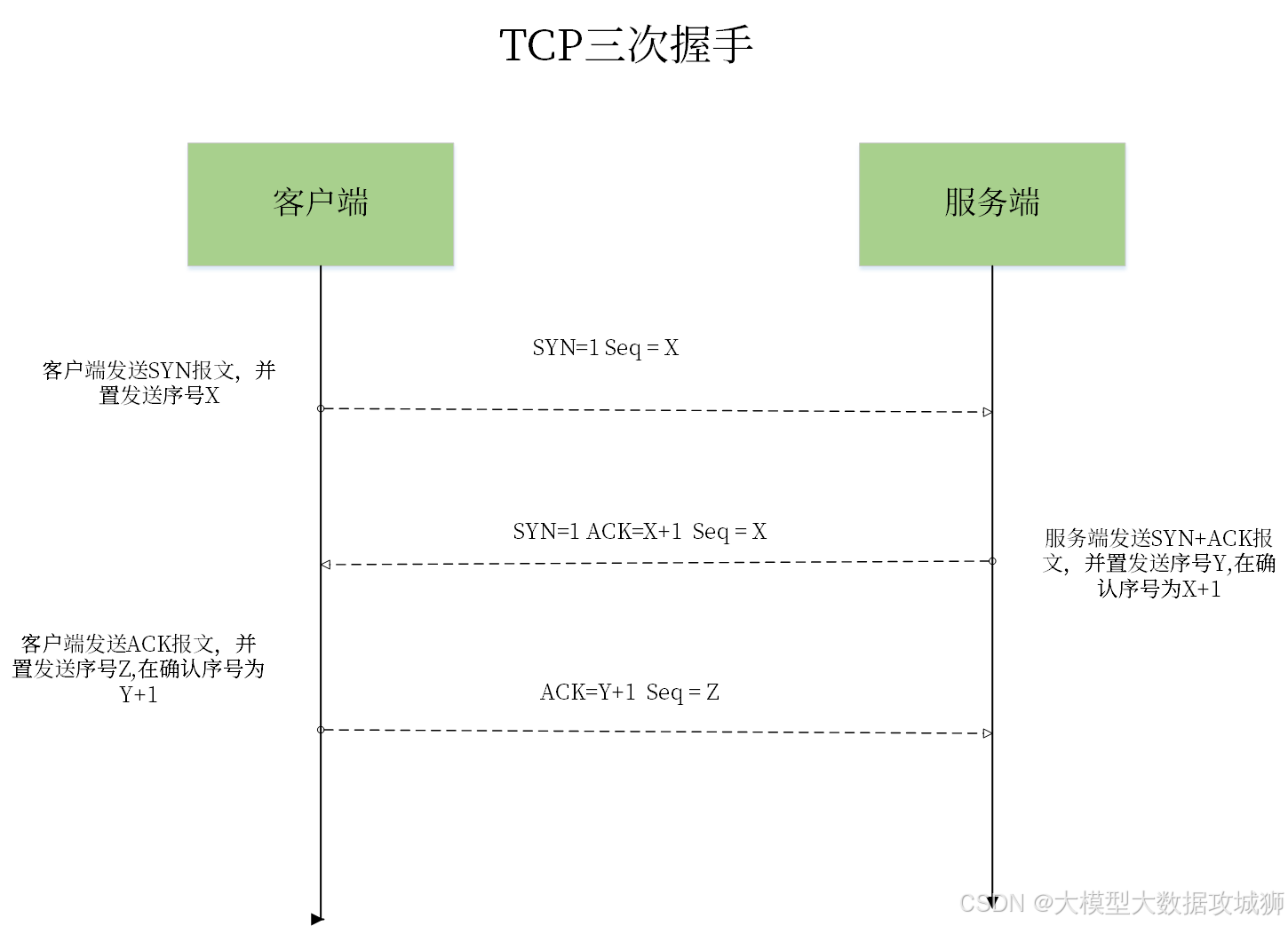

- 核心差异:TCP的核心是"可靠",UDP的核心是"高效",差异源于是否有连接建立、可靠性机制和开销;