实现通用人工智能的一大终极目标就是创建能够自我学习,自我改进的人工智能体。

这个目标已经是老生常谈了。其实在 2003 年,能够自我改进的智能体的理论模型就已经由著名的「现代 AI 之父」Jürgen Schmidhuber 提出,称为哥德尔机。

哥德尔机是一种自我改进型通用智能系统理论模型,设计灵感来自于哥德尔(Kurt Gödel)的不完备性定理。它的核心思想是:机器能够像数学家一样,通过形式证明自身程序的改进在长期内将带来更高收益,然后安全地修改自己。

通俗来说,就是一个「能改写自己」的自我进化的智能体。

而在最近,Jürgen Schmidhuber 对当年提出的理论哥德尔模型进行了一次全新的尝试,构建了赫胥黎 - 哥德尔机,能够在 SWE-Bench Lite 上与官方验证的最佳人类设计的智能体相媲美。

Jürgen Schmidhuber 是一名德国计算机科学家,以人工智能、深度学习和人工神经网络领域的成就而知名,现任达勒・莫尔人工智能研究所(IDSIA)联合主任,阿卜杜拉国王科技大学人工智能研究院院长。

1997 年,Jürgen Schmidhuber 发表了长短期记忆网络(LSTM)论文。2011 年,Jürgen Schmidhuber 在 IDSIA 的团队 GPU 上实现了卷积神经网络(CNN)的显著加速,这种方法基于杨立昆等人早期提出的 CNN 设计 ,已成为计算机视觉领域的核心。

-

论文标题:Huxley-Gödel Machine: Human-Level Coding Agent Development by an Approximation of the Optimal Self-Improving Machine

-

Github 链接:github.com/metauto-ai/...

该研究基于如下发现:编码智能体通过编辑自身代码来实现自我改进,通常采用一种树形结构来记录修改过程,其扩展策略倾向于选择在软件工程基准测试中得分更高的智能体,并假设高分意味着其后继的自我修改也更有可能成功。

然而,研究者发现,一个智能体真正的自我改进潜力与其当前的基准测试性能之间存在着脱节。他们将这个现象命名为「元生产力 - 性能不匹配」。

受赫胥黎谱系( clade)概念启发,Jürgen 等人提出了 CMP(clade-level metaproductivity,谱系元生产力)。该指标通过聚合一个智能体所有后代的性能来衡量其潜力,而非只看其自身分数。

本文证明了在自我改进编程智能体的开发环境中,只要能够获取真实的 CMP,就足以模拟哥德尔机在特定假设下的行为方式。

进一步的,本文提出的赫胥黎 - 哥德尔机(HGM)通过估计 CMP 并以其为指导,可以在自我修改的树结构中进行搜索。

在 SWE-bench Verified 和 Polyglot 基准测试中,HGM 不仅超越了先前的自我改进编程智能体方法,同时消耗的实际运行时间更少。

更重要的是,HGM 展现出向其他编码数据集和大语言模型的强大迁移能力。使用 GPT-5-mini 在 SWE-bench Verified 上通过 HGM 优化的智能体,在 SWE-bench Lite 上使用 GPT-5 进行评估时,达到了人类水平的表现,与经过官方验证的最佳人工设计编程智能体的结果相当。

赫胥黎 - 哥德尔机器

研究团队构建了赫胥黎--哥德尔机(Huxley--Gödel Machine,HGM)------ 一种利用谱系层级(clade-level)统计特性来近似哥德尔机的自我改进型机器。

HGM 的核心思想是元生产力(metaproductivity)------ 即衡量一个智能体提升自身「自我改进能力」的能力,这种能力的增强会在长期上带来更优的后代智能体性能。

原始哥德尔机

原始的哥德尔机是一种通用任务求解器,它在理论上能够在任意可计算的环境中,针对给定目标函数,最优地执行所有可证明的自我改进。

它的实现方式是运行一个「证明搜索器(proof searcher)」,持续寻找能够形式化证明某种自我修改会带来更高期望效用(expected utility)的证明。一旦找到这样的证明,系统便会执行相应修改,并永久性地改变自身代码。

哥德尔机的理论分析明确考虑了两个现实约束:

-

智能体只有一次生命(即没有可重复的试验);

-

证明一个自我改进会消耗实际时间和资源,而这些资源本可以用于直接获取奖励。

元生产力的指标

研究团队提出了两种衡量元生产力的指标:

- 全局元生产力(Global Metaproductivity,GMP):衡量进化一个给定智能体后,对整个智能体谱系(agent tree)的总体元生产力提升程度。此指标较为通用,但难以操作化或精确估计。

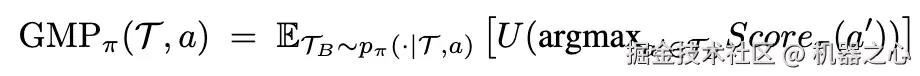

给定一个策略 π,为了量化某个智能体的自我修改对系统性能的影响,定义:

其中: 𝒯 是智能体树;a ∈ 𝒯 为当前节点;Score_π 是对智能体进行最终选择评分的函数; 策略 π 从当前树出发展开完整的搜索轨迹,生成最终的智能体存档 𝒯_B;轨迹的分布由 p_π 给出。

GMP 因此反映了整个系统的长期自我改进潜力,包括「改进自我改进能力本身」的元层次改进。

- 谱系元生产力(Clade Metaproductivity,CMP):衡量从某个特定智能体出发(即其谱系)展开进化的潜在前景。

然而,尽管 GMP 能捕捉策略的全局潜力,但其范围过于广泛,难以在实践中具体化。理论上,一个智能体的自我修改甚至可能通过引入新信息影响其祖先节点的期望效用。

原始哥德尔机的全局最优性来自其对「是否接受自我修改」的判定,只关注那些在形式上可证明会带来进一步自我改进潜力的修改。

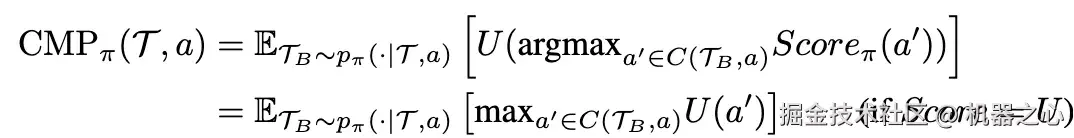

基于这一观察,研究团队定义了 GMP 的局部变体 ------ 谱系元生产力(CMP),它聚焦于以某个智能体为根的子树(即其谱系,clade):

其中 C (𝒯_B, a) 表示在树 𝒯_B 中以节点 a 为根的子树(即谱系)。

CMP 含有关于未来自我进化过程的非贪婪信息(non-greedy information),因此能指导那些不仅旨在提升直接性能、还旨在改进「自我改进能力」的策略。

赫胥黎--哥德尔机(HGM)

该模型通过基于 CMP 估计值的 Thompson 采样 策略来引导自我改进搜索,从而在实践中实现了「近似哥德尔机」的自演化学习过程。

现有方法通常以编程任务的基准性能作为指导指标,将任务成功视为自我改进潜力的体现。然而,这种假设过于贪婪(greedy):它只评估一次修改的即时效用,而忽略了这种修改对未来自我改进能力的长期影响。

研究团队将这种差距称为 「元生产力 --- 性能不匹配」,即短期任务表现与长期自我改进能力(以 CMP 衡量)之间的偏离,核心目标是通过推导 CMP 的估计量来建模这种长期的全局依赖关系。

具体而言,通过定义 HGM 的三个子策略来描述整个框架。

扩展策略

HGM 算法的核心是其「扩展选择准则」。研究团队使用谱系中智能体经验性能的加权平均值来估计 CMP。HGM 的设计会为效用更高的智能体分配更大的权重。

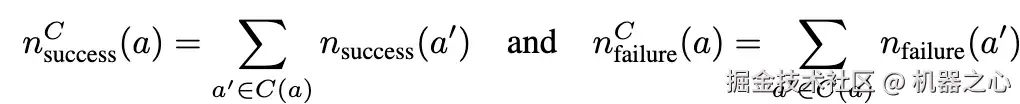

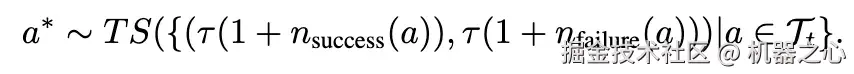

形式化地,设当前固定的智能体存档为 𝒯ₜ,n_success (a) 为智能体 a 通过的测试数,而 n_failure (a) 是智能体 a 未通过的测试数。定义谱系统计量:

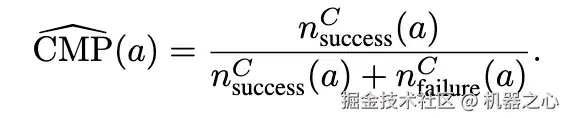

由此定义 CMP 估计量:

在谱系层面而非个体层面评估生产力有若干优势:

-

它更符合自我改进目标 ------ 即使祖先性能一般,只要后代持续改进,它仍具有高价值;停滞的谱系则自然被降权。

-

聚合整个谱系的数据可显著提高统计稳定性,相比单节点结果更稳健,尤其适用于评估成本高、基准数据稀缺的情境。

可以视为谱系中各智能体经验均值的加权和,权重为各智能体的测试次数。此外,我们的评估策略倾向于选择高性能智能体,从而在谱系内部形成「软最大值」的选择趋势。

可以视为谱系中各智能体经验均值的加权和,权重为各智能体的测试次数。此外,我们的评估策略倾向于选择高性能智能体,从而在谱系内部形成「软最大值」的选择趋势。

评估策略

如扩展策略所述,评估策略应优先选择具有更高评估得分的智能体,以在谱系内部诱导最大化趋势。形式化地,评估的智能体 a* 由下式给出:

选择策略

最后,智能体需要在「扩展」与「评估」之间进行选择。HGM 将评估与扩展解耦,并将其视为独立步骤。

为了确定何时进行评估或扩展,研究者们借鉴了「无限臂赌博机(infinite-armed bandit)」的思想。该问题刻画了在探索新臂与重复采样已知臂之间的平衡:

-

「评估」对应于采样现有臂(已有智能体);

-

「扩展」对应于引入新臂(创建新智能体)。

最终,研究者采用 UCB-Air 策略,当 Nₜᵅ ≥ |𝒯ₜ| 时,在时刻 t 添加新智能体。

实验结果

元生产力 - 性能失准

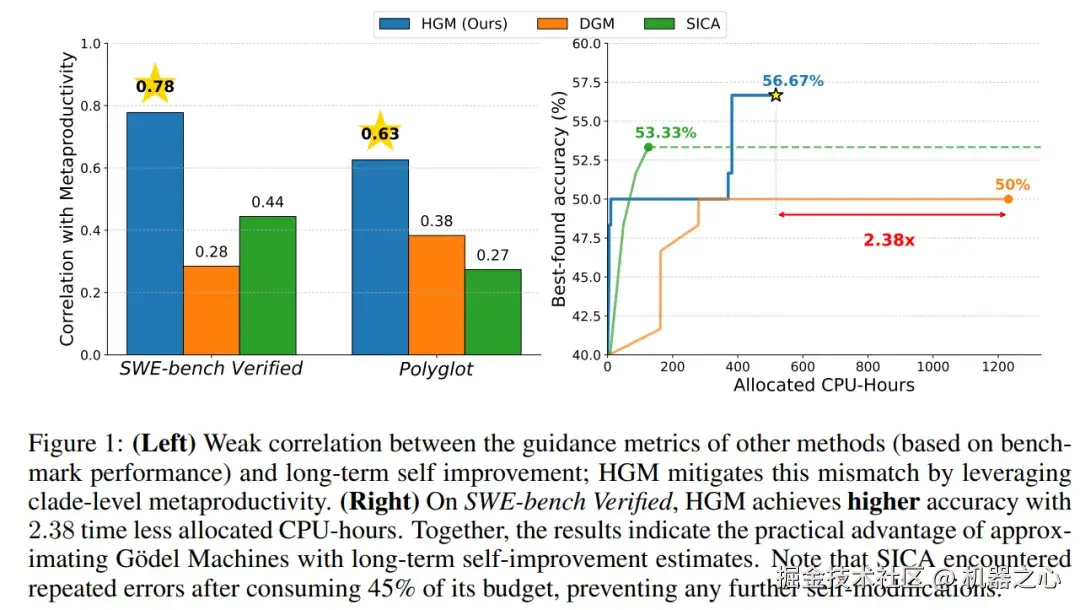

本节中的实验旨在实现两个目的:(i) 提供 MPM(Metaproductivity-Performance Misalignment,元生产力 - 性能失准)问题的证据;(ii) 评估 HGM 的估计量是否比 DGM 和 SICA 采用的效用指标更可靠。

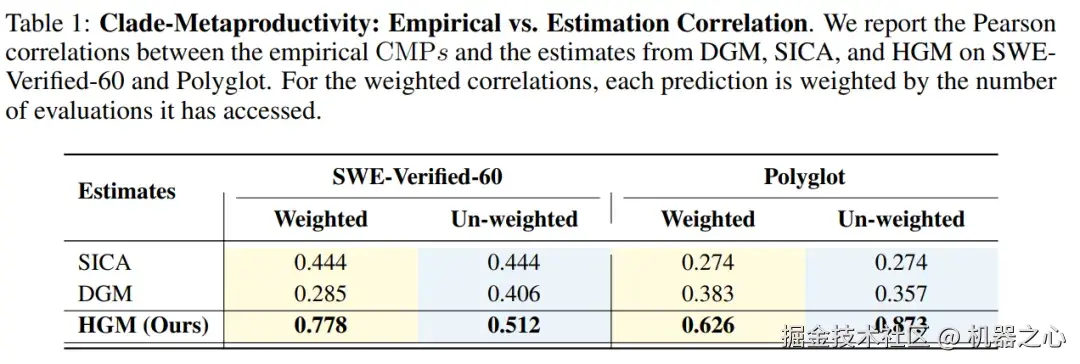

表 1 总结了三种估计量与 CMP(目标值)之间的相关性。SICA 和 DGM 的估计量获得了正皮尔逊相关系数:在 SWE-Verified-60 上分别为 0.444 和 0.285,在 Polyglot 上分别为 0.274 和 0.383,这表明它们与目标值仅存在弱对齐,即存在 MPM 问题。

相比之下,HGM 的估计量 获得了显著更强的相关性:在 SWE-Verified-60 和 Polyglot 上的加权相关系数分别达到 0.778 和 0.626,未加权相关系数分别为 0.512 和 0.878,以显著优势超越了 SICA 和 DGM。

获得了显著更强的相关性:在 SWE-Verified-60 和 Polyglot 上的加权相关系数分别达到 0.778 和 0.626,未加权相关系数分别为 0.512 和 0.878,以显著优势超越了 SICA 和 DGM。

这些结果强有力地表明,配备 的 HGM 能够提供更可靠的元生产力估计,并能有效缓解 SICA 和 DGM 固有的 MPM 问题。

的 HGM 能够提供更可靠的元生产力估计,并能有效缓解 SICA 和 DGM 固有的 MPM 问题。

评估 HGM 的自我改进能力

在这一实验中,本文将 HGM 与两种最先进的自我改进编程方法(DGM 和 SICA)进行了比较。

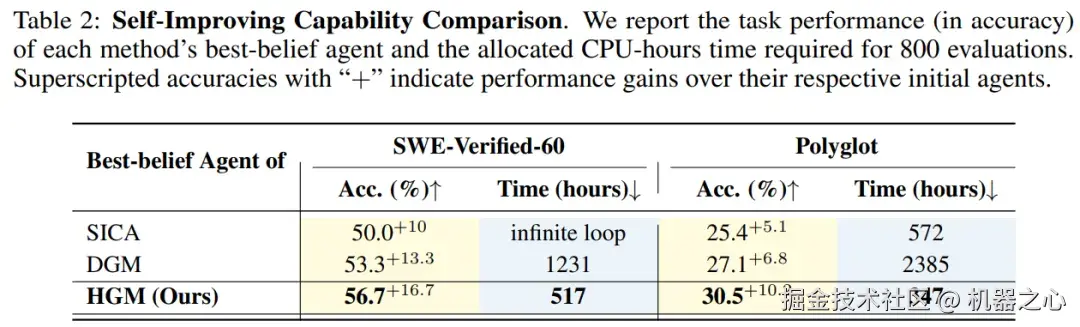

结果如表 2 所示,HGM 在性能与效率两个关键维度上,均显著超越了现有的自改进方法(DGM 和 SICA),确立了其优越性。

-

在 SWE-Verified-60 基准测试中,HGM 发现的智能体取得了 56.7% 的最高准确率。

-

在 Polyglot 基准测试中,HGM 同样以 30.5% 的准确率领先。

在效率上:

-

HGM 在完成 800 次评估所消耗的 CPU 时间远少于基线方法,显示出极高的计算效率。

-

在 Polyglot 上,HGM 比 DGM 快 6.86 倍,比 SICA 快 1.65 倍。

-

在 SWE-Verified-60 上,HGM 比 DGM 快 2.38 倍。

综上所述,HGM 配备了更好的效用估计器和异步扩展 - 评估迭代,与 DGM 和 SICA 相比,它是一种更有效的自我改进机制。

HGM VS 人类

经过 8000 次评估后,HGM 发现了一个能解决 61.4% 任务的优化智能体,超越了 SWE-Verified 排行榜上基于 GPT-5-mini 的最佳人工设计智能体。这些结果证明了 HGM 在相同模型约束条件下与成熟人工设计基线竞争的巨大潜力。

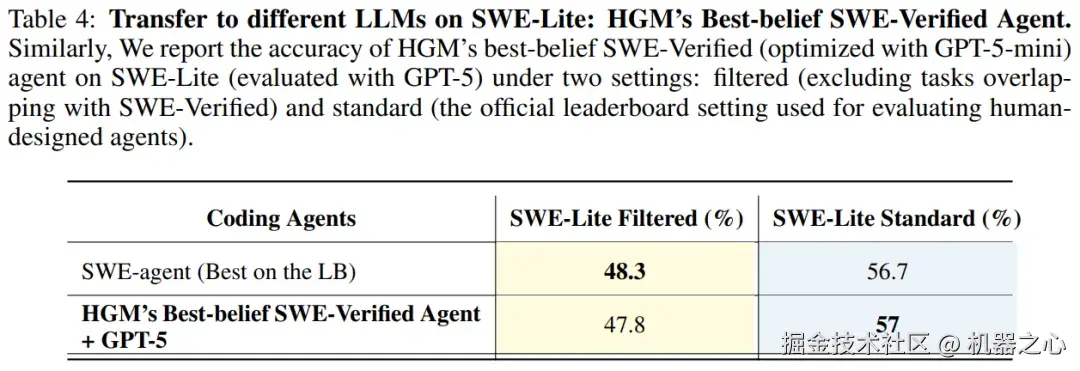

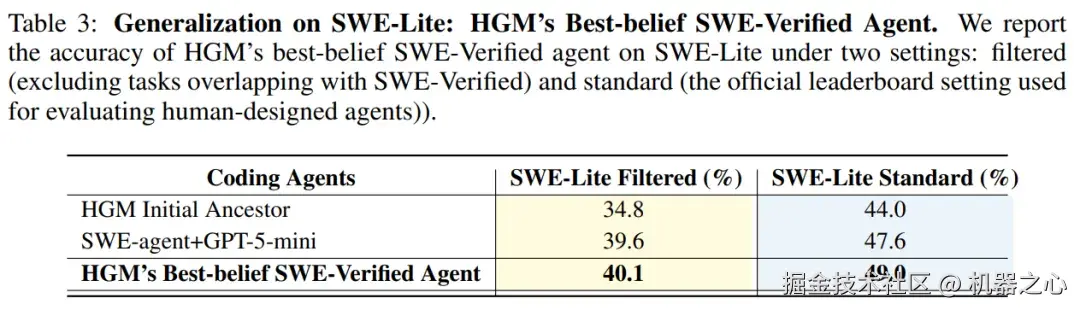

表 3 展示了 HGM 的 「best-belief」 SWE-Verified 智能体在 SWE-Lite 基准测试上的泛化结果。该在 SWE-Verified 上得到的最佳 HGM 智能体,在 filtered(完全未见数据)设置下取得了 40.1% 的成绩,在标准设置下取得了 49.0%。与其初始版本(分别为 34.8% 和 44.0%)相比,这一提升证明了 HGM 的自我进化机制确实能够提升通用编程能力,而不仅仅是对优化集的过拟合。

HGM 发现的智能体展现出卓越的跨模型泛化能力:当将其骨干模型从 GPT-5-mini 替换为更强大的 GPT-5 时,其强劲性能得以保持。在 SWE-Bench Lite 基准测试中,该智能体的表现与排行榜上最先进的人工设计智能体相当。

-

在官方 SWE-Bench Lite 排行榜上,其性能超越了所有其他经过官方结果验证的智能体。

-

在精心筛选的 SWE-bench Filtered 测试集上,仅比最佳模型少解决一个任务。

这一迁移实验的成功,强有力地证明了:HGM 自我进化出的智能体设计原则是普适的,其改进并非依赖于某个特定模型。此外,本文还发现性能提升源于智能体自身能力的真实、本质的增强,而非对特定数据集或大语言模型的过拟合。