「【新智元导读】凌晨,老黄 GTC 主题演讲华盛顿首秀,直接亮出下一代 GPU 核弹------Vera Rubin,性能狂飙 100 倍。目前,Blackwell 已全面量产,2026 年底两大 GPU 王牌预计爆赚 5000 亿美金。」

英伟达 GTC 大会,首次在华盛顿召开。

在近两小时演讲中,老黄不仅再次上演了一波 AI 美队,而且还给出了 AI 时代独一份的洞察------

AI 不是工具,而是会用工具的「工人」。

当老黄首次掏出下一代「杀手锏」Vera Rubin 超级芯片时,全场都震撼了。

相较于九年前,他亲手交付给 OpenAI 的首个超算 DGX-1,性能足足提升了 100 倍。并且明年就能量产。

当然,老黄的野心远不止于硬件。接下来的一系列震撼合作,将英伟达的 AI 帝国展示在了所有人面前:

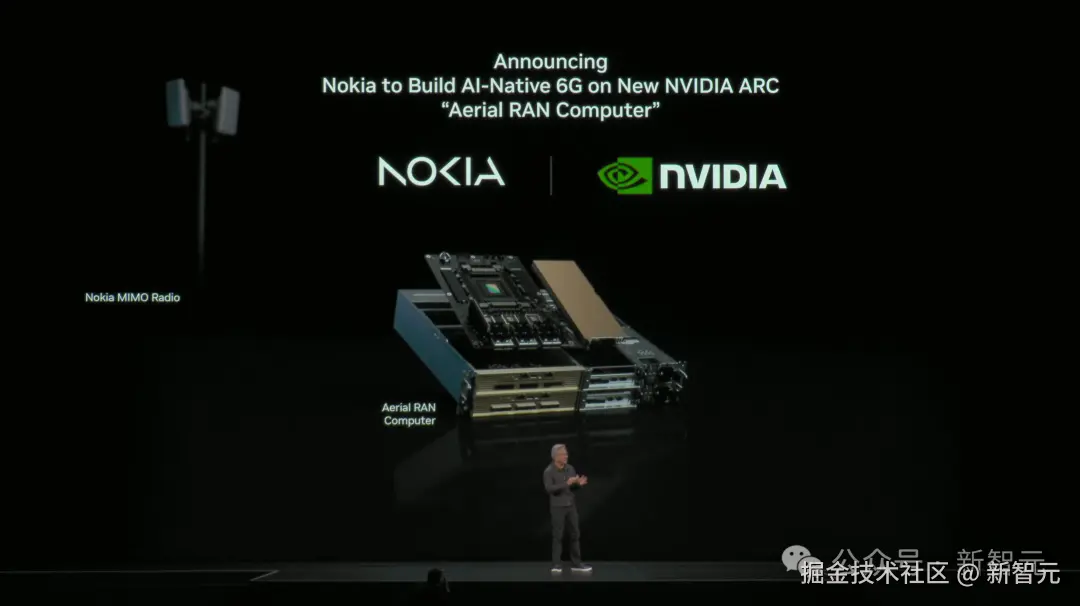

- 「AI 原生 6G」:推出「AI on RAN」技术,将 AI 与 6G 网络深度融合,让基站成为边缘的 AI 计算中心。

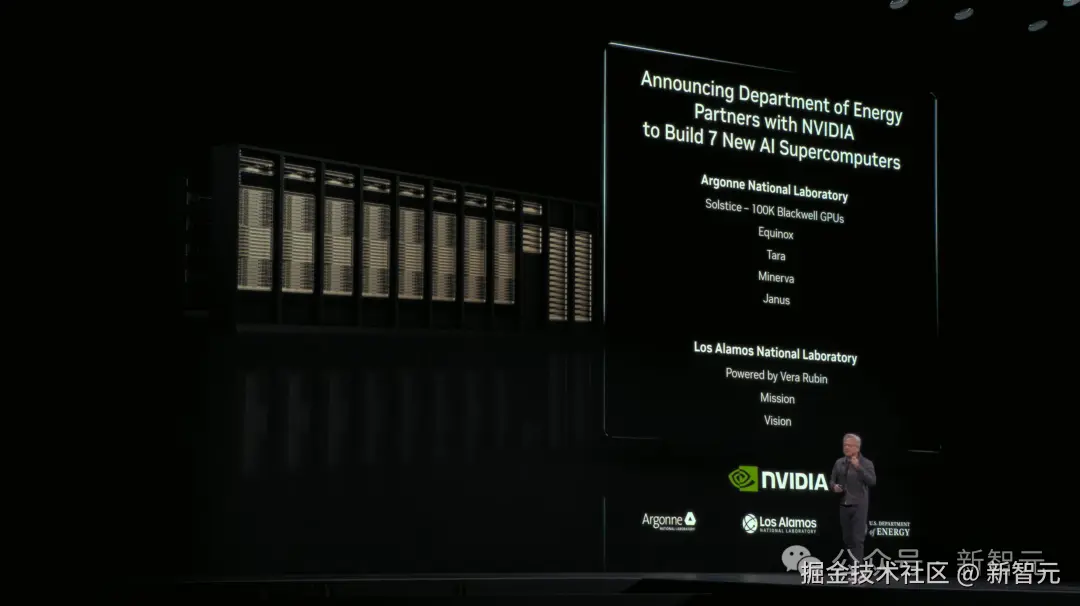

- 「超算基建」:与美国能源部合作,建造 7 座全新的 AI 超算。

- 「自动驾驶」:发布「开箱即用」的 DRIVE Hyperion 平台,让汽车「生而为 Robotaxi」。

- 「量子计算」:发布 NVQLink 技术,首次将 AI 超算与量子处理器无缝连接,加速量子计算的实用化进程。

- 「物理」 「AI」:通过 Omniverse 中的数字孪生技术,训练「物理 AI」,加速机器人在现实世界中的部署,目标直指美国「再工业化」。

在三大 Scaling Law 驱使下,英伟达内部早已形成了良性正循环。

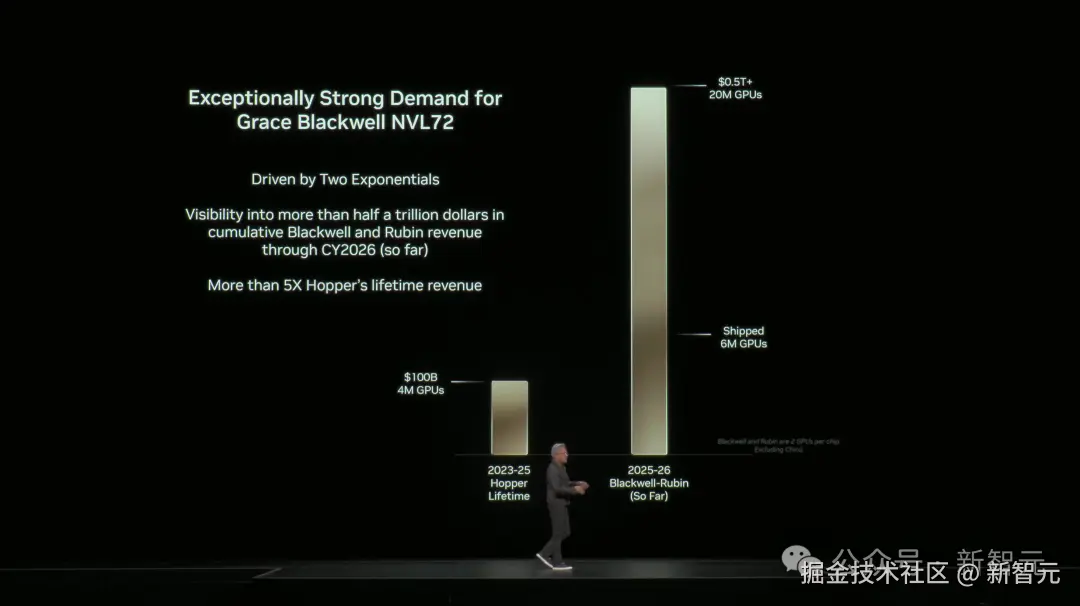

老黄预测,在 2026 年底前,仅凭「Blackwell+Rubin」就足以冲击 5000 亿美元的营收。

而且,这一数字还未将中国市场计算在内。

「下一代 Vera Rubin 首秀」

「性能狂飙百倍」

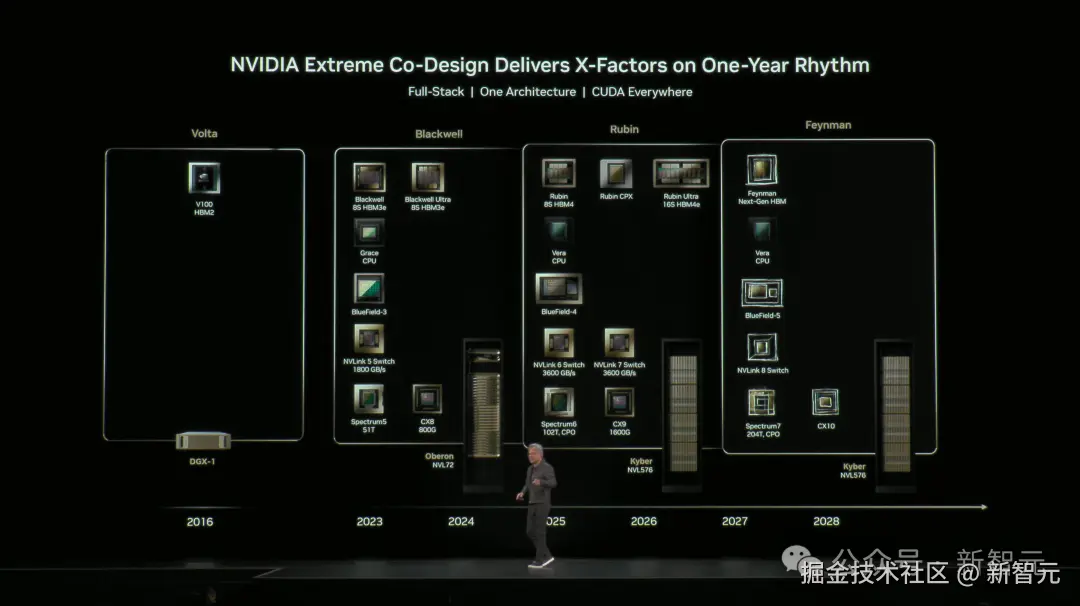

现场,老黄再次搬出了,未来三年英伟达 GPU 路线图,从 Blackwell,到 Rubin,再到 Feynman。

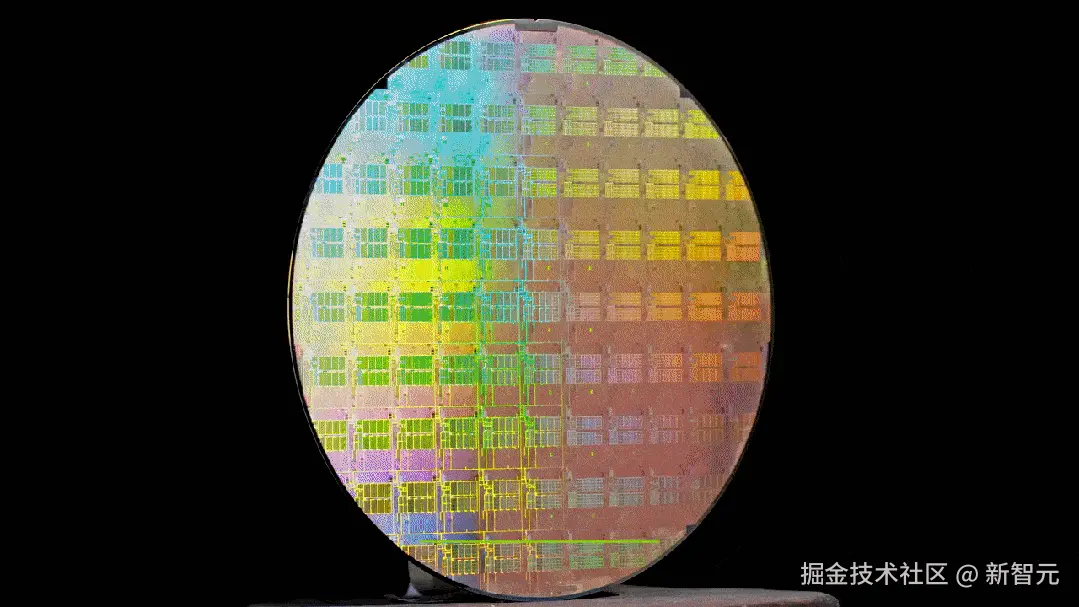

他激动官宣,短短 9 个月后,Blackwell 芯片已在亚利桑那州全面量产。

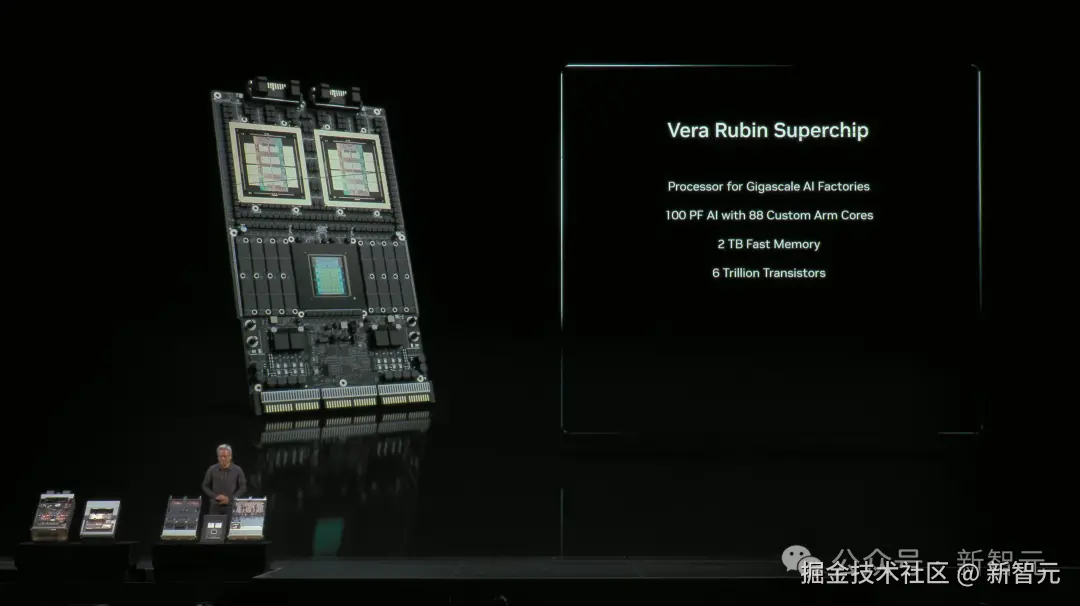

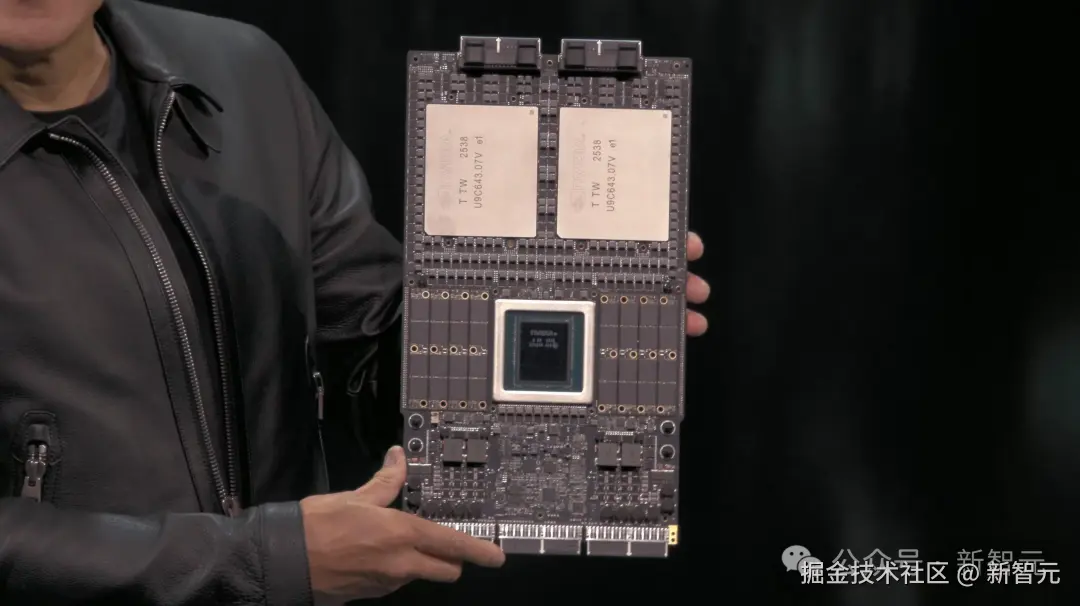

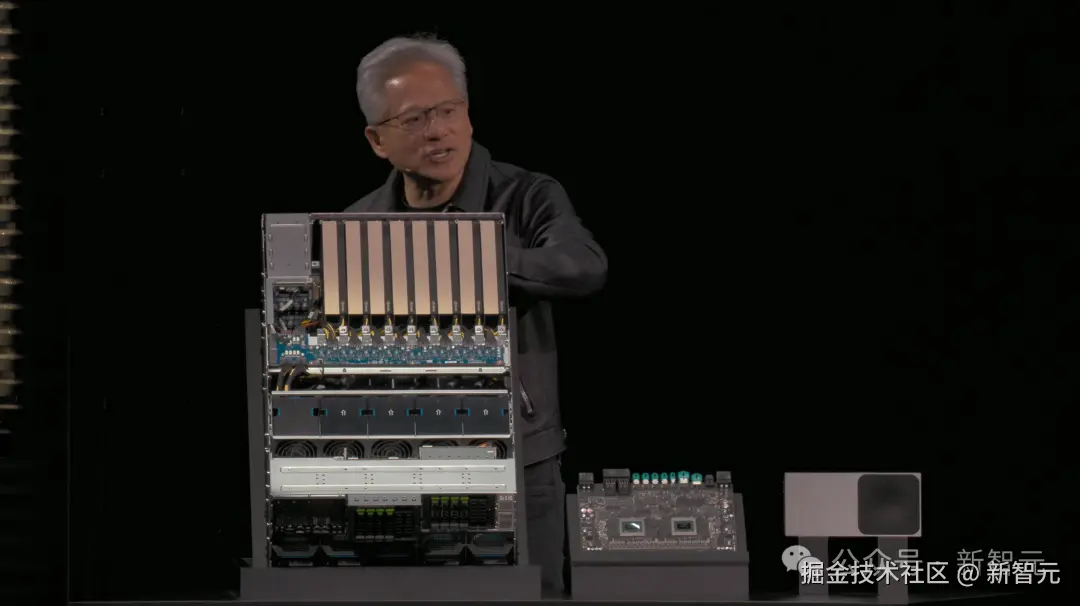

而真正站在全场 C 位的,还是下一代 Vera Rubin 的首次亮相。

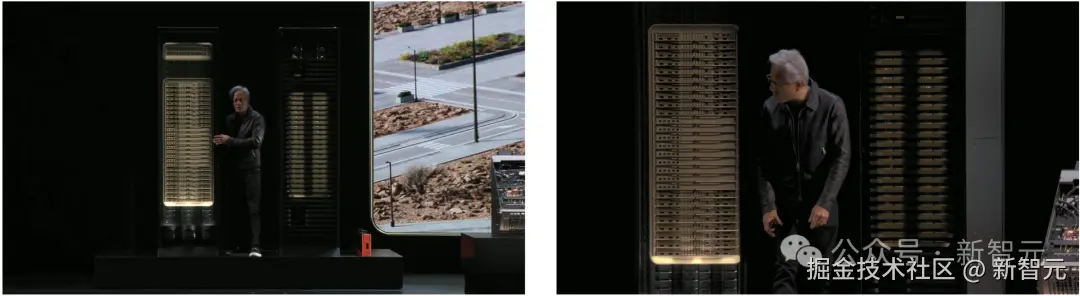

这是英伟达第三代 NVLink 72 机架级超级计算机,彻底实现了无线缆连接。

目前,Vera Rubin 超级芯片已在实验室完成测试,预计明年 10 月可以投产。

这块超级芯片计算能力达到 100 Petaflops,是 DGX-1 性能的 100 倍。

换句话说,以前需要 25 个机架,现在一个 Vera Rubin 就能完成。

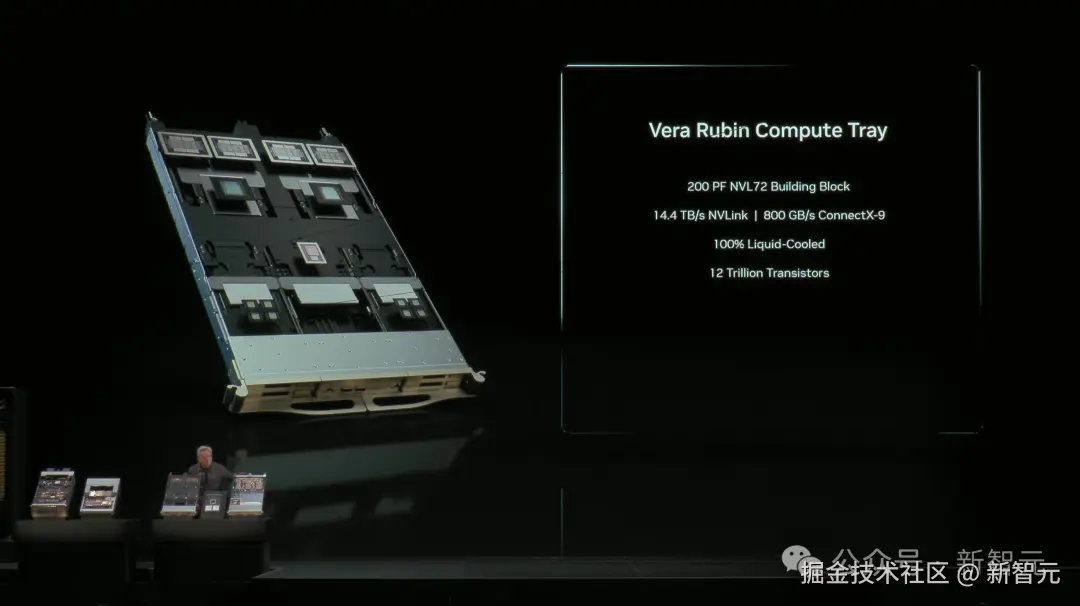

如下,便是 Rubin 计算托盘,推理性能可达 440PF。

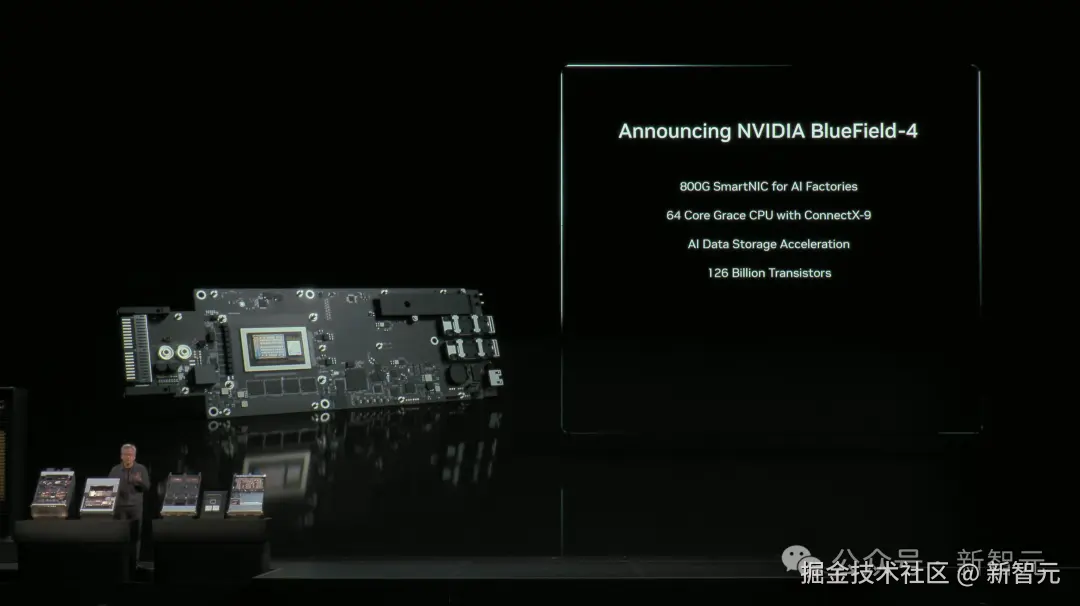

其底部配备了 8 个 Rubin CPX GPU、BlueField-4 数据处理器,还有两颗 Vera CPU,以及 4 个 Rubin 封装------总共 8 个 GPU,全部实现了无缆、全液冷。

同时,英伟达还引入了一种全新「上下文处理器」(Context Processor),支持超 100 万 token 上下文。

如今,AI 模型要处理、记忆的上下文越来越多,它可以在回答问题前,学习和阅读成千上万份 PDF、论文、视频。

此外,BlueField-4 革命性处理器,可以加速 AI 模型加载时间。

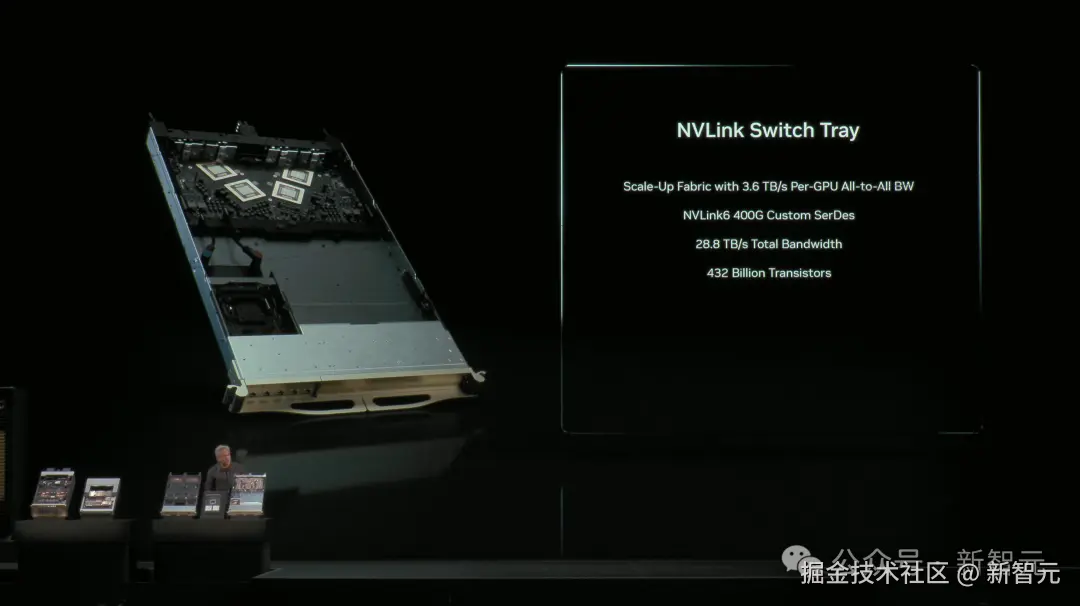

还有 NVLink 交换机,可以让所有 GPU 同步传输数据;以太网交换机 Spectrum-X 可以确保处理器同时通信而不拥堵。

再加上 Quantum 交换机,三者结合,系统全部兼容 InfiniBand、Quantum 和 Spectrum Ethernet。

所有这些组合起来,一个完整的机架塞满 150 万个零件,重量足足有两吨。

它的主干网络,一秒内就能传输相当于整个互联网的流量,刷新全球最快的 token 生成速度。

老黄表示,「一个 1GW 规模的数据中心,大概需要 8000-9000 台这样的机架。这就是未来的 AI 工厂」!

「老黄抛出 5000 亿预言」

「AI 美队再上线」

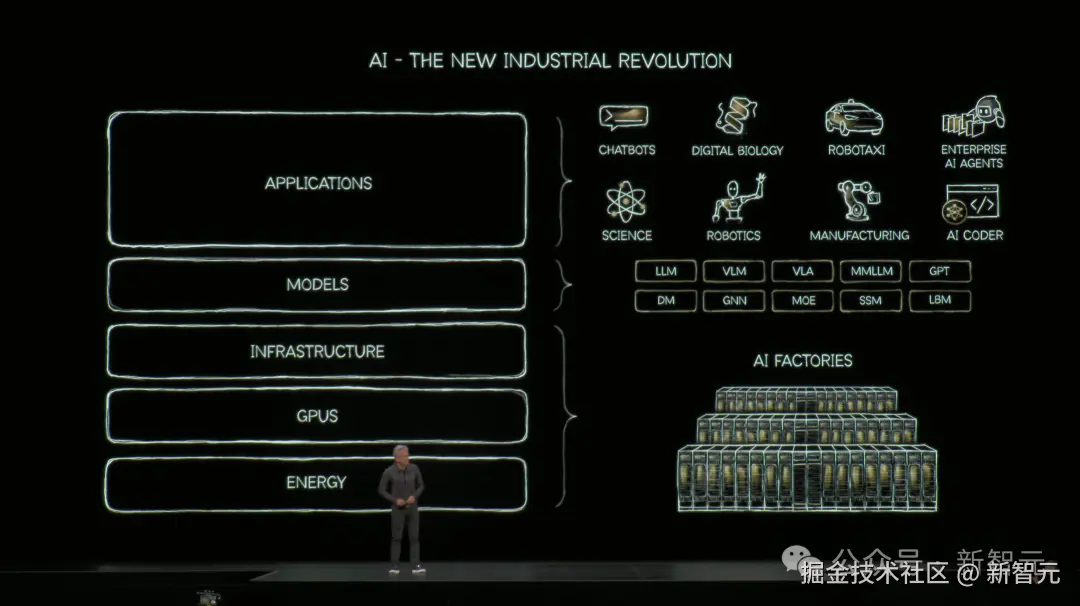

GPU 是 AI 革命的核心引擎,而 AI 的世界,远不止 ChatGPT。

主题演讲上,老黄亲自科普了 AI 的定义。

一上来,他就给大众认知来了一个降维打击,AI 并不等于聊天机器人。

他将其比作一个数据密集型的「编程」,在 CPU 时代的旧世界,人们手工编码,软件在 CPU 上运行,Windows 主导了一切。

而在当下,机器学习训练,模型直接跑在 GPU 之上。

能源 - GPU - 超算 - 模型 - 应用,全栈的能力构成了完整的 AI。

接下来,老黄还提出了一个对于 AI 的深刻洞察------

过去的软件产业,本质上是在「造工具」,Excel、Word、浏览器皆是工具。

在 IT 领域,这些工具可能就是「数据库」之类的,其市场规模大约在一万亿美元左右。

但 AI 不是工具,是「工人」。事实上,AI 是「会用工具的工人」。

这就是根本性差异。

到目前为止,人类发明的一切东西,本质上都是工具,都是给自己用的。

但这回是历史上头一次,技术自己会「干活」了。

老黄举例道,英伟达每一位工程师都在用 Cursor,生产力得以大幅提升。而 Cursor 使用的工具是 VS Code。

AI 本身也正在成为一个「全新的产业」,当人们把各种形式的信息编程 token 之后,就需要一个「AI 工厂」。

「 」

」

「10x 的性能,1/10 的成本」

「AI 工厂」不同于过去的数据中心,是因为它基本上只做一件事------运行 AI。

一来,生产尽可能有价值、更智能的 token;其次,要用极高的速度将其生产出来。

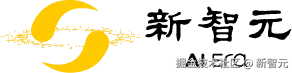

过去两年,业界让 AI 学会了变得更加聪明的方法,预训练是第一阶段。

下一步就是后训练,再之后就是测试时,让 AI 不断思考(Long Thinking)。

这也是老黄一直以来,反复强调的三大 Scaling Law。

模型越聪明,使用的人越多;用的人越多,需要的算力越多。

与此同时,摩尔定律边际趋缓,仅靠狂堆晶体管,无法解决两条指数曲线带来的「饥饿感」。

那么,摩尔定律已死,又该如何将成本大幅压下来?

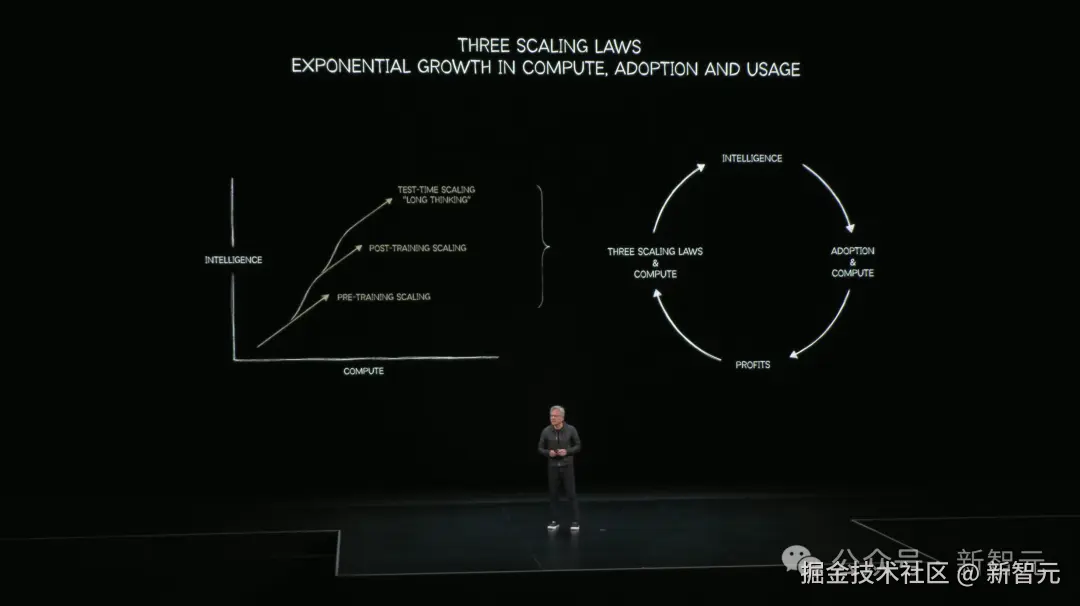

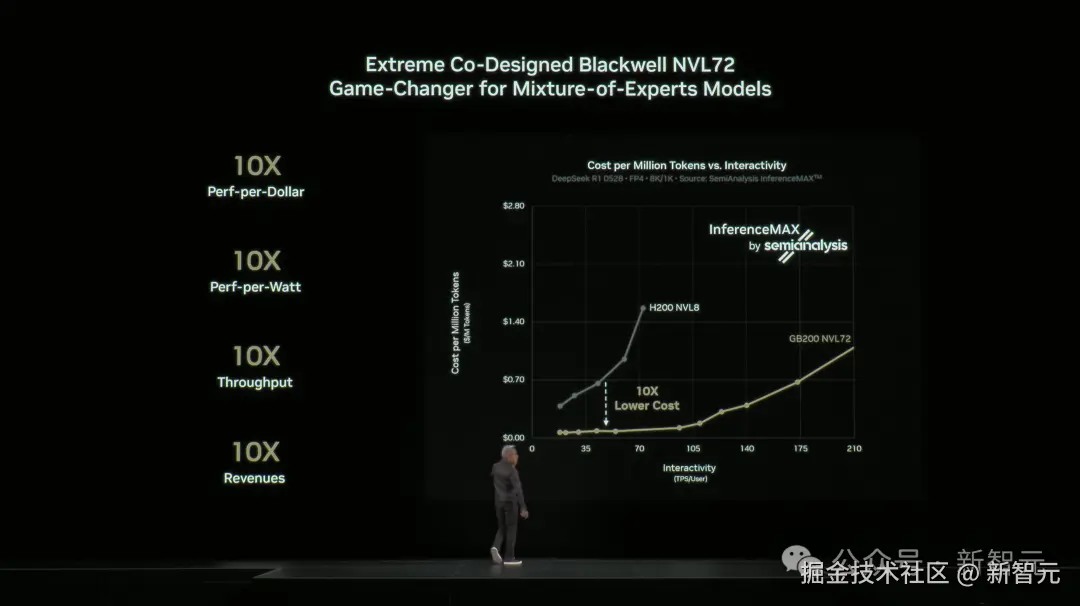

老黄给出的答案是:极致协同设计(Extreme Co-design)。

英伟达是当今世界上,唯一一家真正从一张白纸开始,同时思考芯片、系统、软件、模型、应用的公司。

他们的协同设计,将 AI 算力实现了从 Scale up 到 Scale out,再到 Scale across 的扩展。

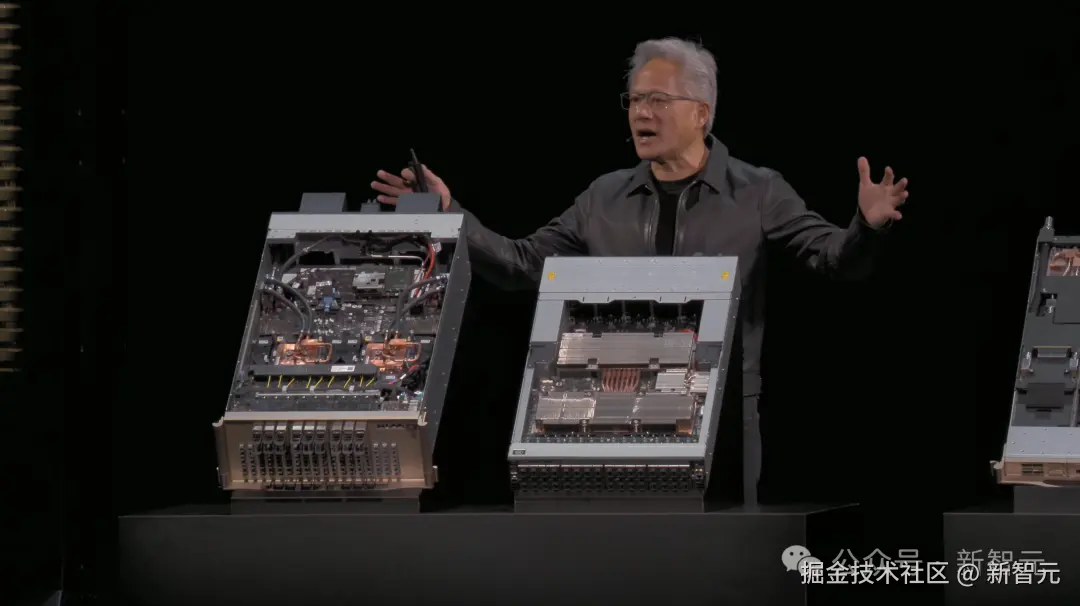

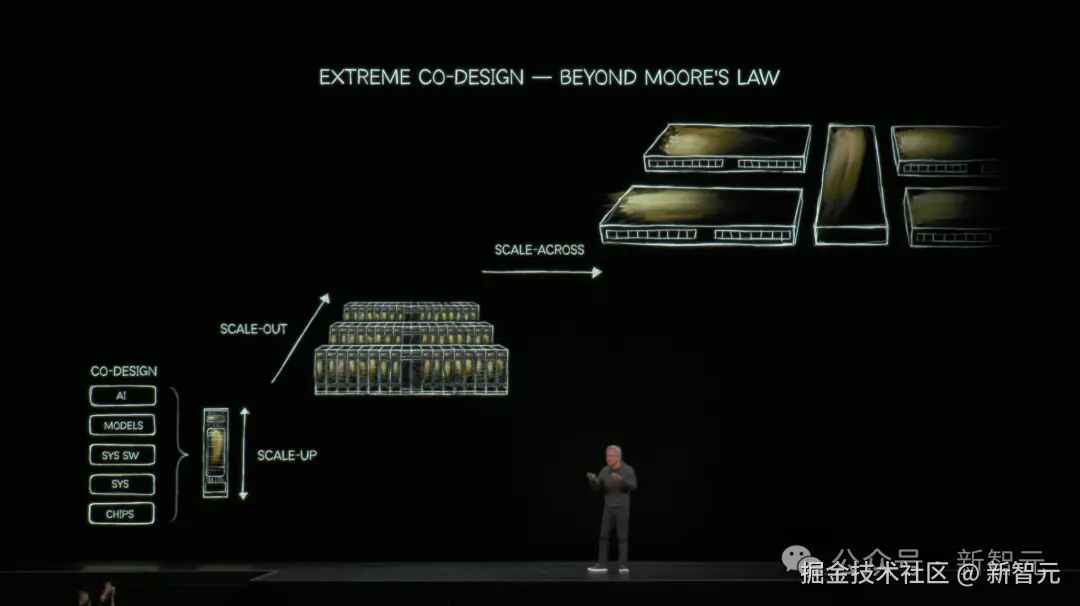

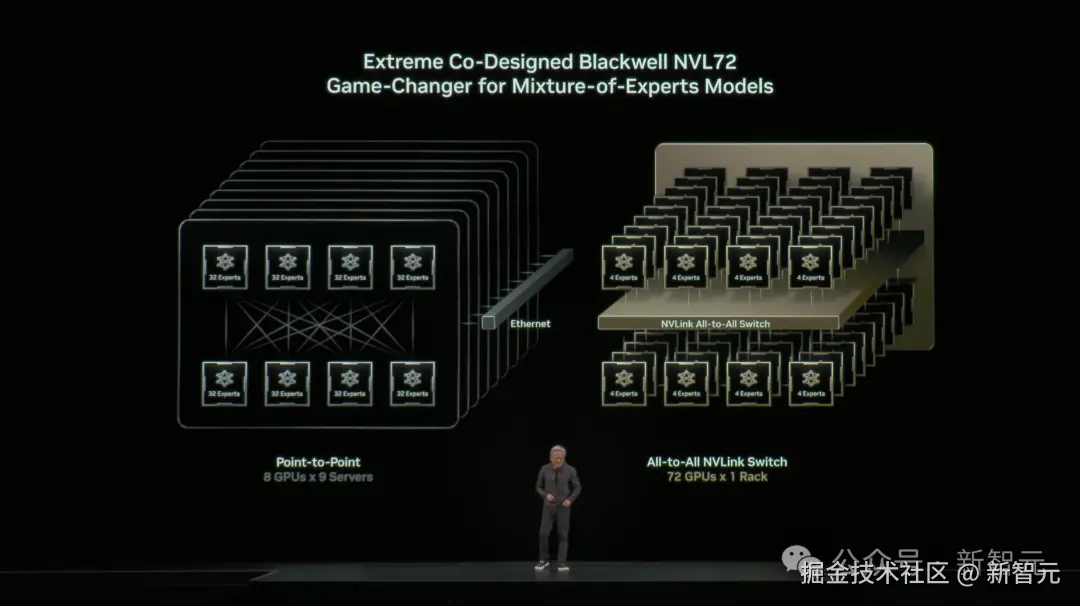

Grace Blackwell NVL72,一台思考机器,就是英伟达「协同设计」的典型代表。

为了更直观说明,老黄再次上演「芯片版美队」,手里拿着巨型芯片,由 72 块 GPU 无缝互联。

他还调侃道,「下次要演雷神,一伸手,芯片就到手里了」

为了驾驭万亿级参数模型,它采用了 MoE 架构。传统系统受限于 GPU 间互联带宽,一块 GPU 要扛 32 位专家的计算。

在 NVLink 72 架构下,每块 GPU 可以放 4 位专家。

SemiAnalysis 最新基准测试显示,Grace Blackwell 每块 GPU 的性能,是 H200 的十倍。

只多了一倍晶体管,速度却快了十倍,秘诀就在于------极致协同设计。

GB200,这台世界上最昂贵的计算机,却能生成成本最低的 token。

它的极致性能,均摊了每一次计算的总拥有成本(TCO),也就是说------

10 倍性能,十分之一成本。

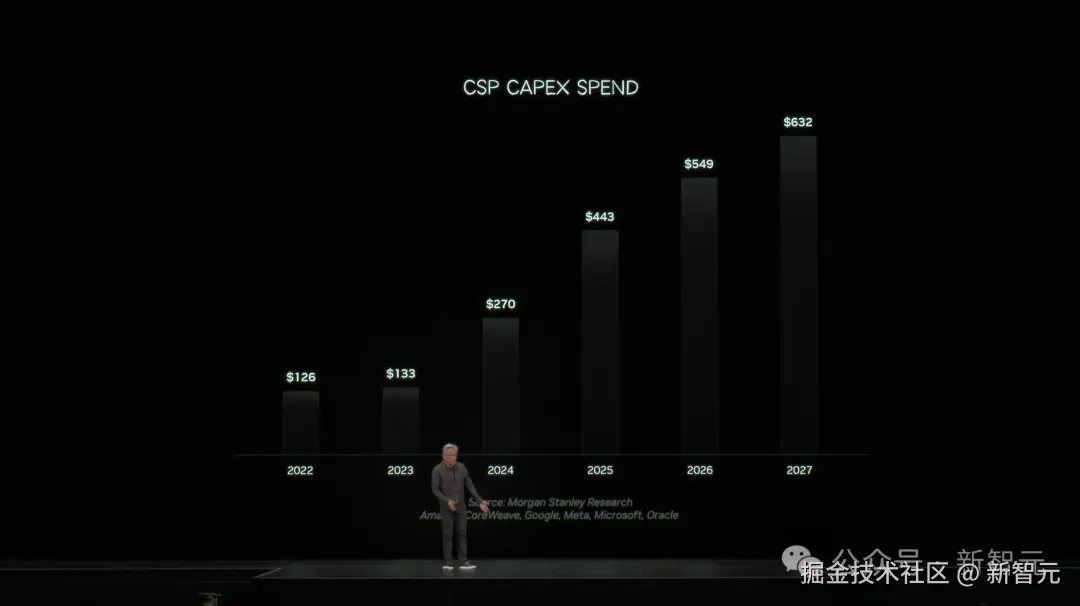

而此刻,这一突破正逢其时。

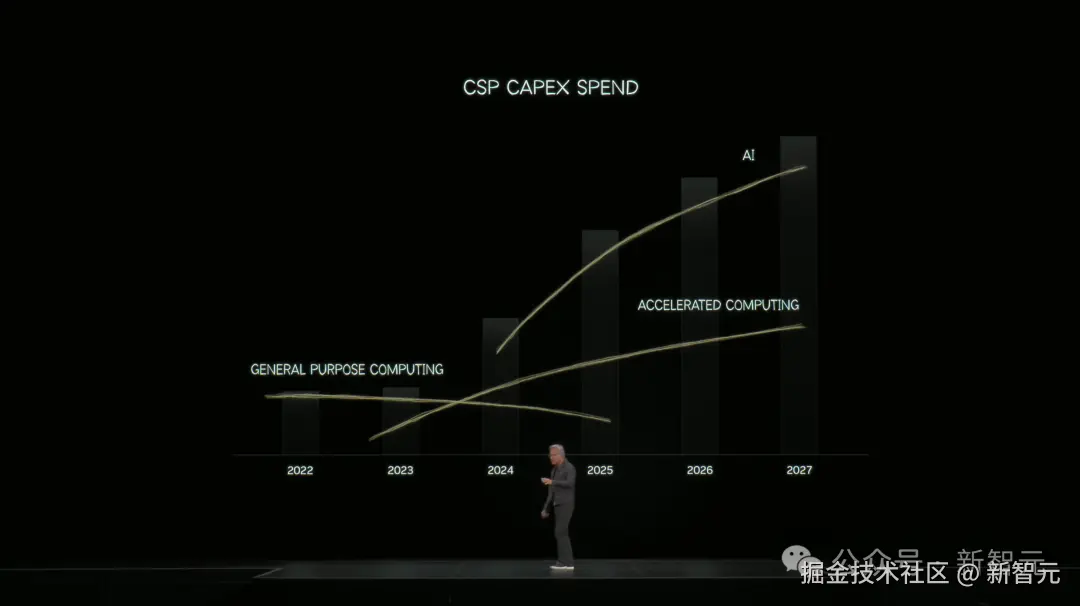

老黄展示了,全球六大云巨头的资本支出曲线(CapEx),正以史无前例的速度飙升。

它还联手能源部,官宣未来要建七大全新 AI 超算。

与此同时,老黄还指出,这场变革不是单线的,而是「双平台迁移」。

即通用计算转向加速计算,工具计算转向智能计算。

而英伟达 GPU 是唯一兼容以上所有的架构,包括加速计算和 AI。

最令人震惊是,他预测,截至 2026 年,Blackwell+Rubin 的可预见性收入累计 5000 亿美元。

算上目前已经出货的 600 万块 Blackwell,未来两年将达 2000 万 GPU 出货量,相较于 Hopper 增长 5 倍(400 万块)。

老黄正在释放一种信号------AI 工厂已成新基建。

「 」

」

「开源扛把子,没有弱项」

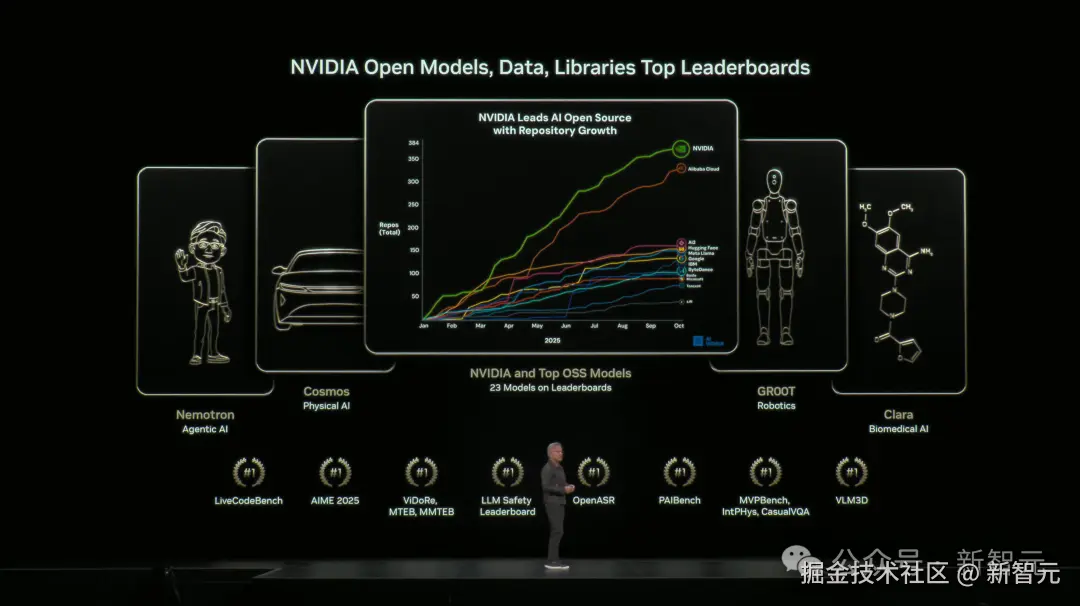

不仅如此,老黄这场演讲,还在向世界宣告:英伟达不仅是算力之王,更是 AI 生态的绝对核心。

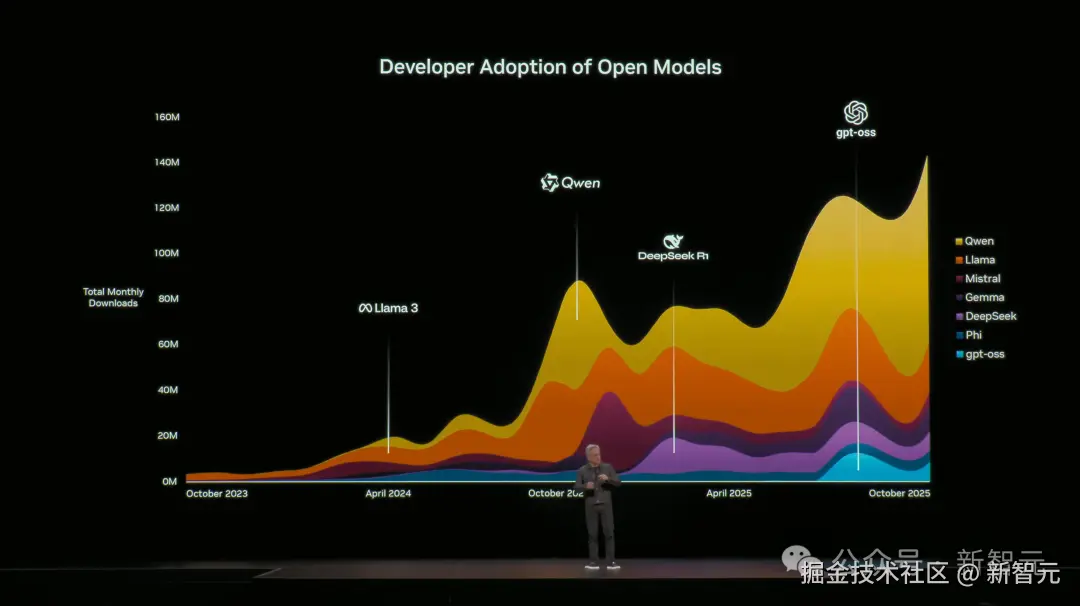

老黄一针见血,「过去几年,开源 AI 在推理、多模态、蒸馏效率三大维度上,实现巨大飞跃」。

正是这些进步,让开源模型第一次真正成为开发者手中非常实用的工具。

全世界,都离不开开源。

为此,英伟达也在全力投入这一方向。目前,他们在全球开源贡献榜上,23 个模型上榜,覆盖了语言、物理 AI、语音、推理等全领域。

我们拥有全球第一的语音模型、第一的推理模型、第一的物理 AI 模型。下载量也非常惊人。

「物理 AI 时代」

「三台计算机铸真神」

当 AI 走向应用最后一层堆栈,那便是物理 AI(Physical AI)。

一直以来,老黄认为,要实现物理 AI,需要三台计算机------

一个是 GPU 超算用于训练,一个通过 Omniverse Computer 用于模拟,另一个是机器人计算机。

以上这三种计算机上都运行着 CUDA,由此才能推动「物理 AI」发展,也就是理解物理世界、物理定律、因果关系的 AI。

目前,英伟达正联手伙伴,打造一个工厂级的物理 AI。一旦建成,就会有大量机器人在数字孪生的世界中工作。

「 」

」

「Robotaxi,也是一种机器人」

在自动驾驶领域,英伟达推出了一套「开箱即用的 L4 级自动驾驶底座」------「DRIVE AGX Hyperion 10。」

它搭载了 NVIDIA DRIVE AGX Thor 系统级芯片、经过安全认证的 NVIDIA DriveOS 操作系统、一套经过完整认证的多模态传感器套件(包含 14 个高清摄像头、9 个雷达、1 个激光雷达和 12 个超声波传感器)以及认证的板卡设计。

- 算力与模型:共有两颗基于 Blackwell 架构的 DRIVE AGX Thor,每颗算力超 2,000 FP4 TFLOPS(1,000 INT8 TOPS),专为 Transformer、VLA 与 GenAI 优化,360° 融合多模态传感器,面向 L4 自动驾驶。

- 迭代与验证:平台可 OTA 升级、兼容现有 AV 软件,并引入 Foretellix Foretify Physical AI 工具链做测试与验证;同时开放全球最大多模态 AV 数据集(1700 小时、25 国),用于基础模型的开发 / 后训练 / 验证。

在数万亿英里真实及合成驾驶数据的加持下,新一代 VLA(视觉 - 语言 - 动作)推理模型,让车辆不只能识别红绿灯,还能在无结构路口或人车行为突变时做出类人判断(比如理解交警临时指挥、突发改道),而且是在车上实时完成。

对于行业来说,公司可以直接拿到可量产的参考架构与数据 / 验证闭环,更快把 Robotaxi 或无人配送车跑起来。

「NVIDIA ARC:用 AI 重新定义 6G 网络」

在通信行业,英伟达则宣布与诺基亚达成合作,并推出了支持 AI 原生 6G 的加速计算平台------Aerial RAN Computer Pro(ARC-Pro)。

- ARC-Pro = AI 基站主机:融合了「连接 + 计算 + 感知」能力的 6G-ready 加速计算平台;运营商未来可以通过软件升级的方式从 5G-Advanced 升到 6G。

- AI-RAN = 无线 + AI 共生:把 AI 推理(如频谱调度、节能控制、用户体验优化)和传统 RAN 处理跑在同一套、由 GPU 加速的软定义基础设施上;同一站点还能顺带承载生成式 / 智能体 AI 的边缘服务,有效利用「基站闲时算力」。

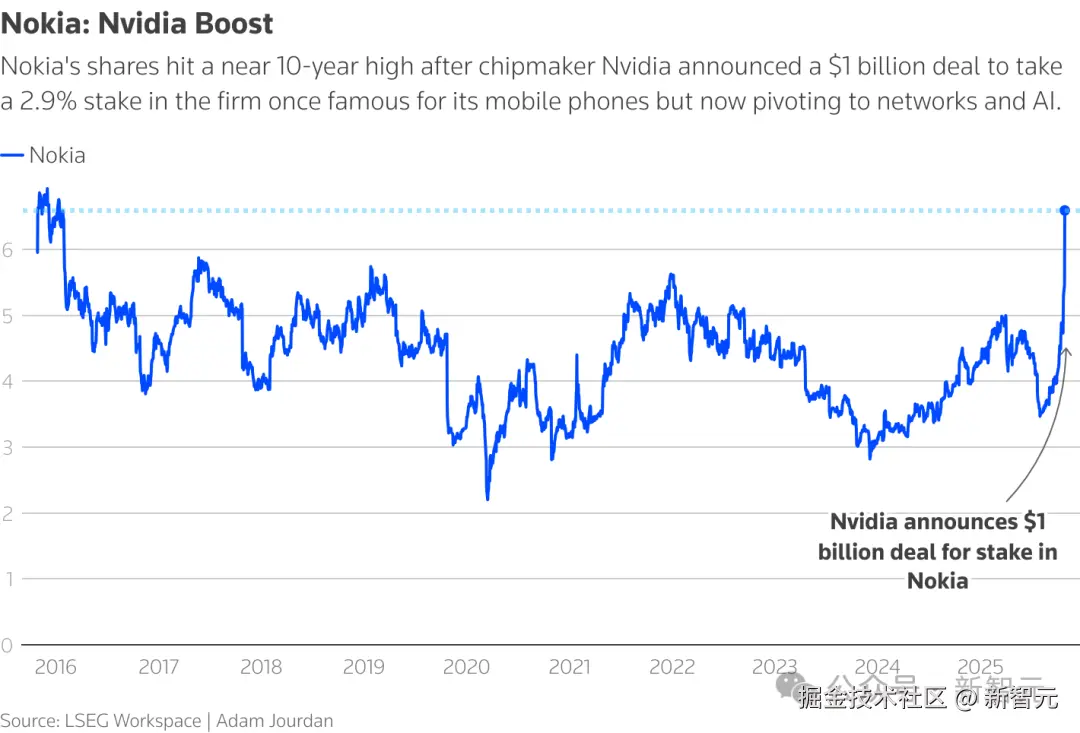

与此同时,英伟达还将以每股 6.01 美元的认购价向诺基亚投资 10 亿美元。

交易宣布后,诺基亚股价收盘上涨 20.86%,创下自 2016 年 1 月下旬以来的新高。

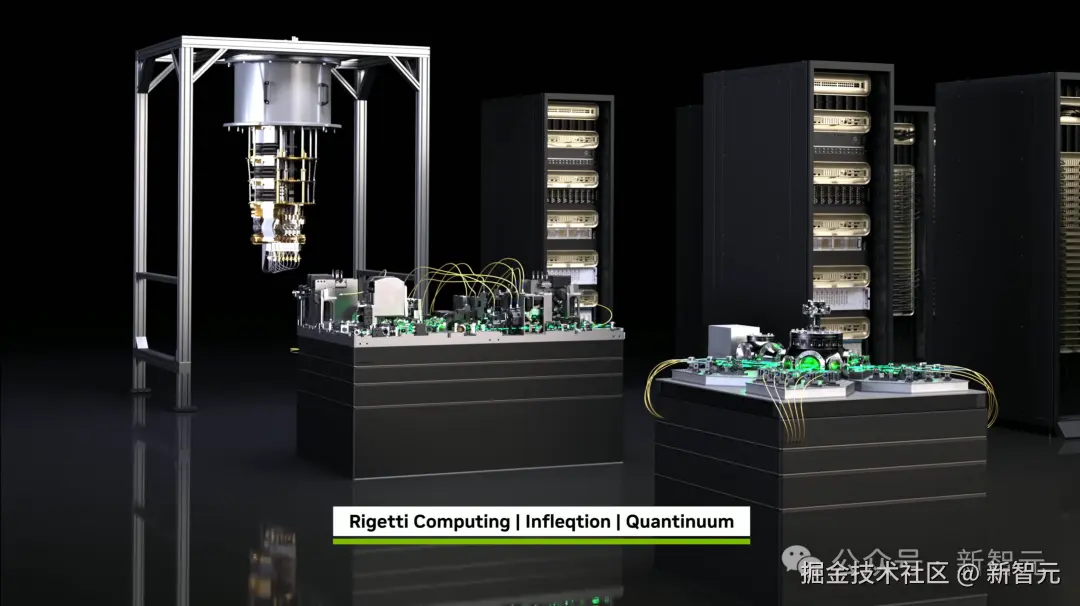

「NVQLink:打通 AI 与量子的融合之路」

在量子计算领域,众所周知,量子计算机的核心「量子比特」(Qubits),虽具备碾压传统计算机的并行计算潜力,但在计算过程会不断产生错误。

为了让它们正常工作,就必须依赖一台传统的超级计算机,通过一条要求严苛的超低延迟、超高吞吐量的连接,实时进行复杂的校准和纠错。

这条连接线,就是量子计算通往现实世界的最大瓶颈。

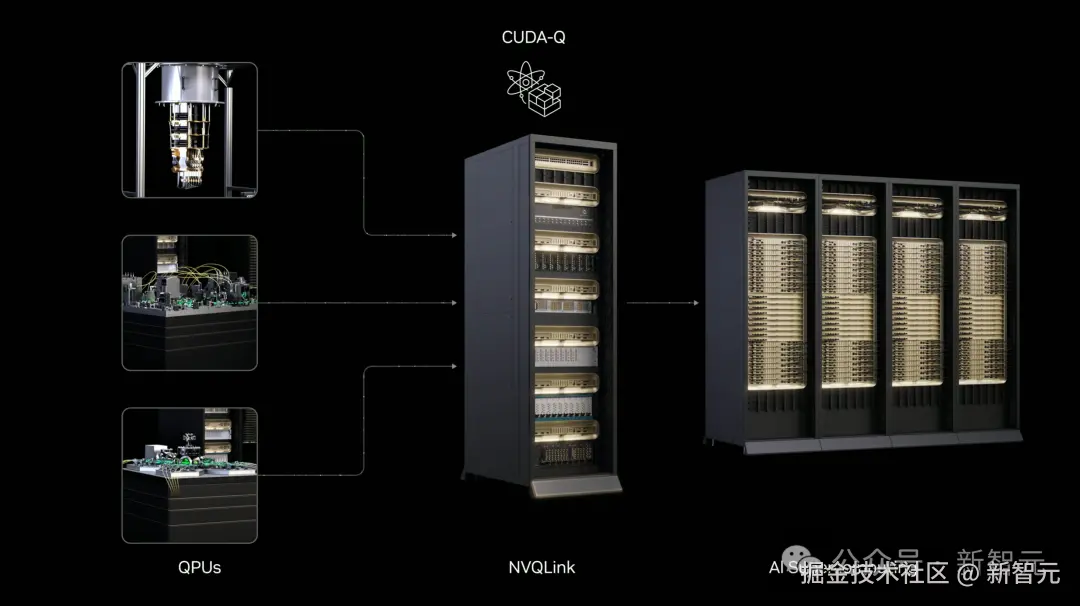

为此,英伟达推出了一款全新的互连技术------NVQLink,首次将量子处理器与 AI 超级计算机无缝地、紧密地连接在一起,形成一个单一、连贯的超级系统。

- 硬件层:通过 NVQLink,研究人员可以把不同量子路线(超导、离子阱、光子等)的处理器和控制硬件直接接到 GPU 超算上,避免了「绕以太网一大圈」的抖动与时延;同时,连在一起的 GPU 集群还可以继续向外扩展。

- 软件层:通过 CUDA-Q,研究人员可以在同一套编程接口里,把 CPU、GPU、QPU 编排成一台「混合超算」,让仿真、编排、实时控制能够在一个平台里闭环。

- 生态层:集合 9 家美国实验室、17 家量子硬件公司、5 家控制系统公司之力,目标是把**「校准、纠错、混合应用」**做成可复用的「套路」。

正如老黄所说:「NVQLink 是连接量子和经典超级计算机的罗塞塔石碑。它的出现,标志着量子 - GPU 计算时代的正式开启。」

参考资料: