数据已成为企业驱动业务流程优化的核心要素。然而,分散的异构系统(ERP、CRM、MES、SaaS 等)导致的数据割裂严重制约了数据分析的实时性和决策的准确性。对于企业而言,提升数据集成效率是确保数据资产价值最大化的首要任务。

本文将从技术架构层面出发,探讨实现高效数据集成所必须关注的关键能力和实施策略。

高效数据集成架构的核心要求

传统的数据集成模式(如硬编码ETL脚本或点对点接口)在面对系统数量激增和数据异构性增强时,维护成本和开发周期呈指数级增长。现代高效集成架构必须满足以下三个核心要求:

1、广泛的系统连接与协议兼容性

企业IT环境涉及关系型数据库、NoSQL 数据库、文件系统、公有云 API 及特定行业应用接口。

- 技术挑战: 平台必须提供标准化的连接器框架,能够快速适配多种数据源和目标系统,避免为每个接口单独开发底层驱动。

- 关键能力: 需要具备如 DB 数据输入组件 、标准 API 输入 (支持 REST/SOAP 等协议),以及针对核心业务系统(如金蝶 K/3Cloud 接口输入)的深度集成能力。

2、可视化的数据流转编排能力

提升效率的核心在于将复杂的编程逻辑转化为可配置、可复用的流程。

- 技术要求: 平台需支持直观的拖放操作 和图形化编辑器 ,允许技术人员通过配置数据流转节点而非编写代码来定义集成任务。

- 效益指标: 降低集成任务的配置时间,将集成项目周期从数周缩短至数日,提高对业务需求的敏捷响应能力。

3、强大的数据预处理与治理流水线

原始数据在集成过程中必须经过严格的清洗、转换和标准化处理。

- 处理复杂性: 涉及数据的结构化、非结构化转换,以及跨源数据的逻辑统一。

- 关键节点功能:

- 数据关联(JOIN): 整合来自不同数据源的业务实体信息。

- 数据分组(GROUP BY): 实现数据聚合计算,为 BI 分析准备汇总数据。

- JSON 解析: 快速处理来自 Web 服务或 NoSQL 数据库的非结构化数据。

- 字段设置/拆分: 统一数据格式和字段标准。

实现效率提升的平台化策略

为了系统性地解决上述挑战,企业需要转向采用专业的数据集成平台化解决方案。

- 集中管理与复用机制

平台应提供一个集中的集成任务管理控制台,所有连接配置、转换规则和执行日志都应集中存储和监控。这确保了集成逻辑的透明度和可维护性。任何一个数据源或目标系统的变化,只需在平台内更新一次连接器配置,无需修改大量分散的接口代码。

- 数据处理的即时化和多样化输出

高效集成不仅仅是数据输入,更在于其输出价值。平台必须支持将处理后的数据投放到不同的业务消费端。

- 数据输出目标: 包括将标准化数据写入数据仓库(数据表输出 )、暴露为微服务接口供前端应用调用(API 输出 ),以及将处理结果反向更新至业务系统(如金蝶 K/3Cloud 接口输出)。

- 分析应用支撑: 集成过程的终点是为业务洞察服务,平台应直接支持报表、大屏等数据呈现方式的快速生成。

平台化的实践价值分析

为更好理解,我们将以 KPaaS平台 为代表的方案进行举例,展示其完整的数据集成分析应用解决方案,如何适用于复杂异构环境下的数据整合。

平台在实践中通过其架构实现效率提升:

- 输入层全覆盖: 平台通过集成 API 输入、DB 数据输入组件、金蝶 K/3Cloud 接口输入等,提供广泛的连接能力。这消除了底层协议适配的复杂性,使技术人员能专注于业务数据流的设计。

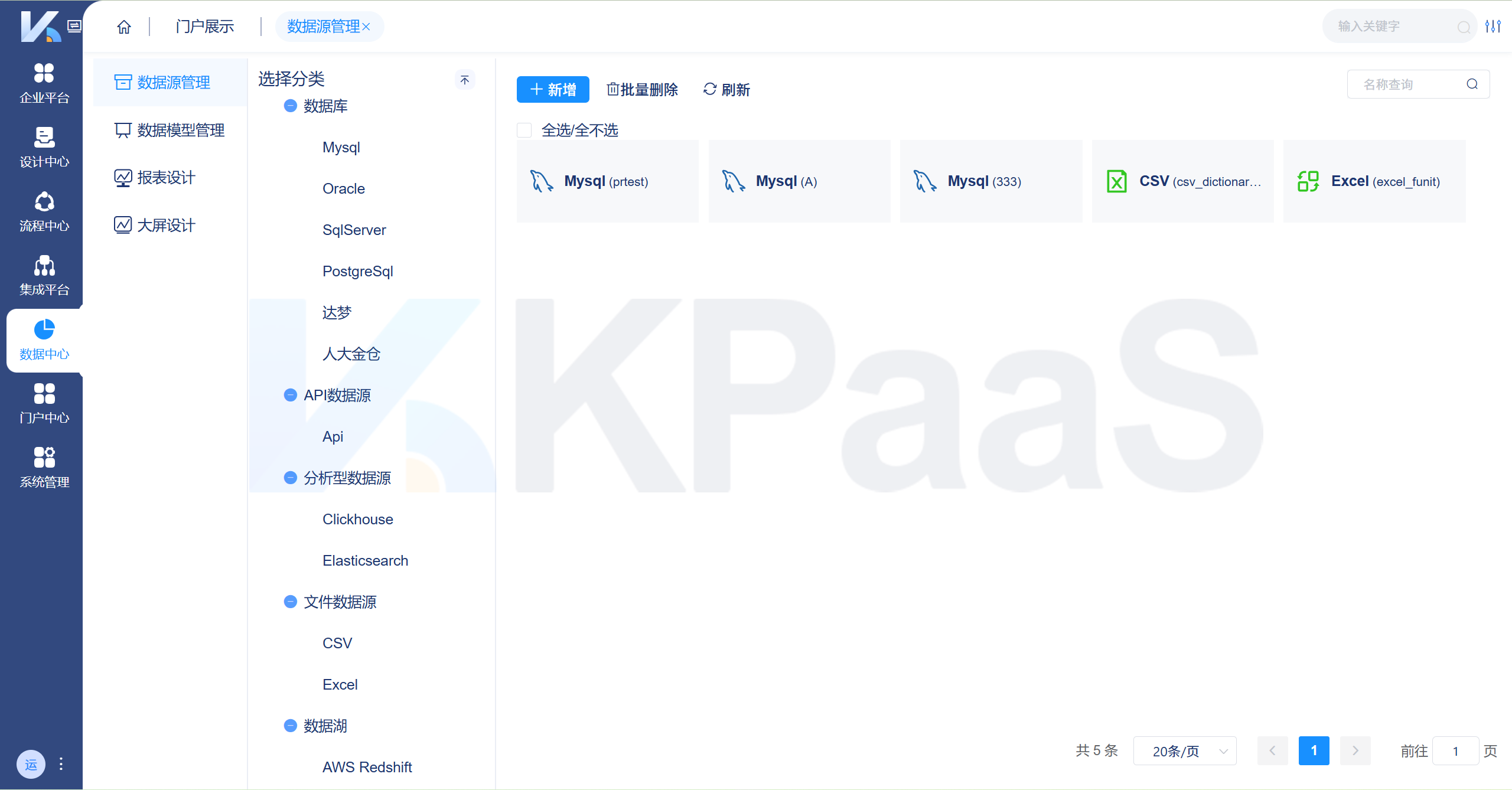

KPaaS平台数据源管理支持多种类型数据接入,助力企业统一管理异构数据。

KPaaS平台数据源管理支持多种类型数据接入,助力企业统一管理异构数据。

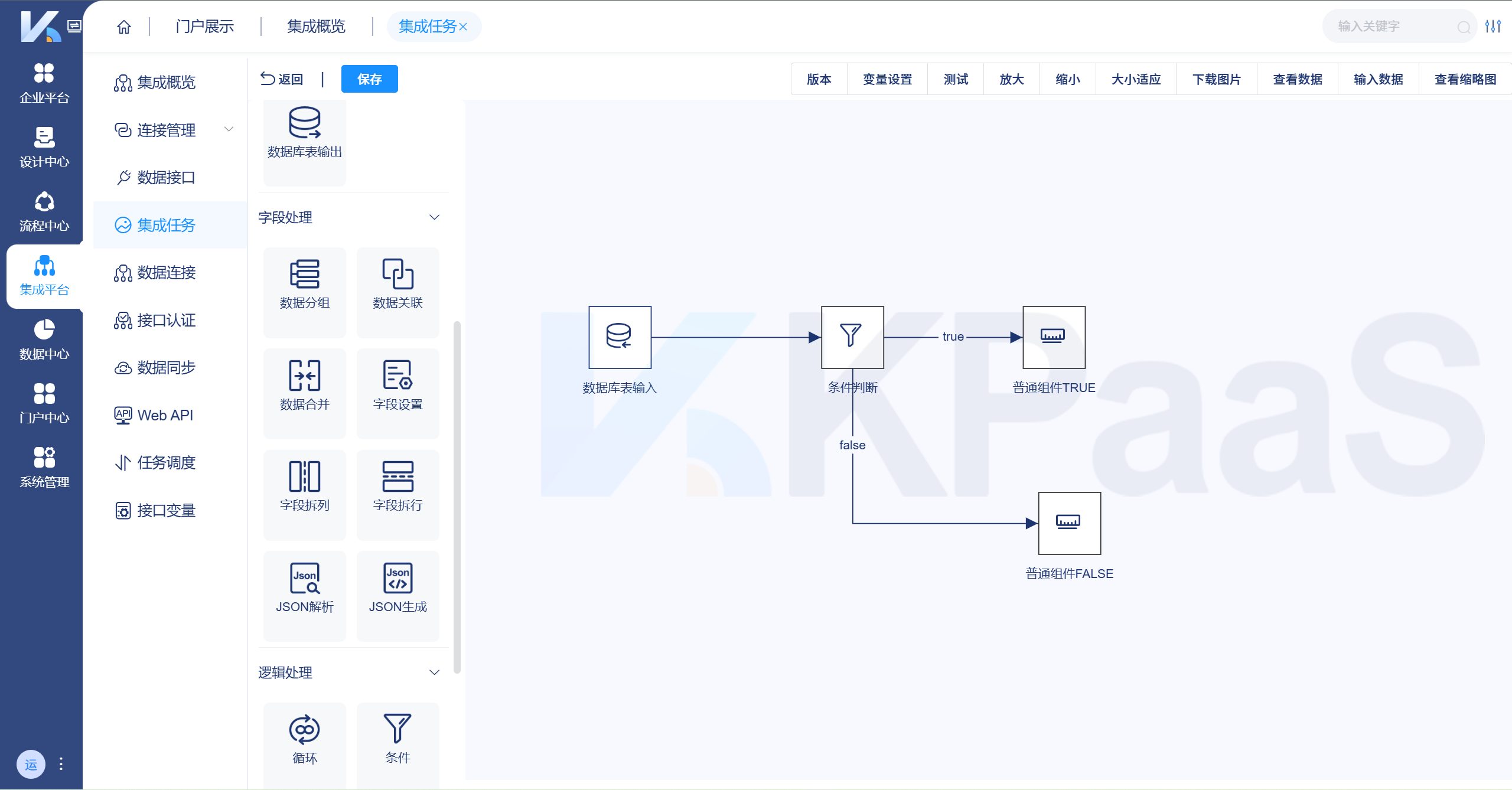

- 治理流程配置化: 平台内置了数据合并、数据关联、数据分组、JSON 解析、字段设置等一站式数据治理/处理能力。这些组件的丰富节点间交互,意味着复杂的数据清洗和逻辑转换可以通过配置而非编码实现,显著减少了开发量和调试时间。

KPaaS平台提供了可视化的建模工具,用户可以高效定义和管理数据模型,无需复杂编码。

KPaaS平台提供了可视化的建模工具,用户可以高效定义和管理数据模型,无需复杂编码。

- 开发体验的优化: 平台的核心优势在于支持直观的拖放操作,用户在可视化编辑器中构建集成任务,将"开发"转化为"配置"。这极大地提高了业务需求的实现速度,提高了IT部门对业务变化的敏捷响应能力。

KPaaS平台接口认证支持Web API在线测试,可直接模拟请求、调试鉴权逻辑、实时验证Token有效性等。

KPaaS平台接口认证支持Web API在线测试,可直接模拟请求、调试鉴权逻辑、实时验证Token有效性等。

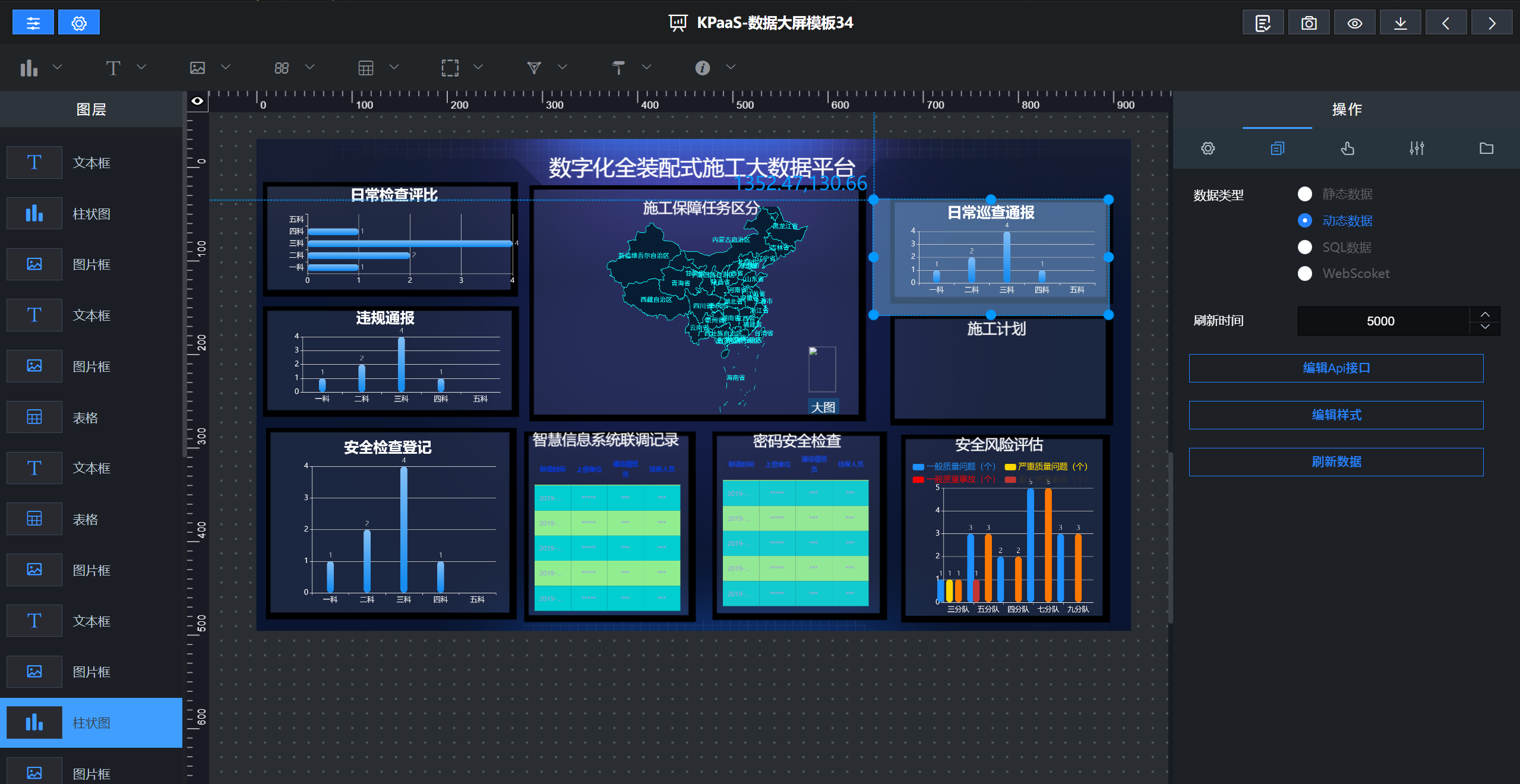

- 输出价值的闭环: 通过支持 API 输出、数据表输出、金蝶 K/3Cloud 接口输出 等多种交付方式,平台确保了处理后的数据能够高效、准确地流向数据仓库、应用系统和微服务,并能通过报表、大屏等方式快速实现数据价值的呈现。

KPaaS 平台提供丰富的图表组件与交互控件,支持任意维度、度量切换,帮助企业快速构建高质量数据可视化大屏。

KPaaS 平台提供丰富的图表组件与交互控件,支持任意维度、度量切换,帮助企业快速构建高质量数据可视化大屏。

结语

对于企业 IT 与数据团队而言,数据集成不应再是"成本中心",而应成为驱动业务创新的"价值引擎"。通过构建一个支持多源接入、可视化处理、闭环输出、可观测治理的集成平台,IT团队可以:

- 缩短需求交付周期,提升响应速度;

- 降低运维复杂度,保障系统稳定性;

- 释放人力投入更具战略性的项目。