类似的聊天前端 还有Cherry Studio 、AnythingLLM

| 维度 | Chatbox | Cherry Studio | AnythingLLM |

|---|---|---|---|

| 安装 & 快速上手 | 很快安装,即下即用,界面简洁 | 安装也方便,但功能较多需要学习 | 安装相对也便利,但功能复杂,新手可能门槛高 |

| 多模型支持(云端 + 本地) | 支持多个提供方但功能可能较基础 | 非常强,多模型 + 本地 +云端切换 | 支持本地 +云端,但重点偏文档+知识库 |

| 本地模型/隐私 | 支持本地模型(如 Ollama) | 支持本地模型 +本地部署 | 本地优先,隐私强,默认本地运行 |

| 文档/知识库/RAG能力 | 较弱/基本 | 较强 | 最强,专注文档 +向量检索 +知识库 |

| 面向的用户类型 | 个人用户、轻量聊天、快速尝试 | 开发者、中高阶用户、需要功能丰富 | 企业用户、研究人员、需要知识库 +自动化 |

| 学习成本 | 最低 | 中等 | 最高(功能最多、配置可能更复杂) |

| 资源要求 | 较低 | 中等 | 较高(特别是本地模型 +RAG场景) |

一、Ollama 和 Chatbox 区别

| 项目 | Ollama | Chatbox |

|---|---|---|

| 角色 | 模型引擎 / 后端 | 聊天前端 |

| 是否离线运行 | ✅ 支持完全离线 | ⚠️ 取决于所连模型 |

| 是否带界面 | ❌ 无界面 | ✅ 有界面 |

| 是否可连接多模型 | ❌ 仅限本地模型 | ✅ 支持多模型来源 |

| 是否开源 | ✅ 部分开源 | ✅ 开源 |

| 常见组合 | 与 Chatbox / LM Studio 等前端搭配 | 作为前端连接 Ollama |

Ollama 和 Chatbox 都可以用来运行或使用大语言模型(LLM),但它们的定位、功能、使用方式和技术原理完全不同。下面做一个清晰对比:

| 工具 | 简介 |

|---|---|

| Ollama | 本地运行大模型的后端服务,可加载如 LLaMA、Mistral、Phi 等模型,专注模型推理与管理。 |

| Chatbox | 多模型统一聊天界面(前端 UI),可连接 Ollama、OpenAI、Claude、Gemini、等后端,用来聊天与管理会话。 |

1.1 技术定位区别

| 对比项 | Ollama | Chatbox |

|---|---|---|

| 类型 | 模型运行环境(Backend) | 聊天应用界面(Frontend) |

| 作用 | 在本地加载、运行和管理大语言模型 | 提供统一界面与不同模型聊天 |

| 运行位置 | 本地后台服务(命令行/服务进程) | 桌面应用(可连接多个模型来源) |

| 是否能独立回答问题 | ✅ 能(加载模型后可直接推理) | ❌ 不能(需要连接后端模型) |

1.2 使用方式区别

| 使用方式 | Ollama | Chatbox |

|---|---|---|

| 安装 | 直接安装 Ollama 程序(Windows/Mac/Linux) | 安装 Chatbox 桌面客户端 |

| 调用接口 | 提供本地 REST API (http://localhost:11434/api/generate) |

通过 GUI 连接 Ollama / OpenAI / etc |

| 模型管理 | 内置模型仓库,支持 ollama pull llama3 等命令 |

仅展示由后端(如 Ollama)提供的模型列表 |

| 聊天功能 | 命令行聊天或配合前端使用 | 图形化聊天界面,可切换模型、保存对话 |

1.3 工作关系(常见组合)

两者是可以配合使用的 👇

[Chatbox] ←→ [Ollama 本地服务]

↑

加载本地模型(如 LLaMA3、Mistral)即:

- Ollama 负责在本地运行模型;

- Chatbox 连接到 Ollama 的本地端口(一般是 11434);

- 在 Chatbox 的界面中输入问题,底层实际调用的是 Ollama 的推理服务。

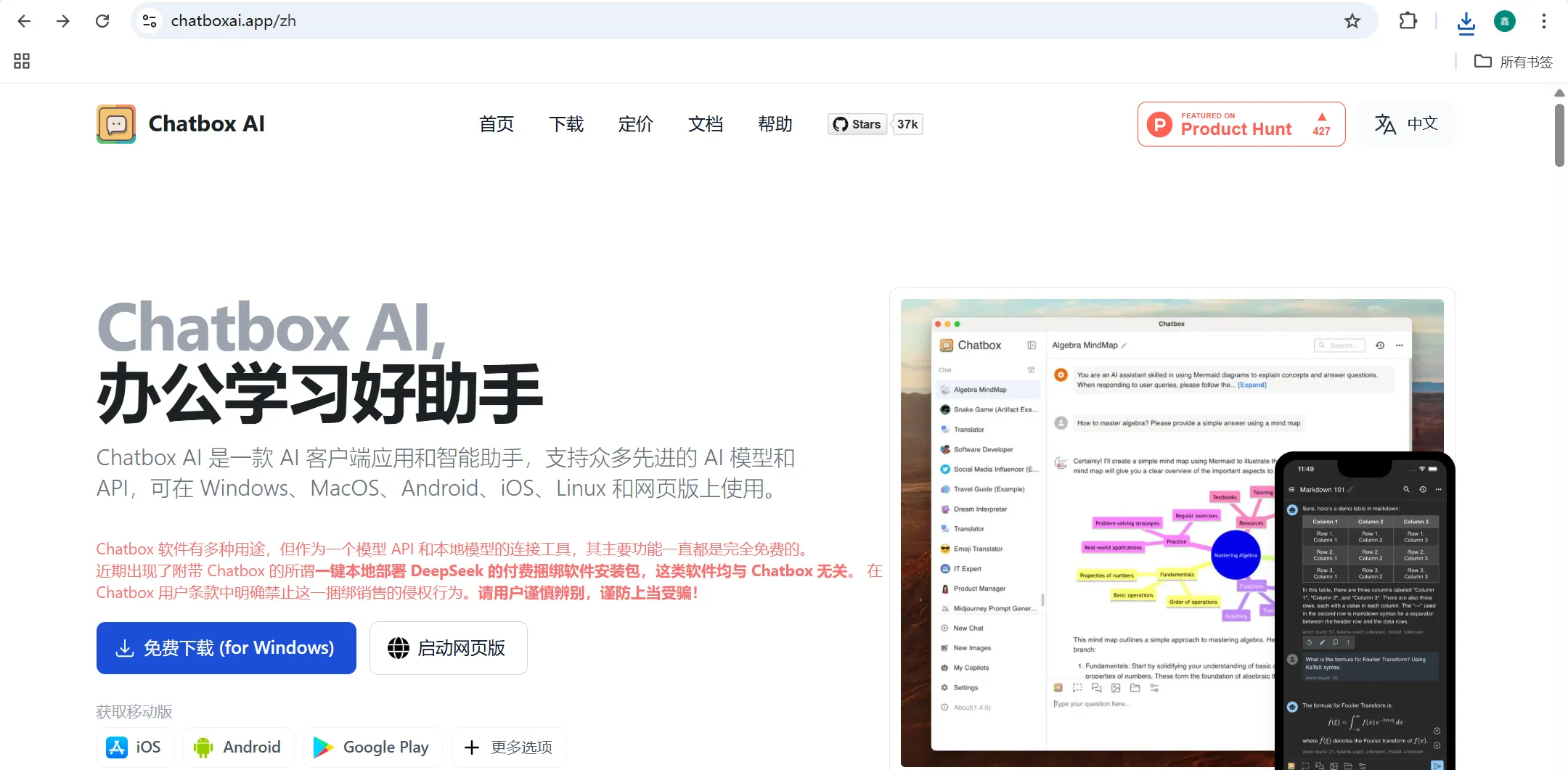

二、Chatbox 安装

2.1 下载安装程序

下载后安装包名称:Chatbox-1.16.4-Setup.exe

2.2 安装

右键安装包已管理员方式运行

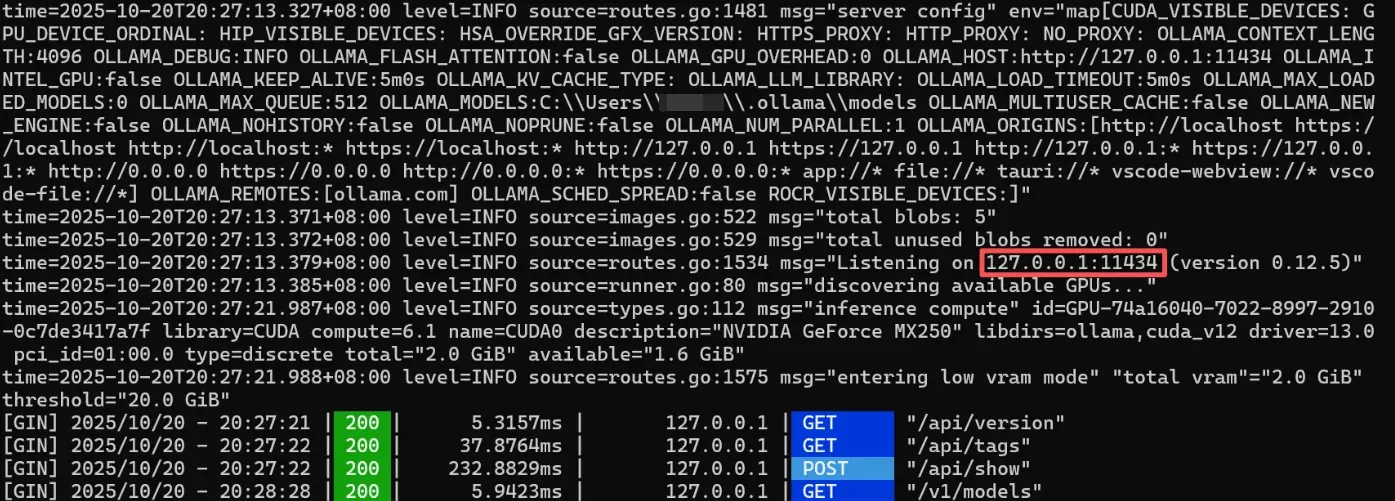

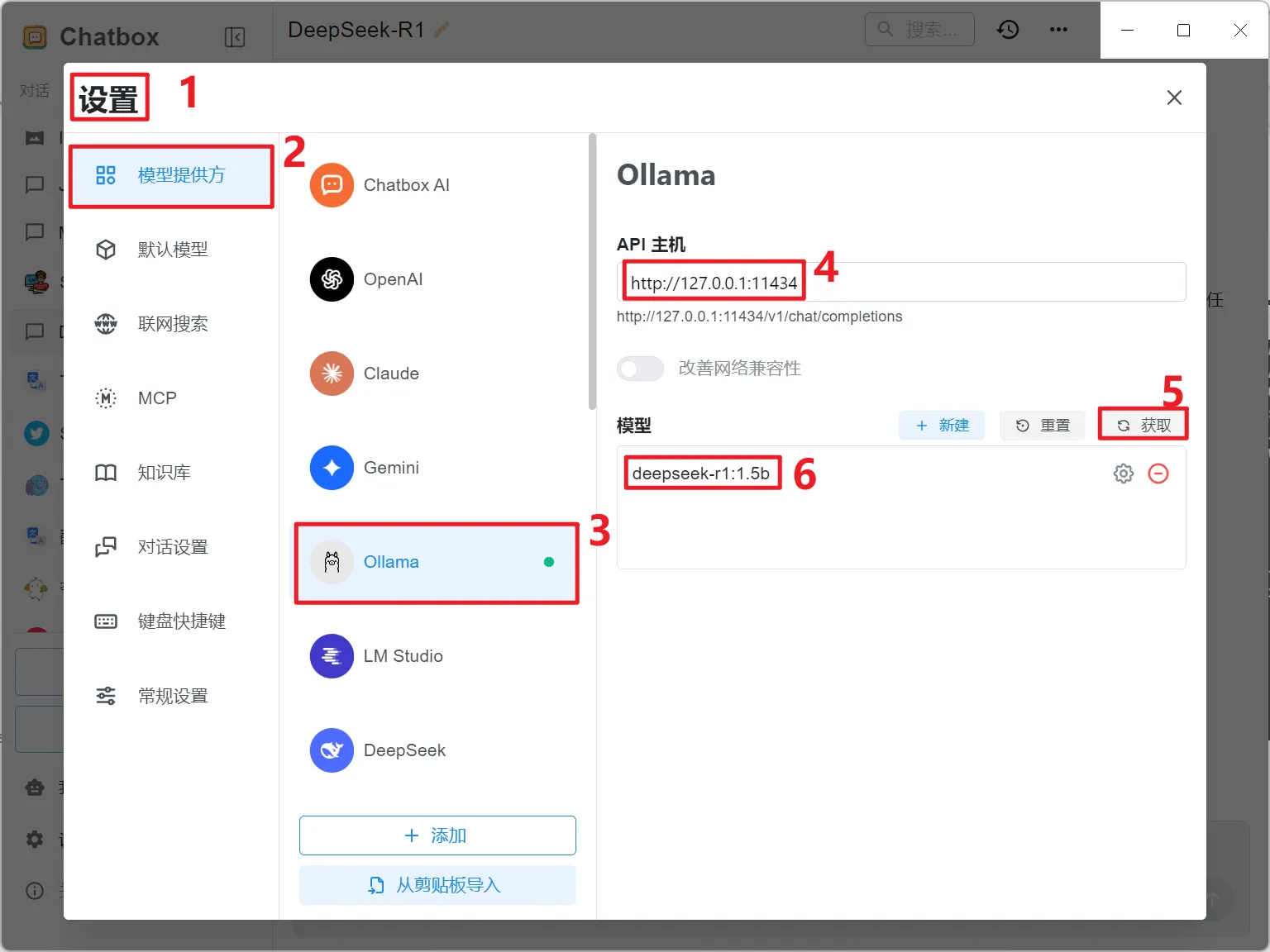

2.3 配置模型

1.先启动Ollama

2.选择Ollama模型

从上述启动Ollama后,日志中暴漏的API(上图红色框选位置)填入配置即可。

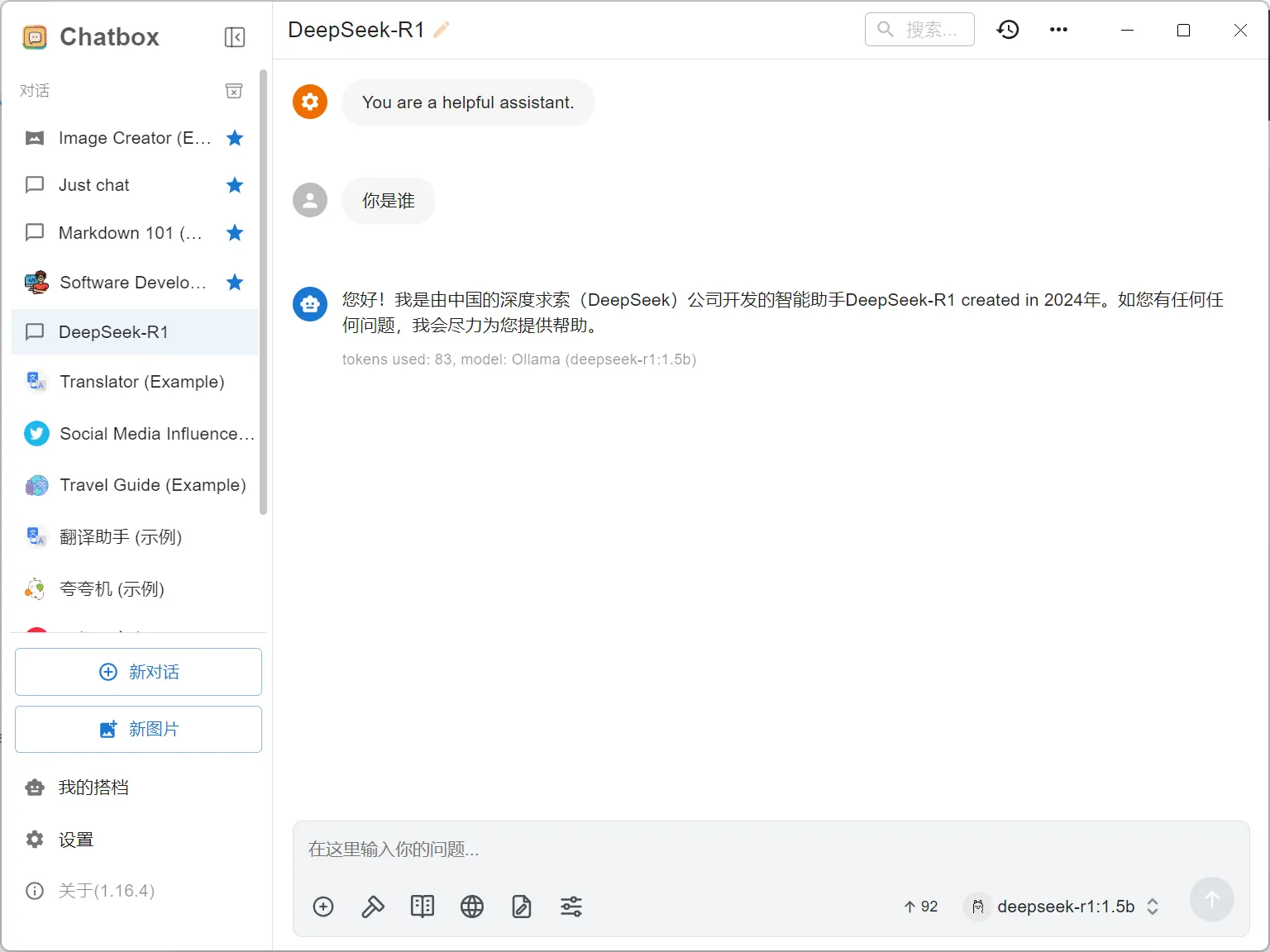

3.成功对话页面如下