笔者链接:扑克中的黑桃A

专栏链接:论文精读

本文关键词 :证券领域; 业务规则; 需求规约; 大语言模型; 领域知识; 软件需求

引

诸位技术同仁:

本系列将系统精读的方式,深入剖析计算机科学顶级期刊/会议论文,聚焦前沿突破的核心机理与工程实现。

通过严谨的学术剖析,解耦研究范式、技术方案及实证方法,揭示创新本质。我们重点关注理论-工程交汇点的技术跃迁,提炼可迁移的方法论锚点,助力诸位的技术实践与复杂问题攻坚,共推领域持续演进。

每日一句

低头看勇气,

抬头看实力。

目录

[1. 四大核心难题:证券"菜单"的特殊性](#1. 四大核心难题:证券“菜单”的特殊性)

[2. 大语言模型的"翻译缺陷":光靠智能工具不够](#2. 大语言模型的“翻译缺陷”:光靠智能工具不够)

[1. 第一步:业务规则过滤------筛选"需要厨房操作的菜品"](#1. 第一步:业务规则过滤——筛选“需要厨房操作的菜品”)

[2. 第二步:需求信息抽取------拆"菜品"为"食材+步骤"](#2. 第二步:需求信息抽取——拆“菜品”为“食材+步骤”)

[3. 第三步:需求可操作化------把"适量盐"明确为"5克盐"](#3. 第三步:需求可操作化——把“适量盐”明确为“5克盐”)

[4. 第四步:需求关系识别------确定"先备菜再烹饪"的顺序](#4. 第四步:需求关系识别——确定“先备菜再烹饪”的顺序)

[1. 案例研究:深圳证券交易所债券规则文档处理](#1. 案例研究:深圳证券交易所债券规则文档处理)

[2. 实验评估:四大核心问题验证](#2. 实验评估:四大核心问题验证)

[1. 当前挑战:有效性威胁](#1. 当前挑战:有效性威胁)

[2. 未来方向:三大优化点](#2. 未来方向:三大优化点)

文献来源

李靓果, 薛志一, 陈小红, 张民, 陈良育, 李萍萍, 姜婷婷. 结合大语言模型和领域知识库的证券规则规约方法.

DOI: 10.13328/j.cnki.jos.007294

软件学报 , 2025, 36(10): 4671--4694

已标明出处,如有侵权请联系笔者。

前言

如果把证券交易所的业务规则文档比作一家高端餐厅的"复合型菜单",你会发现它藏着不少"点餐陷阱":菜单上既有"现点现做的热菜"(需要软件实现的交易规则,如"匹配成交时间9:15-9:25"),也有"餐厅营业时间"(与软件无关的规则,如"交易所动态调整交易方式");既有"专业食材术语"(如"债券通用质押式回购",像菜单里的"M5和牛"),也有"抽象烹饪要求"(如"竞买预约要素",像菜单里的"适量调料");更麻烦的是,菜单没写"先备菜再烹饪"的顺序(如"撤销申报需先有已申报订单"的隐式关系)。

要把这张"复杂菜单"转化为厨房能直接执行的"操作指南"(需求规约),厨师(需求工程师)过去只能靠人工逐条翻译,不仅效率低(处理164条规则要几小时),还容易漏关键步骤(比如漏"申报数量为10万元整数倍")。而现在,结合"智能菜谱解析工具"(大语言模型)和"厨师经验手册"(领域知识库)的新方法,能把这个过程自动化,不仅操作指南准确率媲美资深厨师(功能点识别率91.97%),效率还提升10倍。

本文将从"证券菜单翻译难题"出发,详解如何用大语言模型和领域知识库破解规则过滤、信息抽取、需求落地、关系识别四大难题,通过真实案例和实验验证方法有效性,最后探讨未来优化方向,让你彻底理解证券领域需求规约的"智能翻译"逻辑。

一、证券规则规约的"菜单翻译难题":问题与挑战

要把证券业务规则文档转化为软件需求规约,就像把复杂菜单转化为厨房操作指南,核心难题在于"菜单"本身的复杂性和"翻译工具"的局限性,具体可拆解为四大问题和大语言模型的天然缺陷。

1. 四大核心难题:证券"菜单"的特殊性

证券业务规则文档(如《深圳证券交易所债券交易规则》)就像"加密版菜单",普通人很难直接转化为操作步骤,主要难在四点:

1."无关菜品"多:软件需求无关描述混杂

菜单里会写"餐厅每周三店休"(与厨房操作无关),证券规则里也有大量软件不用管的内容。比如案例1中《深圳证券交易所债券交易规则》的"规则3.1.3:本所可以对债券交易方式实施动态调整并公布",这是交易所的管理职责,不需要交易系统实现,就像餐厅店休时间不用厨师执行一样。但这些无关规则混在文档里,人工筛选耗时且易漏。

2."专业术语"多:领域黑话难理解

菜单里"低温慢煮牛肋条"需要知道"低温是65℃",证券规则里"匹配成交方式的债券现券申报数量为10万元面额或其整数倍","匹配成交""债券现券""面额"都是专业术语,外行人(非证券领域工程师)根本不懂,更别说转化为软件逻辑。传统工具(如基于规则的抽取)无法识别这些术语,导致需求抽取漏关键信息。

3."抽象描述"多:操作要求不明确

菜单里"适量盐"没说具体克数,证券规则里"竞买日前,卖方可以修改竞买预约要素"也没说"竞买预约要素"具体是什么(其实包括竞买方式、证券代码等),也没说适用的交易市场(深圳/上海交易所)、交易品种(债券/股票)。这种抽象描述如果不具体化,软件开发者根本不知道怎么实现,就像厨师不知道"适量"是多少一样。

4."隐藏顺序"多:操作依赖难发现

菜单里"番茄炒蛋"默认"先炒鸡蛋再炒番茄",证券规则里"撤销申报"也默认"先有已申报订单"。比如案例1中"规则4.1.10:9:20-9:25不接受撤销申报",其隐藏前提是"存在已申报的匹配成交订单",而这个前提没在规则里明说,人工容易忽略,导致软件逻辑缺失(比如用户没申报就点撤销,系统没处理)。

2. 大语言模型的"翻译缺陷":光靠智能工具不够

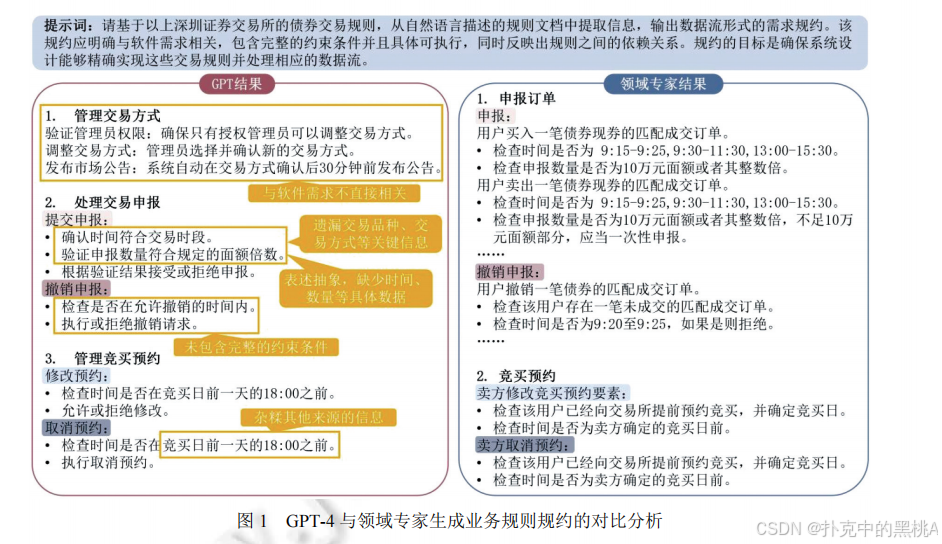

很多人以为用GPT-4这类大语言模型能直接"翻译"规则,但实验证明,它就像"没学过中餐的智能翻译",会犯五类错误,此处插入图1能直观看到差距:

图1这张"GPT-4与领域专家规约对比图"像"智能翻译与厨师操作指南的对比",左侧GPT结果漏了"申报数量需为10万元整数倍"等关键约束,还加入"竞买日前一天18:00前修改"的幻觉内容(规则里没有);右侧专家结果明确了时间、数量、前置条件(如"存在未成交订单"),精准对应软件需求。

具体来说,大语言模型的缺陷包括:

漏筛无关规则:提示词要求"只保留软件相关规则",但GPT-4仍会包含"交易所调整交易方式"这类无关内容,就像翻译菜单时把"店休时间"也写进操作指南。

丢关键信息:抽取"匹配成交申报"规则时,漏了"申报数量为10万元整数倍"的核心约束,导致软件无法校验数量合法性,类似翻译"番茄炒蛋"漏了"鸡蛋打散"的步骤。

表述抽象:把"确认时间符合交易时段"写进规约,却没明确是"9:15-9:25开盘集合匹配时间",软件开发者不知道具体时间范围,像写"加热食材"却没说"加热到100℃"。

漏隐式关系:生成"撤销申报"规约时,没提"需先有已申报订单"的前置条件,导致软件处理无申报时的撤销请求会出错,类似没说"煮米饭前要洗米"。

产生幻觉:无中生有"修改竞买预约需在18:00前",而规则里只说"竞买日前",这种错误信息会导致软件加错约束,像翻译时把"少盐"写成"不加盐"。

这些缺陷的根源是大语言模型缺乏"证券领域经验"------它知道通用语言逻辑,却不懂"匹配成交""竞买预约"的专业含义,也不知道软件需要哪些具体约束,必须结合"证券领域知识库"才能补全这些短板。

二、智能"翻译"方案:4步规约框架与核心技术

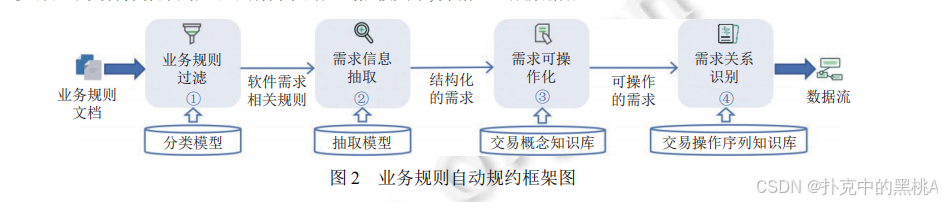

针对上述难题,论文提出"大语言模型+领域知识库"的4步规约框架,就像"智能翻译工具+厨师经验手册"的组合,把证券规则文档一步步转化为数据流形式的需求规约。【此处插入图2】清晰展示了这个流程:

图2这张"业务规则自动规约框架图"像"菜单转化为操作指南的流程",输入是"证券规则文档(菜单)",经过4步处理:①业务规则过滤(筛选需厨房操作的菜品)、②需求信息抽取(拆食材和步骤)、③需求可操作化(明确"适量"为具体克数)、④需求关系识别(确定烹饪顺序),输出"数据流形式的需求规约(厨房操作指南)",每个步骤都有对应的工具(分类模型、抽取模型、交易概念知识库、交易操作序列知识库)。

下面详细拆解每一步的"翻译逻辑"和核心技术,每个步骤都结合类比和具体实现:

1. 第一步:业务规则过滤------筛选"需要厨房操作的菜品"

核心目标:从规则文档中剔除软件无关规则(如交易所管理职责)和领域知识(如术语解释),只保留需要软件实现的规则,就像从菜单里删掉"餐厅营业时间""食材产地介绍",只留需要烹饪的菜品。

技术实现:微调的分类模型

由于"软件相关/无关"的判断靠语义(比如"交易时间""申报数量"是相关,"交易所职责"是无关),无法用简单规则定义,所以用Mengzi-BERT-base-fin模型(中文金融预训练模型)做微调:

- 数据集构建:标注18篇证券规则文档,共3328条数据,包括678条软件相关规则、2351条无关规则、299条领域知识,按9:1分训练集和验证集,并用数据增强(如同义词替换)把训练集扩到3.3万条,避免模型过拟合。

- 模型训练:输入是单条规则文本,输出是"相关/无关/领域知识"三类概率,用交叉熵损失函数、AdamW优化器,学习率从1e-5线性递减到0,每次训练8条数据,训练20轮。

效果:验证集准确率99.1%,能精准筛选,比如把"匹配成交时间9:15-9:25"归为相关,"交易所调整交易方式"归为无关,处理366条规则仅需3.89秒,比人工筛选快50倍。

类比来说,这个模型就像"经验丰富的点餐员",扫一眼菜单就能分清"需要厨房做的菜"和"不需要的信息",而且不会出错。

2. 第二步:需求信息抽取------拆"菜品"为"食材+步骤"

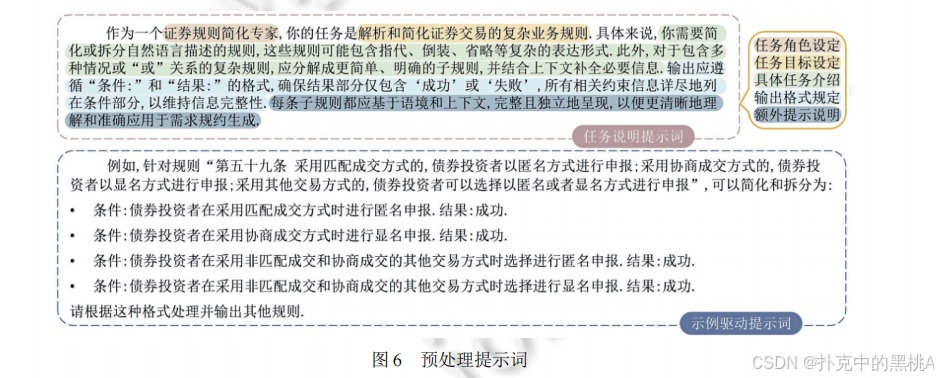

图 6这张 "预处理提示词" 就像 "把'复杂套餐说明'拆成'单个菜品做法'的拆解指南"。它通过两部分实现证券规则的简化:

任务说明提示词:定义 "证券规则简化专家" 的角色,明确要把含指代、倒装、"或" 关系的复杂规则,拆成 "条件 - 结果" 格式的简单子规则(结果仅为 "成功" 或 "失败"),且需补全约束信息,确保子规则独立完整;

示例驱动提示词:用 "复杂规则→多子规则" 的实例(如将包含多种交易方式的规则拆成 4 条 "条件 - 结果" 子规则),直观演示如何把 "套餐说明" 拆成 "单个菜品的做法步骤"。

核心目标

把筛选出的软件相关规则,从自然语言转化为"形式化需求"(FBR格式),就像把"番茄炒蛋"拆成"食材:番茄2个、鸡蛋3个;步骤:1. 鸡蛋打散,2. 番茄切块,3. 先炒鸡蛋再炒番茄",明确关键要素和逻辑。

技术实现:GPTs+证券需求元模型

直接用GPT-4会漏关键信息,所以先构建证券需求元模型(定义需求的构成要素),再用GPTs做上下文学习,确保抽取全面:

步骤1:构建需求元模型------定义"操作指南"的结构

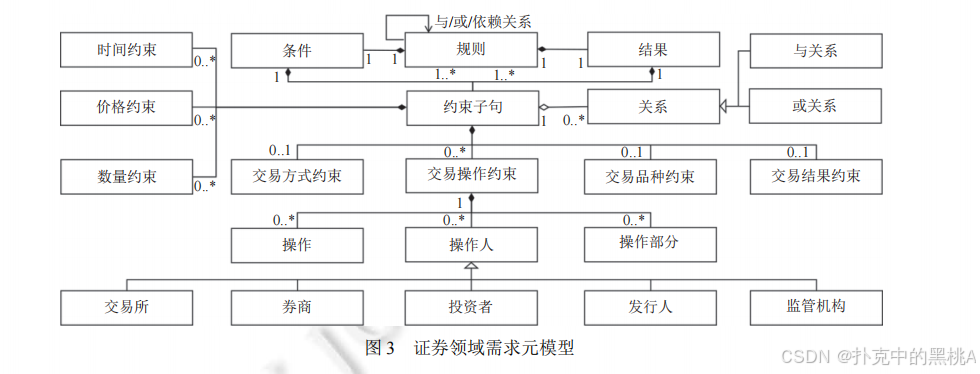

元模型就像"操作指南的模板",规定每个需求必须包含"条件"和"结果",条件又分7类约束:时间(如9:15-9:25)、数量(10万元整数倍)、交易方式(匹配成交)、交易品种(债券现券)、操作人(卖方)、操作(修改)、操作部分(竞买预约要素),还定义了需求间的"与/或/依赖"关系。【此处插入图3】展示了这个元模型的结构:

图3这张"证券领域需求元模型图"像"操作指南模板的结构图",清晰标注了需求由"条件"和"结果"组成,条件包含7类约束子句,约束子句由"实体类型-实体"对构成(如"时间-9:15-9:25"),需求间有与、或、依赖关系,确保抽取时不遗漏任何关键要素。

步骤2:定义15类实体类型------明确"要拆的要素"

基于元模型,定义15种需要抽取的实体类型,除了元模型中的"交易品种""时间""操作人"等,还增加"键(key)"和"值(value)"来处理低频约束(如"申报价格最小变动单位0.001元","申报价格最小变动单位"是key,"0.001元"是value),避免漏信息。

步骤3:设计提示词------教GPTs"怎么拆"

提示词分两部分:①任务说明(如"按15类实体类型抽取,用'实体类型:实体'格式输出");②100条示例(如输入"匹配成交的债券现券申报数量10万元整数倍",输出"交易方式:匹配成交,交易品种:债券现券,key:申报数量,数量:10万元面额或其整数倍")。

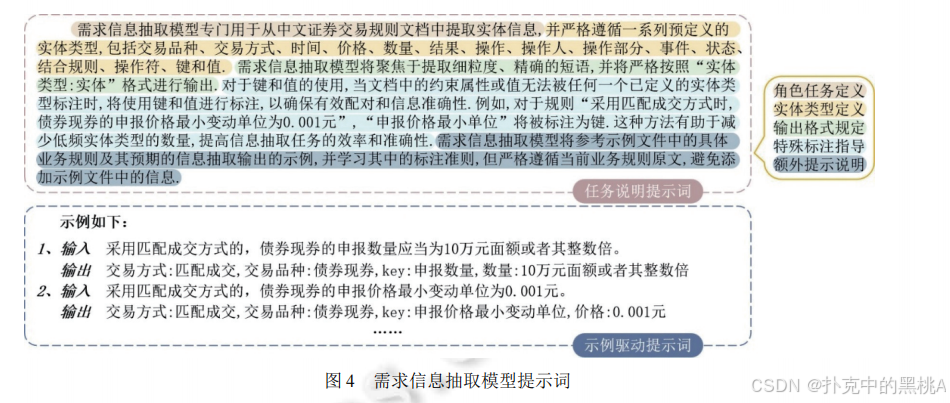

图 4这张 "需求信息抽取模型提示词" 像 "给智能翻译的'操作细则'",明确了三大核心约束:

- 角色任务定义:规定模型专门从中文证券交易规则中提取 15 类实体(交易品种、时间、数量等),对未定义的约束用 "键 - 值" 标注(如 "key: 申报数量,数量:10 万元整数倍"),避免漏检;

- 输出格式规定:强制要求 "实体类型:实体" 的格式,比如 "交易方式:匹配成交,交易品种:债券现券",确保抽取结果结构化;

- 示例驱动提示:通过 "输入 - 输出" 示例(如 "采用匹配成交方式的... 输出交易方式:匹配成交..."),让模型学习标注逻辑,同时严格遵循原文,不添加示例外的信息。

效果:信息抽取准确率97.76%,能完整提取"匹配成交""数量约束""操作人"等关键要素,比直接用GPT-4(准确率55.99%)高40多个百分点,不会漏关键信息。

3. 第三步:需求可操作化------把"适量盐"明确为"5克盐"

核心目标

解决形式化需求中的"抽象"和"不完整"问题,比如把"竞买预约要素"具体化为"竞买方式、证券代码等",补全"交易市场""交易品种"等缺失约束,就像把菜单里的"适量盐"明确为"5克盐","用烤箱加热"明确为"烤箱180℃加热20分钟"。

技术实现:交易概念知识库

知识库就像"厨师的食材处理手册",包含266条交易概念知识,分三类:

- 解释型知识:定义专业术语,如"竞买预约要素包括竞买方式、证券代码、价格区间、数量、竞买时间",用来把抽象术语具体化。

- 分类型知识:分类交易方式/品种,如"债券交易方式有匹配成交、点击成交、询价成交",用来补全缺失的交易方式约束。

- 组合型知识:描述要素组合,如"申报要素需包含证券代码、交易方向、证券账户",用来补全缺失的申报要素。

具体操作分4步:

- 必要约束补全:比如规则"竞买日前卖方可修改竞买预约要素",补全"交易市场:深圳证券交易所、交易方式:竞买成交、交易品种:债券",这些信息来自上下文和知识库。

- 抽象需求具体化:把"竞买预约要素"替换为"竞买方式、证券代码、价格区间、数量、竞买时间",基于知识库的解释型知识。

- 嵌套需求处理:如果规则引用其他规则(如"交易系统在3.1.5条规定的时间内接受申报"),就把3.1.5条的"9:15-9:25"补进当前需求,避免需求断裂。

- 同属性项组合:把"申报数量10万元整数倍"和"单笔最大100亿元"合并,确保数量约束完整,就像把"加少量糖"和"不超过10克糖"合并为"加5克糖"。

比如处理规则4.4.4后,可操作化的需求变为:

"if 交易市场 is 深圳证券交易所 and 交易方式 is 竞买成交 and 交易品种 is 债券 and 时间 is 竞买日前 and 操作人 is 卖方 and 操作 is 修改 and 操作部分 is 竞买预约要素(竞买方式、证券代码、价格区间、数量、竞买时间) then 结果 is 成功"

这一步让抽象的需求变得"软件可执行",就像厨师拿到明确的操作步骤,不会因"适量""少许"而困惑。

4. 第四步:需求关系识别------确定"先备菜再烹饪"的顺序

核心目标

识别需求间的隐式依赖关系(如"撤销申报"依赖"已申报订单"),生成数据流形式的规约,就像确定"先备菜→再炒鸡蛋→最后炒番茄"的顺序,确保软件按正确流程执行。

技术实现:交易操作序列知识库

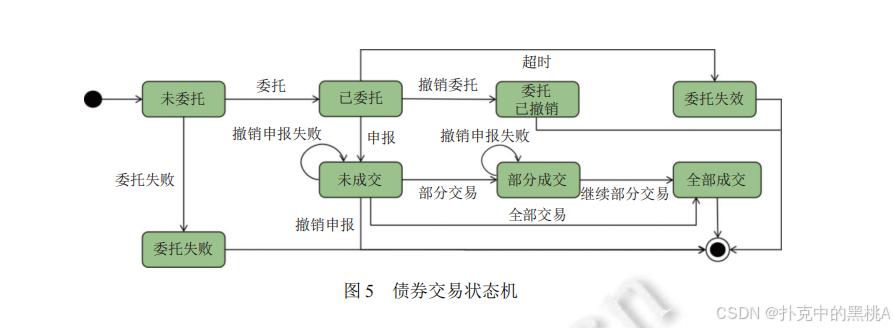

知识库包含56条交易操作序列知识,用状态机描述操作顺序和状态变化,【此处插入图5】是债券交易的状态机示例:

图5这张"债券交易状态机图"像"烹饪流程步骤图",展示了债券交易的8个状态(未委托→已委托→未成交→部分成交→全部成交等)和状态迁移条件(如"申报"触发"未委托→已委托","撤销申报"触发"已委托→已撤销"),基于这个状态机可识别操作的先后顺序。

具体识别分两种依赖:

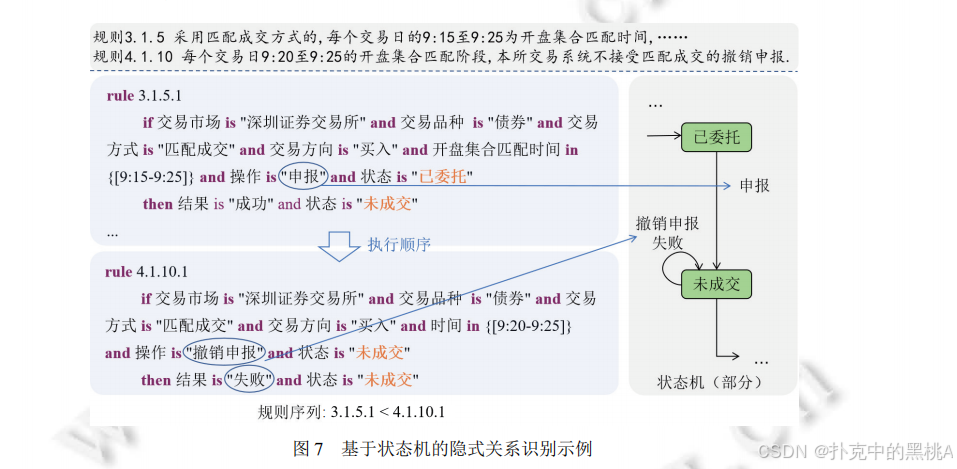

- 基于语义的隐式依赖:从规则的时间介词(如"在...前""在...后")识别前置/后置条件。比如"报价方发出报价后可修改未成交部分",提取"发出报价"为前置需求,补全为"if 报价方发出报价 then 可修改未成交部分";再比如"应价前可撤销竞买发起申报",补全反例需求"if 应价后撤销竞买发起申报 then 结果 is 失败"。

- 基于操作序列的隐式依赖 :对比需求操作与状态机的事件,确定顺序。比如"撤销申报"操作对应状态机的"已委托→已撤销"迁移,而该迁移的前提是"已委托"状态(由"申报"操作触发),因此"撤销申报"依赖"申报"需求,生成数据流"申报→未成交→撤销申报"。

图 7这张 "基于状态机的隐式关系识别示例" 宛如 "烹饪步骤的流程图",清晰拆解了证券规则间的执行顺序与状态依赖。

最后生成的数据流像"厨房操作流程图"。

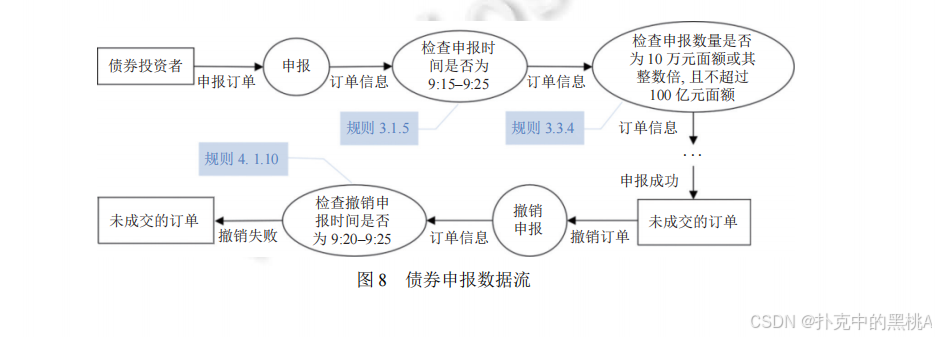

图8展示了债券申报的数据流:从"投资者申报订单"开始,先检查时间(规则3.1.5)、再检查数量(规则3.3.4)、最后检查撤销时间(规则4.1.10),明确每个步骤的输入输出和依赖关系,软件开发者可直接基于这个数据流设计接口和逻辑。

三、实战验证:案例与实验效果

为了验证这套"智能翻译"方案的有效性,论文用真实证券规则文档做案例研究,并通过4组实验回答核心问题(质量、策略对比、知识库作用、通用性),结果证明该方法比人工和单纯大语言模型更优。

1. 案例研究:深圳证券交易所债券规则文档处理

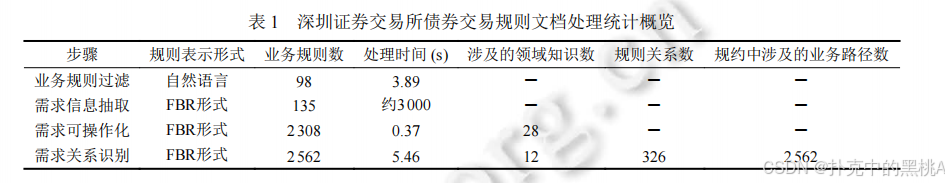

选择《深圳证券交易所债券交易规则》(164条规则,10章节)作为案例,按4步框架处理,表1展示了各步骤的关键数据:

表1这张"深圳债券规则处理统计表"像"菜单转化进度表",记录每一步的"规则形式(菜品状态)""数量(菜品数)""处理时间(耗时)""用到的领域知识(厨师经验)":①业务规则过滤后保留98条相关规则(3.89秒);②需求信息抽取拆为135条FBR形式需求(约3000秒,需与GPTs交互);③需求可操作化补全为2308条可执行需求(0.37秒,用28条领域知识);④需求关系识别生成2562条需求和326对关系(5.46秒,用12条领域知识),最终输出2562条数据流路径。

比如处理规则3.3.4("匹配成交的债券现券申报数量为10万元整数倍,卖出不足部分一次性申报"):

- 过滤:判定为软件相关规则;

- 抽取:拆为3条子规则(买入10万元整数倍、卖出不足一次性申报、回购1000元整数倍),抽取"交易方式:匹配成交、交易品种:债券现券、数量:10万元整数倍";

- 可操作化:补全"交易市场:深圳交易所",把"卖出不足部分"明确为"卖出时不足10万元面额需一次性申报全部数量";

- 关系识别:确定该需求是"申报"操作的一部分,依赖"交易时间符合9:15-9:25",生成数据流"检查时间→检查数量→申报成功"。

这个案例证明该方法能处理复杂的证券规则文档,生成完整、可执行的需求规约。

2. 实验评估:四大核心问题验证

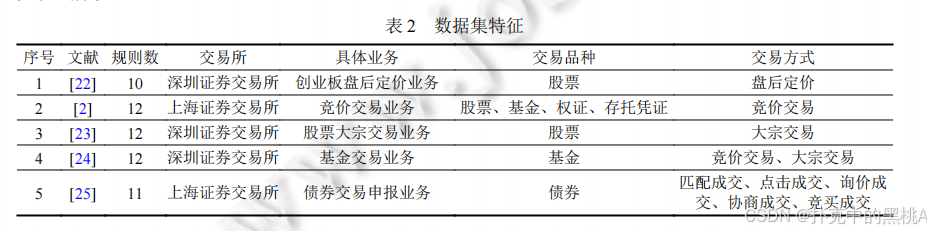

表 2这张 "数据集特征表" 像 "实验食材清单",详细列出 5 组实验数据集的核心信息:序号 1-5 分别对应不同交易所(深圳、上海)、业务(创业板盘后定价、竞价交易等)、交易品种(股票、基金、债券)和交易方式(盘后定价、竞价交易等),规则数在 10-12 条之间。它是实验的 "基础食材库",确保实验覆盖股票、基金、债券等多品种,竞价、大宗、盘后等多交易方式,验证方法的通用性。

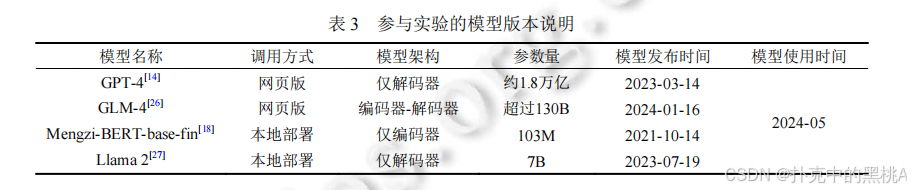

此外,论文设计4组实验(RQ1-RQ4),用5个国内数据集(涵盖债券、股票、基金等)和5个国际数据集(纽约、东京、香港交易所),对比领域专家、非专家、GPT-4、GLM-4与本文工具LLSec的效果,核心结果如下:

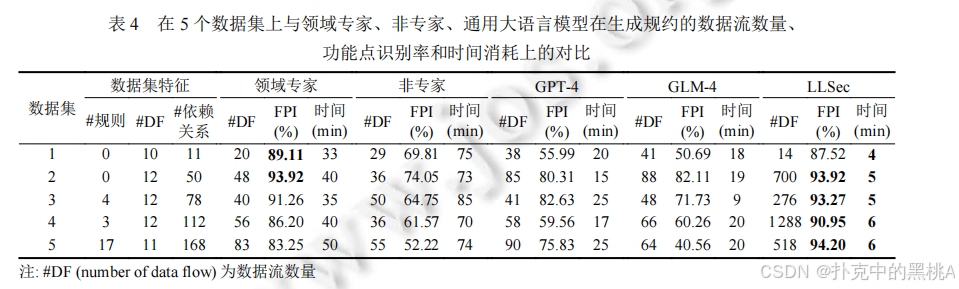

RQ1:质量与效率------LLSec媲美甚至超越专家

表 3这张 "参与实验的模型版本说明表" 应插入到第三章 "2. 实验评估:四大核心问题验证" 的 "RQ1:质量与效率 ------LLSec 媲美甚至超越专家" 部分开头,作为模型对比的基础说明。

- 质量:LLSec的平均功能点识别率91.97%,在数据集5(上海债券申报规则)达94.20%,比领域专家(83.25%)高10个百分点,比GPT-4(75.83%)高18个百分点,比非专家(52.22%)高42个百分点。功能点识别率高意味着规约包含更多正确约束,比如LLSec能补全"申报数量不超过100亿元",而专家有时会漏。

- 效率:LLSec处理单个数据集平均耗时≤6分钟,比领域专家(约60分钟)快10倍,比GPT-4(约20分钟)快3倍。效率高的原因是需求可操作化和关系识别不依赖大语言模型,且抽取模型无需少样本学习。

- 功能点数量:LLSec生成的功能点数量远多于其他方法,比如数据集2中LLSec有700个功能点,而专家只有48个,因为LLSec会基于知识库补全跨规则的知识(如从其他规则补"单笔最大申报量")。

表4这张"5个数据集对比表"清晰展示了LLSec在"数据流数量(#DF)""功能点识别率(FPI)""时间消耗"上的优势:比如数据集5中,LLSec的FPI94.20%>专家83.25%>GPT-475.83%>GLM-440.56%>非专家52.22%,时间6分钟<专家50分钟<GPT-425分钟<非专家74分钟。

RQ2:策略对比------微调和上下文学习各有优势

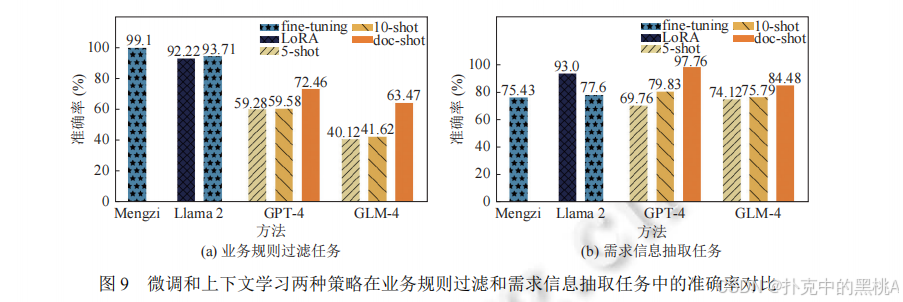

图 9这张 "微调和上下文学习两种策略在业务规则过滤和需求信息抽取任务中的准确率对比" 宛如 "不同烹饪手法在'选菜'与'做菜'环节的效果评测图":

- 子图 (a) 聚焦 "业务规则过滤任务"(即 "选菜",筛选软件相关规则),微调策略(如 Mengzi 的 99.1%、Llama 2 的 93.71%)准确率显著领先,说明分类类任务更适合微调,能让模型精准学习 "软件相关 / 无关" 的语义边界;

- 子图 (b) 针对 "需求信息抽取任务"(即 "做菜",提取实体与约束),上下文学习的 doc-shot 策略(如 GPT-4 的 84.48%)表现更优,证明抽取类任务适合上下文学习,大语言模型的语义理解能力能更好捕捉复杂实体关系。

它直观验证了 "分类任务(规则过滤)用微调,抽取任务(信息提取)用上下文学习" 的策略选择逻辑,是实验中 "策略对比" 结论的核心可视化支撑。

对比"微调模型"和"上下文学习"在规则过滤和信息抽取的效果:

- 规则过滤:微调的Mengzi-BERT准确率99.1%>上下文学习的GPT-4(72.46%),因为规则过滤是分类任务,微调能让模型精准学习"软件相关/无关"的语义特征,而上下文学习受示例数量限制(最多1篇文档)。

- 信息抽取:上下文学习的GPT-4(97.76%)>微调的Llama 2(93%),因为信息抽取需要理解复杂语义和实体类型,GPT-4的预训练数据更丰富,且上下文学习能通过示例快速适配任务,而Llama 2(7B参数)参数量远小于GPT-4(1.8万亿参数),表达能力不足。

结论:分类任务(过滤)用微调,抽取任务(信息提取)用上下文学习,按需选择策略。

RQ3:知识库作用------不可或缺的"厨师经验"

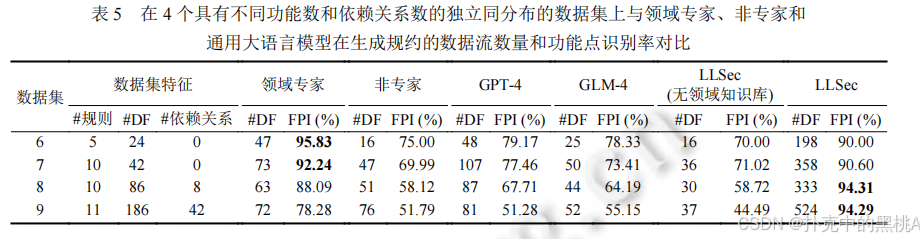

通过消融实验(把LLSec的领域知识库置空)验证知识库的价值:

- 置空后,LLSec的功能点识别率从91.97%骤降到58.72%,甚至低于GPT-4(75.83%),因为无法补全抽象术语(如"竞买预约要素")和隐式关系(如"撤销依赖申报")。

- 随着数据集复杂度增加(依赖关系从0→42),专家的FPI从95.83%降到78.28%,而LLSec仍稳定在94%左右,因为知识库能持续提供一致的领域知识,不受复杂度影响。

表5这张"4个同分布数据集对比表"显示,当依赖关系从0(数据集6)增加到42(数据集9),LLSec(有知识库)的FPI从90.00%升至94.29%,而LLSec(无知识库)从70.00%降至44.49%,专家从95.83%降至78.28%,证明知识库能让方法在复杂场景下保持稳定。

RQ4:通用性------跨制度体系仍有效

测试LLSec在纽约、东京、香港交易所规则上的表现(文档为英文、日文、繁体中文,先翻译为简体中文):

- LLSec的平均FPI达79.84%,在纽约股票规则(数据集10)达82.95%,比GPT-4(73.15%)高10个百分点,比GLM-4(68.93%)高14个百分点。

- 虽然比国内数据集(91.97%)低约12个百分点,但主要原因是训练数据和知识库以国内规则为主,补充国际规则的知识后,FPI可进一步提升,证明方法具有跨制度、跨语言的通用性。

四、挑战与未来:让"智能翻译"更精准、更通用

尽管LLSec表现优异,但仍面临一些"翻译漏洞",未来需要从3个方向优化,让证券规则的"智能翻译"更完善。

1. 当前挑战:有效性威胁

大语言模型的随机性

GPTs在信息抽取时偶尔会输出不同结果(如某次把"10万元"写成"10万"),虽经5轮人工确认可降低风险,但仍影响自动化效率,类似智能翻译偶尔会错译"番茄"为"西红柿"。

领域知识库的完备性

知识库目前有266条交易概念知识和56条操作序列知识,但证券领域还有很多细分场景(如科创板交易、跨境交易)的知识未覆盖,导致这些场景的需求可操作化不充分,像厨师手册里没写"分子料理"的做法。

外部效度局限

实验数据集虽覆盖多品种、多交易所,但证券规则还有很多特殊场景(如熔断机制、退市规则)未测试,无法完全保证所有场景的适用性,类似翻译了中餐菜单,却没试过西餐菜单。

2. 未来方向:三大优化点

构建证券领域专属大语言模型

目前用的是通用大语言模型(GPT-4、Mengzi-BERT),未来可基于海量证券规则文档(如沪深交易所所有规则、国际交易所规则)预训练"证券LLM",无需微调或上下文学习就能精准识别专业术语和需求约束,就像专门学过中餐的翻译,不用示例也知道"火候"指"大火/小火"。

完善多模态领域知识库

当前知识库是文本形式,未来可加入"数据流图""状态机可视化"等多模态知识,比如把"债券交易状态机"转化为交互式图表,让需求可操作化和关系识别更直观,还可加入实时更新机制(如交易所规则更新后自动同步知识库),避免知识过时。

拓展到多领域需求规约

这套"大语言模型+领域知识库"的框架可复用到其他知识密集型领域,比如银行(贷款规则规约)、保险(理赔规则规约),只需替换"证券需求元模型"为"银行需求元模型","证券知识库"为"银行知识库",像把"中餐翻译工具"改成"西餐翻译工具",只需换食材手册和烹饪指南。

五、总结

证券业务规则规约就像"把复杂菜单转化为厨房操作指南",既要筛选关键信息、拆解专业步骤,又要明确抽象描述、确定操作顺序。论文提出的"大语言模型+领域知识库"4步方案,用微调模型筛选规则、用GPTs抽取信息、用交易概念知识补全需求、用操作序列知识识别关系,最终实现了"翻译"质量(91.97%FPI)媲美专家、效率提升10倍的效果。

这套方法不仅解决了证券领域的需求规约难题,还为其他知识密集型领域(如银行、保险)提供了可复用的框架------核心是"用大语言模型处理自然语言,用领域知识库补全专业知识",让智能工具既有"语言理解能力",又有"领域经验",真正实现从"人工翻译"到"智能翻译"的跨越。

未来,随着证券领域大语言模型和多模态知识库的完善,这套方法将能处理更复杂的规则场景(如跨境交易、熔断机制),甚至自动生成软件代码,彻底打通"规则文档→需求规约→软件实现"的全流程,让证券交易系统的开发更高效、更精准。

尾

本期技术解构至此。

论文揭示的方法论范式对跨领域技术实践具有普适参考价值。下期将聚焦其他前沿成果,深入剖析其的突破路径。敬请持续关注,共同深挖工程实现脉络,淬炼创新底层逻辑,在学术与工程融合中洞见技术演进规律,推动领域范式持续进化。