本文较长,建议点赞收藏。更多AI大模型应用开发学习视频及资料,在智泊AI。

今天为大家介绍一个简单易用的RAG开源项目------MaxKB,这是一个功能强大且易于使用的企业级AI助手,它完美整合了RAG(检索增强生成)流水线,支持强大的工作流程,并提供先进的MCP工具使用能力。

项目介绍

MaxKB(Max Knowledge Brain)是由国内1Panel团队开发的开源AI助手平台,专为企业级应用而设计。该项目广泛应用于智能客服、企业内部知识库、学术研究和教育等场景。一个开箱即用型的RAG智能问答应用,MaxKB不仅仅是一个中间件平台,而是一个完整的、可直接部署的AI助手解决方案。

MaxKB 自发布以来,已经在 GitHub 上收获了超过 17k Star,展示了它在社区中的受欢迎程度。

核心功能

1. RAG流水线处理

MaxKB支持直接上传文档或自动抓取在线文档,具备自动文本分割和向量化功能。这样一来可以有效减少大型模型的幻觉问题,为用户提供了卓越的智能问答交互体验。无论是PDF、Word文档还是网页渠道的内容,MaxKB都能智能处理并构建知识库。

2. 智能工作流引擎

配备强大的工作流引擎、函数库和MCP工具使用功能,MaxKB能够编排AI流程以满足复杂业务场景的需求。这使得企业可以根据自身业务特点,定制专属的AI工作流程。

3. 无缝系统集成

MaxKB最大的亮点之一是支持零编码快速集成到第三方业务系统中。企业无需复杂的开发工作,就能为现有系统快速配备智能问答能力,显著提升用户满意度。

4. 模型兼容性

支持多种大型语言模型,包括私有模型(如DeepSeek、Llama、Qwen等)和公共模型(如OpenAI、Claude、Gemini等)。这种模型无关的设计让企业可以根据需求灵活选择最适合的AI模型。

5. 多模态支持

MaxKB原生支持文本、图像、音频和视频的输入输出,真正实现了全方位的多媒体AI交互体验。

安装和使用方法

部署服务器要求:

- 操作系统:Ubuntu 22.04 / CentOS 7(内核版本要求 ≥ 3.10)

- CPU/内存:4C/8GB 以上

- 磁盘空间:100GB

MaxKB的部署极其简单,只需一个Docker命令即可启动:

bash

docker run -d --name=maxkb --restart=always \

-p 8080:8080 \

-v ~/.maxkb:/var/lib/postgresql/data \

-v ~/.python-packages:/opt/maxkb/app/sandbox/python-packages \

1panel/maxkb部署完成后,访问 http://your_server_ip:8080 即可进入MaxKB的Web管理界面。默认管理员账户信息为:

- 用户名:admin

- 密码:MaxKB@123..

国内小伙伴要是拉取镜像慢,可以参考官网官方提供的离线安装文档。

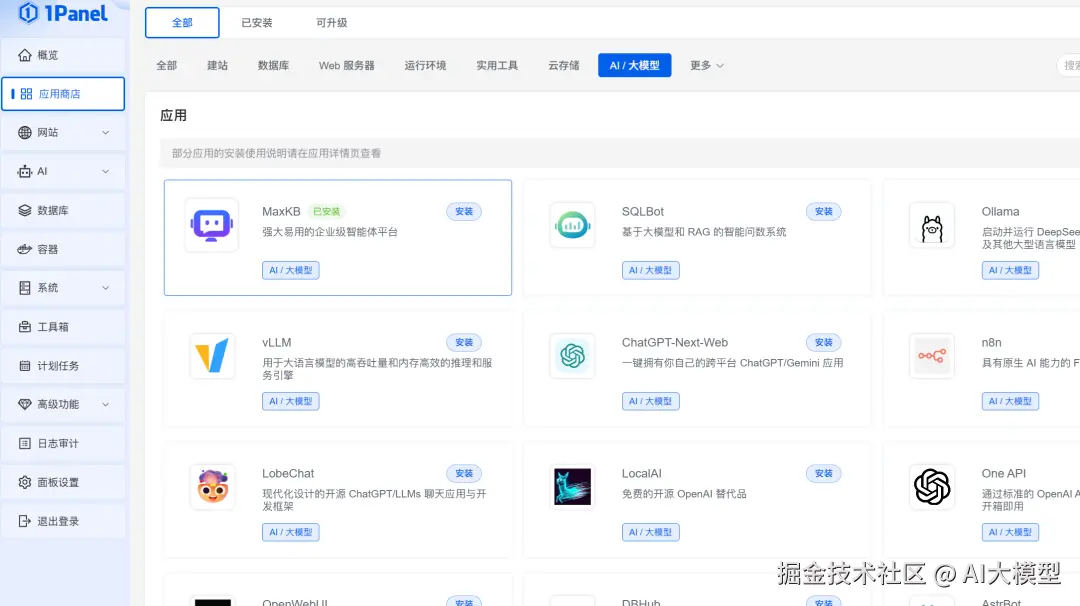

另外,如果你安装1Panel面板服务,可以直接进入到应用商店,在【AI/大模型】分类下找到 MaxKB 进行快速安装使用。

技术架构

MaxKB采用现代化的技术栈:

- 前端:Vue.js提供友好的用户界面

- 后端:Python/Django确保稳定的服务性能

- AI框架:基于LangChain构建强大的LLM应用能力

- 数据库:PostgreSQL + pgvector提供高效的向量存储

MaxKB的核心优势在于其"即用型"特性,企业无需深入了解复杂的AI技术细节,就能快速构建和部署专属的智能助手系统。

总结

MaxKB作为一个成熟的开源企业AI助手解决方案,完美的平衡了功能强大性和易用性。它不仅提供了完整的RAG技术栈,还通过工作流引擎和无缝集成能力,让企业能够快速实现AI驱动的知识管理和客户服务升级。

对于希望快速部署企业级AI助手的团队来说,MaxKB无疑是一个理想的选择。其开源特性保证了技术透明度和可定制性,而简单的部署流程则大大降低了技术门槛。

项目地址: github.com/1Panel-dev/...

学习资源推荐

如果你想更深入地学习大模型,以下是一些非常有价值的学习资源,这些资源将帮助你从不同角度学习大模型,提升你的实践能力。

本文较长,建议点赞收藏。更多AI大模型应用开发学习视频及资料,在智泊AI。