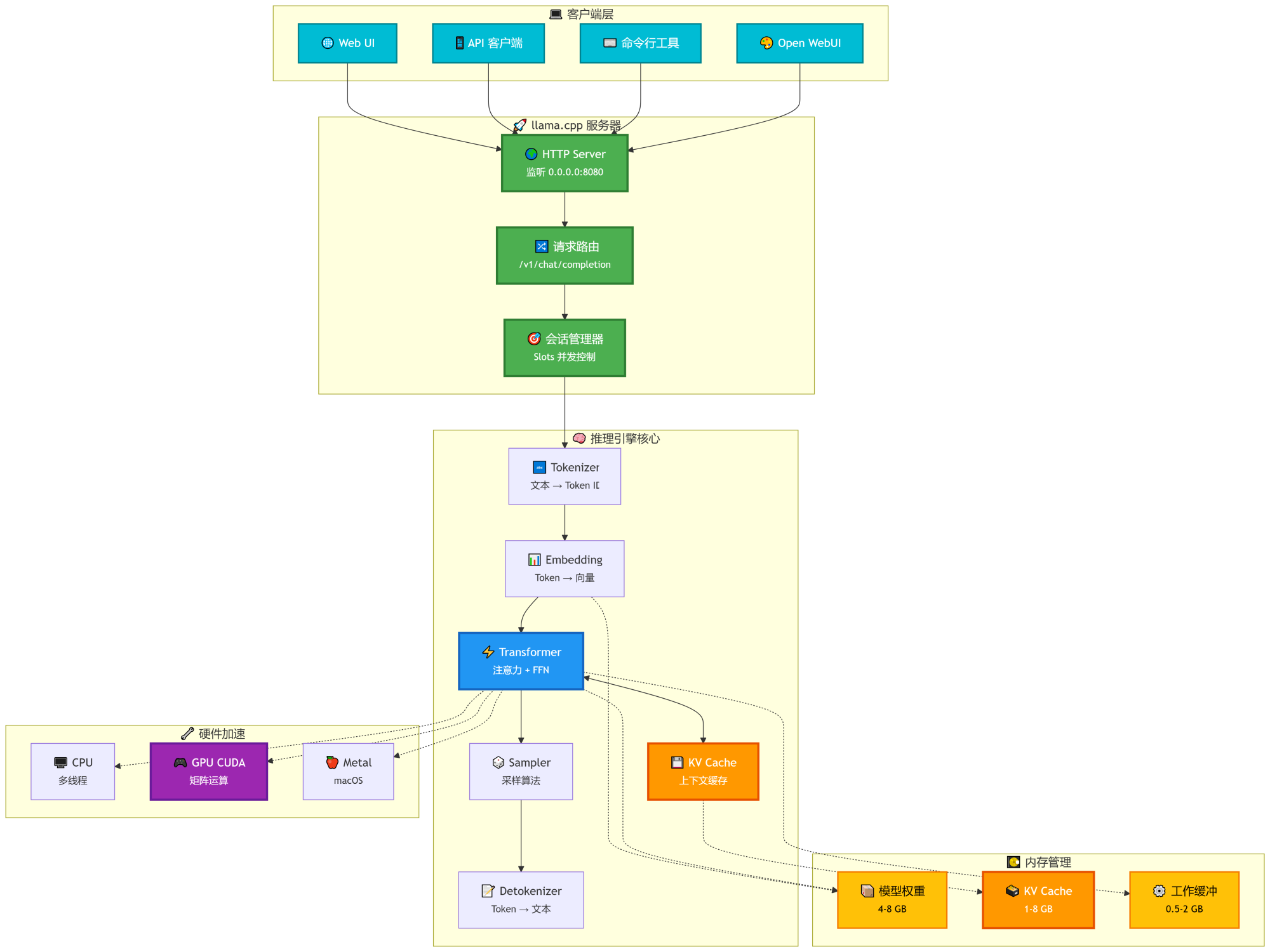

以下是对 llama.cpp 的简单介绍:

- llama.cpp 是一个在 C/C++ 中实现大型语言模型(LLM)推理的工具

- 支持跨平台部署,也支持使用 Docker 快速启动

- 可以运行多种量化模型,对电脑要求不高,CPU/GPU设备均可流畅运行

- 开源地址参考:https://github.com/ggml-org/llama.cpp

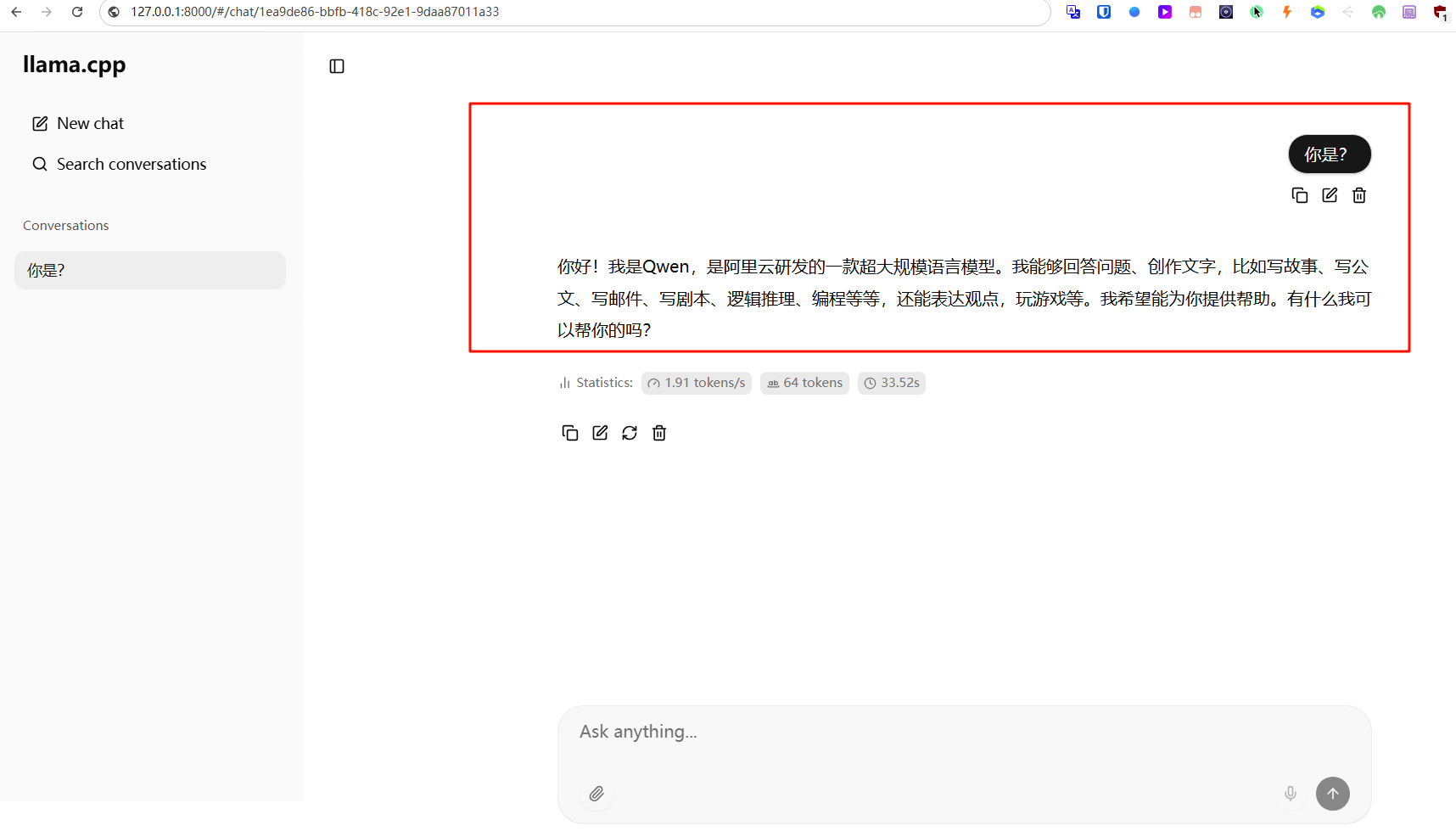

在Docker中使用 llama.cpp 启动 Qwen3-Vl大模型应用实践参考:使用 llama.cpp 在本地高效运行大语言模型,支持 Docker 一键启动,兼容CPU与GPU![]() https://blog.luler.top/d/91

https://blog.luler.top/d/91