本文较长,建议点赞收藏。更多AI大模型应用开发学习视频及资料,在智泊AI。

最近不少学员在面试 AI 岗时反馈,RAG(检索增强生成)成了面试的"常客题"。

面试官的问题五花八门,从"为什么内容缺失"到"RAG-Fusion 怎么工作",甚至还要你分析"RAG 与 SFT 的区别"。

别慌。

这篇文章我们就系统梳理 28 个高频面试问题,直接带你理解 RAG 从"原理 → 问题 → 优化 → 未来"的完整演化逻辑,确保你下一次面试不被问懵。

一、RAG 基础认知篇

问题 1:什么是 RAG?

RAG,全称 Retrieval-Augmented Generation,是一种结合"外部知识检索"和"大语言模型生成"的混合架构。它先从知识库中检索相关文档,再让模型基于这些文档生成回答。

问题 2:RAG 的好处是什么?

能降低幻觉(Hallucination),让回答更贴近事实;还能节省训练成本,无需让模型"死记硬背"海量数据。

问题 3:RAG vs SFT 有何区别?

SFT(监督微调)是在模型内部"灌知识";RAG 是让模型"查资料"。 一个靠记忆,一个靠检索。RAG 的优势是更新快、灵活;SFT 的优势是推理更自然。

二、RAG 常见问题篇(核心 10 大坑)

这部分是面试最容易被问、也最容易踩坑的地方。

问题 4:内容缺失问题

常见原因:切片策略不合理、向量召回率低、知识覆盖不全。

解决思路:调整分段长度、使用多向量检索、增加索引质量评估。

问题 5:错过排名靠前的文档

召回算法问题。可优化向量距离计算方式(如 cosine → dot-product)或引入 rerank 模型。

问题 6:脱离上下文------整合策略的限制

拼接多个文档时,语义边界丢失。解决方案:采用 Context Window Re-weighting 或基于语义的拼接。

问题 7:未能提取答案

常发生在检索结果太广或太窄。需调整相似度阈值,并使用 Prompt 工程引导"必须基于引用回答"。

问题 8:格式错误

源数据清洗不规范,或 LLM 输出未结构化。解决:统一索引格式、在 Prompt 中约束输出模板。

问题 9:特异性错误

RAG 在特定领域(如法律、医学)容易被误导。需引入领域词向量或知识图谱增强。

问题 10:回答不全面

检索召回范围太小。可结合多通道检索(keyword + embedding)。

问题 11:数据处理能力的挑战

尤其在非结构化文档中,提取慢。优化点:批量向量化、流式索引、分布式检索。

问题 12:结构化数据查询的难题

RAG 对 SQL 或表格支持弱。解决:混合架构------让 LLM 先生成查询语句再执行。

问题 13:复杂 PDF 提取困难

PDF 通常带有表格、页眉、脚注。解决方案:布局识别(LayoutLM)+ OCR + 坐标级切分。

三、RAG 高级机制篇

问题 14:备用模型机制

在召回失败或 LLM 输出异常时启用备用小模型,可提高鲁棒性。

问题 15:LLM 安全挑战

如 Prompt 注入、越权访问。解决:过滤输入、分级鉴权、脱敏数据。

四、RAG-Fusion 深入篇

问题 16:为什么需要 RAG-Fusion?

单一检索通道无法覆盖所有语义方向,RAG-Fusion 融合多种检索结果,提高覆盖率与稳定性。

问题 17:RAG-Fusion 的核心技术?

多通道检索(embedding + keyword + rerank)+ 答案融合(voting / re-generation)机制。

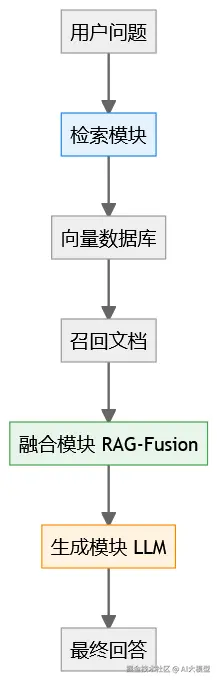

问题 18:RAG-Fusion 工作流程?

简单说:多个 RAG 并行检索 → 汇总候选 → 加权融合 → LLM 最终生成。

问题 19:RAG-Fusion 的优势与不足?

优势:更全、更准、更稳。 不足:成本高、延迟大、工程实现复杂。

五、RAG 优化策略篇

问题 20:RAG 各模块优化策略?

- 检索:语义分段 + 向量融合

- 生成:动态上下文选择 + Prompt 约束

- 存储:向量压缩 + 版本管理

问题 21:RAG 架构优化?

引入缓存层(Redis / Milvus)、支持流式检索、模块化部署(Index / Query / Generation 独立扩展)。

问题 22:RAG 索引优化?

优化向量生成(使用 instruction embedding)、增量索引更新、去重。

问题 23:RAG 索引数据优化?

统一数据格式、冗余去除、文本归一化(大小写、符号、编码)。

六、RAG 发展与展望篇

问题 24:RAG 未来发展方向?

走向多模态(图文音视频)、强化 Agent 自主检索、结合在线学习(Online Fine-tuning)。

问题 25:LLM 已具备强大能力,还存在什么不足?

事实一致性差、上下文记忆短、隐性偏见未消除。RAG 是现实中的"补脑"方案。

七、补充篇:面试延展问题(3个彩蛋)

问题 26:RAG 的局限性?

检索依赖质量、上下文融合难、生成速度慢。

问题 27:RAG 有哪些优点?

实时性强、可解释性好、维护成本低。

问题 28:RAG 未来可能与哪些技术融合?

GraphRAG(知识图谱结合)、Self-RAG(自我优化)、AgentRAG(工具驱动检索)。

🧭 一图总览:RAG 体系结构

学习资源推荐

如果你想更深入地学习大模型,以下是一些非常有价值的学习资源,这些资源将帮助你从不同角度学习大模型,提升你的实践能力。

本文较长,建议点赞收藏。更多AI大模型应用开发学习视频及资料,在智泊AI。