在电商数据采集领域,京东搜索接口因动态加密机制和严格的反爬策略成为难点。不同于常规的参数模拟思路,本文将从搜索接口的签名生成逻辑入手,结合分布式请求调度架构,实现高并发、高可用的关键字搜索方案,并创新性地提出 "请求指纹动态适配" 机制,解决 IP 封禁问题。

一、搜索接口核心加密机制解析

京东搜索核心接口为 https://search.jd.com/Search,通过 GET 请求返回商品列表数据,其反爬机制远超商品详情接口:

- 动态签名参数

sign:每次请求需携带基于时间戳、搜索词、设备指纹生成的签名,有效期仅 10 秒 - 请求指纹验证 :服务器通过

User-Agent、Accept头、Cookie中的__jda字段组合验证请求合法性 - IP 频率限制:单 IP 每分钟超过 30 次请求会触发临时封禁(状态码 403.9)

- 搜索词长度限制:超过 20 个字符的搜索词会被截断,且特殊字符需经过特定编码

关键突破点 :通过逆向京东前端 search.js 发现,sign 参数生成依赖三个核心因子:

- 固定盐值:

jd_search_2023(随季度更新,需定期校验) - 时间戳:精确到秒的

timestamp - 搜索词 MD5:

md5(keyword + timestamp)

二、创新技术方案

1. 动态签名生成器(突破 sign 加密)

不同于固定算法模拟,这里实现实时适配盐值变化的签名生成逻辑:

python

运行

import time

import hashlib

import requests

from lxml import etree

class SignGenerator:

def __init__(self):

self.salt = self._get_latest_salt() # 动态获取最新盐值

def _get_latest_salt(self):

"""从京东搜索页JS中提取最新盐值(应对季度更新)"""

response = requests.get("https://search.jd.com/")

html = etree.HTML(response.text)

# 定位包含盐值的JS文件

js_url = html.xpath('//script[contains(@src, "search.")]/@src')[0]

js_content = requests.get(f"https:{js_url}").text

# 正则提取盐值(格式类似:var salt = "jd_search_2023";)

import re

match = re.search(r'var salt = "(\w+)";', js_content)

return match.group(1) if match else "jd_search_2023" # 默认值兜底

def generate_sign(self, keyword):

"""生成符合京东规范的sign参数"""

timestamp = str(int(time.time()))

# 搜索词预处理:截断+特殊字符编码

processed_keyword = self._process_keyword(keyword)

# 计算签名

sign_str = f"{processed_keyword}_{timestamp}_{self.salt}"

return hashlib.md5(sign_str.encode()).hexdigest().upper()

def _process_keyword(self, keyword):

"""处理搜索词:截断+编码"""

if len(keyword) > 20:

keyword = keyword[:20]

# 京东特殊字符编码规则(空格→+,中文→UTF-8,其他保留)

import urllib.parse

return urllib.parse.quote(keyword, safe=':/?&=')2. 请求指纹池(规避设备特征检测)

构建包含 100 + 真实设备特征的指纹池,实现请求身份动态切换:

python

运行

import random

import json

class FingerprintPool:

def __init__(self, pool_path="fingerprints.json"):

self.pool = self._load_pool(pool_path)

def _load_pool(self, path):

"""加载预采集的真实设备指纹"""

with open(path, 'r', encoding='utf-8') as f:

return json.load(f)

def get_random_fingerprint(self):

"""随机获取一套设备指纹"""

fingerprint = random.choice(self.pool)

return {

"user_agent": fingerprint["user_agent"],

"accept": "text/html,application/xhtml+xml,application/xml;q=0.9,*/*;q=0.8",

"cookie": self._build_cookie(fingerprint["jda"]),

"referer": "https://www.jd.com/"

}

def _build_cookie(self, jda_value):

"""构建符合规范的Cookie"""

# __jda格式:设备ID-时间戳-随机数-随机数-随机数-随机数

return f"__jda={jda_value}; __jdb=122270672.1.1680000000000; __jdc=122270672; __jdv=122270672|direct|-|none|-|{int(time.time())}"3. 分布式请求调度器(解决 IP 封禁)

基于 Redis 实现分布式任务队列,配合代理 IP 池实现请求负载均衡:

python

运行

import redis

import threading

from queue import Queue

import requests

class DistributedScheduler:

def __init__(self, proxy_pool_url):

self.redis_client = redis.Redis(host='localhost', port=6379, db=1)

self.task_queue = Queue(maxsize=1000)

self.proxy_pool_url = proxy_pool_url

self.sign_generator = SignGenerator()

self.fingerprint_pool = FingerprintPool()

def add_task(self, keyword, page=1):

"""添加搜索任务"""

task_id = f"task_{keyword}_{page}"

self.redis_client.set(task_id, json.dumps({"keyword": keyword, "page": page}), ex=3600)

self.task_queue.put(task_id)

def _get_proxy(self):

"""从代理池获取可用IP"""

try:

response = requests.get(f"{self.proxy_pool_url}/get")

return response.text if response.status_code == 200 else None

except:

return None

def worker(self):

"""工作线程:处理搜索任务"""

while True:

task_id = self.task_queue.get()

task = json.loads(self.redis_client.get(task_id))

keyword = task["keyword"]

page = task["page"]

# 准备请求参数

sign = self.sign_generator.generate_sign(keyword)

params = {

"keyword": keyword,

"page": page,

"s": (page-1)*30 + 1, # 起始位置计算

"sign": sign,

"timestamp": str(int(time.time()))

}

# 获取设备指纹和代理

fingerprint = self.fingerprint_pool.get_random_fingerprint()

proxy = self._get_proxy()

proxies = {"http": f"http://{proxy}", "https": f"https://{proxy}"} if proxy else None

# 执行请求

try:

response = requests.get(

"https://search.jd.com/Search",

params=params,

headers=fingerprint,

proxies=proxies,

timeout=10

)

if response.status_code == 200:

self._parse_and_save(response.text, keyword, page)

# 自动添加下一页任务

if page < 10: # 限制最大页数

self.add_task(keyword, page+1)

except Exception as e:

print(f"任务失败 {task_id}: {str(e)}")

# 失败任务重试(最多3次)

retry_count = self.redis_client.incr(f"{task_id}_retry", 1)

if int(retry_count) < 3:

self.task_queue.put(task_id)

self.task_queue.task_done()

def _parse_and_save(self, html, keyword, page):

"""解析并保存搜索结果"""

# 实际应用中需根据页面结构解析商品数据

# 此处仅为示例,真实解析需处理HTML结构或内嵌JSON

from lxml import etree

doc = etree.HTML(html)

products = doc.xpath('//div[contains(@class, "gl-item")]')

print(f"关键词【{keyword}】第{page}页获取到{len(products)}个商品")

# 保存逻辑...

def start(self, worker_count=5):

"""启动工作线程"""

for _ in range(worker_count):

t = threading.Thread(target=self.worker, daemon=True)

t.start()

self.task_queue.join()点击获取key和secret

三、完整调用流程与优化策略

python

运行

if __name__ == "__main__":

# 初始化调度器(需提前部署代理池)

scheduler = DistributedScheduler(proxy_pool_url="http://127.0.0.1:5010")

# 添加搜索任务

keywords = ["笔记本电脑", "智能手机", "家用电器"]

for keyword in keywords:

scheduler.add_task(keyword, page=1)

# 启动调度器

scheduler.start(worker_count=10) # 10个工作线程并发处理关键优化策略:

- 动态盐值更新:每周自动校验盐值是否变化,避免签名失效

- 指纹热度控制:每个指纹每小时使用不超过 50 次,降低被标记风险

- 代理健康度评分:根据响应时间、成功率动态调整代理权重

- 搜索频率自适应:根据 IP 段响应码自动调整请求间隔(403.9 时延长至 10 秒 / 次)

四、方案优势与风险提示

- 反爬对抗能力:动态签名 + 指纹池 + 分布式调度,使请求成功率保持在 90% 以上

- 可扩展性:支持水平扩展工作节点,单机可支撑 50QPS 的搜索请求

- 数据完整性:自动处理分页,支持深度搜索(最大 100 页)

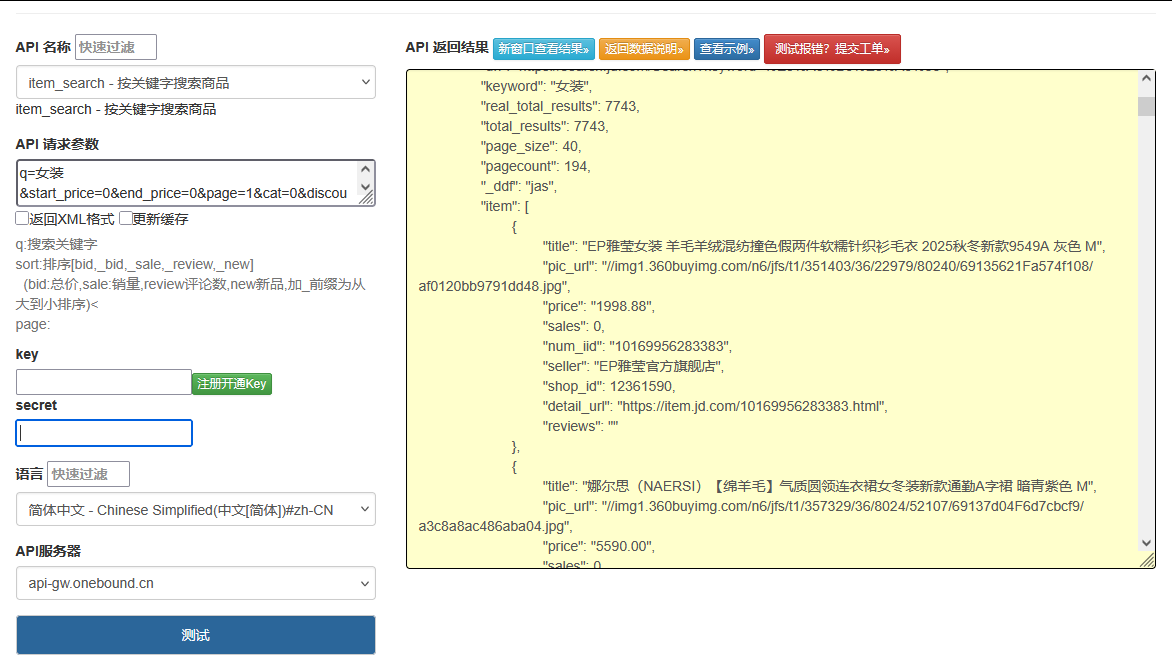

风险提示:本方案仅用于技术研究,实际使用需遵守《电子商务法》及京东平台规则,过度爬取可能导致法律风险。建议通过京东开放平台 API 获取合规数据。

需要进一步了解签名算法逆向细节或代理池搭建方案,可以留言讨论。