🧩 前言速读

11 月 13 日,2025百度世界大会上,新一代「原生全模态」大模型文心 5.0 正式亮相,2.4 万亿参数量,采用原生全模态统一建模技术,具备全模态理解与生成能力,支持「文本、图像、音频、视频」等多种信息的输入与输出,将国内大模型竞争力推向全球顶尖水准。

大会上强调:"智能本身是最大的应用,技术迭代速度是唯一的护城河",而文心 5.0 正是这一理念的最新实践 ------ 它不仅是参数规模的跃升,更标志着 AI 从 "单模态处理" 迈入 "原生多模态融合" 的新阶段。

接下来,让我们来看看这场升级,是否能让大家更加认可的吧!

老规矩,先上效果对比图!看看所谓的「原生全模态」到底是怎么个事,目前主流大模型中,在「文本、图像、音频、视频」四个模态中,支持输入输出的情况是这样的:

这时候可能在想,有没有这么厉害,真的是不是这样?还是那句话:

"Talk is cheap. Show me the code."

话不多说,我们接下来开始它都能干些啥!

一、生成 3D 网页

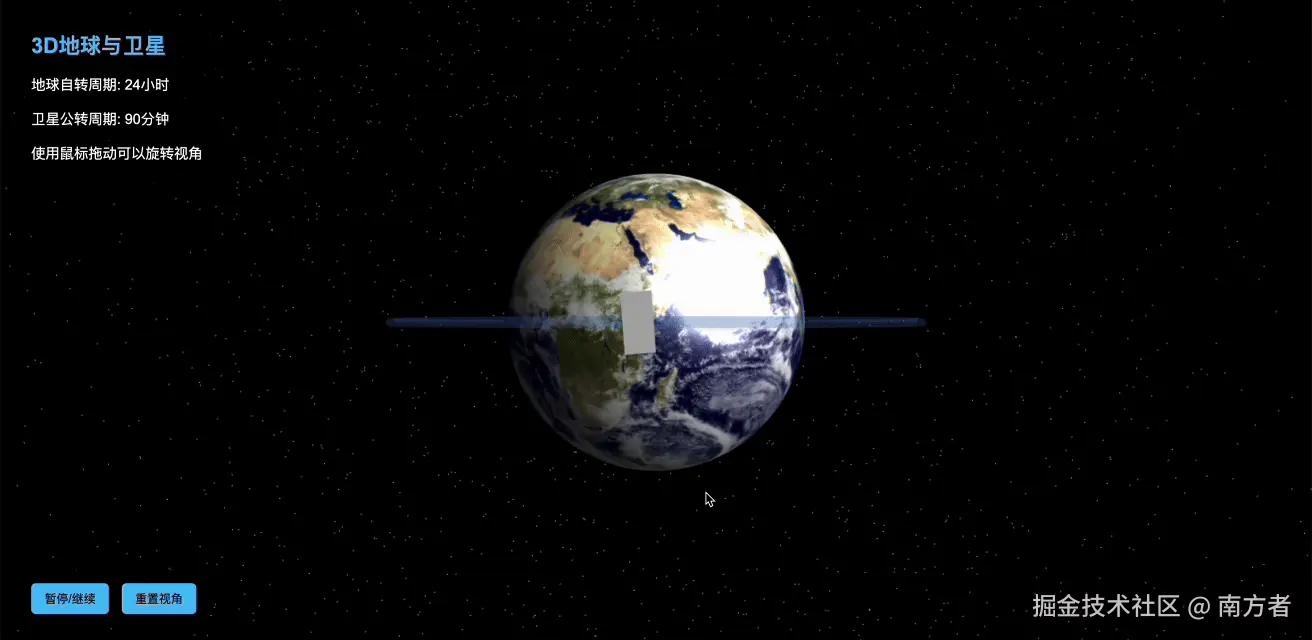

(一)自转地球:毫米级细节的 "掌上星球" 🌍

这是一个 "3D 地球与卫星" 模拟交互界面,用于直观展示地球自转和卫星绕地球公转的运动状态,各部分功能与信息如下:

-

信息说明区:

- 明确地球自转周期为24 小时(即地球自身旋转一圈的时间,对应我们的 "一天");

- 卫星公转周期为90 分钟(即卫星绕地球旋转一圈的时间);

- 操作提示:"使用鼠标拖动可以旋转视角",即通过鼠标拖动能从不同角度观察地球与卫星。

-

3D 可视化场景:

- 背景是布满恒星的黑色太空,模拟宇宙环境;

- 主体是地球的 3D 模型,可清晰看到陆地(如非洲区域)、海洋与云层的细节;

- 地球周围的蓝色轨迹示意卫星的公转轨道,轨道上的白色物体代表绕地卫星。

-

交互控制区:

- 底部 "暂停 / 继续" 按钮:控制地球自转、卫星公转模拟的启停;

- "重置视角" 按钮:将观察角度恢复为初始状态。

这个界面通过 3D 可视化和交互操作,帮助人们直观理解地球自转、卫星公转的周期与运动关系,是兼具科普性与互动性的工具。

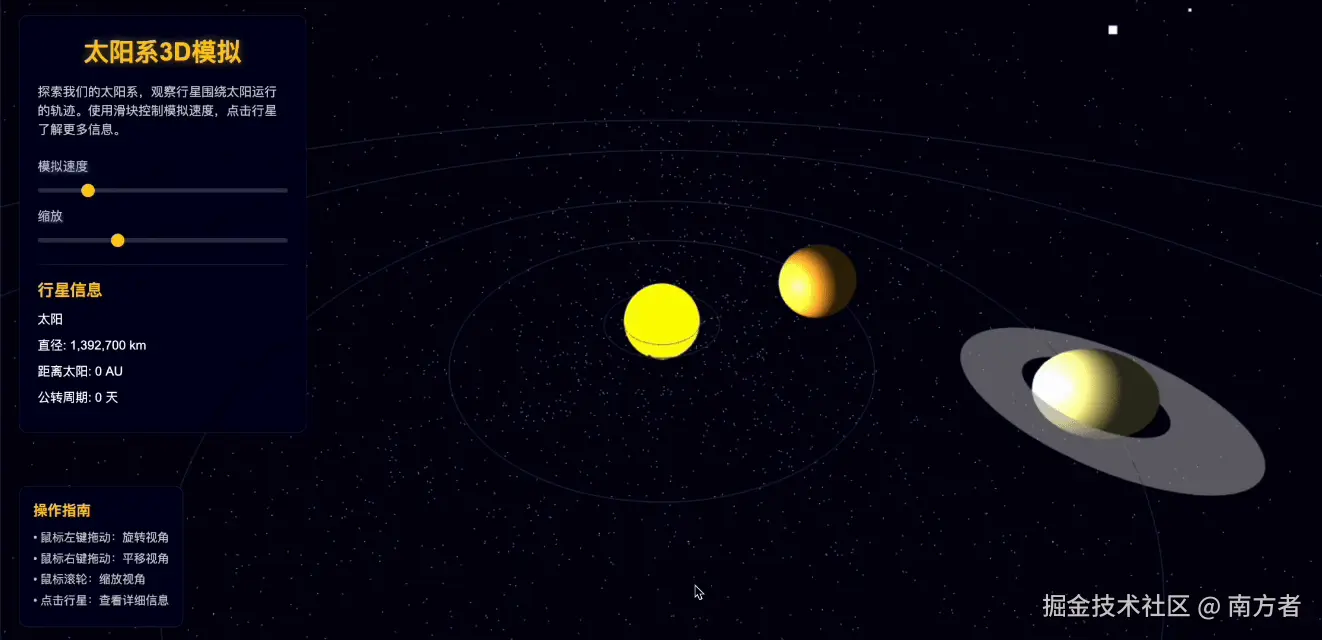

(二)太阳系 3D 模拟:可交互的 "微型宇宙"

这是一个太阳系 3D 模拟交互界面 ,用于直观展示太阳系的结构与行星运动,可分为左侧控制面板 和右侧 3D 模拟场景两部分:

-

左侧控制面板

-

标题与功能说明:"太阳系 3D 模拟",核心功能是探索太阳系,观察行星绕日轨迹,支持通过滑块调节模拟速度、缩放视角,点击行星查看详细信息。

-

交互滑块:

- "模拟速度" 滑块:控制行星绕太阳公转的模拟速率(如加快或减慢公转动画)。

- "缩放" 滑块:调整 3D 场景的视角缩放程度(拉近或拉远观察太阳系)。

-

行星信息区 :当前展示太阳的关键参数:

- 直径:1,392,700 km(太阳系中最大的天体)。

- 距离太阳:0 AU(AU 为天文单位,是太阳到地球的平均距离,约 1.5 亿公里,太阳作为中心天体,距离自身为 0)。

- 公转周期:0 天(太阳是太阳系中心,不绕自身公转)。

-

操作指南:明确了鼠标交互方式 ------ 左键拖动旋转视角、右键拖动平移视角、滚轮缩放视角,点击行星可查看其详细信息。

-

-

右侧 3D 模拟场景

- 呈现了太阳系的3D 可视化效果 :中心是黄色的太阳 ,周围分布着行星(如带有明显环系统的土星),背景是布满恒星的太空,还能看到行星的轨道轮廓(示意行星绕日的运行路径)。用户可通过左侧的交互操作,从不同角度、以不同缩放比例和速度,动态观察太阳系的空间结构与行星运动。

这个界面通过交互设计,帮助人们直观理解太阳系的天体组成、相对位置和运动规律,是一种兼具科普性与趣味性的可视化工具。

二、视频内容

(一)AI 视频(甄嬛传)🎬

真!真真的!这声音,要不是她嗦介个"AI"提到一哈子,阔能都听不粗来是有用 AI 啊!

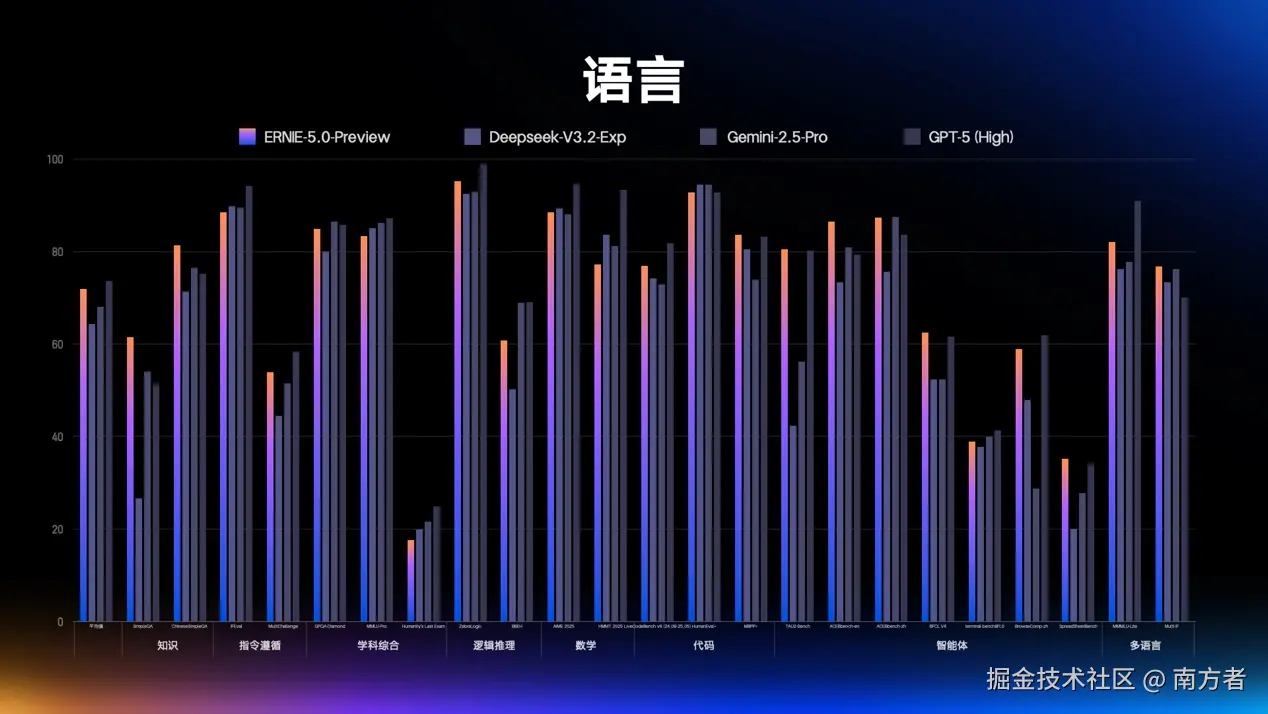

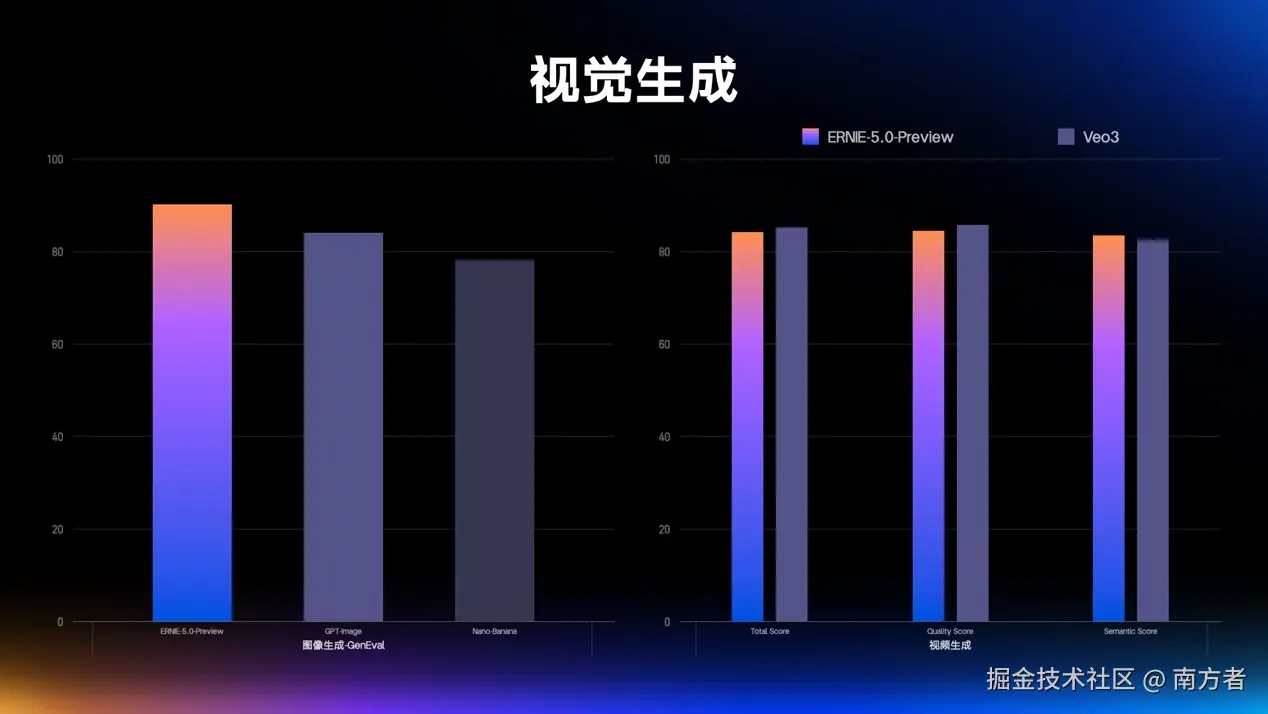

👂 语言、视觉生成的参数对比情况

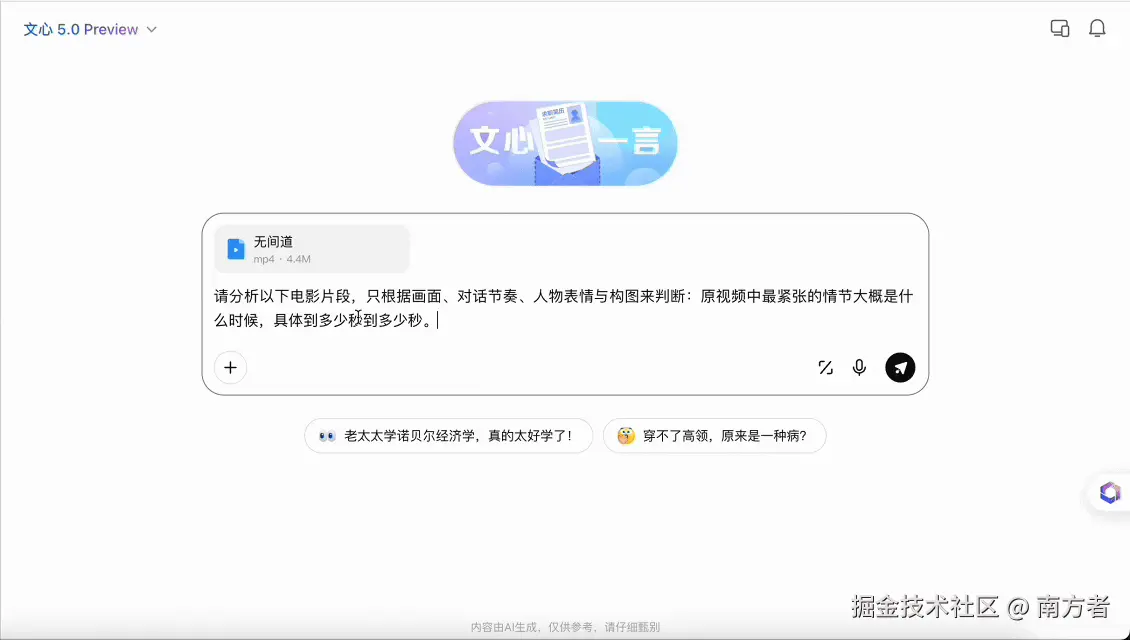

(二)视频分析《无间道》🎬(影视剧情节&时序&情绪分析)

我这里是上传一份无间道的内容,典型的、经典的,"对唔住,我系差人!"

我们一起来看看 它能不能解析分析出来吧!!

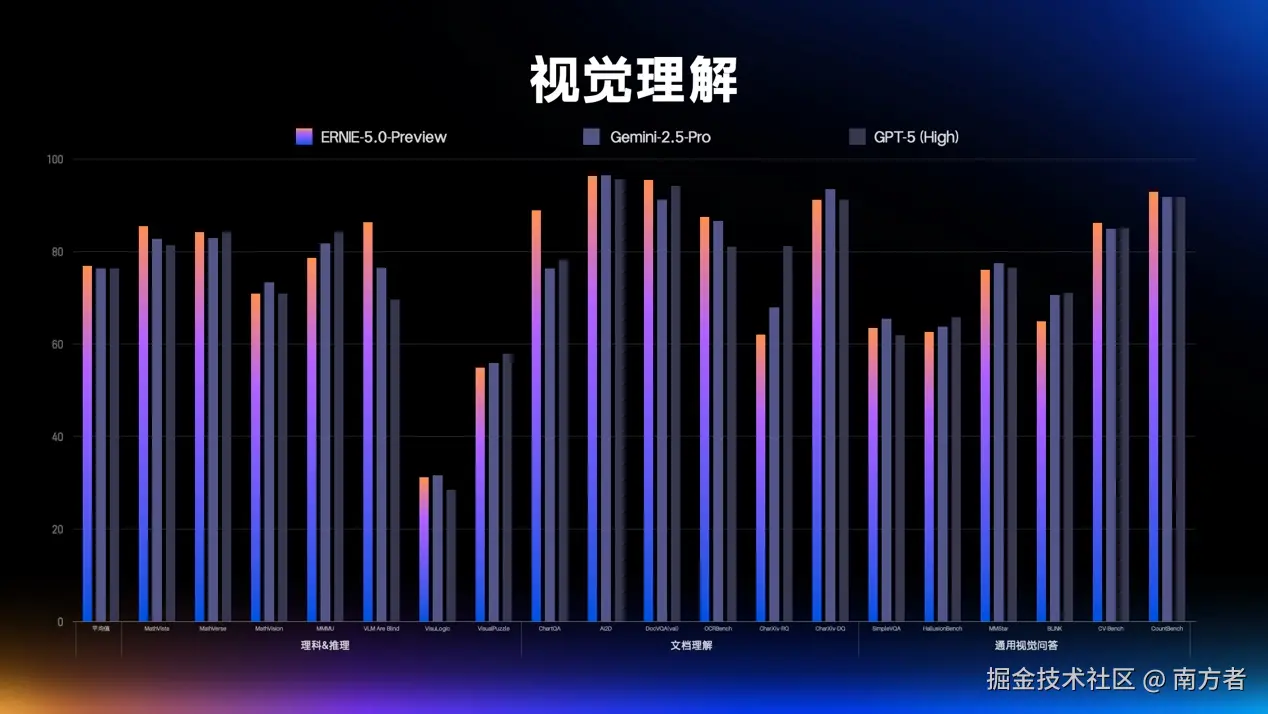

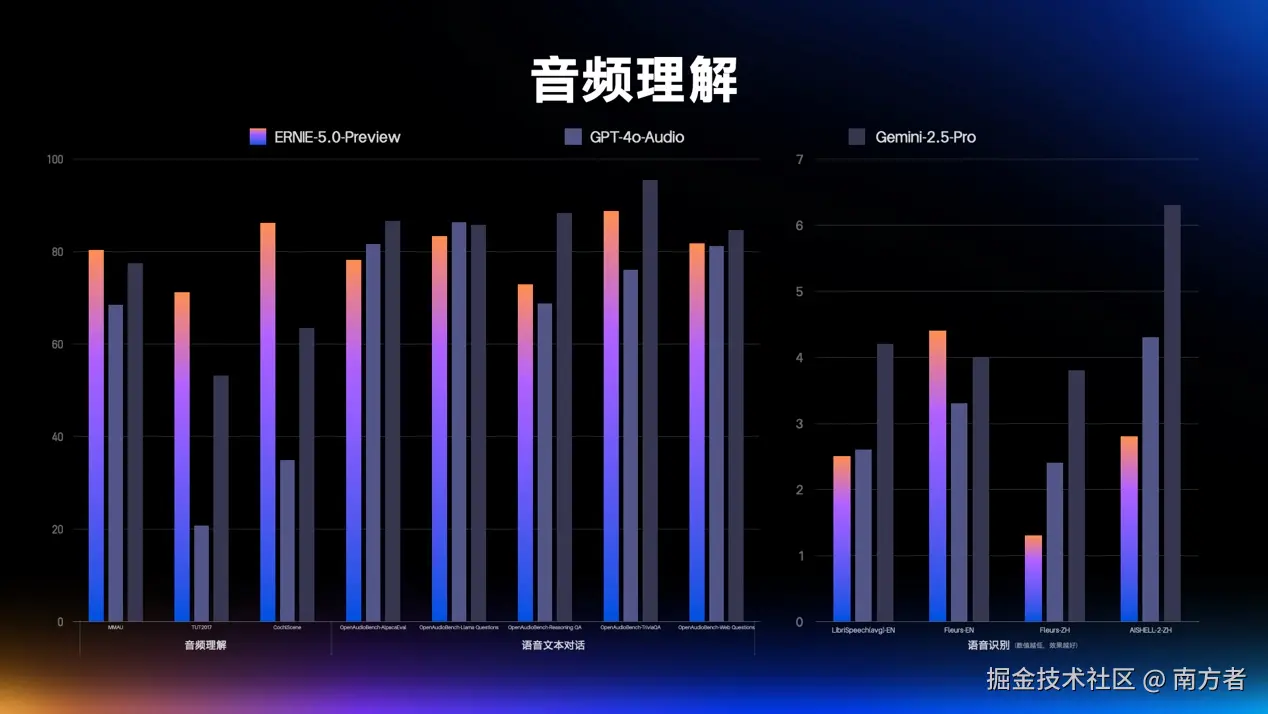

👀 视觉理解、音频理解的参数对比情况

三、图片生成

(一)"特靠谱" 手拿 "奶皮子糖葫芦"

请生成一张,"让特朗普在大街上,手拿一个奶皮子糖葫芦,并面向镜头"

(二)"马斯克" 和 "朱迪" 警官握手

生成一张图片,让马斯克和朱迪警官进行握手,要自然一点面向镜头

⚡ 复盘:关键技术的升级

1. 原生全模态建模:从根上解决 "信息割裂" 难题✅

和很多模型 "先处理单模态、再拼接融合" 不同,文心 5.0 从训练一开始就把文字、图片、视频、音频等数据 "揉在一起学"。不管是同时输入文档 + 产品图 + 讲解音频,还是要输出图文结合的报告 + 配套短视频,它都能直接打通不同信息形式,不用再靠后期技术 "补漏洞",真正实现了多模态信息的统一理解与生成。

2. 理解与生成一体化:让 AI "看懂" 和 "会造" 相辅相成✅

以往多模态模型常出现 "能看懂图却写不出准描述,或能生成内容却理解错需求" 的问题,文心 5.0 通过精细化打磨多模态语义特征,把 "理解信息" 和 "生成内容" 的能力绑在一起升级。比如分析一段产品测评视频时,既能精准提取核心卖点(理解),又能据此生成带货文案 + 演示动画(生成),两者互相助力,大幅提升了全场景下的多模态处理效果。

3. 自回归统一架构:用 "一套逻辑" 学透所有模态✅

为了让文字、图像等不同模态的特征能深度融合,文心 5.0 把各模态的训练目标转化为统一的离散格式,再用一套自回归架构完成训练。就像用同一种 "语言" 教 AI 识别图片、解读文字、分析音频,让不同类型的信息在同一个框架里充分磨合、优化,从根本上增强了多模态统一建模的能力。

4. 超大规模混合专家结构:2 万亿参数也能 "轻装上阵"✅

参数规模与激活效率双突破、训练效率飙升、推理成本大降5. 长程任务增强的智能体能力:AI 能 "连贯做事" 了✅

通过大量真实或模拟场景的长任务数据(比如复杂项目规划、多步工具调用流程),文心 5.0 在训练中强化了 "按步骤解决问题" 的能力。它会像人一样 "先思考、再行动",还能通过多轮强化学习优化流程,比如用它做市场调研,能自动调用数据分析工具、整理报告、生成可视化图表,一步接一步完成复杂任务,工具调用和智能决策能力明显提升。

🚀结语:AI "理解力之战" 的核心,是让技术贴近全能

从文心 5.0 的交互体验到数字人落地,能清晰看到一个趋势:全球 AI 竞争已从 "参数规模" 转向 "理解力深度"。无论是与 GPT-5.1 对标的 "情商"(情绪解读、需求预判),还是原生全模态建模带来的 "沉浸式理解",本质都是让 AI 从 "能计算" 走向 "会感知"!这场升级,我认可了!你认可吗?