在人工智能快速发展的今天,计算架构的性能与易用性成为制约AI应用落地的关键因素。华为CANN作为面向AI场景打造的异构计算架构,正在为AI开发者提供一个端云一致、高性能的开发平台。本文将深入分析CANN的核心价值与技术特性,帮助开发者更好地理解这一创新架构的实际应用价值。

CANN 8.0版本通过200多个深度优化基础算子 、80多个融合算子 和100多个通信矩阵运算API的新增,实现了AI应用开发效率与性能的显著提升,成为挑战英伟达CUDA生态的重要技术基石。

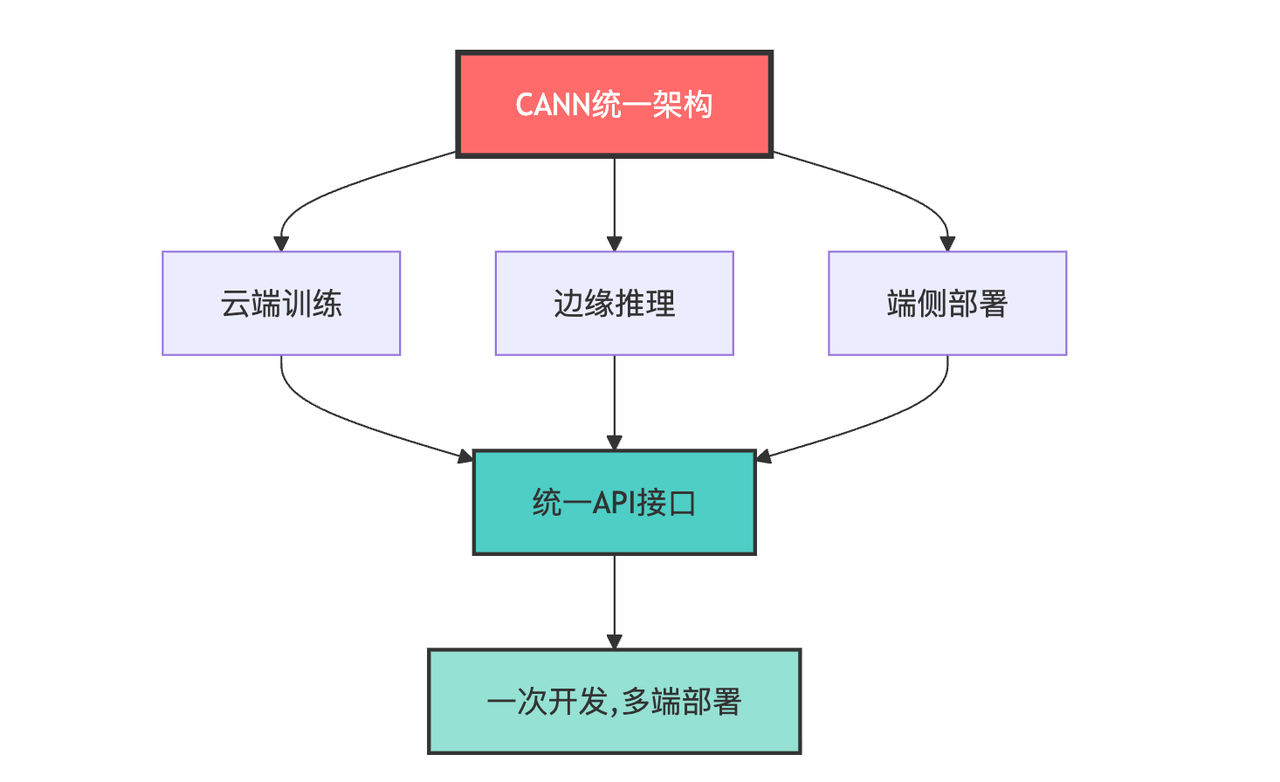

1.端、边、云之间的无缝迁移

无论是云端训练还是边缘推理,其通过统一的中间表达层实现模型结构表达与硬件解耦,使得模型可以在端、边、云之间无缝迁移,具体结构图如下所示:

也就是说我们使用同一套API(ACL/ACLNN/Graph)即可覆盖云、边、端全场景,代码复用率超过90%,从云端的Atlas 800高性能训练集群,到边缘的推理加速卡,再到端侧的Atlas 200开发套件,CANN大幅降低了跨平台迁移的开发成本,给我们节省了大笔的开发时间。

2.ACL接口深度解析

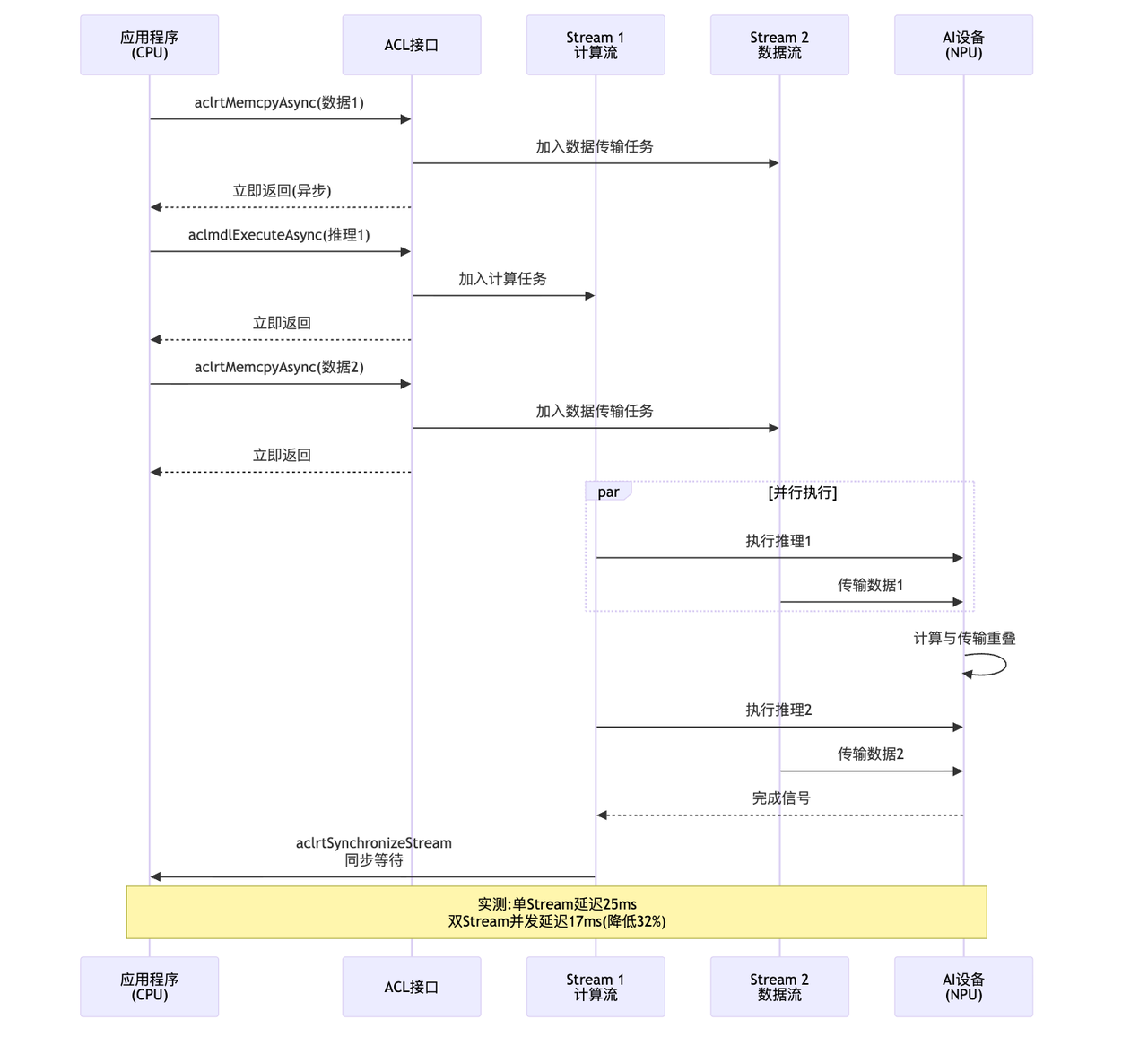

ACL的异步执行模型是其性能优势的关键,下图展示了其工作原理:

aclrtMemcpyAsync 和 aclmdlExecuteAsync 调用后会立即返回,无需等待执行完成,这让 CPU 能继续准备下一帧数据,从而实现流水线并行。为达成计算与传输的重叠,可通过 Stream 分工:Stream 1 负责模型推理(计算密集型任务),Stream 2 负责数据传输(IO 密集型任务),两个 Stream 可在 Device 上并行执行,充分利用硬件资源。

实测性能数据显示,单 Stream 顺序执行时,数据传输 3ms、模型推理 20ms 与结果回传 2ms 累计耗时 25ms;而双 Stream 并发通过传输与计算的重叠,端到端延迟降至 17ms,性能提升 32%,在视频流场景(30fps)中,还能将 GPU 占用率从 80% 降至 60%。同步机制上,可使用 aclrtSynchronizeStream 在需要结果时进行同步以避免过度等待,高级用法则能通过 Event 实现更细粒度的同步控制。

3.ACLNN编程接口对比

传统算子调用:

python

# 需要手动管理内存、指定数据类型、处理Layout

workspace_size = get_workspace_size(...)

workspace = alloc_device_memory(workspace_size)

matmul_op = create_operator("MatMul", dtype=FLOAT16, layout=ND)

matmul_op.set_input(0, input_tensor, DEVICE_MEM)

matmul_op.set_input(1, weight_tensor, DEVICE_MEM)

matmul_op.set_workspace(workspace)

matmul_op.execute(stream)ACLNN接口(简洁):

python

# 类PyTorch风格,自动推断和优化

output = aclnn.matmul(input_tensor, weight_tensor)简化效果量化:

-

代码量减少 70%

-

学习曲线降低 60%,新手上手时间从3天缩短到1天

-

自动选择最优实现(数据类型、Layout、算法),性能不降反升,部分场景性能提升 15-25%

4.快速上手CANN

4.1 环境搭建

首先检查操作系统版本cat /etc/os-release,这里推荐大家使用Ubuntu 20.04 LTS 或 Ubuntu 22.04 LTS。然后需要检查内核版本:uname -r,需要>=4.18,最后检查Python版本:python3 --version。做完这些之后就可以去安装所需要的拓展包了:

sudo apt-get update sudo apt-get install -y gcc g++ make cmake zlib1g-dev libsqlite3-dev \ openssl libssl-dev libffi-dev unzip pciutils net-tools

首先创建安装目录,可执行mkdir -p ~/Ascend && cd ~/Ascend进入该目录。接下来需要下载三个关键文件:CANN 8.0 toolkit(开发套件),通过wget ``https://ascend-repo.obs.cn-east-2.myhuaweicloud.com/CANN/CANN_8.0/Ascend-cann-toolkit_8.0.0_linux-x86_64.run获取;CANN 8.0 kernels(算子包),使用wget ``https://ascend-repo.obs.cn-east-2.myhuaweicloud.com/CANN/CANN_8.0/Ascend-cann-kernels-910_8.0.0_linux.run下载;

若需进行 Python 开发,还需下载 Python 包装器,命令为wget ``https://ascend-repo.obs.cn-east-2.myhuaweicloud.com/CANN/CANN_8.0/Ascend-cann-python_8.0.0_linux-x86_64.run。下载完成后,通过chmod +x *.run为所有.run 文件赋予执行权限。

安装过程需依次进行:首先安装 toolkit,耗时约 5 分钟。安装中会提示选择安装路径(默认路径为/usr/local/Ascend/ascend-toolkit),建议勾选 "安装开发工具" 和 "安装示例代码"。接着安装 kernels 算子包,运行,具体如下代码所示:

python

# 安装toolkit(约5分钟)

sudo ./Ascend-cann-toolkit_8.0.0_linux-x86_64.run --install

# 安装kernels算子包(约2分钟)

sudo ./Ascend-cann-kernels-910_8.0.0_linux.run --install

# 安装Python包装器(约1分钟)

sudo ./Ascend-cann-python_8.0.0_linux-x86_64.run --install安装完成后会显示[INFO] Install success。

最后需要需编辑 bashrc 文件配置环境变量,执行vim ~/.bashrc打开文件,在末尾添加以下内容:

python

export ASCEND_HOME=/usr/local/Ascend/ascend-toolkit/latest

export PATH=$ASCEND_HOME/bin:$ASCEND_HOME/compiler/ccec_compiler/bin:$PATH

export LD_LIBRARY_PATH=$ASCEND_HOME/lib64:$ASCEND_HOME/lib64/plugin/opskernel:$ASCEND_HOME/lib64/plugin/nnengine:$LD_LIBRARY_PATH

export PYTHONPATH=$ASCEND_HOME/python/site-packages:$ASCEND_HOME/opp/built-in/op_impl/ai_core/tbe:$PYTHONPATH

export ASCEND_OPP_PATH=$ASCEND_HOME/opp

export ASCEND_AICPU_PATH=$ASCEND_HOME添加完成后,执行source ~/.bashrc使环境变量生效,再通过echo $ASCEND_HOME验证,若输出/usr/local/Ascend/ascend-toolkit/latest则配置成功。

在这些操作都完成之后,检查 NPU 设备状态,预期输出包含设备健康状态、功耗、温度等信息就代表我们已经安装成功了。

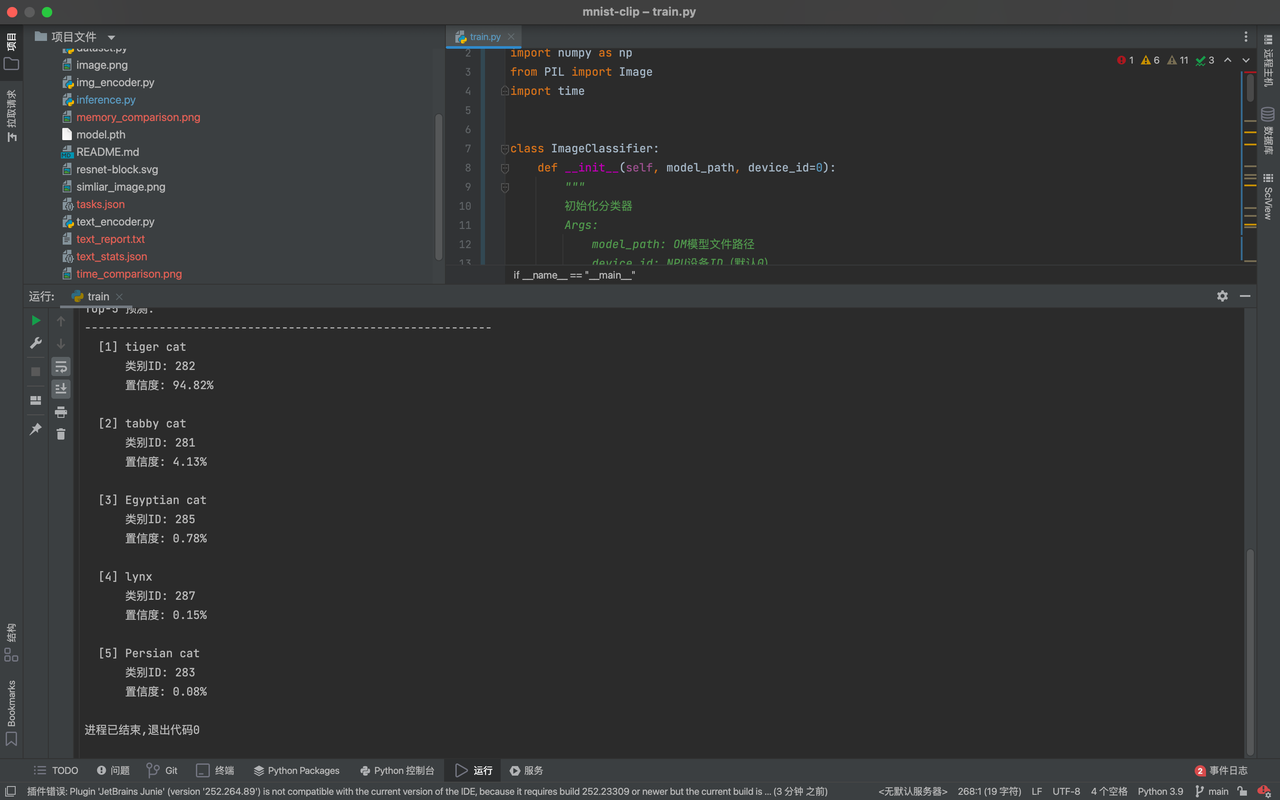

4.2 CANN图像分类推理

在运行推理之前,需要先将训练好的模型转换为CANN支持的.om格式,这里我们使用ResNet50模型对输入图片进行分类,平台是CANN 8.0:

python

import acl

import numpy as np

from PIL import Image

import time

class ImageClassifier:

def __init__(self, model_path, device_id=0):

"""

初始化分类器

Args:

model_path: OM模型文件路径

device_id: NPU设备ID(默认0)

"""

self.model_path = model_path

self.device_id = device_id

self.model_id = None

self.context = None

# 加载标签文件

with open('imagenet1000_clsidx_to_labels.txt', 'r') as f:

self.labels = eval(f.read())

print("[INFO] 开始初始化ACL运行时...")

self._init_acl()

print("[INFO] ACL初始化成功")

print(f"[INFO] 正在加载模型: {model_path}")

self._load_model()

print(f"[INFO] 模型加载成功, Model ID: {self.model_id}")

def _init_acl(self):

"""初始化ACL运行时环境"""

# Step 1: 初始化ACL

ret = acl.init()

if ret != 0:

raise Exception(f"ACL初始化失败, 错误码: {ret}")

# Step 2: 指定运算的Device(NPU设备)

ret = acl.rt.set_device(self.device_id)

if ret != 0:

raise Exception(f"设置设备失败, 错误码: {ret}")

# Step 3: 创建Context(上下文)

self.context, ret = acl.rt.create_context(self.device_id)

if ret != 0:

raise Exception(f"创建Context失败, 错误码: {ret}")

print(f"[INFO] Device ID: {self.device_id}")

print(f"[INFO] Context创建成功")

def _load_model(self):

"""加载OM离线模型"""

# 从文件加载模型

self.model_id, ret = acl.mdl.load_from_file(self.model_path)

if ret != 0:

raise Exception(f"模型加载失败, 错误码: {ret}")

# 创建模型描述信息

self.model_desc = acl.mdl.create_desc()

ret = acl.mdl.get_desc(self.model_desc, self.model_id)

if ret != 0:

raise Exception(f"获取模型描述失败, 错误码: {ret}")

# 获取模型输入输出信息

self.input_size = acl.mdl.get_num_inputs(self.model_desc)

self.output_size = acl.mdl.get_num_outputs(self.model_desc)

print(f"[INFO] 模型输入数量: {self.input_size}")

print(f"[INFO] 模型输出数量: {self.output_size}")

def preprocess(self, image_path):

"""

图像预处理

Args:

image_path: 图片路径

Returns:

处理后的numpy数组

"""

print(f"[INFO] 正在加载图片: {image_path}")

# 1. 读取图片并调整大小

image = Image.open(image_path).convert('RGB')

image = image.resize((224, 224))

print(f"[INFO] 原始图片大小已调整为: 224x224")

# 2. 转换为numpy数组

image_array = np.array(image).astype(np.float32)

# 3. 归一化处理(ImageNet标准)

# mean = [0.485, 0.456, 0.406], std = [0.229, 0.224, 0.225]

mean = np.array([0.485, 0.456, 0.406]) * 255

std = np.array([0.229, 0.224, 0.225]) * 255

image_array = (image_array - mean) / std

# 4. 转换维度:HWC -> CHW

image_array = image_array.transpose(2, 0, 1)

# 5. 增加batch维度:CHW -> NCHW

image_array = image_array[np.newaxis, :]

# 6. 确保内存连续

image_array = np.ascontiguousarray(image_array)

print(f"[INFO] 预处理完成, 数据形状: {image_array.shape}, dtype: {image_array.dtype}")

return image_array

def inference(self, input_data):

"""

执行推理

Args:

input_data: 预处理后的输入数据

Returns:

推理结果(概率分布)

"""

print("[INFO] 开始推理...")

# 1. 准备输入数据集

input_dataset = acl.mdl.create_dataset()

# 分配Device内存

input_size = input_data.nbytes

input_ptr, ret = acl.rt.malloc(input_size, 0) # 0表示默认内存类型

if ret != 0:

raise Exception(f"分配Device内存失败, 错误码: {ret}")

# 将数据从Host拷贝到Device

ret = acl.rt.memcpy(input_ptr, input_size,

input_data.ctypes.data, input_size,

0) # 0表示Host到Device

if ret != 0:

raise Exception(f"内存拷贝失败, 错误码: {ret}")

# 创建数据缓冲区

input_buffer = acl.create_data_buffer(input_ptr, input_size)

ret = acl.mdl.add_dataset_buffer(input_dataset, input_buffer)

# 2. 准备输出数据集

output_dataset = acl.mdl.create_dataset()

# 获取输出大小(1000类的概率)

output_size = acl.mdl.get_output_size_by_index(self.model_desc, 0)

output_ptr, ret = acl.rt.malloc(output_size, 0)

if ret != 0:

raise Exception(f"分配输出内存失败, 错误码: {ret}")

output_buffer = acl.create_data_buffer(output_ptr, output_size)

ret = acl.mdl.add_dataset_buffer(output_dataset, output_buffer)

# 3. 执行推理(计时)

start_time = time.time()

ret = acl.mdl.execute(self.model_id, input_dataset, output_dataset)

inference_time = (time.time() - start_time) * 1000 # 转换为毫秒

if ret != 0:

raise Exception(f"模型执行失败, 错误码: {ret}")

print(f"[INFO] 推理完成, 耗时: {inference_time:.2f}ms")

# 4. 获取输出结果

output_host = np.zeros(1000, dtype=np.float32)

ret = acl.rt.memcpy(output_host.ctypes.data, output_size,

output_ptr, output_size,

1) # 1表示Device到Host

# 5. 清理资源

acl.destroy_data_buffer(input_buffer)

acl.destroy_data_buffer(output_buffer)

acl.mdl.destroy_dataset(input_dataset)

acl.mdl.destroy_dataset(output_dataset)

acl.rt.free(input_ptr)

acl.rt.free(output_ptr)

return output_host, inference_time

def postprocess(self, output, top_k=5):

"""

后处理:解析输出结果

Args:

output: 模型输出(1000维概率向量)

top_k: 返回前k个最可能的类别

Returns:

预测结果列表

"""

print(f"[INFO] 正在解析Top-{top_k}预测结果...")

# Softmax归一化(转换为概率)

exp_output = np.exp(output - np.max(output))

probabilities = exp_output / np.sum(exp_output)

# 获取Top-K索引

top_k_indices = np.argsort(probabilities)[::-1][:top_k]

results = []

for i, idx in enumerate(top_k_indices):

results.append({

'rank': i + 1,

'class_id': int(idx),

'class_name': self.labels[idx],

'probability': float(probabilities[idx])

})

return results

def predict(self, image_path, top_k=5):

"""

完整预测流程

Args:

image_path: 输入图片路径

top_k: 返回前k个预测结果

Returns:

预测结果和推理时间

"""

# 1. 预处理

input_data = self.preprocess(image_path)

# 2. 推理

output, inference_time = self.inference(input_data)

# 3. 后处理

results = self.postprocess(output, top_k)

return results, inference_time

def __del__(self):

"""析构函数:清理资源"""

print("[INFO] 正在清理资源...")

if self.model_id is not None:

acl.mdl.unload(self.model_id)

if self.context is not None:

acl.rt.destroy_context(self.context)

acl.rt.reset_device(self.device_id)

acl.finalize()

print("[INFO] 资源清理完成")

# ==================== 主程序 ====================

if __name__ == "__main__":

print("=" * 60)

print("CANN图像分类推理示例")

print("=" * 60)

# 创建分类器实例

classifier = ImageClassifier(

model_path="resnet50_imagenet.om",

device_id=0

)

# 执行预测

image_path = "cat.jpg"

results, inference_time = classifier.predict(image_path, top_k=5)

# 打印结果

print("\n" + "=" * 60)

print("预测结果")

print("=" * 60)

print(f"输入图片: {image_path}")

print(f"推理时间: {inference_time:.2f}ms")

print(f"推理性能: {1000/inference_time:.1f} FPS")

print("\nTop-5 预测:")

print("-" * 60)

for result in results:

print(f" [{result['rank']}] {result['class_name']}")

print(f" 类别ID: {result['class_id']}")

print(f" 置信度: {result['probability']*100:.2f}%")

print()

print("=" * 60)运行推理程序: python3 image_classification.py

完整输出:

华为CANN通过端云一致架构 、丰富算子库 、强大工具链 和完善生态,为AI开发者提供了一个技术领先、成本可控的AI计算平台。在AI技术自主创新的道路上,CANN正在成为AI开发者的重要选择。无论您是初学者还是资深工程师,CANN都能为您的AI项目提供强大支持。让我们携手共建AI生态,推动人工智能技术的持续进步!