备注 :回顾之前内容,在此总结归纳(注:笔者水平有限,若有描述不当之处,欢迎大家留言)。

阐述的思维逻辑:

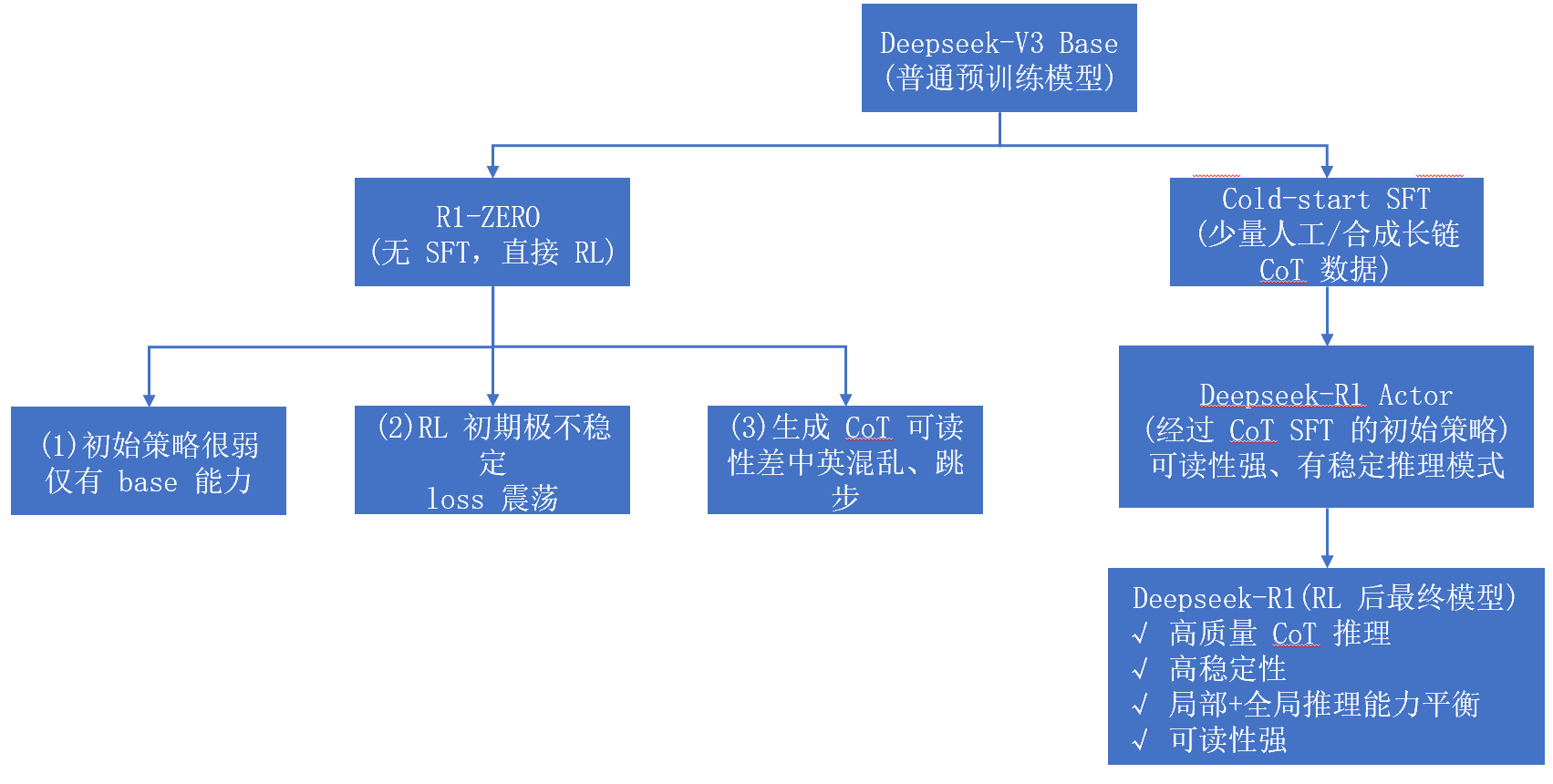

DeepSeek R1-ZERO------------->DeepSeek R1

备注:后续为机器翻译

摘要

我们介绍了第一代推理模型,DeepSeek-R1-Zero和DeepSeek-Rl。DeepSeek-Rl-Zero是通过大规模增强学习(RL)训练的模型,而无需超级微调(SFT)作为初步的步骤,表明了出色的推理能力。通过RL,DeepSeek-R1-Zero自然而然地出现了许多强大而有趣的推理行为。但是,它遇到了挑战,例如不良的可读性和语言混合。为了解决这些问题并进一步提高推理性能,我们介绍了DeepSeek-R1,该问题在RL之前结合了多阶段培训和冷启动数据。DeepSeek-R1在推理任务上实现了与OpenAI-01-1217相当的性能。为了支持研究社区,我们开放源DeepSeek-R1-Zero,DeepSeek-R1和六个密集的型号(1.5b,7b,8b,8b,14b,32b,32b,70b),根据Qwen和Llama蒸馏出了DeepSeek-R1。

一 介绍

近年来,大型语言模型(LLMs)一直在经历快速迭代和演进(Anthropic,2024;谷歌,2024 年;OpenAI,2024a),逐步缩小与通用人工智能 (AGI) 的差距。

最近,后训练已成为完整培训管道的重要组成部分。它已被证明可以提高推理任务的准确性,符合社会价值观,并适应用户偏好,同时在预训练中需要相对最少的计算资源。在推理能力的背景下,OpenAI 的 o1(OpenAI,2024b)系列模型率先通过增加 Chain-ofThought 推理过程的长度引入了推理时间缩放。这种方法在数学、编码和科学推理等各种推理任务中取得了显着改进。然而,有效测试时间缩放的挑战仍然是研究界的一个悬而未决的问题。之前的几项工作探索了各种方法,包括基于过程的奖励模型(Lightman 等人,2023 年;Uesato 等人,2022 年;Wang et al., 2023)、强化学习 (Kumar et al., 2024) 以及蒙特卡洛树搜索和波束搜索等搜索算法 (Feng et al., 2024;Trinh 等人,2024 年;Xin et al., 2024)。然而,这些方法都没有达到与 OpenAI 的 o1 系列模型相媲美的通用推理性能。

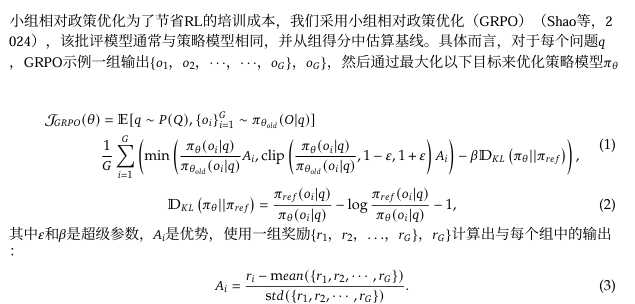

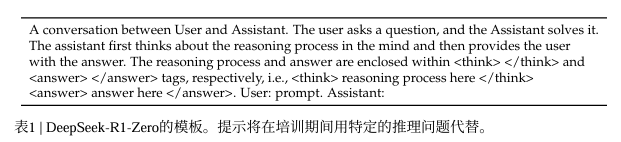

在本文中,我们迈出了使用纯强化学习(RL)提高语言模型推理能力的第一步。我们的目标是探索法学硕士在没有任何监督数据的情况下发展推理能力的潜力,专注于它们通过纯粹的 RL 过程进行自我进化。具体来说,我们使用 DeepSeek-V3-Base 作为基础模型,并采用 GRPO(Shao et al., 2024)作为 RL 框架,以提高模型在推理方面的性能。在训练过程中,DeepSeek-R1-Zero 自然而然地出现了许多强大而有趣的推理行为。经过数千个 RL 步骤后,DeepSeek-R1-Zero 在推理基准测试中表现出超强的性能。例如,AIME 2024 的 pass@1 得分从 15.6% 增加到 71.0%,在多数投票的情况下,该分数进一步提高到 86.7%,与 OpenAI-o1-0912 的性能相当。

然而,DeepSeek-R1-Zero 遇到了可读性差和语言混合等挑战。为了解决这些问题并进一步增强推理性能,我们引入了 DeepSeek-R1,它结合了少量的冷启动数据和多阶段训练管道。具体来说,我们首先收集数千个冷启动数据来微调 DeepSeek-V3-Base 模型。在此之后,我们执行面向推理的 RL,例如 DeepSeek-R1Zero。当 RL 过程接近收敛时,我们通过 RL 检查点上的拒绝采样,结合 DeepSeek-V3 在写作、事实 QA 和自我认知等领域的监督数据,创建新的 SFT 数据,然后重新训练 DeepSeek-V3-Base 模型。使用新数据进行微调后,检查点会经历一个额外的 RL 过程,同时考虑来自所有场景的提示。经过这些步骤,我们获得了一个称为 DeepSeek-R1 的检查点,它的性能与 OpenAI-o1-1217 相当。

我们进一步探索从 DeepSeek-R1 到更小密度模型的蒸馏。以 Qwen2.532B(Qwen,2024b)为基础模型,DeepSeek-R1 的直接蒸馏优于对其应用 RL。这表明,大型基础模型发现的推理模式对于提高推理能力至关重要。我们开源了蒸馏的 Qwen 和 Llama(Dubey 等人,2024 年)系列。值得注意的是,我们的蒸馏 14B 模型大幅优于最先进的开源 QwQ-32B-Preview(Qwen,2024a),蒸馏 32B 和 70B 模型在密集模型中的推理基准上创下了新纪录。

1.1 贡献

后训练:基于基础模型的大规模强化学习

我们将 RL 直接应用于基础模型,而不依赖监督微调 (SFT) 作为初步步骤。这种方法允许模型探索解决复杂问题的思维链(CoT),从而开发出 DeepSeek-R1-Zero。DeepSeekR1-Zero 展示了自我验证、反思和生成长 CoT 等功能,标志着研究界的一个重要里程碑。值得注意的是,这是第一个验证 LLM 的推理能力可以纯粹通过 RL 来激励,而无需 SFT 的开放研究。这一突破为该领域的未来进步铺平了道路。

我们介绍了开发 DeepSeek-R1 的管道。该管道包含两个 RL 阶段,旨在发现改进的推理模式并符合人类偏好,以及两个 SFT 阶段,作为模型推理和非推理能力的种子。我们相信,该管道将通过创造更好的模型使行业受益。

蒸馏:较小的型号也可以很强大

我们证明,与通过 RL 在小型模型上发现的推理模式相比,大型模型的推理模式可以提炼成更小的模型,从而获得更好的性能。开源 DeepSeek-R1 及其 API 将使研究界受益,以在未来提炼出更好的小型模型。

利用 DeepSeek-R1 生成的推理数据,我们微调了几个在研究界广泛使用的密集模型。评估结果表明,蒸馏后的较小密度模型在基准测试中表现异常出色。在 AIME 2024 上DeepSeekR1-Distill-Qwen-7B达到 55.5%,超过 QwQ-32B-Preview。此外,在 DeepSeek-R1-Distill-Qwen-32B AIME 72.6 上得分为 2024%,在 MATH-94.3 上得分为 500%,在 LiveCodeBench 上得分为 57.2%。这些结果明显优于以前的开源模型,可与 o1-mini 相媲美。我们将基于 Qwen2.5 和 Llama3 系列的精炼 1.5B、7B、8B、14B、32B 和 70B 检查点开源到社区。

1.2. 评估结果摘要

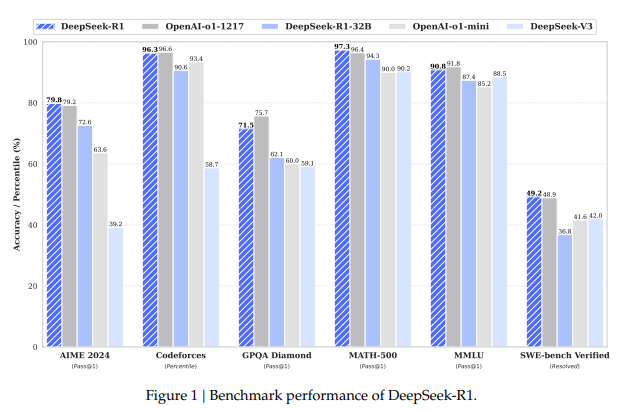

推理任务:(1)DeepSeek-R1 在 AIME 2024 上 Pass@1 得分达到 79.8%,略高于 OpenAI-o1-1217。在 MATH-500 上,它获得了令人印象深刻的 97.3% 分数,与 OpenAI-o1-1217 相当,并且明显优于其他模型。(2)在与编码相关的任务上,DeepSeek-R1 在代码竞赛任务中表现出专家水平,因为它在 Codeforces 上获得了 2,029 Elo 评分,超过了竞赛中 96.3%的人类参与者。对于与工程相关的任务,DeepSeek-R1 的性能略好于 DeepSeek-V3,这可以帮助开发人员完成现实世界的任务。

知识:在 MMLU、MMLU-Pro 和 GPQA Diamond 等基准测试中,DeepSeekR1 取得了出色的成绩,在 MMLU 上得分为 90.8%,在 MMLU-Pro 上得分为 84.0%,在 GPQA Diamond 上得分为 71.5%,明显优于 DeepSeek-V3。虽然在这些基准测试中的性能略低于 OpenAI-o1-1217,但 DeepSeek-R1 超越了其他闭源模型,展示了其在教育任务方面的竞争优势。在事实基准 SimpleQA 上,DeepSeek-R1 的性能优于 DeepSeek-V3,展示了其处理基于事实的查询的能力。观察到类似的趋势,OpenAI-o1 在此基准测试中超过 4o。

其他:DeepSeek-R1 在广泛的任务中也表现出色,包括创意写作、一般问答、编辑、总结等。它实现了令人印象深刻的AlpacaEval 2.0 的长度控制胜率为 87.6%,ArenaHard 的胜率为 92.3%,展示了其智能处理非考试查询的强大能力。此外,DeepSeek-R1 在需要长上下文理解的任务上表现出出色的性能,在长上下文基准测试中大大优于 DeepSeek-V3。

二 方法

2.1. 概述

以前的工作严重依赖大量监督数据来增强模型性能。在这项研究中,我们证明了即使不使用监督微调(SFT)作为冷启动,也可以通过大规模强化学习(RL)显着提高推理能力。此外,通过包含少量冷启动数据,可以进一步提高性能。在以下部分中,我们将介绍:(1) DeepSeek-R1-Zero,它将 RL 直接应用于基础模型,无需任何 SFT 数据,以及 (2) DeepSeek-R1,它从使用数千个长思维链 (CoT) 示例进行微调的检查点开始应用 RL。3)将 DeepSeek-R1 的推理能力提炼到小型密集模型。

2.2. DeepSeek-R1-Zero:基于基础模型的强化学习

强化学习在推理任务中表现出显着的有效性,正如我们之前的工作所证明的那样(Shao et al., 2024;Wang 等人,2023 年)。然而,这些工作在很大程度上依赖于监督数据,收集这些数据非常耗时。在本节中,我们探讨了法学硕士在没有任何监督数据的情况下发展推理能力的潜力,重点关注它们通过纯强化学习过程的自我进化。我们首先简要概述我们的 RL 算法,然后介绍一些令人兴奋的结果,并希望这能为社区提供有价值的见解。

2.2.1. Reinforcement Learning Algorithm

todo.......

四 参考文献

DeepSeek:https://arxiv.org/pdf/2501.12948