在大名鼎鼎的DeepSeek OCR工作发表同期,智谱AI也发表了一篇OCR相关的工作,对于DeekSeek而言,这篇风头被掩盖,属于学术界汪峰了😏,闲言少叙,下面正题:

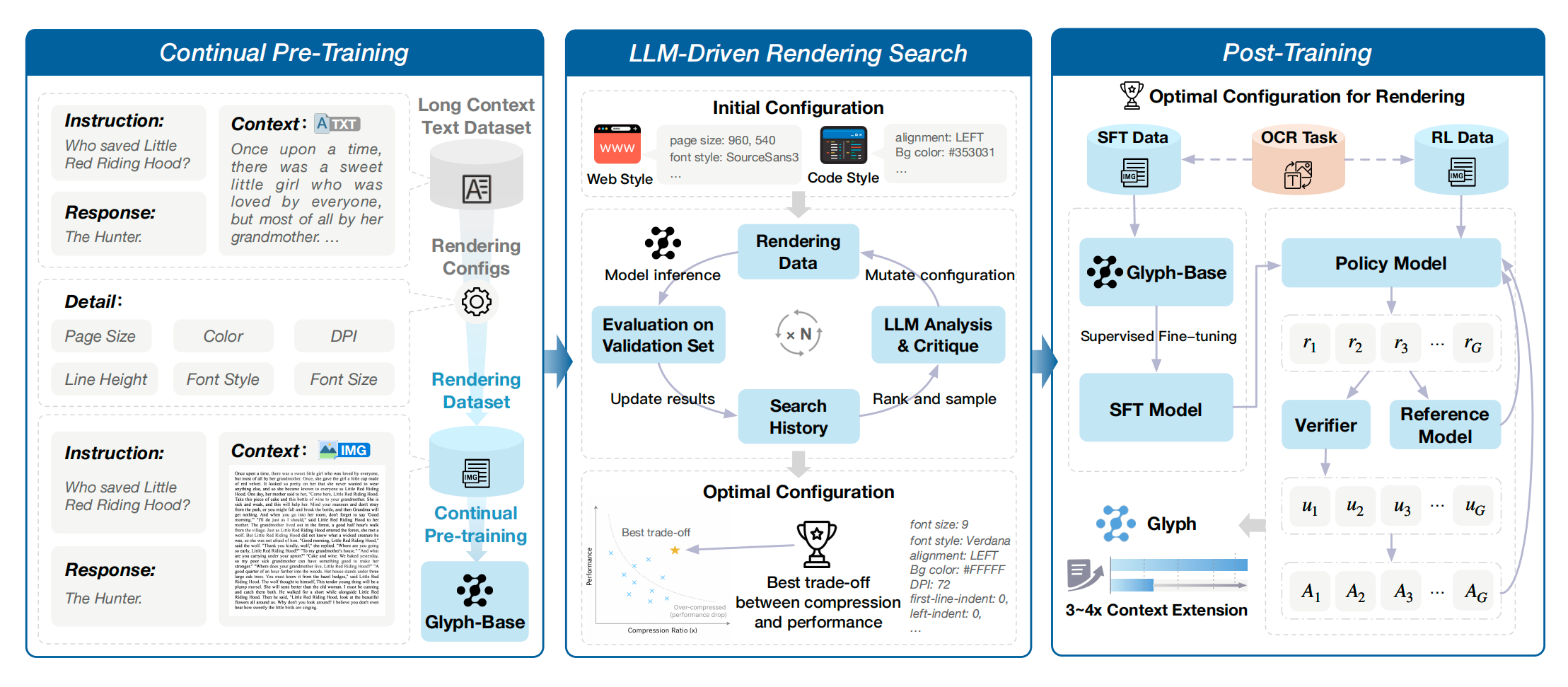

这篇工作的侧重点和DeepSeek的工作还是有很大的不同的:让模型先"看懂字形",再让语言模型推理文字本身。 GlyPh-OCR 更像是一次针对复杂字形的"硬解"。它把文字的"样子"编码下来,让模型真正理解笔画、结构、字体细节,再结合上下文恢复成最终文字。

下面将从技术原理、系统架构、优势、不足及应用场景几个方面,完整解读 GlyPh-OCR 的核心内容。

01 为什么需要 GlyPh-OCR?

传统 OCR 的核心流程通常是:

text

图像 → CNN/ViT encode → CTC/Seq2Seq → 文本问题在于,当图像质量不足时:

- 字模糊

- 分辨率低

- 字体变化大

- 结构不清晰

模型往往只能"猜",而不是"看"。

GlyPh-OCR 的出发点非常简单:

如果模型能"看懂字形",它就能更准确地识别文字。

就像人类一样:

我们不是靠"推断语境"来认字,而是先靠"看字形"。

GlyPh-OCR 正是把这件事系统化、工程化。

02 GlyPh-OCR 的核心思想:字形离散化(Glyph Tokens)

GlyPh-OCR 的最大创新点在于:

把每个字符的视觉信息离散化,转成可让 LLM 使用的 glyph tokens。

它不是直接给 LLM 喂图片,而是先把字符切出来,再转成一种类似"笔画结构向量"的离散 token。

这让模型真正看到的是:

- 字的轮廓

- 字的笔画方向

- 字的几何结构

- 字体风格

这种表示方式远比像素更具表达力。

类似于把字符压缩成一种"视觉字形语言"。

03 GlyPh-OCR 的三大关键模块

3.1 字符检测(Character Detection)

这一步负责:

- 找出图像中所有文字区域

- 定位每个字符框

- 为后续切割提供输入

这一模块类似传统检测模型(如 CRAFT、DBNet),但 GlyPh-OCR 可能做了字体友好的增强。

这是整个流程的第一步,同时也是最"非端到端"的地方。

3.2 字符切割(Character Segmentation)

检测完成后,把每个字符裁成小 patch。

切割要做到:

- 尽量不切到背景

- 尽量完整保留字形

- 在模糊情况下尽量保留笔画轮廓

这一阶段保证了后续 glyph encoder 的输入质量。

3.3 Glyph Encoder:字形离散化(关键创新)

这是 GlyPh-OCR 里最值得关注的部分。

它的任务是:

把一个字符图像 → 一个离散 token 或向量

类似:

"永" → glyph_token_327

"字" → glyph_token_1024

"A" → glyph_token_15Glyph Token 的意义是:

- 降低 LLM 处理难度

- 提供稳定、鲁棒的"字形表示"

- 去除图像噪声影响

- 高度压缩视觉信息

本质上,这一步在做:

字符视觉 → 字形编码语言

从图像世界转换到符号世界。

3.4 LLM 字形理解与文本恢复(Glyph → Text)

最后由 LLM 来完成:

- 字形 → 字

- 字词修复

- 上下文语义推断

- 异体字 / 相似字 disambiguation

例如:

glyph_token_218 glyph_token_553 glyph_token_1003

↓

"複" "杂" "性"这让 GlyPh-OCR 具备很强的纠错能力:

- 字形稍微模糊也能恢复

- 字形近似但语境不同的字,LLM 可以 disambiguate

- 同字不同字体的差异也被统一成 token 空间

04 GlyPh-OCR 不是 End-to-End ------ 它是模块化的 OCR Pipeline

需要注意的是,很多人以为 GlyPh 是端到端模型,但其实不是。

它的整体流程是:

detector → cropper → glyph encoder → LLM decoder这是典型的"多阶段结构化 OCR pipeline"。

优点是模块可控、可解释;

缺点是链路较长,端到端优化难。

这一点与 DeepSeek-OCR 完全不同。

05 GlyPh-OCR 的优势

✔ 1. 模糊文字识别能力超强

得益于 glyph 表征:

- 小字体

- 抖动模糊

- 低分辨率

- 相机噪声

都能被更好地恢复。

- ✔ 2. 字形理解让模型更接近"看字"的过程,比像素编码更稳定。

- ✔ 3. 语言模型能做上下文纠错:"形似但语义不符"的字可以被修正。

- ✔ 4. 对模型大小不敏感,即使小模型也有高性能。

- ✔ 5. 可解释性好,每个字符都有自己的 glyph token→ 非常适合可视化与调试。

06 GlyPh-OCR 的不足与限制

- ❌ 1. 非端到端,链路较长

- ❌ 2. 无法处理文档结构:表格/图表/公式/段落 layout

- ❌ 3. 无法做文档级理解:PDF → Markdown/HTML table 重建/图表 → 数据表/表格结构恢复

这些需要的是文档级语义模型,glyph 无法承担,但是DeepSeek OCR可以。

07 GlyPh-OCR 适合哪里?

- ✔ 扫描件

- ✔ 古籍识别

- ✔ 压缩图片、低清图片

- ✔ 异体字、手写体

- ✔ 小字体、模糊字体

- ✔ 需要可解释性强的场景

它是一条非常适合"字符识别本身"的技术路线。

08 总结

用一句话总结 GlyPh-OCR:

它不是"让模型理解文档",而是"让模型看懂字形"。

它瞄准的是 OCR 的本源:字形识别。

- 如果你需要的是「把字认清楚」,Glyph-OCR 是非常优秀的方案。

- 如果你需要的是「把文档读明白」,则需要像 DeepSeek-OCR 这样的端到端多模态模型。

两者并不是竞争关系,而是:

GlyPh 解决"显微镜级"的字形问题,

DeepSeek-OCR 解决宏观结构化理解问题。

ref:

paper