一. 引言

在大模型应用日益普及的今天,对模型交互过程中Token消耗的深入理解和有效管理变得至关重要。Token作为大模型处理文本的基本单位,不仅直接关系到模型的响应速度和质量,更影响着计算资源的消耗和使用成本。今天我们基于本地部署的Qwen1.5-1.8B-Chat模型,通过构建完整的Token监控与分析系统,深入探讨了模型交互过程中的Token消耗模式、优化策略及实践应用。

随着模型规模的不断扩大和应用场景的多样化,如何在不牺牲对话质量的前提下优化Token使用效率,已成为提升大模型应用经济性和实用性的关键问题。今天我们通过系统化的Token追踪、智能上下文管理和多维度统计分析,为中小规模语言模型的优化部署提供了可复用的解决方案。

二、Token交互基础

1. Token交互过程

在自然语言处理中,token是模型处理的基本单位。对于Qwen1.5-1.8B-Chat模型,输入文本会被 tokenizer 转换成一系列的token ID,模型对这些token进行编码并生成相应的输出token。

python

from modelscope import AutoModelForCausalLM, AutoTokenizer, snapshot_download

import torch

# 设置设备为CPU

device = "cpu"

# 从ModelScope下载/加载模型和分词器

model_id = "qwen/Qwen1.5-1.8B-Chat"

cache_dir = "D:\\modelscope\\hub"

print("正在下载/校验模型缓存...")

local_model_path = snapshot_download(model_id, cache_dir=cache_dir)

# 加载Qwen tokenizer

tokenizer = AutoTokenizer.from_pretrained(local_model_path)

text = "你好,请介绍一下人工智能"

tokens = tokenizer.tokenize(text)

token_ids = tokenizer.encode(text)

print(f"原始文本: {text}")

print(f"Token列表: {tokens}")

print(f"Token IDs: {token_ids}")

print(f"Token数量: {len(token_ids)}")输出结果:

原始文本: 你好,请介绍一下人工智能

Token列表: ['ä½łå¥½', 'ï¼Į请', 'ä>>ĭç>>įä¸Ģä¸ĭ', '人工æĻºèĥ½']

Token IDs: [108386, 37945, 109432, 104455]

Token数量: 4

1.1 对话格式的Token化

Qwen1.5-1.8B-Chat使用了特定的对话格式,其中包含系统提示、用户对话和助理回复。每个部分都由特殊的token分隔。例如,模型使用<|im_start|>和<|im_end|>来标记每个对话轮次。

一个典型的对话格式如下:

- <|im_start|>system

- 你是通义千问,一个有帮助的AI助手。<|im_end|>

- <|im_start|>user

- 你好,请介绍一下你自己。<|im_end|>

- <|im_end|>

- <|im_start|>assistant

模型会接着这个上下文生成助理的回复,直到生成<|im_end|> token为止。

1.2 Token消耗的组成

在一次完整的对话中,token消耗包括:

- 系统提示:系统设定的角色和指令。

- 用户输入:用户当前的问题或对话内容。

- 助理回复:模型生成的回复。

- 特殊token:包括分隔符等。

python

# 查看特殊token

special_tokens = tokenizer.special_tokens_map

print("特殊Token映射:")

for key, value in special_tokens.items():

print(f"{key}: {value}")

# 主要特殊token

print(f"\n<|im_start|> token ID: {tokenizer.encode('<|im_start|>')}")

print(f"<|im_end|> token ID: {tokenizer.encode('<|im_end|>')}")

print(f"<|endoftext|> token ID: {tokenizer.encode('<|endoftext|>')}")输出展示:

特殊Token映射:

eos_token: <|im_end|>

pad_token: <|endoftext|>

additional_special_tokens: ['<|im_start|>', '<|im_end|>']

主要特殊token:

<|im_start|> token ID: [151644]

<|im_end|> token ID: [151645]

<|endoftext|> token ID: [151643]

2. 具体来回示例

假设我们有以下对话:

用户输入:"你好,请介绍一下你自己。"

助理回复:"我是通义千问,一个由开发的大语言模型。我致力于帮助用户解答问题、提供信息和执行各种任务。"

2.1 输入Token化

我们使用Qwen的tokenizer对输入进行token化。注意,整个对话历史(包括系统提示和用户输入)都会被token化。

假设系统提示为:"你是通义千问,一个有帮助的AI助手。"

那么,完整的输入序列为:

- <|im_start|>system

- 你是通义千问,一个有帮助的AI助手。<|im_end|>

- <|im_start|>user

- 你好,请介绍一下你自己。<|im_end|>

- <|im_end|>

- <|im_start|>assistant

我们将这个序列输入模型,模型会生成助理的回复。

2.2 Token数量计算

我们可以使用以下代码来计算token数量:

python

from modelscope import AutoModelForCausalLM, AutoTokenizer, snapshot_download

import torch

# 设置设备为CPU

device = "cpu"

# 从ModelScope下载/加载模型和分词器

model_id = "qwen/Qwen1.5-1.8B-Chat"

cache_dir = "D:\\modelscope\\hub"

print("正在下载/校验模型缓存...")

local_model_path = snapshot_download(model_id, cache_dir=cache_dir)

# 加载Qwen tokenizer

tokenizer = AutoTokenizer.from_pretrained(local_model_path)

def analyze_single_turn_conversation():

"""分析单轮对话的token消耗"""

system_prompt = "你是一个有帮助的AI助手。"

user_message = "请解释一下机器学习的基本概念"

# 构建对话格式

conversation = [

{"role": "system", "content": system_prompt},

{"role": "user", "content": user_message}

]

# 应用聊天模板

formatted_text = tokenizer.apply_chat_template(

conversation,

tokenize=False,

add_generation_prompt=True

)

print("格式化后的对话文本:")

print(formatted_text)

print("\n" + "="*50)

# Token分析

input_tokens = tokenizer.encode(formatted_text)

print(f"输入Token数量: {len(input_tokens)}")

print(f"输入Tokens: {input_tokens}")

print(f"解码验证: {tokenizer.decode(input_tokens)}")

# 假设模型回复

assistant_response = "机器学习是人工智能的一个分支,它使计算机系统能够从数据中学习和改进,而无需明确编程。"

response_tokens = tokenizer.encode(assistant_response)

print(f"\n回复Token数量: {len(response_tokens)}")

print(f"回复内容: {assistant_response}")

total_tokens = len(input_tokens) + len(response_tokens)

print(f"\n总Token消耗: {total_tokens}")

return input_tokens, response_tokens

input_tokens, response_tokens = analyze_single_turn_conversation()运行上述代码,我们可以得到格式化后的对话文本以及输入和输出的token数量:

格式化后的对话文本:

<|im_start|>system

你是一个有帮助的AI助手。<|im_end|>

<|im_start|>user

请解释一下机器学习的基本概念<|im_end|>

<|im_start|>assistant

==================================================

输入Token数量: 28

输入Tokens: [151644, 8948, 198, 56568, 101909, 18830, 100364, 9370, 15469, 110498, 1773, 151645, 198, 151644, 872, 198, 14880,

104136, 100158, 102182, 100134, 105166, 101290, 151645, 198, 151644, 77091, 198]

解码验证: <|im_start|>system

你是一个有帮助的AI助手。<|im_end|>

<|im_start|>user

请解释一下机器学习的基本概念<|im_end|>

<|im_start|>assistant

回复Token数量: 24

回复内容: 机器学习是人工智能的一个分支,它使计算机系统能够从数据中学习和改进,而无需明确编程。

总Token消耗: 52

2.3 多轮对话token累积消耗

接下来我们分析多轮对话中token的累积消耗情况。首先使用Qwen1.5-1.8B-Chat模型的分词器(tokenizer),然后模拟一个多轮对话,并逐轮计算token数量,包括每轮新增的token和累积的token。主要任务是分析多轮对话中Token消耗的累积效应,通过模拟一个完整的对话流程,详细追踪每一轮对话对总Token数量的贡献。

python

from modelscope import AutoModelForCausalLM, AutoTokenizer, snapshot_download

import torch

# 设置设备为CPU

device = "cpu"

# 从ModelScope下载/加载模型和分词器

model_id = "qwen/Qwen1.5-1.8B-Chat"

cache_dir = "D:\\modelscope\\hub"

print("正在下载/校验模型缓存...")

local_model_path = snapshot_download(model_id, cache_dir=cache_dir)

# 加载Qwen tokenizer

tokenizer = AutoTokenizer.from_pretrained(local_model_path)

def analyze_multi_turn_conversation():

"""分析多轮对话的token累积消耗"""

conversation_history = [

{"role": "system", "content": "你是一个专业的科技顾问。"},

{"role": "user", "content": "什么是深度学习?"},

{"role": "assistant", "content": "深度学习是机器学习的一个子领域,它使用多层神经网络来学习和表示数据。"},

{"role": "user", "content": "它和传统机器学习有什么区别?"}

]

# 分析每轮对话的token增长

cumulative_tokens = 0

token_breakdown = []

for i in range(1, len(conversation_history) + 1):

current_convo = conversation_history[:i]

formatted_text = tokenizer.apply_chat_template(

current_convo,

tokenize=False,

add_generation_prompt=(i % 2 == 0) # 只在用户消息后添加生成提示

)

tokens = tokenizer.encode(formatted_text)

token_count = len(tokens)

cumulative_tokens += token_count if i > 1 else 0 # 第一轮不计入累积

token_breakdown.append({

"turn": i,

"role": current_convo[-1]["role"],

"content": current_convo[-1]["content"][:30] + "...",

"tokens_this_turn": token_count,

"cumulative_tokens": cumulative_tokens

})

# 输出分析结果

print("多轮对话Token累积分析:")

print("轮次 | 角色 | 内容摘要 | 本轮Token | 累积Token")

print("-" * 70)

for item in token_breakdown:

print(f"{item['turn']:2} | {item['role']:8} | {item['content']:15} | {item['tokens_this_turn']:11} | {item['cumulative_tokens']:10}")

analyze_multi_turn_conversation()输出结果:

多轮对话Token累积分析:

轮次 | 角色 | 内容摘要 | 本轮Token | 累积Token

1 | system | 你是一个专业的科技顾问。... | 11 | 0

2 | user | 什么是深度学习?... | 23 | 23

3 | assistant | 深度学习是机器学习的一个子领域,它... | 46 | 69

4 | user | 它和传统机器学习有什么区别?... | 62 | 131

三、完整交互Token追踪

1. 完整对话流程监控

我们基于本地的Qwen模型实现Token感知聊天机器人,具备完整的Token使用监控和统计分析功能,实现对模型交互过程中Token消耗的精确追踪。

主要实现过程:

- 初始化方法:加载模型和分词器,初始化对话历史和统计信息。

- chat_with_monitoring方法:进行单轮对话,并监控Token使用情况。

- 更新统计信息和打印交互详情的方法。

流程重点:

- 完整的对话管理:自动维护对话历史上下文

- 精确的Token追踪:在编码和解码阶段分别计算Token

- 性能监控:记录生成时间并计算Token吞吐量

- 平衡控制:temperature=0.7在创造性和准确性间取得平衡

- 长度管理:max_new_tokens防止生成过长回复

- 完整性保障:正确设置结束标记确保生成质量

python

import time

import torch

from transformers import AutoTokenizer, AutoModelForCausalLM

from modelscope import snapshot_download

import json

class TokenAwareChatBot:

def __init__(self, model_path, device="cpu"):

# 从ModelScope加载模型和分词器

print("正在加载模型和分词器...")

self.tokenizer = AutoTokenizer.from_pretrained(

model_path,

trust_remote_code=True

)

self.model = AutoModelForCausalLM.from_pretrained(

model_path,

torch_dtype=torch.float32, # CPU上使用float32

device_map=device,

trust_remote_code=True

)

self.device = device

self.conversation_history = []

self.token_statistics = {

"total_input_tokens": 0,

"total_output_tokens": 0,

"turn_count": 0,

"average_tokens_per_turn": 0

}

def chat_with_monitoring(self, user_input, max_tokens=200):

"""带Token监控的聊天方法"""

# 添加用户消息到历史

self.conversation_history.append({"role": "user", "content": user_input})

# 构建当前对话上下文

formatted_text = self.tokenizer.apply_chat_template(

self.conversation_history,

tokenize=False,

add_generation_prompt=True

)

# 计算输入token

input_tokens = self.tokenizer.encode(formatted_text)

input_token_count = len(input_tokens)

# 准备模型输入

inputs = self.tokenizer(formatted_text, return_tensors="pt").to(self.device)

# 执行生成

start_time = time.time()

with torch.no_grad():

outputs = self.model.generate(

**inputs,

max_new_tokens=max_tokens,

temperature=0.7,

do_sample=True,

eos_token_id=self.tokenizer.eos_token_id,

pad_token_id=self.tokenizer.eos_token_id

)

generation_time = time.time() - start_time

# 解码回复

response = self.tokenizer.decode(

outputs[0][len(inputs["input_ids"][0]):],

skip_special_tokens=True

)

output_tokens = outputs[0][len(inputs["input_ids"][0]):]

output_token_count = len(output_tokens)

# 更新统计

self.conversation_history.append({"role": "assistant", "content": response})

self._update_statistics(input_token_count, output_token_count)

# 输出详细信息

self._print_interaction_details(

user_input, response, input_token_count,

output_token_count, generation_time

)

return response

def _update_statistics(self, input_tokens, output_tokens):

"""更新token统计"""

self.token_statistics["total_input_tokens"] += input_tokens

self.token_statistics["total_output_tokens"] += output_tokens

self.token_statistics["turn_count"] += 1

self.token_statistics["average_tokens_per_turn"] = (

self.token_statistics["total_input_tokens"] +

self.token_statistics["total_output_tokens"]

) / self.token_statistics["turn_count"]

def _print_interaction_details(self, user_input, response, input_tokens, output_tokens, generation_time):

"""打印交互详情"""

print("\n" + "="*80)

print(f"对话轮次: #{self.token_statistics['turn_count']}")

print(f"用户输入: {user_input}")

print(f"AI回复: {response}")

print(f"输入Token数: {input_tokens}")

print(f"输出Token数: {output_tokens}")

print(f"总Token数: {input_tokens + output_tokens}")

print(f"生成时间: {generation_time:.2f}秒")

if generation_time > 0:

print(f"Token/秒: {output_tokens/generation_time:.1f}")

print("="*80)

def get_statistics(self):

"""获取统计信息"""

return self.token_statistics.copy()

# 设置设备

device = "cpu"

# 从ModelScope下载/加载模型和分词器

model_id = "qwen/Qwen1.5-1.8B-Chat"

cache_dir = "D:\\modelscope\\hub"

print("正在下载/校验模型缓存...")

local_model_path = snapshot_download(model_id, cache_dir=cache_dir)

print(f"模型路径: {local_model_path}")

# 使用示例

bot = TokenAwareChatBot(local_model_path, device=device)

# 模拟多轮对话

conversation_topics = [

"请介绍一下Python编程语言",

"它有哪些主要应用领域?",

"学习Python需要什么基础?"

]

for topic in conversation_topics:

response = bot.chat_with_monitoring(topic, max_tokens=150)

# 输出总体统计

stats = bot.get_statistics()

print("\n总体Token统计:")

print(f"总对话轮次: {stats['turn_count']}")

print(f"总输入Token: {stats['total_input_tokens']}")

print(f"总输出Token: {stats['total_output_tokens']}")

print(f"总Token消耗: {stats['total_input_tokens'] + stats['total_output_tokens']}")

print(f"平均每轮Token: {stats['average_tokens_per_turn']:.1f}")输出详细过程和结果:

=========================================================================

对话轮次: #1

用户输入: 请介绍一下Python编程语言

AI回复: Python是一种高级、解释型的动态类型计算机程序设计语言,由Guido van Rossum在1989年首次发布。它具有简单易学、代码可读性强、可移植性好等特点,适合初学者和专业人士使用。

以下是Python的一些主要特性:

1. **简洁明了**:Python语法清晰,简洁明了,易于理解和学习。它的变量声明和赋值操作都是用小写字母和逗号分隔,没有全局变量和静态变量

的概念,这使得代码结构更加清晰。

2. **面向对象编程**:Python支持面向对象编程(OOP),提供了类、对象、继承、多态等概念,使代码更具复用性和灵活性。例如....

- 输入Token数: 24

- 输出Token数: 150

- 总Token数: 174

- 生成时间: 38.31秒

- Token/秒: 3.9

=========================================================================

=========================================================================

对话轮次: #2

用户输入: 它有哪些主要应用领域?

AI回复: Python在以下几个主要应用领域有广泛应用:

1. **科学计算与数据分析**:Python是数据科学和机器学习的重要工具,可以用于处理各种数值计算任务,如线性代数、统计分析、图像处理、自然语言处理等。

2. **Web开发**:Python拥有丰富的Web框架,如Django、Flask、Pyramid等,可以帮助开发者快速构建高质量的Web应用程序,如网站搭建、用户 管理、数据库管理等。

3. **人工智能与机器学习**:Python是深度学习、神经网络等AI领域的主流编程语言,有大量的库和框架可供选择,如TensorFlow、Keras、Scikit-learn等,可以用于构建各种机器学习模型,如分类...

- 输入Token数: 190

- 输出Token数: 150

- 总Token数: 340

- 生成时间: 38.24秒

- Token/秒: 3.9

=========================================================================

=========================================================================

对话轮次: #3

用户输入: 学习Python需要什么基础?

AI回复: 学习Python的基本要求如下:

1. **基本数学知识**:Python中涉及到很多数学概念,如变量、函数、循环、条件语句、列表推导式、矩阵运算、几何图形等,因此,具备一定的数学基础知识对于学习Python至关重要。

2. **编程基础**:熟悉基本的编程概念和语法,如变量、数据类型、控制结构(if-else、for、while)、函数、模块等。Python中有许多内置的数据类型和运算符,以及一些常用的控制结构,如循环、条件语句、函数等。

3. **计算机科学基础知识**:了解计算机系统的基本组成和工作原理,如操作系统、文件系统、网络通信、算法和数据结构等。

- 输入Token数: 356

- 输出Token数: 150

- 总Token数: 506

- 生成时间: 41.69秒

- Token/秒: 3.6

=========================================================================

- 总体Token统计:

- 总对话轮次: 3

- 总输入Token: 570

- 总输出Token: 450

- 总Token消耗: 1020

- 平均每轮Token: 340.0

2. Token消耗模式分析

在原有的Token感知聊天机器人系统基础之上,我们增加了多类型对话模式分析功能。这段示例通过精确的Token追踪和统计分析,深入揭示了不同类型对话在Token消耗上的差异模式。

token监控的维度:

- 总量指标:累计Token消耗

- 效率指标:平均每轮Token使用

- 性能指标:生成速度和吞吐量

- 质量指标:通过回复内容间接反映

场景分类逻辑:

- 短问答:简单事实性查询,预期简短回复

- 技术解释:复杂概念阐述,需要详细说明

- 创意生成:开放性内容创作,需要想象力

- 代码生成:结构化输出,需要精确语法

分析策略:

- 隔离测试:每个场景独立运行,避免历史干扰

- 数据收集:统一格式记录关键指标

- 对比分析:横向比较不同场景的Token模式

python

import time

import torch

from transformers import AutoTokenizer, AutoModelForCausalLM

from modelscope import snapshot_download

import json

class TokenAwareChatBot:

def __init__(self, model_path, device="cpu"):

# 从ModelScope加载模型和分词器

print("正在加载模型和分词器...")

self.tokenizer = AutoTokenizer.from_pretrained(

model_path,

trust_remote_code=True

)

self.model = AutoModelForCausalLM.from_pretrained(

model_path,

torch_dtype=torch.float32, # CPU上使用float32

device_map=device,

trust_remote_code=True

)

self.device = device

self.conversation_history = []

self.token_statistics = {

"total_input_tokens": 0,

"total_output_tokens": 0,

"turn_count": 0,

"average_tokens_per_turn": 0

}

def chat_with_monitoring(self, user_input, max_tokens=200):

"""带Token监控的聊天方法"""

# 添加用户消息到历史

self.conversation_history.append({"role": "user", "content": user_input})

# 构建当前对话上下文

formatted_text = self.tokenizer.apply_chat_template(

self.conversation_history,

tokenize=False,

add_generation_prompt=True

)

# 计算输入token

input_tokens = self.tokenizer.encode(formatted_text)

input_token_count = len(input_tokens)

# 准备模型输入

inputs = self.tokenizer(formatted_text, return_tensors="pt").to(self.device)

# 执行生成

start_time = time.time()

with torch.no_grad():

outputs = self.model.generate(

**inputs,

max_new_tokens=max_tokens,

temperature=0.7,

do_sample=True,

eos_token_id=self.tokenizer.eos_token_id,

pad_token_id=self.tokenizer.eos_token_id

)

generation_time = time.time() - start_time

# 解码回复

response = self.tokenizer.decode(

outputs[0][len(inputs["input_ids"][0]):],

skip_special_tokens=True

)

output_tokens = outputs[0][len(inputs["input_ids"][0]):]

output_token_count = len(output_tokens)

# 更新统计

self.conversation_history.append({"role": "assistant", "content": response})

self._update_statistics(input_token_count, output_token_count)

# 输出详细信息

self._print_interaction_details(

user_input, response, input_token_count,

output_token_count, generation_time

)

return response

def _update_statistics(self, input_tokens, output_tokens):

"""更新token统计"""

self.token_statistics["total_input_tokens"] += input_tokens

self.token_statistics["total_output_tokens"] += output_tokens

self.token_statistics["turn_count"] += 1

self.token_statistics["average_tokens_per_turn"] = (

self.token_statistics["total_input_tokens"] +

self.token_statistics["total_output_tokens"]

) / self.token_statistics["turn_count"]

def _print_interaction_details(self, user_input, response, input_tokens, output_tokens, generation_time):

"""打印交互详情"""

print("\n" + "="*80)

print(f"对话轮次: #{self.token_statistics['turn_count']}")

print(f"用户输入: {user_input}")

print(f"AI回复: {response}")

print(f"输入Token数: {input_tokens}")

print(f"输出Token数: {output_tokens}")

print(f"总Token数: {input_tokens + output_tokens}")

print(f"生成时间: {generation_time:.2f}秒")

if generation_time > 0:

print(f"Token/秒: {output_tokens/generation_time:.1f}")

print("="*80)

def get_statistics(self):

"""获取统计信息"""

return self.token_statistics.copy()

# 设置设备

device = "cpu"

# 从ModelScope下载/加载模型和分词器

model_id = "qwen/Qwen1.5-1.8B-Chat"

cache_dir = "D:\\modelscope\\hub"

print("正在下载/校验模型缓存...")

local_model_path = snapshot_download(model_id, cache_dir=cache_dir)

print(f"模型路径: {local_model_path}")

# 使用示例

bot = TokenAwareChatBot(local_model_path, device=device)

def analyze_token_patterns():

"""分析不同类型的对话token消耗模式"""

test_cases = [

{

"type": "短问答",

"user_input": "今天天气怎么样?",

"expected_response": "这是一个关于天气的简单问题。"

},

{

"type": "技术解释",

"user_input": "请详细解释Transformer架构的工作原理",

"expected_response": "Transformer是一种基于自注意力机制的神经网络架构..."

},

{

"type": "创意生成",

"user_input": "写一个关于人工智能的短故事",

"expected_response": "在未来的世界里,人工智能已经深度融入人类生活..."

},

{

"type": "代码生成",

"user_input": "用Python写一个快速排序算法",

"expected_response": "def quicksort(arr):\n if len(arr) <= 1:\n return arr\n pivot = arr[len(arr)//2]\n left = [x for x in arr if x < pivot]\n middle = [x for x in arr if x == pivot]\n right = [x for x in arr if x > pivot]\n return quicksort(left) + middle + quicksort(right)"

}

]

results = []

for case in test_cases:

print(f"\n测试类型: {case['type']}")

response = bot.chat_with_monitoring(case['user_input'])

stats = bot.get_statistics()

results.append({

"type": case['type'],

"user_input": case['user_input'],

"input_tokens": stats['total_input_tokens'],

"output_tokens": stats['total_output_tokens']

})

# 分析结果

print("\n不同对话类型Token消耗对比:")

for result in results:

total_tokens = result['input_tokens'] + result['output_tokens']

print(f"{result['type']:12} | 输入: {result['input_tokens']:4} | 输出: {result['output_tokens']:4} | 总计: {total_tokens:4}")

analyze_token_patterns()输出详细过程和结果:

测试类型: 短问答

=========================================================================

对话轮次: #1

用户输入: 今天天气怎么样?

AI回复: 抱歉,作为一个人工智能模型,我无法实时获取和提供您所在地区的天气信息。但是,我可以告诉您一般情况下,天气预报会根据地理位

置、日期、时间等因素进行预测。您可以查看当地的天气预报网站或者应用来获取当前或未来几天的天气情况,包括温度、湿度、风速、降水量等详细信息。

如果您能告诉我您所在的城市或地区,我会很乐意为您提供更准确的天气预报信息。例如,如果我在北京,我可以告诉您今天的天气情况是多云转晴,气温为20℃,相对湿度为50%,风速为3级。请注意,这些信息可能会随时间和地点的变化而变化,请及时查询最新的天气预报以确保您的出行安全。

- 输入Token数: 23

- 输出Token数: 153

- 总Token数: 176

- 生成时间: 41.67秒

- Token/秒: 3.7

=========================================================================

测试类型: 技术解释

=========================================================================

对话轮次: #2

用户输入: 请详细解释Transformer架构的工作原理

AI回复: Transformer是一种深度学习模型,由Google在2017年提出,并在自然语言处理(NLP)领域中广泛应用。Transformer的主要工作原理如下:

*1. **输入层**:

- 在Transformer的输入层,我们将原始文本数据转换为一个称为"token"的低维向量表示。每个词都被表示为一个向量,长度通常为32个单位。*

- 这些向量被称为编码器,它们通过前馈神经网络(FFN)进行编码,该网络使用循环神经网络(RNN)结构来接收输入序列并生成新的编码。在

这种情况下,我们使用了Transformer的自注意力机制,它允许模型对输入序列中的每一个单词都进行局部加权求和,然后将结果传递给下一个隐藏层。

*2. **隐藏层**:

- 隐藏层是Transformer的核心部分,其目的是将编码器输出的编码子向量转换为更高维度的*

- 输入Token数: 192

- 输出Token数: 200

- 总Token数: 392

- 生成时间: 64.20秒

- Token/秒: 3.1

=========================================================================

测试类型: 创意生成

=========================================================================

对话轮次: #3

用户输入: 写一个关于人工智能的短故事

AI回复: 在一个遥远的未来,人工智能已经超越了人类的认知能力,成为了社会的重要组成部分。在这个世界里,人们通过一种名为"智能大脑"的技术,将机器学习算法嵌入到他们的思维中,让计算机能够理解和思考复杂的任务。

一天,一位名叫艾米丽的年轻科学家被分配了一个重要的任务:研究一种新型的人工智能系统,它可以解决全球范围内的气候变化问题。她开始了一项艰苦的研究项目,深入探讨如何利用深度学习和强化学习的方法,使这种智能系统具有自我学习和适应环境的能力。

艾米丽设计了一系列复杂的实验,包括模拟气候模式、训练AI系统在不同气候条件下的行为和决策过程,并与传统机器学习方法进行了对比。经过几个月的努力,艾米丽成功地开发出了一种名为"气候智能体"的AI系统。

这个智能体不仅具备强大的气候预测和模拟能力,还能根据历史数据和实时数据动态调整策略,优化能源消耗和碳排放,....

- 输入Token数: 409

- 输出Token数: 200

- 总Token数: 609

- 生成时间: 71.17秒

- Token/秒: 2.8

=========================================================================

测试类型: 代码生成

=========================================================================

对话轮次: #4

用户输入: 用Python写一个快速排序算法

AI回复: 以下是一个简单的Python实现的快速排序算法:

```python

def quick_sort(arr):

if len(arr) <= 1:

return arr

pivot = arr[len(arr) // 2]

left = [x for x in arr if x < pivot]

middle = [x for x in arr if x == pivot]

right = [x for x in arr if x > pivot]

return quick_sort(left) + middle + quick_sort(right)

# 测试代码

arr = [4, 2, 9, 6, 8, 1, 3, 5, 7]

print(quick_sort(arr))

```

快速排序的基本思想是选择一个基准值(pivot),将数组分为三个部分:小于基准值的部分、等于基准值的部分和大于基准值的部分。然后递归地对小于和大于基准值的部分进行排序,直到整个数组有序。

在上述代码中,我们首先检查数组...

- 输入Token数: 628

- 输出Token数: 200

- 总Token数: 828

- 生成时间: 67.96秒

- Token/秒: 2.9

=========================================================================

不同对话类型Token消耗对比:

- 短问答 | 输入: 23 | 输出: 153 | 总计: 176

- 技术解释 | 输入: 215 | 输出: 353 | 总计: 568

- 创意生成 | 输入: 624 | 输出: 553 | 总计: 1177

- 代码生成 | 输入: 1252 | 输出: 753 | 总计: 2005

四、Token优化策略实践

1. 上下文长度优化

面对有限上下文窗口的挑战,我们可以设计更加智能上下文管理系统。当检测到当前对话Token数超过预设阈值时,系统自动触发压缩流程:

压缩策略:

- 保留系统提示信息和最近两轮对话内容,确保基础对话上下文的完整性

- 对较早的历史对话进行摘要处理,通过插入摘要提示词维持对话连贯性

- 动态调整压缩粒度,根据对话长度和复杂度平衡信息保留与资源节省

python

def _compress_conversation_history(self):

"""压缩对话历史的智能实现"""

if len(self.conversation_history) <= 2:

return

# 智能识别系统消息和关键对话内容

system_message = None

for msg in self.conversation_history:

if msg["role"] == "system":

system_message = msg

break

# 保留最近的关键对话轮次

recent_messages = self.conversation_history[-4:]

# 构建压缩后的对话历史

if system_message:

self.compressed_history = [system_message] + recent_messages

else:

self.compressed_history = recent_messages2. Prompt工程优化

这段示例实现了一个Prompt工程优化技术分析工具,通过对比分析不同Prompt表达方式的Token消耗差异,系统性地展示了Prompt优化的有效方法和具体效果。

分析方法:

- 精确计量:使用相同分词器确保计算标准一致

- 相对比较:计算绝对节省值和相对节省百分比

- 效果可视化:通过对比数据直观展示优化效果

技术实现分类:

- 词汇层面:缩写、术语简化

- 句式层面:去除冗余、直接表达

- 结构层面:标点优化、逻辑简化

- 语义层面:保持指令意图不变

验证方法:

- 独立测试:每个技巧单独计算节省效果

- 统一格式:使用" → "分隔优化前后版本

- 量化展示:精确显示每个技巧的Token节省数

python

from transformers import AutoTokenizer, AutoModelForCausalLM

from modelscope import snapshot_download

# 设置设备

device = "cpu"

# 从ModelScope下载/加载模型和分词器

model_id = "qwen/Qwen1.5-1.8B-Chat"

cache_dir = "D:\\modelscope\\hub"

print("正在下载/校验模型缓存...")

local_model_path = snapshot_download(model_id, cache_dir=cache_dir)

def prompt_optimization_techniques():

"""Prompt工程优化技术"""

# 原始prompt(低效)

inefficient_prompt = """

请你作为一个专业的人工智能助手,详细地、全面地、有条理地回答以下问题。

请确保你的回答准确、完整且易于理解。请分点说明,并提供相关示例。

问题:什么是机器学习?

"""

# 优化后的prompt(高效)

efficient_prompt = "解释机器学习概念,分点说明并提供示例"

tokenizer = AutoTokenizer.from_pretrained(local_model_path)

inefficient_tokens = len(tokenizer.encode(inefficient_prompt))

efficient_tokens = len(tokenizer.encode(efficient_prompt))

print("Prompt优化对比:")

print(f"低效Prompt Token数: {inefficient_tokens}")

print(f"高效Prompt Token数: {efficient_tokens}")

print(f"节省Token: {inefficient_tokens - efficient_tokens} ({((inefficient_tokens - efficient_tokens)/inefficient_tokens)*100:.1f}%)")

# 更多优化技巧

optimization_tips = [

("使用缩写", "自然语言处理 → NLP"),

("移除冗余词语", "请详细地、全面地 → 请详细说明"),

("直接表达", "你能否告诉我... → 解释..."),

("使用标点", "第一点 第二点 → 1. 2."),

("简化结构", "首先...其次...最后... → 分点说明:")

]

print("\nPrompt优化技巧:")

for technique, example in optimization_tips:

before_tokens = len(tokenizer.encode(example.split(" → ")[0]))

after_tokens = len(tokenizer.encode(example.split(" → ")[1]))

savings = before_tokens - after_tokens

print(f"{technique:15} | 节省 {savings:2} tokens | {example}")

prompt_optimization_techniques()输出详细过程和结果:

Prompt优化对比:

- 低效Prompt Token数: 58

- 高效Prompt Token数: 12

- 节省Token: 46 (79.3%)

Prompt优化技巧:

- 使用缩写 | 节省 1 tokens | 自然语言处理 → NLP

- 移除冗余词语 | 节省 3 tokens | 请详细地、全面地 → 请详细说明

- 直接表达 | 节省 2 tokens | 你能否告诉我... → 解释...

- 使用标点 | 节省 0 tokens | 第一点 第二点 → 1. 2.

- 简化结构 | 节省 2 tokens | 首先...其次...最后... → 分点说明:

3. 响应长度控制

这段示例通过系统性地测试不同Token限制参数对模型生成结果的影响,揭示了Token限制与响应质量之间的内在关系。代码基于之前构建的Token感知聊天机器人,增加了对生成长度与质量平衡的深入研究。

评估逻辑:

- 绝对长度阈值:20字符作为最低可接受长度

- 相对比例评估:基于Token-字符转换经验比例

- 截断检测:识别是否因限制导致内容不完整

Token-字符转换原理:

- 中文特性:中文字符与Token通常存在1:1到1:2的关系

- 经验系数:基于大量实验得出的近似转换比例

- 实际应用:为长度预估提供参考基准

测试方法:

- 独立测试:每次测试前重置对话历史,确保结果可比性

- 实时监控:利用已有的监控系统记录详细交互数据

- 双重度量:同时关注Token数量和字符长度

python

import time

import torch

from transformers import AutoTokenizer, AutoModelForCausalLM

from modelscope import snapshot_download

import json

class TokenAwareChatBot:

def __init__(self, model_path, device="cpu"):

# 从ModelScope加载模型和分词器

print("正在加载模型和分词器...")

self.tokenizer = AutoTokenizer.from_pretrained(

model_path,

trust_remote_code=True

)

self.model = AutoModelForCausalLM.from_pretrained(

model_path,

torch_dtype=torch.float32, # CPU上使用float32

device_map=device,

trust_remote_code=True

)

self.device = device

self.conversation_history = []

self.token_statistics = {

"total_input_tokens": 0,

"total_output_tokens": 0,

"turn_count": 0,

"average_tokens_per_turn": 0

}

def chat_with_monitoring(self, user_input, max_tokens=200):

"""带Token监控的聊天方法"""

# 添加用户消息到历史

self.conversation_history.append({"role": "user", "content": user_input})

# 构建当前对话上下文

formatted_text = self.tokenizer.apply_chat_template(

self.conversation_history,

tokenize=False,

add_generation_prompt=True

)

# 计算输入token

input_tokens = self.tokenizer.encode(formatted_text)

input_token_count = len(input_tokens)

# 准备模型输入

inputs = self.tokenizer(formatted_text, return_tensors="pt").to(self.device)

# 执行生成

start_time = time.time()

with torch.no_grad():

outputs = self.model.generate(

**inputs,

max_new_tokens=max_tokens,

temperature=0.7,

do_sample=True,

eos_token_id=self.tokenizer.eos_token_id,

pad_token_id=self.tokenizer.eos_token_id

)

generation_time = time.time() - start_time

# 解码回复

response = self.tokenizer.decode(

outputs[0][len(inputs["input_ids"][0]):],

skip_special_tokens=True

)

output_tokens = outputs[0][len(inputs["input_ids"][0]):]

output_token_count = len(output_tokens)

# 更新统计

self.conversation_history.append({"role": "assistant", "content": response})

self._update_statistics(input_token_count, output_token_count)

# 输出详细信息

self._print_interaction_details(

user_input, response, input_token_count,

output_token_count, generation_time

)

return response

def _update_statistics(self, input_tokens, output_tokens):

"""更新token统计"""

self.token_statistics["total_input_tokens"] += input_tokens

self.token_statistics["total_output_tokens"] += output_tokens

self.token_statistics["turn_count"] += 1

self.token_statistics["average_tokens_per_turn"] = (

self.token_statistics["total_input_tokens"] +

self.token_statistics["total_output_tokens"]

) / self.token_statistics["turn_count"]

def _print_interaction_details(self, user_input, response, input_tokens, output_tokens, generation_time):

"""打印交互详情"""

print("\n" + "="*80)

print(f"对话轮次: #{self.token_statistics['turn_count']}")

print(f"用户输入: {user_input}")

print(f"AI回复: {response}")

print(f"输入Token数: {input_tokens}")

print(f"输出Token数: {output_tokens}")

print(f"总Token数: {input_tokens + output_tokens}")

print(f"生成时间: {generation_time:.2f}秒")

if generation_time > 0:

print(f"Token/秒: {output_tokens/generation_time:.1f}")

print("="*80)

def get_statistics(self):

"""获取统计信息"""

return self.token_statistics.copy()

# 设置设备

device = "cpu"

# 从ModelScope下载/加载模型和分词器

model_id = "qwen/Qwen1.5-1.8B-Chat"

cache_dir = "D:\\modelscope\\hub"

print("正在下载/校验模型缓存...")

local_model_path = snapshot_download(model_id, cache_dir=cache_dir)

print(f"模型路径: {local_model_path}")

# 使用示例

bot = TokenAwareChatBot(local_model_path, device=device)

def response_length_optimization():

"""响应长度控制优化"""

# bot = TokenAwareChatBot("./qwen1.5-1.8b-chat")

# 测试不同max_tokens设置的影响

test_questions = [

"介绍人工智能的历史发展",

"解释神经网络的基本原理",

"说明Python在数据分析中的应用"

]

token_limits = [50, 100, 200, 500]

for question in test_questions:

print(f"\n问题: {question}")

print("不同Token限制下的响应长度:")

for limit in token_limits:

# 重置对话历史避免累积影响

bot.conversation_history = [{"role": "user", "content": question}]

response = bot.chat_with_monitoring(question, max_tokens=limit)

response_length = len(response)

print(f" max_tokens={limit:3}: 响应长度={response_length:3}字符")

# 分析响应质量

if response_length < 20:

quality = "过短"

elif response_length < limit * 2: # 假设平均每个token约2个中文字符

quality = "适中"

else:

quality = "被截断"

print(f" 质量评估: {quality}")

response_length_optimization()输出详细过程和结果:

问题: 介绍人工智能的历史发展

不同Token限制下的响应长度:

=========================================================================

对话轮次: #1

用户输入: 介绍人工智能的历史发展

AI回复: 人工智能(Artificial Intelligence,简称AI)是一种模拟人类智能的技术,旨在使计算机系统能够自动完成一系列复杂的任务,例如语音识别、图像识别、自然语言处理、机器学习和深度学习等。以下是人工智能历史发展的简要

- 输入Token数: 32

- 输出Token数: 50

- 总Token数: 82

- 生成时间: 21.43秒

- Token/秒: 2.3

=========================================================================

max_tokens= 50: 响应长度=114字符

质量评估: 被截断

=========================================================================

对话轮次: #2

用户输入: 介绍人工智能的历史发展

AI回复: 人工智能(Artificial Intelligence,AI)起源于20世纪50年代,最初是一种计算机科学领域中的研究,旨在开发能够模拟人类智能的机器。以下是人工智能历史发展的几个关键阶段:

1. 早期发展阶段:在20世纪50年代至60年代,人工智能主要关注如何设计和实现可编程的算法和模型,以便让计算机能够解决复杂的问题,例如图像识别、语音识别、自然语言处理等。这一时期的主要成果包括专家

- 输入Token数: 32

- 输出Token数: 100

- 总Token数: 132

- 生成时间: 28.88秒

- Token/秒: 3.5

=========================================================================

max_tokens=100: 响应长度=197字符

质量评估: 适中

=========================================================================

对话轮次: #3

用户输入: 介绍人工智能的历史发展

AI回复: 人工智能(Artificial Intelligence,简称AI)是一个广泛且复杂的概念,它涉及到计算机科学、数学、统计学、机器学习、自然语言处理、计算机视觉和机器人技术等多个领域。以下是人工智能历史发展的简要概述:

1950年代:达特茅斯会议是人工智能的诞生地,该会议由美国麻省理工学院于1956年召开,标志着现代人工智能研究的开始。在这次会议上,科学家们首次提出了"智能"一词,并讨论了如何设计和构建具有人类智能的计算机系统。

1960年代:随着计算机硬件的发展,如晶体管和电子管,以及数据存储和传输的进步,机器学习和专家系统开始在人工智能领域崭露头角。1962年,John McCarthy等人提出了"机器学习"的概念,这是人工智能的一个重要分支,旨在使计算机能够从经验中自动学习并改进性能。

1970年代:人工智能的研究进入了一个新的

- 输入Token数: 32

- 输出Token数: 200

- 总Token数: 232

- 生成时间: 57.42秒

- Token/秒: 3.5

=========================================================================

max_tokens=200: 响应长度=375字符

质量评估: 适中

=========================================================================

对话轮次: #4

用户输入: 介绍人工智能的历史发展

AI回复: 人工智能(Artificial Intelligence, AI)是一种计算机科学分支,旨在使机器能够模拟人类智能行为和思维过程。它的历史可以追溯到20世纪50年代,当时科学家们开始探索如何让计算机系统学习、推理和解决问题。

1956年,达特茅斯会议是AI领域的重要里程碑,标志着现代AI的诞生。在这次会议上,阿兰·图灵提出了"图灵测试",这是评估一个计算机程序是否具有人类智能的标准。该测试要求被试者与一台计算机进行对话,而计算机需要能够理解并回答问题,即使它们没有预先编程或训练。图灵测试的结果表明,虽然许多早期的AI系统无法通过这个测试,但它们在某些任务上表现出了一定程度的智能,如语音识别、图像分类等。

然而,直到20世纪80年代末和90年代初,随着计算机硬件技术的发展和数据集的增长,AI研究取得了显著的进步。这包括神经网络、支持向量机、决策树和深度学习等算法的出现,这些技术使得计算机系统能够从大量数据中自动提取特征,并通过复杂的模型进行预测和决策。

21世纪初,随着云计算和大数据技术的发展,AI的应用范围得到了空前扩展。例如,在自动驾驶汽车、医疗诊断、金融风控、智能家居等领域,AI已经发挥了重要作用。此外,自然语言处理、机器人技术、计算机视觉等领域的研究也在不断发展,为AI应用提供了更多的可能性。

当前,AI正在逐步改变我们的生活方式和社会结构。AI技术不仅提高了工作效率和生活质量,也为解决复杂的社会问题提供了新的工具。例如,在医疗保健领域,AI可以帮助医生更准确地诊断疾病,提高治疗效果;在教育领域,AI可以根据学生的学习情况和需求提供个性化的教学方案;在交通管理方面,AI可以通过实时监测交通流量和路况,优化道路规划和交通调度。

尽管AI带来了巨大的潜力,但也面临着一些挑战和风险,如数据隐私、安全漏洞、就业影响等。因此,未来的人工智能发展需要在技术创新和伦理规范之间找到平衡,以实现人工智能的可持续发展和人类社会的长远福祉。

- 输入Token数: 32

- 输出Token数: 444

- 总Token数: 476

- 生成时间: 118.09秒

- Token/秒: 3.8

=========================================================================

max_tokens=500: 响应长度=831字符

质量评估: 适中

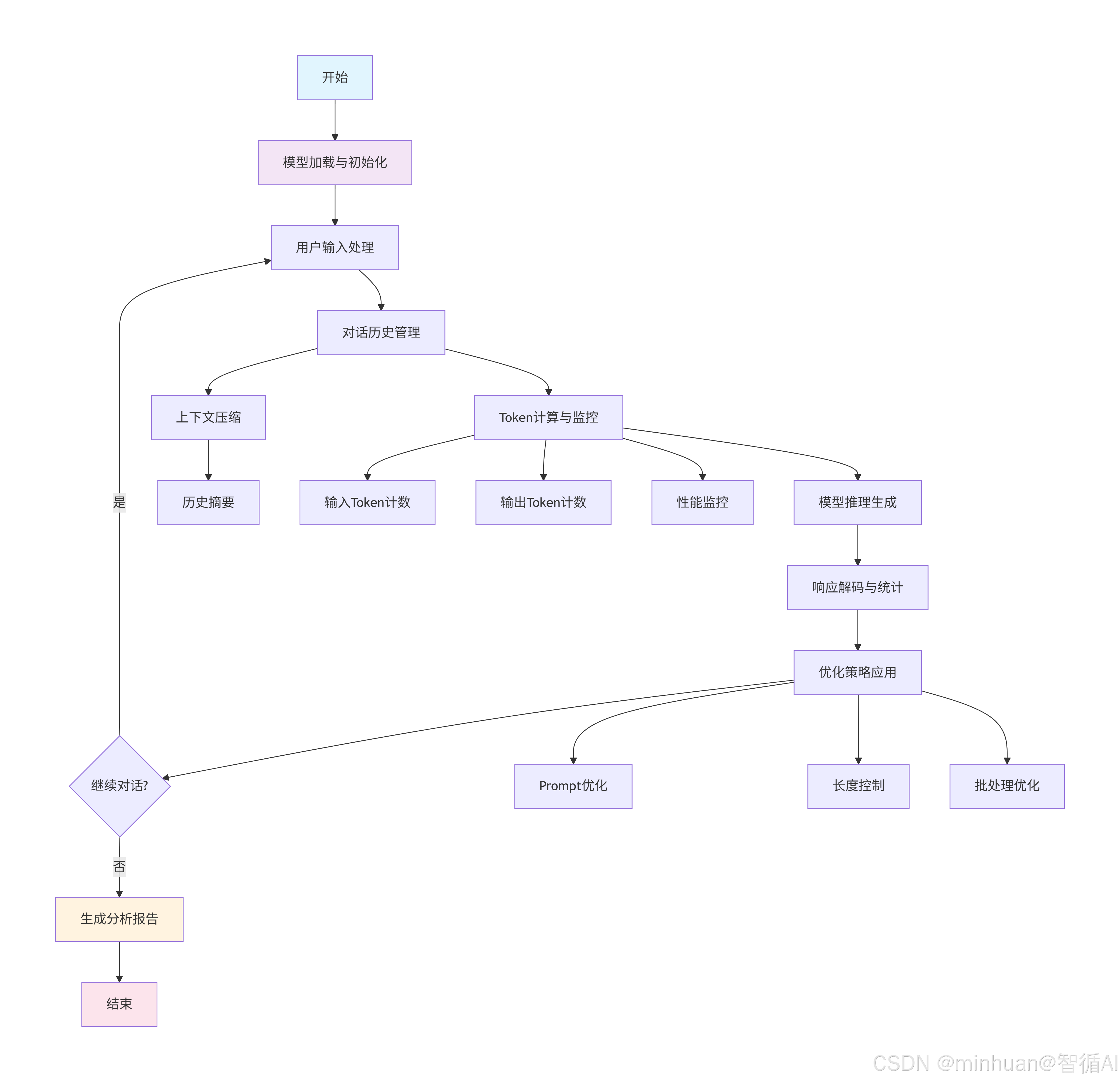

五、优化流程汇总

1. 初始化阶段

- 模型加载与初始化:从ModelScope下载模型,加载分词器和模型权重

- 设置设备环境(CPU/GPU),配置生成参数

2. 对话处理循环

- 用户输入处理:接收用户问题并格式化

- 对话历史管理:维护上下文,包含压缩和摘要机制

- Token计算与监控:实时追踪输入输出Token消耗

- 模型推理生成:执行模型前向传播生成回复

- 响应解码与统计:解码生成结果并更新统计数据

3. 优化策略层

- Prompt优化:精简指令,减少冗余Token

- 长度控制:动态调整生成长度参数

- 批处理优化:提高批量请求处理效率

- 上下文压缩:智能管理长对话历史

4. 分析输出阶段

- 性能报告:生成详细的Token使用统计

- 优化建议:基于数据分析提供改进建议

六、总结

今天我们通过构建基于Qwen1.5-1.8B-Chat的完整Token监控与优化系统,实现了以下主要成果:

- 建立了全面的Token分析体系,从实时监控到历史统计,提供了多层次的Token使用洞察

- 开发了智能上下文管理策略,有效解决了长对话中的上下文窗口限制问题

- 验证了多种Token优化技术,为资源受限环境下的模型部署提供了实用方案

- 实现了设备自适应的模型加载,确保系统在不同硬件环境下的可用性

通过持续的技术迭代和优化,我们相信Token效率优化将在推动大语言模型普惠应用方面发挥越来越重要的作用。