前置准备

- 安装必备工具

bash

# 安装Homebrew (包管理器)

/bin/bash -c "$(curl -fsSL https://raw.githubusercontent.com/Homebrew/install/HEAD/install.sh)"

# 安装Python 3.10 (M3芯片推荐)

brew install python@3.10

# 安装Node.js 20.x

brew install node@20

# 安装Git

brew install git

# 安装Ollama (用于LLM)

brew install ollama

# 安装Sox (用于CosyVoice)

brew install sox- 验证安装

bash

python3 --version # 应显示 3.10.x

node -v # 应显示 v20.x

ollama --version # 应显示 0.1.x- SillyTavern (情感/叙事写作)

bash

cd ~/AI_Creation_System

git clone https://github.com/SillyTavern/SillyTavern -b release

cd SillyTavern

npm install在 Ollama 中,Phi-3-mini 的正确拉取命令是:

bash

ollama pull phi3:mini

ollama pull phi3:mini-q4_K_M 二选一都行 🧪 快速测试步骤(M3 Mac 推荐)

bash

# 1. 拉取模型(只需一次)

ollama pull phi3

# 2. 启动对话

ollama run phi3

# 3. 输入你的提示(比如):

写一个关于海边日落的微小说,要有孤独感和希望。🔧 正确操作步骤(M3 Mac)

第一步:启动 Ollama(确保 LLM 可用)

bash

# 确保 phi3 已安装

ollama pull phi3

# 启动 Ollama 服务(通常会自动启动)

ollama serve✅ 验证:访问

http://localhost:11434/api/tags,应看到已安装的模型列表

第二步:启动 SillyTavern

bash

cd ~/AI_Creation_System/SillyTavern

npm start默认打开:

http://localhost:8000

第三步:在 Web 界面中配置 Ollama(关键!)

- 打开浏览器 →

http://localhost:3000 - 首次进入会看到欢迎界面,点击 "Connect to a backend"

- 选择 "Ollama" 作为后端

- 填写以下信息:

- API URL :

http://localhost:11434 - Model :

phi3(或其他你安装的模型,如mistral、qwen:7b)

- API URL :

- 点击 "Test Connection" → 应显示 "Success!"

- 点击 "Save"

✅ 完成!现在你可以直接在聊天框里和 Phi-3 对话了。

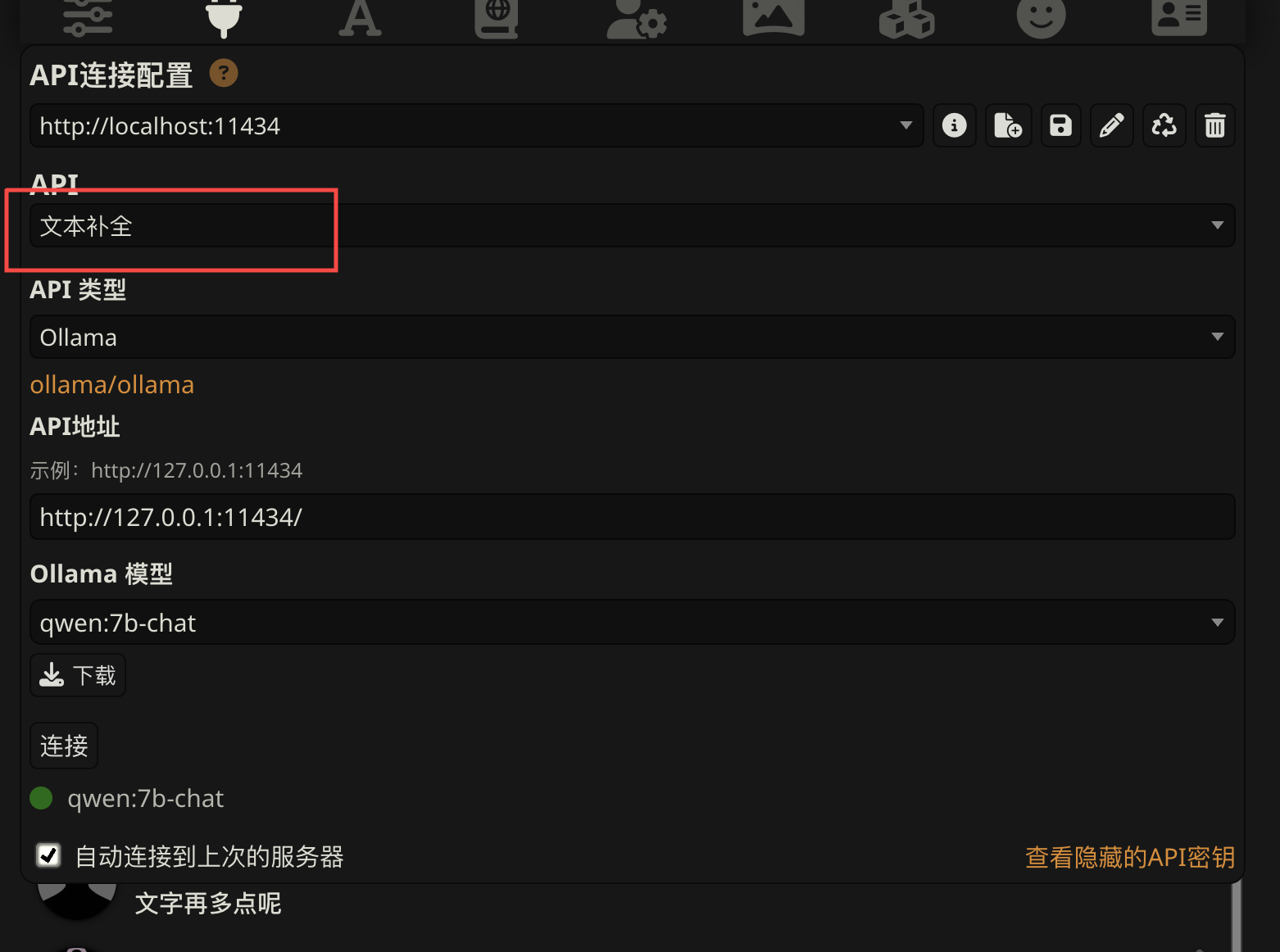

配置大模型的时候要注意 这里要选择文本 ollama只支持文本模型

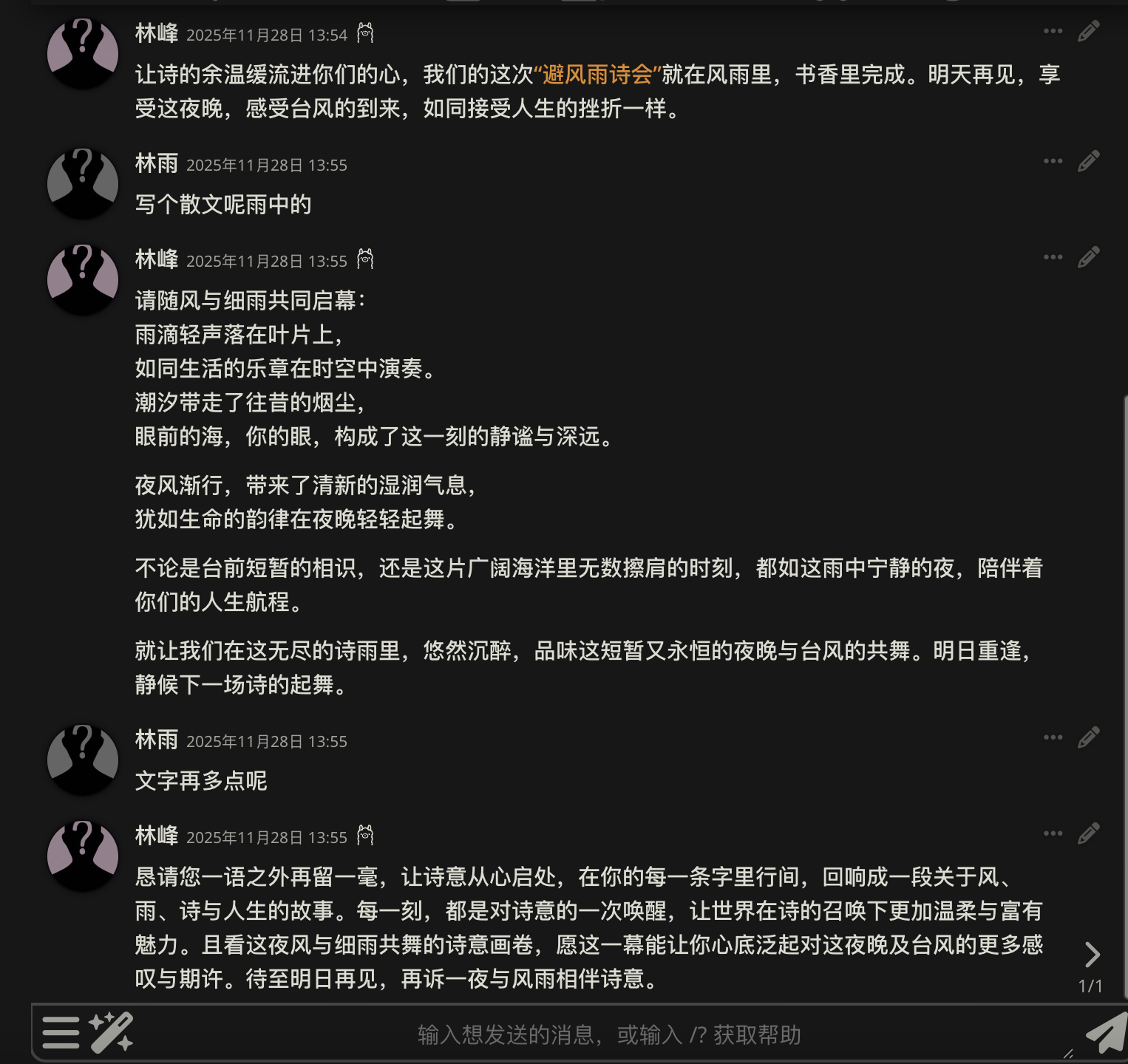

这是实际效果 具体怎么玩有兴趣的key自己研究下