就在这周,也就是 2025 年的 12 月初,AI 圈子再次变得热闹非凡。当我们还在讨论几家硅谷巨头谁的闭源 API 更贵时,来自法国的 Mistral AI 直接把桌子掀了。

Mistral 3 系列正式发布。

这一波更新不仅硬核,而且充满了一种久违的极客浪漫主义色彩------全系回归 Apache 2.0 许可。如果你是开发者,看到这里大概已经懂了这意味着什么:自由。没有繁琐的商用限制,拿着这些模型,你想怎么改就怎么改,想怎么用就怎么用。

这次发布的阵容非常有意思,Mistral 似乎看透了现在的 AI 落地痛点,打出了一套"高低搭配"的组合拳。

不仅大,而且还要"大得聪明"

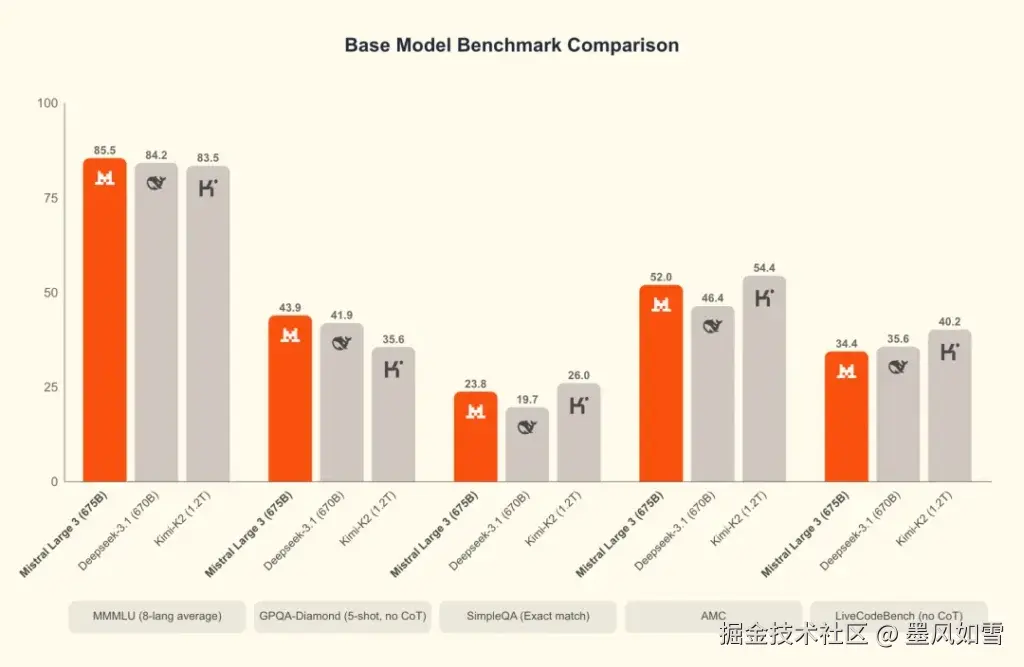

首先登场的是重型武器:Mistral Large 3。

看参数党可能会先被吓一跳:总参数量高达 6750 亿。但别急着担心你的显存,它是经典的稀疏混合专家(MoE)架构。这意味着虽然它脑容量巨大,但每次思考时只动用其中最灵光的 410 亿参数(活跃参数)。

这种设计非常鸡贼,它在保留了万亿级模型那样的广博知识和逻辑深度的同时,把推理成本压到了一个非常可观的水平。加上 256K 的超长上下文,这基本上就是对着 GPT-4o 这种前沿闭源模型去的。而且它原生支持多模态,不论是看图说话还是多语言处理,都不再是英语语境下的"特供版",对非英语用户相当友好。

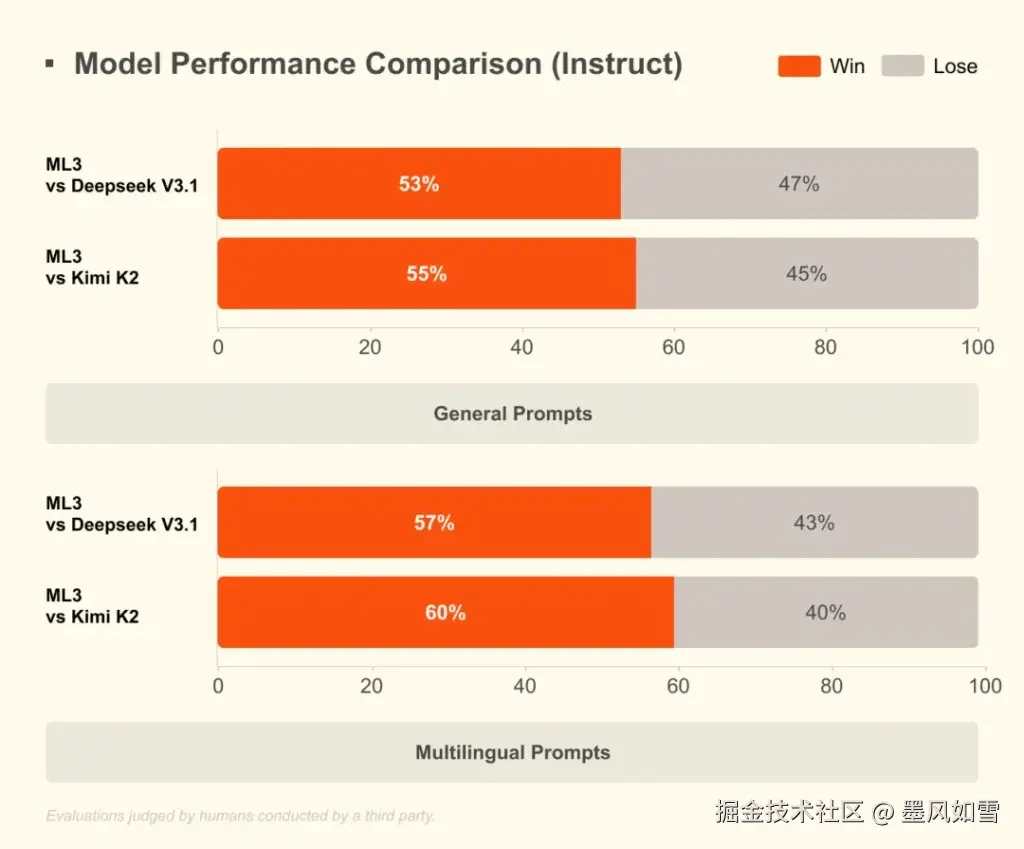

在 LMArena 的榜单上,它已经冲到了开源非推理模型的第二把交椅。这说明什么?说明开源和闭源的护城河,又被填平了一截。

把 AI 装进你的口袋:Ministral 的野心

如果说 Large 3 是为了秀肌肉,那么 Ministral 3 系列就是为了抢地盘。

这一次,Mistral 居然一口气发了 3B、8B 和 14B 三个尺寸的密集型模型。这显然是冲着"边缘智能"去的。

以前我们总觉得跑个大模型得有张 H100,现在 Mistral 告诉你:不用。你的笔记本电脑、甚至高端手机,就能跑得起来。特别是那个 3B 的版本,简直是为浏览器和 IoT 设备量身定做的。

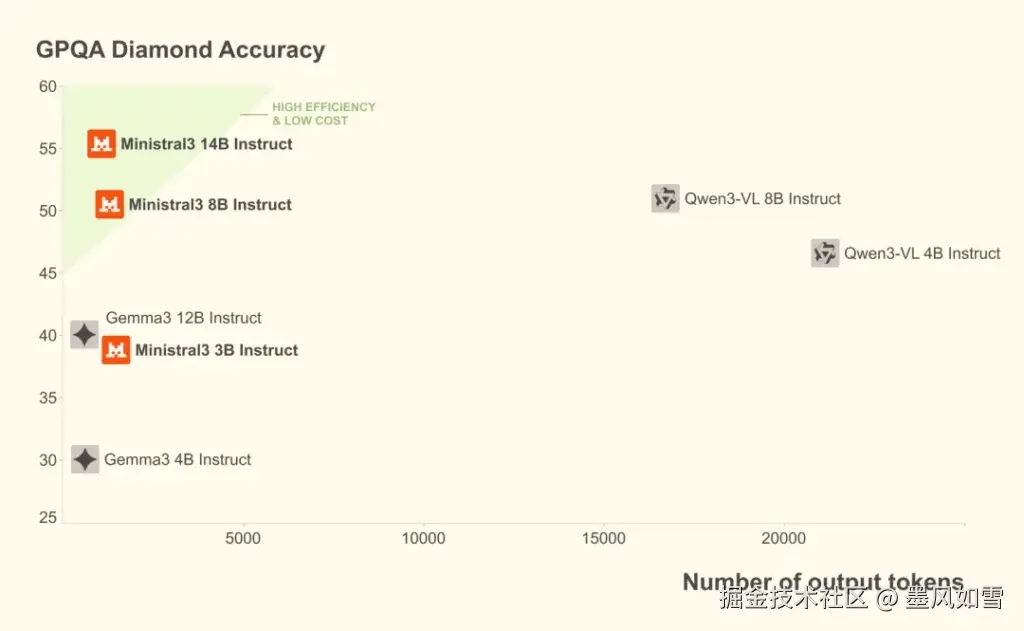

最关键的是,这些小模型并不"傻"。Mistral 给它们配备了 Base(基础)、Instruct(指令)和 Reasoning(推理)三种变体。在同等性能下,Ministral 生成 token 的数量比对手少了一个数量级。这不仅仅是快,更是省钱。对于那些想把 AI 能力集成到本地应用里的企业来说,这才是真正的杀手锏。

为什么要回归 Apache 2.0?

这次发布最耐人寻味的,其实是那个许可证。

在过去的一年里,很多所谓的"开源"模型其实都加了不少限制条款,变成了"开放权重"而非真正的开源。但 Mistral 这次彻底放开了。

这是一种极其聪明的战略博弈。面对 Google 和 OpenAI 这种构筑高墙的打法,Mistral 选择了发动群众。通过最宽松的 Apache 2.0 协议,它把全球的开发者都拉到了自己的阵营里。你用我的模型赚钱,我不在乎,我只在乎我的生态是不是遍布了从云端到手机的每一个角落。

加上英伟达在背后的全栈支持,从 H200 的训练算力到 TensorRT-LLM 的推理优化,这套组合拳打得非常流畅。

写在最后

Mistral 3 系列的出现,给 2025 年的 AI 结尾战定了一个调子:大模型不仅仅是云端神坛上的神像,它正在变成每个人手中的工具。

无论你是需要在服务器上处理海量多模态数据的企业 CTO,还是想在自己开发的 App 里塞进一个离线智能助手的独立开发者,Mistral 这次都给了你一个无法拒绝的理由。

目前模型已经在 Hugging Face 和各大云平台上线,本地跑个 Ollama 就能试用。建议你也去试试,感受一下这股来自欧洲的开源飓风。

如果你也对最新的AI信息感兴趣或者有疑问 都可以加入我的大家庭 第一时间分享最新AI资讯、工具、教程、文档 欢迎你的加入!!!😉😉😉

公众号:墨风如雪小站