一.研究背景与意义

1.1 冷启动问题简介

在推荐系统中,冷启动问题指的是系统无法为新加入的物品(cold-start items)提供有效推荐,因为这些物品没有任何历史交互记录。传统协同过滤(CF)方法依赖用户-物品交互数据来学习表示,因此无法处理冷启动物品。

1.2 现有方法的局限性

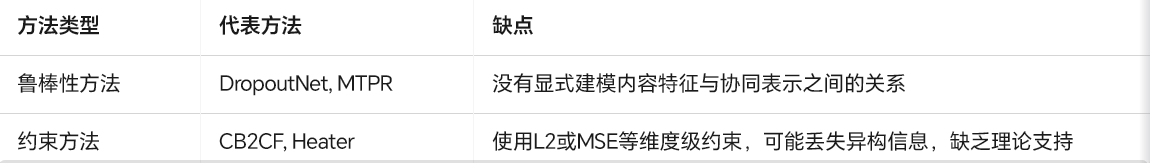

目前解决冷启动问题的主流方法是引入物品的内容特征(如图像、文本、音频等),并将其与协同信号结合。这些方法大致分为两类:

本文指出:现有方法未能充分挖掘内容特征与协同表示之间的互信息(Mutual Information),缺乏理论指导,导致冷启动推荐性能不佳。

二.研究目标与贡献

2.1 目标

从信息论角度重新建模冷启动物品表示学习,最大化内容特征与协同信号之间的互信息,从而提升冷启动推荐性能。

2.2 主要贡献

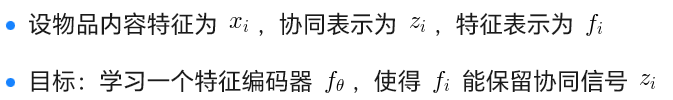

- 理论建模:提出冷启动表示学习的下界是两类互信息之和:

用户-物品协同表示之间的互信息(U-I MI)

物品特征表示与协同表示之间的互信息(R-E MI)

-

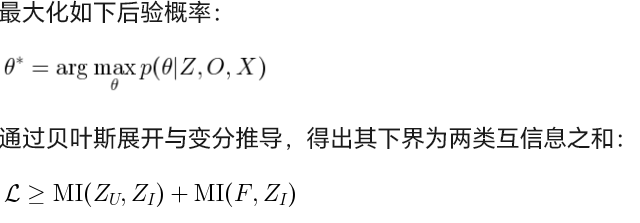

方法设计:提出基于对比学习(Contrastive Learning)的目标函数,最大化上述互信息。

-

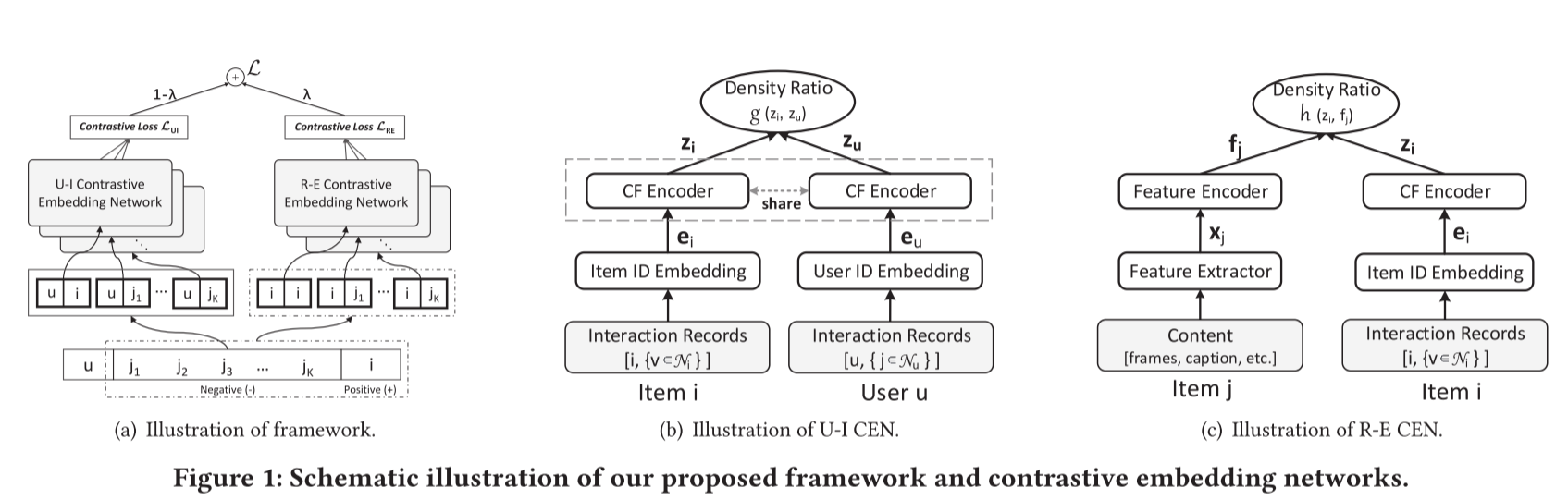

框架实现:设计通用框架 CLCRec,包含三个模块:

对比样本组织(Contrastive Pair Organization)

对比嵌入网络(Contrastive Embedding Network)

对比优化(Contrastive Optimization)

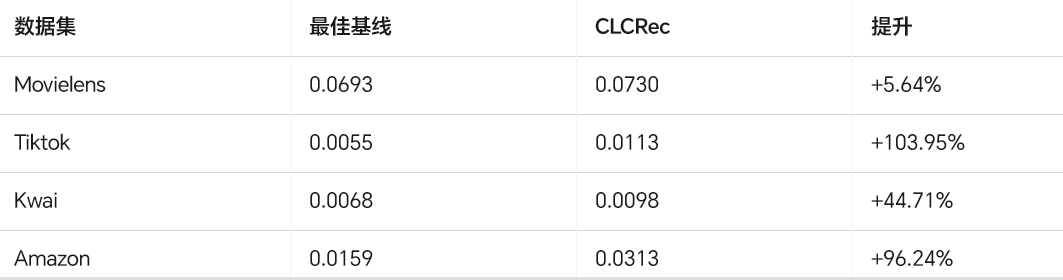

- 实验验证:在4个公开数据集上验证,在冷启动和正常场景下均显著优于SOTA方法。

三.核心思路与理论基础

3.1 问题建模与目标函数推导

3.1.1 冷启动表示学习建模

3.1.2 最大后验估计(MAP)

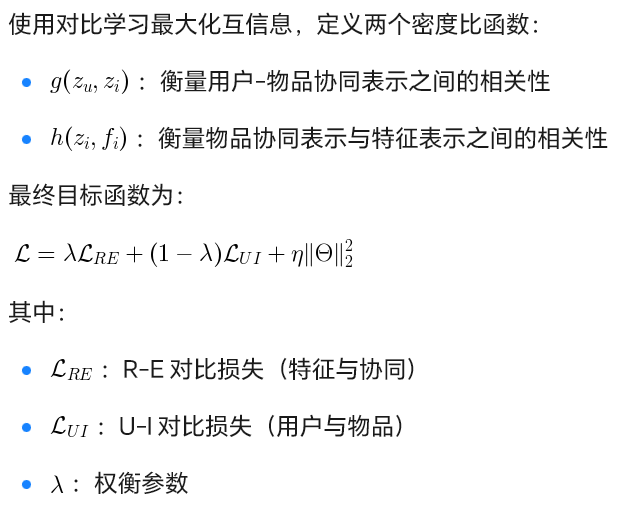

3.2 对比学习目标函数

3.3 CLCRec 框架结构

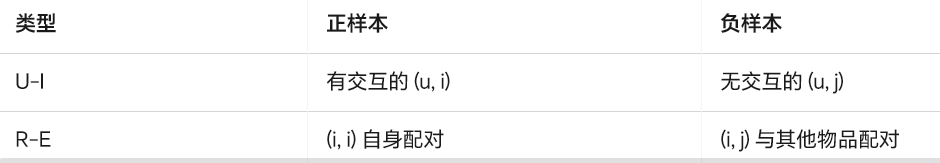

3.3.1 对比样本组织

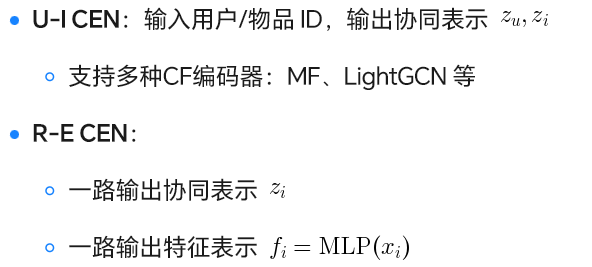

3.3.2 对比嵌入网络(CEN)

3.3.3 对比优化

1.使用多个负样本进行对比训练

2.支持混合训练策略(以概率 ρ 使用特征或协同表示)

3.最终用于预测用户对冷启动物品的偏好

四.实验与结果分析

4.1 数据集与设置

评估指标:Recall@10、NDCG@10

对比方法:DUIF、DropoutNet、MTPR、CB2CF、Heater、MF-BPR、LightGCN

4.2 实验结果

4.2.1 冷启动推荐性能(Recall@10)

4.2.2 与BPR模型对比(CENMF vs MF-BPR)

1.CENMF 在所有数据集上均显著优于 MF-BPR

2.冷启动场景下提升更明显(如 Amazon 上提升近 40 倍)

4.3 消融实验

4.3.1 U-I CEN 影响

1.多负样本采样(128)优于单负样本

2.混合训练策略(ρ=0.2)对冷启动有效

4.3.2 R-E CEN 影响

1.增加负样本数可提升性能,但超过 256 会过拟合

2.R-E 互信息对冷启动物品表示至关重要

4.3.3 λ 参数影响

1.λ 增加 → 冷启动性能提升,热启动略降

2.建议 λ 在 0.6~0.8 之间权衡

五.结论与未来工作

5.1 结论

1.首次从信息论角度建模冷启动表示学习,提出互信息最大化目标。

2.设计通用框架 CLCRec,结合对比学习有效融合内容与协同。

3.在多个数据集上取得SOTA性能,尤其在冷启动场景下提升显著。

5.2 未来工作

1.探索互信息在可解释推荐、解耦表示学习中的应用

2.将对比学习扩展至视频定位、时尚推荐等多模态任务