应用场景

LLM-as-a-Judge 并非局限于单一技术场景,而是横跨技术领域与专业行业的通用评估工具,其核心价值在于:以大语言模型的自然语言理解、知识整合能力,替代或辅助人类完成 "评估、判断、裁决" 类任务 ------ 既解决了传统人工评估效率低、成本高、主观性强的问题,也满足了不同领域对 "专业化、规模化评估" 的需求。

技术领域:机器学习(ML)相关评估

主要用于优化 AI 模型研发与任务效果验证,核心场景包括:

-

NLP 任务评估:直接评估文本生成、翻译、摘要、问答等 NLP 任务的输出质量(如判断生成文本的流畅度、准确性);

-

社交智能评估:衡量 AI 系统在社交互动中的表现(如对话的共情能力、礼仪合规性);

-

多模态评估:对文本、图像、音频等多模态内容的融合效果进行评估(如判断图文匹配度、语音转文本的准确性)。

NLP 任务评估

-

覆盖任务:情感分析、机器翻译、文本生成(对话、摘要、创意写作)、推理、信息检索(文档排序、RAG)等。

-

核心作用:

-

文本生成:评估安全性、准确性、上下文相关性,检测幻觉(通过证据匹配、批判式反馈)和有害内容,优化长文本与多模型对比评估;

-

推理:作为 "过程奖励模型(PRM)" 或法官角色,筛选有效推理路径(样本级 / 步骤级)、优化多智能体辩论结果、支持工具使用与复杂决策场景;

-

检索:提升文档排序精度(零样本 / 少样本场景),优化 RAG 系统的相关性与实用性评估,支持领域专用 RAG(如生物医学、阿尔茨海默病研究)。

-

-

挑战:需解决评估鲁棒性、幻觉敏感性、偏见控制,以及安全评估中的 "过度拒绝" 问题。

社交智能评估

-

评估目标:LLM 在社交场景中的语境解读、伦理文化适配、情感共情、谈判说服等人类特有能力。

-

关键方法:构建模拟社交环境(如 SOTOPIA),采用 "Agent-as-a-Judge" 框架,让 LLM 扮演有感知的评估者,对多智能体社交互动进行打分。

-

研究发现:GPT-4 等 LLM 的评估结果与人类评分相关性较高(r=0.83),但在社会推理能力上仍落后于人类,且存在随智能体匿名性增加的系统性偏见。

-

优化方向:结合人类在环校准、拓展跨文化 / 多语言场景评估。

多模态评估

-

评估对象:多模态大模型(MLLMs/LVLMs)的跨模态理解与生成能力(如图文匹配、视觉问答、自动驾驶场景视觉推理)。

-

核心挑战:模态对齐、语义一致性、异源信息整合,以及绝对评分和批量排序的一致性问题。

-

关键方法:

-

开发专用基准测试(含中英文场景);

-

采用 "评分 + 自然语言理由" 双输出模式提升评估透明度;

-

验证文本型 LLM 法官在视觉主导任务中的通用性(与人类评估相关性更高)。

-

-

未来方向:拓展至视频、视听融合、具身智能等动态 / 交互场景评估。

共性结论

-

LLM-as-a-Judge 在机器学习领域的核心优势是灵活性、规模化和人类对齐性,尤其适用于无单一 "正确答案" 的开放场景;

-

现存核心挑战包括评估偏见、鲁棒性不足、绝对评分一致性差,以及领域专用场景的知识适配问题;

-

未来优化需聚焦批判式反馈、元评估校准、跨场景 / 跨模态拓展,同时提升评估透明度与可解释性。

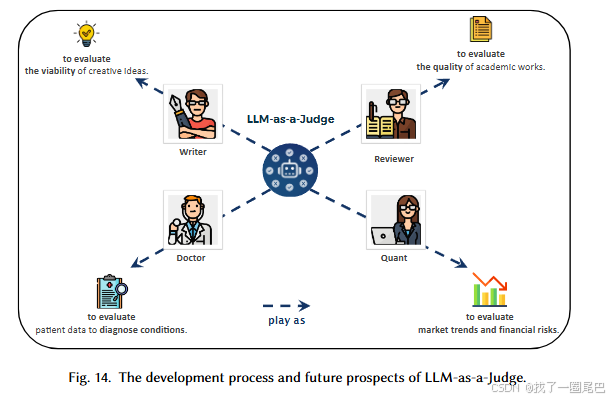

专业行业领域:替代 / 辅助人类专业判断

这类场景的核心需求是 "领域 expertise(专业知识)+ 严谨评估逻辑",LLM 凭借海量领域数据训练的知识储备,成为重要辅助工具,典型场景包括:

-

创意与学术:作家用其评估创意想法的可行性、原创性(分析叙事结构、市场趋势);研究者用其评审学术作品质量;

-

医疗健康:医生借助其分析患者病历、影像数据,辅助疾病诊断与预后预测;

-

金融:量化分析师用其识别金融数据中的规律,预测市场走势、评估投资风险;

-

法律:法官利用其解读法律条文、过往判例,辅助案件裁决;

-

科学发现(Ai4Sci):在科研领域提供评估支持(如实验方案可行性、论文结论合理性验证)。

金融领域

金融领域对评估的 "严谨性、高可靠性、透明度" 需求极高(涉高风险决策),LLM-as-a-Judge 作为适配金融场景的专用评估工具,主要用于辅助定性分析与决策优化,目前处于早期发展阶段,核心价值是整合领域知识、标准化评估流程。

三大核心应用方向及研究进展

1. 融合领域专业知识的评估器设计

-

核心目标:让 LLM 法官具备金融专业认知,提升评估准确性;

-

关键方法:通过多任务微调优化金融评估性能、构建多智能体系统(如 FinCon),利用 LLM 评估器的概念性语言强化反馈支持金融决策。

2. 金融专用基准测试与评估框架构建

-

核心目标:提供标准化的金融场景评估依据;

-

代表性成果:UCFE(基于用户反馈的金融评估基准)、IndoCareer(专业金融考试题库数据集)、AI 生成的领域专用评估集(用于测试金融知识理解与推理能力)。

3. 特定金融场景的定向应用

-

量化投资策略:代表框架为 QuantAgent,通过 "双 LLM 迭代循环" 优化交易信号 ------ 一个 LLM 生成初始交易思路,另一个 LLM 基于信息系数(IC)、夏普比率等量化指标进行评估与迭代改进;

-

其他场景:在信用评分、ESG(环境、社会、治理)评分中已展现潜力,可辅助完成定性分析类评估任务。

现存局限与挑战

-

准确性与一致性不足:面对复杂金融法规、动态变化的市场数据时,难以保证事实准确性和判断一致性;

-

量化能力薄弱:仅擅长金融新闻 / 报告解读等定性分析,无法自主完成投资组合优化、高频交易等定量任务;

-

角色定位受限:当前以辅助功能为主,无法独立承担核心金融决策任务。

科学领域

科学领域(尤其医学、数学)对评估的 "准确性、一致性、科学性" 要求极高(涉高风险决策与学术严谨性),LLM-as-a-Judge 作为专用评估范式,主要用于验证推理逻辑、提升结果可靠性,目前发展迅速,核心价值是标准化科学场景评估流程、辅助高 stakes 决策。

三大核心应用方向及研究进展

1. 高险临床推理专用评估器风

-

核心目标:验证临床相关输出的一致性、正确性与安全性;

-

关键成果:LLaMA-2 评估器在临床笔记内部一致性检查中达到人类级一致性(Cohen's κ=0.79);开源大模型评估医疗问答时,在正确性、实用性、无害性等维度与医生评分相关性良好;已发布首个长文本医疗问答公开基准。

2. 数学领域的分步推理验证

-

核心目标:解决数学推理的逻辑严谨性问题,而非仅关注最终答案;

-

关键方法:

-

构建过程奖励模型(如 Math-Shepherd),无需人工标注即可验证每一步推理,显著提升模型解题准确率(Mistral-7B 在 GSM8K 达 84.1%);

-

提出难度感知的拒绝调优 pipeline(DART-Math),聚焦难题训练,刷新多项数学基准;

-

开发多模态数学评估基准(MathVista),暴露模型在图表类推理中的短板。

-

3. 规模化科学评估基准框架构建

-

核心目标:提供全面、标准化的科学 LLM 评估依据;

-

代表性成果:

-

医学领域:MedHELM 覆盖 11 类临床任务,揭示顶级商业模型在用药安全问题上的不足;Nature Medicine 倡导 "医生在环" 的总结评估流程;

-

数学领域:逻辑一致性评估器(Xia et al.)可对完整证明轨迹评分,提供更丰富的诊断信息。

-

现存局限与未来方向

核心局限

-

医学场景:依赖考试类 / 短文本输出,难以应对真实临床复杂性,幻觉检测仍是关键难题;

-

数学场景:在开放式、多模态问题上鲁棒性不足,分步验证的计算成本较高;

-

共性问题:多模态理解能力薄弱,复杂场景下的验证效率与准确性难以平衡。

未来优化方向

-

技术融合:将 LLM 评估器与符号求解器、医学知识库结合,强化事实核查;

-

能力升级:引入不确定性估计(如校准后的拒绝机制),设计支持图表、表格解读的多模态评估器;

-

生态建设:构建公开、多样化的科学评估基准,透明化报告失败案例,提升部署可信度。

其他多元领域

LLM-as-a-Judge 在多元领域的核心价值是 提升评估效率、保证判断一致性,尤其擅长传统量化方法难以覆盖的 "定性评估" 任务(如主观偏好、创意内容评估),同时可替代易疲劳的人工评估,提供规模化解决方案,但需结合领域特性进行适配。

典型应用场景及关键进展

| 应用领域 | 核心评估任务 | 关键成果与优势 | 现存挑战 |

|---|---|---|---|

| 软件工程 | 缺陷报告摘要的正确性、完整性评估 | 评估准确性高,甚至超越易疲劳的人类评估者,具备规模化潜力 | - |

| 教育 | 作文自动评分与修改 | 开源 LLM 性能比肩传统深度学习模型;通过少样本学习、提示词微调提升评分准确性,修改不破坏原文核心意思 | - |

| 内容审核 | 平台(如 Reddit)违规规则识别 | 真阴性率高(减少误判合规内容) | 复杂规则解读能力不足,需人类监督细微案例 |

| 行为科学 | 基于用户画像的偏好评估 | 加入语言化不确定性估计后,高确定性案例与人类评估一致性高 | 简化画像导致评估可靠性、一致性不足 |

| 其他定性场景 | 服务质量评估、用户体验反馈分析、艺术 / 文学评论等创意内容评估 | 擅长捕捉语言 nuances,适配传统量化方法难以覆盖的主观评估任务 | - |

核心优势

-

适配性强:覆盖技术、教育、社交等多元场景,尤其擅长主观定性评估;

-

效率与规模化:突破人工评估的疲劳限制,实现批量、快速评估;

-

灵活性:通过提示词优化、少样本学习等方法,可快速适配不同领域的评估需求。

核心挑战

-

场景特异性不一致:不同领域对规则解读、主观偏好的要求不同,LLM 易出现判断偏差;

-

复杂场景依赖人工:面对复杂规则、细微案例时,仍需人类监督补位;

-

基础条件限制:如行为科学中 "简化画像" 会直接影响评估可靠性,需依赖高质量输入数据。

未来方向

-

深耕定性评估领域:聚焦服务质量、用户体验、创意内容等传统方法难以覆盖的任务,提升评估准确性;

-

强化领域适配:针对不同领域的规则特性、评估标准,优化提示词设计或模型微调策略。

六大核心挑战

1. 可靠性(Reliability):评估一致性与公平性的核心障碍

可靠性直接决定评估结果的可信度,问题源于模型的概率性本质与输入敏感性,具体表现为三方面:

- 上下文学习敏感性:提示词措辞微调、示例顺序变化(如位置偏见,模型倾向偏好列表首尾响应),会导致评估结果不稳定;且模型生成的随机性会引发 "评分不一致",同一输入可能得到不同分数。

- 过度自信与自我增强偏见:经 RLHF(基于人类反馈的强化学习)训练的模型,易对自身生成的响应打高分,即便响应质量与其他模型相当,形成 "自我偏袒",误导评估结论。

- 模型选择与泛化能力弱:商业模型(如 GPT-4)的 "黑箱特性" 与版本依赖,导致评估结果难以复现;微调后的评估模型易过拟合,仅在训练数据内有效,跨场景泛化能力差,还可能继承训练数据中的隐性偏见。

2. 鲁棒性(Robustness):抗攻击与抗干扰能力不足

鲁棒性指模型抵御恶意攻击与异常输入的能力,当前 LLM-as-a-Judge 在该领域研究较薄弱,主要风险包括:

- 对抗性攻击:攻击者通过 "隐性篡改输入"(如 paraphrase 关键句、添加语法正确但误导性的短语),操纵评估结果 ------ 篡改内容对人类无害,却会导致 LLM 判断大幅偏差。

- 输入敏感性与越狱攻击:模型易被 "越狱提示词" 绕过安全过滤,如被引导扮演带偏见的 "角色",输出偏向性评估;开源模型因安全微调不足,该问题更突出。

- 评分机制脆弱性:依赖特定评分格式(如 1-5 分制)时,攻击者可设计输入使模型输出文本而非数字,破坏自动化评分流程,导致评估系统瘫痪。

3. 骨干模型局限性(Limitations of Backbone Models):评估能力的基础瓶颈

LLM-as-a-Judge 的效果完全依赖底层骨干模型的能力,当前模型存在两大核心短板:

- 多模态理解薄弱:虽文本评估能力较强,但处理 "文本 + 其他模态"(如医学场景的症状文本 + X 光影像)时,难以整合跨模态信息,易遗漏关键矛盾点(如文本与影像诊断不一致),导致评估错误。

- 抽象与因果推理不足:即便纯文本任务,模型对 "逻辑一致性、因果关系" 的深度理解欠缺 ------ 如评估科学论文或法律论证时,可能因文本流畅度高而打高分,却忽略逻辑链中的根本性缺陷。

4. 判断的可解释性与透明度(Interpretability and Transparency):"黑箱评估" 削弱信任

LLM-as-a-Judge 的评估过程缺乏透明度,成为高风险领域(医疗、法律、教育)应用的关键障碍:

- 模型可输出合理评分或结论,但无法解释 "判断依据"------ 如法律场景中,无法说明参考了哪些判例、优先依据哪些法条;而人类专家能提供可追溯的推理逻辑,这种 "黑箱特性" 严重降低用户信任。

5. 元评估与时间一致性(Meta-Evaluation and Temporal Consistency):缺乏自我验证与稳定性

当前研究聚焦 "LLM 评估任务结果",却忽视 "评估 LLM 自身",同时存在时间维度的稳定性问题:

- 元评估缺失:缺乏严谨基准测试来衡量 LLM-as-a-Judge 的准确性、稳定性与偏见,无法验证 "评估者是否可靠",形成研究空白。

- 时间漂移:模型判断随时间变化(如版本更新、安全微调),导致同一输入在不同时间得到不同评估(如 3 月判定可接受的争议内容,6 月因安全优化被处罚),破坏长期评估标准的一致性,影响公平性。

6. 伦理与社会影响(Ethical and Social Implications):技术应用的隐性风险

除技术问题外,LLM-as-a-Judge 还引发多方面伦理社会问题,需重点关注:

- 偏见放大:模型训练数据含有的性别、种族等社会偏见,会通过评估过程放大 ------ 如对非标准英语方言、边缘群体写作风格的响应不公平扣分,在招聘、内容审核等场景引发歧视。

- 责任与透明度缺失: proprietary(专有)模型的黑箱特性,导致评估错误时无法追溯根源、明确责任,违背高风险领域对 "可追责性" 的需求。

- 抑制创意多样性:模型若长期偏好特定风格、格式的内容(如标准化写作),会引发 "评估驱动趋同",导致创作者为迎合评分而放弃多元表达,削弱信息生态的丰富性与创新性。

未来研究方向

一、以推理为核心的判断能力提升

该方向聚焦将 LLM-as-a-Judge 从传统评估方法转向 "推理驱动" 模式,通过强化推理与判断的协同作用,实现系统自我进化,包含三方面关键内容:

-

推理与判断的协同增效:推理是基于证据推导结论的逻辑过程,判断是依据标准评估事物质量的行为,二者存在共生关系。在 LLM 场景中,判断可验证推理的中间步骤是否合理,推理则为判断提供逻辑框架支撑。当 LLM 高频次评估自身思考过程(如每一步推理)时,判断能力会逐步接近推理能力,使 LLM-as-a-Judge 不仅是评估工具,更成为增强模型推理能力的核心机制。

-

反馈循环与自我改进:将 LLM-as-a-Judge 融入动态反馈循环是实现持续自我改进的关键。该机制分两种模式:训练时,通过 RLHF 等方式将 LLM-as-a-Judge 的反馈整合到学习目标中,帮助模型内化优质推理策略;推理时,实时评估模型推理过程,支持动态纠错与输出优化,无需额外训练。例如 OpenAI 的 o1 模型、DeepSeek-R1 模型均通过此类反馈机制提升问题解决能力,契合宪法 AI(Constitutional AI)的自我批判与修正框架。

-

自进化评估者:长期目标是赋予 LLM-as-a-Judge 自我校准与自我修正能力。评估者可根据外部反馈持续调整偏差,进化为更可靠的 "评估智能体",并结合 "世界模型"(World Model),通过模拟解决方案在假设环境中的后果提前识别缺陷,从静态工具转变为动态进化的智能系统,推动 AI 向更自主、更可信方向发展。

二、构建理论支撑的评估体系

当前 LLM-as-a-Judge 的可靠性研究多依赖实证基准,缺乏坚实理论基础,该方向旨在填补这一空白:

未来需借鉴统计学、测量理论等领域的思想,建立更正式的评估理论框架。例如引入 Cohen's Kappa、Krippendorff's Alpha 等成熟指标量化不同 LLM 评估者的评分一致性,对 "一致性""鲁棒性" 等核心概念进行形式化定义,推动领域从 "试错式" 研究转向 "科学驱动" 研究,确保评估结果可验证、可复现。

三、提升 LLM-as-a-Judge 的可靠性

针对 LLM 作为概率模型在可靠性上的不足,该方向从全评估流程优化入手:

-

重点改进上下文学习、模型选择、后处理技术及整体评估框架,提升评估的适应性与鲁棒性;

-

开发系统方法评估并验证评估结果的鲁棒性,建立全面的评估基准与可解释分析工具;

-

针对鲁棒性风险,制定主动缓解策略,如设计面向判断任务的对抗训练技术、整合鲁棒的不确定性量化方法、部署人类在环系统监督关键决策,确保系统在对抗环境下仍能保持高可靠性。

四、发展多模态 LLM 评估者(MLLM-as-a-Judge)

随着 AI 系统向多模态统一架构演进(如 GPT-4o、Gemini、LLaVA),MLLM-as-a-Judge 成为重要研究方向:

-

当前 MLLM-as-a-Judge 主要用于模型评估,未来需拓展至数据评估、智能体评估等场景,承担数据标注、奖励模型、推理过程验证等角色;

-

核心目标是提升多模态评估者的推理深度与可靠性,解决当前多模态 LLM 在跨模态内容(文本、音频、图像、视频)评估中推理能力薄弱的问题,推动其在多模态内容审核、自动化知识提取等领域的应用。

五、完善评估基准体系

评估基准是推动 LLM-as-a-Judge 发展的关键,需从 "评估评估者" 与 "拓展评估范围" 两方面发力:

-

元评估框架构建:开发专门测试 LLM 评估者可靠性、公平性、一致性的元评估基准,例如包含具有对抗性特征的提示集(如细微词语替换、改写)测试鲁棒性,跟踪评估结果随时间与模型版本的变化(缓解 "评估漂移"),且基准需具备模型无关性,支持解释评估者行为,提升透明度与信任度;

-

基准范围拓展:构建高质量、大规模、多样化的基准数据集,覆盖领域专用场景(如法律论证逻辑评估)、多模态场景(如图文一致性判断),引入细粒度评估指标,打造类似 ImageNet 级别的影响力基准,深化对模型性能的理解,加速评估方法发展。

六、LLM-as-a-Judge 用于数据标注

数据标注面临复杂性高、主观性强、成本高的挑战,LLM-as-a-Judge 为解决这些问题提供新路径:

-

利用 LLM(如 GPT-4、Gemini、LLaMA-2)的语义理解能力,自动化标注任务,确保大规模数据标注的一致性,并通过微调或提示优化适配特定领域;

-

应用场景包括:在数据不足时扩展数据集,在数据质量低时评估并标记数据质量以筛选高质量数据;

-

当前局限是无法完全依赖 LLM 进行所有场景的可靠标注,仍需人类标注保障专业性,且 LLM 标注常需借鉴人类标注经验,未来需提升其自主标注能力。

七、LLM-as-a-Judge 用于 AI 规模化发展

LLM-as-a-Judge 是推动 AI 规模化开发的核心机制,主要通过三方面实现:

-

规模化数据标注:替代成本高、速度慢的人工标注,生成大规模高质量数据集(如为 RLHF 生成偏好标签),或采用 "LLM 初步标注 + 人类快速验证" 的半自动化流程提升效率;

-

规模化模型优化:作为自动化评论者或奖励模型,在多智能体系统中实时评估智能体协作质量,在优化流水线中提供动态反馈,指导模型微调与推理链优化,替代传统固定指标;

-

核心价值是突破人工资源限制,支撑大规模、高迭代速度的 AI 开发流程。

八、LLM-as-a-Judge 用于具身智能

将 LLM-as-a-Judge 的应用从数字输出(文本、图像)拓展至具身智能领域,是全新且复杂的方向:

-

评估目标是具身智能体(如机器人)在物理或模拟环境中的行为,需评估动作序列、时空关系及与目标的 alignment,依赖对物理规律与因果关系的深度理解;

-

应用示例包括:评估机器人做饭任务(动作效率、安全性、逻辑性)、评估虚拟环境中智能体的策略能力与导航能力;

-

核心作用是提供高维度自然语言反馈,替代简单标量奖励信号,加速具身智能体的学习,推动其向更通用、更贴合人类需求的方向发展。

九、LLM-as-a-Judge 用于 LLM 优化

LLM-as-a-Judge 在 LLM 优化中展现出巨大潜力,未来需进一步深化应用:

-

当前进展包括:融入多智能体框架指导智能体交互以提升决策质量,在强化微调(ReFT)流水线中作为评分模块评估模型推理过程;

-

未来方向:拓展应用领域至复杂多模态场景,系统评估其可靠性与泛化能力,充分释放其在提升模型性能与鲁棒性上的价值。

十、领域专用可靠应用开发

不同领域对评估可靠性的需求差异显著,需开发定制化 LLM-as-a-Judge 系统:

-

针对医疗诊断、法律裁决、教育评估、科学同行评审等场景,设计专用评估标准、偏差控制机制与社会责任框架,而非仅调整提示或微调策略;

-

示例:法律领域评估者需严格遵循法律判例与法规,确保判断可辩护、可审计;医疗领域评估者需准确理解临床指南与医学术语,经严格测试后应用;

-

核心目标是通过定制化设计满足领域独特需求,获得领域专家信任,推动 LLM-as-a-Judge 在高风险、高严谨性领域的落地。

总结

LLM-as-a-Judge 的核心价值与优势

LLM-as-a-Judge 作为自动化评估的创新范式,显著超越传统 "专家驱动" 或 "指标驱动" 方法,核心价值体现在三方面:

-

效率与规模化突出:凭借大语言模型的推理能力,可高效完成文本质量评估、模型性能评价、自动化数据标注等任务,尤其适配大规模、高灵活性的评估需求;

-

适配性广泛:能处理多样内容格式,整合领域专用知识,在教育(如作文评分)、同行评审(如学术论文评估)、决策系统(如医疗 / 法律辅助判断)等场景中具备独特应用价值;

-

功能全面:覆盖从基础文本评估到复杂领域决策辅助的多类任务,填补传统评估方法在 "主观定性评估""动态场景适配" 上的短板。

需突破的核心挑战

尽管优势显著,LLM-as-a-Judge 要实现全部潜力仍需解决三大关键挑战:

-

可靠性不足:作为概率模型,输出存在 "不一致性"(同一输入不同评分)、"过度自信"(对错误结论仍给出高置信度),且会继承训练数据中的偏见;虽 RLHF 等技术提升了与人类判断的对齐度,但无法完全消除主观性;

-

鲁棒性薄弱:易受对抗性攻击(如恶意设计提示词操纵评估结果)和上下文框架偏见影响,可能产生非预期、不可靠的评估结论;

-

泛化能力有限:跨领域、跨模态适配困难 ------ 当前模型难以有效评估多模态输入(如图文结合内容)、结构化数据推理,且难以快速适配不同领域的专属评估标准(如法律判例规则、医疗临床指南)。

论文提出的系统性解决方案 roadmap

针对上述挑战,论文从 "概念定义、框架整合、实证支撑、视角统筹" 四层提供全面解决方案:

-

概念定义层:明确 LLM-as-a-Judge 的正式 / 非正式定义,划定范式边界;创新性提出 "上下文感知的可靠性定义",将输入变异性、模型特性、上下文依赖纳入考量,为设计可信系统奠定基础;

-

框架整合层:针对现有研究碎片化问题,以四大核心问题(What is it? How to use it? How to improve it? How to evaluate it?)为脉络整合文献,既统一研究体系,又识别出关键研究空白与探索方向;

-

实证支撑层:对现有方法进行对比分析,更关键的是提出 "面向评估者自身的元评估基准",可系统性衡量 LLM-as-a-Judge 的性能,揭示 "鲁棒性与敏感性" 等关键权衡关系,为构建严谨、可落地的评估框架提供可操作思路;

-

视角统筹层:综合分析该范式的应用场景、挑战与未来方向,明确其在金融、法律等高风险领域的应用路径 ------ 通过识别各领域独特的可靠性需求,推动技术适配;同时提出前瞻性发展议程,强调 "理论支撑的方法论""元评估系统基准""人机混合框架",助力构建 "技术稳健、认知合理、社会可信、跨关键领域适用" 的 LLM-as-a-Judge 系统。