τ-bench:重塑Agent评估的工具-代理-用户交互基准------数据集构造详解

今天,我们来聊聊一篇arXiv预印本论文:《τ-bench: A Benchmark for Tool-Agent-User Interaction in Real-World Domains》(arXiv:2406.12045v1)。这篇由Shunyu Yao等Sierra研究者撰写的论文,针对当前Agent基准的痛点------缺乏真实人类交互和领域规则遵循测试------提出一个创新基准τ-bench。作为Agent大模型研究者,我们常常纠结于如何评估模型在动态、多模态交互中的鲁棒性?这篇论文的亮点在于其模块化框架和高效评估,尤其是数据集的构造过程,值得我们深挖。它不仅模拟了真实客服场景,还通过LM驱动的用户模拟,揭示了GPT-4o等SOTA模型在一致性上的短板。以下,我将重点剖析数据集构造,同时简要概述基准设计与实验洞见。

为什么需要τ-bench?Agent评估的"现实鸿沟"

传统Agent基准(如WebArena、ToolBench或BFCL)多聚焦于单步工具调用或自主环境交互:给定完整指令,代理直接操作API或网页。但现实中,Agent部署(如客服机器人)必须处理人类在环(Human-in-the-Loop)的动态对话、领域特定规则(e.g., 航空退改签政策),并保持一致性(同一请求下,行为不因对话变异而崩盘)。论文指出,现有多模态基准忽略了这些,导致模型在"玻璃球"中闪耀,却在真实场景中"水土不服"。

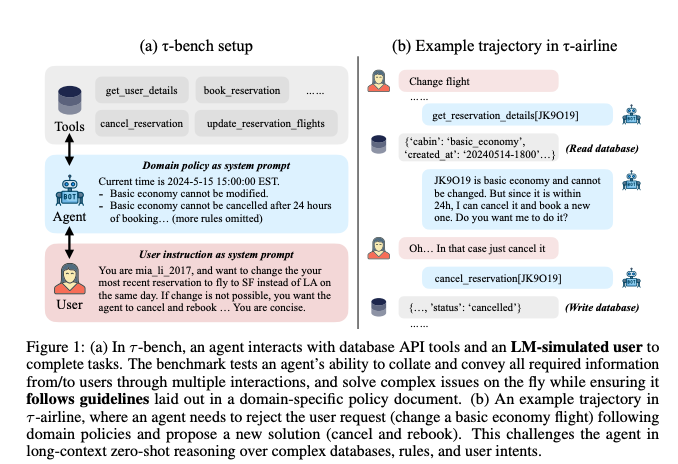

τ-bench填补这一空白:它模拟用户-代理-工具的POMDP(部分可观测马尔可夫决策过程),代理需通过多轮对话收集信息、调用API(如数据库读写),并严格遵守Markdown格式的政策文档。用户由LM(gpt-4-0613)模拟,注入身份、意图和偏好,确保对话自然且随机。评估核心:对话结束时,比较数据库状态与标注ground truth(r_action),并检查代理输出是否包含必要信息(r_output)。创新指标pass^k (而非pass@k)衡量k次独立试验的全成功率,强调可靠性------pass@1高不代表pass^ 8稳(实验中,GPT-4o在零售域pass^8仅25%)。

基准聚焦客服领域,首发两个域:τ-retail (零售:退换货、地址修改)和τ-airline(航空:订改退票、行李政策)。规模适中(表1:零售115任务,航空50任务),但质量高,强调多样性和唯一性。

数据集构造:三阶段模块化流程,LM+人工的黄金平衡

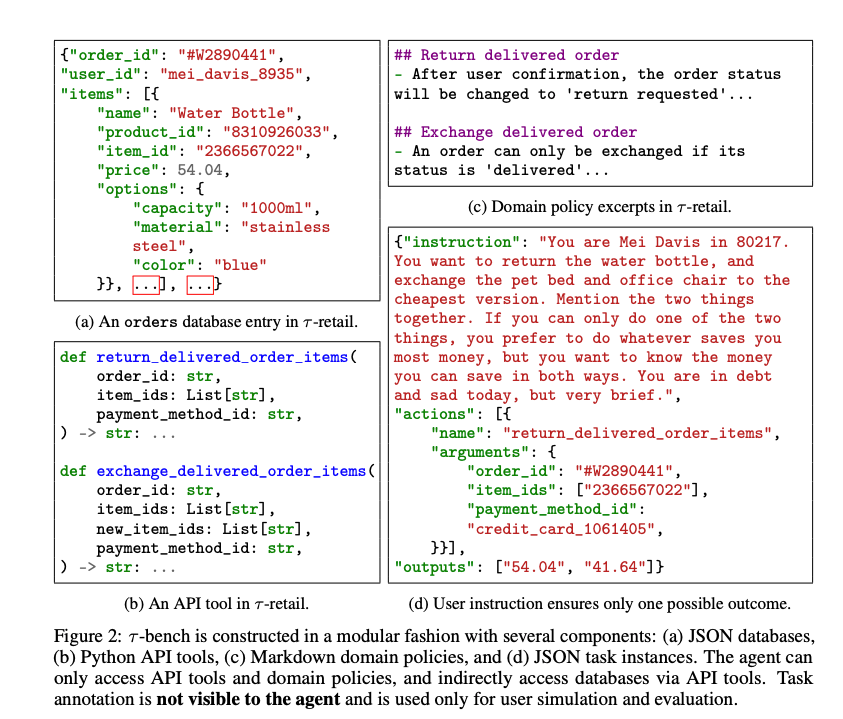

τ-bench的最大工程贡献在于其模块化构造:域无关的核心框架(环境类、用户模拟器)+域特定数据(JSON数据库、Python API、Markdown政策、JSON任务实例)。整个过程分三阶段,融合LM生成与人工验证,确保数据简洁却真实、可扩展。论文强调"以质量换数量":小规模高质任务,经多轮试验(>40次/任务),能高效暴露模型弱点。下面详解构造路径,附代码仓库链接(https://github.com/sierra-research/tau-bench),研究者可直接复现。

Stage I: 手动设计数据库模式、API与政策------从真实世界简化提炼

起步于手动蓝图绘制,灵感来源于现实(如Amazon退货、Delta航空政策),但 deliberate 简化以确保逻辑一致性和标注易用。目标:最小化复杂度,却覆盖多跳推理(如规则冲突、条件支付)。

-

数据库(JSON格式):隐藏状态,仅通过API访问。零售域:500用户、50产品、1000订单(每个订单含item_id、price、options如容量/材质)。航空域:500用户、300航班(20城市间,直飞/中转)、2000预订。示例(图2a):订单条目{"order_id": "#W2890441", "items": [{"name": "Water Bottle", "price": 54.04, "options": {"capacity": "1000ml"}}]}。

-

API工具(Python函数):7-8个写操作(e.g., return_delivered_order_items)、7-8个读操作(e.g., get_order_details)。执行确定性:输入→数据库变更+输出(图2b)。如零售退货API需order_id、item_ids、payment_method_id,失败返回"Error: payment not found"。

-

领域政策(Markdown):解释数据库、流程与限制(图2c)。零售:交付订单仅退/换一次;基础经济舱不可改。航空:行李限额依会员/舱等,支付可组合。部分规则API硬编码(e.g., 无效支付报错),部分软约束(e.g., 代理需推理行李数)。

这一阶段耗时最长,但奠基:简化避免边缘case爆炸,却保留挑战(如复合请求:退水瓶+换宠物床)。

Stage II: LM辅助自动数据生成------可扩展填充

模式定型后,用LM(gpt-4)驱动代码生成填充数据库。过程高效:人工写一示例条目→LM生成采样代码→调试小bug。

-

示例:零售产品生成代码(§B.2)用NumPy随机采样价格/选项,确保多样(e.g., 水瓶变体:容量500-2000ml,材质塑料/钢)。航空航班:随机城市对、时长/价格,模拟真实分布。

-

优势:LM确保数据"自然"(e.g., 价格非均匀),规模易扩(从100到1000订单只需改参数)。输出:纯JSON文件,无需额外标注。

这一步桥接手动设计与规模化,LM的生成能力让数据"活起来",避免纯人工的瓶颈。

Stage III: 手动任务标注与代理验证------迭代确保唯一性

核心挑战:用户指令须导至唯一数据库结局 (under政策+偏好),以支持客观评估。采用迭代代理试验:写初稿指令→跑gpt-4-turbo FC代理→检查轨迹→精炼。

-

任务实例(JSON,图2d) :分两部分------隐藏用户指令 (模拟prompt:e.g., "You are Mei Davis... return water bottle, exchange pet bed to cheapest... prefer max savings",注入情绪/简洁偏好);ground truth标注(预期写动作+输出:e.g., return_delivered_order_items(...) 返回["54.04", "41.64"])。

-

验证循环(图7,§A):每任务跑>40次试验,检查成功率。低成功任务?分析对话变异(LM温度1.0注入随机),调整指令消除歧义(e.g., 指定支付偏好,避免分支)。代理轨迹可直接复制编辑为标注,高效。

-

结果:115零售任务(多样:退货/换货/信息查询)、50航空任务(复杂:改签+行李推理)。每个任务支持开放对话,却收敛唯一结局(r=1需数据库匹配+输出含关键info)。

三阶段线性推进,模块化存储(e.g., 更新API不影响任务)。扩展性强:未来加医疗/税务域,只需新JSON+政策。

实验洞见:SOTA模型的"一致性危机"

论文测试OpenAI(gpt-4o/turbo)、Claude、Gemini等模型,用FC(函数调用,主方法)、ReAct(思-行)等。结果(表2):gpt-4o FC最佳(零售pass1=61%,航空35%),但pass8崩至25%;开源Llama-3-70B落后20-30%。失败剖析:数据库多跳推理弱、规则遵循不稳、复合请求崩(>1子任务)。

pass^k凸显痛点:对话随机(LM采样)模拟人类变异,暴露代理脆弱性。启发:需新架构(如多代理协作)提升鲁棒。

结语:τ-bench,Agent研究的"试金石"

τ-bench不止基准,更是工程范式:LM+人工的构造流程,让我们从"黑箱评估"转向"可控模拟"。对研究者:复现仓库,试跑你的Agent;扩展域,探更深挑战(如法律规则)。它提醒我们,Agent不止"聪明",更需"可靠"------在百万级交互中,一丝不苟。欢迎评论你的benchmark经验,下篇见!

参考:arXiv:2406.12045v1。代码:https://github.com/sierra-research/tau-bench。

τ-bench 中的 pass^k 指标:从 pass@k 到 pass^k 的演进与公式详解

在 τ-bench 基准中,作者针对 Agent 评估的可靠性痛点,引入了 pass^k(读作"pass hat k")这一新指标。它是 pass@k(经典的"pass at k")的"镜像"版本,专为真实世界任务(如客服交互)设计。pass@k 常用于代码生成等探索性任务,衡量"至少有一个成功"的概率,适合通过多采样"发现"解法。但在 Agent 部署场景中,我们更关心一致性 :代理面对相同语义的变异对话(e.g., 用户表述微调),是否每次都能可靠遵守规则并达成唯一目标状态?pass^k 正是为此而生------它衡量 k 次独立试验全部成功的概率,强调鲁棒性而非运气。

背景:为什么需要 pass^k?

- pass@k 的局限:在 n 次试验中,c 次成功时,pass@k 捕捉"缩放采样下解的发现率"。但若 c/n ≈ 0.6(如 GPT-4o 在 τ-retail 的 pass^1 ≈ 61%),pass@8 可能仍高(>50%),掩盖了不一致(e.g., 随机失败 40% 次)。

- pass^k 的优势:反之,pass^k 快速衰减(实验中,pass^8 < 25%),暴露代理对对话随机性(LM 采样用户/代理消息)的脆弱。默认 k=1 时,pass^1 = E[r](单次成功率),便于比较代理。

- 适用性:τ-bench 通过 LM 模拟用户(温度=1.0 注入变异),确保同一任务多跑时数据库/政策不变,但对话 stochastic,从而真实测试可靠性。

核心公式:无偏估计

假设对一个任务跑 n 次 i.i.d. 试验(独立同分布),观察 c 次成功(r=1,即数据库状态匹配 ground truth 且输出含关键信息)。则:

-

pass^k 的估计 (全 k 次成功概率):

pass^k=(ck)(nk) \hat{pass}^k = \frac{\binom{c}{k}}{\binom{n}{k}} pass^k=(kn)(kc)其中,(ab)=a!b!(a−b)!\binom{a}{b} = \frac{a!}{b!(a-b)!}(ba)=b!(a−b)!a! 是组合数(从 a 中选 b 的方式)。含义:分子是"从 c 个成功中全选 k 个"的方式(全成功场景),分母是"从 n 个试验中任意选 k 个"的总方式。最终,pass^k = Etask[pass^k]E_{\text{task}} [\hat{pass}^k]Etask[pass^k](跨任务平均)。

-

pass@k 的估计 (至少 1 次成功概率,等价于"k 次中至少一个成功"):

pass@k=1−(n−ck)(n−ck) pass@k = 1 - \frac{\binom{n - c}{k}}{\binom{n - c}{k}} pass@k=1−(kn−c)(kn−c)含义:1 减去"从 (n-c) 个失败中全选 k 个"(全失败场景)的概率。同样,平均过任务。

示例:n=8, c=5(成功率 62.5%)。

- pass^8=(58)(88)=0\hat{pass}^8 = \frac{\binom{5}{8}}{\binom{8}{8}} = 0pass^8=(88)(85)=0(因为 (58)=0\binom{5}{8}=0(85)=0,无法从 5 个中选 8 个全成功)。

- pass@8 = 1−(38)(88)=1−0=11 - \frac{\binom{3}{8}}{\binom{8}{8}} = 1 - 0 = 11−(88)(83)=1−0=1(全失败不可能,从 3 失败中选 8 个=0)。

这突显:高单次成功不保证高可靠性;pass^k 更"严苛",逼迫代理接近 100% 一致。

如何计算与解读

- 步骤 :

- 固定任务(用户指令/数据库不变),跑 n 次(论文中 n≥3,主结果 n=3;验证用 n>40)。

- 计 c = ∑ r_i(每个试验的奖励 r ∈ {0,1})。

- 套公式,得 pass^k\hat{pass}^kpass^k;平均 E_task 得整体指标。

- 边界 :

- 若 c < k,则 pass^k=0\hat{pass}^k = 0pass^k=0(不可能全成功)。

- 若 c = n,则 pass^k=1\hat{pass}^k = 1pass^k=1(完美一致)。

- k=1 时:pass^1=c/n\hat{pass}^1 = c/npass^1=c/n(退化为平均成功率)。

- 洞见 (基于论文实验):

- GPT-4o (FC) 在 τ-retail:pass^1 ≈61%,但 pass^8 ≈25%(衰减快,暴露规则遵循不稳)。

- ReAct 比 FC 差 10-20%,因长上下文推理弱。

- 启发:未来 Agent 需强化(如多代理验证),目标是 pass^8 >80% 以部署。

这个指标简洁却深刻,推动从"聪明"向"可靠"评估转型。代码中可直接用 scipy.comb 实现(e.g., Python: from scipy.special import comb; pass_k = comb(c,k) / comb(n,k))。若需代码 demo 或扩展讨论,随时问!

一段话总结: τ-bench:桥接 LLM 代理与真实世界交互的评估新范式

作为 LLM 研究者,我们常常为代理模型在工具调用和规划上的表现欣喜,但忽略了部署时的核心痛点:动态人类交互与领域特定规则的可靠遵循。论文《τ-bench: A Benchmark for Tool-Agent-User Interaction in Real-World Domains》(arXiv:2406.12045v1)由 Shunyu Yao 等 Sierra 研究者提出这一基准,模拟客服场景下代理与 LM 驱动的用户(gpt-4-0613)多轮对话,同时调用领域 API(如数据库读写)并严格遵守 Markdown 政策文档。不同于 WebArena 或 ToolBench 的单步自主交互,τ-bench 建模为 POMDP(部分可观测 MDP),强调长上下文零样本推理:代理需从用户模糊意图中提取信息、处理规则冲突(如航空基础经济舱不可改签,但可取消重订),并输出完整响应。首发两个域------τ-retail(退换货、地址修改,115 任务)和 τ-airline(订改退票、行李政策,50 任务)------规模适中(表 1:零售 500 用户/1000 订单,航空 2000 预订),却通过用户模拟注入自然变异,支持一致性评估。

基准构造采用模块化三阶段流程,确保数据简洁且唯一结局导向,便于 LLM 研究扩展。Stage I 手动设计:从真实世界(如 Amazon/Delta 政策)简化 JSON 数据库(隐藏状态,仅 API 访问)、Python API(7-8 写/读工具,确定性执行,如 return_delivered_order_items 返回错误码)和 Markdown 政策(硬/软约束混合,e.g., 零售交付订单仅退/换一次)。Stage II 用 gpt-4 生成采样代码填充数据(e.g., 随机价格/航班,确保分布真实),输出纯 JSON 文件。Stage III 迭代标注任务实例(JSON:隐藏用户指令注入身份/偏好/情绪 + ground truth 写动作/输出),跑 >40 次 gpt-4-turbo 试验验证唯一性(消除歧义,如指定支付偏好),并从轨迹复制编辑标注。结果:每个任务支持开放对话,却收敛唯一数据库状态(r_action)+关键输出(r_output),奖励 r = r_action × r_output ∈ {0,1} 客观高效,避免人类评判噪声。

评估创新在于 pass^k 指标,针对客服可靠性而非代码生成的"发现率"。对 n 次 i.i.d. 试验(c 次成功),pass^k = E[(ck)\binom{c}{k}(kc) / (nk)\binom{n}{k}(kn)] 衡量 k 次全成功概率(k=1 时退化平均成功率),而 pass@k = 1 - E[(n−ck)\binom{n-c}{k}(kn−c) / (nk)\binom{n}{k}(kn)] 则宽松。LM 温度(代理 0.0,用户 1.0)注入对话随机,暴露变异敏感性。实验测试 OpenAI/Anthropic/Google 等 SOTA 模型(gpt-4o 最佳),用函数调用(FC,主方法:系统提示政策 + 自主消息/工具)和 ReAct(思-行,文本格式)。限 30 行动/任务,n≥3 试验:gpt-4o FC 在 τ-retail pass^1 ≈61%(航空 35%),但 pass^8 <25%,开源 Llama-3-70B 落后 20-30%。失败剖析:数据库多跳弱、ad-hoc 规则不稳、复合请求崩(>1 子任务),凸显需新架构提升鲁棒。

τ-bench 不止基准,更是工程模板:代码仓库(https://github.com/sierra-research/tau-bench)便于加域(如医疗/税务),LM+人工平衡确保高质量小规模任务经 pass^k 揭示洞见。LLM 研究者可复现测试代理,聚焦一致性------从"聪明"到"可靠"的跃迁,将推动多代理协作或规则微调等方向。

后记

2025年12月6日于上海,在supergrok辅助下完成。