目录

前言

这周出去参加了一个硕博论坛,并且做了报告,感觉自己还有着很大的努力空间。然后分享一下这周组会讲的这篇文章,感觉A会的文章确实很不一样。

一、基本信息

论文题目:AGLLDiff: Guiding Diffusion Models Towards Unsupervised Training-free Real-world Low-light Image Enhancement

代码链接: https://github.com/LYL1015/AGLLDiff

论文链接:https://dl.acm.org/doi/10.1609/aaai.v39i5.32564

二、Motivation和主要贡献

现实世界LIE中常见的两个主要挑战:

i)失真/干净图像对的集合往往不切实际,有时甚至无法获得;ii)准确建模复杂退化是不容易的

1.引入了一种新范式AGLLDiff(Attribute Guidance Diffusion Framework),这是一种无需训练且无监督的方法,无需降低先验知识,但对现实低光环境图像增强具有高保真度和通用性;

2.AGLLDiff 足以通过 HQ (High Quality)图像空间中容易得到的属性(曝光度、结构与颜色),引导预训练扩散模型进入可靠的高质量解空间。

三、整体框架

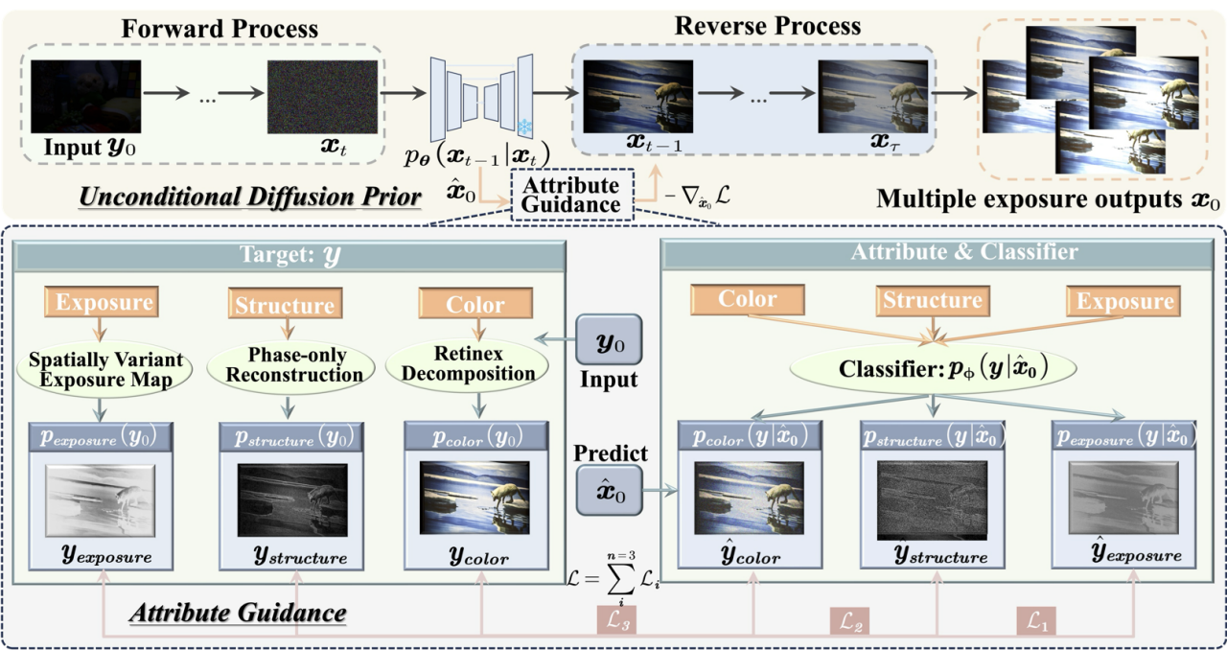

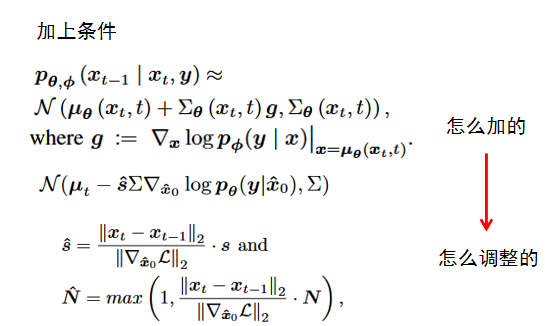

这篇文章就是通过属性gudiance这样的方式作为扩散的条件,并且是利用打分的方式(classifier),可以做到无训练,并且对真实世界的图像效果好,这是一个很吸引人的地方,并且添加了动态调整的策略,就比较合理,美中不足的是它可能推理过程并没有很快。

四、思考

这篇文章会在Introduction部分会有比较直观的解释,就是确实会存在文章要解决的这个问题,会让文章的motivation更加清晰。

总结

希望努力的一切都有回报