长上下文处理能力、Agent的记忆机制、Text2SQL技术的演进,是否终将取代RAG?

换句话来说:RAG是否仅是技术演进中的"阶段性方案"?

近两年,业界对此的争议持续不断。支持替代的一方认为,随着上下文容量扩展、Agent智能水平提升、数据库交互效率优化,RAG的淘汰已成必然;而反对者则主张,RAG将如同搜索引擎般,成为AI基础设施的核心支柱。

让我们系统性地对比分析:将长上下文、Agent记忆、Text2SQL与RAG置于同一框架下,逐一评估其技术特性与适用场景。

更多AI大模型学习视频及资源,都在智泊AI。

一、先承认一个前提:LLM 有"原罪"

所有后续的技术,本质上都在为大模型"查漏补缺"。

尽管LLM能力卓越,仍存在三个固有缺陷:

1.幻觉问题

表现为高度确信却输出虚构内容。

本质定义:生成内容与事实存在偏差,或缺乏可信依据支撑。

2.上下文容量瓶颈(注意力衰减)

从理论看,扩展上下文本应增强记忆能力,但实际存在临界点:

当文本过长时,模型注意力会显著分散,导致后续内容对前文的理解逐渐淡化。

扩展上下文不等于"永久记忆",而是"容量增加但浓度降低的记忆体"。

3.知识边界固化

模型的知识体系源自训练数据:公开网络信息+开放数据集。

由此衍生两大局限:

未涵盖非公开数据(企业专有知识库、内部文档等)

时效性滞后:训练截止日期后的新事件完全超出认知范围

因此,核心挑战始终是:

如何在不全量重训的条件下,使模型具备"实时更新的"、"专属领域的"、"系统化的"知识,同时最大限度减少虚构输出?

RAG技术、扩展上下文、智能体记忆机制、Text2SQL等,均为该问题提供了差异化解决方案。

二、RAG 到底在解决什么问题?

一句话概括:

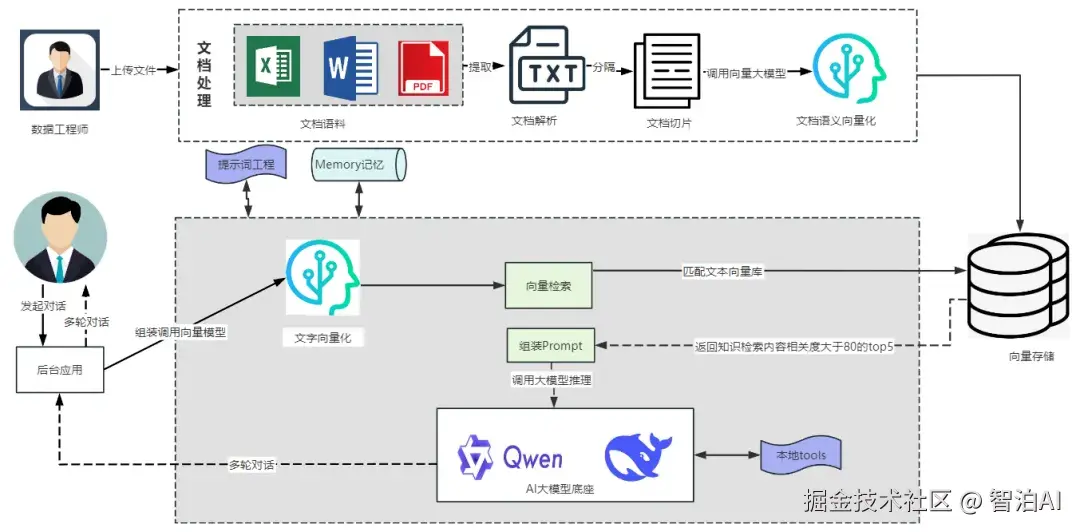

RAG(Retrieval-Augmented Generation)= 检索 + 生成,即在向模型提问前,先从数据中筛选相关内容,再基于这些信息生成回答。

详细说明:

1.定位与作用

RAG是大语言模型(LLM)的补充而非替代,其核心是为模型提供上下文支持,确保回答基于可信资料。

方法论属性:属于技术架构设计,非特定模型或产品。

示例类比:提问时,先检索"地球自转"的百科段落作为Prompt背景,再要求模型结合内容作答。

2.技术优势

减少幻觉:模型优先参考用户提供的文档,而非依赖自身知识库(可设定"严格基于文档回答"规则)。

扩展知识源:支持企业文档、数据库、PDF等外部数据接入。

动态更新:数据更新后通过重新索引即时生效,无需重新训练模型。

透明可审计:可追溯回答的原始文档及段落,满足企业合规需求。

低成本部署:仅需在现有模型外叠加检索逻辑,无需微调或再训练。

三、RAG vs 微调:它们不是对立面

许多团队初期最常提出的疑问是:"究竟该选择RAG,还是直接对现有模型进行微调?"

核心结论:RAG与微调本质上是协同而非对立的关系,绝大多数业务场景会优先部署RAG方案。

从多维度对比分析:

1.幻觉控制

微调:虽能缓解幻觉问题,但存在过拟合风险;在事实性问答中表现不稳定。

RAG:通过直接引用"原始资料"实现更稳定的幻觉抑制。

2.知识整合机制

微调:将知识固化至模型参数内部。

RAG:构建外部知识库实现动态检索调用。

3.更新效率

微调:每次知识更新都需重新训练或增量训练。

RAG:仅需更新索引库,耗时通常为分钟级至秒级。

4.个性化适配

微调:更适用于调整输出风格(如编程规范、客服话术等)。

RAG:更高效整合业务领域专业知识。

5.决策透明度

微调:模型内部决策过程不可见。

RAG:可追溯引用文档的具体内容片段。

6.资源消耗

微调:训练成本高昂,推理延迟与原模型相当。

RAG:因增加检索-排序流程会略微提升端到端延迟。

行业实践建议:

"先实施RAG验证效果,待系统稳定运行后,再通过微调优化输出风格与格式"的渐进式策略最为常见。

四、RAG 的基本模型:5 个阶段讲清楚

RAG系统的五个核心阶段

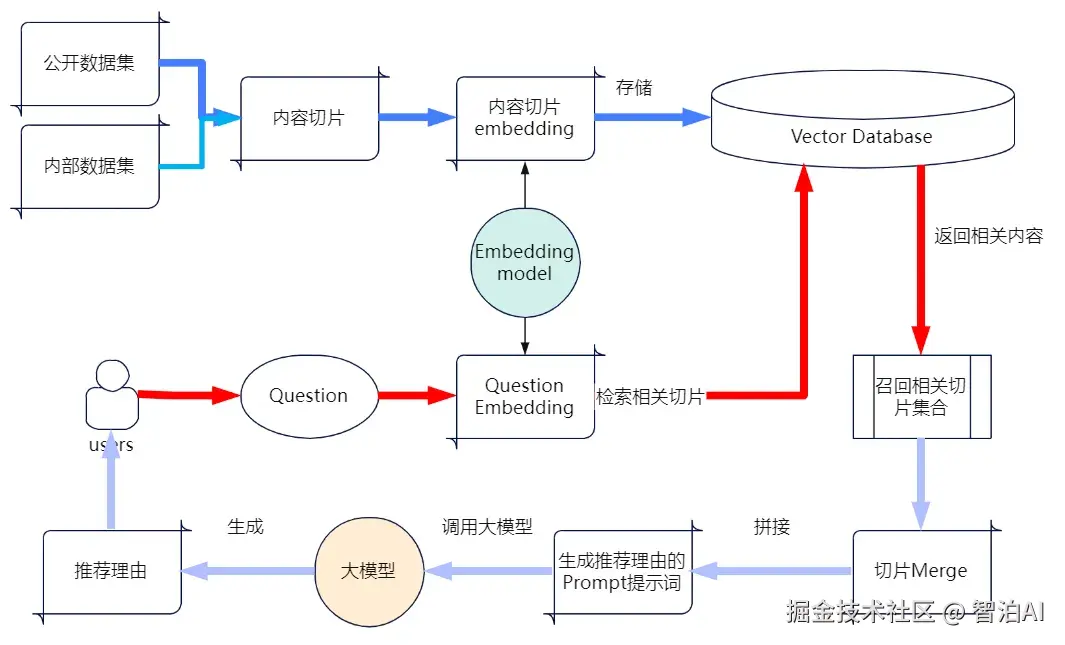

1.数据加载(Loading)

功能:整合多源数据输入

支持格式:PDF/Word文档、网页内容、数据库记录、API接口数据等

核心组件:

节点(Node):文本分块后的最小处理单元

连接器(Connector):实现不同数据源的标准接入

2.索引构建(Indexing)

目标:建立高效检索机制

关键技术:

索引(Index):结构化检索目录

嵌入(Embedding):文本向量化转换

3.数据存储(Storage)

存储内容:文本节点、向量表示、元数据

典型方案:Elasticsearch、OpenSearch、Pinecone、Chroma等

4.查询处理(Querying)

执行流程:

检索器(Retriever):向量库匹配候选节点

路由器(Router):确定检索策略、判断是否需要结构化查询、决定是否调用特定Agent

节点后处理器(Node Post-Processor):结果去重、内容合并、信息扩展

响应合成器(Response Synthesizer):组合检索结果与用户问题、生成LLM输入Prompt

5.系统评估(Evaluation)

方法:构建标准问答测试集

评估维度:检索准确率、分块合理性、Prompt有效性

迭代优化:持续调整系统参数

五、RAG 的技术体系和评估指标

检索部分评估

基础检索指标(衡量"检索准确度"):

Precision(精准率):系统返回结果中正确答案的占比。

Recall(召回率):所有正确答案中被系统检索到的比例。

F1 Score:综合精准率与召回率的平衡指标。

排序优化指标(衡量"结果排序质量"):

MRR(Mean Reciprocal Rank):正确答案排名越靠前得分越高。

MAP(Mean Average Precision):多查询场景下的平均精确率均值。

NDCG:对排名靠前的相关文档赋予更高权重。

核心评估维度:

"检索内容对后续回答的支撑作用如何?"

生成结果评估(大模型回答质量)

Correctness:与标准答案的符合度

Relevance:对用户问题的贴合程度

Logic:论证结构的严谨性

Style:文本长度、语气与品牌调性的匹配

生成过程评估(细粒度指标)

Faithfulness:回答严格基于检索内容

Noise Robustness:过滤无关信息的能力

Negative Rejection:对未知问题的坦诚响应

Info Integration:多源信息整合能力

Counterfactual Robustness:抵御错误假设干扰

这些指标共同定义了RAG系统在实际应用中的可靠性水平。

六、长上下文、Agent 记忆、Text2SQL 各自的定位

核心问题回归:

这些技术能否真正取代RAG?我们逐一分析。

1.长上下文技术(Long Context)

核心价值:扩展模型单次对话的信息承载量,例如完整解析多页文档或复杂合同。

替代RAG的可能性:

有限,主要受制于三点:

注意力衰减:当上下文扩展至数十万token时,模型对远端内容的敏感度会显著降低。

非智能筛选:该技术仅提供"容量扩展"功能,关键内容筛选仍需人工决策------包括输入内容的选择与排序逻辑,这本质上仍是检索需求的转移。

经济性限制:大规模上下文推理成本高昂,多数业务场景难以承担。

实际应用定位:

更适合作为RAG的补充模块,例如:

对RAG预筛选的文档进行深度分析(如长报告摘要、代码库解析)。

作为"增强组件"辅助RAG完成复杂任务。

2.Agent记忆系统

核心价值:维护对话连续性,保留用户偏好与任务状态(如写作风格、已确认信息)。

替代RAG的不可行性:

两者功能维度截然不同:

Agent记忆:聚焦对话进程管理(如已上传文件、用户选择方案)。

RAG:专注外部知识库的接入与检索(如企业制度、产品文档)。

协同应用场景:

Agent将对话上下文(如查询项目/客户)作为检索条件,驱动RAG获取精准数据。

在多轮对话中自动补全背景信息,避免重复描述。

3.Text2SQL技术

核心价值:将自然语言查询转换为结构化数据库操作(如"查询2024年10月订单总额"→自动生成SQL→返回精确结果)。

替代RAG的边界:

在结构化数据查询场景中,其效果优于"文本检索+生成"模式。

但无法覆盖非结构化知识(如规章制度、技术文档)的处理需求。

系统集成视角:

可作为RAG体系的专用检索后端,由路由机制判断优先调用知识库(向量检索)或数据库(Text2SQL),最终综合输出结果。

七、回到开头的问题:RAG 会被替代吗?

若拆解各项技术的核心定位,可清晰识别其差异化价值:

长上下文:突破"单次交互的信息容量限制"

Agent记忆:实现"跨对话轮次的上下文延续"

Text2SQL:构建"自然语言与结构化数据的桥梁"

RAG:完成"多源异构知识的智能筛选与整合"

这些能力呈正交关系,共同构成技术矩阵而非替代选项。

面向实际落地的系统架构将呈现以下特征:

知识增强模块(向量检索+文本RAG)、超长文本解析能力、对话状态管理机制、结构化查询接口(Text2SQL+API联动)、可选的特征微调层

由此可推导:RAG作为基础设施层的地位不会动摇,其演进将聚焦于:

技术实现路径创新、效果评估标准优化、与其他组件的协同范式

八、如果你在团队里落地 RAG,可以从哪几步开始?

实操建议推进步骤:

1.优先确定应用场景

明确需求类型:是常见问题解答(FAQ)、企业知识库检索,还是内部文档智能助手?不同场景需匹配差异化的检索策略与评估标准。

2.快速构建最小可行产品(MVP)

工具选择:

直接采用可视化平台(如QAnything、Dify、Ragflow)降低开发门槛

或通过LlamaIndex/LangChain框架结合FastAPI/Gradio搭建轻量Demo

核心验证目标:

数据可用性、检索准确率、终端用户操作友好性、建立早期评估机制

创建标准化测试问题集,定期进行效果回溯

关键指标监控:

文档召回率与精确度(Recall/Precision、NDCG)

回答与原文一致性(Faithfulness)及幻觉控制(Correctness)

3.渐进式功能扩展

当场景复杂度提升时,逐步集成:

智能体(Agent)自动化流程、Text2SQL数据查询能力、长上下文理解技术

示例应用:用户请求"分析某产品近三月销售数据并结合策略文档输出建议"时,可组合Text2SQL数据提取+RAG文档检索+LLM综合分析能力。

更多AI大模型学习视频及资源,都在智泊AI。