在 Kubernetes 中配置 Ingress 的负载均衡以实现高吞吐量,需要从流量分发策略、后端服务配置、基础设施优化、监控调优等多个维度综合优化。以下是具体实现方法:

一、选择高性能的 Ingress 控制器

Ingress 控制器的性能直接影响流量处理能力,推荐以下高性能方案:

1)NGINX Ingress Controller

- 基于 NGINX 构建,支持七层负载均衡,性能强劲,适合高吞吐量场景。

- 配置要点 :

-

启用

worker_processes自动调优(根据节点 CPU 核心数调整)。 -

开启 HTTP/2 和 TLS 会话复用(减少 SSL 握手开销)。

-

示例配置片段:

controller: config: worker-processes: "auto" # 自动根据 CPU 核心数设置工作进程数 http2: "on" # 启用 HTTP/2 ssl-protocols: TLSv1.2 TLSv1.3 # 使用高效 TLS 协议 ssl-trusted-certs: /etc/nginx/ssl/trusted-certs # 信任的 CA 证书路径

-

2)HAProxy Ingress Controller

- 支持四层和七层负载均衡,适合需要混合协议(如 TCP/UDP)的场景,吞吐量表现优异。

- 优势:基于事件驱动架构,资源占用低,适合高密度流量转发。

3)云厂商原生 Ingress 控制器

- 如 AWS ALB、Google GCLB、阿里云 SLB 等,深度集成云厂商负载均衡器,利用底层硬件加速(如 FPGA)提升性能。

二、优化负载均衡策略

通过配置 Ingress 的流量分配策略,提升后端服务的并发处理能力:

1. 基于权重的流量分配

-

在

Service中为不同 Pod 副本设置权重,将更多流量分配给高性能实例。 -

示例:

apiVersion: v1 kind: Service metadata: name: my-service spec: selector: app: my-app ports: - protocol: TCP port: 80 targetPort: 8080 loadBalancerIP: "10.0.0.10" # 固定负载均衡器 IP(需云厂商支持) externalTrafficPolicy: Local # 保留客户端源 IP,避免二次负载均衡 sessionAffinity: None # 关闭会话亲和性(若无需粘性会话) sessionAffinityConfig: clientIP: timeoutSeconds: 10800

2. 基于流量特征的负载均衡算法

-

NGINX Ingress 支持多种七层算法:

least_conn:最少连接数(适合长连接场景)。ip_hash:基于客户端 IP 哈希(实现会话亲和性)。random:随机分配(适合无状态服务)。

-

配置示例(在 Ingress 中指定注解):

apiVersion: networking.k8s.io/v1 kind: Ingress metadata: name: high-throughput-ingress annotations: nginx.ingress.kubernetes.io/load-balancer-method: "least_conn" # 最少连接算法 spec: rules: - host: app.example.com http: paths: - path: / pathType: Prefix backend: service: name: my-service port: number: 80

3. TCP/UDP 流量的四层负载均衡

-

对于非 HTTP 协议(如 gRPC、WebSocket),使用

Service的type: LoadBalancer直接转发流量,减少七层处理开销。 -

示例:

apiVersion: v1 kind: Service metadata: name: grpc-service spec: type: LoadBalancer ports: - protocol: TCP port: 50051 targetPort: 50051 selector: app: grpc-app

三、后端服务高并发优化

1. 水平扩展 Pod 副本数

-

使用

Horizontal Pod Autoscaler (HPA)根据 CPU / 内存利用率自动扩缩容,确保后端服务始终有足够资源处理流量。 -

示例:

apiVersion: autoscaling/v2beta2 kind: HorizontalPodAutoscaler metadata: name: my-hpa spec: scaleTargetRef: apiVersion: apps/v1 kind: Deployment name: my-deployment minReplicas: 4 maxReplicas: 20 metrics: - type: Resource resource: name: cpu target: type: Utilization averageUtilization: 70 # 当 CPU 利用率超过 70% 时扩容

2. 启用连接池和批量处理

- 在应用层实现连接池(如数据库连接池、HTTP 连接池),减少建立连接的开销。

- 对支持批量处理的接口(如批量查询、批量写入),优化请求批次大小,减少请求次数。

3. 无状态服务设计

- 避免使用会话亲和性(

sessionAffinity),允许负载均衡器将请求随机分发到任意副本,充分利用所有实例的资源。

四、基础设施层优化

1. 使用高性能网络插件

- 选择支持

SR-IOV、DPDK等加速技术的 CNI 插件(如Calico企业版、Cilium),减少网络转发延迟和 CPU 消耗。 - 示例:

Cilium通过 eBPF 实现内核级流量转发,提升吞吐量。

2. 节点资源预留

- 为 Ingress 控制器和后端服务节点预留 CPU 和内存资源,避免资源竞争导致性能波动。

- 通过

node taints和pod affinities将 Ingress 控制器部署在专用高性能节点。

3. 硬件加速 TLS

-

在节点上启用 TLS 硬件加速(如 Intel AES-NI),减少 SSL 加密 / 解密的 CPU 开销。

-

验证硬件加速是否启用:

grep -q aes /proc/cpuinfo && echo "AES-NI supported" || echo "Not supported"

五、监控与调优

1. 关键指标监控

- 监控 Ingress 控制器的以下指标:

- 请求速率(Requests per Second, RPS):判断是否达到控制器性能瓶颈。

- 连接数(Active/Idle Connections) :确保不超过 NGINX 的

worker_connections限制。 - 后端延迟(Backend Latency):定位慢响应的服务节点。

- 工具推荐:Prometheus + Grafana + NGINX Ingress Exporter。

2. 性能压测

-

使用

wrk、k6等工具模拟高并发流量,测试 Ingress 的吞吐量极限。 -

示例压测命令(模拟 1000 并发请求):

wrk -t4 -c1000 -d30s http://app.example.com/

3. 动态调优参数

- 根据监控结果调整 Ingress 控制器参数,例如:

-

增加 NGINX 的

worker_connections(默认 1024):controller: config: worker-connections: "8192" # 按节点内存调整,建议每 worker 进程分配 1MB 连接内存 -

调整 TCP 缓冲区大小(

so_keepalive、tcp_nodelay)优化网络传输。

-

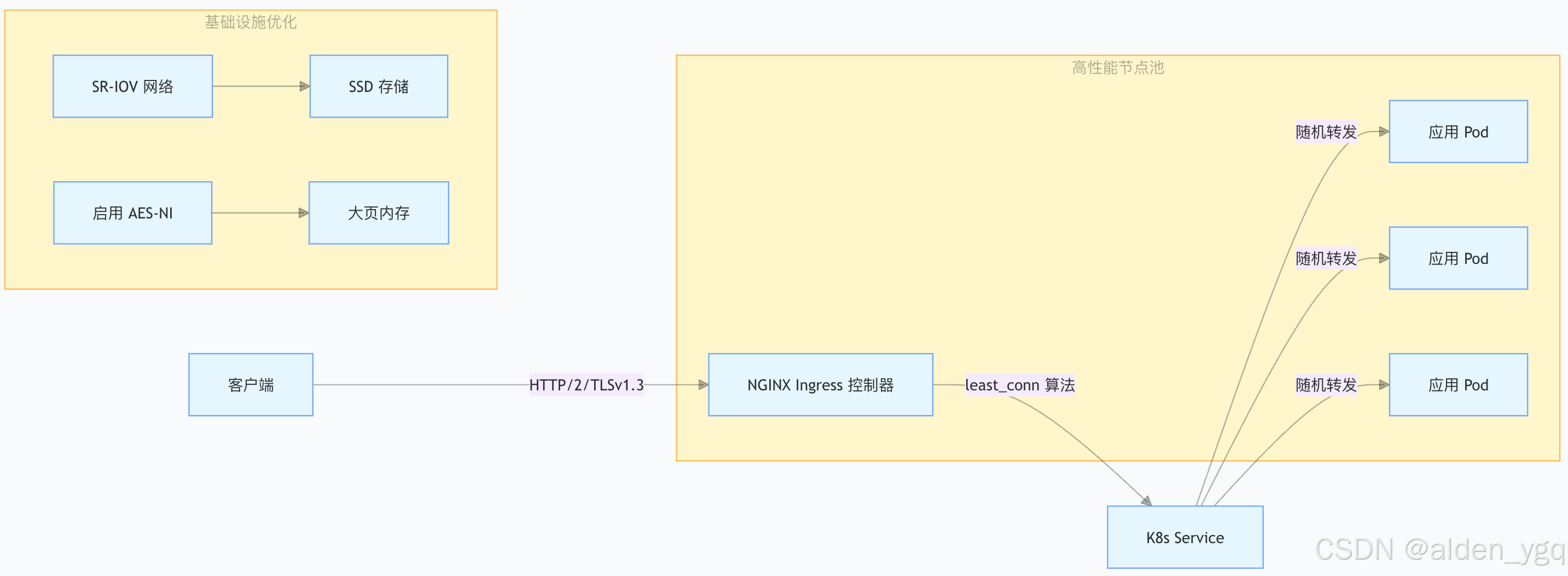

六、高吞吐量架构示例

总结

实现 Ingress 负载均衡的高吞吐量需遵循以下原则:

- 减少层次化处理 :优先使用四层负载均衡(如

Service type: LoadBalancer),避免七层不必要的协议解析。 - 最大化并行处理:通过多 worker 进程、多 Pod 副本、无状态设计充分利用计算资源。

- 硬件与软件协同优化:结合云厂商负载均衡器、硬件加速、高性能网络插件提升底层性能。

- 动态弹性扩展:通过 HPA 和自动扩缩容节点池,应对流量峰值。

通过以上措施,可显著提升 Kubernetes 集群中 Ingress 的流量处理能力,满足高吞吐量场景的需求。