激活函数最大的作用:向线性模型中注入非线性

1.Sigmoid

公式:

输出范围为[0,1]

缺点:

梯度消失问题

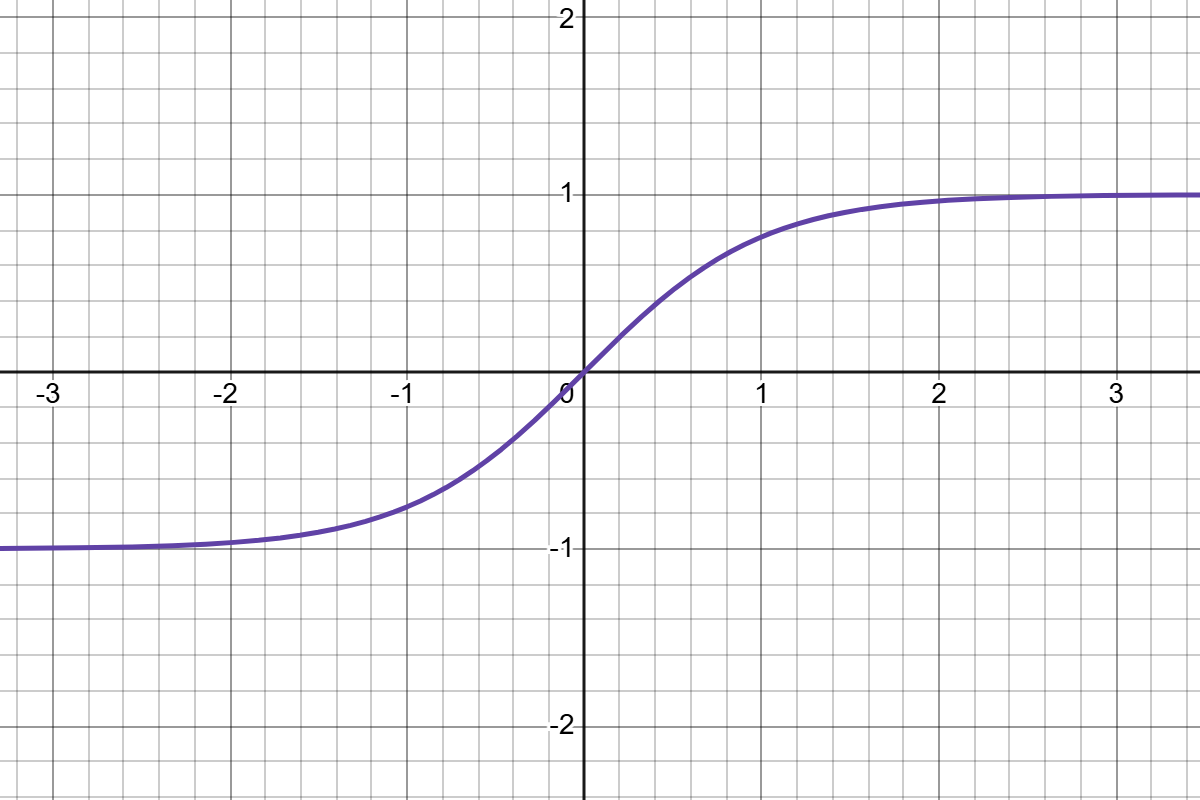

2.Tanh

公式:

输出范围[-1,1]

缺点:未完全解决梯度消失问题

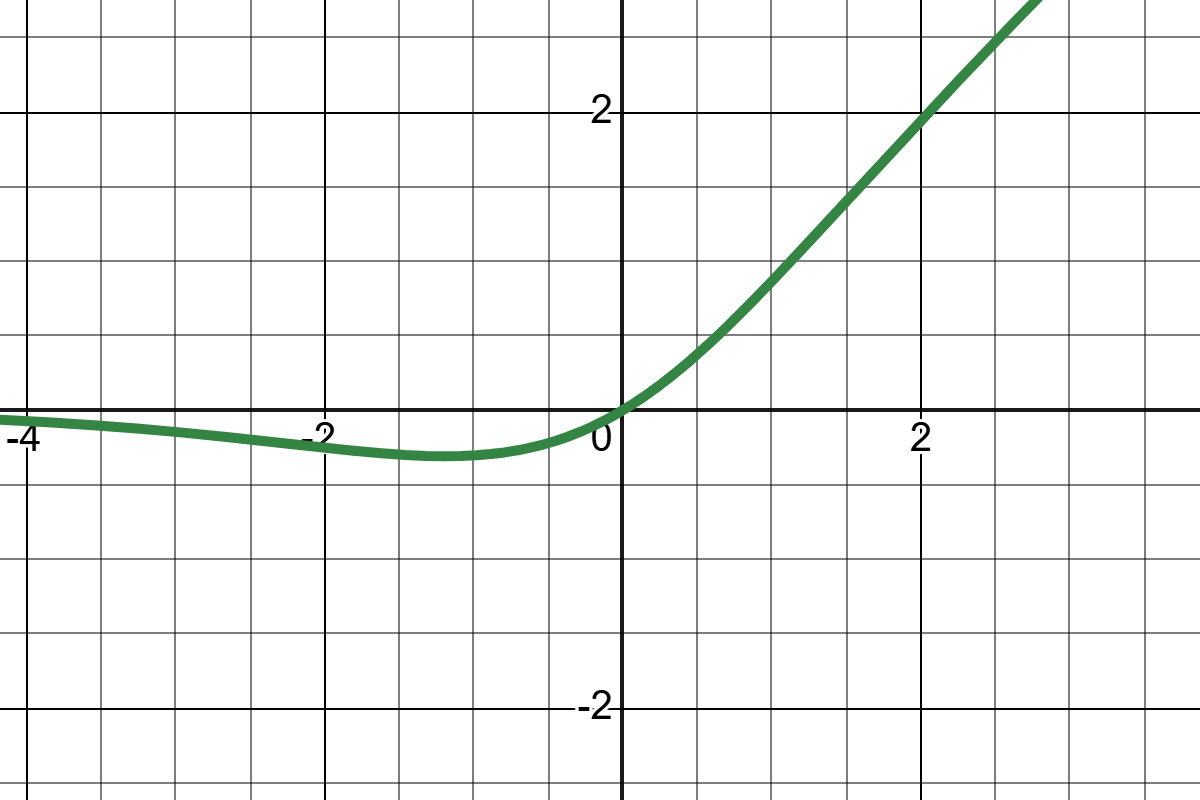

3.ReLU

公式:

输出范围[0,+∞]

缺点:若有些神经元始终小于0,会导致其始终无法更新。

4.Leaky Relu

公式:

输出范围[-∞,+∞]

缺点:超参数 α 需手动调优

5.PRelu

公式:

为可学习参数,通过反向传播更新

缺点:增加模型复杂度,需限制 α>0

6.ELU

公式:

7.selu

公式:

缺点:计算复杂度高,网络结构不支持RNN/LSTM(时序数据的自归一化条件不满足)

8.swish

公式:

兼具 "梯度平滑、无死亡神经元、自适应特征权重" 三大优势

9.mish

公式:

缺点:计算复杂度高,指数溢出风险。小数据容易过拟合

10.softmax

公式: