StarRocks 处理每日 PB 级日增量时,核心矛盾是「高吞吐导入」与「低延迟查询」的平衡,需从 数据模型设计、导入链路、存储查询、资源调度、稳定性保障 五维度系统性优化,同时规避增量场景下的典型风险。以下是具体细节:

一、核心注意点(基础设计,决定 80% 性能上限)

1. 数据模型选择:匹配业务场景,拒绝 "一刀切"

PB 级增量场景下,模型选错会导致导入阻塞或查询雪崩,需按业务类型精准选择:

| 模型类型 | 适用场景 | 注意事项(PB 级增量关键约束) |

|---|---|---|

| 明细模型(Duplicate Key) | 原始数据存储、全量字段查询(如用户行为日志、原始交易记录) | 避免全表扫描!必须搭配分区 + 分桶 + 过滤索引;不适合高频聚合查询 |

| 聚合模型(Aggregate Key) | 统计分析、指标汇总(如日活、销售额、渠道转化率) | 聚合粒度需前置(如按 "用户 + 日期" 聚合),减少增量计算量;避免过多维度列导致聚合开销飙升 |

| 更新模型(Unique Key) | 需 Upsert/Delete 的场景(如用户画像、库存数据) | 主键选择高基数且更新频繁的字段;PB 级场景建议用「Partial Update」而非全字段更新,降低 IO 开销 |

| 主键模型(Primary Key) | 实时点查、高频更新(如订单状态实时同步) | 依赖 FE 的主键索引,需控制单表行数(建议≤100 亿行 / 表);避免大字段频繁更新 |

2. 分区与分桶:控制数据粒度,避免 "扫描爆炸"

- 分区设计(核心:按时间分区,控制单分区大小) :

- 必选「时间分区」(如按天 / 小时分区),单分区数据量建议控制在 50GB~200GB(PB 级增量可按小时分区,每日 24 个分区,单分区≈40TB/PB 不合理,需结合分桶进一步拆分);

- 避免分区过细(如每分钟分区):会导致元数据膨胀(FE 需管理大量分区元数据),查询时分区 pruning 开销增加;

- 开启「分区生命周期管理(TTL)」:自动淘汰过期冷数据(如保留 90 天),避免存储溢出。

- 分桶设计(核心:均匀分布,避免数据倾斜) :

- 分桶键选择:高基数、分布均匀的字段(如 user_id、order_id),避免用低基数字段(如性别、渠道)导致分桶数据不均;

- 分桶数量:按 BE 节点磁盘容量计算,公式:

分桶数 = (单分区数据量 / 单分桶目标大小) × 副本数(单分桶目标大小建议 1GB~5GB,副本数默认 3); - 示例:单分区数据量 100GB,副本数 3 → 分桶数 = (100GB / 2GB) ×3 = 150 个,确保每个 BE 节点分摊均衡。

3. 导入策略:拒绝 "暴力全量",拥抱 "增量友好"

- 优先选择「高吞吐导入方式」:Stream Load(实时增量)、Broker Load(批量增量)、Routine Load(Kafka 实时消费),避免使用 Insert Into(单条写入,性能极差);

- 控制导入批次:单批次导入数据量建议 ≤10GB,PB 级增量需分拆为千级以上批次(如每批次 5GB,每日 200 批次),避免单批次占用过多 BE 内存;

- 导入时机:避开查询高峰(如凌晨低峰期集中导入),或采用 "错峰导入 + 流量控制"(通过

max_filter_ratio控制导入速率)。

4. 元数据与数据质量:避免 "隐形开销"

- 元数据控制:单表列数建议 ≤100 列,过多列会导致 Manifest 文件膨胀,查询时元数据解析开销增加;

- 数据预处理:在导入 StarRocks 前,通过 Flink/Spark 完成数据清洗(去重、补全、格式转换),避免在 StarRocks 内部做复杂计算;

- 空值与异常值:过滤无效数据(如金额 < 0、时间戳异常),避免占用存储和影响查询准确性。

二、关键调优点(针对性提升导入 / 查询性能)

1. 导入链路调优(核心:高吞吐、低延迟、稳容错)

- 并行度优化 :

- Stream Load/Broker Load:设置

max_filter_ratio=0.01(允许 1% 数据过滤),开启strict_mode=false(非严格模式,避免单条数据错误导致整批失败); - Routine Load:调整

consumer_num(消费者数量,建议 = Kafka 分区数)、batch_size(每批次消费条数,建议 10 万~100 万),提升 Kafka 数据拉取速率;

- Stream Load/Broker Load:设置

- 导入内存控制 :

- BE 节点配置

load_mem_limit(默认 4GB),PB 级场景建议调整为 16GB~32GB(避免导入时 OOM); - 开启「导入限流」:通过

fe.conf中的max_parallel_load_tasks控制同时运行的导入任务数(建议 = BE 节点数 ×2),避免集群资源耗尽;

- BE 节点配置

- 容错优化 :

- 开启导入任务重试(

retry_num=3),失败批次自动重试; - 采用 "两阶段提交":确保导入原子性,避免部分数据写入导致数据不一致。

- 开启导入任务重试(

2. 存储与压缩调优(核心:节省空间,提升 IO 效率)

- 压缩算法选择 :

- 明细模型:用 ZSTD 压缩(压缩比高,查询解压开销适中),避免用 Snappy(压缩比低,PB 级场景存储开销过大);

- 聚合模型:用 LZ4 压缩(解压速度快,适合高频聚合查询);

- 分级存储(冷热分离) :

- 热数据(近 7 天)存储在 SSD,冷数据(7 天前)自动迁移到 HDD / 对象存储(如 S3),降低存储成本;

- 配置

storage_medium参数,指定分区存储介质,避免手动迁移。

3. 查询性能调优(核心:减少扫描范围,提升计算效率)

- 索引优化 :

- 高频过滤字段(如时间、用户 ID、渠道):建立 Bitmap 索引(适用于低基数字段)或 Bloom Filter 索引(适用于高基数字段);

- 聚合模型:对维度列建立 Short Key 索引(默认前 36 字节,可调整

short_key_length),加速查询过滤; - 避免过度索引:索引会增加导入开销和存储,仅对高频查询字段建立索引;

- 物化视图(预聚合加速) :

- 对高频聚合查询(如 "每日各渠道销售额"),创建物化视图,增量更新时自动同步数据,查询时直接命中物化视图,避免全表扫描;

- 注意:物化视图数量不宜过多(建议≤10 个 / 表),否则会增加导入时的预计算开销;

- 查询计划优化 :

- 开启 CBO 优化(

set enable_cbo=true),让 StarRocks 自动选择最优查询计划; - 避免

SELECT *,仅查询必要字段;高频查询建议用「查询结果缓存」(set query_result_cache=true)。

- 开启 CBO 优化(

4. 资源与集群调优(核心:匹配 PB 级增量的硬件 / 配置)

- FE 配置优化 :

- 元数据缓存:调整

metadata_cache_size(默认 1GB)为 8GB~16GB,减少元数据查询开销; - 并行查询线程:

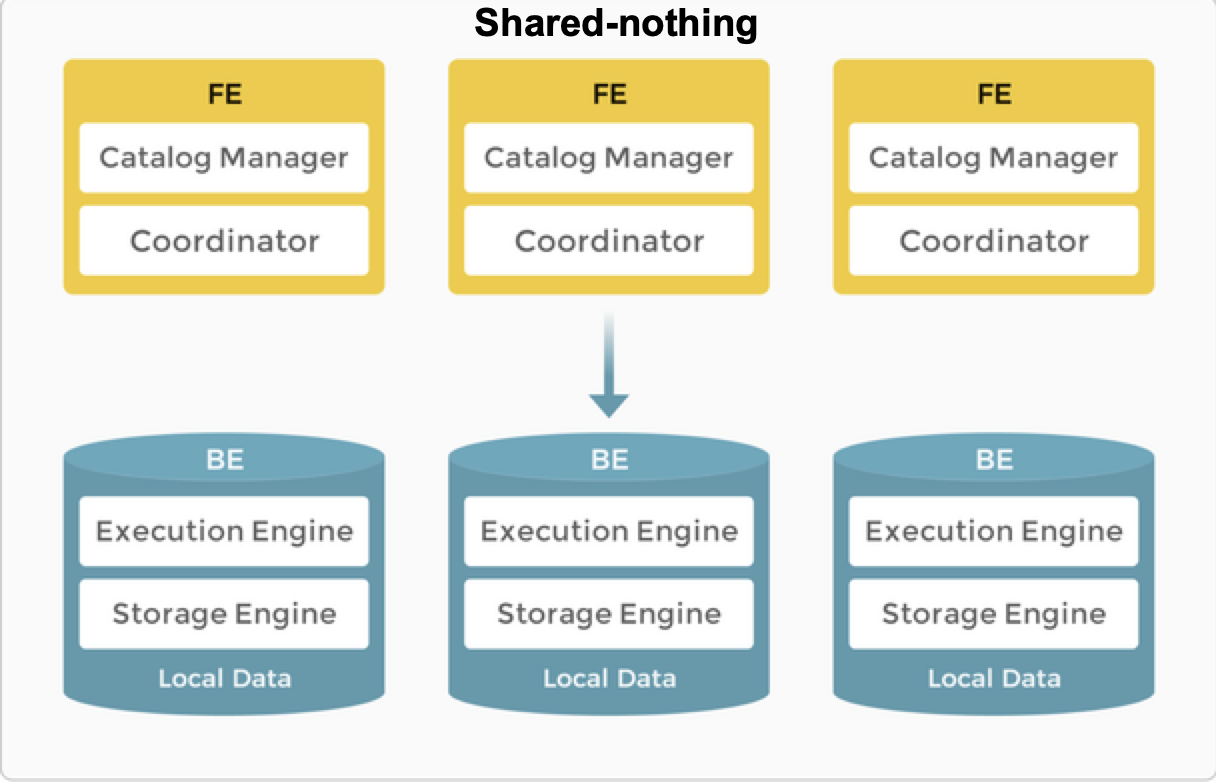

fe.conf中query_pool_thread_num调整为 CPU 核心数 ×2,提升查询并发能力; - 高可用:部署 3 个 FE 节点(1 主 2 备),避免 FE 单点故障导致集群不可用;

- 元数据缓存:调整

- BE 配置优化 :

- 内存分配:

be.conf中mem_limit调整为物理内存的 60%~70%(如 128GB 内存分配 80GB),其中storage_engine_mem_limit分配 40%(用于存储引擎),query_mem_limit分配 30%(用于查询计算); - 磁盘配置:每个 BE 节点挂载 4~8 块 SSD/HDD,开启磁盘 IO 均衡(

enable_disk_io_balance=true),避免单块磁盘 IO 瓶颈; - 并行 Compaction:调整

max_compaction_threads(默认 4)为 8~16,加速小文件合并(PB 级增量会产生大量小文件,Compaction 不及时会导致查询性能下降);

- 内存分配:

- 集群扩容 :

- 按 "CPU: 内存:磁盘 = 1:4:100" 比例扩容 BE 节点(如 PB 级日增量建议 BE 节点数≥20 个,总磁盘容量≥10PB,预留 30% 冗余);

- 避免单 BE 节点负载过高:通过

balance_tablet命令定期均衡数据分布。

三、可能出现的问题及风险防控

1. 导入瓶颈:吞吐量上不去,或频繁失败

- 典型诱因 :

- 单批次导入数据量过大(如 50GB / 批次),导致 BE 内存溢出;

- Kafka 消费速率跟不上(Routine Load 消费者数量<Kafka 分区数);

- 导入任务并发过高,抢占查询资源;

- 解决方案 :

- 分拆批次:将大批次拆分为小批次(如 50GB→5GB / 批次),增加导入并发;

- 扩容 Kafka 消费者:

consumer_num与 Kafka 分区数保持一致; - 资源隔离:通过

resource_group为导入和查询分配独立资源池(如导入占 40% CPU,查询占 60%); - 监控告警:关注

load_success_rate(导入成功率)、load_avg_latency(导入延迟),低于 95% 时触发告警。

2. 查询性能雪崩:查询延迟飙升,甚至超时

- 典型诱因 :

- 分区 / 分桶设计不合理,导致全表扫描;

- 小文件过多(Compaction 不及时),查询时打开 / 关闭文件开销过大;

- 高频查询未命中索引或物化视图;

- 解决方案 :

- 紧急优化:对慢查询添加索引、创建临时物化视图;手动触发 Compaction(

ADMIN COMPACT TABLE table_name;); - 长期优化:重构分区 / 分桶策略,确保查询时能精准过滤分区;调整 Compaction 参数(

base_compaction_num_threads=8); - 限流降级:对非核心查询设置超时时间(

set query_timeout=30s),避免占用过多资源。

- 紧急优化:对慢查询添加索引、创建临时物化视图;手动触发 Compaction(

3. 数据倾斜:部分 BE 节点负载过高

- 典型诱因 :

- 分桶键选择不当(如用低基数字段分桶),导致部分分桶数据量是其他分桶的 10 倍以上;

- 热点数据集中(如某明星用户的行为日志占比极高);

- 解决方案 :

- 更换分桶键:选择高基数、分布均匀的字段(如 user_id 的哈希值);

- 热点打散:对热点字段添加随机后缀(如 user_id→user_id + rand ()%10),打散分桶分布;

- 均衡数据:执行

ADMIN BALANCE TABLET FOR TABLE table_name;手动均衡分桶分布。

4. 元数据膨胀:FE 内存占用过高,响应缓慢

- 典型诱因 :

- 分区过细(如每分钟分区,每日 1440 个分区);

- 单表列数过多(>200 列),导致 Manifest 文件过大;

- 解决方案 :

- 合并分区:将细粒度分区合并(如每分钟→每小时分区);

- 裁剪列:删除无用字段,将大字段(如 JSON、TEXT)迁移到外部存储(如 MinIO),StarRocks 仅存储索引字段;

- 限制元数据大小:

fe.conf中metadata_fragment_size调整为 64MB,拆分大元数据文件。

5. 存储溢出:磁盘空间耗尽

- 典型诱因 :

- 未开启 TTL,冷数据累积;

- 导入数据量超出集群存储冗余(预留<20%);

- 解决方案 :

- 紧急处理:删除过期数据(

ALTER TABLE table_name DROP PARTITION partition_name;); - 长期优化:开启 TTL(

ALTER TABLE table_name SET TTL = INTERVAL 90 DAY;); - 扩容存储:新增 BE 节点或挂载更多磁盘。

- 紧急处理:删除过期数据(

6. 稳定性问题:集群崩溃或数据不一致

- 典型诱因 :

- FE 单点故障(未部署备节点);

- BE 节点磁盘损坏,未开启副本(副本数<3);

- 导入任务中断导致数据部分写入;

- 解决方案 :

- 高可用部署:FE 至少 3 节点(1 主 2 备),BE 副本数 = 3;

- 数据备份:开启定期快照备份(

BACKUP TABLE table_name TO "hdfs_path";); - 故障恢复:BE 节点故障时,通过

ADMIN RECOVER TABLET;恢复副本;导入中断时,通过导入日志重试失败批次。

四、总结:PB 级增量优化核心逻辑

StarRocks 处理 PB 级日增量的关键是「提前规划 + 动态调优 + 风险兜底」:

- 基础层:数据模型、分区分桶设计必须匹配业务,从源头减少无效 IO;

- 链路层:导入和查询资源隔离,避免相互抢占;

- 性能层:通过索引、物化视图、Compaction 优化,提升查询效率;

- 稳定性层:监控核心指标(导入成功率、查询延迟、磁盘使用率),提前预警风险。

核心原则:"宁做细粒度规划,不做大规模重构",PB 级场景下,后期调整数据模型或分区策略的成本极高,需在项目初期就完成精准设计。