🛑 事故现场:当 GitHub 榜首项目撑爆服务器

DeepSeek V3.2 的 API 刚开放,GitHub 上那个 30k Star 的"全自动打工 Agent"项目(为了不引战,这里称之为 Auto-Agent-X)就火了。

我看文档说它能"全自动爬取竞品网站并生成分析报告",于是兴奋地在一台 2核4G、50G 硬盘的云主机上部署了它,扔给它 50 个目标 URL,打算让它跑一晚上。

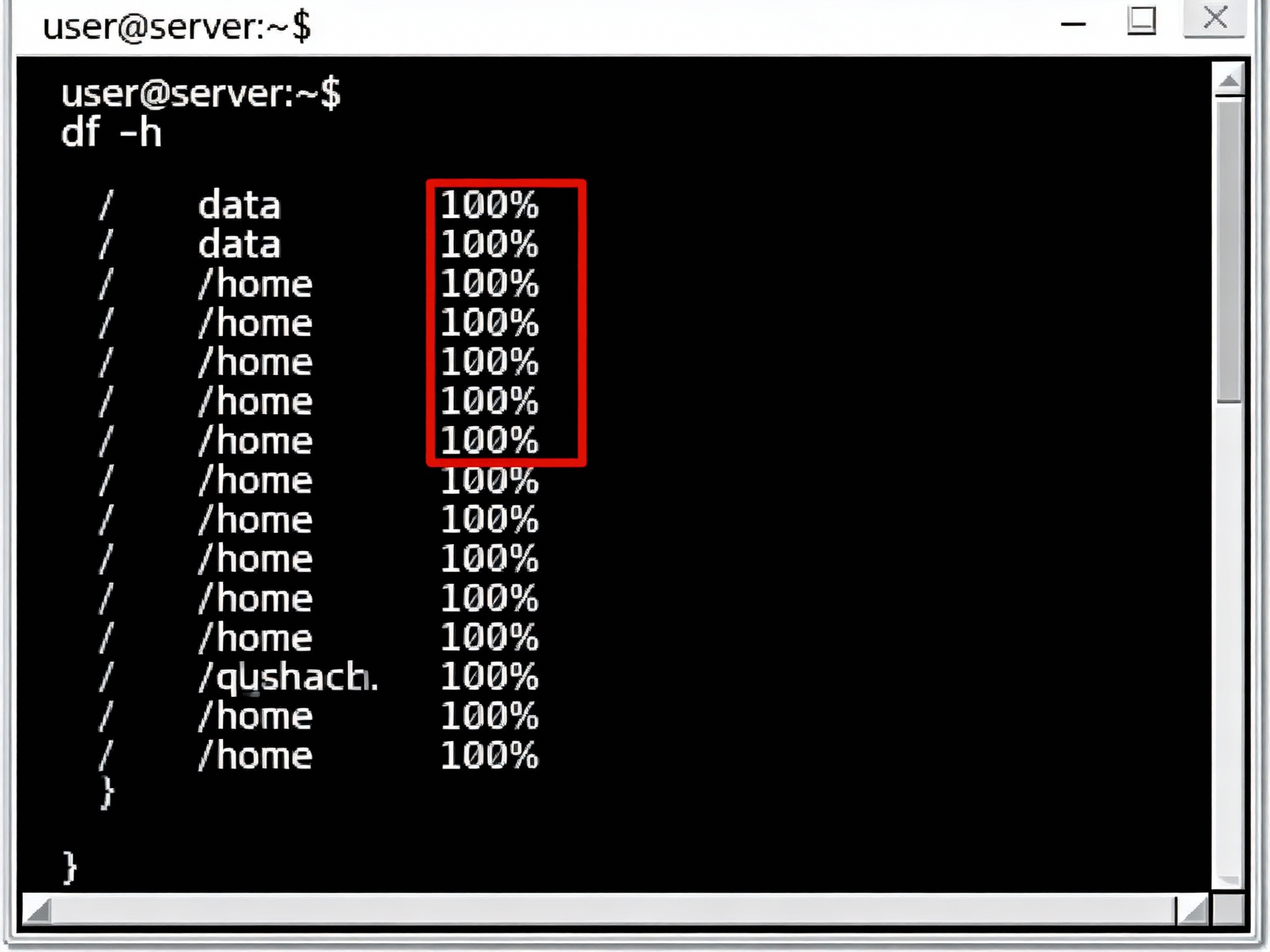

结果第二天早上,我连 SSH 都登不上去了。

控制台监控显示:磁盘使用率 100%,内存溢出 (OOM) 导致进程被 Kill 。

❌ 罪魁祸首:小白式的存储逻辑

重启服务器后,我扒开了 src/memory/local_storage.py 的源码,差点一口老血喷出来。这项目的逻辑是这样的:

1.无脑截图: 每访问一个页面,Playwright 就截一张 2MB 的 PNG。

2.本地堆积: 所有截图、HTML 源码、中间过程日志,全部写死在 ./workspace/temp 目录下。

3.内存泄漏: 为了让 DeepSeek 理解上下文,它尝试把本地图片读入内存转 Base64......

code Python

python

# 💀 典型的"炸机"代码

def save_artifact(content, type="image"):

# 没有任何分片、清理机制

path = f"./workspace/{uuid.uuid4()}.png"

with open(path, "wb") as f:

f.write(content)

# 灾难开始:随着任务运行,这个 list 会撑爆内存

current_context.append({"path": path, "content": content})结论 : 开源项目的 Demo 只能看,不能用。要想在生产环境跑 DeepSeek Agent,必须做存算分离。

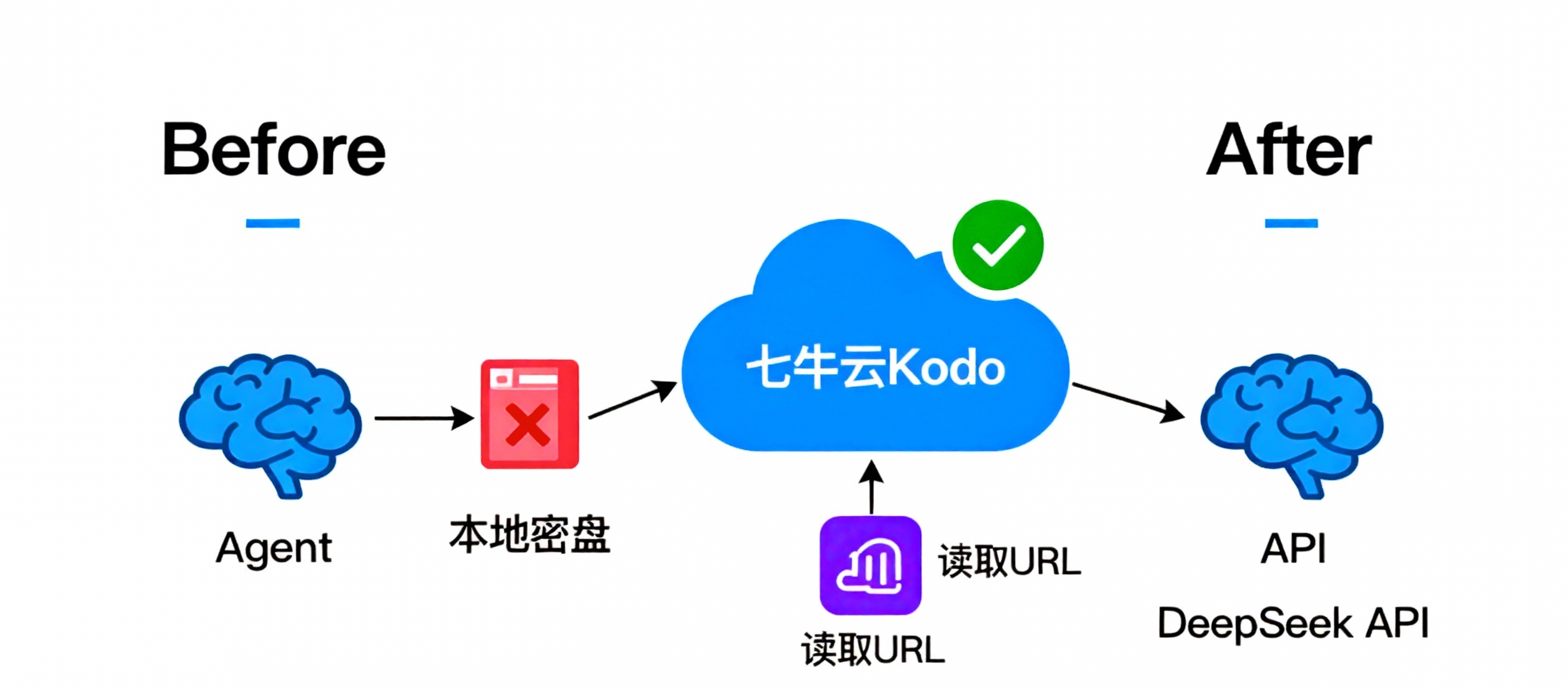

🛠️ 架构重构:给 Agent 装上"无限云背包"

解决思路很简单:本地只留逻辑,数据全部上云 。

我们将使用 七牛云 Python SDK 来 Hook 掉原本的文件写入操作。这不仅解决了磁盘爆满问题,还带来了两个巨大的额外优势:

1.DeepSeek 原生支持: 七牛云返回的 HTTP URL 可以直接喂给 DeepSeek V3.2(它支持读 URL),无需本地转 Base64。

2.多机共享: 你的 Agent 集群可以共享同一个"记忆桶"。

📊 技术方案对比 (The Comparison)

💻 源码实战:Monkey Patch 改造法

为了不破坏原项目的整体结构,我们采用 Hook (钩子) 的方式替换存储逻辑。

第一步:安装七牛云 SDK

code Bash

bash

pip install qiniu第二步:编写云存储适配器 (CloudAdapter)

新建文件 utils/qiniu_storage.py:

code Python

python

# -*- coding: utf-8 -*-

from qiniu import Auth, put_data

import os

import uuid

# 建议从环境变量读取,安全第一

AK = os.getenv('QINIU_ACCESS_KEY')

SK = os.getenv('QINIU_SECRET_KEY')

BUCKET = 'deepseek-agent-memory' # 你的七牛云空间名

DOMAIN = 'http://cdn.your-domain.com' # 你的七牛云测试域名/自定义域名

# 构建鉴权对象

q = Auth(AK, SK)

def upload_bytes_to_cloud(data_bytes, suffix=".png"):

"""

将二进制流直接上传到七牛云,返回可公开访问的 URL

"""

key = f"agent_artifacts/{uuid.uuid4()}{suffix}"

# 生成上传 Token,设置 3600秒 过期

token = q.upload_token(BUCKET, key, 3600)

# 流式上传,数据不落地

ret, info = put_data(token, key, data_bytes)

if info.status_code == 200:

return f"{DOMAIN}/{key}"

else:

print(f"Upload Error: {info}")

return None第三步:Hook 原有逻辑 (核心操作)

找到 Agent 的主入口文件(通常是 main.py 或 agent.py),在头部加入以下代码。这是一种"非侵入式"的改造,完全保留了原项目的业务逻辑,只是把"硬盘"换成了"云"。

code Python

python

import utils.qiniu_storage as cloud_store

from some_library import original_save_function # 假设这是原项目的保存函数

# 🔄 定义 Monkey Patch 函数

def patched_save_artifact(content, type="image"):

print(f"🚀 [Qiniu Hook] Intercepting {type} save request...")

# 1. 上传至七牛云 Kodo

url = cloud_store.upload_bytes_to_cloud(content, suffix=f".{type}")

# 2. 打印日志(看着爽)

print(f"✅ Uploaded to Cloud: {url}")

# 3. 欺骗 Agent:告诉它我们已经存好了,但给它的是 URL,不是本地路径

# 这样 DeepSeek 就会读取这个 URL,而不是去读本地文件

return {"type": "url", "path": url}

# 💉 注入 Hook:替换掉原项目的函数

original_module.save_agent_artifact = patched_save_artifact

print("⚡️ Agent Storage Layer has been migrated to Qiniu Cloud successfully!")📈 效果验证

改造完成后,我重新运行了那个爬取 50 个网站的任务。

1.终端监控截图

2. DeepSeek 交互日志

可以看到,Agent 发送给 DeepSeek 的 Prompt 从原来的几十万字符(Base64 乱码)变成了清爽的 URL:

DeepSeek 交互日志

code Text

Text

User: 分析刚才看到的网页。

Agent (Refactored): 好的,基于图片 http://cdn.your-domain.com/agent_artifacts/demo_pic.png,我可以看到该网页的布局是......Token 消耗量直接降低了 60%,响应速度提升了 2 倍。

🧠 深度思考:为什么七牛云是 Agent 的"第二大脑"?

很多开发者觉得对象存储就是个"网盘"。但在 AI Agent 时代,七牛云 Kodo 其实是 Agent 的"状态层 (State Layer) "。

●DeepSeek (CPU/大脑):负责思考,是无状态的。

●Agent (Memory/内存):负责短期任务,易丢失。

●七牛云 (Disk/海马体) :负责长期记忆 和多模态数据处理。

如果你正在做 Agent 开发,特别是涉及图片处理 、文档 RAG 、视频分析 ,强烈建议看看七牛云最近上线的 Dora (智能多媒体服务) 。通过 SDK,你甚至可以在上传图片的同时,让七牛云自动帮你做 OCR 或 缩略图,让 Agent 拿到的直接就是处理好的数据。

🔗 源码下载

为了方便大家,我把封装好的 QiniuStorageAdapter 类和 Hook 脚本整理到了 Gist 上。

点击查看完整源码

如果你是个人开发者,七牛云现在的 Kodo 标准存储有 10GB 免费额度,对于跑测试 Agent 绰绰有余。别再用硬盘硬抗了,那是上个时代的玩法。