文章目录

前期检查

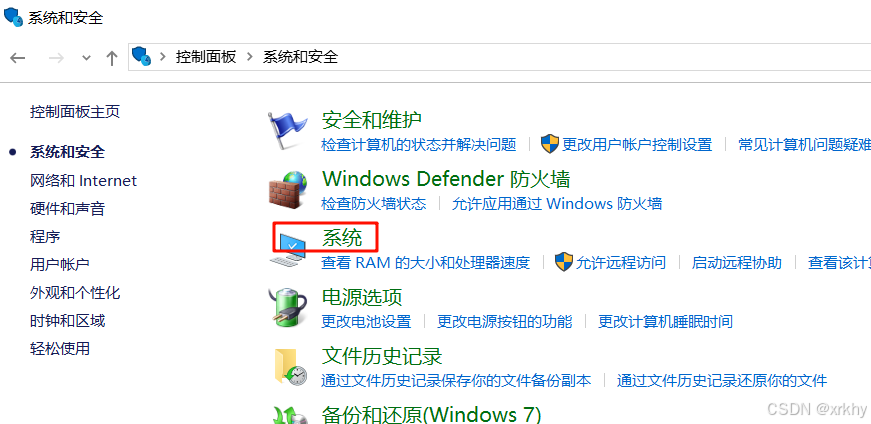

查看系统

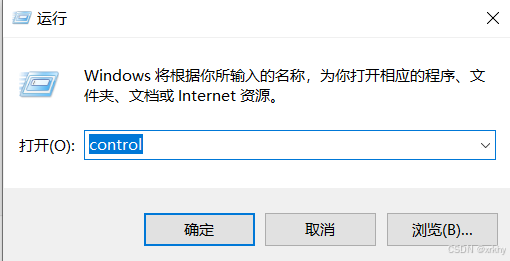

快捷键【win+R】,输入"control"

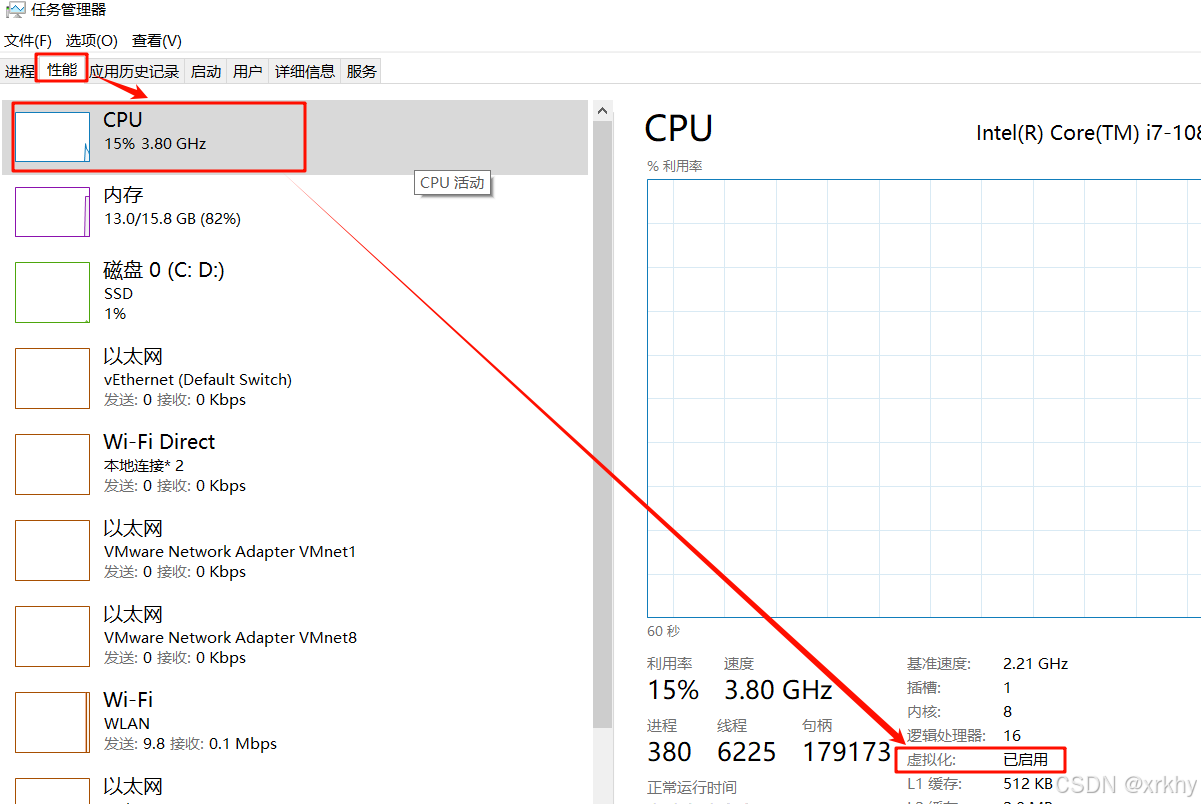

确认虚拟化

【任务管理器】---【性能】

安装Hyper-V

1、创建并运行安装脚本

在桌面新建一个 .txt 文件,将上面内容保存至文件中,将文件名字改为 Hyper-V.cmd,以管理员身份运行。

bash

pushd "%~dp0"

dir /b %SystemRoot%\servicing\Packages\*Hyper-V*.mum >hyper-v.txt

for /f %%i in ('findstr /i . hyper-v.txt 2^>nul') do dism /online /norestart /add-package:"%SystemRoot%\servicing\Packages\%%i"

del hyper-v.txt

Dism /online /enable-feature /featurename:Microsoft-Hyper-V-All /LimitAccess /ALL2、启用Hyper-V功能

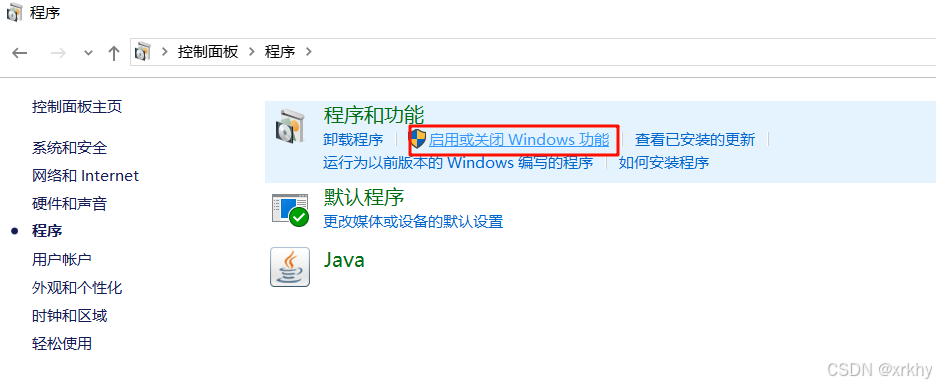

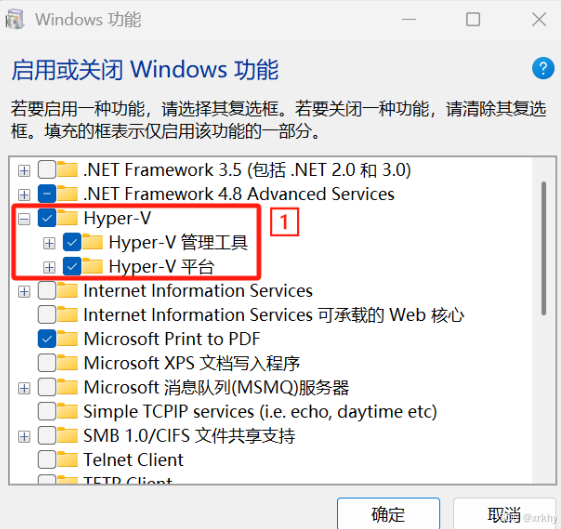

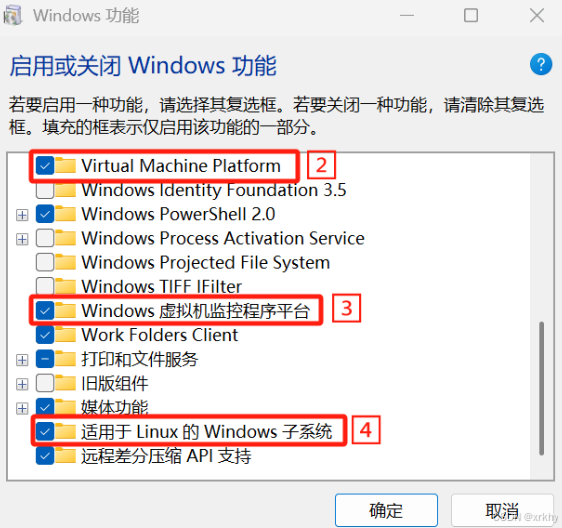

【控制面板】--->【程序】--->【启用或关闭Windows功能】

选择"Hyper-V"、"Virtual Machine Platform"、"Windows 虚拟机监控程序平台"和"适用于Linux的Windows子系统",点击"确定"

点击确定后要重启电脑

安装WSL

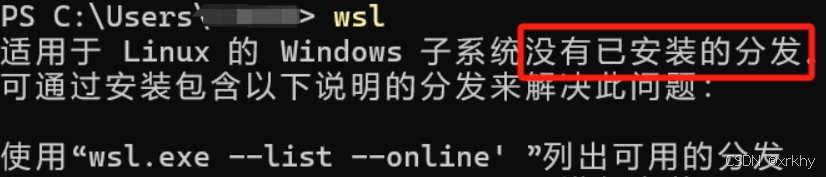

1、安装前检验

菜单搜索"Windows PowerShell",输入"wsl.exe --update"安装。

# 适用于 Linux 的 Windows 子系统必须更新到最新版本才能继续

wsl.exe --update

#检测是否安装

wsl输出以下结果

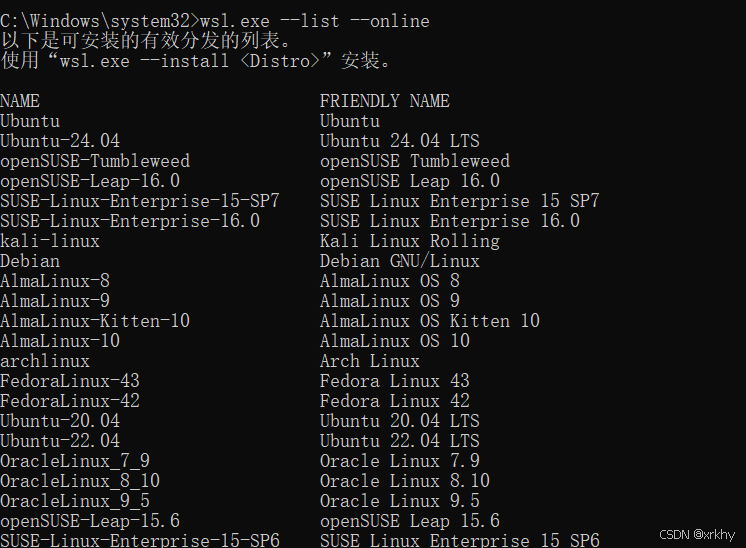

2、列出可安装的Linux发行版

bash

wsl.exe --list --online

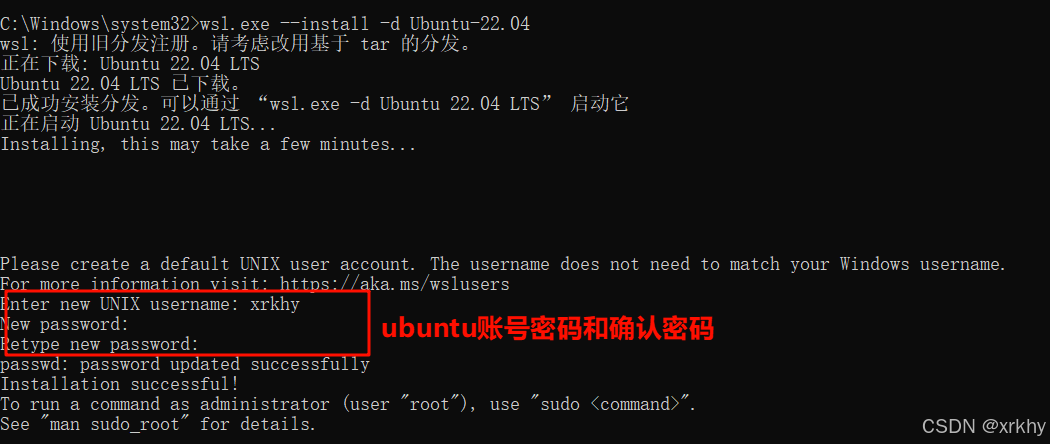

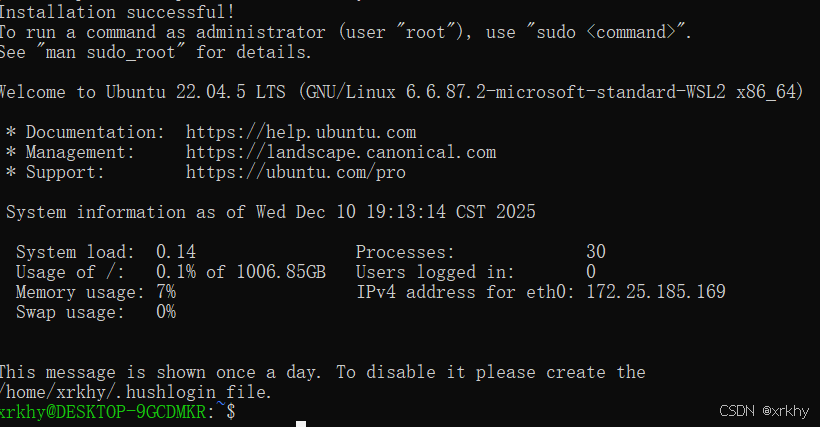

3、安装Ubuntu-22.04版本

docker安装

去官网开发或者看我网盘

D盘安装

我们下载过后千万不要双击打开Docker Desktop Installer.exe,因为双击打开安装的是C盘。

-

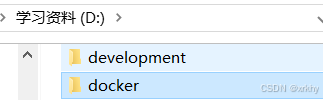

在你要安装docker的盘符(比如D盘)新建docker文件夹。

-

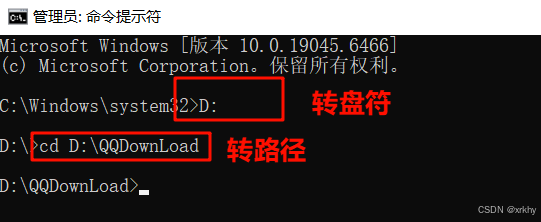

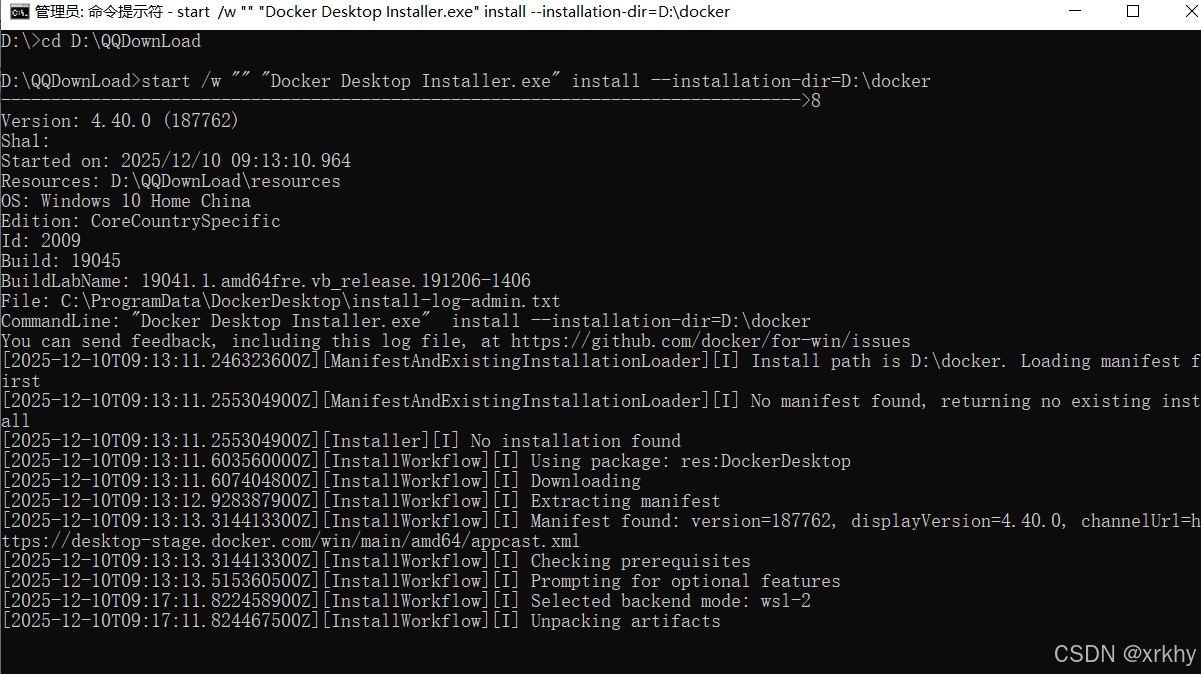

以管理员身份打开cmd

-

命令行转到你下载文件(

Docker Desktop Installer.exe)的所在目录

-

我们需要执行指令,表示将本路径下的

bashstart /w "" "Docker Desktop Installer.exe" install --installation-dir=D:\docker

-

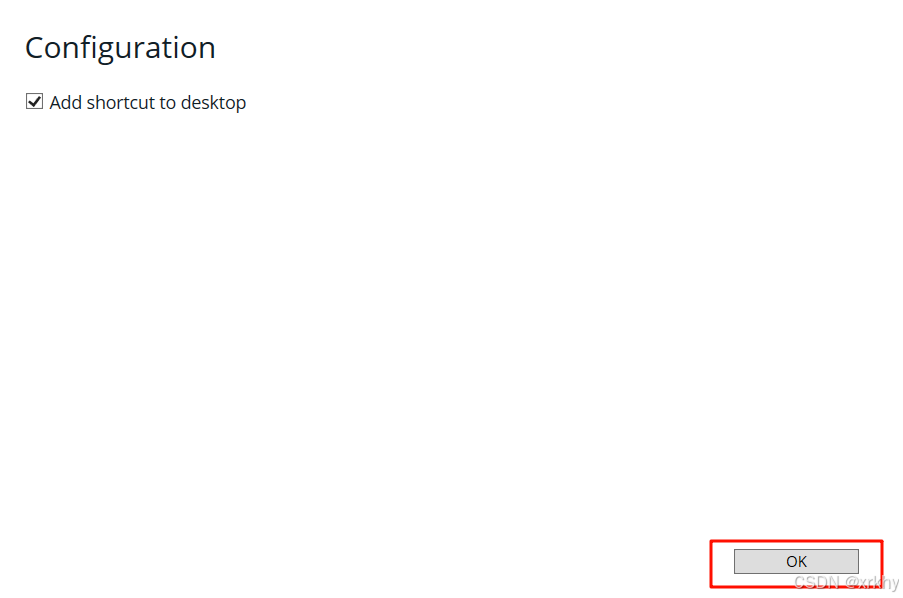

等一会就会出现如下界面,你点击OK

-

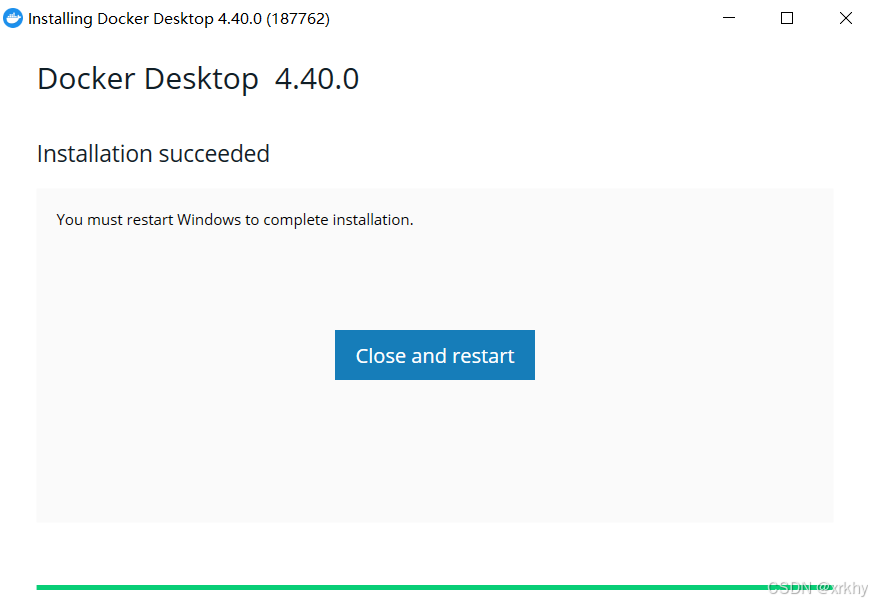

点击Close and restart重启。

-

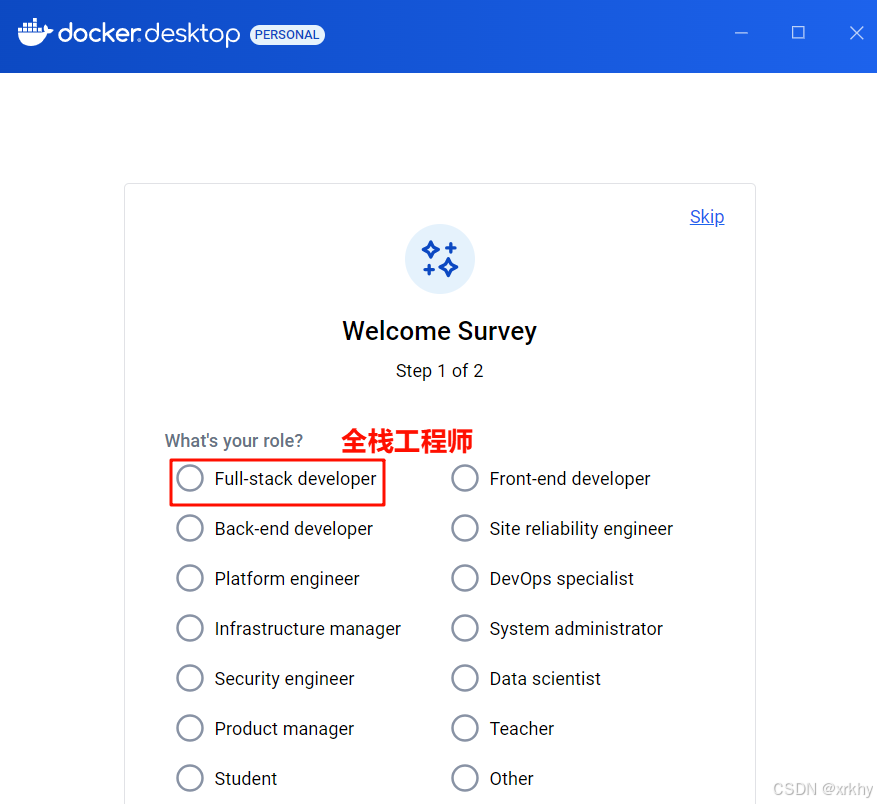

重启电脑后就会有如下界面

登录注册

可以直接跳过

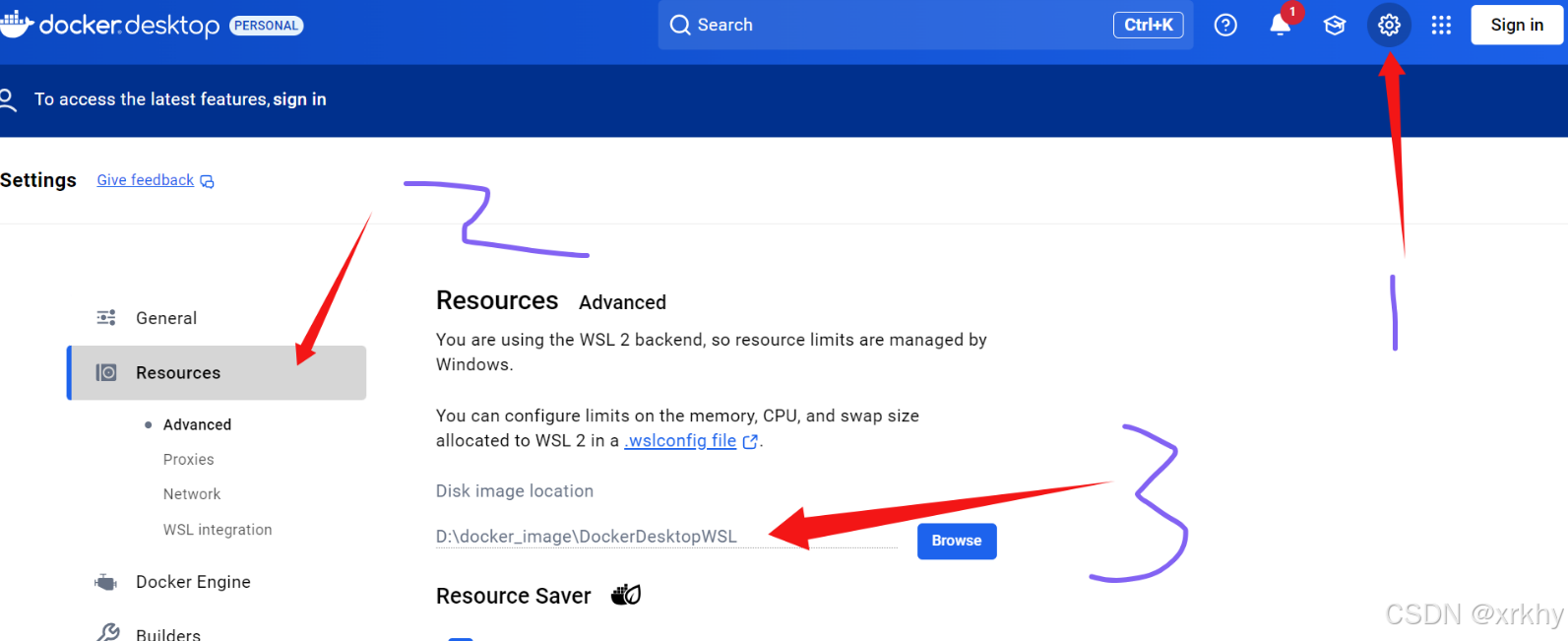

在D盘新建docker_image文件夹,然后选择这个文件夹。如果这里改不了,关闭docker并删除刚刚下载的docker的文件夹内所有内容重新再装一次。

下载安装dify

下载并安装

从github上克隆或者下载dify项目

https://github.com/langgenius/dify

进入dify-main项目中打开docker文件夹,将文件名 .env.example 改为 .env

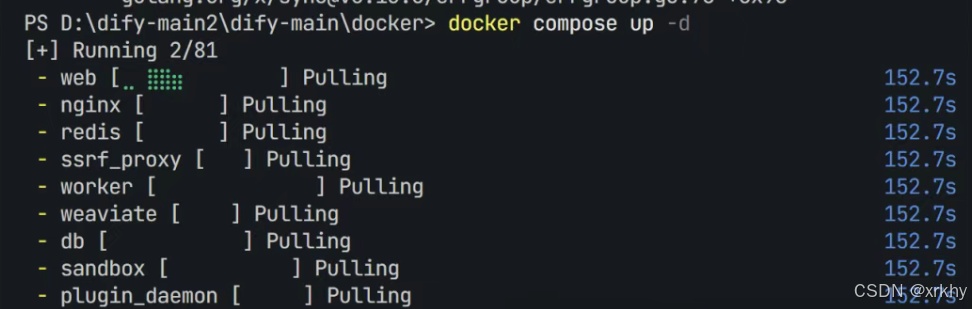

使用cmd管理员身份进入,执行命令docker compose up --d

第一次拉取镜像需要一点时间

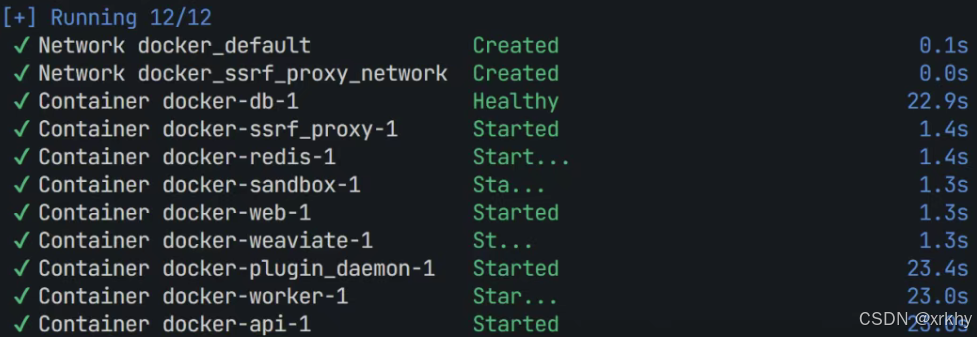

启动成功是这样的

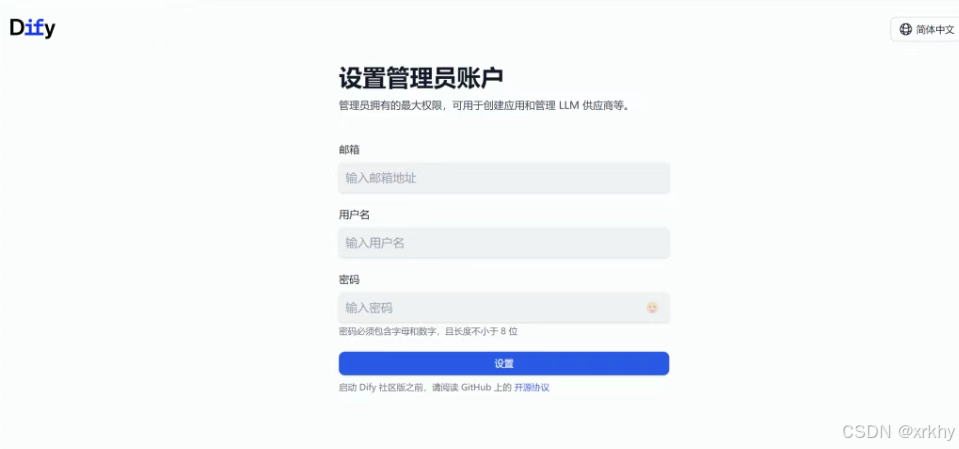

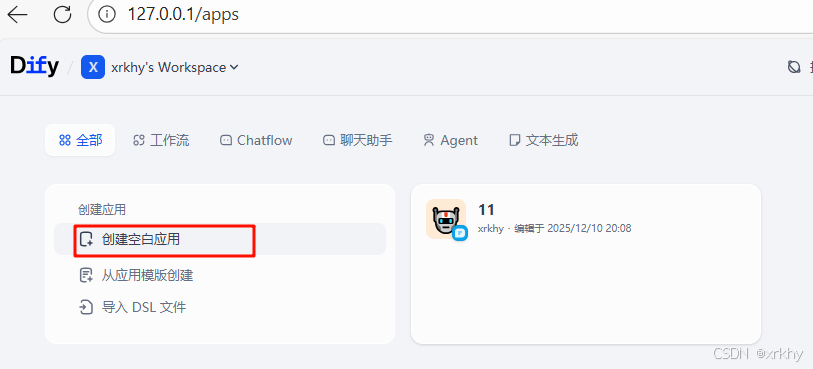

成功启动服务后,进行dify本地访问和配置 ,默认端口号为80,也可以在.env文件中进行修改端口访问本地dify:http://127.0.0.1

创建管理员账号

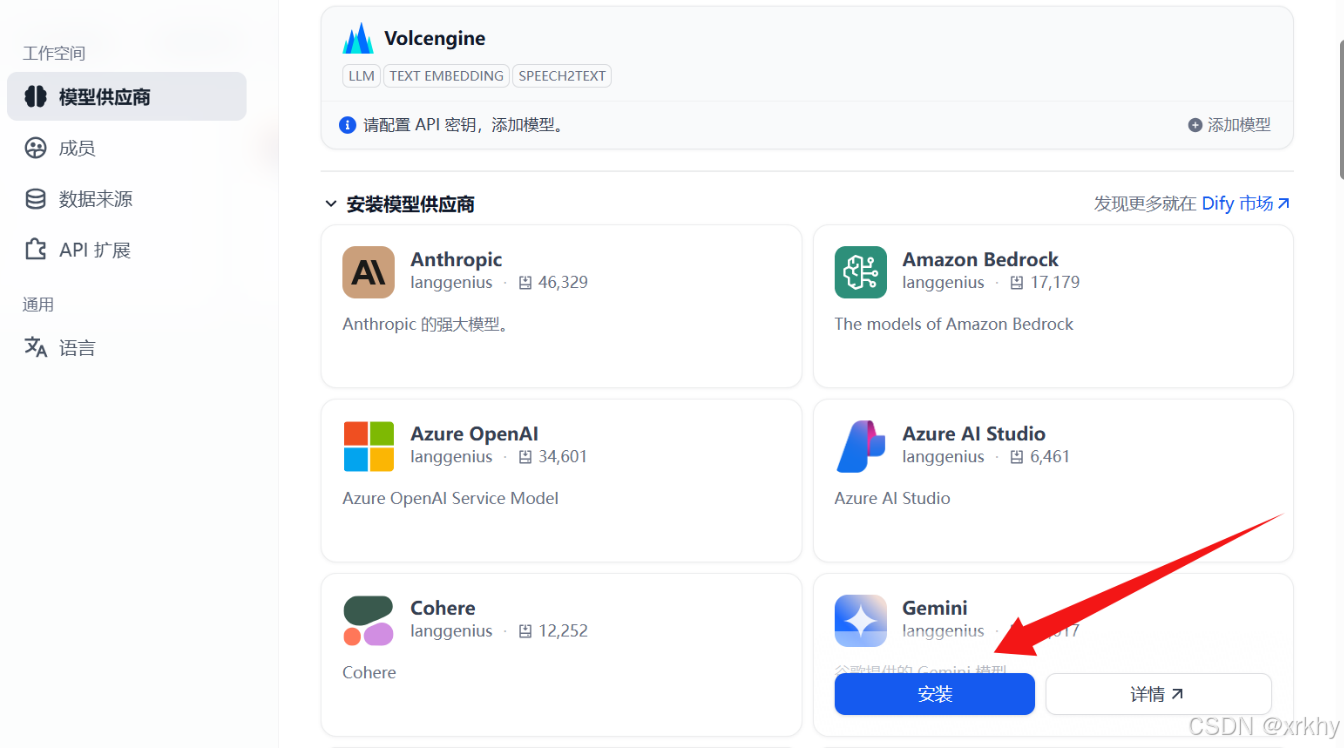

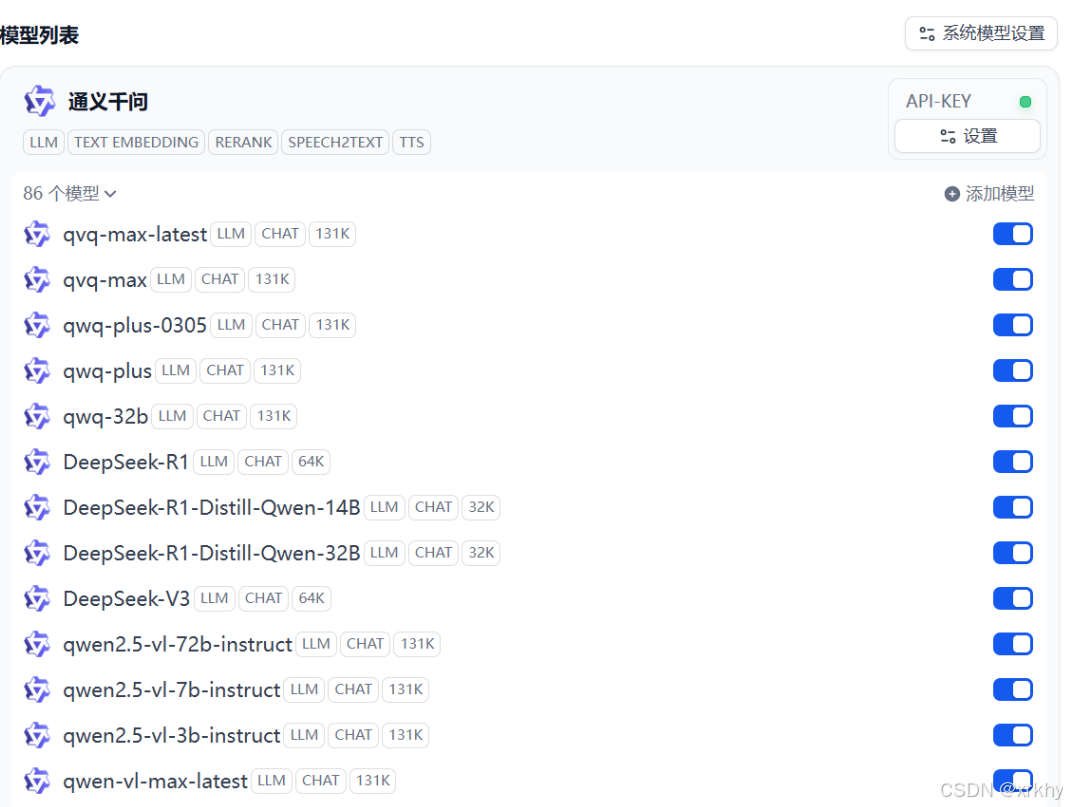

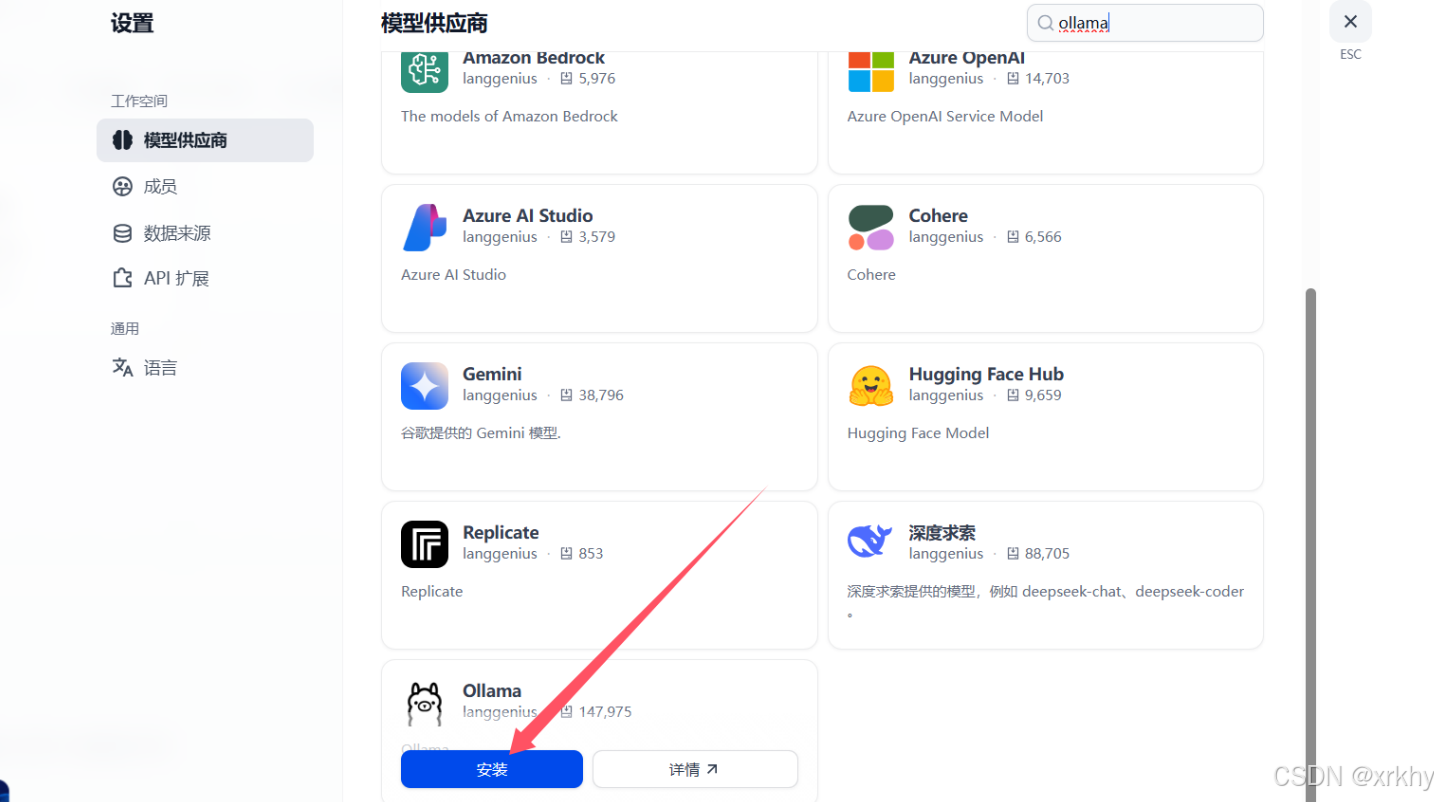

配置模型供应商

选择自己想要的模型进行安装

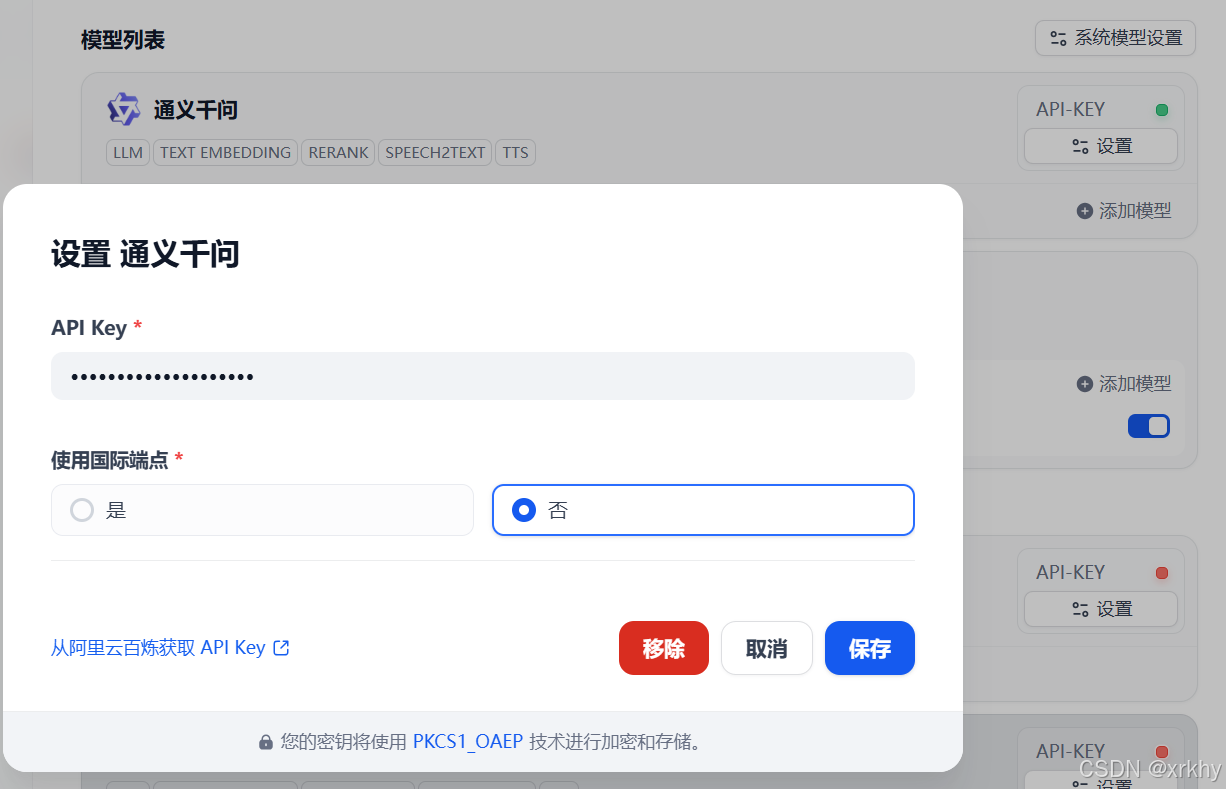

指定模型的相关参数即可

配置本地ollama模型

安装ollama与下载模型

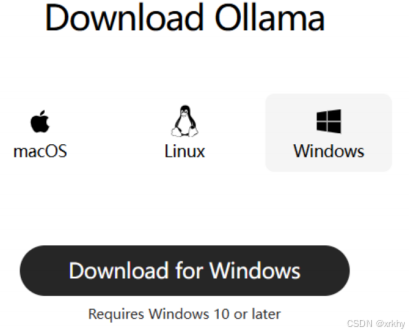

首先,我们需要下载一个Ollama的客户端,在官网提供了各种不同版本的Ollama,大家可以根据自己的需要下载。

Ollama官网:https://ollama.com/download

安装Ollama

下载完成后,不要双击OllamaSetup.exe,不要点击【Install】

注意:

知己双击安装 Ollama默认安装目录是C盘的用户目录,如果不希望安装在C盘的话(其实C盘如果足够大放C盘也没事),就不能直接双击安装了。需要通过命令行安装。

命令行安装方式如下:

在OllamaSetup.exe所在目录打开cmd命令行,管理员身份进入,然后命令如下:

bash

OllamaSetup.exe /DIR=你要安装的目录位置

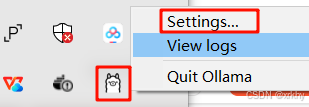

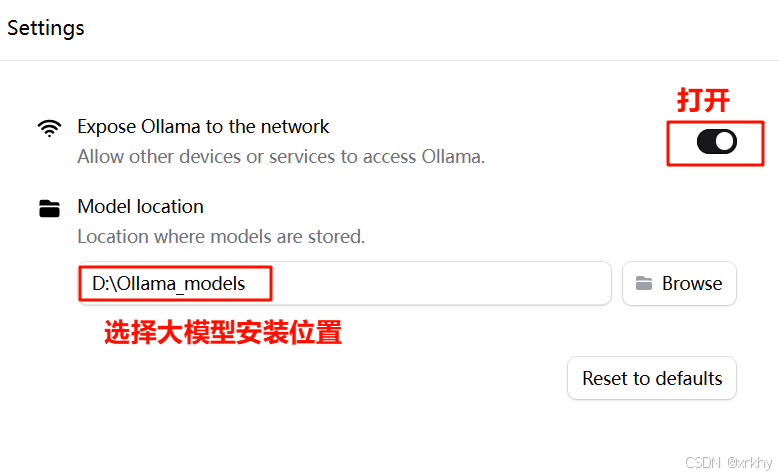

# 如:OllamaSetup.exe /DIR=D:\ollamaOK,安装完成后,配置羊驼(Ollama)的配置,选择settings...

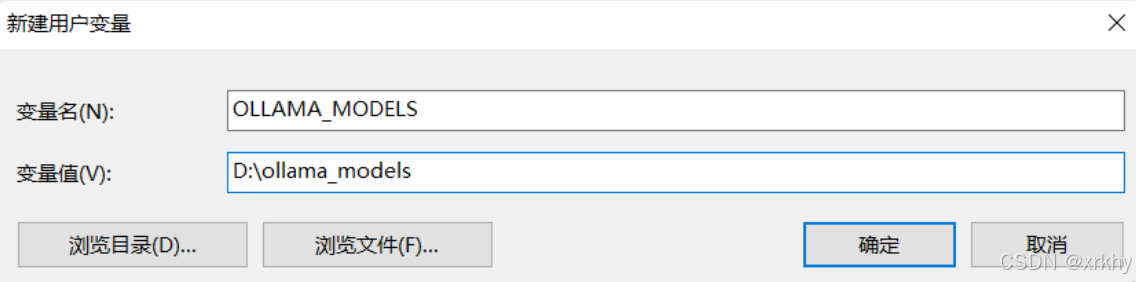

还需要配置一个环境变量,更改Ollama下载和部署模型的位置。环境变量如下:

bash

OLLAMA_MODELS=你想要保存模型的目录环境变量配置方式相信学过Java的都知道,这里不再赘述,配置完成如图:

搜索模型进行下载

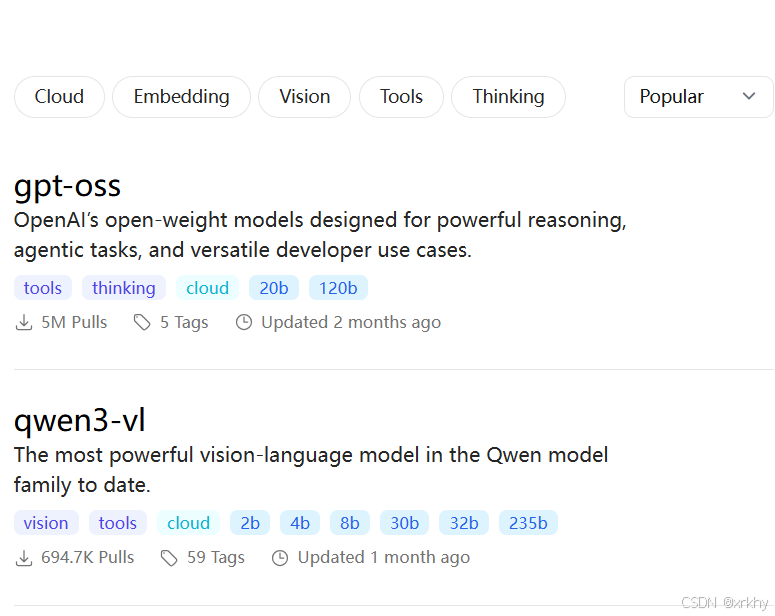

ollama是一个模型管理工具和平台,它提供了很多国内外常见的模型,我们可以在其官网上搜索自己需要的模型:https://ollama.com/search

如图,目前热度排第一的就是gpt-oss:

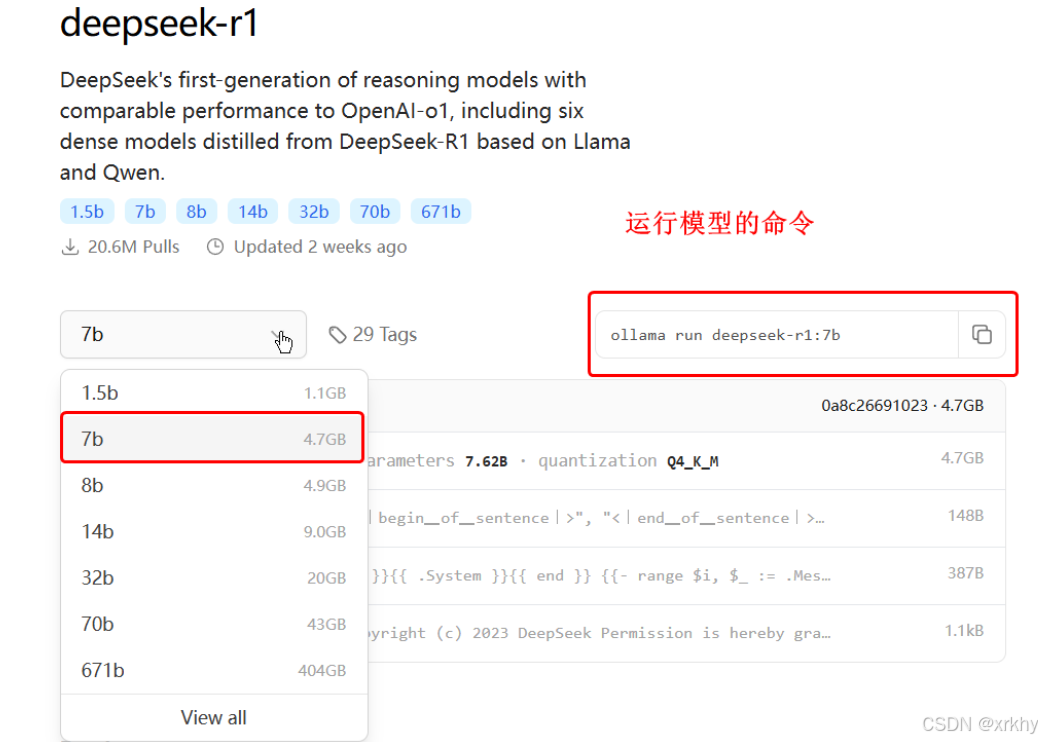

我们使用deepseek-r1,点击进入deepseek-r1页面,会发现deepseek-r1也有很多版本:

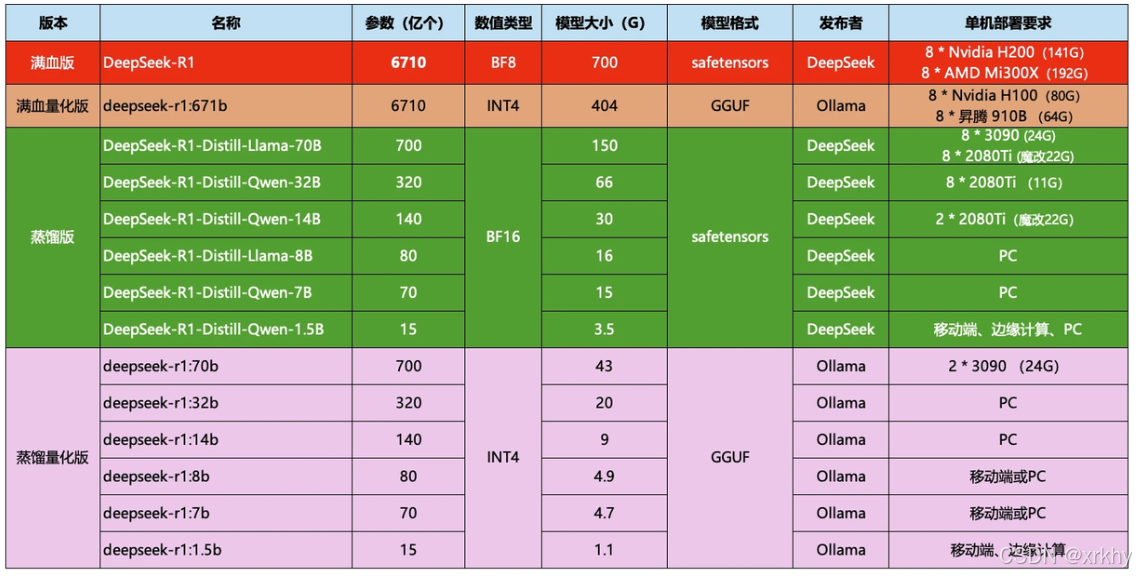

这些就是模型的参数大小,越大推理能力就越强,需要的算力也越高。671b版本就是最强的满血版deepseek-r1了。需要注意的是,Ollama提供的DeepSeek是量化压缩版本,对比官网的蒸馏版会更小,对显卡要求更低。对比如下:

比如,我的电脑内存32G,显存是6G,我选择部署的是7b的模型,当然8b也是可以的,差别不大,都是可以流畅运行的。

运行模型

选择自己合适的模型后,ollama会给出运行模型的命令:

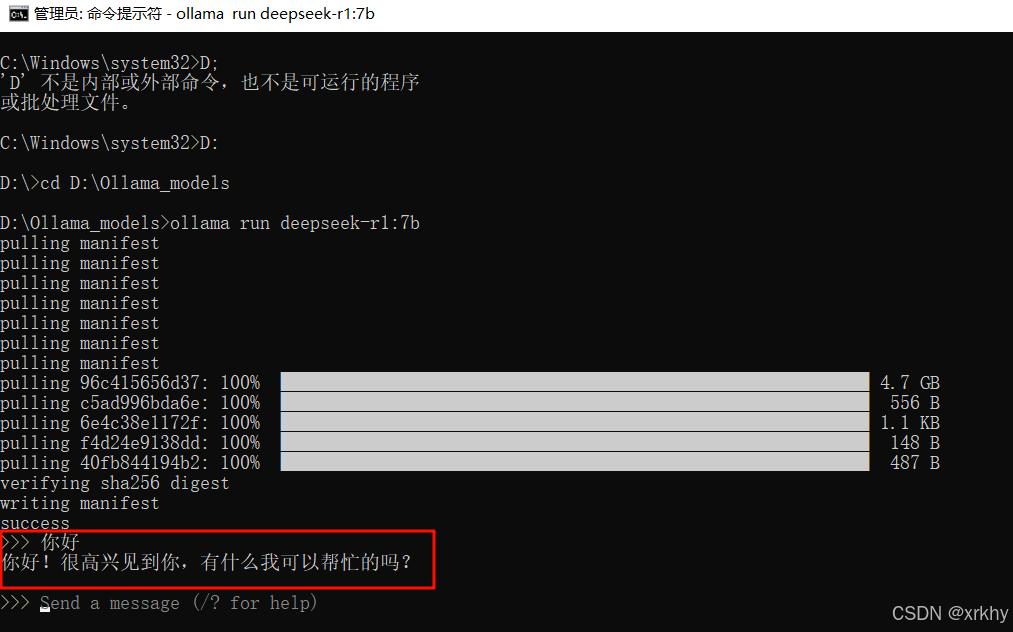

复制这个命令,然后打开一个cmd命令行管理员身份进入,运行命令即可,然后你就可以跟本地模型聊天了:

注意:

- 首次运行命令需要下载模型,根据模型大小不同下载时长在5分钟~1小时不等,请耐心等待下载完成。

- ollama控制台是一个封装好的AI对话产品,与ChatGPT类似,具备会话记忆功能。

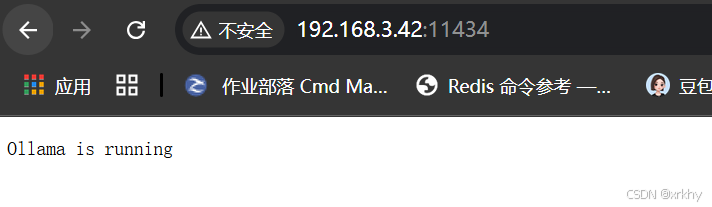

然后访问:http://你的IP+11434

出现running说明Ollama启动正常

Ollama常用指令

- 查看已经安装的模型:

ollama list - 下载模型:

ollama pull 模型名称(比如:deepseek-r1:1.5b)运行模型:

ollama run 模型名称(deepseek-r1:1.5b) - 删除模型:

ollama rm 模型名称 - 查看模型信息

ollama show 模型名称 - 查看当前模型

ollama ps - 停⽌模型

ollama stop 模型名称

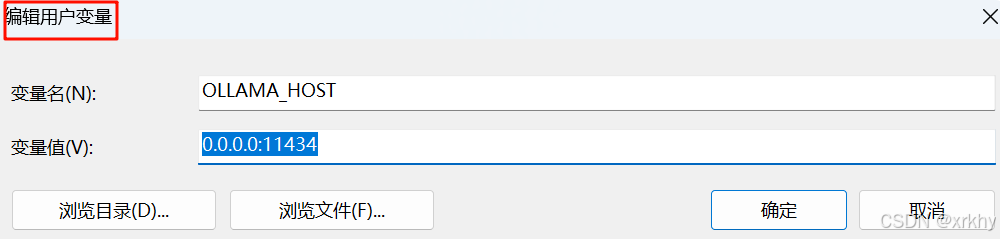

监听端口配置(可选)

如果自己电脑的11434端口被占用了,给Ollama指定一个其他端口,在系统环境变量⾥设置:

变量名:OLLAMA_HOST

变量值(端⼝)::端口(端口前⾯有个冒号)

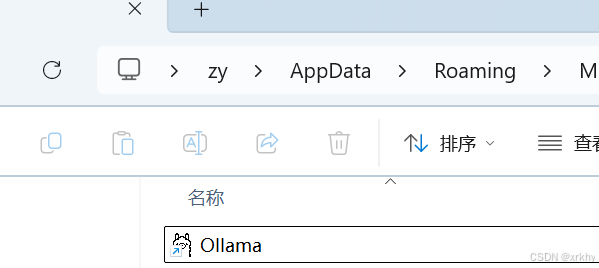

ollama关闭开机启动(可选)

Ollama默认会随Windows⾃动启动,可以在⽂件资源管理器的地址栏中访问以下路径,删除其中的Ollama.lnk快捷⽅式⽂件,阻⽌它⾃动启动

bash

%APPDATA%\Microsoft\Windows\StartMenu\Programs\Startup

重启电脑后,就算完成安装和配置了

Dify关联Ollama

Dify 是通过Docker部署的,而Ollama 是运行在本地电脑的,得让Dify能访问Ollama 的服务。在环境变量中添加配置

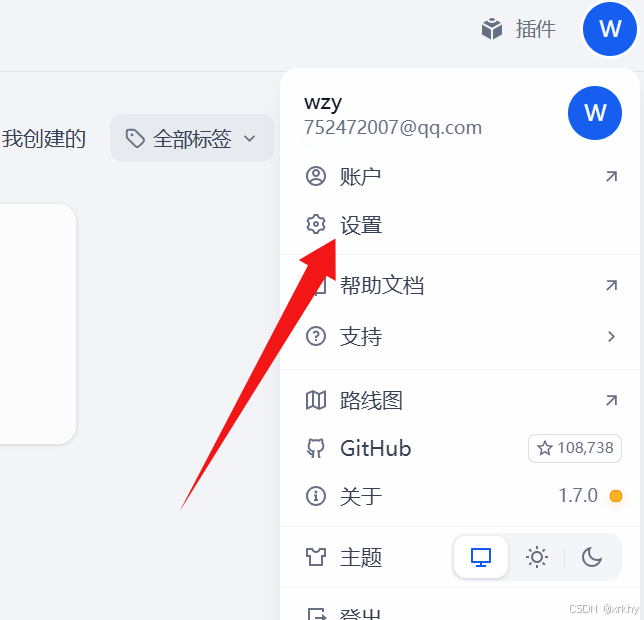

在Dify的主界面http://localhost/apps,点击右上角用户名下的【设置】

这里的模型号要和你的大模型一致

使用大模型

然后点击