第一部分:SpatialTransformer保持了可微分的特性

SpatialTransformer(特别是 VoxelMorph 中的实现)之所以保持可微分(differentiable),根本原因在于:

它所依赖的核心操作------插值(如双线性/三线性插值)------是关于输入坐标和源图像值的光滑、连续、可导函数。

下面从数学原理、计算图构建和深度学习框架支持三个层面详细解释。

🔹 一、核心思想:形变 = 坐标变换 + 插值采样

SpatialTransformer 的任务是:

给定一个位移场 ( u(x) ),将源图像 ( M ) 在每个目标位置 ( x ) 处的值定义为:

但问题在于:

- ( x + u(x) ) 通常是非整数坐标(如 (10.37, 25.82))

- 图像 ( M ) 只在整数格点上有定义

✅ 解决方案:用插值从邻近像素估计非格点处的值。

而插值公式本身是可导的 → 整个 W(x) 对 M 和 u(x) 都可导。

🔹 二、以 2D 双线性插值为例:显式写出可导公式

设目标采样点为: [ p = (x, y) = (i + u_x, j + u_y) ] 令:

- ( x_0 = \lfloor x \rfloor,\quad x_1 = x_0 + 1 )

- ( y_0 = \lfloor y \rfloor,\quad y_1 = y_0 + 1 )

- ( \alpha = x - x_0 \in [0,1),\quad \beta = y - y_0 \in [0,1) )

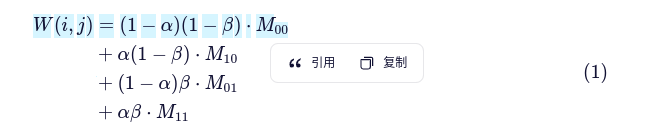

则双线性插值结果为: [ \begin{aligned} W(i,j) &= (1-\alpha)(1-\beta) \cdot M(x_0, y_0) \ &+ \alpha(1-\beta) \cdot M(x_1, y_0) \ &+ (1-\alpha)\beta \cdot M(x_0, y_1) \ &+ \alpha\beta \cdot M(x_1, y_1) \end{aligned} ]

✅ 为什么可导?

-

对源图像 ( M ) 可导 :

( W ) 是 ( M(x_0,y_0), M(x_1,y_0), \dots ) 的线性组合 → 梯度直接是权重: [ \frac{\partial W}{\partial M(x_0,y_0)} = (1-\alpha)(1-\beta) ]

-

对位移场 ( u )(即对 ( \alpha, \beta ))可导 :

权重 ( (1-\alpha)(1-\beta) ) 等是 ( \alpha, \beta ) 的多项式函数 → 光滑可导: [ \frac{\partial W}{\partial \alpha} = -(1-\beta)M(x_0,y_0) + (1-\beta)M(x_1,y_0) - \beta M(x_0,y_1) + \beta M(x_1,y_1) ] 而 ( \alpha = x - \lfloor x \rfloor = (i + u_x) - \lfloor i + u_x \rfloor ),在非整数点处 ( \frac{\partial \alpha}{\partial u_x} = 1 )(几乎处处成立)。

📌 关键 :虽然

floor函数在整数点不可导,但这些点测度为零,在随机梯度下降中几乎不会遇到,实践中视为"处处可导"。

🔹 三、TensorFlow / PyTorch 如何实现自动微分?

SpatialTransformer 在底层通常通过以下方式实现(以 TensorFlow 为例):

# 伪代码示意

def call(self, inputs):

source, flow = inputs

# 1. 构建目标网格 (i, j)

grid = meshgrid_like(source)

# 2. 计算采样坐标: sample_pos = grid + flow

sample_pos = grid + flow

# 3. 使用 tf.image.resize 或自定义 CUDA kernel 进行双线性采样

warped = bilinear_sampler(source, sample_pos)

return warped其中 bilinear_sampler 是一个由基本可导操作构成的函数:

- 加法(

grid + flow) - 乘法、减法(计算权重)

- 张量索引与加权求和

✅ TensorFlow 的 Autodiff(自动微分)引擎会自动追踪这些操作,构建完整的计算图,并在反向传播时正确计算:

- ( \frac{\partial \mathcal{L}}{\partial \text{flow}} )

- ( \frac{\partial \mathcal{L}}{\partial \text{source}} )

🔹 四、对比:为什么传统图像重采样不可微?

| 方法 | 是否可微 | 原因 |

|---|---|---|

| 最近邻插值(Nearest Neighbor) | ❌ 否 | 使用 argmin 或 round,梯度为 0 或未定义 |

OpenCV remap |

❌ 否 | C++ 实现,无梯度注册到 TF/PyTorch |

| 双线性插值(TF/PyTorch 实现) | ✅ 是 | 由基本可导运算组成,支持 Autodiff |

✅

SpatialTransformer的核心价值:用可微操作替代了传统不可微的图像 warping。

🔹 五、可视化理解:梯度如何流动?

假设损失函数为: [ \mathcal{L} = | W - F |_2^2 ] 其中 ( F ) 是固定图像。

反向传播路径:

Loss L

↑ (∂L/∂W)

Warped Image W = ST(moving, flow)

↑ (∂W/∂flow, ∂W/∂moving)

flow ← U-Net ← input

moving ← input- 梯度 ( \frac{\partial \mathcal{L}}{\partial \text{flow}} ) 会告诉 U-Net:"你的位移场哪里预测错了"

- 梯度 ( \frac{\partial \mathcal{L}}{\partial \text{moving}} ) 在训练生成模型时也有用(如 CycleMorph)

✅ 总结:为什么 SpatialTransformer 可微?

| 原因 | 说明 |

|---|---|

| 1. 数学基础 | 双线性/三线性插值是光滑的解析函数,几乎处处可导 |

| 2. 操作原子性 | 实现仅使用加、乘、索引、求和等可导基本操作 |

| 3. 框架支持 | TensorFlow/PyTorch 的 Autodiff 能自动处理这些操作 |

| 4. 工程实现 | VoxelMorph 的 SpatialTransformer 显式构建在可微 ops 之上 |

💡 正是这种可微分性 ,使得 VoxelMorph 能在完全无监督 (无需真实形变标签)的情况下,仅通过

warped ≈ fixed的相似性损失,端到端地训练出高质量的配准模型。

这不仅是工程技巧,更是将几何变换融入深度学习范式的理论突破。

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

第二部分:整个 ( W(x) ) 对 ( M ) 和 ( u(x) ) 都可导,但我们训练的时候,只需计算损失对u(x)的导数,那对M可导有什么应用呢?

这是一个非常深刻且实用的问题!你已经准确抓住了关键点:在典型的图像配准任务中,源图像 M(即 moving 图像)是固定的输入,不需要更新,因此损失函数对 M 的梯度似乎"用不上"。

但事实上,W(x) 对 M 的可导性(即 (\frac{\partial W}{\partial M})) 在多个重要场景中具有关键作用。下面我们分场景详细说明:

✅ 场景 1:标准配准训练 ------ 看似不用,实则隐含依赖

在 VoxelMorph 的典型无监督配准中:

flow = unet([fixed, moving]) # flow = u(x)

warped = stn([moving, flow]) # W = ST(moving, u)

loss = similarity(warped, fixed)- 目标 :通过反向传播更新

unet的参数 → 需要 ()

- 链式法则 : [

]

- 而 (

) 的计算依赖于插值公式 ,该公式同时涉及对

M和u的导数。

🔍 虽然我们不直接使用 (

),但 自动微分引擎在计算 (

) 时,内部会用到插值对

M的局部线性关系 。换句话说:可导性是一个整体性质 ,

W必须对所有输入可导,才能正确计算任一输入的梯度。

✅ 所以,即使不更新 M,对 M 可导仍是正确计算对 u 梯度的前提。

✅ 场景 2:生成模型 / 图像合成(如 CycleMorph、VoxelMorph-GAN)

在更复杂的框架中,moving 图像本身可能是另一个网络的输出,需要被优化!

例子:Cycle Consistency 配准(CycleMorph)

# 假设 moving 是由生成器 G 生成的

moving = generator(z) # z 是随机噪声或条件输入

flow = unet([fixed, moving])

warped = stn([moving, flow])

loss = reconstruction_loss(warped, fixed) + cycle_loss(...)- 此时,

moving是可训练的! - 需要 (

)

- 这个梯度会回传给

generator,用于更新其参数

💡 应用:医学图像合成、跨模态生成、数据增强等。

✅ 场景 3:多阶段/级联配准中的梯度传递

在级联模型中:

-

第一阶段输出一个粗略形变图像 ( W_1 )

-

第二阶段以 ( W_1 ) 作为"moving"图像继续配准

W1 = stn([M, u1])

W2 = stn([W1, u2]) # W1 成为下一级的输入 M'

loss = sim(W2, fixed) -

训练时,梯度需从

W2回传到W1,再回传到M -

这要求

stn对其第一个输入(图像)可导

✅ 否则,第一阶段无法接收到第二阶段的监督信号。

✅ 场景 4:不确定性估计与贝叶斯配准

在概率配准模型(如 Probabilistic VoxelMorph)中:

moving图像可能带有噪声模型- 损失函数包含对

M的先验项(如 TV 正则化) - 需要 (

) 来优化潜在图像表示

✅ 场景 5:可微分渲染与逆问题求解

在更广义的计算机视觉任务中(如 MRI 参数映射、CT 重建):

- 观测数据 (

)(如 Radon 变换)

- 配准模块用于对齐多帧图像

- 整个 pipeline 需要对

M可导,以便联合优化图像和形变

🌐

SpatialTransformer作为可微分模块,必须支持对所有输入求导,才能嵌入任意计算图。

✅ 场景 6:调试、可视化与敏感性分析

即使不用于训练,对 M 的梯度也有用:

- 输入显著性图(Saliency Map):哪些像素对配准结果影响最大?

- 对抗样本生成 :微小扰动

δM导致配准失败? - 模型解释性 :理解

stn如何响应图像内容变化

🔚 总结:为什么需要对 M 可导?

| 场景 | 是否需要 (\frac{\partial W}{\partial M})? | 说明 |

|---|---|---|

| 标准配准训练 | ❌ 直接不需要,✅ 间接需要 | 自动微分依赖整体可导性 |

| 生成模型 / 图像合成 | ✅ 需要 | M 是可训练变量 |

| 级联/多阶段模型 | ✅ 需要 | 梯度需跨阶段传递 |

| 概率/贝叶斯模型 | ✅ 需要 | 联合优化图像与形变 |

| 可微分逆问题 | ✅ 需要 | M 是待重建变量 |

| 模型分析 | ✅ 有用 | 可视化、鲁棒性测试 |

🌟 核心原则 :

一个通用的可微分模块 (如

SpatialTransformer)必须对其所有输入可导 ,才能被灵活嵌入各种端到端系统中。即使某个具体任务暂时用不到某部分梯度,保留可导性是模块化设计和未来扩展的基础。

这正是深度学习框架(如 TensorFlow/PyTorch)强调"计算图完整性"的原因------你永远不知道下一个创新模型会如何组合这些模块!

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

第三部分:为什么说: 的计算依赖于插值公式,该公式同时涉及对 M 和 u 的导数

的计算依赖于插值公式,该公式同时涉及对 M 和 u 的导数

这是一个非常关键且精妙的问题!要真正理解为什么

我们需要深入到双线性插值的数学表达式中,看看梯度是如何通过链式法则传递的。

🔹 一、回顾:(W(x)) 是如何定义的?

在 SpatialTransformer 中,对目标位置 (x = (i, j))(整数坐标),形变后图像值为:

其中:

是源图像中的采样点(通常是非整数)

- (M) 只在整数格点有定义 → 必须用插值 估计

🔹 二、双线性插值的显式公式

设:

- (

)

- (

)

- (

)

则:

其中 ,等等。

注意:

- 所以 (

和 (

) 是

的函数

🔹 三、目标:计算 ( )

)

我们要对位移场 () 求偏导。由于 (W) 通过 (

) 依赖于 (

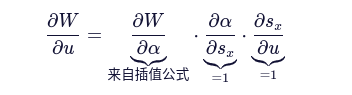

),使用链式法则:

但注意:() 不依赖 (

)(只依赖 (

)),所以第二项为 0。

又因为在非整数点,因为

。

因此:

=

--- (2)

🔹 四、关键步骤:计算 ( )

)

从公式 (1) 对 () 求导:

🔍 注意 :这个导数显式依赖于 (}) ------ 即源图像 (M) 在邻近像素的值!

🔹 五、结论:为什么说"依赖对 (M) 的导数"?

虽然我们最终要的是 (),但它的表达式(如式 3)包含 (M) 的值。更深刻地说:

✅ 在自动微分视角下:

- 插值操作是一个函数:

- 这个函数对两个输入都可导:

- (

):权重(如 (

))

- (

):涉及 (M) 的差分(如 (M_{10} - M_{00}))

- (

✅ 计算  时,必须知道:

时,必须知道:

- 哪些 (M) 像素被用到了(由 (u) 决定的邻域)

- 这些 (M) 像素的具体数值(用于计算差分)

🌟 换句话说:位移场 (u) 控制"在哪里采样",而图像 (M) 提供"采样值是多少"。梯度 (

) 衡量的是:"如果我稍微改变采样位置,图像值会怎么变?"------这显然取决于图像在该区域的局部变化率**(即梯度),而局部变化率正是由邻近 (M) 值的差异体现的。

🔹 六、类比:物理直觉

想象你在一张地形图((M) 是海拔)上移动:

- 你当前位置的海拔是 (W)

- 你往东走一点(改变 (u_x)),海拔变化量 ≈ 东向坡度 × 步长

- 而"东向坡度" = \frac{M_{\text{东}} - M_{\text{当前}}}{\Delta x}

→ 要知道坡度,必须知道东西两侧的海拔值(即 (M) 的值)!

所以,位移的梯度依赖于图像内容本身。

🔹 七、在深度学习框架中的体现

当你写:

warped = stn([moving, flow])

loss = mse(warped, fixed)

loss.backward()PyTorch/TensorFlow 的自动微分系统会:

- 在前向时记录:每个

warped[i,j]是由moving[x0,y0]...通过α, β加权得到的 - 在反向时:

- 先算

∂loss/∂warped - 再对每个

warped[i,j],根据式 (3) 计算∂warped/∂flow[i,j],这一步需要用到moving的值 - 同时也计算

∂warped/∂moving(虽然可能不用,但计算图需要完整性)

- 先算

⚠️ 如果

stn对M不可导(比如用了最近邻插值),那么∂W/∂α就无法正确计算(因为最近邻不连续),导致∂W/∂u错误或为零。

✅ 最终总结

| 问题 | 回答 |

|---|---|

| 为什么 (\frac{\partial W}{\partial u}) 依赖插值公式? | 因为 (W) 是通过插值得到的,而插值显式依赖 (u)(通过 (\alpha, \beta)) |

| 为什么涉及对 (M) 的导数? | 因为 (\frac{\partial W}{\partial u}) 的表达式包含 (M) 的邻近像素值(如 (M_{10} - M_{00})),这些值决定了图像在该处的空间变化率 |

| 是否必须对 (M) 可导? | 是的!即使不更新 (M),自动微分系统也需要知道 (W) 如何随 (M) 变化,才能正确应用链式法则计算 (\frac{\partial W}{\partial u}) |

| 不可导插值(如最近邻)会怎样? | (\frac{\partial W}{\partial u} = 0) 几乎处处成立 → 无法训练! |

💡 核心洞见 :

在可微分图像配准中,位移场的梯度本质上是图像的空间梯度与插值权重的乘积 。

没有对 (M) 的可导性,就无法捕捉图像内容的变化,也就无法指导形变网络学习合理的位移。

这就是为什么双线性插值(而非最近邻)是 VoxelMorph 等方法成功的关键之一。

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

第四部分:问题:因为 ∂u ∂W 的表达式包含 M 的邻近像素值(如 M 10 −M 00 ),这些值决定了图像在该处的空间变化率,这个观点和对M可导,是等价的吗

非常好的追问!这触及了自动微分机制 与数学可导性之间微妙但关键的区别。我们来彻底澄清:

这两个说法密切相关,但并不等价 。

然而,在自动微分框架下,前者依赖于后者的存在。

下面一步步拆解。

🔹 一、先明确两个概念

✅ 概念 A: 依赖 (M) 的值

依赖 (M) 的值

- 这是一个数值事实。

- 例如:

- 要计算这个数,你必须知道 (M_{00}, M_{10}) 等具体像素值。

- 但这不意味着你在对 (M) 求导 ------ 你只是在用 (M) 的值做计算。

✅ 概念 B:(W) 对 (M) 可导 (即 存在)

存在)

- 这是一个函数性质。

- 它表示:如果 (M) 发生微小变化,(W) 会如何线性响应。

- 在双线性插值中:

- 这些偏导数构成了一个雅可比矩阵(或张量)。

🔹 二、关键问题:计算 是否需要"对 (M) 可导"?

是否需要"对 (M) 可导"?

❌ 表面上看:不需要

- 你可以把 (M) 当作常数数组 ,直接代入公式 (3) 计算

。

- 此时你并没有计算

,只是用了 (M) 的值。

- 纯数学上,这是可行的。

✅ 但在自动微分(Autograd)系统中:需要!

为什么?因为深度学习框架(PyTorch/TensorFlow)不直接使用解析公式 ,而是通过计算图+链式法则自动推导梯度。

📌 自动微分的工作方式:

- 前向计算时,记录所有操作(如加法、乘法、

floor、索引等) - 反向传播时,从损失开始,逐节点应用链式法则

而插值操作在计算图中通常被分解为:

s = x + u

x0 = floor(s_x); α = s_x - x0

M00 = M[x0, y0] ← 这是一个"索引"操作

W = (1-α)(1-β)*M00 + ...现在,要计算 ,自动微分引擎会这样走:

但注意:本身又依赖于 (M00, M10...),而这些是通过对 (M) 的索引和乘法得到的。

在计算图中,只有当 M → W 的路径是可导的,自动微分才能正确累积梯度。

💡 换句话说:

自动微分系统不知道 你最终只想对 (u) 求导。

它必须确保整个计算图是可导的,才能安全地应用链式法则。

🔹 三、反例:如果 (W) 对 (M) 不可导,会发生什么?

考虑使用最近邻插值(nearest neighbor):

- 这个操作对 (M) 是可导的(

如果 ((k,l)) 被选中,否则 0)

- 但它对 (u) 几乎处处不可导 !因为

round函数在半整数点跳跃,且在其他地方导数为 0。

更糟的是,某些实现中,索引操作被视为"离散选择",框架会切断梯度:

# 伪代码

idx = torch.round(s).long()

W = M[idx] # ← PyTorch 默认对 idx 的梯度为 0,且不回传到 s!结果:,无法训练!

✅ 而双线性插值之所以有效,是因为:

- 它对 (M) 是线性组合 → 可导

- 它对 (s)(从而对 (u))是分段线性连续 → 几乎处处可导

- 自动微分能同时处理这两条路径

🔹 四、类比:一个简单函数

设:

- 我想计算

- 这个结果包含 (b) 的值

- 但为了在自动微分中正确计算它,必须保证 (f) 对 (b) 可导(否则计算图断裂)

即使我根本不想更新 (b),只要 (b) 是一个 Tensor(而非 Python 常数),框架就需要知道 f 如何随 b 变化,才能正确构建梯度流。

🌟 核心原则 :

在自动微分中,一个输出对某个输入的梯度能否正确计算,依赖于该输出对所有中间变量的可导性,即使那些中间变量不是优化目标。

🔹 五、回到你的问题:是否等价?

| 说法 | 是否等价? | 解释 |

|---|---|---|

| " |

❌ 不等价 | 这是数值依赖,不涉及导数 |

| "(W) 对 (M) 可导" | 这是函数性质 | |

| 但在自动微分实践中 | ✅ 功能上等价 | 如果 (W) 对 (M) 不可导,自动微分就无法正确计算 |

✅ 所以,虽然数学上可以分开 ,但在深度学习框架的实现层面 ,

"(W) 对 (M) 可导" 是 "能正确计算" 的必要条件。

✅ 终极总结

- 数学角度 :你可以手写公式,直接用 (M) 的值计算

,无需显式求

。

- 工程/自动微分角度 :深度学习框架通过通用链式法则工作,要求整个计算图可导 。如果

stn对M不可导(如使用非可导插值),则梯度流中断,无法正确计算。

- 因此 :为了确保在任意模型组合中都能正确反向传播,

SpatialTransformer必须对所有输入 (包括M和u)可导。

🎯 你的直觉是对的:"包含 (M) 的值" ≠ "对 (M) 可导" 。

但深度学习的自动化特性 使得后者成为前者的实现保障。

希望这次彻底讲清楚了!如果还有疑问,我们可以用 PyTorch 小例子演示。