引言

在现代微服务架构中,容器网络不仅仅是简单的容器间通信,更是构建分布式系统的基石。今天我们将深入探讨Docker容器网络的进阶主题,包括容器互联、跨主机通信以及资源限额管理。无论你是开发者还是运维工程师,掌握这些知识都将让你从容应对复杂的容器化部署场景。

一、Docker容器互联

1. 容器互联的局限性

使用docker network ls命令可以查看当前的网络配置,但传统的容器互联方式存在明显的局限性:

bash

# 查看当前网络

$ docker network ls

NETWORK ID NAME DRIVER SCOPE

abc123def456 bridge bridge local

xyz789uvw012 host host local

mno345pqr678 none null local2. --link参数:单向通信的老方法

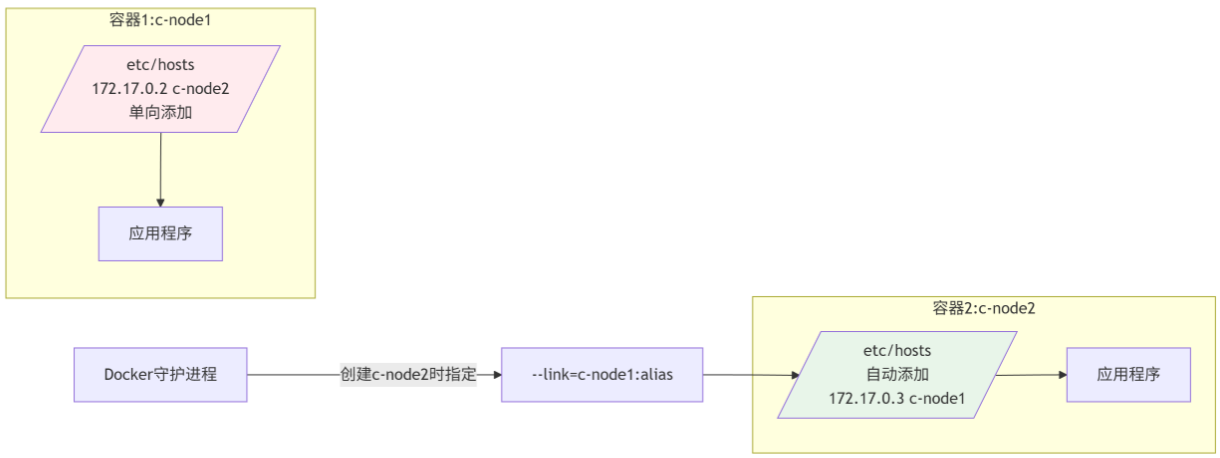

--link参数曾是Docker早期实现容器互联的主要方式,但其工作原理简单且有明显限制:

实际操作演示:

bash

# 1. 创建第一个容器

$ docker run -itd --name=c-node1 centos:test

# 2. 创建第二个容器并链接到第一个(单向)

$ docker run -itd --name=c-node2 --link=c-node1 centos:test

# 3. 验证单向通信

$ docker exec c-node2 ping c-node1

PING c-node1 (172.17.0.2): 56 data bytes

64 bytes from 172.17.0.2: seq=0 ttl=64 time=0.085 ms

# 成功

$ docker exec c-node1 ping c-node2

ping: bad address 'c-node2'

# 失败3. 双向互联的手动实现

要实现真正的双向通信,需要手动配置:

bash

# 1. 获取容器IP地址

$ docker inspect -f '{{range .NetworkSettings.Networks}}{{.IPAddress}}{{end}}' c-node1

172.17.0.2

$ docker inspect -f '{{range .NetworkSettings.Networks}}{{.IPAddress}}{{end}}' c-node2

172.17.0.3

# 2. 手动修改/etc/hosts(需要进入容器)

$ docker exec c-node1 sh -c "echo '172.17.0.3 c-node2' >> /etc/hosts"

$ docker exec c-node2 sh -c "echo '172.17.0.2 c-node1' >> /etc/hosts"

# 3. 验证双向通信

$ docker exec c-node1 ping c-node2

PING c-node2 (172.17.0.3): 56 data bytes

64 bytes from 172.17.0.3: seq=0 ttl=64 time=0.092 ms

# 成功重要限制:

-

--link无法通过docker update动态添加 -

容器重启后手动修改的

/etc/hosts会丢失 -

不适合大规模容器编排场景

二、跨主机容器通信:生产环境的挑战与解决方案

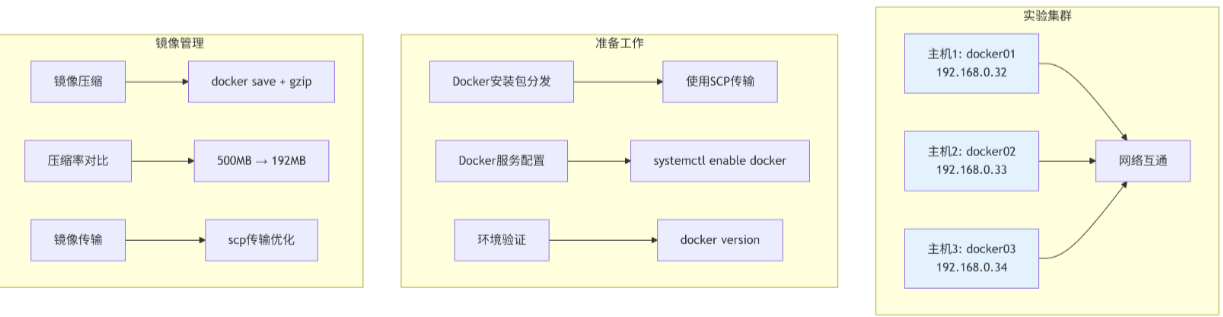

1. 实验环境搭建

1.1 Docker环境部署脚本

bash

#!/bin/bash

# deploy-docker.sh - 批量部署Docker环境

HOSTS=("192.168.0.32" "192.168.0.33" "192.168.0.34")

# 1. 传输安装包

for host in "${HOSTS[@]}"; do

echo "正在部署 $host"

scp docker-install.tar.gz root@$host:/tmp/

ssh root@$host "tar -zxvf /tmp/docker-install.tar.gz -C /tmp/"

done

# 2. 安装Docker

install_docker() {

yum remove -y docker*

yum install -y /tmp/docker/*.rpm

systemctl enable docker

systemctl start docker

docker version

}

# 3. 压缩并传输基础镜像

echo "压缩CentOS镜像..."

docker save centos:7 | gzip -9 > centos-7.tar.gz

ls -lh centos-7.tar.gz

# -rw-r--r-- 1 root root 192M Jan 15 10:30 centos-7.tar.gz

# 4. 分发镜像到所有主机

for host in "${HOSTS[@]}"; do

scp centos-7.tar.gz root@$host:/root/

ssh root@$host "docker load -i /root/centos-7.tar.gz"

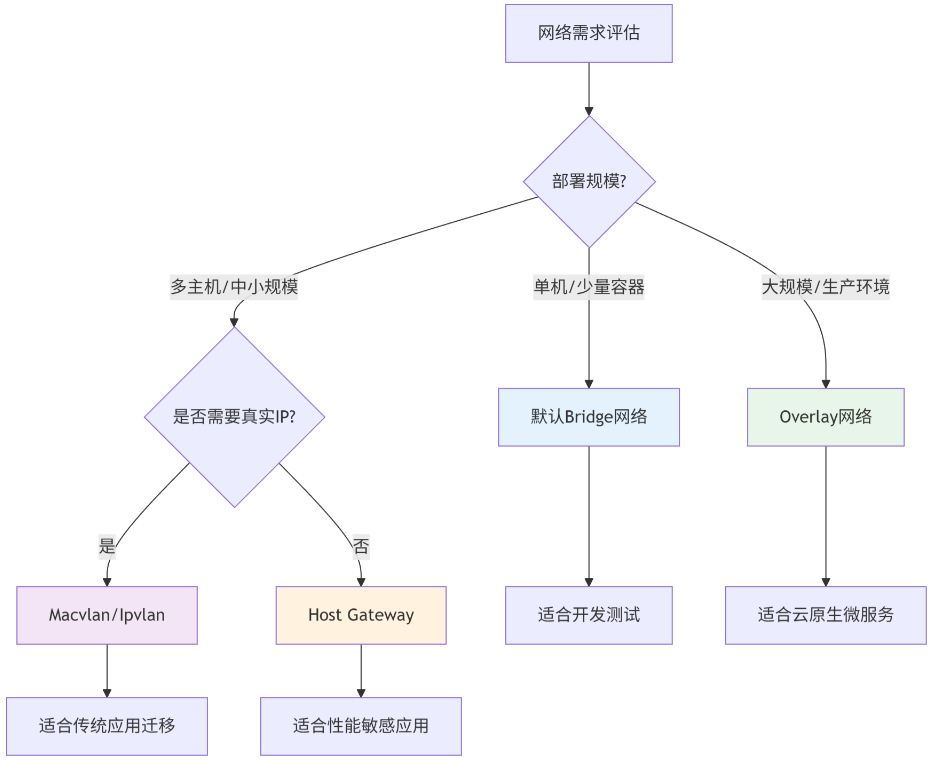

done2. 跨主机通信网络方案对比

| 网络类型 | 实现原理 | 优点 | 缺点 | 适用场景 |

|---|---|---|---|---|

| Macvlan | 物理网卡混杂模式+虚拟MAC地址 | 1. 性能接近物理网络 2. 容器直接获真实IP | 1. IP地址消耗快 2. 交换机需支持混杂模式 3. VLAN管理复杂 | 小型网络,容器需要真实IP |

| Overlay | VXLAN隧道封装 | 1. 支持大规模部署 2. IP重叠没问题 3. 自动服务发现 | 1. 需要外部KV存储 2. 有封装开销 3. 配置较复杂 | 生产环境,多云/多数据中心 |

| Host Gateway | 主机路由 | 1. 性能较好 2. 无封装开销 | 1. 需要路由表支持 2. 网络规模受限 | 可控的内部网络环境 |

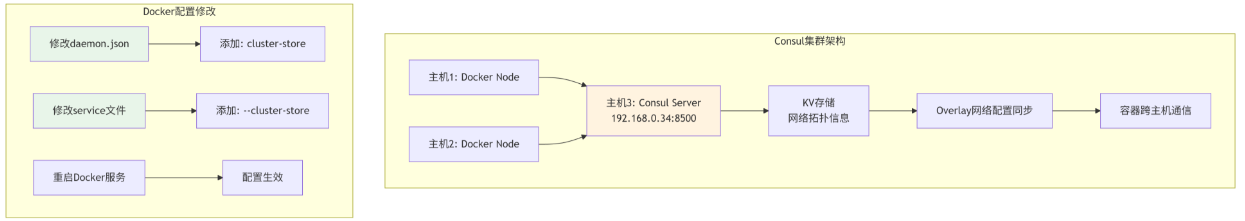

3. Overlay网络实战:基于Consul的解决方案

3.1 Consul服务部署

bash

# 在主机3(192.168.0.34)上启动Consul

$ docker run -d \

--name=consul \

-p 8500:8500 \

-p 8600:8600/udp \

-h consul \

--restart=always \

consul agent -server -bootstrap -ui -client=0.0.0.0

# 验证Consul运行

$ curl http://192.168.0.34:8500/v1/agent/self3.2 Docker节点配置

bash

# 修改所有节点的docker.service文件

$ vi /usr/lib/systemd/system/docker.service

# 在ExecStart行末尾添加(示例为主机1配置)

ExecStart=/usr/bin/dockerd -H fd:// --containerd=/run/containerd/containerd.sock \

--cluster-store=consul://192.168.0.34:8500 \

--cluster-advertise=ens32:2376

# 重新加载并重启服务

$ systemctl daemon-reload

$ systemctl restart docker

$ systemctl status docker

# 验证节点注册

# 访问 http://192.168.0.34:8500/ui 查看节点信息3.3 创建Overlay网络

bash

# 在任何节点创建Overlay网络

$ docker network create \

--driver overlay \

--subnet 10.10.0.0/16 \

--gateway 10.10.0.1 \

my-overlay

# 查看网络创建情况(在所有节点都会看到)

$ docker network ls

NETWORK ID NAME DRIVER SCOPE

xyz789uvw012 bridge bridge local

abc123def456 host host local

efg456hij789 my-overlay overlay global # 注意:SCOPE为global

mno345pqr678 none null local

# 查看网络详细信息

$ docker network inspect my-overlay

[

{

"Name": "my-overlay",

"Id": "efg456hij789...",

"Created": "2024-01-15T11:00:00Z",

"Scope": "global",

"Driver": "overlay",

"EnableIPv6": false,

"IPAM": {

"Driver": "default",

"Options": null,

"Config": [

{

"Subnet": "10.10.0.0/16",

"Gateway": "10.10.0.1"

}

]

},

"Internal": false,

"Attachable": false,

"Ingress": false,

"Containers": {},

"Options": {

"com.docker.network.driver.overlay.vxlanid_list": "4096"

},

"Labels": {}

}

]4. 跨主机容器通信验证

4.1 在不同主机创建容器

bash

# 在主机1上创建容器

$ docker run -itd \

--name=container1 \

--net=my-overlay \

--ip=10.10.0.10 \

centos:7

# 在主机2上创建容器

$ docker run -itd \

--name=container2 \

--net=my-overlay \

--ip=10.10.0.20 \

centos:7

# 在主机3上创建容器

$ docker run -itd \

--name=container3 \

--net=my-overlay \

--ip=10.10.0.30 \

centos:74.2 通信测试与网络分析

bash

# 从container1测试到其他容器的连通性

$ docker exec container1 ping -c 3 10.10.0.20

PING 10.10.0.20 (10.10.0.20): 56 data bytes

64 bytes from 10.10.0.20: seq=0 ttl=64 time=0.356 ms

64 bytes from 10.10.0.20: seq=1 ttl=64 time=0.289 ms

64 bytes from 10.10.0.20: seq=2 ttl=64 time=0.301 ms

$ docker exec container1 ping -c 3 10.10.0.30

PING 10.10.0.30 (10.10.0.30): 56 data bytes

64 bytes from 10.10.0.30: seq=0 ttl=64 time=0.412 ms

64 bytes from 10.10.0.30: seq=1 ttl=64 time=0.378 ms

64 bytes from 10.10.0.30: seq=2 ttl=64 time=0.395 ms

# 查看容器网络接口

$ docker exec container1 ip addr show

1: lo: <LOOPBACK,UP,LOWER_UP> mtu 65536 qdisc noqueue state UNKNOWN group default qlen 1000

link/loopback 00:00:00:00:00:00 brd 00:00:00:00:00:00

inet 127.0.0.1/8 scope host lo

valid_lft forever preferred_lft forever

2: eth0: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1450 qdisc noqueue state UP group default

link/ether 02:42:0a:0a:00:0a brd ff:ff:ff:ff:ff:ff

inet 10.10.0.10/16 brd 10.10.255.255 scope global eth0

valid_lft forever preferred_lft forever

3: eth1: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc noqueue state UP group default

link/ether 02:42:ac:12:00:02 brd ff:ff:ff:ff:ff:ff

inet 172.18.0.2/16 brd 172.18.255.255 scope global eth1

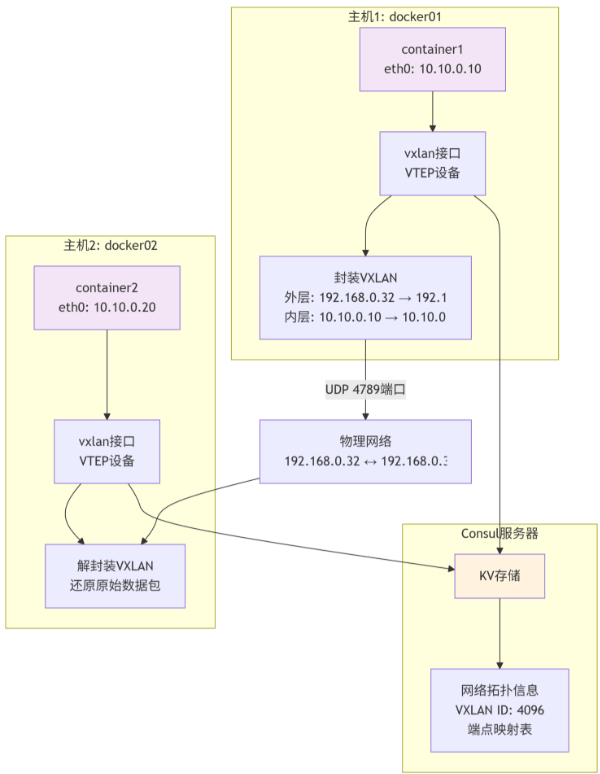

valid_lft forever preferred_lft forever4.3 Overlay网络通信原理

关键机制解析:

-

VXLAN隧道:通过UDP 4789端口建立隧道

-

VTEP设备:每台主机都有虚拟隧道端点

-

Consul协调:存储网络状态和端点映射

-

封包流程:

bash容器数据 → VXLAN封装 → 物理网络 → VXLAN解封 → 目标容器

三、Docker容器资源限额管理

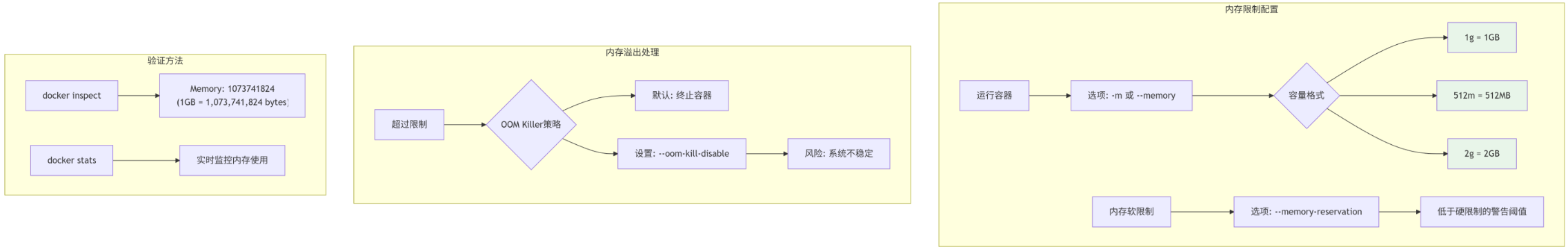

1. 内存资源限制

1.1 内存限制配置示例

bash

# 限制容器最多使用1GB内存

$ docker run -itd \

--name=limited-container \

-m 1g \

--memory-reservation=512m \

--oom-kill-disable=false \

centos:7

# 查看限制配置

$ docker inspect limited-container | grep -A 10 Memory

"Memory": 1073741824, # 1GB的字节表示

"MemoryReservation": 536870912, # 512MB

"MemorySwap": 2147483648, # Swap限制(默认为内存的两倍)

"OomKillDisable": false

# 实时监控内存使用

$ docker stats limited-container

CONTAINER ID NAME CPU % MEM USAGE / LIMIT MEM % NET I/O

abc123def456 limited-container 0.05% 125MiB / 1GiB 12.21% 1.12kB / 0B1.2 内存压力测试

bash

# 创建内存消耗测试容器

$ docker run -itd \

--name=mem-test \

-m 100m \

alpine sh -c "while true; do tail /dev/null; done"

# 在容器内执行内存消耗测试

$ docker exec mem-test sh -c "

# 分配50MB内存

dd if=/dev/zero bs=1M count=50 | tail

echo '50MB allocated successfully'

# 尝试分配更多内存(会触发OOM)

dd if=/dev/zero bs=1M count=60 | tail

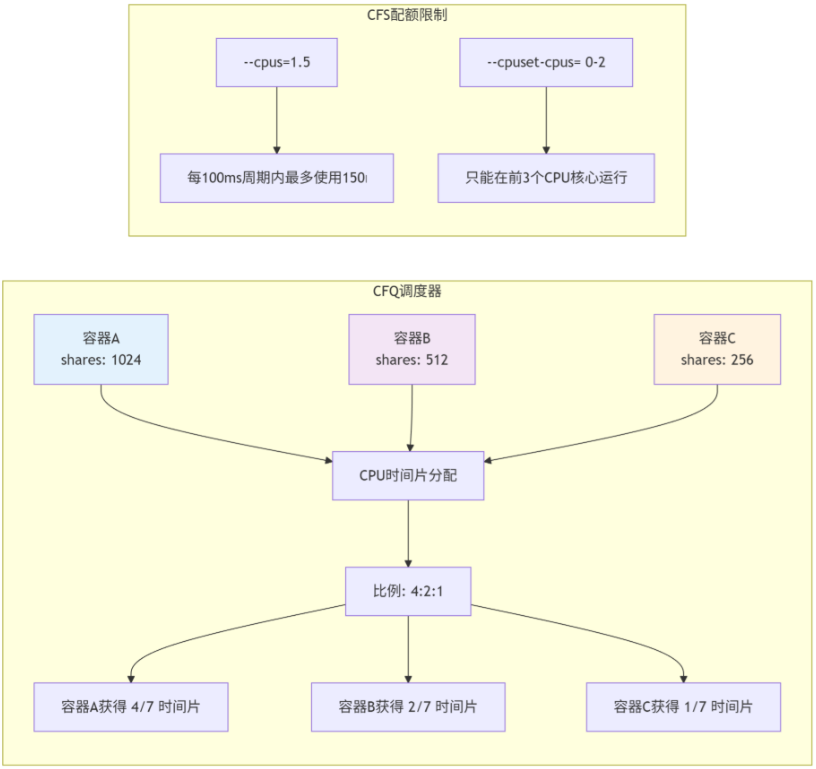

"2. CPU资源限制

2.1 CPU限制配置

bash

# 限制容器最多使用1个CPU核心

$ docker run -itd \

--name=cpu-limited \

--cpus=1.5 \ # 可以使用1.5个CPU核心

--cpuset-cpus="0-2" \ # 只能使用0、1、2号CPU

--cpu-shares=512 \ # 相对权重(默认1024)

centos:7

# 动态调整CPU限制

$ docker update --cpus=2 cpu-limited

# 查看CPU限制

$ docker inspect cpu-limited | grep -i cpu

"CpuShares": 512,

"NanoCpus": 1500000000, # 1.5 CPUs

"CpusetCpus": "0-2",

"CpuPeriod": 100000,

"CpuQuota": 150000,2.2 CPU限制原理详解

3. 磁盘I/O限制

3.1 I/O限制配置

bash

# 创建带I/O限制的容器

$ docker run -itd \

--name=io-limited \

--device-read-bps /dev/sda:10mb \ # 读速率10MB/s

--device-write-bps /dev/sda:5mb \ # 写速率5MB/s

--device-read-iops /dev/sda:1000 \ # 每秒1000次读IO

--device-write-iops /dev/sda:500 \ # 每秒500次写IO

centos:7

# 验证blkio限制

$ docker inspect io-limited | grep -A 5 BlkioWeight

"BlkioWeight": 0,

"BlkioWeightDevice": [],

"BlkioDeviceReadBps": [

{"Path": "/dev/sda", "Rate": 10485760}

],

"BlkioDeviceWriteBps": [

{"Path": "/dev/sda", "Rate": 5242880}

]3.2 I/O性能测试

bash

# 在容器内进行磁盘I/O测试

$ docker exec io-limited sh -c "

# 写入测试(应该受5MB/s限制)

dd if=/dev/zero of=/tmp/test.img bs=1M count=100 oflag=dsync

# 读取测试(应该受10MB/s限制)

dd if=/tmp/test.img of=/dev/null bs=1M

# 清理测试文件

rm -f /tmp/test.img

"4. 综合资源限制策略

4.1 生产环境资源配置示例

bash

# docker-compose.yml中的资源限制配置

version: '3.8'

services:

database:

image: mysql:8.0

deploy:

resources:

limits:

cpus: '2.0'

memory: 4G

reservations:

cpus: '1.0'

memory: 2G

volumes:

- db_data:/var/lib/mysql

environment:

- MYSQL_ROOT_PASSWORD=secret

webserver:

image: nginx:alpine

deploy:

resources:

limits:

cpus: '1.0'

memory: 1G

pids: 100 # 进程数限制

reservations:

cpus: '0.5'

memory: 512M

ports:

- "80:80"

depends_on:

- app

app:

build: .

deploy:

resources:

limits:

cpus: '1.5'

memory: 2G

device_read_bps:

- path: /dev/sda

rate: 50mb

device_write_iops:

- path: /dev/sda

rate: 1000

reservations:

cpus: '0.75'

memory: 1G

environment:

- DATABASE_URL=mysql://database:3306/mydb

volumes:

db_data:4.2 资源监控与报警

bash

#!/bin/bash

# monitor-resources.sh - 容器资源监控脚本

# 监控所有容器的资源使用

monitor_containers() {

while true; do

clear

echo "=== 容器资源监控 $(date) ==="

echo ""

# CPU和内存使用

docker stats --no-stream --format \

"table {{.Name}}\t{{.CPUPerc}}\t{{.MemUsage}}\t{{.MemPerc}}\t{{.NetIO}}\t{{.BlockIO}}"

echo ""

echo "=== 高资源使用告警 ==="

# 检查内存超限

docker stats --no-stream --format \

"{{.Name}},{{.MemPerc}}" | tr -d '%' | while read line; do

container=$(echo $line | cut -d',' -f1)

usage=$(echo $line | cut -d',' -f2)

if [ ${usage%.*} -gt 80 ]; then

echo "⚠️ 警告: 容器 $container 内存使用率 $usage% > 80%"

fi

done

sleep 5

done

}

# 生成资源使用报告

generate_report() {

echo "生成容器资源使用报告..."

docker stats --no-stream --format \

"json" > /tmp/docker-stats-$(date +%Y%m%d-%H%M%S).json

# 分析趋势

echo "分析最近一小时资源使用趋势..."

# 这里可以添加更复杂的分析逻辑

}

# 主程序

case "$1" in

monitor)

monitor_containers

;;

report)

generate_report

;;

*)

echo "使用方法: $0 {monitor|report}"

exit 1

;;

esac四、环境清理与配置恢复

1. 实验环境清理

bash

#!/bin/bash

# cleanup-environment.sh - 清理实验环境

echo "=== 开始清理实验环境 ==="

# 1. 停止并删除所有容器

echo "清理容器..."

docker stop $(docker ps -aq) 2>/dev/null || true

docker rm $(docker ps -aq) 2>/dev/null || true

# 2. 删除Overlay网络

echo "清理网络..."

docker network rm my-overlay 2>/dev/null || true

# 3. 停止Consul服务

echo "停止Consul服务..."

docker stop consul 2>/dev/null || true

docker rm consul 2>/dev/null || true

# 4. 恢复Docker服务配置

echo "恢复Docker服务配置..."

cp /usr/lib/systemd/system/docker.service.backup \

/usr/lib/systemd/system/docker.service

# 5. 重启Docker服务

echo "重启Docker服务..."

systemctl daemon-reload

systemctl restart docker

# 6. 清理残留文件

echo "清理临时文件..."

rm -f centos-7.tar.gz *.json.log

echo "=== 环境清理完成 ==="2. 最佳实践总结

2.1 网络选择指南

2.2 资源限制配置原则

-

渐进式配置:

bash# 开发环境:宽松限制 --memory=2g --cpus=2 # 测试环境:适中限制 --memory=1g --cpus=1 # 生产环境:严格控制 --memory=512m --cpus=0.5 --memory-reservation=256m -

监控与调整:

bash# 定期监控 docker stats --format "{{.Name}}: {{.CPUPerc}} {{.MemUsage}}" # 动态调整 docker update --memory=1g busy_container -

安全边界:

bash# 防止资源耗尽 --pids-limit=100 # 进程数限制 --ulimit nofile=1024:2048 # 文件描述符限制 --read-only=true # 只读文件系统

结语

Docker容器网络和资源管理是现代容器化技术的两大支柱。通过本文的学习,你应该掌握了:

容器互联机制:理解了传统--link的局限性和现代DNS-based服务发现的优势

跨主机通信方案:掌握了Overlay网络的配置和工作原理

资源限额管理:学会了如何合理配置CPU、内存、磁盘I/O限制

生产环境最佳实践:了解了监控、调优和安全配置的策略

记住,没有一种网络模式或资源配置适合所有场景。关键在于理解各种方案的优缺点,然后根据你的具体需求做出明智的选择。

随着容器技术的发展,新的网络插件和资源管理工具不断涌现。建议持续关注Docker生态的发展,结合CNCF项目(如Calico、Flannel、Cilium)来构建更加健壮和灵活的容器网络架构。

下一步学习建议:

-

深入研究Kubernetes网络模型

-

学习服务网格(Service Mesh)如Istio、Linkerd

-

探索云原生网络策略和网络安全

-

实践多集群网络管理和跨云网络方案

容器网络的世界在不断演进,保持学习和实践是最好的成长方式!