摘要

核心背景 :在算力多样化、技术方案碎片化的行业现状下,AI推理的低延迟需求与大数据处理的高吞吐诉求对算力调度与加速技术提出双重挑战,传统方案普遍存在资源利用率低、场景适配性差、软硬协同不足等问题。

方案聚焦: 基于openFuyao"云原生+AI"核心理念,解析其针对AI推理与大数据场景的加速技术体系,重点拆解算力亲和组件、异构资源调度、软硬协同架构等核心技术路径。

实践价值: 结合金融等行业落地案例,量化分析方案在资源利用率提升、任务延迟降低等维度的成效,阐明openFuyao对开发者简化场景加速落地流程、释放算力价值的核心价值。

引言

1. 行业痛点与技术诉求

AI推理场景: 大模型部署成本高、多异构硬件适配复杂、高并发下延迟波动大,难以兼顾"低时延"与"高吞吐";

大数据场景: 批流混合任务资源冲突、数据密集型计算效率低,传统方案资源利用率不足 30%;

共性挑战: 异构算力协同难、云原生与 AI 负载融合度低、缺乏场景化加速组件。

2. openFuyao的定位与解决方案逻辑

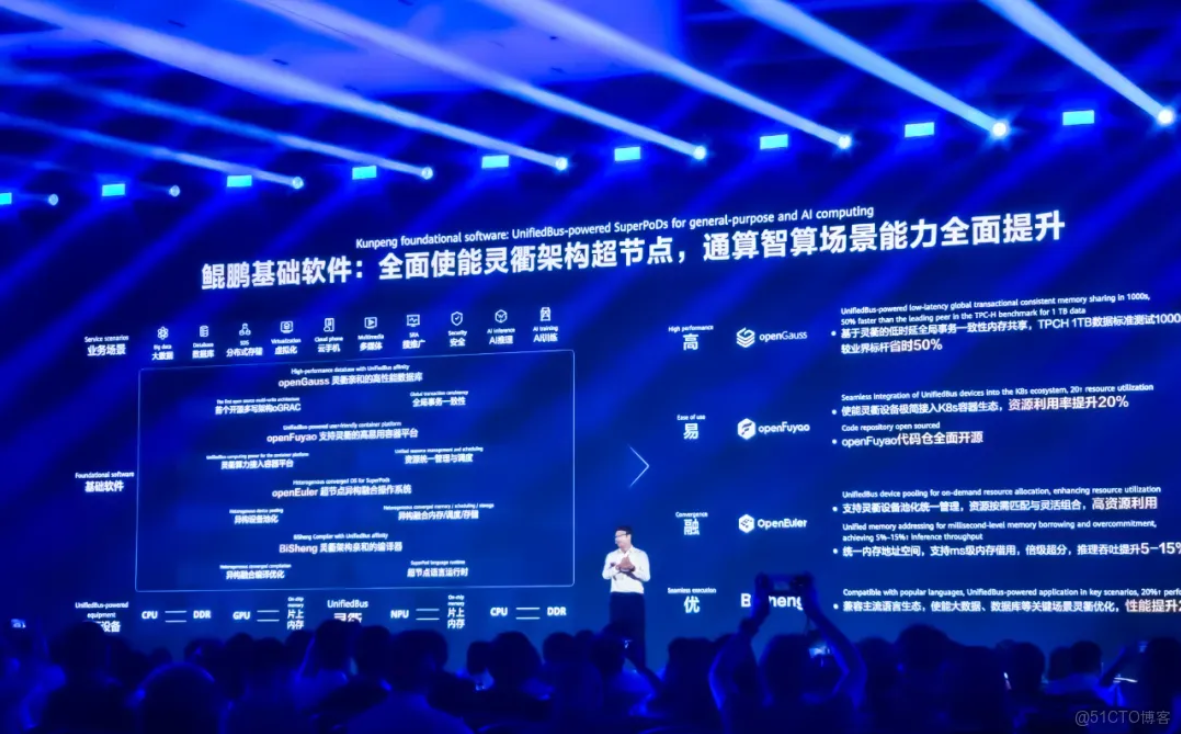

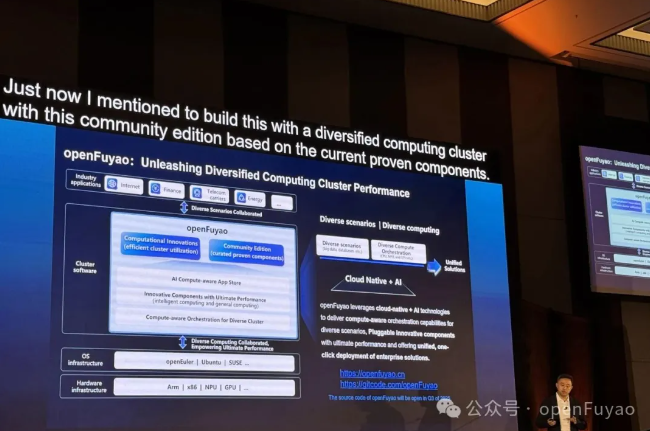

社区定位: 衔接 openEuler 与 openGauss,构建算力集群软件根生态核心环节;

技术范式: "核心平台 + 可插拔组件" 架构,实现从 "资源配给" 到 "应用使能" 的全链路革新;

方案价值: 提供 AI 与大数据场景垂直增强套件,降低开发与运维复杂度。

3. 本文核心内容与结构

围绕技术底座、场景化加速方案、实践案例、开发者生态展开,先解析底层支撑能力,再拆解两大场景方案,最后通过案例验证价值并展望演进。

第一章 openFuyao场景加速的技术底座与核心支撑

1.1 架构设计:模块化与软硬协同的双重保障

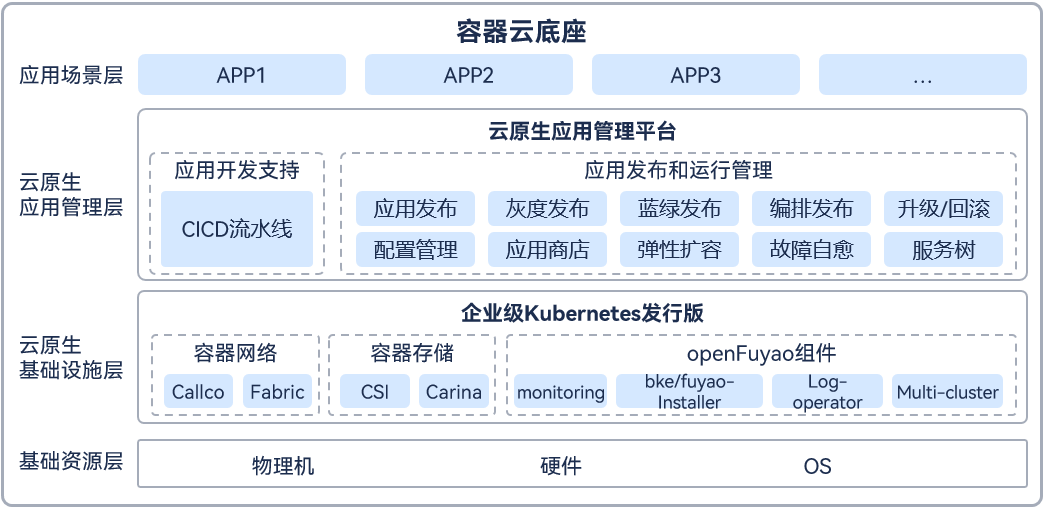

核心架构: 轻量核心 + 可插拔组件,集成智算 / 通算调度、异构资源管理等产业级组件;

全栈协同: 打通 openEuler、容器引擎、AI 框架,实现 CPU/GPU/DPU 等 xPU 资源无感调用 。

1.2 核心调度能力与基础加速组件

核心调度能力 : 异构资源池化、AI 动态调度、万节点级集群调度、三级 QoS 在离线混部、NUMA 亲和调度;

基础加速组件 : 数据传输优化、计算分片、端到端可观测性监控,为场景加速与案例落地提供底层支撑。

第二章 openFuyao AI推理场景加速方案:技术特性与落地路径

2.1 场景适配架构:全流程加速的分层设计

全链路覆盖: 打通数据标注、模型训练、推理发布,适配智能客服、NLP 等多元场景;

2.2 核心加速特性与技术实现

智能调度优化: NUMA 亲和 + 动态资源分配,避免敏感任务共节点部署;

推理性能增强: 算子融合、量化加速 + 智能路由,提升推理效率与负载均衡;

2.3 开发者友好的落地工具链

可视化平台、预置模型(通义千问、豆包等)、完整文档与测试工具,降低落地门槛。

第三章 openFuyao大数据场景加速方案:优化策略与技术创新

3.1 大数据场景的核心适配逻辑

批流混合调度架构: 基于三级QoS(HLS/LS/BE)定义工作负载优先级,保障流处理实时性的同时优化批处理资源利用率;

数据密集型计算优化: 针对Spark、Flink等框架提供算力亲和加速组件,通过数据分片与并行计算策略提升处理效率。

3.2 关键加速特性与技术路径

资源调度优化: 在离线混部支持优先级抢占调度与资源水位线驱逐机制,QPS下降不超过5%的前提下提升CPU与内存利用率40%+;

跨集群协同能力: 依托大规模集群调度引擎,实现万节点级数据计算任务的实时调度与负载均衡,解决传统架构的性能瓶颈;

存储与网络增强: 优化容器存储挂载效率与数据传输链路,降低大数据任务的IO延迟,提升数据吞吐能力。

3.3 与主流大数据生态的兼容与增强

工具链兼容: 无缝对接Hadoop、Spark、Flink等主流大数据框架,无需修改业务代码即可接入加速能力;

运维效率提升: 集成集群生命周期管理的前置校验模块,避免节点配置失误导致的任务失败,降低运维复杂度。

第四章 实践案例:openFuyao场景加速方案的价值验证

**4.1 金融行业AI推理加速案例:**江苏博云科技股份有限公司

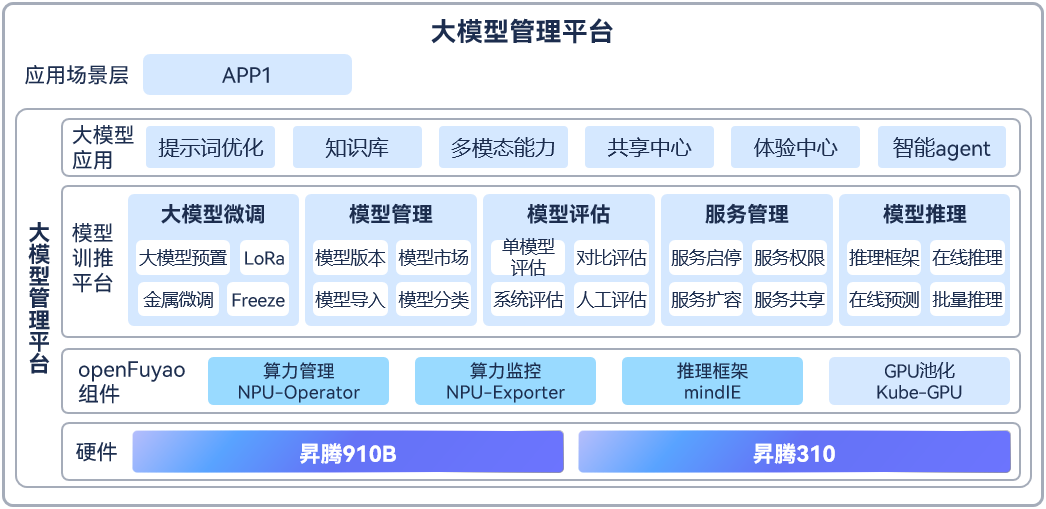

场景背景: 苏州农商行为应对不断升级的互联网业务系统,紧跟同行科技信息化建设的步伐,建设具有苏州农商银行特有金融架构特征的金融云平台变得尤为重要,需要建设能够稳定支撑金融级生产业务的高可用云平台,实现生产环境的业务迁云、应用快速迭代、业务高可用的需求,并为本行的大模型的微调、推理、管理、评估、服务等提供基础设施提供大模型管理服务能力支持。

部署方案: 基于openFuyao构建昇腾资源池与大模型管理容器云平台,在易用性、容错性、弹性伸缩、负载均衡、监控告警等方面满足苏州农商行的生产标准,实现网络隔离、资源配额、日志收集、多租户、健康检查、监控告警等能力,保障来生产环境的高可用和安全性。加入CI/CD的流水线模块,加速应用持续化的部署和发布,满足应用快速迭代、快速发布上线的需求。

- 实施成效:

降低人员技能要求,全面提升工作效率。

加速环境就绪,保证业务上线,将宝贵精力聚焦业务本身。

有效提升资源利用率,充分保障业务可用性。

多模型管理:统一管理多个不同类型、尺寸的大模型和小模型。

多NPU卡管理:统一管理和分配NPU卡。

模型微调:基于行内私有数据进行模型微调训练,支持多卡微调,提升训练效率。

模型部署:统一多模型部署上线流程,支持分布式推理和服务质量监测。

。

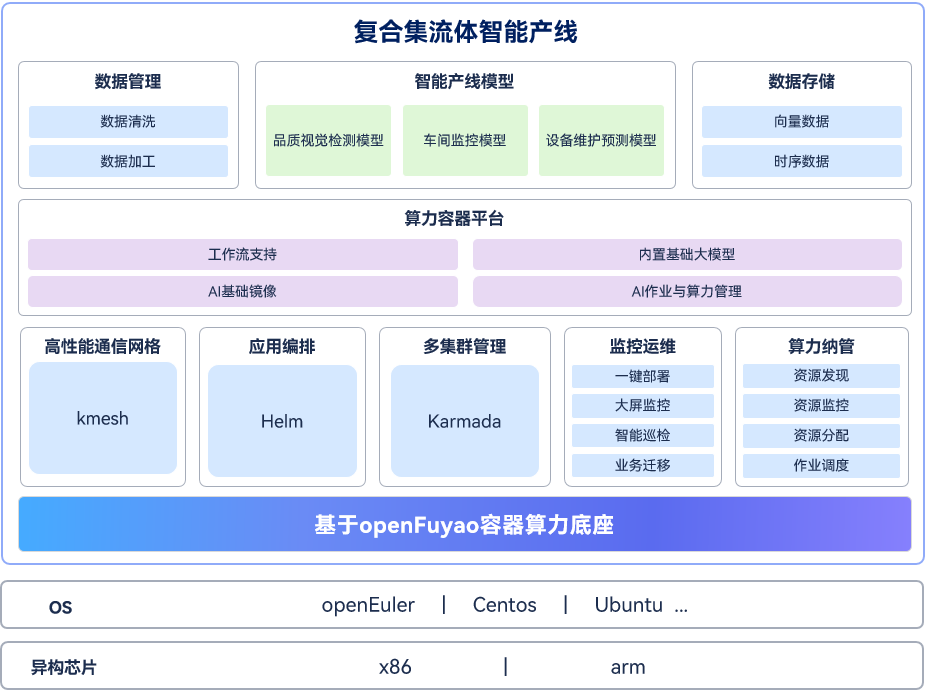

**4.2复合集流体智能产线系统案例:**广州广电五舟科技股份有限公司

场景需求: 使用产线设备技术复杂核心控制点多,流程繁杂,识别核心控制因素和控制要求困难(从材料到工艺到设备等),识别问题困难,研发试验周期长,成本高。开展创新的科学试验困难。基于以上痛点,以openFuyao为底座,面向"以薄膜生产为代表"的先进制造产线行业,打造智能产线系统。

优化路径: 基于openFuyao国产最强算力调度底座,算力,算法,数据三位一体,构建复合集流体智能产线系统。

聚合算力:集中管控,实现异地、异构资源池化。

运维智能化:一站式运维监控各种资源使用情况,集成Devops等。

调度算力:软件定义计算、网络、存储;实现算力统一调度与管理,智能调度。

AI工具开箱即用:AI开发工具,AI大模型、算法以及AI工具开箱即用。

关键指标: 通过容器平台的融合和管理能力,实现AI算力调度自动化、AI工具算法场景化,大大提升了构建复合集流体智能产线系统的便捷性,提升开发效率。

高效调度,一站式可视化管控

4.3 案例共性启示与技术可复用性

优化逻辑: 均通过异构资源池化+场景化调度策略实现算力释放,验证"云原生+AI"协同的普适性;

复用价值: 开发者可基于案例模板,快速适配政务、医疗等其他领域的AI推理与大数据处理场景。

第五章 openFuyao场景加速的开发者生态与未来演进

5.1 开发者赋能体系:从工具到社区的全维度支撑

低代码开发支持: 模块化组件支持"分钟级"一键部署,平滑升级能力避免版本迭代导致的业务中断;

技术资源矩阵: 提供官网文档、专题教程、性能测试工具,定期更新场景化最佳实践与组件开发指南;

社区协作机制: 通过技术委员会主导的特性迭代,接收开发者场景需求反馈,持续丰富加速组件库。

5.2 版本迭代与能力升级方向

性能优化: 深化众核高密调度能力,针对256核以上场景进一步提升容器部署密度与推理并行效率;

场景拓展:增强多模态大模型推理加速、实时大数据分析等新兴场景的适配能力;

生态融合: 深化与openEuler、openGauss的协同,拓展与主流AI框架、大数据工具的适配范围。

5.3 开发者参与路径与贡献价值

组件开发: 基于可插拔架构开发垂直场景加速组件,通过应用市场实现价值共享;

案例共建: 沉淀行业落地经验,参与社区案例库建设,助力其他开发者降低落地门槛;

技术共创: 参与调度算法优化、硬件适配等核心技术研发,推动场景加速能力迭代。

结论

**技术体系:**openFuyao 以 "云原生 + AI" 为核心,通过模块化架构、异构资源池化、智能调度,解决传统方案的核心痛点;

**实践价值(核心突出):**金融、先进制造案例充分验证,方案可实现资源利用率提升 3-4 倍、任务延迟降低 40%+,落地周期从月级压缩至小时级,且具备极强的行业复用性;

**生态展望:**随众核高密调度、在离线混部等特性增强,openFuyao 将成为开发者构建场景化加速方案的核心基础设施,推动 "算力价值" 向各行业深度渗透。