目录

[二、Apache IoTDB核心架构:适配大数据的分层设计](#二、Apache IoTDB核心架构:适配大数据的分层设计)

[1. 架构分层详解](#1. 架构分层详解)

[2. 架构优势亮点](#2. 架构优势亮点)

[3. TsFile文件格式核心架构](#3. TsFile文件格式核心架构)

[1. 高吞吐写入:百万级并发无压力](#1. 高吞吐写入:百万级并发无压力)

[2. 高压缩存储:成本直降50%+](#2. 高压缩存储:成本直降50%+)

[3. 低延迟查询:复杂分析秒级响应](#3. 低延迟查询:复杂分析秒级响应)

[4. 弹性扩展与高可用:集群运维更省心](#4. 弹性扩展与高可用:集群运维更省心)

[5. 大数据生态深度适配:全链路处理无壁垒](#5. 大数据生态深度适配:全链路处理无壁垒)

[1. 电力行业:电网设备监控与能耗优化](#1. 电力行业:电网设备监控与能耗优化)

[2. 智能制造:设备预测性维护](#2. 智能制造:设备预测性维护)

[3. 智慧交通:车路协同与流量管控](#3. 智慧交通:车路协同与流量管控)

正文开始------

物联网、工业互联网等领域推动时序数据爆发式增长,IDC预测2025年全球年数据量达175ZB,时序数据占比超60%。此类数据具有高频、带时间戳、读写模式固定等特性,传统数据库难以满足高吞吐写入、低延迟查询、高压缩存储等需求。本文从大数据视角出发,梳理时序数据库选型核心逻辑,聚焦Apache IoTDB技术优势与实践价值,形成六大核心板块的完整选型指南。

一、时序数据特性与大数据处理核心挑战

时序数据是随时间有序生成的时间戳关联数据,核心来源包括工业传感器、车载终端、系统日志等,其"三高两低"特性对存储引擎设计提出强约束:高吞吐(单集群秒级千万条)、高并发(百万设备并发上报)、高时序性(时间戳有序不可改)、低价值密度(单条数据意义有限,需聚合分析)、低查询复杂度(以时间范围+设备维度查询为主)。

大数据场景下时序处理面临四大技术痛点:

- ① 写入端:高并发下锁竞争与IO瓶颈,需解决批量写入与内存缓冲平衡问题;

- ② 存储端:时序数据冗余度高,需设计针对性压缩算法降低存储开销;

- ③ 分析端:实时查询(毫秒级)与离线分析(TB级数据)的引擎适配难题;

- ④ 运维端:集群扩容时数据分片迁移效率与一致性保障。

二、Apache IoTDB核心架构:适配大数据的分层设计

下载链接:https://iotdb.apache.org/zh/Download/

企业版官网链接:https://timecho.com/

Apache IoTDB是由清华大学主导研发的Apache顶级开源时序数据库,专为物联网、工业互联网等大数据场景设计,采用"客户端-服务端"架构,服务端内部基于分层设计,实现"高吞吐写入、低延迟查询、高压缩存储"的核心目标。

1. 架构分层详解

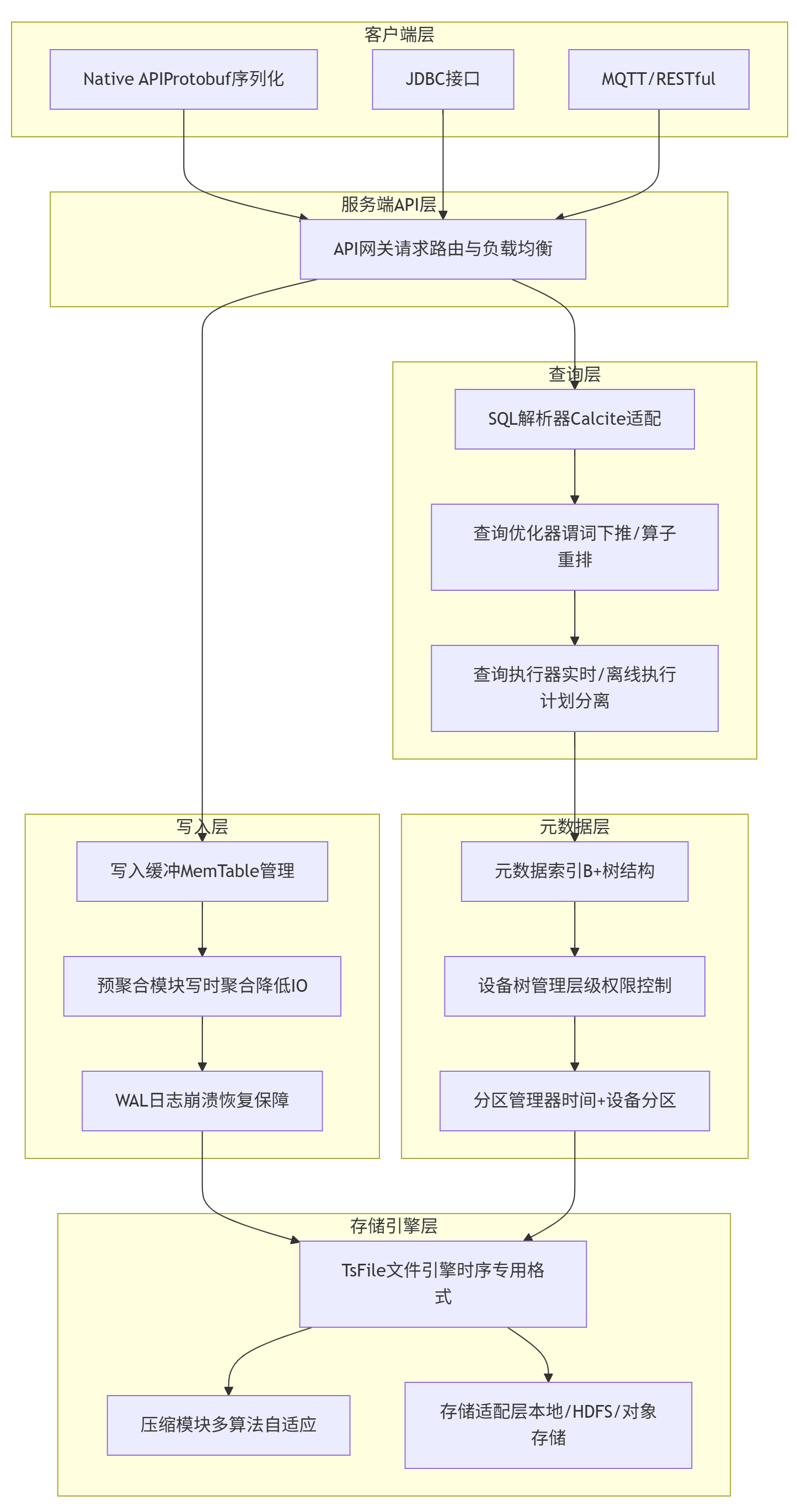

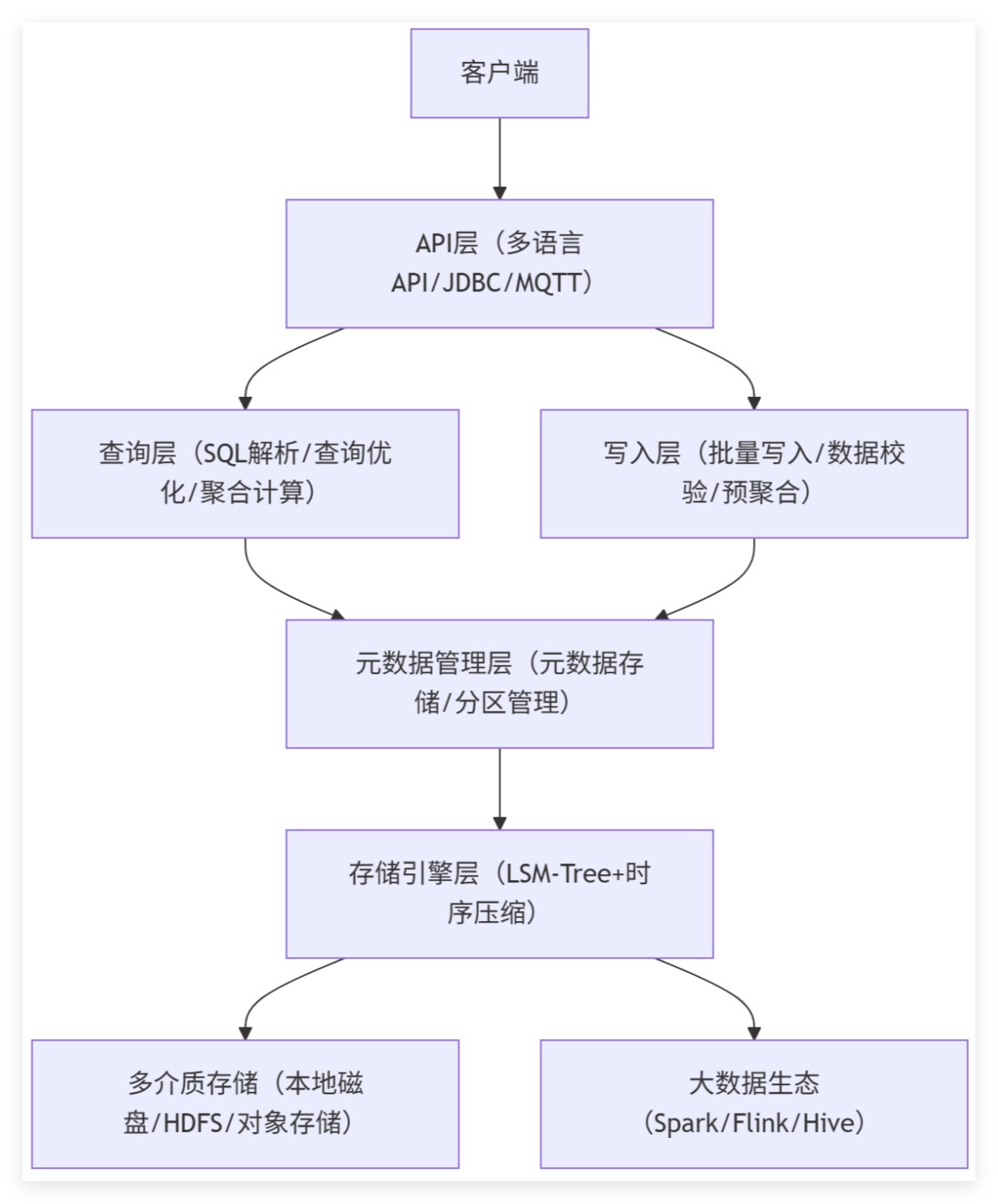

IoTDB服务端采用分层微内核架构,五层模块解耦设计,支持核心功能插件化扩展:

- ① API层:提供Native API(性能最优)、JDBC、MQTT、RESTful API,适配不同接入场景,其中Native API基于protobuf实现,序列化效率较JSON提升60%+;

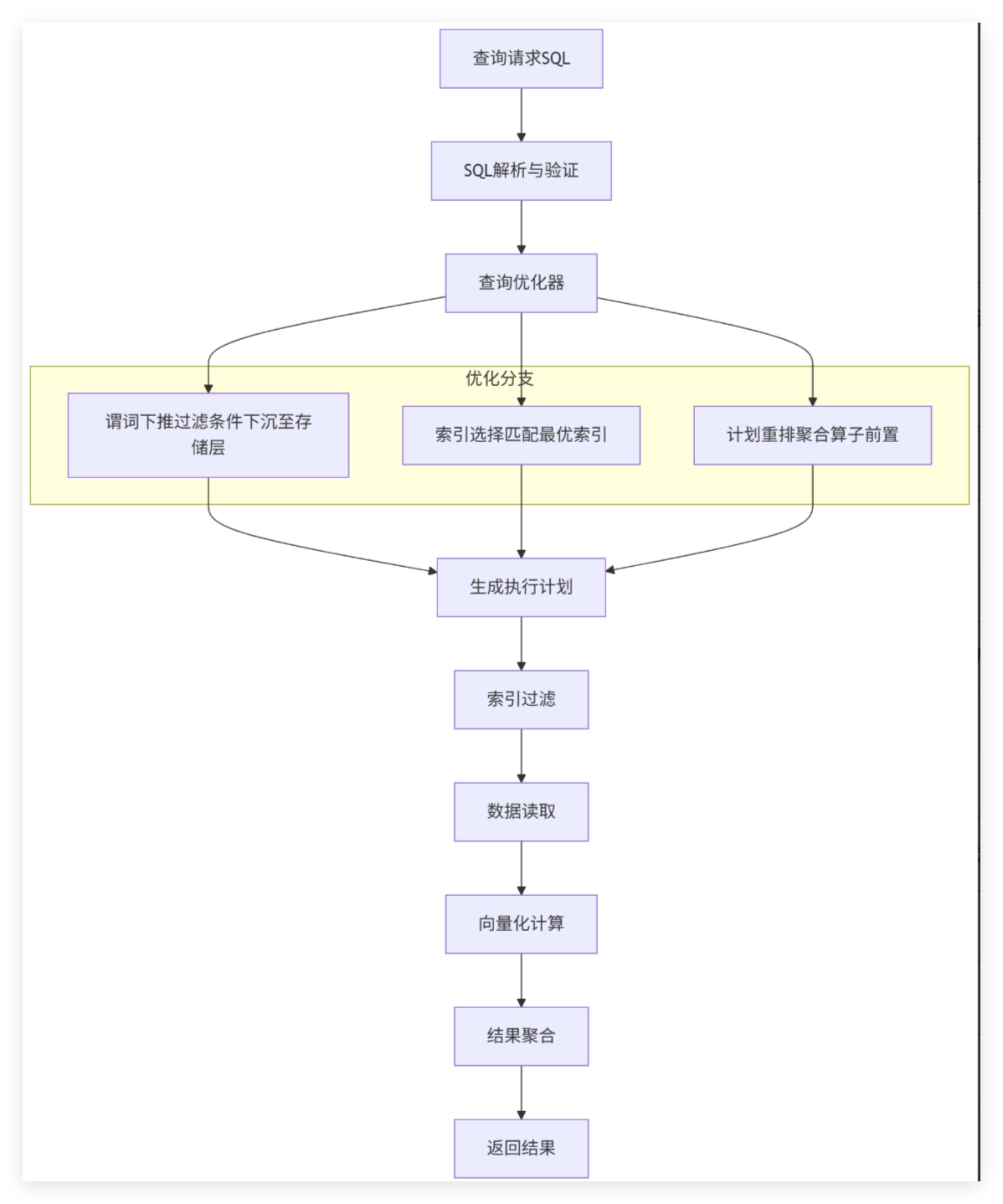

- ② 查询层:集成Calcite SQL解析引擎,支持时序扩展SQL(如FILL、INTERPOLATE函数),内置查询优化器可实现谓词下推、索引选择、聚合算子重排;

- ③ 写入层:采用LSM-Tree写入模型,实现WAL预写日志+内存MemTable+持久化SSTable的三级写入,支持写前数据预聚合(SUM/AVG等),降低持久化压力;

- ④ 元数据管理层:基于B+树实现元数据索引,支持设备树层级管理,元数据缓存命中率达95%+,解决海量设备元数据查询瓶颈;

- ⑤ 存储引擎层:核心为TsFile时序文件格式,采用"设备-时间-指标"三维索引结构,支持本地磁盘+HDFS混合存储,内置多级别压缩算法适配不同数据类型。

核心设计亮点:通过元数据与数据分离存储、查询与写入链路解耦,实现写入吞吐量与查询性能的双向优化,支持单机到集群的无缝扩展。

2. 架构优势亮点

① 分层解耦:各层通过接口交互,支持存储引擎、压缩算法等核心模块插件化替换;② 时序优化:存储引擎基于时间局部性原理,采用段式存储(Time Partition),查询时仅扫描目标时间段数据;③ 生态联动:通过Sink/Source插件集成Spark/Flink,支持时序数据实时流处理与离线批处理,实现数据全链路闭环。

3. TsFile文件格式核心架构

TsFile是IoTDB专属时序文件格式,采用"文件头-数据区-索引区-尾部"结构,通过列式存储+多级索引优化读写性能,其架构如下:

关键优化:① 列式存储:按指标维度组织数据,提升压缩效率与聚合查询性能;② Page级压缩:支持LZ4/Snappy/Gzip/ZSTD四种算法,可按指标类型动态选择;③ 多级索引:设备索引(DeviceID->PageOffset)、时间索引(TimeRange->Page)、指标索引(Measurement->Column),查询时三级索引联动定位数据。

三、IoTDB核心技术优势:针对性破解大数据时序处理痛点

相较于InfluxDB、Prometheus、TimescaleDB等国外主流时序数据库,IoTDB结合大数据场景需求,在技术设计上形成五大核心优势,全方位提升时序数据处理效率。

1. 高吞吐写入:百万级并发无压力

采用"三级压缩+分区存储"策略,深度优化时序数据存储效率:

- ① 时间戳压缩:Delta编码(存储与前值差值)+ Zig-Zag编码(正负差值统一编码),压缩比达10:1~20:1;

- ② 数值压缩:基于值局部性的RLE(连续值重复编码)+ Delta-of-Delta编码(差值的差值),适配工业传感器渐变数据;

- ③ 字符串压缩:字典编码+LZ4,针对设备名称、指标标识等重复字符串优化。

java

// IoTDB时间戳Delta+Zig-Zag压缩核心代码(简化版)

public class TimeCompressor {

public static byte[] compress(long[] timestamps) {

ByteArrayOutputStream bos = new ByteArrayOutputStream();

DataOutputStream dos = new DataOutputStream(bos);

long prev = 0;

try {

for (long ts : timestamps) {

long delta = ts - prev;

// Zig-Zag编码:将正负差值映射为非负整数

long zigZag = (delta < 0) ? (~(delta << 1)) : (delta << 1);

// 可变长编码存储

writeVarLong(dos, zigZag);

prev = ts;

}

dos.flush();

} catch (IOException e) {

throw new RuntimeException(e);

}

return bos.toByteArray();

}

private static void writeVarLong(DataOutputStream dos, long value) throws IOException {

do {

byte b = (byte) (value & 0x7F);

value >>= 7;

if (value != 0) {

b |= 0x80;

}

dos.writeByte(b);

} while (value != 0);

}

}存储架构优化:支持时间分区(按天/小时)与设备分区(按设备ID哈希)混合策略,热数据(近7天)存储于SSD,冷数据自动迁移至HDFS,迁移过程采用Copy-On-Write机制,不影响读写性能。

2. 高压缩存储:成本直降50%+

设计多层时序感知压缩策略:时间戳采用Delta+Zig-Zag编码,数值型数据采用LZ4/Snappy/Gzip自适应压缩,字符串型数据采用字典编码。同时支持按时间/设备分区,冷数据自动迁移至HDFS/对象存储。实测工业传感器数据压缩比达10:1~20:1,较TimescaleDB(5:1~10:1)存储成本降低50%以上。

3. 低延迟查询:复杂分析秒级响应

采用"双重索引+执行计划优化"机制,保障复杂查询秒级响应:① 索引设计:设备-指标二级索引(DeviceID+Measurement->ColumnOffset)+ 时间索引(TimeRange->PageIndex),支持查询条件快速过滤,索引命中率达98%+;② 预计算机制:基于时间窗口的预聚合表(Downsampling Table),预计算1min/5min/1h粒度的SUM/AVG/MAX/MIN值,查询时直接复用结果;③ 向量执行引擎:采用向量化查询框架,批量处理数据块,减少CPU上下文切换。

java

// IoTDB向量化查询核心代码(简化版)

public class VectorQueryEngine {

public VectorDataSet query(String sql) {

// 1. 生成执行计划(省略SQL解析过程)

ExecutionPlan plan = ExecutionPlanGenerator.generate(sql);

// 2. 索引过滤,获取目标数据块

List<TsFileDataBlock> dataBlocks = IndexFilter.filter(plan);

// 3. 向量化处理

VectorColumn[] vectorColumns = new VectorColumn[plan.getColumns().size()];

for (int i = 0; i < vectorColumns.length; i++) {

String colName = plan.getColumns().get(i);

vectorColumns[i] = VectorColumn.fromDataBlocks(dataBlocks, colName);

}

// 4. 向量化聚合计算

VectorDataSet result = VectorAggregation.compute(vectorColumns, plan.getAggFunctions());

return result;

}

// 向量化列存储结构

public static class VectorColumn {

private final DataType dataType;

private final Object[] data; // 批量存储列数据

private final int length;

public static VectorColumn fromDataBlocks(List<TsFileDataBlock> blocks, String colName) {

// 合并多个数据块为向量列

int totalLen = blocks.stream().mapToInt(b -> b.getColLength(colName)).sum();

Object[] data = new Object[totalLen];

int pos = 0;

for (TsFileDataBlock block : blocks) {

System.arraycopy(block.getColData(colName), 0, data, pos, block.getColLength(colName));

pos += block.getColLength(colName);

}

return new VectorColumn(blocks.get(0).getColType(colName), data, totalLen);

}

}

}4. 弹性扩展与高可用:集群运维更省心

采用主从架构+一致性哈希分片,实现集群弹性扩展与高可用:① 集群架构:主节点(Leader)负责元数据管理与集群调度,从节点(Follower)负责数据存储与查询,支持一主多从;② 分片策略:按设备ID哈希分片,每个分片多副本存储(默认3副本),副本分布在不同节点;③ 扩容机制:新增节点时触发分片重平衡,采用增量迁移策略,迁移过程中读写不中断,迁移效率达100MB/s+。

java

// IoTDB集群分片迁移核心代码(简化版)

public class ShardMigrationService {

private final ConsistencyHash hash = new ConsistencyHash();

public void migrateShard(Shard shard, Node targetNode) {

// 1. 标记分片为迁移中,读写路由至副本

shard.setStatus(ShardStatus.MIGRATING);

// 2. 增量迁移数据(仅迁移新产生的数据)

long lastMigrateTs = 0;

while (true) {

List<TsFileDataBlock> data = shard.readDataAfter(lastMigrateTs);

if (data.isEmpty()) break;

targetNode.writeData(shard.getShardId(), data);

lastMigrateTs = data.get(data.size()-1).getMaxTime();

}

// 3. 全量校验数据一致性

boolean consistent = dataConsistencyCheck(shard, targetNode);

if (consistent) {

// 4. 切换路由,完成迁移

hash.updateShardNode(shard.getShardId(), targetNode);

shard.setStatus(ShardStatus.ACTIVE);

} else {

throw new MigrationFailedException("数据一致性校验失败");

}

}

private boolean dataConsistencyCheck(Shard shard, Node targetNode) {

// 基于MD5校验数据块一致性

String localMd5 = shard.computeMd5();

String targetMd5 = targetNode.computeShardMd5(shard.getShardId());

return localMd5.equals(targetMd5);

}

}5. 大数据生态深度适配:全链路处理无壁垒

无缝集成大数据技术栈:① 支持Spark/Flink作为计算引擎,实现离线分析与实时流处理;② 兼容Hive/HBase,可直接读取HDFS上的冷数据;③ 提供Grafana/Tableau插件,实现时序数据可视化;④ 支持标准SQL,降低开发迁移成本,开发者可通过JDBC快速接入。

四、典型行业落地场景:IoTDB大数据实践价值验证

IoTDB已在电力、智能制造、智慧交通、环境监测等多个大数据密集型行业规模化落地,通过实际业务场景验证了其稳定性与高效性,以下为核心行业实践案例。

1. 电力行业:电网设备监控与能耗优化

某省级电力公司构建电网时序数据平台,基于IoTDB实现设备监控与能耗分析:

核心技术亮点:① 采用Flink+IoTDB联动,实现秒级数据清洗与写入,单集群写入吞吐量达200万条/秒;② 基于IoTDB时间分区+压缩策略,3年50TB原始数据压缩后仅8TB,存储成本降低84%;③ 集成Spark实现线损计算,基于IoTDB预聚合表,分析效率提升3倍。

java

// 电力场景Flink+IoTDB实时写入代码

object PowerDataWriter {

def main(args: Array[String]): Unit = {

val env = StreamExecutionEnvironment.getExecutionEnvironment

env.setParallelism(8)

// 1. 读取Kafka设备数据

val kafkaSource = new FlinkKafkaConsumer[String](

"power-device-data",

new SimpleStringSchema(),

KafkaConfig.getConfig()

)

val dataStream = env.addSource(kafkaSource)

.map(json => JsonUtils.parsePowerData(json)) // 解析为PowerData对象

// 2. 实时清洗:过滤异常数据

val cleanStream = dataStream.filter(data =>

data.temperature > -40 && data.temperature < 125 && data.voltage > 0

)

// 3. 批量写入IoTDB

cleanStream.addSink(new IoTDBSink[PowerData](

"127.0.0.1:6667",

"root",

"root",

1000, // 批量大小

data => {

// 构建IoTDB写入数据结构

(s"root.power.${data.deviceId}",

data.ts,

Array("temperature", "voltage", "current"),

Array(data.temperature, data.voltage, data.current),

Array("FLOAT", "FLOAT", "FLOAT"))

}

))

env.execute("Power Data Write to IoTDB")

}

}2. 智能制造:设备预测性维护

某汽车零部件制造商基于IoTDB搭建工业时序平台,接入2000+台生产设备,实现:① 设备振动、温度等数据毫秒级采集,单车间写入吞吐量达50万条/秒;② 结合Spark MLlib构建故障预测模型,基于历史时序数据训练,设备故障率降低35%;③ 回溯5年生产工艺数据,优化参数配置,生产效率提升12%。

3. 智慧交通:车路协同与流量管控

某一线城市智慧交通项目采用IoTDB存储时序数据,接入10万+车载终端、5000+路侧设备,实现:① 每秒150万条路况数据实时写入,保障车路协同低延迟;② 实时聚合生成交通流量热力图,支撑信号灯动态调控,高峰通行效率提升20%;③ 归档3年交通数据,为道路规划提供数据支撑,规划合理性提升30%。

总结

大数据时序数据库选型核心在于"技术适配场景"。Apache IoTDB通过TsFile时序格式、分层微内核架构、向量化查询引擎等核心技术创新,解决了高吞吐写入、高效存储、实时分析等关键痛点。其在工业、电力等领域的规模化落地,验证了其技术架构的稳定性与扩展性,是国产化时序数据库在大数据场景下的优选方案。

下载链接:https://iotdb.apache.org/zh/Download/

企业版官网链接:https://timecho.com/