12月12日深夜,谷歌在官方博客及合作媒体36氪同步发布了全新开源项目------Gemini Deep Research Agent(以下简称Deep Research Agent)。该项目在谷歌自研基准上取得了领先的SOTA成绩,并声称其运行成本仅为同类商业模型GPT‑5 Pro的10%,即比后者便宜90%。此举被业界视为一次"降本增能"的重要里程碑,也标志着大型语言模型(LLM)生态向更开放、更高效方向迈进。

一、核心技术亮点

统一的可解释、可组合数据模型

Deep Research Agent采用专为复杂Agent历史设计的图式结构,实现了对交错信息、思考链、工具调用及其结果的统一管理。开发者可以在调试、流式分析和推理阶段直观查看每一步的输入输出,显著降低上下文管理错误的风险。

缓存与成本优化

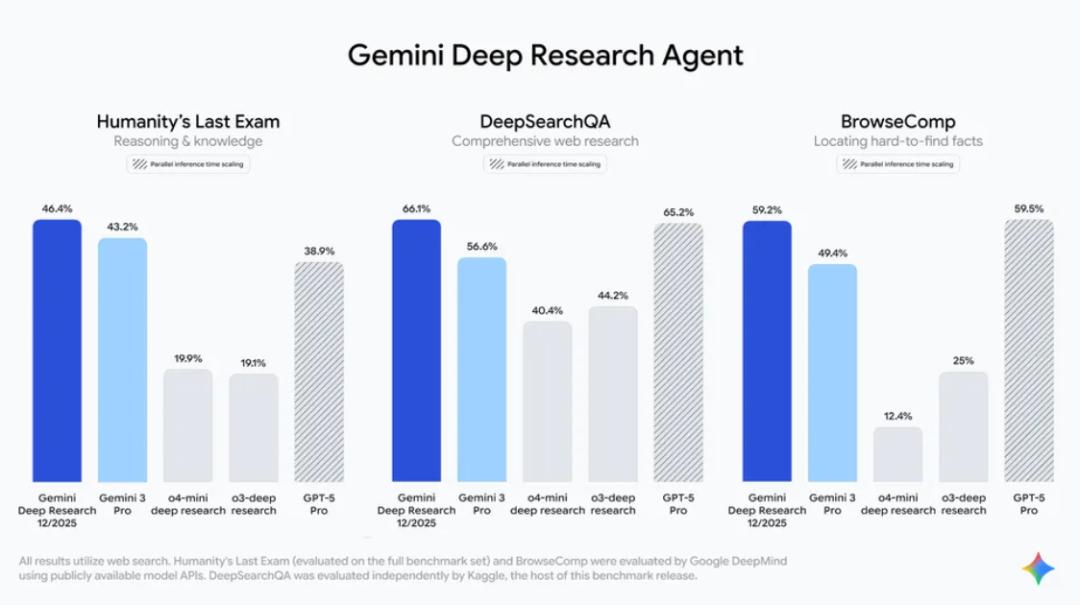

通过提升缓存命中率,系统在重复查询或相似任务中能够直接复用已有结果,进一步压缩计算开销。谷歌称,这一机制是实现"低成本生成深度研究报告"的关键因素。

背景执行(Background Execution)

传统Agent需要保持客户端长连接以完成长时序推理,而Deep Research Agent支持将长期运行的推理环路卸载至服务器端,客户端无需维持持续连接即可获得完整结果,提升了使用灵活性。

远程MCP工具支持

该Agent能够直接调用模型上下文协议(Model Context Protocol,MCP)服务器作为工具,实现模型对外部工具的即时调用,进一步扩展了Agent的功能边界。

二、性能与成本对比

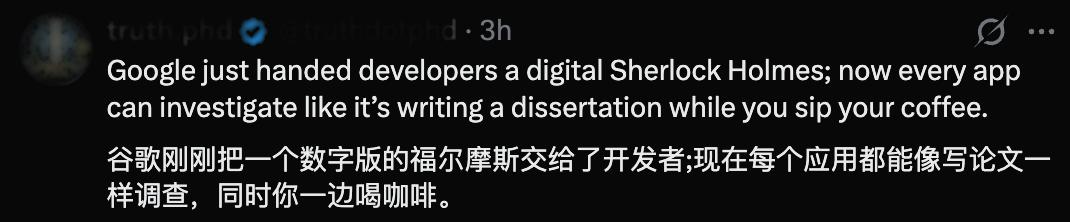

谷歌Deep Mind产品经理Lukas Haas在社交平台X上透露,Deep Research Agent在谷歌内部新基准Gemini‑Bench上取得了46.4的得分,刷新了该基准的最高记录。同时,在公开的BrowseComp基准测试中,其表现与GPT‑5 Pro相当,但运行费用仅为后者的约1/10。这一数据在业界引发热议,因为GPT‑5 Pro一直被视为高性能付费模型的标杆。

三、行业背景与意义

自2023年以来,AI模型的算力与训练成本呈指数级增长,导致商业化部署的门槛不断提升。OpenAI、Anthropic等公司相继推出高价位的旗舰模型,市场对"高性能+低成本"方案的需求日益迫切。谷歌此次开源Deep Research Agent,既提供了最前沿的技术实现,又通过成本优势打开了中小企业和开发者的使用场景,可能在以下几个方面产生深远影响:

加速AI应用落地:低成本的Agent可在科研、金融、法律等需要大量文献检索与报告生成的行业快速部署,降低企业的AI投入成本。

促进开源生态竞争:与Meta、Anthropic等公司近期的开源模型相比,谷歌在Agent框架、远程工具调用等方面的创新为开源社区提供了新的参考范式。

推动模型透明化:开源代码与训练细节的公开,有助于学术界对模型行为进行审计与改进,提升整体AI安全治理水平。

四、发布细节与后续计划

36氪报道中指出,谷歌已同步在GitHub上发布了完整代码、模型权重以及详细的使用文档,开发者可直接下载并在本地或云端部署。同时,谷歌计划在未来几周内推出配套的API服务,帮助企业在不自行部署的情况下,以按需计费的方式调用Deep Research Agent的核心功能。

五、业界声音

技术评论员:认为Deep Research Agent的"背景执行"是解决长时序推理瓶颈的关键突破,尤其在需要多轮搜索与信息整合的任务中表现突出。

企业用户:部分已试用的AI创业公司反馈,使用该Agent生成的研究报告质量与GPT‑5 Pro相当,但成本仅为后者的10%‑15%,显著提升了项目的经济可行性。

学术界:部分研究者指出,虽然开源有助于透明度,但仍需关注模型在特定领域的偏见与误导风险,呼吁社区共同制定评估标准。

结语

谷歌的Gemini Deep Research Agent以"一键开源、低成本高性能"的姿态进入AI生态,标志着大型语言模型从"封闭巨头"向"开放协作"转型的加速。未来,随着更多企业和开发者基于该Agent构建垂直应用,AI技术的普惠化进程有望进一步提速。