如果是长期关注大模型领域的朋友,大概都会有这样一种感觉:现在的AI虽然智商越来越高,但只要一开口说话,那种特有的"塑料感"还是很难消除。无论是语音的机械停顿,还是多模态交互时的"脑子慢半拍",都时刻提醒着我们,对面只是个程序。

但在2025年12月9日,这个局面似乎被阿里的Qwen团队撕开了一道口子。

他们正式发布的Qwen3-Omni-Flash-2025-12-01,不再仅仅是在刷榜单上的分数(虽然分数确实也刷得很猛),而是实打实地盯着"像人一样交流"这件事死磕。作为一名在这个圈子里摸爬滚打的观察者,我想聊聊为什么这次更新可能比你想象的更重要。

终于不再是"听不懂话"的复读机了

以往的多模态模型有一个通病,叫"降智"。简单说,就是模型处理文本时很聪明,一旦加上图像、视频或者音频,脑子不仅转得慢,逻辑还会变差。

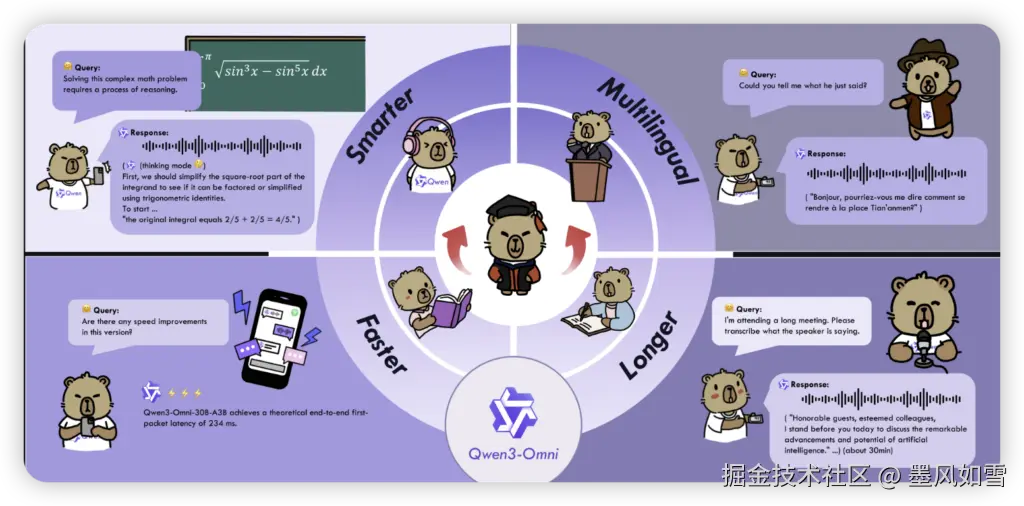

Qwen3-Omni-Flash最核心的突破,在于它是一个"原生全模态"的家伙。它不需要先把你的声音转成字,再把字转成意思,然后再生成字,最后转成声音。它是端到端的------你的视频、音频、文字,对它来说都是一种输入信号。

这就带来了一个极为直观的体验升级:流式输出,即问即答。

你在Demo里上传一段30秒的视频,它能一边看一边跟你聊,甚至能实时生成带画面的口播。这种感觉不再是你在操作一个工具,而是对面坐了一个眼疾手快的剪辑师或者解说员。多轮对话的流畅度大幅提升,那种"我说一句,你卡三秒"的尴尬场面,在这个版本里被极大地消解了。

捏人系统的全面开放

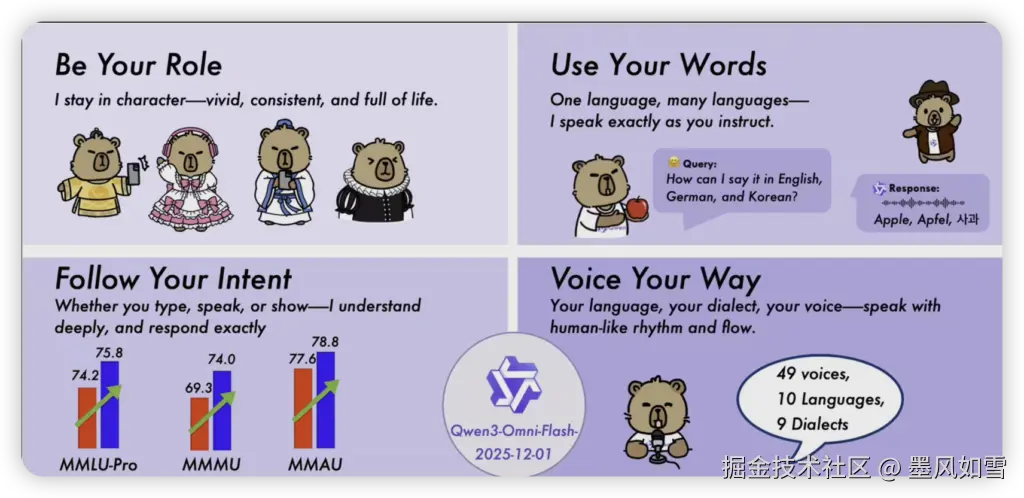

如果说反应快是"硬实力",那么这次开放的System Prompt自定义,就是给了AI"灵魂"。

之前的AI性格大多是出厂设置好的,礼貌、克制、甚至有点无聊。但现在,Qwen把控制权交给了用户。你想对面是个温柔甜妹?还是个高冷御姐?亦或是一个严谨的职场导师?

这不仅仅是换个音色那么简单。你可以精细地控制它的表达风格、口语习惯甚至是回复的长度。官方数据显示,这种"人格化"的语音合成在韵律、停顿和语速上都能自适应调节。

这意味着,如果你是一个内容创作者,你可以直接用语音指令让它生成一段情绪饱满的短视频配音,甚至不需要后期再去调教语调。因为它现在的语音自然度MOS评分已经到了4.8分,这是一个逼近真人说话水平的数据。

硬核数据与白菜价的API

当然,作为技术博主,我们不能只谈感受不看参数。

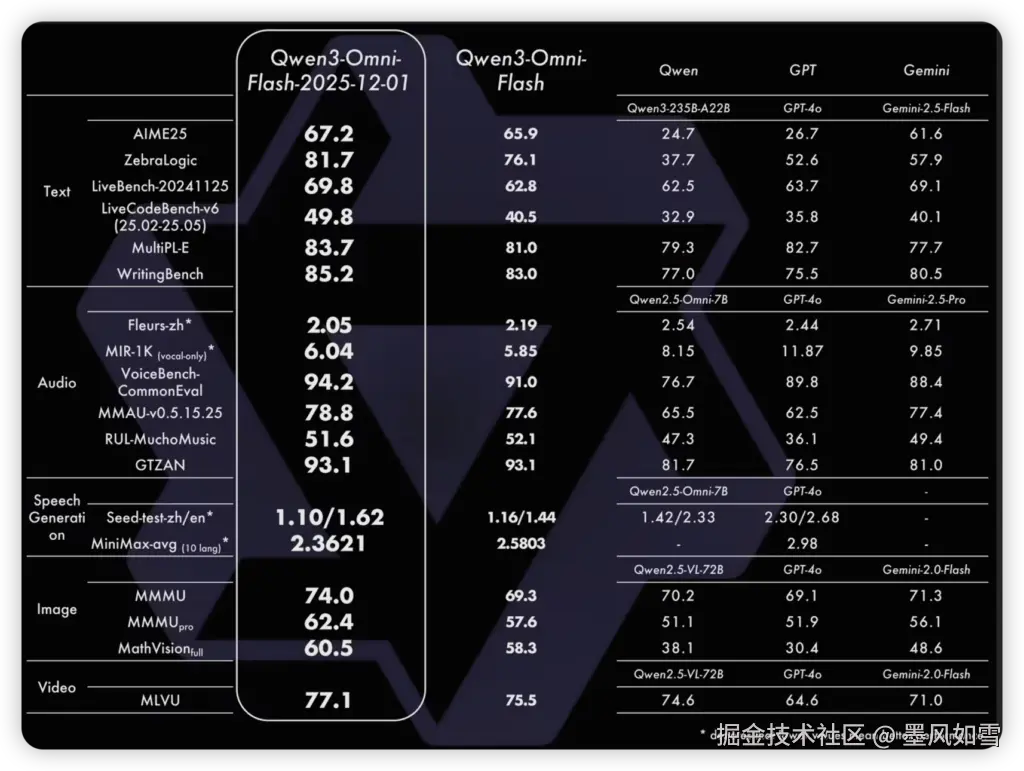

相较于前代Qwen3-Omni,Flash版本在各项硬核指标上都有显著增长。ZebraLogic逻辑推理提升了5.6分,LiveCodeBench代码生成更是暴涨了9.3分。在视觉理解(MMMU)和语音对话评估上,也都有肉眼可见的进步。这说明阿里的团队并没有为了追求"拟人化"而牺牲模型的智商,它依然是个聪明的六边形战士。

更让我感到意外的是定价。

阿里这次直接把API价格压到了"输入1元/百万tokens,输出3元/百万tokens"。对于开发者来说,这简直就是入场券大放送。结合它支持的119种文本语言和19种语音识别能力,无论是做跨境电商客服,还是做全球化的教育应用,成本门槛都被直接打了下来。

未来的剧透

看完这次发布,我最期待的其实是Qwen团队画下的"大饼"------或者说即将在未来几个月兑现的技术承诺。

按照规划,2025年第一季度,我们就能见到可以在单张A100显卡上跑起来的70B轻量版模型。到了第二季度,那个传说中的"10秒语音克隆"接口就要开放了。而第三季度,视频驱动头像功能也将上线。

这意味着什么?意味着也许到明年夏天,你只需要一张显卡和几段素材,就能在直播间里造出一个拥有你声音、你长相,并且能用几十种语言实时跟弹幕互动的"数字分身"。

Qwen3-Omni-Flash的出现,标志着大模型正在从"不仅要有用"向"还要好用、爱用"转变。它不再满足于做一个冷冰冰的问答机器,而是试图成为一个有情绪、有人设、能听会看的伙伴。

对于行业来说,这可能只是一次版本号的迭代;但对于每一个渴望真正智能交互的用户来说,这可能是人机共生时代开启的前夜。

如果你也对最新的AI信息感兴趣或者有疑问 都可以加入我的大家庭 第一时间分享最新AI资讯、工具、教程、文档 欢迎你的加入!!!😉😉😉

公众号:墨风如雪小站