摘要

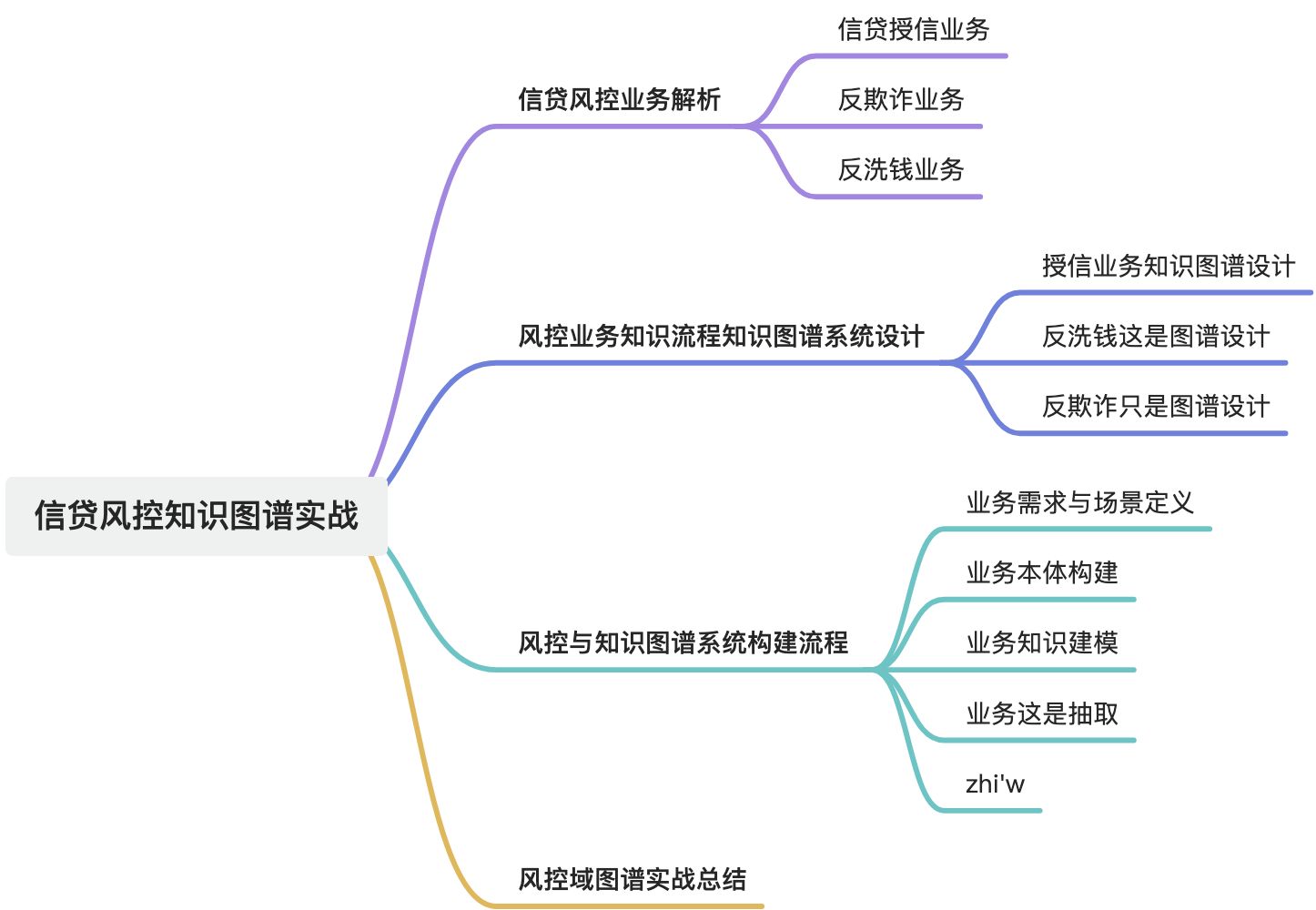

本文深入探讨了信贷风控知识图谱的构建与实战应用。首先解析了风控域的业务流程,涵盖风控授信、反欺诈与反洗钱等业务。接着详细阐述了风控业务知识图谱系统的设计,包括授信、反欺诈与反洗钱知识图谱设计。重点介绍了风控域知识图谱构建流程,从业务需求定义到知识抽取、清洗、存储、查询设计,再到推理构建与可视化平台搭建,最后总结了知识图谱在风控领域的应用价值,如反欺诈、客户关系分析等,并探讨了图数据库在金融信贷领域的作用、知识图谱技术架构、应用场景、数据量级挑战、查询优化方法以及数据更新策略等关键问题。

1. 风控域业务流程解析

1.1. 风控授信业务

1.2. 反欺诈业务

1.3. 反洗钱业务

2. 风控业务知识图谱系统设计

2.1. 风控授信业务知识图谱设计

2.2. 反欺诈业务知识图谱设计

2.3. 反洗钱业务知识图谱设计

3. 风控域知识图谱统构建流程

一个完整的知识图谱系统一般包含五大阶段:

- 业务建模(明确图谱要解决什么问题)

- 知识抽取(从结构化/非结构化数据中提取实体、关系、属性)

- 知识融合(消歧、对齐、合并)

- 知识存储(图数据库 + 检索 + 索引)

- 知识应用(查询、推理、风控规则、策略调用、推荐、可视化)

3.1. 业务需求与场景定义

知识图谱不等于炫技,必须先明确"你要解决什么问题"。

3.1.1. 金融风控常见目标

- 客户信息统一(多来源融合)

- 企业/人关联关系识别(反欺诈、反洗钱)

- 产品/规则/策略之间关系可视化

- 风险事件关联与传播路径分析

- 攻击或欺诈链路检测

3.1.2. 关键交付成果

- 场景清单 (如:借贷反欺诈、资金流向分析)

- 核心实体类型 (客户、商户、订单、设备、银行卡、行为事件...)

- 关系类型定义 (持有、认证、登录、交易、共用设备、同IP...)

- 属性定义 (身份证、手机号、设备指纹...)

📝输出:业务本体(Ontology)草稿。

3.2. 构建业务本体(Ontology 设计)

知识图谱建设的核心: 定义世界观 。

3.2.1. 关键内容

- 实体(Entity)

- 关系(Relation)

- 属性(Attribute)

- 层级结构(类目)

- 约束规则(如唯一性、关系方向)

3.2.2. 金融风控本体示例

实体:

- 用户(User)

- 设备(Device)

- 订单(Order)

- 银行卡(BankCard)

- IP地址(IP)

- 商户(Merchant)

关系:

- 用户-使用-设备

- 用户-绑定-银行卡

- 用户-登录-IP

- 订单-支付-用户

- 用户-下单-商户

属性示例:

- 设备:device_id, device_type

- 用户:name, id_card, phone

- 订单:order_id, amount, time3.3. 知识抽取(NER + RE + 属性识别)

知识来源可以分为三类:

3.3.1. 结构化数据(数据库,CSV)

- 最容易,直接字段映射成实体和关系

- 如订单表、交易日志、用户表

工具:Python + Pandas + Neo4j batch import

3.3.2. 半结构化数据(JSON、XML、Excel)

- 常见于交易流水、风控规则 JSON 输入输出

- 通过 XPath / JSONPath 提取

3.3.3. 非结构化文本(文档、合同、客服记录)

- 用 NLP 进行实体识别、关系抽取

- NLP 模型可选:

-

- BERT-NER

- GPT-4/5 系大模型(Zero-shot/Few-shot)

- HanLP(中文强)

3.3.4. 输出

- triples:⟨实体1, 关系, 实体2⟩

- 属性:key-value

3.4. 知识清洗与融合(ETL + 消歧 + 对齐)

不同数据源中可能存在:

- 同一用户不同 ID 表达

- 同一设备指纹不一致

- 实体名称不同(别名、缩写)

处理步骤:

3.4.1. 实体消歧(Entity Disambiguation)

规则 + 模型结合:

- 手机号一致 → 同人

- 身份证一致 → 同人

- 设备指纹距离 < 阈值 → 同设备

3.4.2. 数据清洗

- 缺失值填补

- 时间格式规范

- 字符串格式化

3.5. 知识存储(图数据库选择)

3.5.1. 主流图数据库

|-----------------|----------------------------------|

| 数据库 | 特点 |

| Neo4j | 最好用、生态丰富、支持 Cypher,适合中小规模 |

| NebulaGraph | 分布式高可用,适合亿级节点 |

| JanusGraph | 依赖后端存储(HBase/Cassandra),扩展性强 |

| ArangoDB | 多模型数据库 |

3.5.2. 金融风控一般选择:

- Neo4j (研发快)

- 或 NebulaGraph(生产级别+大规模)

3.6. 索引与查询设计

图数据库常用查询:

3.6.1. Cypher 示例

MATCH (u:User)-[:USE]->(d:Device)

WHERE u.id_card = 'xxx'

RETURN d3.6.2. 常见应用查询

- 共设备用户(羊毛党检测)

- IP 共用链路

- 商品 → 风险标签 → 客户 → 设备 的传播链路

- 支付路径图、资金流向图

3.7. 构建推理(Rule Engine + 图算法)

3.7.1. 规则推理(最常见)

例如:

用户 A 与 B 共用 3 个设备 → 高风险关系3.7.2. 图算法推理

使用:

- PageRank(核心用户)

- Louvain 社区检测(欺诈团伙识别)

- Shortest Path(路径风险发现)

- Connected Components(团伙聚类)

3.8. 可视化与分析平台搭建

可选工具:

- Neo4j Bloom(图谱可视化)

- Nebula Graph Studio

- Linkurious(高级图分析)

- Graphistry(GPU 加速)

- 自研前端(ECharts,G6,Cytoscape.js)

3.9. 风控知识图谱的应用(落地价值)

在金融风控中最常见的落地方式:

- 用户画像(标签系统 + 图谱特征)

- 设备/手机号关联检测(反欺诈)

- 风险传播路径分析(规则/策略回溯)

- 模型特征提取(图特征+深度图嵌入)

- 专家规则匹配(规则引擎 + 图规则)

- 策略治理与模型量化

4. 风控域知识图谱实战总结

4.1. 图数据库,在金融金融、信贷领域的作用? 业务场景是什么?

4.1.1. 图数据库的核心特征

图数据库(Graph DB)以节点(Node) 、**边(Edge)和属性(Property)**为基本元素:

- 节点:代表实体(如客户、账户、公司、交易、设备、IP、银行卡等);

- 边:代表关系(如转账、登录、关联、投资、控制、共享设备等);

- 属性:可用于描述节点和边的特征(如金额、时间、关系强度、交易频率等)。

优势:天然支持复杂关系的建模与查询,可高效执行"多跳"关联计算,比如"某客户的朋友的朋友是否也参与过同一笔交易"。

4.1.2. 在金融与信贷领域的主要作用

4.1.2.1. 反欺诈与关联欺诈识别(最典型)

场景:

- 多账户共用手机号、身份证、设备号、银行卡;

- 虚假借款人团伙作案(同一设备登录多个账户);

- "黑产"通过不同身份串联骗贷。

图数据库的作用:

- 建立账户--设备--手机号--银行卡--IP--公司等多维关系图;

- 实现多跳查询,如:

"A客户是否与任何已标记欺诈客户在2跳内有关联?"

- 可通过图算法(如PageRank、Community Detection、Connected Components)识别"欺诈团伙";

- 支持实时风控拦截:当新用户注册或发起交易时,快速计算其"图关联风险分数"。

🔹 常用图算法:

|----------------------|----------------------|

| 算法 | 作用 |

| Connected Components | 判断是否属于欺诈团伙 |

| PageRank | 判断节点在关系网络中的重要性(如中介人) |

| Louvain | 发现社群(欺诈团伙、灰产团伙) |

| Shortest Path | 判断风险客户到目标客户的最短路径 |

| Degree Centrality | 判断节点的活跃度/可疑度 |

4.1.2.2. 客户关系与企业穿透分析

场景:

- 企业信贷审批中需进行股权穿透分析;

- 查明企业实际控制人、关联企业、上下游关系;

- 银企互联中需识别企业与企业之间的资金流关系。

图数据库的作用:

- 建立企业→股东→投资→高管→企业的关系网;

- 实现股权穿透分析,如:

"该企业的最终控制人是谁?"

"企业A与企业B是否存在间接关联?"

- 结合工商、税务、司法、舆情数据,形成企业风险画像图谱;

- 应用在信贷审批与尽职调查环节中。

4.1.2.3. 信贷资金流向与风险传导监控

场景:

- 多层资金转账链路下,追踪贷款资金是否被挪用;

- 判断风险事件的"传染路径";

- 银行间、账户间的复杂交易网络分析。

图数据库的作用:

- 建立资金流向图谱(账户→交易→账户);

- 快速追踪"资金路径";

- 分析可疑转账链(例如资金回流、循环放贷、空转交易);

- 风险事件时(如企业违约),分析潜在风险传导路径,辅助预警。

4.1.2.4. 客户全景画像与关系营销

场景:

- 客户多渠道(APP、POS、企业关系、家庭关系)融合画像;

- 挖掘客户的社交圈层、购买偏好、共同特征;

- 识别潜在高净值客户群或交叉销售机会。

图数据库的作用:

- 将客户与交易、产品、地域、兴趣、社交关系等建成**"客户知识图谱"**;

- 利用图算法识别相似客户群;

- 支持"客户关系推荐":比如"与某高价值客户关系密切的人可能也是潜在客户"。

4.1.2.5. 黑名单共享与灰名单传播控制

场景:

- 黑名单客户往往会用新身份、新设备、新手机号再申请;

- 金融机构间可建立共享关系网络。

图数据库的作用:

- 构建黑名单节点及其关联关系图;

- 新申请时检测是否与黑名单图谱"相连";

- 可用近邻算法实现快速风险传导识别。

4.1.2.6. 合规与反洗钱(AML)

场景:

- 监控大额频繁交易、循环交易、分拆交易;

- 分析资金链条,识别"洗钱团伙结构";

- 满足监管穿透要求(如 FATF、央行反洗钱规范)。

图数据库的作用:

- 建立账户间交易网络;

- 识别复杂多层路径下的资金回流;

- 分析关键"中转节点";

- 支持监管报告生成(如"可疑交易链路可视化")。

4.2. 知识图谱典型技术架构

|-------|-----------------------------------------------|

| 层级 | 说明 |

| 数据采集层 | 日志、交易、征信、设备指纹、客户信息、工商数据 |

| 图构建层 | ETL + 实体解析 + 实体消歧 + 边关系构建 |

| 图存储层 | 图数据库(Neo4j、TigerGraph、JanusGraph、NebulaGraph) |

| 图计算层 | 图算法引擎(如Spark GraphX、GraphScope、TUGraph) |

| 应用层 | 欺诈检测、信贷审批、反洗钱、企业风险分析、可视化监控 |

4.3. 图数据系统实际案例简述

- **蚂蚁金服(芝麻信用):**构建"信贷欺诈图谱",实现设备号、手机号、银行卡号等的全域关联分析。用图计算实现毫秒级关联风险查询。

- **招商银行:**企业信贷穿透系统使用图数据库分析股权关系。自动识别"疑似一致行动人"或"隐形控制人"。

- **工商银行反洗钱系统:**通过交易关系图谱追踪资金流向;结合 PageRank 找出关键节点账户。

4.4. 图数据库在风控系统中作用有哪些?

4.4.1. 图数据库作用:

- 高效的关系查询(快速找到"某个用户和多少黑名单账户关联")

- 关系的可视化(辅助风控解释、审计分析)

- 实时规则校验:参与判断交易风险(例如最短路径、环路检测)。

- 图特征计算:为风控模型提供关键特征。

- 风险解释与审计:辅助人工决策和合规需求。

- 团伙/洗钱检测:通过图模式匹配发现复杂欺诈行为。

4.4.2. 作为实时风控规则引擎的一部分

风控决策时,系统会调用图数据库,判断交易相关的账户/设备/卡片是否落在"高风险网络"中。

举例:

- 规则:如果用户与黑名单用户的最短路径 ≤ 2,则拒绝交易。

- 规则:如果交易涉及的资金链条形成环路(洗钱特征),则触发人工审核。

图数据库在这里 直接提供判断结果,参与到实时风控决策。

4.4.3. 2. 图计算特征 → 进入风控模型

风控模型(比如逻辑回归、XGBoost、深度学习模型)除了使用交易金额、时间、地域等特征外,还会用 图特征。

常见特征:

- 用户到黑名单的最短路径长度

- 该用户所在团伙的规模(社区检测结果)

- 用户在资金流图中的中介度 / PageRank 分数

这些特征通常由图数据库或图计算引擎离线/实时计算后,输入到风控模型中。图数据库是 特征生产器,结果会影响决策。

4.4.4. 辅助人工审核 & 决策解释

一些高风险交易不能直接拒绝,需要 人工复核。

图数据库提供的可视化能力,可以帮助风控人员快速理解:

- 该用户和多少高危账号有关联

- 资金流向哪些异常账户

- 是否存在团伙行为

在这个环节,图数据库不是"算分器",而是 解释器,提高风控的可解释性。

4.4.5. 大规模反洗钱/团伙欺诈检测

在 AML(反洗钱)或大额团伙欺诈场景中,很多风险行为不是单点触发,而是通过子图模式匹配来识别:

- 环形转账 → 图检测环路

- 资金分拆 → 一对多的资金扩散模式

- 群体骗贷 → 多个用户共用同一银行卡/IP

这些模式需要 图计算能力 (不是传统 RDBMS 能胜任的)。这里图数据库就是 检测引擎,直接决定是否触发风控决策。

4.5. 图数据的信贷风控中典型应用场景?

4.5.1. 多头借贷识别

问题:用户同时在多家机构申请借款,导致"拆东墙补西墙"。

图建模:

- 节点:借款人、手机号、身份证、设备、银行卡

- 边:借款人 ↔ 设备、借款人 ↔ 银行卡、借款人 ↔ 手机号

检测逻辑:

-

- 发现多个借款人共享同一手机号/银行卡/设备 → 疑似多头借贷。

- 计算借款人到高风险借款人的最短路径 → 距离越近风险越高。

4.5.2. 团伙骗贷(羊毛党)

问题:黑产通过批量注册账号、使用虚假资料骗取贷款。

图建模:

- 节点:用户、设备、IP、银行卡、收款账户

- 边:用户与设备/IP/银行卡的关联

检测逻辑:

- 通过社区发现算法,识别"高密度用户集群" → 同一团伙。

- 检测是否存在"多个用户共用少量设备/IP"。

- 找到资金最终流向是否汇聚到同一个收款账户。

4.5.3. 虚假身份 & 中介欺诈

问题:中介或黑产利用虚假身份资料牟利。

图建模:

- 节点:身份证、手机号、地址、联系人

- 边:用户 ↔ 身份证、用户 ↔ 联系人、用户 ↔ 地址

检测逻辑:

- 多个用户使用同一个身份证号/地址/紧急联系人。

- 分析用户与"黑名单联系人"的路径距离。

- 检测"高风险中介节点"(高 betweenness 的节点,频繁作为多个用户的联系人)。

4.5.4. 关联关系欺诈(熟人骗贷 / 套现)

问题:借款人通过熟人关系包装信用。

图建模:

- 节点:用户、联系人、社交关系

- 边:通讯录关系、紧急联系人关系、推荐人关系

检测逻辑:

- 识别"虚假推荐链":一群互相推荐的用户形成闭环,但都没有良好还款记录。

- 检测"黑名单联系人" → 判断新借款人风险。

4.5.5. 资金流转与反洗钱

问题:借贷资金被快速转移,掩盖真实流向。

图建模:

- 节点:借款账户、收款账户、商户、银行卡

- 边:转账、提现、支付

检测逻辑:

- 检测资金环路(洗钱典型特征)。

- 资金拆分(一个账户资金分散到多个下游账户)。

- 资金汇聚(多个账户资金集中到一个可疑账户)。

4.5.6. 黑名单传播

问题:黑名单用户往往会带动周边关系用户风险上升。

图建模:

- 节点:用户、设备、银行卡

- 边:共享关系(共用设备/IP/银行卡)

检测逻辑:

- 计算用户到黑名单的最短路径 → 距离越短风险越大。

- 传播模型:一个黑名单节点会提高邻居节点的风险评分。

4.5.7. 信贷社群风险管理

问题:在小微企业、供应链金融中,企业之间存在担保关系、合同关系。

图建模:

- 节点:企业、法人、担保人、合同、银行

- 边:担保、合同签署、股权关系

检测逻辑:

- 识别"担保链过长"的风险(连环担保 → 多米诺效应)。

- 检测企业法人是否同时在多个高风险企业担任职务。

- 找到"隐形集团企业"(通过股权和担保关系连成团伙)。

4.6. 知识图谱系统在金融行业数据量级是多少? 数据量大会带来什么影响?

这是图数据库、知识图谱在金融行业落地时最核心的挑战之一 :数据量级巨大,且关系复杂。下面我们从实际案例和技术角度系统地分析:

4.6.1. 金融行业知识图谱的数据量级(实际情况)

不同金融机构、不同场景下,数据量级差异较大,但可以从几个典型类别来概览👇

|---------------------------------|--------------|---------------|------------------------------------------------|

| 应用场景 | 节点数量 | 边数量 | 特征描述 |

| 企业知识图谱(股权穿透、工商关系) | 1,000万 -- 1亿 | 5,000万 -- 10亿 | 全国企业、股东、高管、投资关系,数据源包括天眼查、启信宝、企查查、国家企业信用信息公示系统等 |

| 个人信贷图谱(客户、账户、设备、手机号) | 5,000万 -- 3亿 | 1亿 -- 30亿 | 客户维度高、设备与账户关系密集(例如每人多个手机号、多个账户) |

| 交易/资金流图谱(账户转账、支付交易) | 1亿 -- 10亿 | 10亿 -- 1000亿+ | 大型银行或支付机构每天新增千万级交易记录 |

| 反欺诈/反洗钱图谱(跨平台、跨账户) | 1,000万 -- 5亿 | 1亿 -- 500亿 | 跨渠道、跨地域的风险用户关系和交易图 |

| 综合金融知识图谱(客户、产品、合同、企业、交易、行为) | 10亿+ 节点 | 1000亿+ 边 | 融合客户、企业、产品、风控、征信等多源异构数据,接近互联网级数据量 |

头部金融机构(如工行、建行、蚂蚁、腾讯金融),其知识图谱一般都在:

- 节点量级:1亿 -- 100亿;

- 边量级:100亿 -- 1000亿;

- 日增量:百万 ~ 千万级。

4.6.2. 大规模数据量带来的挑战与影响

图数据库的性能瓶颈不在"数据存储",而在"关系遍历(Traversal)与图计算"。数据量越大,这些问题越明显

4.6.2.1. 1️⃣ 存储与计算成本急剧上升

- 关系型数据库可通过分表、分区来横向扩展;

- 图数据库的关系数据密集(一个节点可能关联上千条边),存储开销远高于表结构数据;

- 大量边索引(Edge Index)带来 磁盘IO压力;

- 需要分布式存储(如 NebulaGraph、JanusGraph + Cassandra/HBase)。

举例:假设一个节点平均有 100 条边,1亿节点意味着至少 100亿条边。每条边占用约 100B(含索引) → 仅边就需近 1TB 存储。

4.6.2.2. 2️⃣ 查询性能急剧下降(尤其是多跳查询)

- 图查询通常涉及多跳(例如 "2跳内的风险节点"),随着数据量增长,关系指数级爆炸;

- 单机Neo4j在1亿节点、10亿边规模时,多跳查询(3跳以上)耗时可达数秒至数十秒;

- 若没有预计算或缓存机制,会导致实时风控不可用。

解决策略:

- 使用 分布式图数据库(TigerGraph、NebulaGraph、HugeGraph);

- 对高频查询图模式建立 模式索引(Pattern Index);

- 使用 近实时缓存(Graph Cache) 存储常用子图;

- 通过 图嵌入(Graph Embedding) 将关系向量化后进入AI模型(降低实时遍历)。

4.6.2.3. 3️⃣ 关系爆炸与热点节点问题

- 金融网络中常见"超级节点":如支付平台、常用设备号、常见IP;

- 这些节点连接成千上万条边,会导致:

-

- 查询时CPU、内存飙升;

- 数据分布不均;

- 子图拉取过大;

- 图算法(如PageRank)迭代时间剧增。

解决策略:

- 设置 节点度阈值(Degree Capping);

- 对热点节点做分裂/抽象聚合;

- 使用 异步计算+采样算法(Sampling);

- 对常用模式(Pattern)预计算。

4.6.2.4. 4️⃣ 数据一致性与更新难题

知识图谱不是静态结构,金融场景中每天新增数据:

- 新交易、账户注册、黑名单变动;

- 企业股权变更、工商注销;

- 新设备号、新IP、新征信记录。

如果全量重构图:

- 图构建耗时长(几小时到几天);

- 更新成本高。

解决策略:

- 使用 增量图构建管道(Incremental Graph ETL);

- 对实时流(Kafka)接入的数据进行 流式图更新;

- 利用 时间版本图(Temporal Graph) 保存变化历史。

4.6.2.5. 5️⃣ 算法可扩展性与计算延迟

图算法(社群检测、PageRank、相似度计算等)在亿级边上运算代价极高:

- 分布式计算框架(如 GraphX、GraphScope、Flink Graph)常需小时级别;

- 对实时风控系统(要求 <1s)不可行。

解决策略:

- 离线训练 + 在线召回;

- 图算法结果向量化存储(Graph Embedding + VectorDB);

- 模型推理用"图特征快照"而非实时计算。

4.6.2.6. 6️⃣ 安全与隐私问题

知识图谱中往往融合:

- 客户个人信息(PII);

- 交易记录;

- 信用评分;

- 企业机密信息。

需遵守金融监管要求(如《个人信息保护法》《数据安全法》),并引入:

- 数据脱敏;

- 节点/边访问权限控制;

- 图分区隔离;

- 审计追踪。

4.7. 怎么实现千万级别图数据库中查询时间到ms级别?

要在千万级 (数千万节点、数亿边)规模的图数据库里把查询响应缩到 毫秒级(ms) ,需要在建模、存储、计算、预计算/缓存、查询设计与运维上做系统化优化。下面给你一套实战可落地的方案 ------ 包含原则、具体手段、示例与权衡,按优先级和可实施性排序,方便你直接照着做。

把多跳、重计算、热点扫描变成预计算/近似/局部计算 + 高效本地访问 + 并行分布式执行,并用缓存与向量化手段减少在线遍历量。

4.7.1. 数据建模与范式化(最先做)

- 按访问模式建模:先梳理常见查询(1-hop、2-hop、路径检测、社群检测、相似性查询),针对这些优化节点/边类型与属性。

- 把高频关系物化:将常查的聚合关系做成专门的边或物化表(materialized edges),避免每次多步展开计算。

- 避免超大度节点直接遍历:对"超级节点"(如平台账户、公共IP)做抽象或分裂(把公共节点拆成按时间/场景的子节点)。

4.7.2. 索引与存储优化

- 建立合适的索引:节点主键索引、按关系类型+属性索引、按时间的边索引(时间序列边)。

- 邻居按度优先存储(adjacency lists):把邻居集中、按热度/权重排序,利于快速读取前 N 条。

- 列式/压缩存储:使用支持列式或压缩存储的图引擎(减少 IO)。

- 热点分区(degree-aware partitioning):把高出度节点与其邻居放在同一分片以减少跨机器通信。

4.7.3. 分布式架构与分片策略

- 图分片策略 :采用 边切分(edge-cut) 或 顶点切分(vertex-cut),并根据查询类型选择(查询局部性强用vertex affinity)。

- 本地优先(locality):按社区或业务域划分分区,保证常用子图局部可查询。

- 副本与读写分离:对只读热点子图做更多副本(减少延迟)。

4.7.4. 预计算 / 物化视图(决定性提升)

- 预计算 k-hop 邻居(k=1/2):对常查的 1-2 hop 邻居直接维护缓存或物化表(例如:每个用户的 2-hop 风险邻居列表)。

- 预计算图算法输出:如 PageRank、社群ID、关键度(centrality)等定期/增量计算并存储在节点属性里。

- 增量更新:使用流式 ETL(Kafka → 流处理)更新物化视图,避免全量重算。

4.7.5. 缓存层(毫秒级的关键)

- 二级缓存结构:

-

- L1:本地内存/进程缓存(如 Caffeine)用于极短期热点;

- L2:分布式缓存(Redis)用于共享热点 / 物化子图。

- 缓存粒度:缓存节点邻居、路径片段、算法结果(社群 id、embedding)而非完整大子图。

- 缓存策略:按业务 TTL、版本号、变更事件驱逐(基于消息总线触发失效)。

示例(Redis Key 设计):

key: user:neighbors:2hop:{userId}:v{version} // 存 json 或二进制邻居列表

key: account:risk_neighbors:{accountId} // 直接存常用风险邻居4.7.6. 在线近似与向量化(降低遍历成本)

- 图嵌入(Graph Embedding):把节点向量化(GraphSAGE、DeepWalk 等),相似性检索通过向量相似度在向量库(Milvus/Faiss)中做近邻查询(ms 级),再回到图做少量验证。适合相似客户推荐、异常相似性检测。

- 近似算法:如 LSH、Bloom filter、采样遍历,换取极低延迟与可控精度下降。

4.7.7. Query & Algorithm 层优化

- 限制遍历宽度与深度:线上查询默认限制 k-hop 和分支宽度(例如 2-hop 且每层最多 200 个邻居)。

- 基于模式的快速查找(pattern index):对常见子图模式做索引(例如 A--B--C 三节点模式直接用索引检索)。

- 异步/批量化请求合并:对短时间内对相同节点的大量请求做合并处理(batching)。

4.7.8. 特殊硬件与部署

- 高速 NVMe SSD / PMEM:减少随机读延迟。

- 足够内存(内存优先):把常用索引/邻居放内存。

- 网络优化:低延迟网络(RDMA 或 25/100Gbps)减少跨节点通信成本。

- CPU核与 NUMA 优化:图计算常对 CPU 密集,保证核数充裕与内存带宽。

4.7.9. 引擎选择与能力利用

- 实时图专用引擎:TigerGraph、NebulaGraph、HugeGraph、Dgraph 等在分布式实时查询上各有优势;选择支持:

-

- 高效邻居扫描、

- 模式索引、

- 物化/视图、

- 支持增量更新。

(按业务做评估与压测)

4.7.10. 监控、剖析与持续迭代

- 埋点关键指标:查询时延 P50/P95/P99、IOPS、网络延迟、热点节点访问频次、缓存命中率。

- 查询剖析:记录慢查询,定位是否为遍历爆发或跨分片通信导致。

- 压力测试与灰度:用真实样本做压测(含热点)并调整阈值。

4.8. 生产中对于知识图谱的数据更新有什么问题? 能实时更新知识图谱吗? 如果不能应该怎么更新知识图谱?

知识图谱在生产中一般无法做到完整"实时更新",只能做到"近实时 + 分层更新 + 增量更新"。 原因涉及:存储结构、关联复杂度、计算开销、图一致性、写入冲突 等问题。

生产级知识图谱无法实现完整实时更新,因为图数据库在写入吞吐、锁机制、拓扑一致性、分布式事务方面存在天然限制。而风控场景中又需要稳定的图结构和高性能的查询。因此业界普遍采用:增量实时 + 批处理更新 + 图快照 + 热冷图结合 的体系,实现既可用又成本可控的图谱系统。原因可以分为技术层面和业务层面:

4.8.1. 无法实时更新技术层原因

4.8.1.1. ❌ 图结构高度关联,实时写入易造成锁冲突

图数据库(Neo4j / JanusGraph / HugeGraph)一条边的写入可能需要:

- 修改节点 A

- 修改节点 B

- 修改 edge 索引

- 维护反向索引

- 更新属性、标签

节点数量高、边数量大时:⚠ 高并发写入 = 死锁 + 性能抖动 + 读延迟增大。所以图数据库对强实时写入非常敏感。

4.8.1.2. ❌ 图数据库写入吞吐量远低于读吞吐量

例如 Neo4j:

- 读 QPS 可达 万级

- 写 QPS 常常只有 几十 ~ 几百

完全不能承担高并发实时写入。

4.8.1.3. ❌ 图计算通常依赖全局结构

例如风控中的图算法:

- 社交网络最短路径

- 关联检测

- 中心性计算

- 社区发现

- N-hop 可疑用户传播

这些都依赖整体拓扑,一旦结构变动,算法结果重新计算代价巨大。因此:图的全局指标不可能实时更新。

4.8.1.4. ❌ 图数据库的 ACID 对实时要求是灾难

金融风控需要强一致性,但图数据库天然不擅长高并发写:

- 写锁范围大

- 跨节点事务复杂

- 集群下分布式事务成本高

因此 强一致实时写入基本不可行。

4.8.1.5. ❌ 图存储规模大,实时更新需要巨大的存储和计算

风控图谱往往:

- 用户节点:千万级

- 设备节点:千万级

- 手机号、银行卡、地址节点:千万级

- 边:上亿到几十亿

实时更新等于实时大数据处理,成本过高、工程不可行。

4.8.2. 无法实时更新技业务层原因(风控常见)

4.8.2.1. ❌ 风控业务需要的是"稳定图",不是一个不断抖动的图

如果图结构实时变化,风险规则就会:

- 出现瞬时波动

- 关联路径抖动

- 社区结构变化

风控策略无法稳定运行。

4.8.2.2. ❌ 很多图关系并非强实时信息

如:

- 手机号绑定关系

- 银行卡使用行为

- 设备多账号登录

- 联系人共线关系

- 注册、借款、大额支付

这些一般是小时级更新,不需要毫秒同步。

4.8.3. 正确实践:分层 + 分桶 + 增量的更新方式

4.8.3.1. ✔ 方式 1:增量更新(Near Real-Time)

经典做法:每 5 秒、30 秒 或者每分钟更新增量边。流程:

OLTP 业务 → Kafka → Stream(Flink) → 图数据库(增量写)适用场景:

- 新注册用户

- 新的设备登录

- 新的手机号绑定关系

特点:节点/边的新增可近实时,但不更新全局指标

4.8.3.2. ✔ 方式 2:批处理更新(离线)

每天凌晨或者每小时重建:

- 用户画像

- 全局连接组件

- 图嵌入(Graph Embedding)

- 社区结构

- 多跳风险传播

这些不能实时,只能批处理。

4.8.3.3. ✔ 方式 3:图"快照"体系(Snapshot)

为保证风控稳定:

- "今天的图"不动

- 所有决策都用当天版本

第二天凌晨生成新的版本。

好处:

- 决策逻辑稳定

- 调试可追溯

- 框架不会因为实时写变得抖动

4.8.3.4. ✔ 方式 4:热图(Live Graph) + 冷图(Offline Graph)融合

这是大厂风控常用方式(蚂蚁、度小满、京东金融均如此):

冷图(离线计算)→ 大规模结构

热图(在线增量)→ 最新变化策略使用时:

- 主要用冷图

- 对于近几分钟的关系,用热图补充

例如:

- 新设备关联用户

- 新设备多头申请

- 新手机号关联多设备

都是热图来补。

4.8.3.5. ✔ 方式 5:数据湖 + 图索引(Graph Index)

数据湖(Hive / Iceberg / Hudi)保存全量边,在线存储系统保持热点边,基本架构:

离线:Hive/Hudi → 图批处理

在线:Redis/HBase/HugeGraph → 关联检索两者合并提供风控决策。

4.8.4. 最终现实结论(必须明确)

4.8.4.1. 不可能做到"图全局实时更新"

除非是几万节点的小图,但金融风控是千万亿级节点。

4.8.4.2. 可以做到"增量实时更新一部分图"

如新增节点、最近几分钟新增边。

4.8.4.3. 全局图指标与图计算绝不可能实时

如:

- PageRank

- Connected Component

- K-hop 风险传播

- 社区发现

- Graph Embedding

都只能批处理。

4.8.4.4. ❗ 最好采用"冷热图结合",这是行业标准

既满足实时性,也保持计算成本可控。

4.9. 哪些属于热图(Live Graph) 哪些属于:冷图(Offline Graph) 什么数据适合在热图? 什么数据适合在的冷图?

金融风控实际生产经验 + 图数据库特性 + 大厂(蚂蚁、度小满、京东)的实践 ,把 热图(Live Graph) 和 冷图(Offline Graph) 的区分讲得非常清晰,并给出"哪些数据适合放热图 / 冷图"的完整清单。这是一套在风控图谱里最常用的分层方式,你可以直接用在你的系统设计文档里。

4.9.1. 热图与冷图理解

- ✔ 热图(Hot / Live Graph):用于实时风控决策,只保存"最新、强时效性、少量但关键"的关系,要求毫秒级读写。

- ✔ 冷图(Cold / Offline Graph):用于离线计算与大规模图分析,保存"历史全量、规模巨大、用于画像/模型/大图计算"的数据。

4.9.2. 热图(Live Graph)到底是什么?

热图 = 近实时新增的节点与边(分钟级或秒级同步)。

**特点:高时效 + 高价值 + 小体量 + 高频调用。**热图一般存储在:

- Redis(hash / set / zset)

- Tair(高性能 KV)

- HBase(热点边)

- HugeGraph / JanusGraph(在线图库的一部分)

- Kafka/Flink 的实时计算结果

4.9.3. 🎯 热图适合存储:

**▷ 最近几分钟/小时内发生的强风险事件或行为,**例如:

|---------------------|---------|-----------------------|

| 热图典型数据 | 为什么要实时? | 存储位置 |

| 设备与用户最新绑定关系 | 反欺诈关键特征 | Redis/HBase |

| 短时间内同设备注册多账号(撞库/羊毛) | 秒级风控 | Redis |

| 最新登录 IP、地理位置 | 异常登录检测 | Redis |

| 最新交易、提现、借款请求节点 | 实时决策使用 | HBase |

| 设备多头申请行为(过去 10 分钟) | 反欺诈核心信号 | Redis |

| 新增联系人关系(通讯录上传) | 催收、反欺诈 | HBase |

| 中台事件流新增的边 | 高时效事件 | Kafka → Flink → Redis |

| 黑名单新增节点关系 | 秒级更新 | Redis |

热图的本质:**只放最新的、高价值的、对实时决策有影响的数据。**热图不存"长期历史",不做大型图计算。

4.9.4. 冷图(Offline Graph)到底是什么?

冷图 = 全量历史图谱(大而重)。

**特点:大规模、非实时、用于离线图计算与画像。**存储在:

- Hive / Hudi / Iceberg(大规模边)

- Neo4j(离线批量结构)

- TigerGraph(离线图)

- HugeGraph(冷分区)

冷图一般一天更新一次(T+1),也可能 1 小时更新一次(H+1)。

4.9.5. 🎯 冷图适合存储:

▷ 全量历史、低频变化、需要跑图算法的大规模关系

|------------------------------|----------|------------------|

| 冷图典型数据 | 为什么适合冷图? | 存储位置 |

| 用户-设备历史所有绑定关系 | 数据量巨大 | Hive/Hudi |

| 历史所有借款记录、转账记录 | 长期画像用 | Hive |

| 历史所有银行卡绑定关系全量边 | 离线分析/建模 | Iceberg |

| 历史所有登陆 IP 关系 | 用于反欺诈画像 | Hive |

| 用户社交行为全量关系 | 用于图社区算法 | Graph DB Offline |

| 图嵌入(Graph Embedding)向量 | 基于冷图计算 | HDFS |

| PageRank、Connected Component | 必须全局计算 | HDFS |

| 多跳风险传播(N-hop)结果 | 离线运行 | Hive/HBase |

| 用户画像标签(如 IGL, RFM) | 非实时更新 | HBase |

冷图的本质:大规模、低频更新、用于脱敏分析、画像生成、模型训练。

4.9.6. 如何判断数据应该进入"热图"还是"冷图"?

给你一个简单易用的决策表:

|------|-----------------|-----------------|

| 维度 | 热图(Live) | 冷图(Offline) |

| 时效性 | 需要秒级/分钟级 | T+1、H+1 即可 |

| 变化频率 | 高频变动 | 稳定或低频 |

| 数据体量 | 小(< GB~几十 GB) | 超大(TB 级) |

| 计算需求 | 实时查询 | 离线图计算 |

| 使用场景 | 在线风控 | 模型训练 / 画像 / 图挖掘 |

| 数据形式 | 最新的增量边 | 全量节点 + 全量边 |

| 示例 | 新注册、新绑定、实时申请 | 历史行为、全量关系 |

一句话总结判断方式:一旦数据需要 "实时决策" → 热图 ,一旦数据需要 "全局分析/历史追踪" → 冷图。

4.10. 风控知识图谱典型示例

以下是金融风控知识图谱常见分类(行业标准)

4.10.1. 🔥热图(Hot Graph)

设备 - 用户(过去10分钟)

用户 - 手机号(最新绑定)

用户 - 登录IP(最近1小时)

设备 - 申请事件(实时事件流)

设备多头申请计数(10分钟窗口)

手机号 - 设备 最新1~3次登录

实时黑名单4.10.2. 🧊冷图(Cold Graph)

用户所有历史行为

所有交易记录(借款/还款/支付)

多跳社交关系(N-hop)

设备历史使用情况(全量年份)

用户 AUC / 用户画像特征

图聚类结果、图嵌入向量

历史反欺诈相关边(全量)

联系人图谱(完整历史交叉)4.10.3. 🎯 为什么要"热图 + 冷图结合"?

因为:冷图 大但不快,热图 快但不全,所以风控系统在决策时: 决策引擎 = 热图实时判断 + 冷图支撑画像。 例如一个用户来申请贷款:

- 查询热图:

-

- 最近 10 分钟是否多设备登录?

- 是否有抢注册行为?

- 是否出现刷单/撞库?

- 查询冷图:

-

- 过去半年设备关联情况

- 历史有无欺诈团伙

- 其所在社群的风险指数

- 图嵌入的风险度

两者合并形成 真正有用的风控判断。

4.11. 互联网大厂普遍采用的知识抽取技术体系(ChatGPT)

|--------|-----------------------------|

| 技术类型 | 典型工具/模型 |

| 实体抽取 | BERT-CRF、UIE、RoBERTa、Doubao |

| 关系抽取 | CasRel、TPLinker、UIE |

| 事件抽取 | UIE、OneIE、LLM |

| 弱监督 | Snorkel-like、LLM 自动标注 |

| 规则抽取 | DSL、正则、模式匹配 |

| LLM 抽取 | Doubao/ChatGPT/GLM 结构化抽取 |

大型互联网公司(字节跳动、阿里、腾讯、百度、美团)在构建知识图谱时使用 多模态 + 规则 + 深度学习的混合抽取体系,整体包含:

4.11.1. 规则抽取(Rule-based / Pattern-based Extraction)

适用于:

- 明确结构化的业务文档(产品规格、指标文档)

- 大规模高精度抽取场景(强业务约束)

使用方式:

- DSL(领域规则语言)

- 正则表达式 + 模式匹配

- OpenIE + 手工过滤

- 领域模板(如金融、广告、内容安全)

字节跳动在内容安全、广告审计中大量使用规则&模板

4.11.2. 深度学习模型 / Transformer 系列抽取

NER(命名实体识别)

常用模型:

- BERT / RoBERTa / NEZHA

- ERNIE(百度开源,但业内大量使用)

- ChatGLM tokenizer + 自训练模型

- LLaMA(ByteDance 公开场合提到内部使用 LLaMA 进行 NLP 任务)

- mBERT 处理跨语言文本

典型任务:

- 人名、机构、产品、内容标签提取

- 风控特征抽取、用户意图抽取(你正好风控方向)

4.11.3. 关系抽取(RE, Relation Extraction)

主流技术:

- BERT + Softmax 分类

- Span-based relation extraction

- CasRel / TPLinker(效果非常好,很多大厂用)

- UIE(百度提出统一信息抽取,大厂广泛采用)

特别是 UIE (Unified Information Extraction)

- 2023 起各大厂内部大量采用

- 模型可统一处理 NER、RE、事件抽取

- 结合 Prompt 效果优异

字节跳动招聘 JD 明确写过:"熟悉结构化抽取模型,如 BERT-CRF、TPLinker、UIE 等优先"

4.11.4. 事件抽取(Event Extraction)

用于:

- 内容推荐(识别事件:发生了什么)

- 舆情监测

- 风控(识别:逾期、违约、投诉、欺诈事件)

常用技术:

- Trigger + Argument模型

- OneIE

- UIE + Prompt 式事件抽取

4.11.5. 大模型(LLM)知识抽取(最新趋势)

字节跳动从 2023--2024 开始使用 LLM 做知识抽取:使用方式:

- Prompt 信息抽取("从文本中提取XX字段")

- 多轮自问式抽取

- 稳定结构化输出 JSON

- LLM + 工具链(验证器、Schema 约束)

模型来源:字节跳动自研大模型"抖音云雀(Doubao)"

用于:

- 文本理解

- 内容理解

- 信息抽取

- 推荐特征生产

在知识抽取部分,类似 OpenAI 的 Structured Output:

Extract entities and relations in JSON format:

{

"entities": [...],

"relations": [...]

}字节跳动在广告、内容审核、推荐等场景对 LLM 抽取应用非常多。

4.11.6. 知识蒸馏 / 弱监督 + 半监督抽取(大厂常用)

互联网公司大量采用弱监督来扩大训练集:方法包括:

- Snorkel 弱监督框架(自己做类似体系)

- Rule distillation(规则蒸馏给模型)

- Teacher-student(LLM 教小模型)

例子:LLM 自动标注 10 万条 → 训练小模型(4B)执行线上抽取。字节跳动在高吞吐量业务(推荐、搜索)最爱用此方式。

4.11.7. 知识增强(K-Adapter / KEPLER 类)

为了提升抽取 + 下游结构化质量,字节跳动、阿里会:

- 使用实体字典增强(gazetteer)

- 使用图神经网络(GNN)增强结构约束

- 多任务训练(NER+RE+Event)

用于提升一致性与鲁棒性。

4.12. 字节跳动典型场景中的知识抽取方式(公开信息)

4.12.1. 内容推荐

技术:

- Title/Caption NER(实体识别)

- Tag 抽取

- 事件抽取

- 用户兴趣点抽取

使用模型:

- BERT 系列

- RoBERTa,MacBERT

- UIE

- LLM(Doubao)

4.12.2. 内容安全 / 审核

技术:

- 敏感实体识别

- 场景 + 事件抽取(如暴力、色情、谣言)

- 多模态抽取(图文结合)

模型:

- 文本:BERT + CNN + GRU

- UIE 结构化抽取

- LLM 做高精审判

- OCR 内容结构化抽取

4.12.3. 广告知识图谱

技术:

- 商品实体抽取(商品、品牌、型号)

- 属性抽取(配置、参数)

- 类目关系抽取

模型:

- TPLinker、CasRel

- BERT-CRF

- LLM+JSON 抽取

- URL 多模态融合

4.12.4. 风控(你熟悉的方向)

字节跳动金融业务(如抖音支付)使用:

- 风险事件抽取(欺诈、盗刷、投诉)

- 实体抽取(用户、设备、IP)

- 特征抽取(文本 → 特征值 → 模型)

使用技术:

- BERT + BiLSTM

- UIE 事件抽取

- LLM 做高质标注

- 小模型推理(线上高吞吐)

结构非常类似阿里支付宝风控体系。