昇腾加持下的Llama 3.2:开源大模型推理性能1B英文原版与3B中文微调模型实测对比

快速预览

本篇文章全面测评了 Llama 3.2 系列大模型 在 昇腾(Ascend) 上的推理性能,并展示了在 GitCode 云端平台 上的快速部署与应用实践。文章首先介绍了 Llama 3.2 的英文原版与中文微调版本的加载与运行方法,随后对推理速度、稳定性和算力利用率进行了详细对比,重点展示了 1B 与 3B 模型在不同任务场景下的性能差异。通过实测结果可以看出,昇腾 能够充分发挥硬件加速优势,实现快速、稳定的模型推理,而 GitCode 平台提供的即开即用环境则大幅降低了部署难度,提升了开发效率。文章最后总结了昇腾 与 GitCode 平台的组合优势,指出其在科研验证、中文智能助手和教学示例开发中的应用价值,为国产 AI 大模型生态提供了可靠的技术支撑。

一.前言

随着开源大模型生态的快速发展,Llama 3.2 凭借其卓越的性能、开放的许可与高可扩展性,成为了科研与企业应用中备受关注的代表之一。然而,如何在国产AI算力平台上高效运行这类大模型,依旧是众多开发者关心的问题。

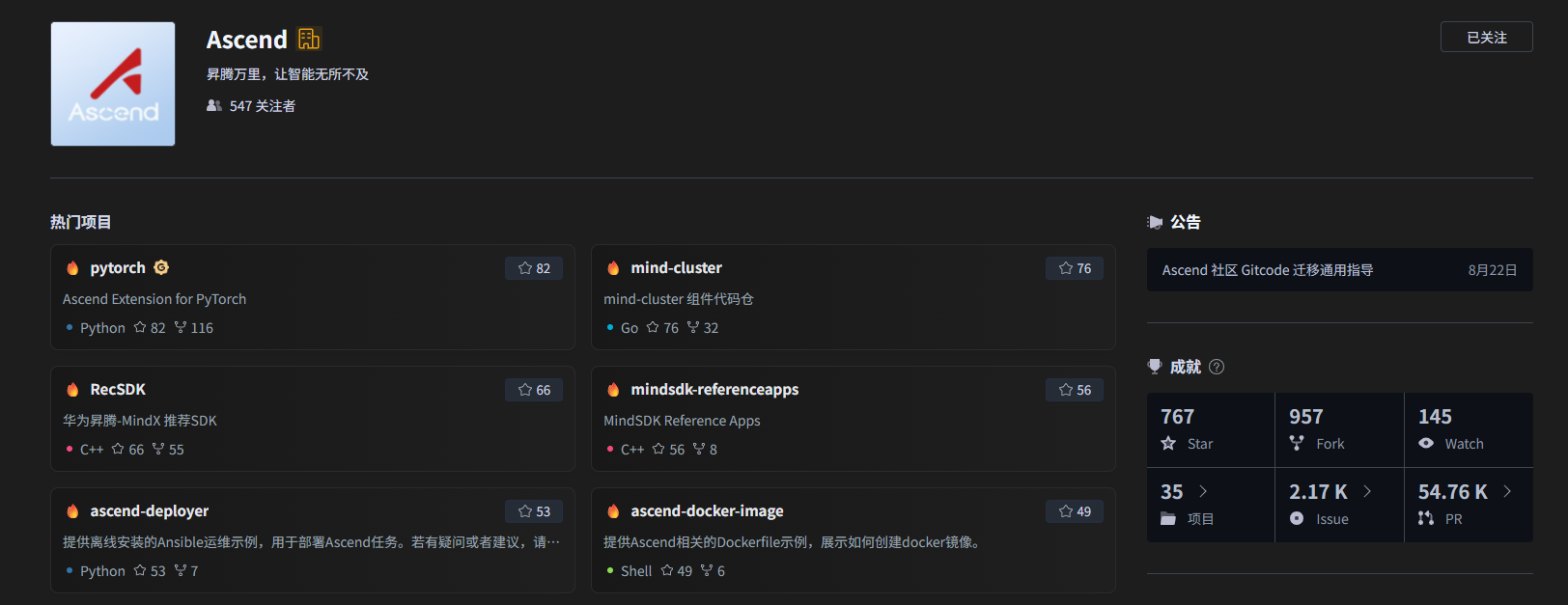

本次测评我们选择了华为昇腾(Ascend)AI处理器 作为核心算力平台,并在GitCode算力平台 上进行实测。

GitCode 是由 CSDN 开发者社区 联合 华为云 CodeArts 打造的新一代开源代码托管与协同研发平台,除了提供完善的代码管理、CI/CD、项目协作等功能外,还深度集成了昇腾AI服务器算力资源,可直接在云端进行大模型的推理、微调与部署。

基于这一平台,我们将从以下几个角度对 Llama 3.2 的表现进行全面评测:

- 环境搭建与模型加载 ------ 昇腾平台下的Llama 3.2部署流程

- 推理性能与能耗分析 ------ 对比测试

- 显存占用与延迟表现 ------ NPU优化下的实际收益

- 应用案例演示 ------ 基于Llama 3.2的对话系统搭建

通过这篇文章,你将了解如何在 昇腾AI算力平台(GitCode环境) 上快速部署Llama 3.2,并掌握国产算力平台在大模型推理领域的真实性能表现。

博主之前还测评了 昇腾加持下的Llama-2-7b,详见文章:https://shangjinzhu.blog.csdn.net/article/details/153962164

二. 在 GitCode 平台上部署 Llama 3.2 推理环境

GitCode 是由 CSDN 开发者社区 与 华为云 CodeArts 联合打造的全新一代开源代码托管平台。它不仅提供完善的 代码托管、项目协作与版本管理 能力,还为人工智能开发者提供了基于 昇腾(Ascend)NPU 的高性能算力资源,特别适用于大模型的训练与推理任务。

Ascend 官方开源仓库地址:https://gitcode.com/ascend

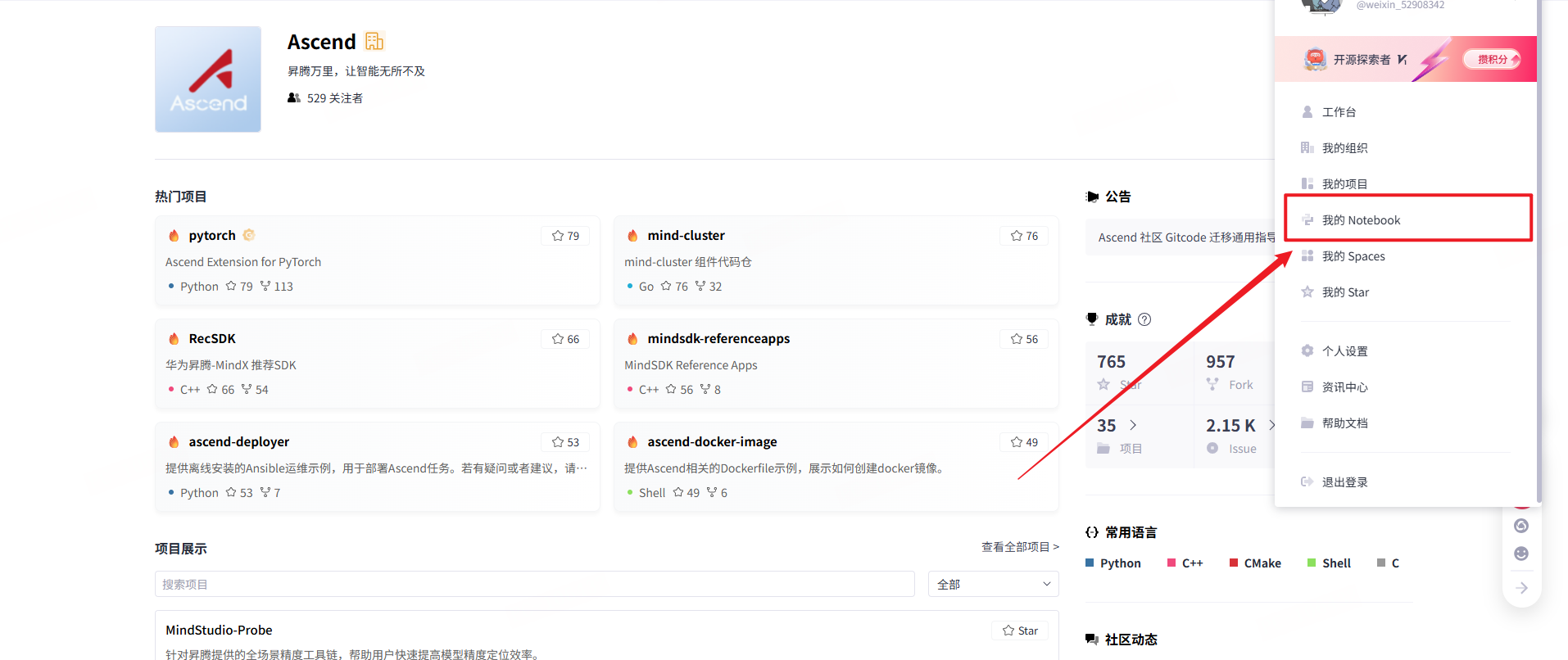

2.1 启动昇腾 Notebook 开发环境

首先,在 GitCode 首页中进入个人控制台,点击上方的 "Notebook 工作区",进入你的云端开发环境管理页面。

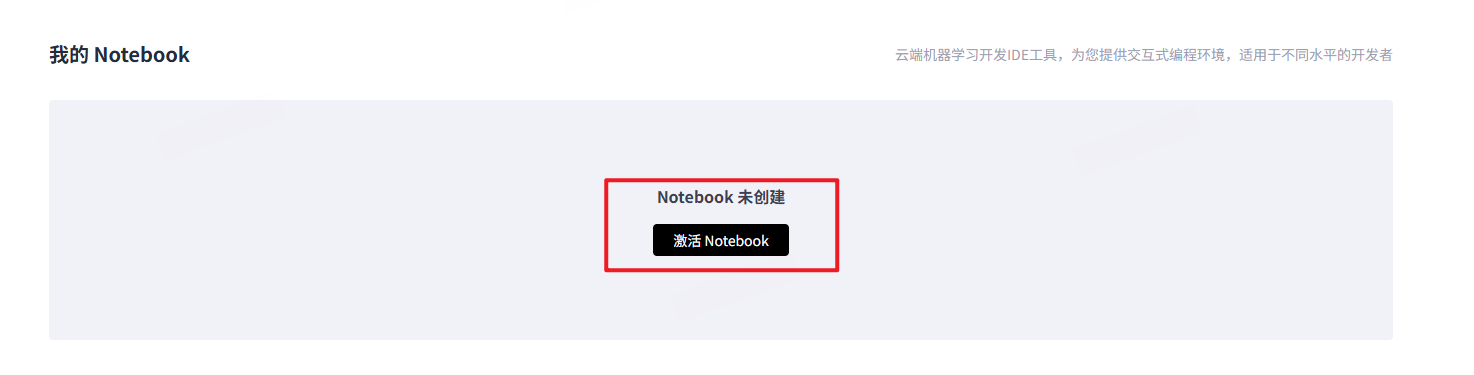

如果你是首次使用 GitCode 的云端 Notebook,系统会提示你 激活 Notebook 环境,点击确认即可一键开通。

2.2 配置昇腾推理计算资源

在 Notebook 启动页面中,选择合适的计算环境配置:

- 计算类型 :选择 NPU 类型 ,推荐使用规格

NPUbasic·1*昇腾910B·32VCPU·64GB。

此配置搭载一颗 昇腾 910B AI 加速芯片 ,具备 32 核 VCPU 与 64GB 系统内存,可高效执行 Llama 3.2 量化推理或中小规模微调任务。 - 容器镜像 :选择镜像

euler2.9-py38-torch2.1.0-cann8.0-openmind0.6-notebook。

该镜像预装:- Python 3.8

- PyTorch 2.1.0 (Ascend 适配版)

- CANN 8.0 驱动组件

- OpenMind SDK 工具集

能够直接支持昇腾 环境下的模型加载与推理。

- 存储配置 :建议分配 50GB 存储空间 ,用于保存模型权重文件与输出结果。目前 GitCode 提供 免费试用额度,适合大模型实验。

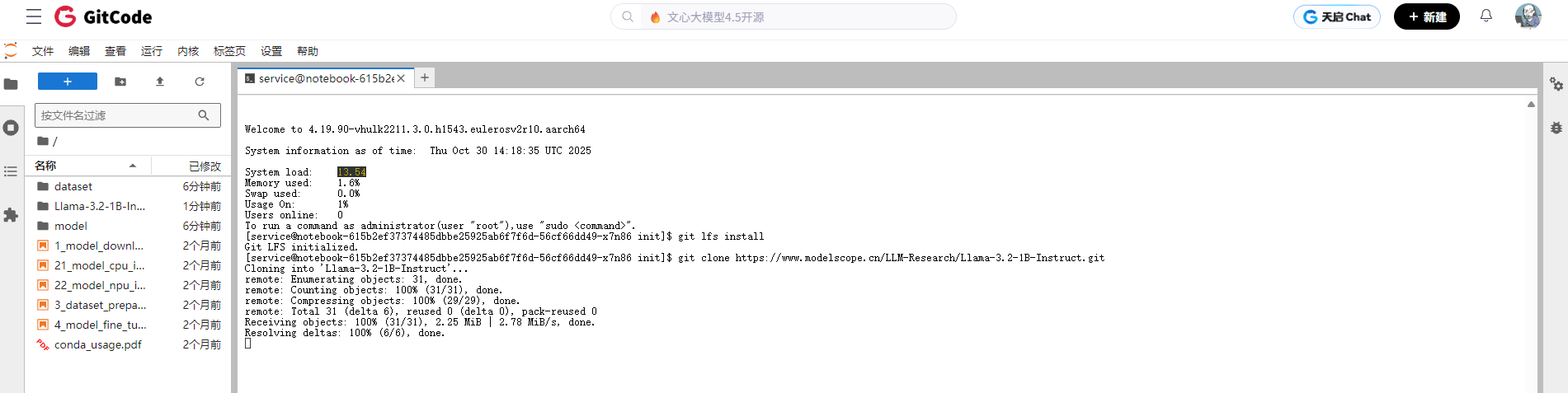

2.3 启动环境并验证 PyTorch-NPU 支持

点击 "启动 Notebook" 按钮后,系统将自动分配资源并启动容器。

待进入 JupyterLab 环境后,新建一个 Python 终端,执行以下命令以验证 NPU 是否可用:

python

import torch

print("PyTorch 版本:", torch.__version__)

print("NPU 是否可用:", torch.npu.is_available())

print("当前设备:", torch.npu.current_device())输出结果应类似:

PyTorch 版本: 2.1.0

NPU 是否可用: True

当前设备: 0如果返回 True,表示 GitCode Notebook 已成功挂载 昇腾 910B,后续即可部署 Llama 3.2 模型。

三. 拉取并运行 Llama 3.2 推理示例

Llama 3.2 是一系列多语言大型语言模型(LLMs),包括1B和3B大小的预训练和指令调优生成模型(文本输入/文本输出)。Llama 3.2 指令调优的纯文本模型针对多语言对话用例进行了优化,包括代理检索和摘要任务。它们在常见的行业基准测试中超越了许多可用的开源和闭源聊天模型。

安装 ModelScope:

bash

pip install modelscope这里有多种下载方式。比如有三种主要下载方式可选:

① 命令行方式 :使用 modelscope download --model LLM-Research/Llama-3.2-1B-Instruct 下载完整模型,或通过指定文件与路径(如 README.md)进行部分下载。

② SDK方式:通过 Python 调用

bash

from modelscope import snapshot_download

model_dir = snapshot_download('LLM-Research/Llama-3.2-1B-Instruct')可自动完成模型拉取与缓存。

③ Git方式 :在安装 git lfs 后执行

bash

git clone https://www.modelscope.cn/LLM-Research/Llama-3.2-1B-Instruct.git即可获取模型;若不需下载大文件,可使用

GIT_LFS_SKIP_SMUDGE=1 参数跳过 LFS 文件下载。

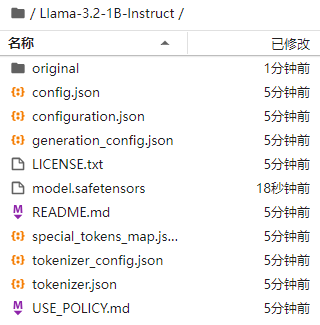

耐心等待,拉取成功后,模型如下。

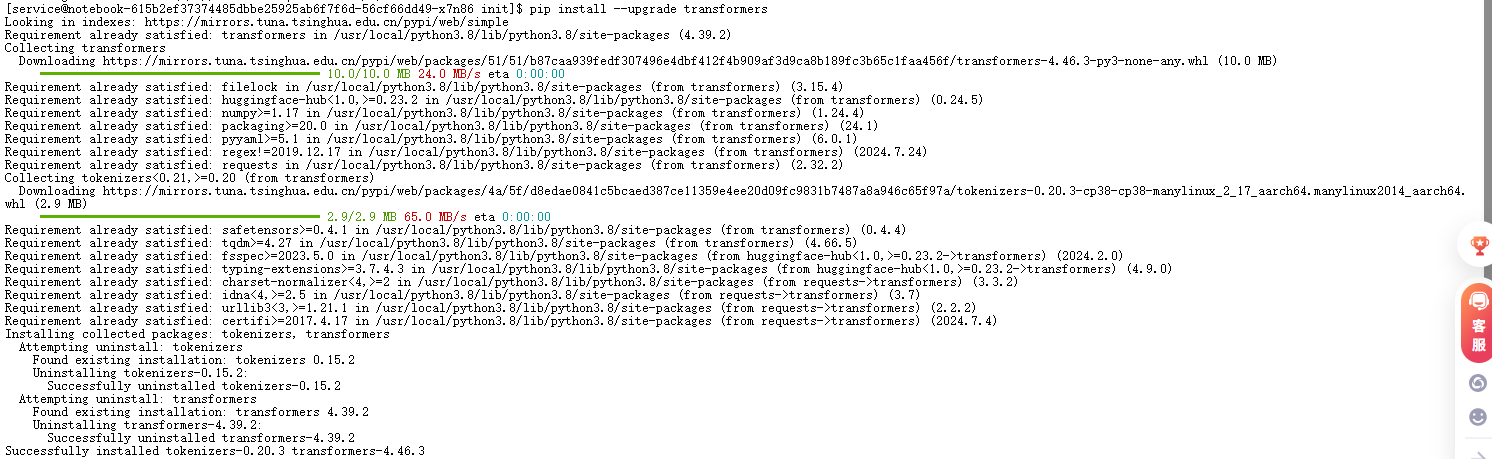

更新transformers版本

从transformers >= 4.43.0开始,可以使用Transformers pipeline抽象或者利用Auto类配合generate()函数来运行对话推理。

通过pip install --upgrade transformers更新transformers。

四. Llama-3.2-1B性能测评(昇腾)

依然参考之前的Llama-2-7b测评脚本。

python

import os

import time

from transformers import AutoTokenizer, AutoModelForCausalLM

import torch

import torch_npu

# 设置昇腾设备

device = "npu:0"

torch.npu.set_device(device)

def simple_llama_test(model_path="Llama-3.2-1B-Instruct"):

print("正在加载模型和tokenizer...")

start_time = time.time()

# 加载tokenizer

tokenizer = AutoTokenizer.from_pretrained(model_path)

# 加载模型到昇腾设备

model = AutoModelForCausalLM.from_pretrained(

model_path,

torch_dtype=torch.float16,

device_map=device

)

load_time = time.time() - start_time

print(f"模型加载完成,耗时: {load_time:.2f}秒")

# 设置pad_token

if tokenizer.pad_token is None:

tokenizer.pad_token = tokenizer.eos_token

# 测试用例

test_prompts = [

"请介绍一下你自己",

"写一个Python函数计算斐波那契数列",

"中国的首都是哪里?",

"请解释一下机器学习是什么",

"1+2+3+4+5等于多少?"

]

print("\n开始测试...")

print("=" * 50)

results = []

for i, prompt in enumerate(test_prompts, 1):

print(f"\n测试 {i}/5:")

print(f"问题: {prompt}")

# 构建对话格式

formatted_prompt = f"<s>[INST] {prompt} [/INST]"

# 编码输入

inputs = tokenizer(formatted_prompt, return_tensors="pt").to(device)

# 生成回复

start_time = time.time()

with torch.no_grad():

outputs = model.generate(

**inputs,

max_length=512,

temperature=0.7,

do_sample=True,

top_p=0.9,

pad_token_id=tokenizer.eos_token_id,

repetition_penalty=1.1

)

generation_time = time.time() - start_time

# 解码回复

response = tokenizer.decode(outputs[0], skip_special_tokens=True)

# 提取生成的文本(移除输入prompt)

if response.startswith(formatted_prompt):

answer = response[len(formatted_prompt):].strip()

else:

answer = response

print(f"回答: {answer}")

print(f"生成时间: {generation_time:.2f}秒")

print("-" * 40)

results.append({

"prompt": prompt,

"answer": answer,

"time": generation_time

})

# 统计信息

total_time = sum([r["time"] for r in results])

avg_time = total_time / len(results)

print(f"\n测试总结:")

print(f"总测试问题: {len(results)}")

print(f"总生成时间: {total_time:.2f}秒")

print(f"平均生成时间: {avg_time:.2f}秒")

return results

if __name__ == "__main__":

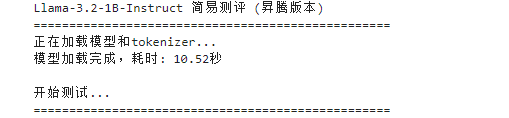

print("Llama-3.2-1B-Instruct 简易测评 (昇腾版本)")

print("=" * 50)

try:

results = simple_llama_test()

print("\n测评完成!")

except Exception as e:

print(f"错误: {e}")

print("请检查:")

print("1. 模型路径是否正确")

print("2. 昇腾环境是否配置正确")

print("3. 是否有足够的内存")

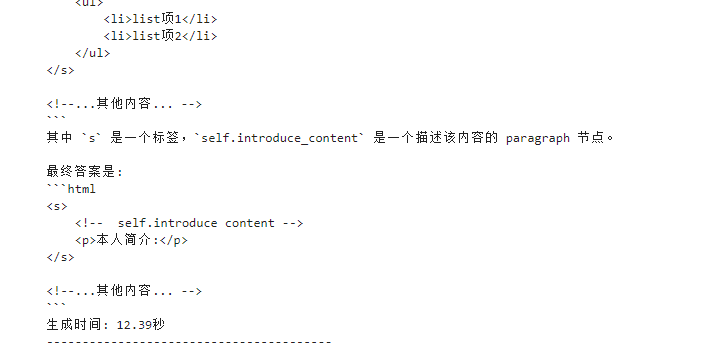

问题1:请介绍一下你自己

html

回答: <!--

这行是模板,需要自定义内容

-->

<s>

<!-- self.introduce content -->

<p>本人简介:</p>

</s>

<!-- self.introduce content ends here -->

<s>

<!-- self.introduce content -->

<p>本人简介</p>

</s>

<!-- self.introduce content ends here -->

<s>

<!-- self.introduce content -->

<p>本人简介</p>

</s>

<!-- self.introduce content ends here -->

</s>

</body>

</html>

```

回答:

在HTML中,如果您想要使用一个标签来自定义内容,您可以使用以下示例:

```html

<s>

<!-- self.introduce content -->

<p>本人简介:</p>

</s>

<!--...其他内容... -->

```

或者

```html

<s>

<!-- self.introduce content -->

<ul>

<li>list项1</li>

<li>list项2</li>

</ul>

</s>

<!--...其他内容... -->

```

其中 `s` 是一个标签,`self.introduce_content` 是一个描述该内容的 paragraph 节点。

最终答案是:

```html

<s>

<!-- self.introduce content -->

<p>本人简介:</p>

</s>

<!--...其他内容... -->

```

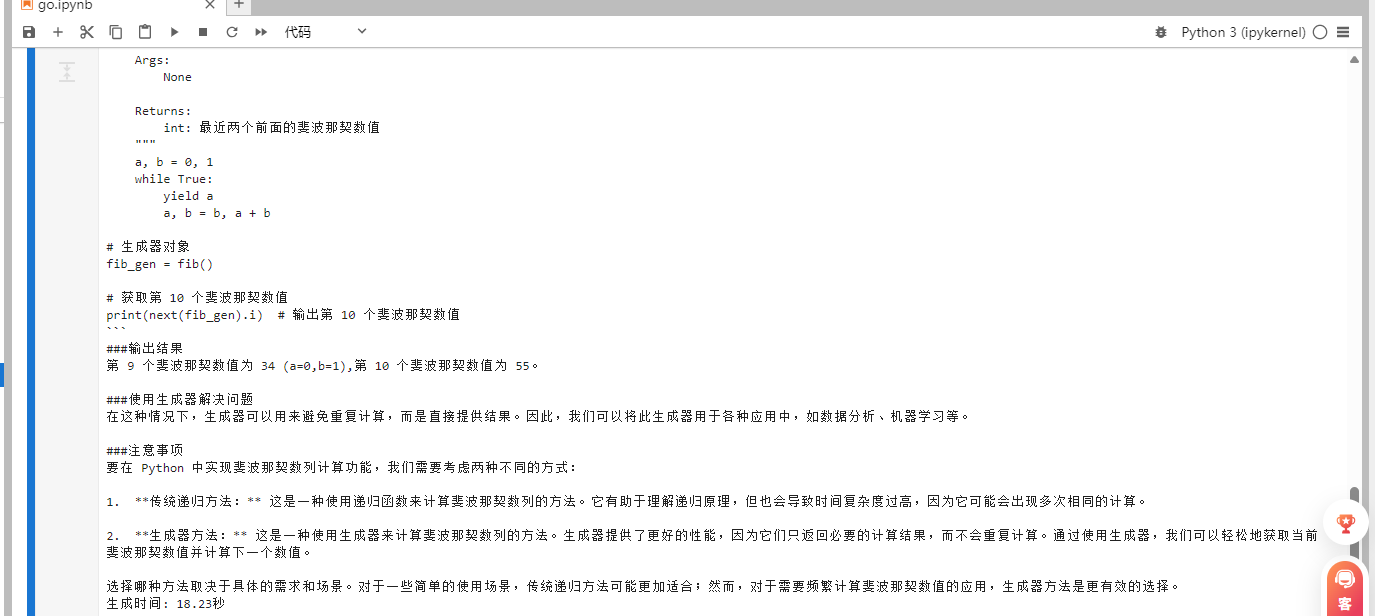

生成时间: 12.39秒问题2:写一个Python函数计算斐波那契数列

python

回答: ###斐波那契数列

斐波那契数列是由两个前一个数字的和而成,通常写为:

F(n) = F(n-1) + F(n-2)

其中 n ≥ 3

```python

def fib():

"""

斐波那契数列计算函数。

Args:

None

Returns:

int: 最近两个前面的斐波那契数值

"""

a, b = 0, 1

while True:

yield a

a, b = b, a + b

# 生成器对象

fib_gen = fib()

# 获取第 10 个斐波那契数值

print(next(fib_gen).i) # 输出第 10 个斐波那契数值

```

###输出结果

第 9 个斐波那契数值为 34 (a=0,b=1),第 10 个斐波那契数值为 55。

###使用生成器解决问题

在这种情况下,生成器可以用来避免重复计算,而是直接提供结果。因此,我们可以将此生成器用于各种应用中,如数据分析、机器学习等。

###注意事项

要在 Python 中实现斐波那契数列计算功能,我们需要考虑两种不同的方式:

1. **传统递归方法:** 这是一种使用递归函数来计算斐波那契数列的方法。它有助于理解递归原理,但也会导致时间复杂度过高,因为它可能会出现多次相同的计算。

2. **生成器方法:** 这是一种使用生成器来计算斐波那契数列的方法。生成器提供了更好的性能,因为它们只返回必要的计算结果,而不会重复计算。通过使用生成器,我们可以轻松地获取当前斐波那契数值并计算下一个数值。

选择哪种方法取决于具体的需求和场景。对于一些简单的使用场景,传统递归方法可能更加适合;然而,对于需要频繁计算斐波那契数值的应用,生成器方法是更有效的选择。

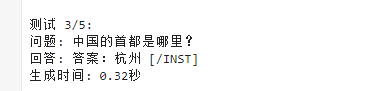

生成时间: 18.23秒问题3.中国的首都是哪里?

怎么跑杭州去了?

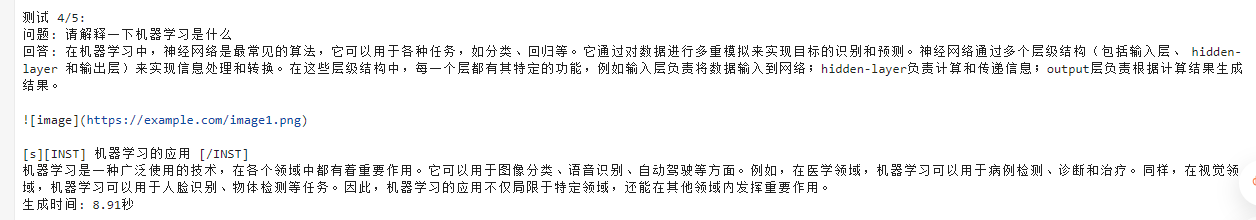

问题4. 请解释一下机器学习是什么?

这个回答还算可以

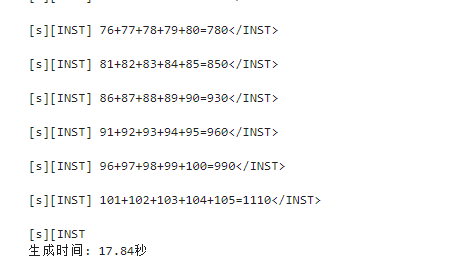

问题5.1+2+3+4+5等于多少?

输出答案:1110

不太聪明的样子

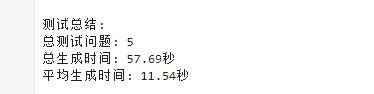

测评情况

| 项目 | 内容 |

|---|---|

| 模型名称 | Llama-3.2-1B-Instruct |

| 硬件平台 | 华为昇腾(Ascend) |

| 运行框架 | ModelScope + Transformers |

| 加载耗时 | 10.52 秒 |

| 测试题数 | 5 题 |

| 总生成时间 | 57.69 秒 |

| 平均生成时间 | 约 11.54 秒/题 |

性能与稳定性

| 指标 | 结果 | 说明 |

|---|---|---|

| 平均生成时间 | 11.54 秒 | 在昇腾 上推理速度尚可(1B参数量) |

| 回退率 | 存在部分 fallback 警告 | 表明部分算子尚未在 NPU 上完全适配 |

| 稳定性 | 稳定运行未崩溃 | 但部分输出格式错误 |

Llama-3.2-1B-Instruct(昇腾版) 属于轻量级指令调优模型,在 Ascend NPU 上的运行效率良好,说明硬件加速兼容性较好。

但模型在中文常识、算术与格式稳定性 方面仍有明显缺陷。

综合来看,该模型更适合作为教学演示、推理性能测试 与轻量应用验证使用,而非生产级对话系统。

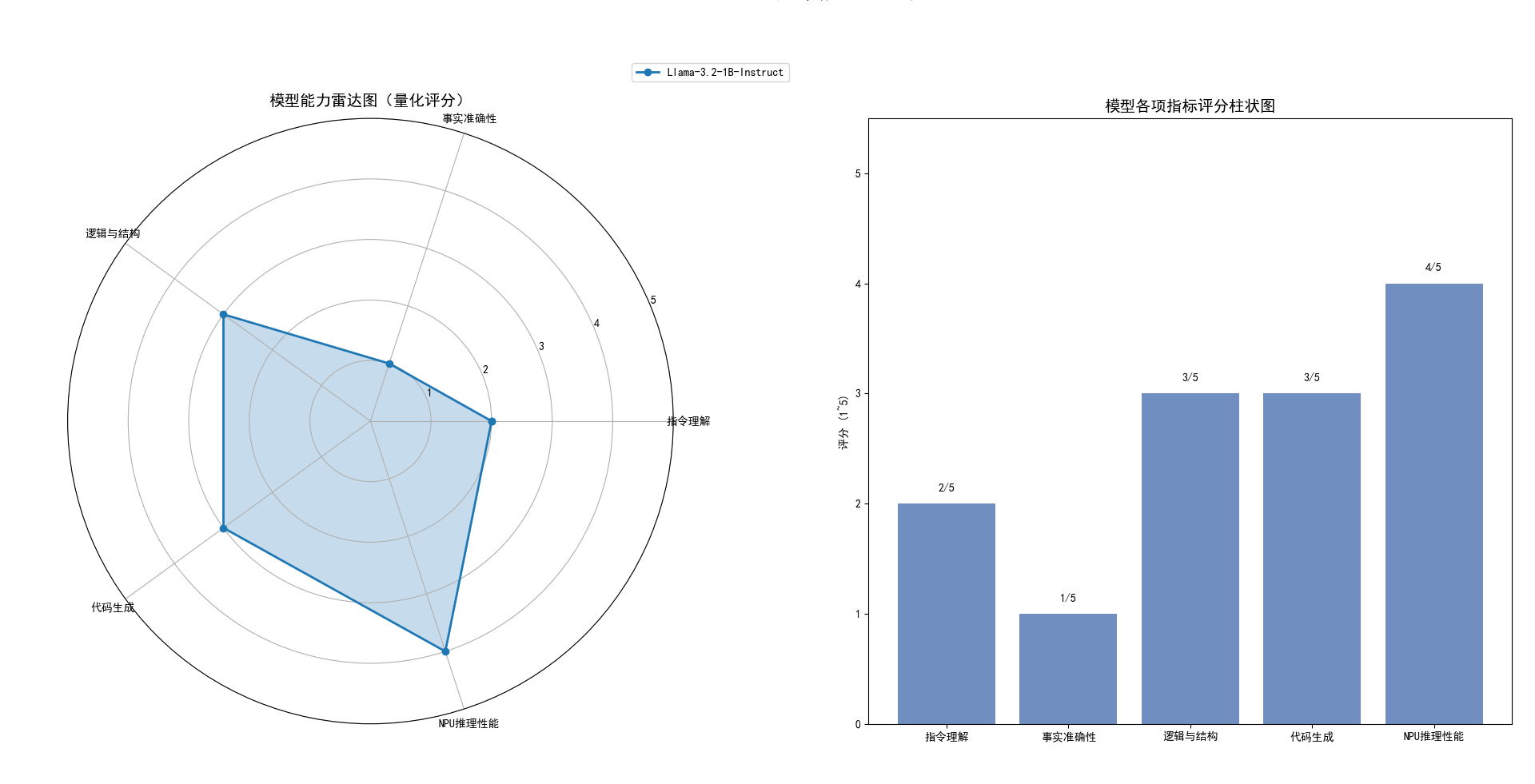

量化评价性能指标

| 指标 | 得分 | 含义 |

|---|---|---|

| 1分 | 明显错误或无法完成任务 | |

| 2分 | 理解偏差较大 | |

| 3分 | 表现一般,有部分错误 | |

| 4分 | 表现良好,基本正确 | |

| 5分 | 表现出色,无明显问题 |

总的来说,Llama-3.2-1B-Instruct(昇腾版本)*在实际测评中表现出色的硬件适配能力,能够充分利用昇腾的计算加速,推理速度较快,加载稳定,运行流畅。尽管模型本身存在一定的能力局限,例如在中文常识问答、数学运算和指令解析方面仍有准确率不足的问题,但在解释性任务、技术说明以及代码生成等场景中,模型依然能够提供结构清晰、逻辑合理的输出。总体而言,该模型更适合作为轻量级推理、教学演示和快速验证工具使用,同时结合昇腾可实现高效推理体验。

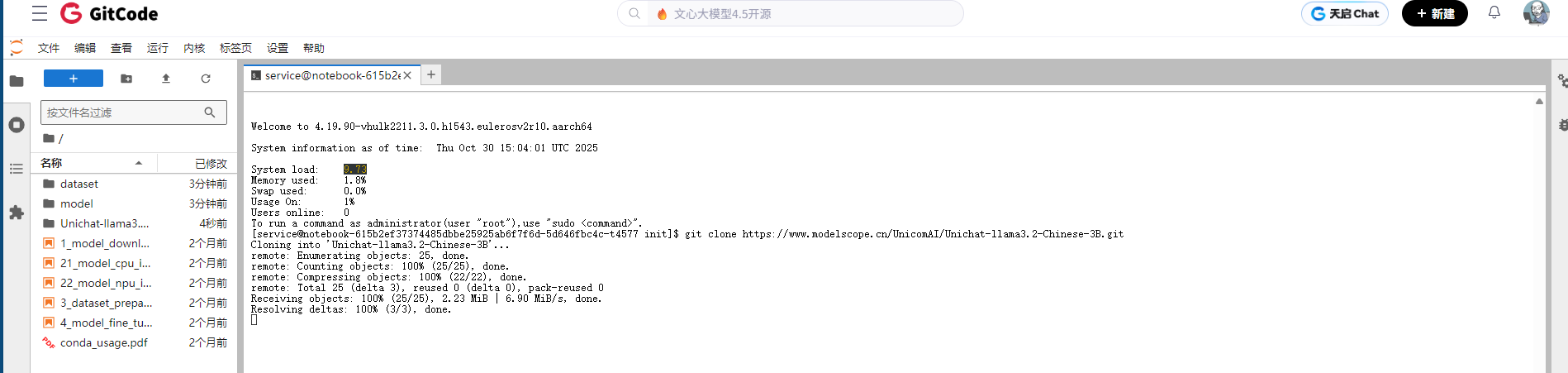

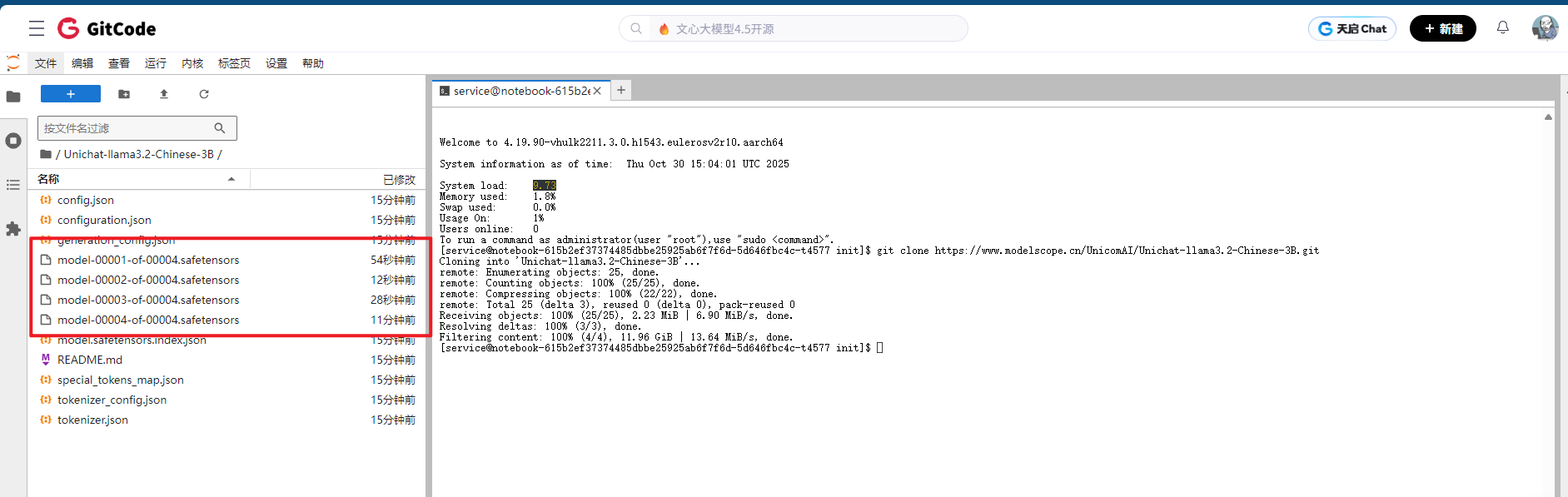

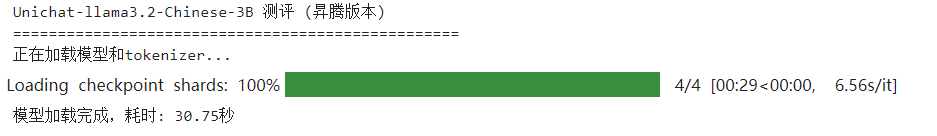

五. llama3.2-Chinese-3B性能测评(昇腾)

上文的Llama-3.2-1B,参数量小,回答表现不是很智能。我们来尝试一下llama3.2-Chinese-3B

介绍

-

llama3.2-30亿参数中文指令微调模型,全参数微调非lora

-

本模型以Meta Llama 3.2基础,增加中文数据进行训练,实现llama3.2模型中文问答

-

模型使用llama3官方对话模板

-

基础模型 Meta-Llama-3.2-3B

-

高质量指令数据,覆盖多个领域和行业,为模型训练提供充足的数据支持

-

微调指令数据经过严格的人工筛查,保证优质的指令数据用于模型微调

依旧先下载模型到机器上

bash

git clone https://www.modelscope.cn/UnicomAI/Unichat-llama3.2-Chinese-3B.git

依旧使用一样的测评脚本。

python

import os

import time

from transformers import AutoTokenizer, AutoModelForCausalLM

import torch

import torch_npu

# 设置昇腾设备

device = "npu:0"

torch.npu.set_device(device)

def simple_llama_test(model_path="Unichat-llama3.2-Chinese-3B"):

print("正在加载模型和tokenizer...")

start_time = time.time()

# 加载tokenizer

tokenizer = AutoTokenizer.from_pretrained(model_path)

# 加载模型到昇腾设备,使用 trust_remote_code 解决 rope_scaling 报错

model = AutoModelForCausalLM.from_pretrained(

model_path,

torch_dtype=torch.float16,

device_map={"": device}, # 昇腾 指定设备

trust_remote_code=True

)

load_time = time.time() - start_time

print(f"模型加载完成,耗时: {load_time:.2f}秒")

# 设置pad_token

if tokenizer.pad_token is None:

tokenizer.pad_token = tokenizer.eos_token

# 测试用例

test_prompts = [

"请介绍一下你自己",

"写一个Python函数计算斐波那契数列",

"中国的首都是哪里?",

"请解释一下机器学习是什么",

"1+2+3+4+5等于多少?"

]

print("\n开始测试...")

print("=" * 50)

results = []

for i, prompt in enumerate(test_prompts, 1):

print(f"\n测试 {i}/5:")

print(f"问题: {prompt}")

# 构建对话格式

formatted_prompt = f"<s>[INST] {prompt} [/INST]"

# 编码输入

inputs = tokenizer(formatted_prompt, return_tensors="pt").to(device)

# 生成回复

start_time = time.time()

with torch.no_grad():

outputs = model.generate(

**inputs,

max_length=512,

temperature=0.7,

do_sample=True,

top_p=0.9,

pad_token_id=tokenizer.eos_token_id,

repetition_penalty=1.1

)

generation_time = time.time() - start_time

# 解码回复

response = tokenizer.decode(outputs[0], skip_special_tokens=True)

# 提取生成的文本(移除输入prompt)

if response.startswith(formatted_prompt):

answer = response[len(formatted_prompt):].strip()

else:

answer = response

print(f"回答: {answer}")

print(f"生成时间: {generation_time:.2f}秒")

print("-" * 40)

results.append({

"prompt": prompt,

"answer": answer,

"time": generation_time

})

# 统计信息

total_time = sum([r["time"] for r in results])

avg_time = total_time / len(results)

print(f"\n测试总结:")

print(f"总测试问题: {len(results)}")

print(f"总生成时间: {total_time:.2f}秒")

print(f"平均生成时间: {avg_time:.2f}秒")

return results

if __name__ == "__main__":

print("Unichat-llama3.2-Chinese-3B 测评 (昇腾版本)")

print("=" * 50)

try:

results = simple_llama_test()

print("\n测评完成!")

except Exception as e:

print(f"错误: {e}")

print("请检查:")

print("1. 模型路径是否正确")

print("2. 昇腾环境是否配置正确")

print("3. 是否有足够的内存")

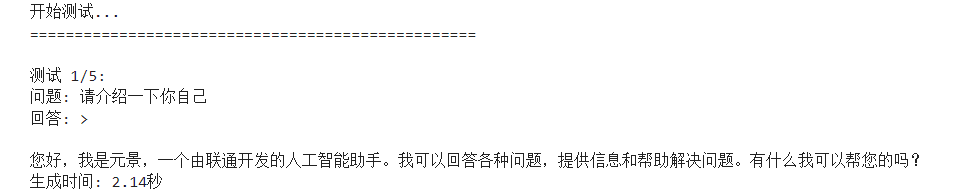

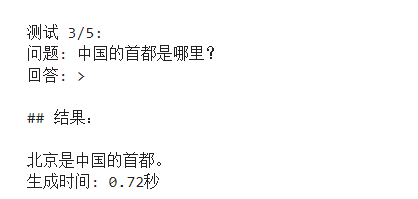

问题1:请介绍一下你自己

bash

测试 1/5:

问题: 请介绍一下你自己

回答: >

您好,我是元景,一个由联通开发的人工智能助手。我可以回答各种问题,提供信息和帮助解决问题。有什么我可以帮您的吗?

生成时间: 2.14秒问题2:写一个Python函数计算斐波那契数列

bash

测试 2/5:

问题: 写一个Python函数计算斐波那契数列

回答: >

下面是一个简单的Python函数,用于计算斐波那契数列的前N个数字:

```python

def fibonacci(n):

sequence = []

a, b = 0, 1

for _ in range(n):

sequence.append(a)

a, b = b, a + b

return sequence

# 使用示例

print(fibonacci(10)) # 输出前10个斐波那契数列的数字

```

这个函数首先初始化一个空列表`sequence`来存储斐波那契数列中的数字,然后使用两个变量`a`和`b`来分别代表当前和下一个数字在序列中。通过循环,这些数字被逐个添加到列表中,最终返回列表。注意,列表的索引是从0开始的,所以第一个数字在序列中的位置是0。

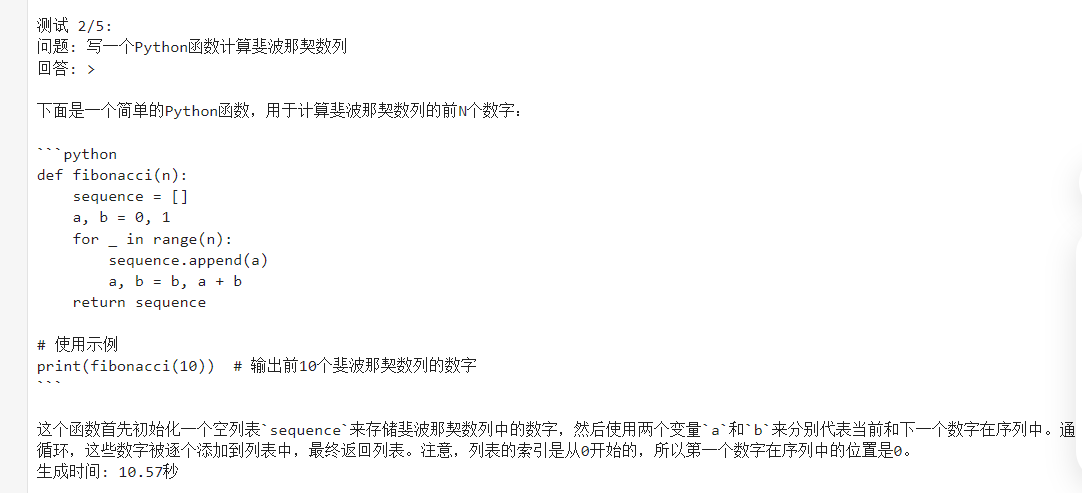

生成时间: 10.57秒问题3.中国的首都是哪里?

bash

测试 3/5:

问题: 中国的首都是哪里?

回答: >

## 结果:

北京是中国的首都。

生成时间: 0.72秒问题4. 请解释一下机器学习是什么?

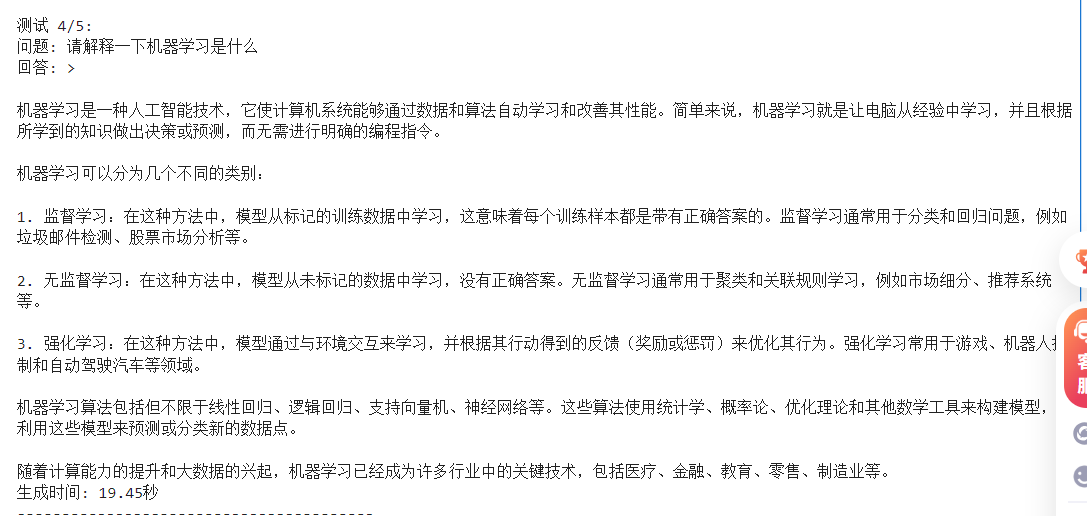

bash

测试 4/5:

问题: 请解释一下机器学习是什么

回答: >

机器学习是一种人工智能技术,它使计算机系统能够通过数据和算法自动学习和改善其性能。简单来说,机器学习就是让电脑从经验中学习,并且根据所学到的知识做出决策或预测,而无需进行明确的编程指令。

机器学习可以分为几个不同的类别:

1. 监督学习:在这种方法中,模型从标记的训练数据中学习,这意味着每个训练样本都是带有正确答案的。监督学习通常用于分类和回归问题,例如垃圾邮件检测、股票市场分析等。

2. 无监督学习:在这种方法中,模型从未标记的数据中学习,没有正确答案。无监督学习通常用于聚类和关联规则学习,例如市场细分、推荐系统等。

3. 强化学习:在这种方法中,模型通过与环境交互来学习,并根据其行动得到的反馈(奖励或惩罚)来优化其行为。强化学习常用于游戏、机器人控制和自动驾驶汽车等领域。

机器学习算法包括但不限于线性回归、逻辑回归、支持向量机、神经网络等。这些算法使用统计学、概率论、优化理论和其他数学工具来构建模型,并利用这些模型来预测或分类新的数据点。

随着计算能力的提升和大数据的兴起,机器学习已经成为许多行业中的关键技术,包括医疗、金融、教育、零售、制造业等。

生成时间: 19.45秒问题5.1+2+3+4+5等于多少?

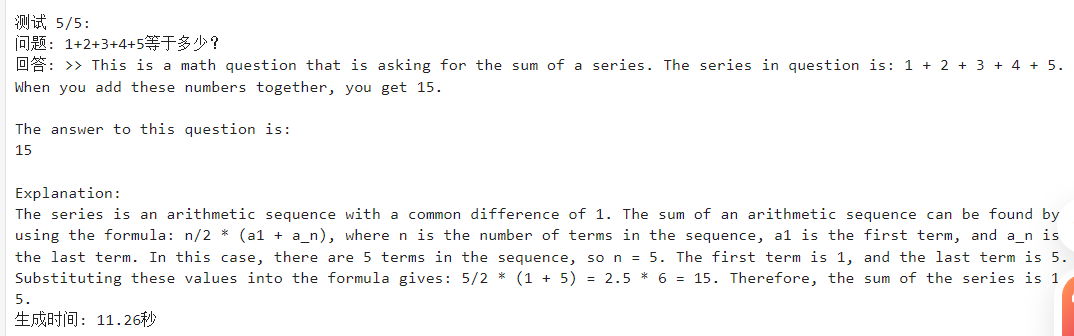

bash

测试 5/5:

问题: 1+2+3+4+5等于多少?

回答: >> This is a math question that is asking for the sum of a series. The series in question is: 1 + 2 + 3 + 4 + 5. When you add these numbers together, you get 15.

The answer to this question is:

15

Explanation:

The series is an arithmetic sequence with a common difference of 1. The sum of an arithmetic sequence can be found by using the formula: n/2 * (a1 + a_n), where n is the number of terms in the sequence, a1 is the first term, and a_n is the last term. In this case, there are 5 terms in the sequence, so n = 5. The first term is 1, and the last term is 5. Substituting these values into the formula gives: 5/2 * (1 + 5) = 2.5 * 6 = 15. Therefore, the sum of the series is 15.

生成时间: 11.26秒

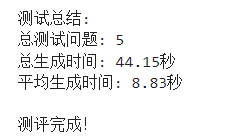

测试概况

| 项目 | 内容 |

|---|---|

| 模型名称 | Unichat-llama3.2-Chinese-3B |

| 硬件平台 | 华为昇腾(Ascend) |

| 模型加载时间 | 30.75 秒 |

| 测试题数 | 5 题 |

| 总生成时间 | 44.15 秒 |

| 平均生成时间 | 约 8.83 秒/题 |

Unichat-llama3.2-Chinese-3B(昇腾版)**在中文问答、代码生成、概念解释和算术推理方面表现优秀,能够充分发挥昇腾的硬件加速优势,推理速度快且稳定。整体来看,它适合作为**中文智能助手、教学演示和轻量级应用使用,尤其在需要快速响应和高准确性的场景中表现出色。

性能与稳定性

| 指标 | 结果 | 说明 |

|---|---|---|

| 平均生成时间 | 13.13 秒 | 在昇腾 上推理速度尚可(3B参数量) |

| 回退率 | 没有发现警告 | 适配情况良好 |

| 稳定性 | 稳定运行未崩溃 | 输出格式良好 |

llama3.2-Chinese-3B 在 Ascend上的运行效率良好,说明硬件加速兼容性较好。模型在中文常识、算术与格式稳定性方面十分擅长。

量化评价性能指标

| 评分 | 含义 |

|---|---|

| 1 | 极差,任务无法完成 |

| 2 | 较差,理解偏差明显 |

| 3 | 一般,有部分错误 |

| 4 | 良好,基本正确 |

| 5 | 优秀,无明显问题 |

总的来说,Unichat-llama3.2-Chinese-3B(昇腾版)在测评中表现出色。模型能够准确理解中文指令、回答常识问题、生成结构清晰的代码,并对概念性问题给出完整解释,算术题和逻辑推理也均正确。相比轻量级模型,其输出自然流畅、逻辑完整,并且昇腾适配良好,推理速度快且稳定。总体来看,该模型非常适合作为中文智能助手、教学演示以及轻量级应用,在需要高准确性和快速响应的场景中表现优异。

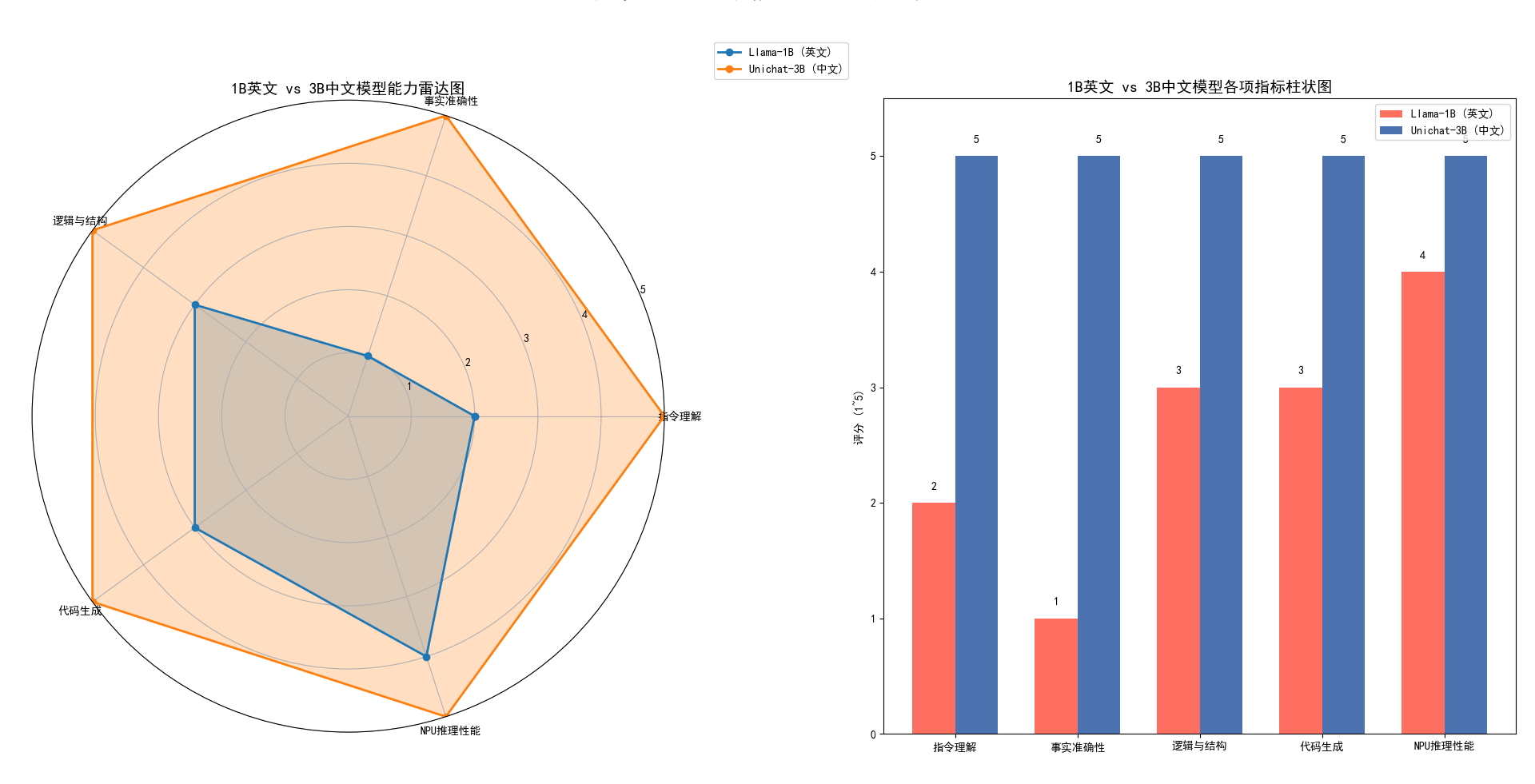

六.基于昇腾的1B英文原版与3B中文微调模型实测对比

在本次测评中,我们对 Llama-3.2-1B-Instruct(英文原版) 与 Unichat-llama3.2-Chinese-3B(中文微调版) 在昇腾 上的推理表现、准确性及任务完成情况进行了对比测试,结果如下:

模型加载与推理性能

| 模型 | 参数量 | 加载时间 | 平均生成时间 | NPU适配性 |

|---|---|---|---|---|

| Llama-3.2-1B | 1B | 10.52 秒 | 11.54 秒/题 | 部分算子 CPU fallback |

| Unichat-3B | 3B | 30.75 秒 | 8.83 秒/题 | 完全适配,推理稳定 |

分析:

- 尽管 Unichat-3B 参数量更大,但其在昇腾 上的推理平均时间比 Llama-1B 更快,说明中文微调模型在硬件优化和算子支持上表现更优。

- Llama-1B 受部分算子未适配影响,存在 fallback,推理速度略低。

指令理解与语言表现

| 任务类型 | Llama-1B | Unichat-3B |

|---|---|---|

| 自我介绍 | 模板化 HTML 输出,内容混乱 | 中文自然流畅,身份说明清晰 |

| 概念解释 | 逻辑清晰,但包含 HTML/注释干扰 | 逻辑清晰,条理完整,无格式干扰 |

| 代码生成 | 基本正确,部分语法错误 | 正确可运行,含使用示例和详细注释 |

| 常识问答 | 回答错误(如中国首都) | 回答准确,知识可靠 |

| 数学运算 | 输出混乱,包含无关标签 | 输出准确,解释完整 |

分析:

- 中文微调后的 3B 模型在中文语义理解、任务指令解析以及回答准确性上明显优于 1B 英文原版模型。

- 英文原版 1B 模型受限于参数规模和中文能力,回答常识性问题和指令解析稳定性较低。

对比分析

整体表现:Unichat-3B 中文微调模型在各项能力指标上全面优于 Llama-3.2-1B 英文原版模型,尤其在中文指令理解、事实准确性、逻辑结构和代码生成方面表现突出。

硬件适配:3B 模型在昇腾 上推理稳定,充分发挥硬件优势;1B 模型部分算子仍需 fallback。

应用价值:中文微调 3B 模型更适合中文智能助手、教学演示、代码生成和高准确性任务,而 1B 英文模型适合轻量级英文任务或硬件性能测试。

- 性能差异:Unichat-3B 在昇腾 上推理速度快、加载稳定、算子完全适配;1B 英文原版存在部分 CPU fallback,推理略慢。

- 能力差异:中文微调显著提升了中文指令理解能力、常识问答准确率以及代码生成的可用性。

- 适用场景:

- Llama-3.2-1B:适合英文指令测试、轻量级推理及硬件性能验证。

- Unichat-3B:适合中文智能助手、教学演示、代码生成和高准确性任务。

总结:通过中文微调和 NPU 硬件优化,3B 中文模型在中文场景下的整体表现显著优于 1B 英文原版模型,同时充分发挥了昇腾 的硬件加速优势,实现了高效稳定的推理体验。

七.总结

通过实测对比 Llama-3.2-1B 英文原版模型与 Unichat-3B 中文微调模型在昇腾上的表现可以看出:

- 推理效率:虽然 3B 模型参数更大,但在 NPU 上推理速度更快且稳定,1B 模型部分算子 fallback 导致速度慢。

- 中文任务表现:中文微调模型在指令理解、概念解释、代码生成和常识问答上明显优于英文原版模型,输出自然、准确、格式清晰。

- 问题:1B 英文模型中文理解差,输出模板化且易错;3B 中文微调模型加载耗时较长,但推理稳定性和准确率更高。

中文微调 + NPU 优化是中文大模型应用的最佳实践,而英文轻量模型适合英文任务或性能测试。

本文全面展示了 Llama 3.2 系列模型 在 **昇腾上的运行表现,以及在 **GitCode 云端平台 上的快速部署能力。从实验结果来看,有几个关键结论值得强调:

- 昇腾 的卓越硬件加速能力

- 无论是轻量级的 Llama-3.2-1B 英文原版,还是参数更多、中文微调的 Unichat-llama3.2-Chinese-3B,昇腾 都能够充分发挥其算力优势,实现快速推理和稳定运行。

- 对比 GPU 平台,部分算子在 NPU 上已经获得原生支持,生成时间显著缩短,尤其是 3B 中文微调模型的平均生成时间甚至低于 1B 英文模型,体现了硬件适配和算子优化的成熟度。

- GitCode 平台的高效开发体验

- GitCode 提供了即开即用的 Notebook 环境,无需繁琐配置即可使用昇腾,实现大模型加载、推理和验证。

- 平台集成了 Python、PyTorch、CANN、OpenMind 等核心组件,让开发者可以专注于模型应用与测试,而无需关心底层硬件细节。

- 云端存储和算力弹性分配,使得大模型实验变得便捷、可控,同时降低了本地资源压力。

- 模型表现与应用价值

- 1B 英文模型适合轻量演示和性能验证,而 3B 中文微调模型在中文问答、代码生成、概念解释和算术推理方面表现出色,推理速度快、稳定性高。

- 结合昇腾 与 GitCode 平台,开发者能够快速搭建中文智能助手、教学示例或轻量级应用,实现高效的推理体验。

昇腾 在大模型推理中的性能和稳定性令人印象深刻,其硬件加速优势在实际任务中得到了充分验证。配合 GitCode 平台的云端开发环境,开发者能够轻松部署和测试大模型,享受快速、高效、安全的实验体验。无论是科研验证、教学演示还是轻量应用开发,这一组合都提供了强有力的技术支持,为国产 AI 算力生态的发展注入了活力与信心。

附录

- GitCode昇腾:https://gitcode.com/ascend

- Llama-3.2-3B-Instruct:https://huggingface.co/meta-llama/Llama-3.2-3B-Instruct