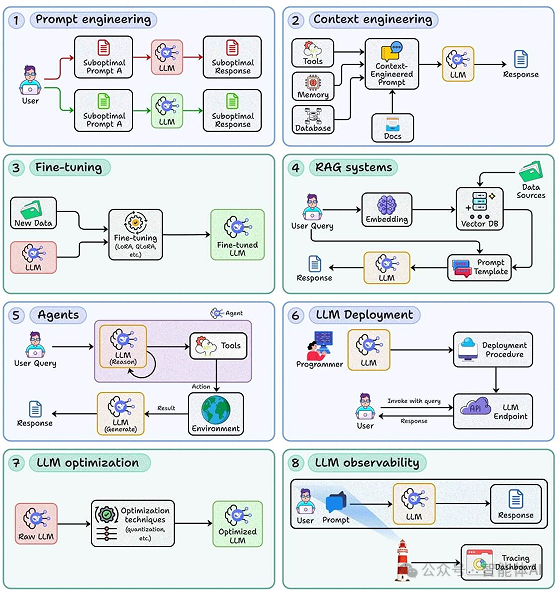

真正可上线、可扩展、可控成本的 LLM 应用,靠的不是灵光一现的提示词,而是一整套从检索、推理、部署到观测的工程方法。

接下来这8个核心技能,会把"会调 Prompt"的手艺变成可复现、可评测、可迭代的体系:让输出可预期、成本有抓手、故障可定位。花5分钟看清全局,用1周做出最小可用版本,把能演示的 Demo,变成扛得住流量与质检的产品。

一、为什么LLM开发不止是"提示词工程"?

如果你的应用只在演示环境表现不错,一上线就暴露问题------回答胡说八道、延迟飙升、成本失控、一次事故牵动全链路------那就说明它还停留在"玩具级"。

生产级LLM应用的关键,不是"把Prompt写得像诗",而是把整个链路工程化:数据、检索、推理、部署、观测、优化,环环相扣。

下面这8项技能,构成了从0到1到稳定运营的骨架。

二、八大支柱:从交互到架构再到运维

第1部分:基础交互层(决定模型如何**"思考"和"响应"**)

1、提示工程:与模型沟通的工程化方法

-

核心:从试错走向标准化,让输出可预期、可复现、可评测。

-

实操要点:

-

结构化提示:明确角色/任务/输入/约束/输出格式,用示例固定风格与边界。

-

思维链策略:鼓励中间推理但避免泄露冗长步骤;面向生产用"隐式推理+显式检查表"更稳。

-

少样本示例:以代表性样例覆盖常见与极端场景;维持一致格式,减少模型"跑偏"。

-

守护规则:加入禁答域、合规提示、拒答模板;用后置校验约束输出。

-

-

升华:这不是文案,而是"接口设计"。每个提示词都应可版本化、可回滚、可AB测试。

2、上下文工程:为模型注入"外部记忆"、

-

核心:把最新、私域、长尾知识按需注入模型上下文,突破训练语料的时效与领域限制。

-

实操要点:

-

切分与压缩:语义切分胜过定长切分;对长文本做摘要压缩、关键句抽取、表格结构化。

-

上下文预算:控制总token;采用"查询理解→检索→重排→压缩→生成"的分层管线。

-

冷热分层:热点知识缓存,冷数据检索;对重复查询做响应缓存与模板化。

-

完整性与噪声平衡:宁缺毋滥,优先高相关、可溯源片段。

-

-

价值:上下文工程是RAG与代理能力的地基,决定了应用的"读题能力"。

第2部分:系统架构层(决定应用如何**"构成"和"运作"**)

3、模型微调:为业务场景"量身定制"

-

核心:当Prompt/RAG到顶时,用微调注入风格、术语与流程知识。

-

技术路径:

-

SFT + LoRA/QLoRA:低成本适配指令、领域写作与对话风格。

-

偏好对齐:DPO/ORPO等让模型学会"更像人类/更像你的专家"。

-

数据治理:高质量小数据胜过大噪声;去重、反模板化、难例采样。

-

-

风险与控制:防过拟合、防遗忘;离线/在线评测与训练-推理漂移监控。

-

实践建议:先用弱监督构建基线,再用真实反馈迭代对齐。

4、RAG系统:让模型"引经据典",减少幻觉

-

核心:检索增强生成,用事实支撑生成,显著降低编造。

-

关键构件:

-

向量索引:HNSW/IVF等;嵌入模型选型以领域为先(如多语种/代码/法务)。

-

检索流水线:召回→重排(BM25/交叉编码器)→去冗→上下文构造→提示拼装。

-

提示融合:把证据块结构化嵌入,附带来源、时间戳、置信度。

-

-

质量闭环:

-

指标:检索@k准确率、支持度覆盖率、答案忠实度、端到端满意度。

-

评测集:真实问题+标准证据+期望答案,持续回放回归。

-

-

进阶:多路检索(关键词/语义/表格/图像)、查询改写、基于任务的动态k值。

5、智能体(Agent):让AI从"问答机"变成"执行者"

-

核心:多步骤推理、工具调用、计划---执行---反思闭环。

-

设计要点:

-

工具接口:函数/HTTP/schema定义清晰、幂等可重试、超时/速率限制明确。

-

状态管理:有限状态机或DAG工作流更可控;记录计划、上下文、产出与原因。

-

错误恢复:超时、半故障、幂等补偿、回滚策略;为"未知未知"准备安全出口。

-

安全护栏:输入净化、输出校验、权限最小化(只给必要工具与数据)。

-

-

运营实践:为关键步骤落盘日志与可回放剧本,便于复盘与再训练。

第3部分:运维优化层(决定应用如何**"跑得稳、跑得省"**)

6、LLM部署:把模型变成可靠的生产力API

-

核心:高可用、可扩展、可控成本。

-

关键能力:

-

推理引擎:vLLM/TGI/TensorRT-LLM等;动态批处理、PagedAttention、KV缓存。

-

性能与弹性:并发控制、队列与优先级、灰度与熔断、自适应扩缩容。

-

成本与安全:分层路由(小模型兜底/大模型提质)、配额/速率限制、鉴权与审计。

-

-

上手工具:Ray Serve/KServe/Beam 等简化部署与扩缩容;按SLA划分服务层级。

7、LLM优化:在不牺牲质量的前提下"瘦身提速"

-

核心:以单位效果最低成本为目标的系统性优化。

-

技术选型:

-

量化:INT8/4/3/2;AWQ/GPTQ/FP8;评估精度回退并做任务级对齐。

-

蒸馏:任务蒸馏/回应蒸馏,把大模型能力迁移到小模型。

-

结构优化:剪枝、Speculative Decoding、早停、响应裁剪与缓存。

-

-

工程技巧:提示裁剪、上下文压缩、可复用中间结果缓存;命中率与新鲜度双指标。

8、可观测性:没有观测,就没有优化

-

核心:让每一次请求都有"来龙去脉"和"量化画像"。

-

三类信号:

-

Trace:从请求到工具再到生成的链路追踪(OpenTelemetry等)。

-

Metrics:p50/p95延迟、成功率、Token用量、命中率、成本/请求。

-

Logs & Evals:输入/输出快照(脱敏)、拒答率、幻觉告警、离线评测与在线AB。

-

-

闭环:观测→诊断→变更→回归测试→发布→再观测,形成周/日级改进节奏。

三、总结

-

这八项能力不是拼图碎片,而是一条完整的生命周期:需求与交互设计(1-2)→系统化实现(3-5)→上线与保障(6-8)。任何一环薄弱,都会在生产环境被放大。

-

入门路径建议:

-

初学者:先把"提示工程(1)""上下文工程(2)"打牢;再做一个最小可用的RAG(3)。

-

进阶者:引入"智能体(4)"与"微调(5)",把复杂任务跑通;并开始建设"部署(6)""优化(7)""可观测性(8)"。

-

自检清单(摘录):

-

-

你的提示是否版本化并可AB?上下文是否有预算与压缩策略?

-

RAG是否有可回放评测集?代理是否可重试、可回滚?

-

推理是否支持动态批处理与KV缓存?是否做了分层路由与成本监控?

-

是否建立端到端观测与数据脱敏?是否有周度质量回归?

-