[二、ELK 核心组件功能](#二、ELK 核心组件功能)

[Kiabana 介绍](#Kiabana 介绍)

[三、ELK 的工作原理](#三、ELK 的工作原理)

[五、Filebeat+ELK 部署](#五、Filebeat+ELK 部署)

前言

在数字化时代,企业面临海量日志数据的处理和分析挑战。ELK(Elasticsearch、Logstash、Kibana)堆栈作为开源日志分析解决方案,以其高效的数据采集、存储、搜索和可视化能力,成为企业级日志管理的首选工具。通过集中化管理日志数据,ELK不仅提升了运维效率,还为业务决策提供了实时、直观的数据支持。本方案旨在阐述ELK的核心组件、部署架构及最佳实践,助力企业构建稳定、可扩展的日志分析平台。

一、ELK简介

ELK 是三个开源工具的缩写组合:

- Elasticsearch:分布式搜索和分析引擎,提供实时数据检索和高性能处理能力。

- Logstash:数据收集、转换和传输工具,支持多种数据源输入和输出。

- Kibana:数据可视化平台,用于展示 Elasticsearch 中的数据分析结果。

简单理解:ELK Stack 是一个一体化的工具包,帮助用户从多个数据源中收集数据、存储并进行快速搜索、分析和可视化,适合于日志分析、监控、数据可视化等场景。

二、ELK 核心组件功能

Elasticsearch

Elasticsearch 是一个开源的分布式搜索和分析引擎,基于 Apache Lucene 构建,专为处理大规模数据设计。它提供近实时的搜索能力,支持结构化、非结构化数据的全文检索、聚合分析及复杂查询。

核心特性

分布式架构 :数据自动分片(Sharding)和副本(Replication),支持水平扩展和高可用性。

近实时搜索 :数据索引后通常在 1 秒内可被搜索。

RESTful API :通过 HTTP 接口进行交互,支持 JSON 格式的请求和响应。

多数据类型支持 :文本、数值、地理空间数据等,支持动态映射(Dynamic Mapping)。

聚合分析:提供丰富的聚合功能(如统计、分桶、嵌套聚合)。

典型应用场景

- 全文搜索:网站内容、日志、文档的快速检索。

- 日志分析:结合 Logstash 和 Kibana(ELK Stack)实现日志收集、分析与可视化。

- 业务分析:用户行为分析、实时监控仪表盘。

- 地理数据查询:基于地理位置的服务(如附近商家搜索)。

基本概念

索引(Index) :类似数据库中的表,存储具有相同结构的文档。

文档(Document) :JSON 格式的数据单元,是索引中的基本数据单位。

分片(Shard) :索引的子集,每个分片是一个独立的 Lucene 实例,支持分布式存储和计算。

副本(Replica):分片的备份,提高容错性和查询吞吐量。

查询示例

简单匹配查询(通过 REST API):

http

GET /my_index/_search

{

"query": {

"match": {

"title": "elasticsearch"

}

}

}

扩展工具

- Kibana:数据可视化和管理界面。

- Logstash:数据采集和预处理管道。

- Beats:轻量级数据采集器(如 Filebeat 用于日志文件)。

Elasticsearch 广泛应用于企业搜索、日志分析、安全监控等领域,其灵活性和扩展性使其成为大数据生态中的重要组件。

Logstash****介绍

Logstash是一个开源的服务器端数据处理管道,由Elastic开发,主要用于采集、转换和传输数据。它支持从多种来源(如日志、数据库、消息队列等)实时收集数据,经过过滤和格式化后输出到目标存储(如Elasticsearch、文件系统等)。

核心功能

数据采集 :支持从文件、Syslog、Kafka、JDBC等数十种输入源读取数据。

数据处理 :通过过滤器(如Grok、Mutate、Date)解析、转换和丰富数据。

数据输出:将处理后的数据发送到Elasticsearch、文件、Redis等目的地。

典型应用场景

- 日志集中管理:聚合多台服务器的日志到Elasticsearch,便于搜索和分析。

- ETL工具:提取、转换和加载数据,用于数据仓库或大数据分析。

- 实时监控:处理流式数据并触发告警,如异常检测。

架构与组件

- Input插件 :定义数据来源(如

file、beats)。 - Filter插件 :执行数据解析(如

grok匹配日志模式)。 - Output插件 :指定数据目的地(如

elasticsearch)。

配置示例

以下是一个简单的Logstash配置文件,用于读取日志文件并输出到Elasticsearch:

puppet

input {

file {

path => "/var/log/nginx/access.log"

start_position => "beginning"

}

}

filter {

grok {

match => { "message" => "%{COMBINEDAPACHELOG}" }

}

}

output {

elasticsearch {

hosts => ["http://localhost:9200"]

index => "nginx-logs-%{+YYYY.MM.dd}"

}

}

优势与局限

优势:

- 插件生态丰富,扩展性强。

- 与Elastic Stack(如Kibana、Beats)无缝集成。

局限:

- 高负载时资源消耗较大。

- 复杂数据处理需编写自定义规则。

替代方案对比

- Fluentd:轻量级,适合容器化环境。

- Filebeat:仅采集数据,需配合Logstash或Elasticsearch使用。

Logstash适用于需要灵活数据处理能力的场景,尤其在Elastic Stack生态中表现突出。

Kiabana****介绍

Kibana 是一个开源的数据可视化与分析平台,专为 Elasticsearch 设计,用于交互式探索、分析和展示存储在 Elasticsearch 中的结构化或非结构化数据。它提供丰富的图表、地图、仪表盘等功能,帮助用户快速理解数据趋势和模式。

核心功能

数据可视化

支持柱状图、折线图、饼图、热力图等多种图表类型,用户可通过拖拽方式自定义可视化视图。

仪表盘

将多个可视化组件整合到单一界面,支持实时数据更新和交互式操作,适合监控和报告场景。

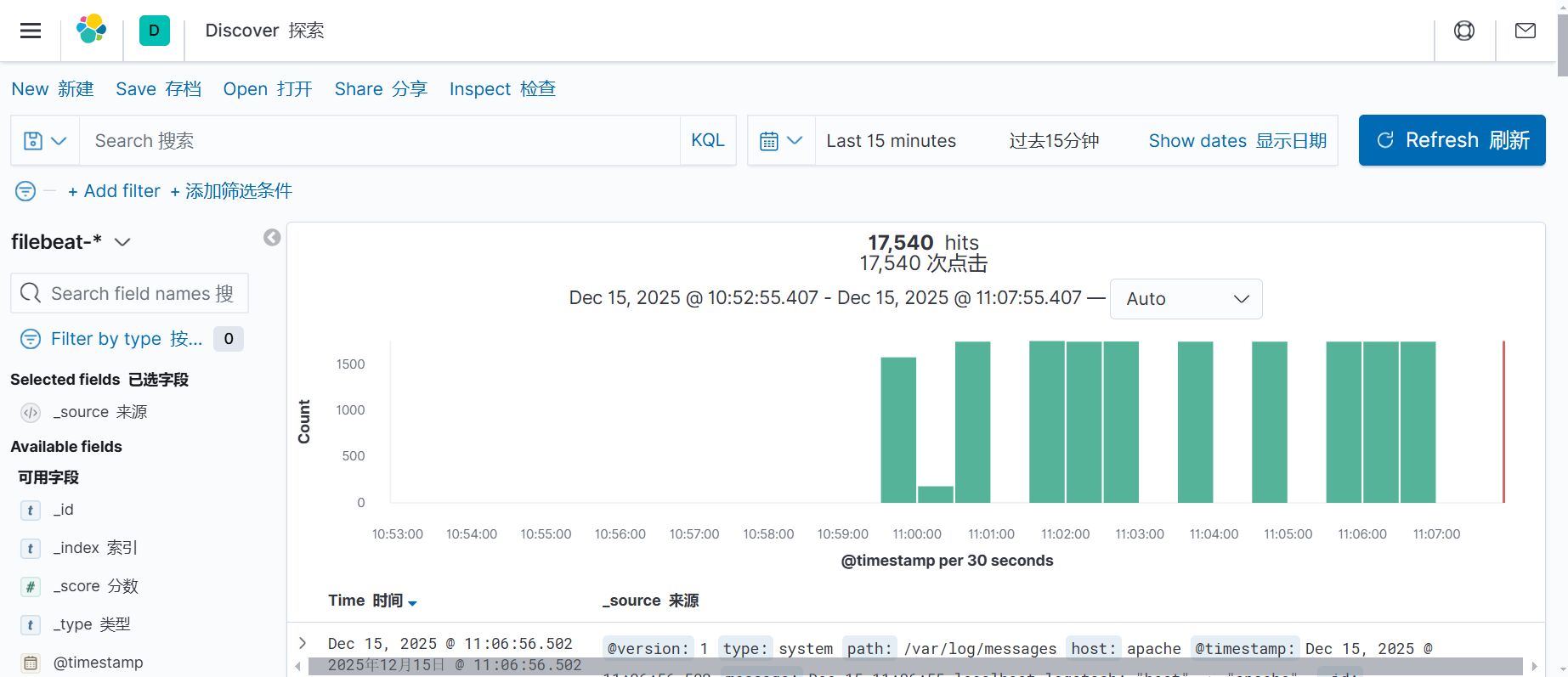

Discover 探索工具

提供全文搜索、字段过滤和聚合分析功能,用户可快速查询 Elasticsearch 索引中的原始数据。

开发者工具

内置 Console 工具,允许直接编写和执行 Elasticsearch 查询语句(如 REST API 请求),便于调试和管理索引。

机器学习集成

与 Elasticsearch 的机器学习功能结合,支持异常检测、预测分析等高级场景。

日志与指标分析

常用于日志管理(如 ELK Stack 中的日志分析)、应用性能监控(APM)和基础设施指标跟踪。

典型应用场景

- 运维监控:实时展示服务器性能指标、日志异常。

- 业务分析:可视化销售数据、用户行为分析。

- 安全审计:通过 SIEM 解决方案检测安全事件。

技术特点

- 基于 Web 的交互界面,支持多用户协作。

- 与 Elasticsearch 深度集成,查询响应速度快。

- 插件扩展机制,可集成第三方工具(如 Timelion 时间序列分析)。

Kibana 通常与 Elasticsearch、Logstash 和 Beats 组成 ELK Stack,是数据分析和可视化的重要工具之一。

三、ELK****的工作原理

( 1 )在所有需要收集日志的服务器上部署 Logstash ;或者先将日志进行集中化管理在日志服务器上,

在日志服务器上部署 Logstash 。

( 2 ) Logstash 收集日志,将日志格式化并输出到 Elasticsearch 群集中。

( 3 ) Elasticsearch 对格式化后的数据进行索引和存储。

( 4 ) Kibana 从 ES 群集中查询数据生成图表,并进行前端数据的展示。

四、部署环境ELK

节点配置与服务分配

Node1节点

- 配置:2核CPU,4GB内存

- 主机名:node1

- IP地址:192.168.10.50

- 运行服务:Elasticsearch(集群模式)、Kibana

Node2节点

- 配置:2核CPU,4GB内存

- 主机名:node2

- IP地址:192.168.10.51

- 运行服务:Elasticsearch(集群模式)

Apache节点

- 主机名:apache

- IP地址:192.168.10.10

- 运行服务:Logstash、Apache HTTP服务器

Elasticsearch集群配置

确保Node1和Node2节点上的Elasticsearch配置为集群模式。编辑Elasticsearch配置文件(通常位于/etc/elasticsearch/elasticsearch.yml):

stylus

cluster.name: my-elasticsearch-cluster

node.name: node1

network.host: 192.168.10.50

discovery.seed_hosts: ["192.168.10.50", "192.168.10.51"]

cluster.initial_master_nodes: ["node1", "node2"]

Node2节点的配置类似,但需修改 node.name和 network.host:

avrasm

node.name: node2

network.host: 192.168.10.51

Kibana配置

在Node1节点上配置Kibana以连接到Elasticsearch集群。编辑Kibana配置文件(通常位于/etc/kibana/kibana.yml):

stylus

server.host: "192.168.10.50"

elasticsearch.hosts: ["http://192.168.10.50:9200", "http://192.168.10.51:9200"]

Logstash配置

在Apache节点上配置Logstash以收集Apache日志并发送到Elasticsearch集群。创建Logstash配置文件(如/etc/logstash/conf.d/apache.conf):

puppet

input {

file {

path => "/var/log/apache2/access.log"

start_position => "beginning"

}

}

output {

elasticsearch {

hosts => ["192.168.10.50:9200", "192.168.10.51:9200"]

index => "apache-logs-%{+YYYY.MM.dd}"

}

}

Apache日志配置

确保Apache节点上的Apache HTTP服务器已启用日志记录。检查Apache配置文件(如/etc/apache2/apache2.conf或/etc/httpd/conf/httpd.conf):

arcade

CustomLog /var/log/apache2/access.log combined

服务启动与验证

启动Elasticsearch和Kibana服务:

crmsh

systemctl start elasticsearch

systemctl start kibana

启动Logstash服务:

crmsh

systemctl start logstash

验证集群状态:

routeros

curl -X GET "192.168.10.50:9200/_cluster/health?pretty"

预期输出应显示集群状态为green或yellow。

防火墙配置

确保各节点之间的必要端口已开放:

- Elasticsearch:9200(HTTP API)、9300(节点通信)

- Kibana:5601

- Apache HTTP服务器:80或443

监控与维护

定期检查Elasticsearch集群的健康状态和节点负载。使用Kibana的可视化工具监控日志数据。对于生产环境,建议配置Elasticsearch的索引生命周期管理(ILM)以优化存储。

故障排查

如果节点无法加入集群,检查以下内容:

- 网络连通性(使用

ping或telnet) - Elasticsearch日志(通常位于

/var/log/elasticsearch/) - 防火墙规则

- 主机名解析(确保

/etc/hosts包含所有节点条目)

五、Filebeat+ELK****部署

环境配置说明

Node1节点

- 主机名:node1

- IP地址:192.168.10.50

- 资源配置:2核CPU/4GB内存

- 运行服务:Elasticsearch(集群模式)、Kibana

Node2节点

- 主机名:node2

- IP地址:192.168.10.51

- 资源配置:2核CPU/4GB内存

- 运行服务:Elasticsearch(集群模式)

Apache节点

- 主机名:apache

- IP地址:192.168.10.10

- 运行服务:Logstash、Apache HTTP服务器

Filebeat节点

- 主机名:filebeat

- IP地址:192.168.10.20

- 运行服务:Filebeat

服务功能与协作流程

Elasticsearch集群

- Node1和Node2共同组成Elasticsearch集群,用于分布式存储和检索数据。

- 需确保两节点配置相同的集群名称(如

cluster.name: my-elastic-cluster)并相互发现。

Kibana

- 部署在Node1上,提供Elasticsearch数据的可视化界面。

- 配置需指向Elasticsearch服务地址(如

elasticsearch.hosts: ["http://192.168.10.50:9200"])。

Logstash

- 运行在Apache节点,负责接收、过滤和转发日志数据至Elasticsearch。

- 示例配置输入(如Filebeat)、过滤(如Grok解析)和输出(如Elasticsearch节点地址)。

Filebeat

- 部署在filebeat节点,采集本地或远程日志(如Apache日志)并发送至Logstash或Elasticsearch。

- 需配置输出目标为Logstash(如

output.logstash.hosts: ["192.168.10.10:5044"])。

关键配置建议

Elasticsearch集群配置

-

修改

elasticsearch.yml确保节点通信:yamlcluster.name: my-elastic-cluster node.name: node1 # 或 node2 network.host: 192.168.10.50 # 或 192.168.10.51 discovery.seed_hosts: ["192.168.10.50", "192.168.10.51"]Kibana连接Elasticsearch

-

修改

kibana.yml:yamlserver.host: "192.168.10.50" elasticsearch.hosts: ["http://192.168.10.50:9200"]Logstash管道配置

-

示例

logstash.conf:plaintextinput { beats { port => 5044 } } output { elasticsearch { hosts => ["http://192.168.10.50:9200", "http://192.168.10.51:9200"] } }Filebeat输出配置

-

修改

filebeat.yml:yamloutput.logstash: hosts: ["192.168.10.10:5044"]验证步骤

-

检查Elasticsearch集群状态:

bashcurl -X GET "http://192.168.10.50:9200/_cluster/health?pretty"

-

返回的

number_of_nodes应为2。 -

访问Kibana界面:

http://192.168.10.50:5601,确认能否加载Elasticsearch索引。 -

测试日志流水线:

- 在Apache节点生成日志,通过Filebeat发送至Logstash,最终在Kibana中查询日志数据。

总结

ELK堆栈通过整合Elasticsearch的分布式搜索、Logstash的数据管道和Kibana的可视化仪表盘,为企业提供端到端的日志分析能力。其灵活的架构设计支持从基础监控到复杂业务场景的定制化需求,同时具备横向扩展性以应对数据量增长。实施过程中需重点关注日志格式标准化、集群性能调优及安全策略配置,确保系统长期稳定运行。未来,结合机器学习或实时告警功能可进一步释放日志数据的价值,推动企业智能化运维转型。