如果你跟我一样,喜欢:

1)用IDEA进行JAVA后端开发

2)将一堆的AI服务装进WSL

3)希望体验或深度使用vibe coding

4)编程模型看中极致性价比

那么你可以继续向下看,接下来记录了本人打造vibe coding编程环境的一些经验,帮你更快的集成

为什么选这个组合

本人是全栈,如果你接触了前端vscode+claude code开发后,会发现将claude code集成进终端进行开发是多么的舒服。不用忍受纯WSL下打中文输入法无法选字的尴尬,又能上面代码下面输出对比查看结果(也是手头紧,没有多屏来进行开发)

IDEA安装

(略) 本人认为使用的人就默认是后端JAVA开发,使用行业最流程的IDEA工具

CLAUDE CODE安装

WSL下,把梯子准备好,剩下的就一行命令安装

bash

curl -fsSL https://claude.ai/install.sh | bash安装过程中会有询问你是登录账号还是使用API,选择API的方式(本人懒得注册)

LITELLM安装

我是使用litellm来进行中转服务。它的好处是可以映射多个模型,无需我通过环境变量切换模型,直接使用claude code的model命令可以随意切换。

安装完Claude Code后,如果是API模式,那么默认是使用国外的环境。我 希望使用经济的国内模型,因此需要中转的方式把Claude Code模型都映射到国内的地址,可以月40管饱(GLM MAX拼车)

安装

安装python后,直接安装litellm组件

bash

pip install litellm然后写一个服务,让WSL了直接命令service litellm start就可以起来(如果你想更省事直接写到bashrc也行)

vi /etc/systemd/system/litellm.service

内容如下:

cs

[Unit]

Description=LiteLLM proxy server

After=network-online.target

Wants=network-online.target

[Service]

Type=exec

User=root

Group=root

WorkingDirectory=/root

# 关键:把 pyenv 的 shims 和对应版本 bin 都放进 PATH

Environment="PATH=/root/.pyenv/shims:/root/.pyenv/versions/3.11.9/bin:/usr/local/sbin:/usr/local/bin:/usr/sbin:/usr/bin:/sbin:/bin"

ExecStart=/root/.pyenv/shims/litellm \

--config /opt/litellm.yaml \

--port 3456 \

--host 0.0.0.0

Restart=on-failure

RestartSec=5s

[Install]

WantedBy=multi-user.target然后 systemctl daemon-reload生效

配置

编写配置:vi /opt/litellm.yaml

html

model_list:

- model_name: claude-sonnet-4-5-20250929

litellm_params:

model: openai/qwen3-coder-local # 想换别的后端就改这里

api_base: http://192.168.1.119:30000/v1

api_key: sk-local-qwen3

- model_name: claude-haiku-4-5-20251001

litellm_params:

model: openai/qwen3-coder-local # 想换别的后端就改这里

api_base: http://192.168.1.119:30000/v1

api_key: sk-local-qwen3

- model_name: claude-3-5-haiku-20241022

litellm_params:

model: openai/qwen3-coder-local # 想换别的后端就改这里

api_base: http://192.168.1.119:30000/v1

api_key: sk-local-qwen3

- model_name: claude-3-opus-20240229

litellm_params:

model: openai/qwen3-coder-local

api_base: http://192.168.1.119:30000/v1

api_key: sk-local-qwen3

- model_name: qwen3-coder-local

litellm_params:

model: openai/qwen3-coder-local

api_base: http://192.168.1.119:30000/v1

api_key: sk-local-qwen3

- model_name: qwen3-coder-plus

litellm_params:

model: openai/qwen3-coder-plus-2025-09-23

api_base: https://dashscope.aliyuncs.com/compatible-mode/v1

api_key: sk-8888888888888888888888888888888

- model_name: glm-4.5-air

litellm_params:

model: openai/glm-4.5-air

api_base: https://open.bigmodel.cn/api/paas/v4

api_key: 88888888888888888888888888888888888

- model_name: glm-4.6

litellm_params:

model: openai/glm-4.6

api_base: https://open.bigmodel.cn/api/coding/paas/v4

api_key: 88888888888888888888888888888888888

litellm_settings:

drop_params: true

transform_request_to: anthropic上面的配置是这样解释的:

1)我把claude自带的几个模型都指向本地的Qwen3-Coder了(之前玩过一段时间本地Qwen3-Coder)

2)除了默认的模型意外,可以通过qwen3-coder-plus切换到阿里云百炼的公网qwen3-coder模型(阿里云百炼有免费3个月100W Token可以玩),通过Claude Code的/model命令切换:

/model qwen3-coder-plus

3)glm-4.5-air是智谱的注册赠送的免费模型,通过以下命令切换:

/model glm-4.5-air

4)glm-4.6是我拼车的公网MAX编程模型,通过以下命令切换:

/model glm-4.6

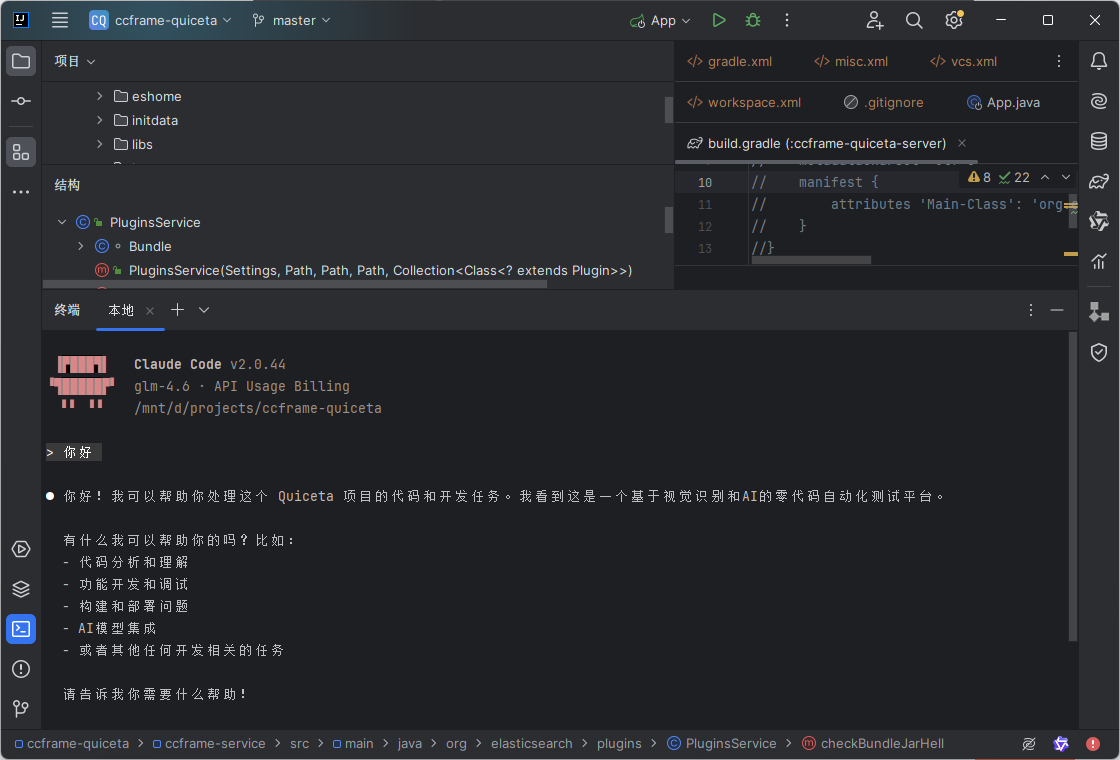

IDEA整合CC

IDEA整合Claude Code,只有在WINDOWS的WSL下会有点麻烦。因为我希望开启终端时直接跑到项目目录下,能够直接敲入cladue命令打开项目。

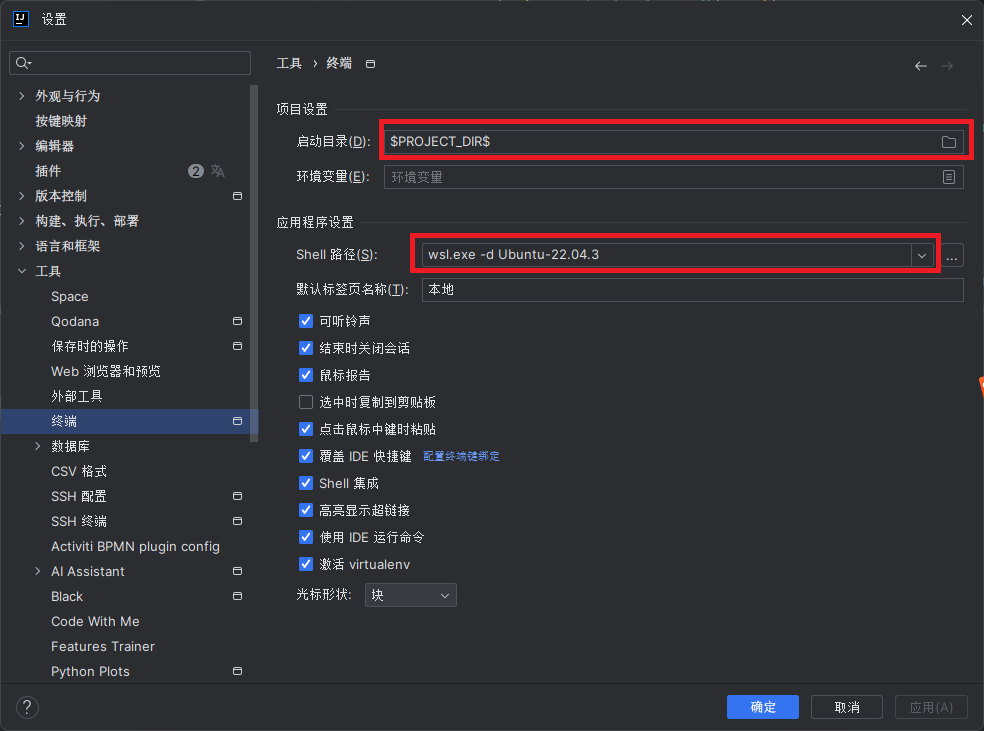

找到 设置->终端->工具。修改这几个地方:

启动目录:直接填写PROJECT_DIR,不然启动WSL的时候无法启动到你的终端

SHELL路径:wsl.exe -d <你的WSL系统名>

这里我的是Ubuntu-22.04.3的镜像,有点旧了。最新的可以自己装24.04

这样设置后,在IDEA走下角打开终端的时候就直接进入WSL环境并跳转到项目目录,只需要直接敲:claude,即可启动claude并打开项目

下一步使用/model切换到你需要的模型就可以愉快的vibe coding啦