多模态赋能情绪理解:Qwen3-VL+LLaMA-Factory 的人脸情绪识别实战

近年来,人脸情绪识别在智慧监控、教育辅助、人机交互、行为理解等应用场景中迅速发展。

传统的人脸表情识别方法通常依赖CNN或轻量化视觉网络,只基于单一视觉特征进行分类判断。

这类方法虽然在标准数据集上表现优秀,但在真实环境中往往容易受到光照变化、遮挡、拍摄角度、人脸姿态、表情强度差异等因素干扰,导致泛化能力不足。

随着多模态大语言模型(MLLM)的快速突破,一种新的可能性出现------让模型不仅能"看见"图像,还能理解图像背后的语义,并利用语言能力进行辅助推理。

MLLM将视觉+语言融合到统一的表示空间,使模型能够在视觉判断中加入语言逻辑、常识知识及推理能力,为传统视觉任务带来新的发展趋势。

基于此,本项目将探索:

- 是否可以通过大模型微调提升人脸情绪识别性能?

- 传统分类任务是否可以转换为 多模态推理任务,从而提升鲁棒性?

- 使用 LLaMA-Factory 框架微调 Qwen3-VL 是否能在 FER-2013 数据集上获得稳健表现?

项目核心思路

为实现这些目标,本项目基于Qwen3-VL模型,并在FER-2013数据集上进行了深度改造:

1. 任务重构:借助多模态技术突破传统局限

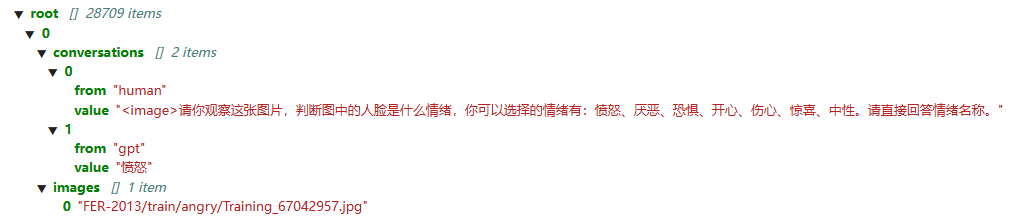

FER-2013作为经典的人脸表情识别数据集,其原始结构为"图片+标签"的纯视觉分类形式,但多模态大语言模型(MLLM)所需的数据集结构为 "图片+prompt(提示词)+答案"。

为此,我们需要对该数据集进行提示词重构,将传统的表情分类任务转化为多模态推理任务。

本项目已预置好数据重构的相关代码,执行数据处理流程后,即可将数据集中的每张人脸图片(face.png)封装为 "图片→提示词(instruction)→情绪标签(output)"的结构化形式。

这种格式调整将原本单纯的表情识别任务转化为跨模态问答任务,能够帮助大模型更好地利用语言知识完成推理过程。

2.定向微调:使用高效框架提升任务专属性能

基于Qwen3-VL多模态大模型,我们采用LLaMA-Factory框架进行针对性微调,显著增强了模型对人脸情绪识别任务的适配能力。

本项目配置简洁、支持一键启动,可自动完成数据加载、训练与评估,大幅降低显存占用,实现单卡训练。

3.方法转型:从传统视觉分类转向多模态大模型推理

摆脱依赖单一视觉特征的传统模型,引入具备强大自然语言理解与跨模态推理能力的多模态大语言模型(Qwen3-VL),将人脸情绪识别从纯粹的图像分类问题转化为结合视觉与文本推理的复杂任务。

项目操作

Step1 进入项目

在 Lab4AI 平台中搜索或点击对应项目LLaMA-Factory微调Qwen3-VL进行人脸情感识别 ,点击立即体验,使用1卡GPU,大约需要6h,也可以选择多卡。

Step2 激活环境

打开project_reproduce.ipynb,第四部分是快速复现,根据文档指引,在终端激活环境。

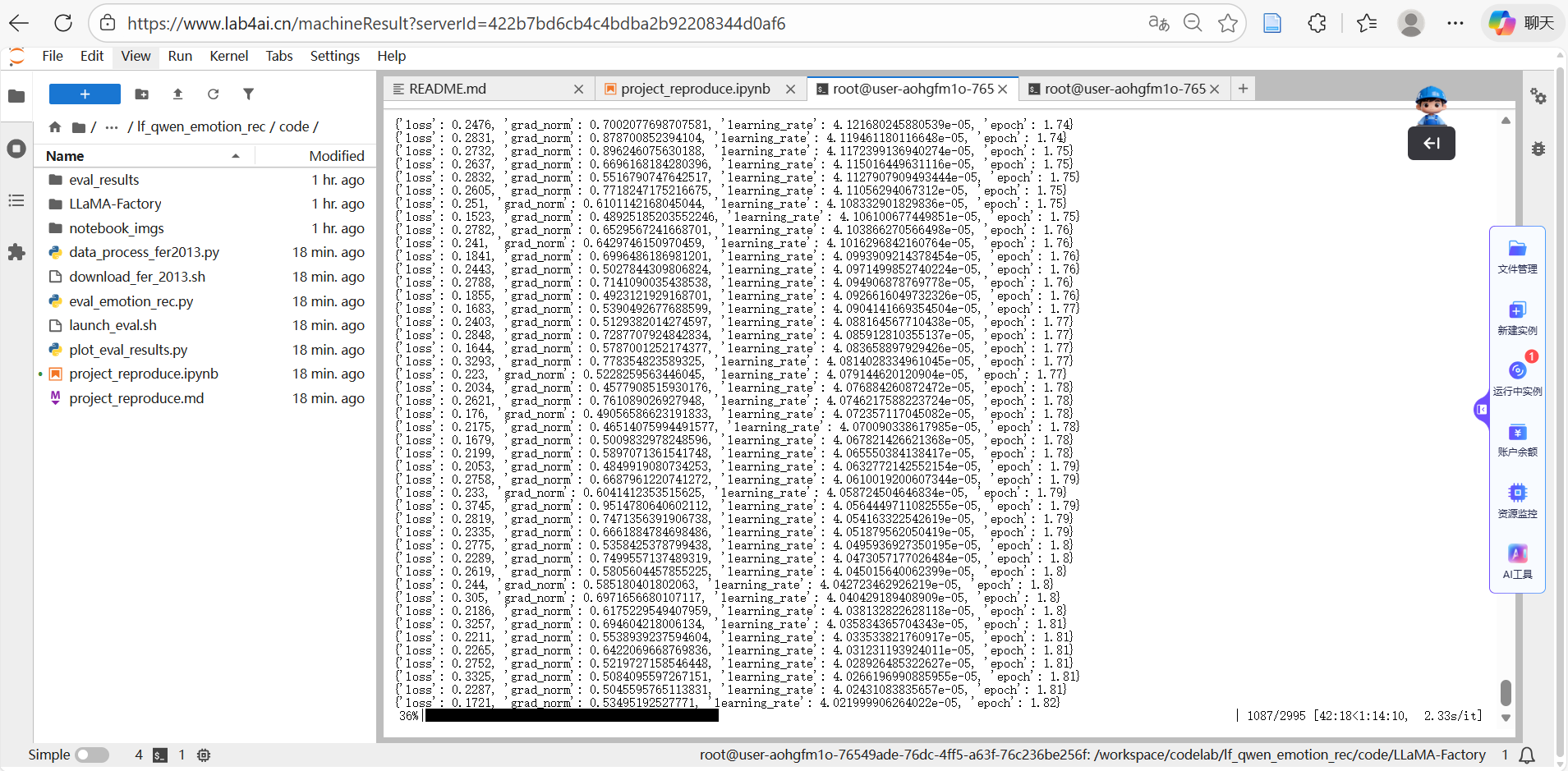

Step3 微调训练

在激活环境后,进行微调训练,训练时长视具体配置而定。

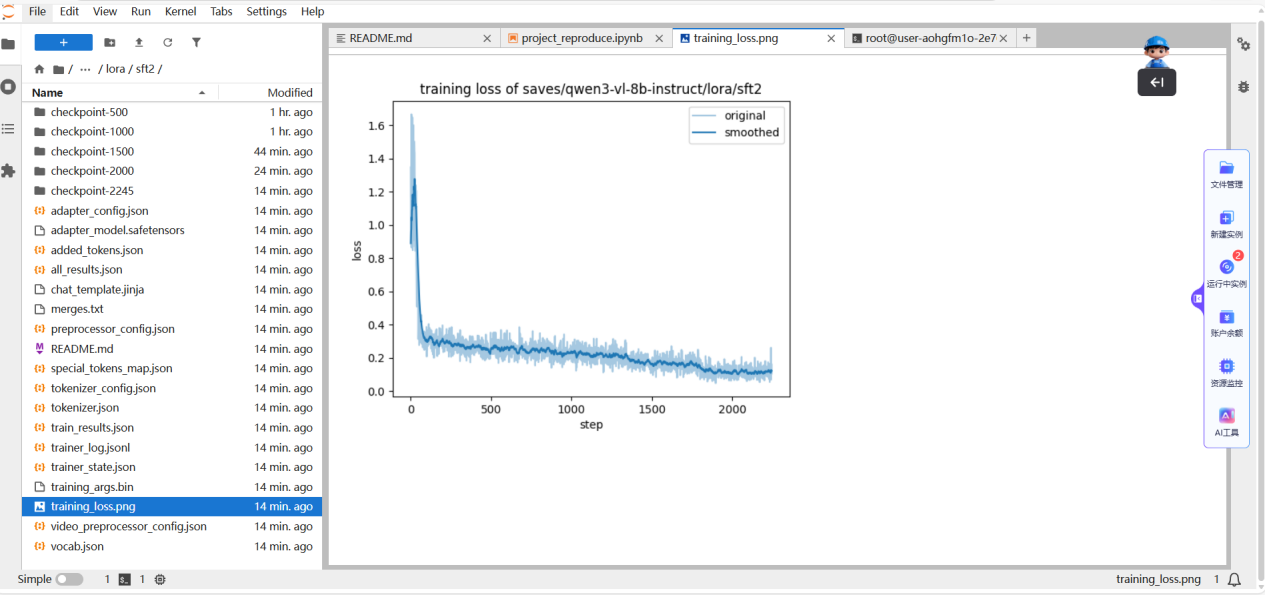

训练完成后,您可以在输出文件夹内查看checkpoints和其他训练记录文件,如loss曲线。

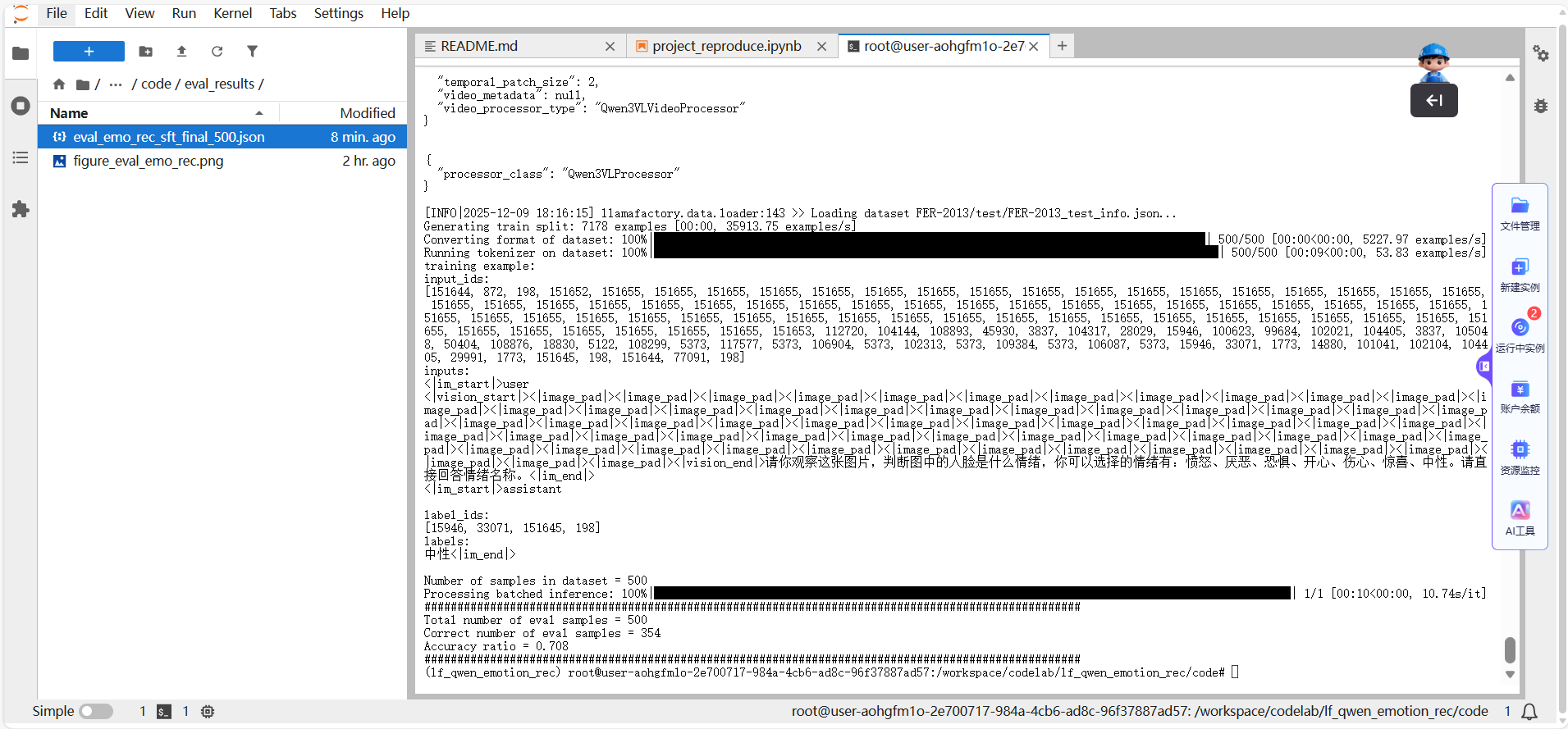

Step4 模型评估

根据project_reproduce.ipynb文件在终端运行评估代码。

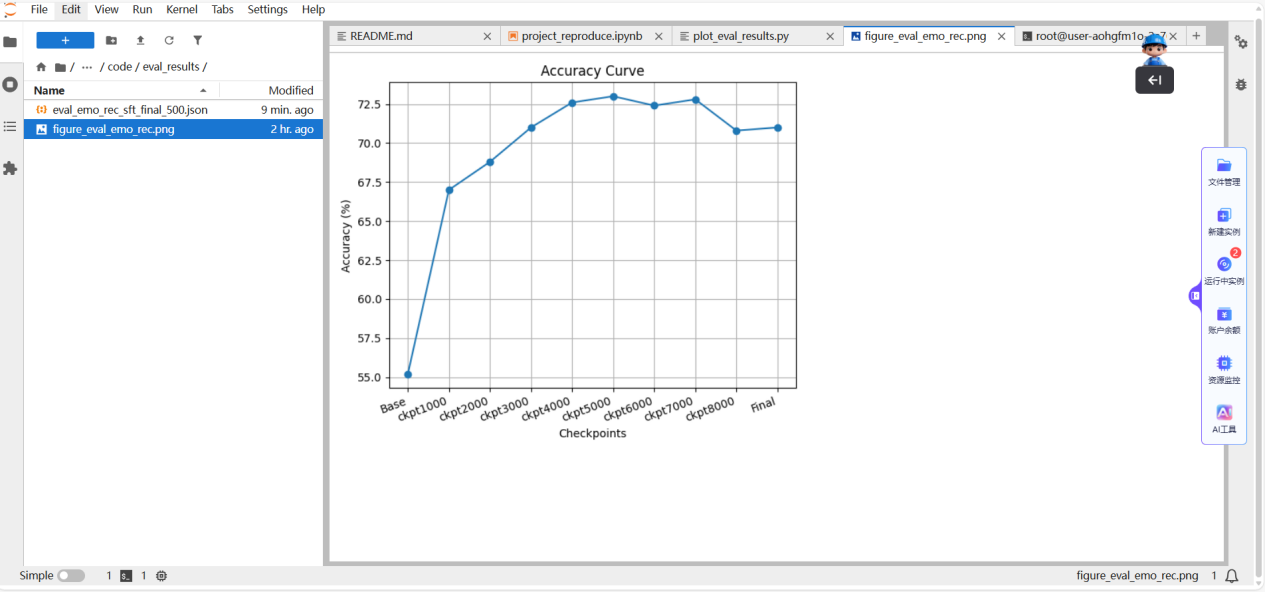

完成评估后,我们提供了可视化脚本,用于绘制checkpoints准确率变化曲线。

根据训练结果,Step=5000时,模型的准确率达到最佳。

通过该过程,您可以直观地看到微调前后准确率的提升,具体数值显示微调后准确率从基线模型的55.2%提升到73%,提升幅度达到17.8%。

此外,您还可以尝试优化超参数,进一步提升训练效果。

注意: 如果您希望体验从零开始的完整过程,请参考附录中的指南,按照文档进行数据集下载、环境配置等操作。

项目总结

本项目依托Lab4AI平台,基于LLaMA-Factory成功对Qwen3-VL进行了完整的微调流程。

我们将传统的人脸情绪识别任务与多模态大语言模型(MLLM)相结合,探索了MLLM在视觉情绪理解中的应用。

通过微调Qwen3-VL,我们成功将传统的分类任务转化为多模态推理任务,显著提升了模型在复杂场景下的鲁棒性和准确率。

这一方案不仅在人脸情绪识别上取得了显著提升,还为其他视觉任务的多模态大模型应用提供了新的思路,具有广泛的应用前景。

创作者招募中!Lab4AIxLLaMA-Factory邀你共创实战资源

想解锁大模型微调实战,却愁无算力、缺平台?现在机会来了!Lab4AI 联合 LLaMA-Factory 启动创作者招募,诚邀 AI 开发者、学生及技术爱好者提交微调实战案例,通过审核即享算力补贴与官方证书等,共创AI实践新生态。

大模型实验室Lab4AI实现算力与实践场景无缝衔接,具备充足的H卡算力,支持模型复现、训练、推理全流程使用,且具备灵活弹性、按需计费、低价高效的特点,解决用户缺高端算力、算力成本高的核心痛点。