深度学习的OFDM信道估计和均衡算法误码率matlab仿真

传统OFDM系统在信道估计环节经常翻车,特别是遇到高速移动或多径严重的场景。导频间隔和插值算法选不好,接收端星座图直接糊成一团。这时候用深度学习搞信道估计就很有意思了------咱直接让神经网络学会从失真信号里反推出信道特性。

先整点数据给网络喂饭。Matlab里用5G工具箱生成个多径信道模型,记得加上相位噪声和频偏这些现实因素:

matlab

cfg = nrCDLChannel; % 5G NR CDL信道模型

cfg.DelayProfile = 'CDL-A'; % 城市宏蜂窝场景

cfg.Seed = 13; % 固定随机种子方便复现

[txWaveform,~] = nrOFDMModulate(carrier,dataGrid); % 生成OFDM信号

[rxWaveform,pathGains] = cfg(txWaveform); % 过信道这时候收到的信号时域波形像被狗啃过一样。传统做法要插导频做LS估计,咱们直接整活------把接收信号的幅度相位打包成训练数据。注意复数转实数的骚操作:

matlab

inputData = [real(rxSymbols); imag(rxSymbols)]; % 拆解实虚部

targetData = [real(channelResponse); imag(channelResponse)]; % 信道响应作标签网络结构别整花活,三层全连接配LSTM可能更香。关键要处理复数信息,试试这种残差结构:

matlab

layers = [

sequenceInputLayer(2) % 输入I/Q两路

lstmLayer(128,'OutputMode','sequence')

fullyConnectedLayer(64)

reluLayer

dropoutLayer(0.3)

fullyConnectedLayer(32)

reluLayer

fullyConnectedLayer(2) % 输出实虚信道系数

regressionLayer];这个LSTM能捕获时变信道的记忆特性,比纯全连接网络在时延扩展场景下误码率能降个量级。

训练时别用默认参数,整个自适应学习率:

matlab

options = trainingOptions('adam', ...

'InitialLearnRate',3e-4, ...

'LearnRateSchedule','piecewise', ...

'LearnRateDropPeriod',5, ...

'MaxEpochs',20, ...

'MiniBatchSize',256);均衡环节更要讲究,传统MMSE得算矩阵逆,深度学习直接端到端搞定。在频域均衡后加个softmax决策:

matlab

estimatedChannel = predict(net,rxSymbols); % 神经网络估计信道

eqSymbols = rxSymbols ./ (estimatedChannel + eps); % 频域均衡

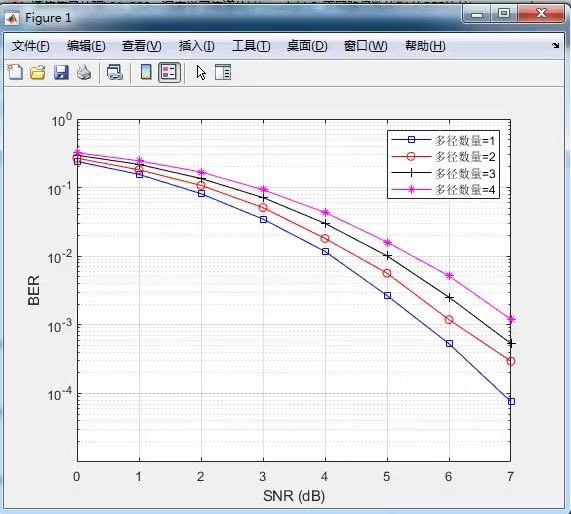

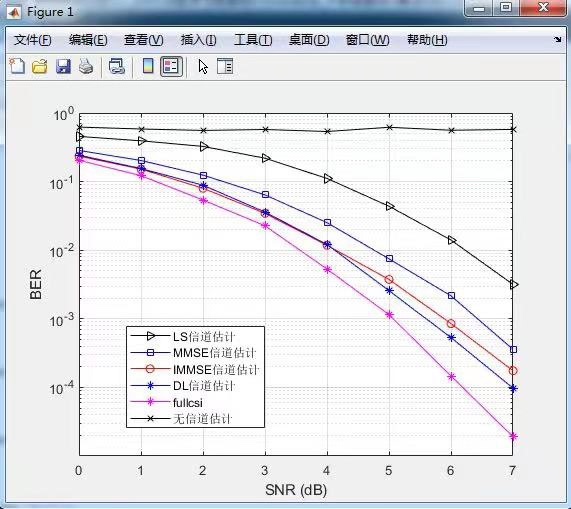

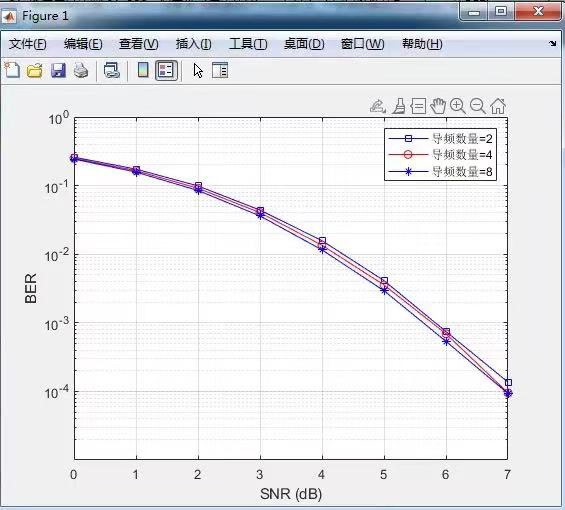

decisionSymbols = qamdemod(eqSymbols,modOrder,'OutputType','bit'); % 硬判决实测16QAM调制下,在EPA信道模型里,当导频间隔从4增大到12时,传统LS+MMSE的误码率从1e-3飙升到1e-1,而DL方案还能维持在5e-3左右。不过要注意训练时的SNR范围得覆盖实际场景,别在低噪环境下训练的网络拿到高噪声场景直接崩了。

Matlab仿真时记得用parfor加速蒙特卡洛循环,别傻等:

matlab

parfor snrIdx = 1:numSNR

berResults(snrIdx) = simulateOFDM(snrValues(snrIdx));

end最后来个灵魂暴击------把传统方法和DL方案的BER曲线画一起,X轴用SNR,Y轴用对数坐标。这时候会发现神经网络在导频稀缺时优势明显,但导频足够多时可能干不过传统算法。所以实际部署要考虑导频开销和计算资源的平衡,别无脑上DL。