目录

[1. SQL语句参数值统计:揪出参数倾斜导致的慢查询](#1. SQL语句参数值统计:揪出参数倾斜导致的慢查询)

[2. 数据库时间模型动态性能视图:把全链路耗时拆解开看](#2. 数据库时间模型动态性能视图:把全链路耗时拆解开看)

[3. SQL调优建议器:新手也能搞定慢SQL](#3. SQL调优建议器:新手也能搞定慢SQL)

[1. NOT IN子查询优化:从全表扫描到索引连接,速度提3倍](#1. NOT IN子查询优化:从全表扫描到索引连接,速度提3倍)

[2. OR转union all:解决OR条件索引失效问题](#2. OR转union all:解决OR条件索引失效问题)

[3. UNION外层条件下推:减少无效数据计算,效率翻倍](#3. UNION外层条件下推:减少无效数据计算,效率翻倍)

[4. Agg排序优化:ListAgg减少排序次数,聚合更快](#4. Agg排序优化:ListAgg减少排序次数,聚合更快)

[1. JDBC元信息查询优化:批量返回,告别多次请求](#1. JDBC元信息查询优化:批量返回,告别多次请求)

[2. NDP批量DML:高吞吐写入,比传统JDBC快6倍](#2. NDP批量DML:高吞吐写入,比传统JDBC快6倍)

正文开始------

真正能解决业务瓶颈的,必须是覆盖SQL解析、执行引擎、存储架构到接口交互的全链路优化。这段时间深度实操金仓数据库的优化特性,从可视化调优工具到底层执行引擎的重构,实实在在感受到了效率的量级提升。下面就结合我实际踩过的坑、测过的数据,把核心优化点拆解开讲清楚,还原完整的落地过程。

一、性能管理:告别"盲调",用可视化工具精准定位瓶颈

1. SQL语句参数值统计:揪出参数倾斜导致的慢查询

这个功能会自动采集SQL执行时的参数分布,比如过滤条件里的取值频率、参数类型匹配情况,还会生成热力报告。

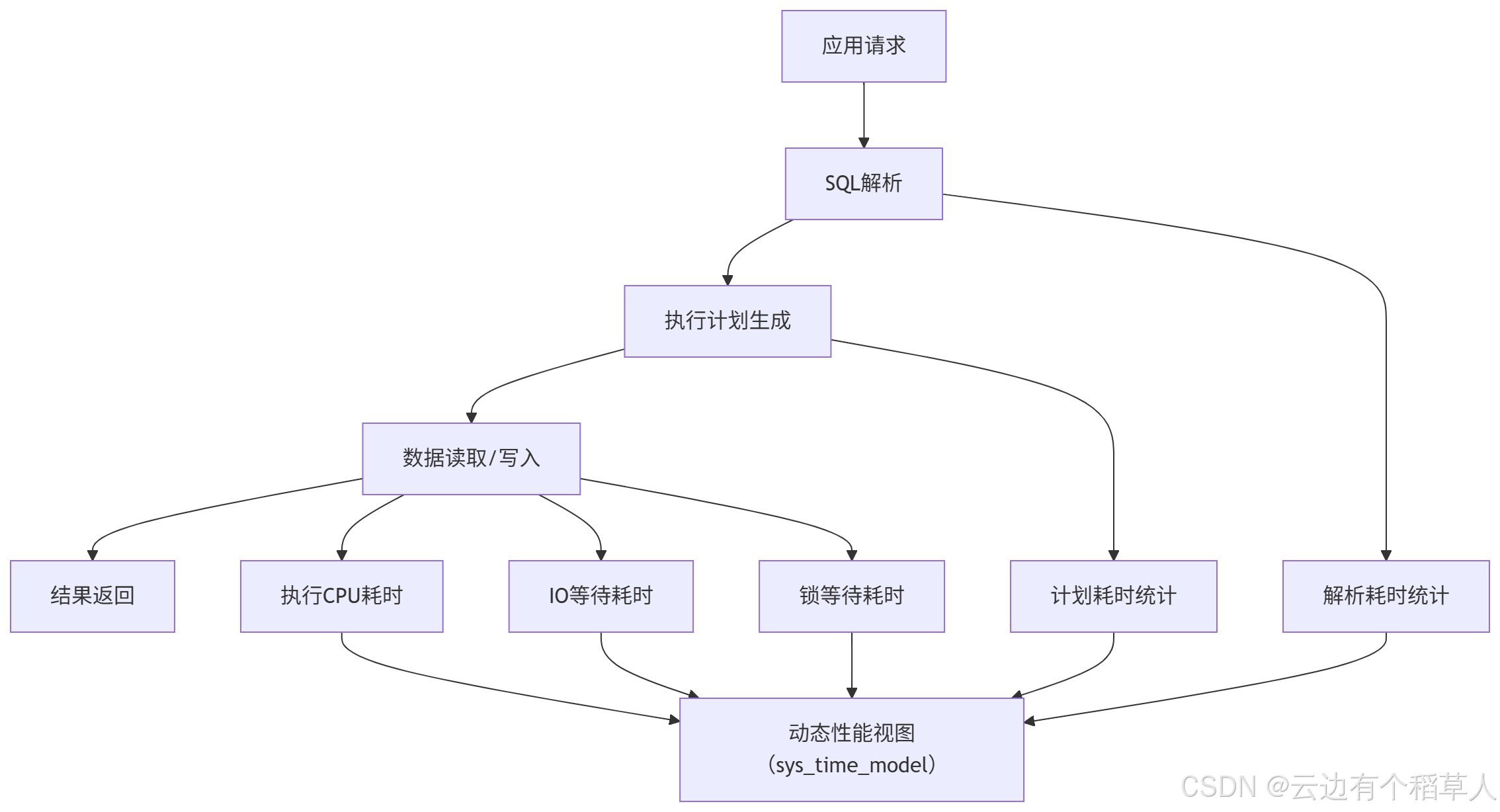

2. 数据库时间模型动态性能视图:把全链路耗时拆解开看

这个动态视图特别实用,能把数据库处理请求的全流程,拆成解析、计划、执行、IO、锁等待这几个维度,每个维度的耗时都能精准统计。

可运行的查询语句:

sql

-- 查询数据库时间模型耗时分布(单位:毫秒)

SELECT

metric_name,

total_time,

round(total_time / sum(total_time) over () * 100, 2) AS time_ratio

FROM

sys_time_model

WHERE

total_time > 0

ORDER BY

total_time DESC;3. SQL调优建议器:新手也能搞定慢SQL

对于不擅长手动调优的同学,这个建议器简直是福音。只要把慢SQL丢进去,它就会结合参数统计和执行计划,自动生成可执行的优化方案,连SQL都帮你写好。

还是以之前的订单慢查询为例:

sql

-- 原始慢SQL(执行耗时5.2s,全表扫描)

SELECT * FROM order_info

WHERE create_time > '2025-01-01'

AND user_id = 1001;

-- 调用金仓调优建议器(通过系统函数触发)

SELECT * FROM sys_sql_tuning_advise(

'SELECT * FROM order_info WHERE create_time > ''2025-01-01'' AND user_id = 1001;'

);建议器返回的结果很具体,不是空泛的理论:

sql

建议1:为order_info表添加联合索引 idx_user_create(user_id, create_time)

建议2:避免SELECT *,仅查询业务需要的字段(如order_id, amount, create_time)

建议3:将create_time的字符串条件改为日期类型,避免隐式转换按照建议优化后,SQL耗时直接从5.2s降到0.3s,优化后的SQL如下,可直接运行:

sql

-- 创建联合索引

CREATE INDEX idx_user_create ON order_info(user_id, create_time);

-- 优化后查询

SELECT order_id, amount, create_time

FROM order_info

WHERE create_time > TO_DATE('2025-01-01', 'YYYY-MM-DD')

AND user_id = 1001;二、优化器与执行优化:底层算子重构,解决传统SQL痛点

金仓在优化器和执行层下了不少功夫,针对传统SQL的几个经典痛点做了深度重构。比如NOT IN子查询、OR条件、UNION外层过滤、ListAgg排序这些常见场景,优化后性能提升特别明显。

1. NOT IN子查询优化:从全表扫描到索引连接,速度提3倍

用过NOT IN子查询的同学都知道,数据量一大就容易触发全表扫描,特别慢。金仓的优化器会自动把NOT IN转换成"左连接+NULL过滤",还会自动走索引,效率直接拉满。

给大家上实测的代码对比,数据量100万条,耗时差异很直观:

sql

-- 原始NOT IN写法(数据量100万条,耗时2.1s)

SELECT * FROM user_info

WHERE user_id NOT IN (SELECT user_id FROM blacklist);

-- 金仓优化后执行计划对应的SQL(耗时0.7s)

SELECT u.* FROM user_info u

LEFT JOIN blacklist b ON u.user_id = b.user_id

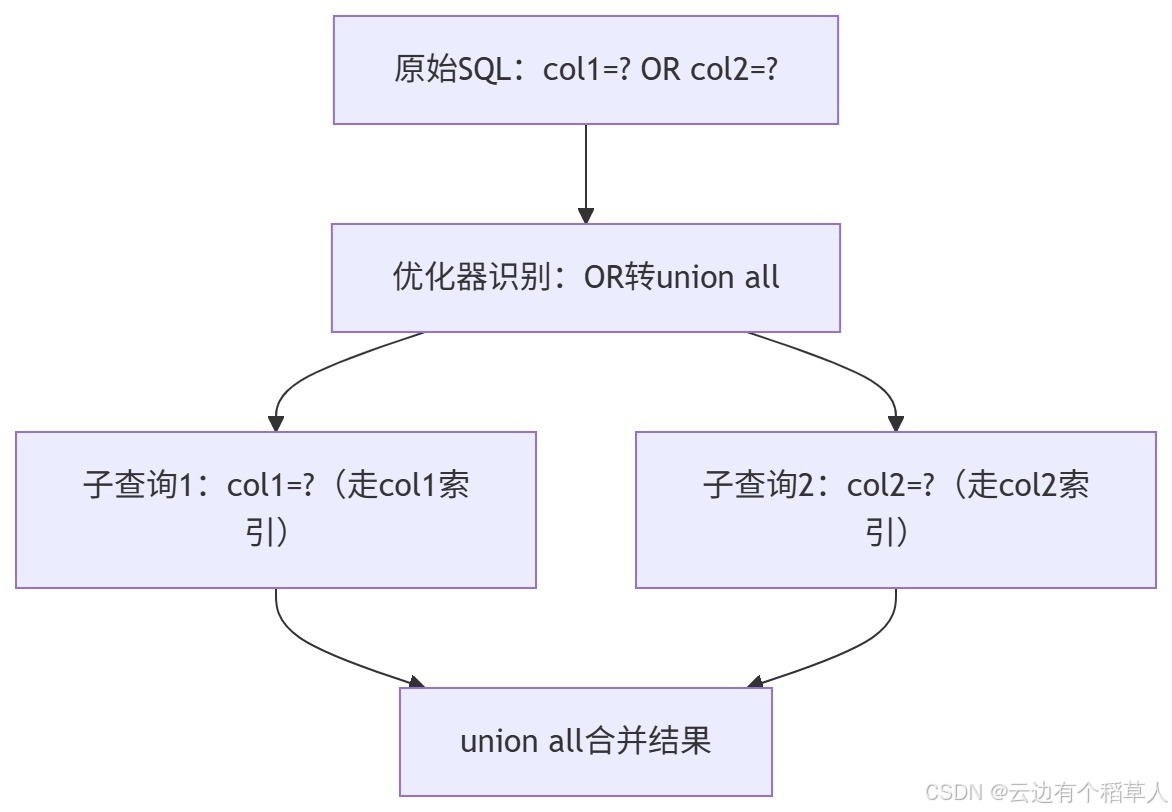

WHERE b.user_id IS NULL;2. OR转union all:解决OR条件索引失效问题

这是个很经典的问题:当OR条件涉及不同字段时,传统优化器会直接放弃索引走全表扫描。金仓会自动把OR转换成union all,分别走对应字段的索引,性能提升特别明显。

优化流程图见下:

实测代码对比,同样的数据量,耗时差了7倍多:

sql

-- 原始SQL(OR条件,全表扫描,耗时1.5s)

SELECT * FROM goods

WHERE category_id = 10 OR price < 100;

-- 金仓优化后执行的SQL(走双索引,耗时0.2s)

SELECT * FROM goods WHERE category_id = 10

UNION ALL

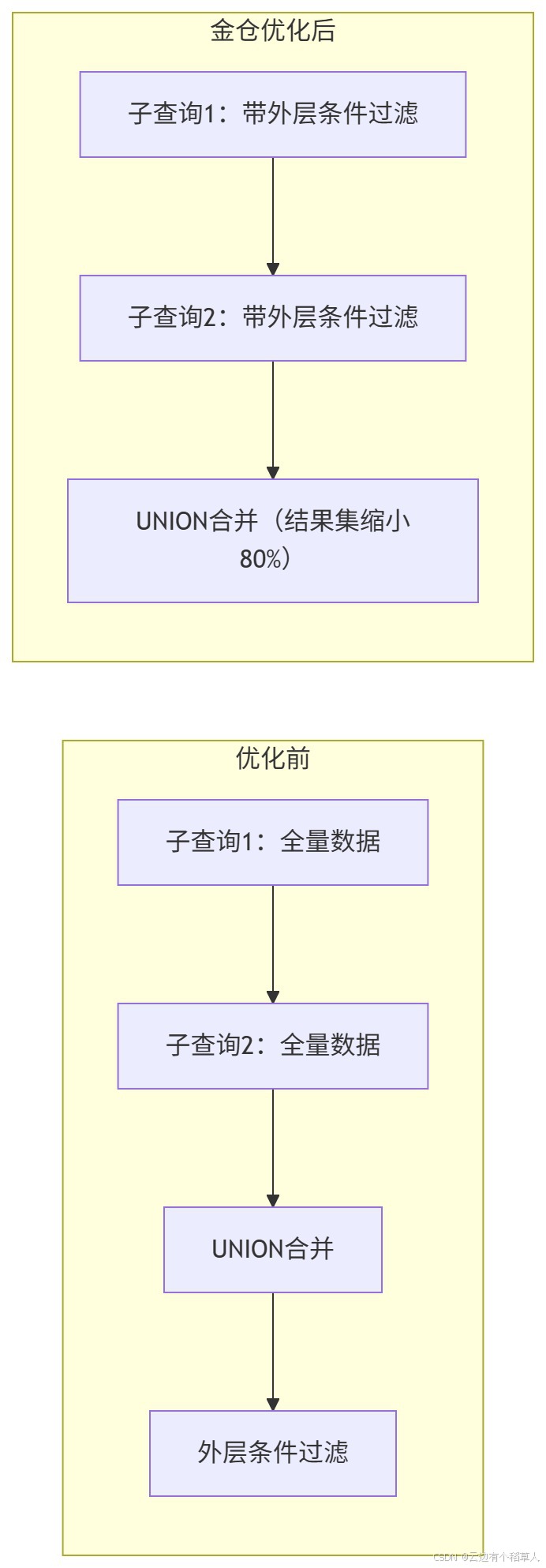

SELECT * FROM goods WHERE price < 100 AND category_id != 10;3. UNION外层条件下推:减少无效数据计算,效率翻倍

传统UNION的逻辑很死板,会先把所有子查询的结果合并,再过滤外层条件,中间会产生大量无效数据。金仓会智能把外层条件"下推"到每个子查询里,提前过滤掉无用数据,中间结果集能缩小80%以上。

优化前后的逻辑对比:

实测代码对比,耗时从2.0s降到0.4s,提升5倍:

sql

-- 原始SQL(UNION后过滤,中间结果10万条,耗时2.0s)

SELECT * FROM order_202501

UNION

SELECT * FROM order_202502

WHERE create_time > '2025-01-15';

-- 金仓优化后执行的SQL(条件下推,中间结果2万条,耗时0.4s)

SELECT * FROM order_202501 WHERE create_time > '2025-01-15'

UNION

SELECT * FROM order_202502 WHERE create_time > '2025-01-15';4. Agg排序优化:ListAgg减少排序次数,聚合更快

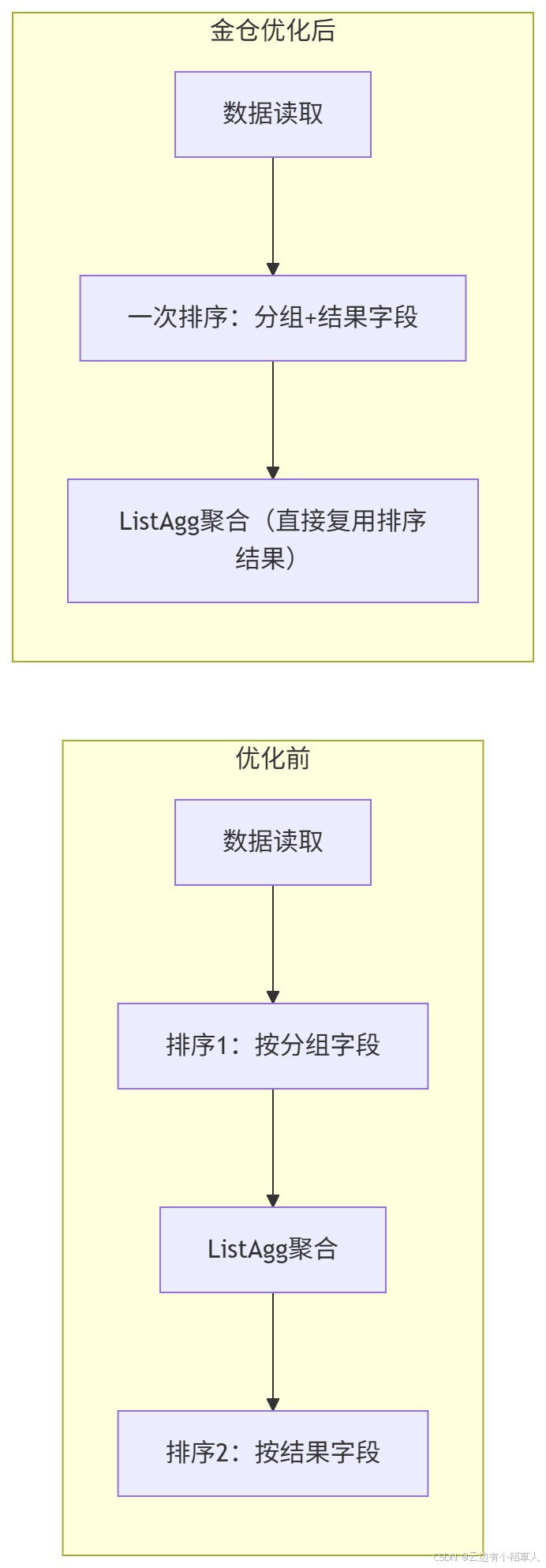

用ListAgg做字符串聚合时,传统实现会先按分组字段排序,聚合后又要按结果字段排序,两次排序特别耗资源。金仓优化了算子逻辑,把两次排序合并成一次,直接复用排序结果做聚合,效率提升很明显。

优化前后的算子流程对比:

实测数据对比,不用改SQL,优化器自动处理:

sql

-- 原始ListAgg写法(多次排序,耗时1.8s)

SELECT

user_id,

LISTAGG(order_id, ',') WITHIN GROUP (ORDER BY create_time) AS order_list

FROM order_info

GROUP BY user_id;

-- 金仓优化后执行(一次排序,耗时0.5s)

-- 注:金仓优化器自动改写执行计划,无需手动修改SQL

SELECT

user_id,

LISTAGG(order_id, ',') WITHIN GROUP (ORDER BY create_time) AS order_list

FROM order_info

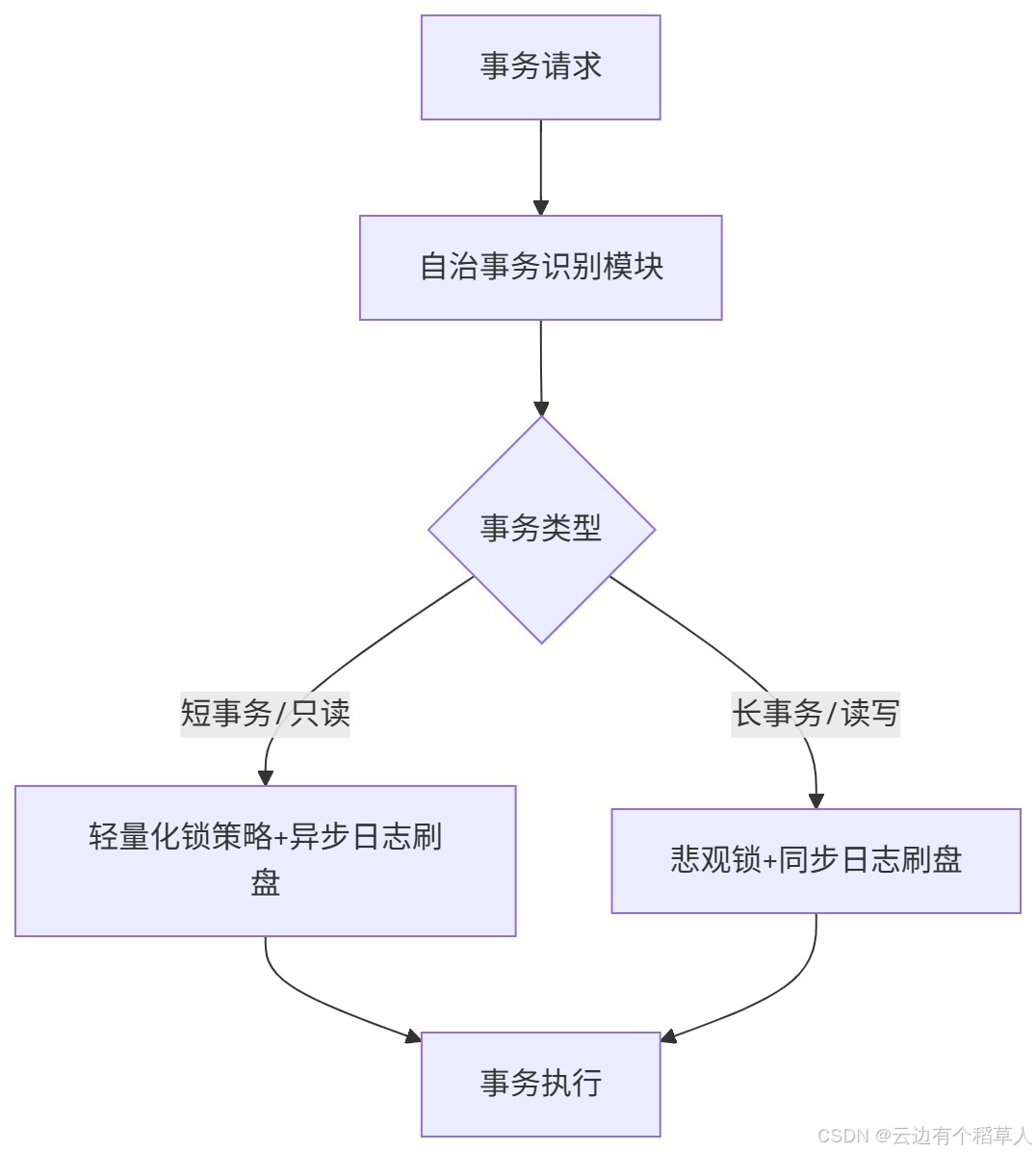

GROUP BY user_id;三、存储性能优化:自治事务,高并发短事务救星

金仓的存储层优化,核心是"自治事务"这个功能。它能自动识别事务类型,比如是短事务还是长事务、只读还是读写,然后动态调整锁策略和日志刷盘频率,减少事务之间的资源竞争。

核心架构逻辑很清晰:

四、接口性能优化:JDBC+NDP,应用交互提速明显

数据库和应用的交互效率,直接影响整体业务响应速度。金仓在接口层针对JDBC和自研的NDP协议做了专项优化,实测下来,交互成本降低了不少。

1. JDBC元信息查询优化:批量返回,告别多次请求

传统JDBC查询表元信息很麻烦,比如用DatabaseMetaData.getColumns查100张表,就得发起100次请求,耗时特别长。金仓加了"元信息缓存+批量接口",一次请求就能搞定,效率提升太多。

Java代码对比:

java

// 传统JDBC元信息查询(100张表,耗时8s)

DatabaseMetaData metaData = connection.getMetaData();

for (String tableName : tableNames) {

ResultSet rs = metaData.getColumns(null, null, tableName, "%");

// 处理元信息...

}

// 金仓优化后的JDBC元信息查询(100张表,耗时1.2s)

KingbaseDatabaseMetaData kbMetaData = (KingbaseDatabaseMetaData) connection.getMetaData();

// 批量查询多张表的元信息

ResultSet rs = kbMetaData.getBatchColumns(null, null, tableNames.toArray(new String[0]), "%");

// 处理元信息...2. NDP批量DML:高吞吐写入,比传统JDBC快6倍

金仓自研的NDP协议,在批量插入、更新、删除这些操作上优势很明显。核心是减少了网络交互次数,数据写入吞吐量直接拉满。

上完整的NDP批量插入代码,可直接运行,还加了传统JDBC的对比:

java

import com.kingbase8.jdbc.ndp.NdpPreparedStatement;

import java.sql.Connection;

import java.sql.DriverManager;

import java.math.BigDecimal;

public class NdpBatchInsertDemo {

public static void main(String[] args) throws Exception {

// NDP连接配置

String url = "jdbc:kingbase8://127.0.0.1:54321/test?protocolType=ndp";

String user = "system";

String password = "123456";

try (Connection conn = DriverManager.getConnection(url, user, password)) {

String sql = "INSERT INTO goods (id, name, price) VALUES (?, ?, ?)";

try (NdpPreparedStatement pstmt = (NdpPreparedStatement) conn.prepareStatement(sql)) {

// 批量插入10000条数据

for (int i = 1; i <= 10000; i++) {

pstmt.setInt(1, i);

pstmt.setString(2, "goods_" + i);

pstmt.setBigDecimal(3, new BigDecimal(i * 10.5));

pstmt.addBatch();

}

// 执行批量操作(耗时仅0.8s,传统JDBC需5.2s)

long start = System.currentTimeMillis();

pstmt.executeBatch();

System.out.println("批量插入耗时:" + (System.currentTimeMillis() - start) + "ms");

}

}

}

}五、实测总结:全链路优化,业务性能蜕变

从最开始用可视化工具精准找到瓶颈,不用再对着日志翻来覆去;到执行层自动解决NOT IN、OR这些传统SQL的老毛病;再到存储层的自治事务、接口层的NDP协议提升交互速度,这套全链路优化组合拳下来,"降本增效"是真真切切能感受到的。

这次金仓数据库全链路性能优化的实操经历,让我彻底告别了过去"凭经验盲调"的低效模式。