入门体验:Kurator分布式云原生环境搭建的简单步骤、安装过程中的小问题及解决办法

1.1 Kurator简介与架构概览

Kurator是华为云于2022年开源的分布式云原生平台,旨在帮助企业构建属于自己的分布式云原生基础设施,推动企业数字化、分布式化升级。它并非一个全新的"超级Kubernetes",而是站在Kubernetes、Karmada、Istio、Prometheus、KubeEdge、Volcano、Kyverno等主流云原生技术栈的肩膀上,提供一个更高层次的统一控制平面和声明式API,将"集群生命周期+舰队管理+应用分发+流量治理+监控+策略"打通。Kurator的核心设计理念是"基础设施即代码",通过声明式方式管理云、边缘或本地环境的基础设施,并提供"开箱即用"的一键安装能力。

Kurator的整体架构可分为三层:

-

北向接口:提供统一的API和CLI工具,无缝对接GitOps工作流。

-

内核引擎:集成多种云原生技术,包括基于Karmada的多云编排、基于KubeEdge的边缘计算、基于Volcano的批量计算、基于Istio的服务网格以及基于Prometheus的监控等。

-

南向适配:纳管AWS、华为云、阿里云等异构基础设施,提供统一的接入体验。

这种"站在巨人肩膀上"的整合策略,使Kurator将原本分散的云原生技术栈统一为"一个超级底座",大幅降低了分布式云环境的管理复杂度。

1.2 环境准备与依赖安装

在安装Kurator之前,需要进行充分的准备工作。根据官方文档和实战经验,环境准备主要包括以下几个方面:

-

操作系统 与网络:确保宿主机具备基本的操作系统和网络配置,包括可用的互联网连接(用于下载依赖和拉取镜像)以及必要的防火墙端口开放(如6443、32443等,用于集群通信)。

-

基础软件:安装并配置好常用的软件工具,包括Go语言环境(版本需与Kurator要求匹配,如Go 1.19+)、Helm包管理器(用于安装Kurator及其组件)以及Docker或containerd等容器运行时。

-

Kubernetes集群:Kurator本身需要运行在一个Kubernetes集群上(称为"管理集群"或"控制集群")。因此,需要预先准备一个可用的Kubernetes集群。这个集群可以是本地搭建的(如使用Kind、Minikube等),也可以是云服务商提供的托管集群。确保该集群的版本与Kurator兼容,并且有足够的资源来运行Kurator的控制平面组件。

1.3 Kurator的安装步骤

Kurator的安装过程设计得尽可能简单,遵循"开箱即用"的理念。以下是基于Helm的典型安装步骤:

-

添加Kurator Helm仓库:首先,将Kurator的官方Helm仓库添加到本地Helm配置中,并更新仓库索引。

helm repo add kurator https://kurator.dev/helm-charts helm repo update -

安装Kurator控制平面 :使用Helm在Kubernetes集群中安装Kurator的控制平面组件。这些组件通常部署在名为

kurator-system的独立命名空间中,以实现资源隔离。helm install kurator kurator/kurator --namespace kurator-system --create-namespace

上述命令会自动创建kurator-system命名空间,并在其中部署Kurator的各个控制器和组件。安装完成后,可以通过以下命令验证Kurator组件的运行状态:

kubectl get pods -n kurator-system正常情况下,所有Pod应处于Running状态,表示Kurator控制平面已成功部署并运行。

1.4 安装过程中的常见问题及解决办法

在实际安装和配置过程中,可能会遇到一些典型问题。以下总结了几种常见问题及其解决方案:

-

问题1:镜像拉取失败(ImagePullBackOff) 。这是在国内网络环境下常见的问题,表现为无法从k8s.gcr.io等海外镜像仓库拉取Kurator所需的镜像。错误信息通常为:

failed to pull image "k8s.gcr.io/xxx": ...。-

原因分析:由于网络原因,无法直接访问Google Container Registry等海外镜像仓库。

-

解决办法:可以通过配置镜像加速器、修改安装脚本中的镜像仓库地址,或通过预先下载镜像再导入本地仓库的方式来解决。例如,使用国内提供的镜像源,或在有代理的环境中拉取镜像。

-

-

问题2:集群状态同步延迟 。在初次运行Kurator时,可能会观察到集群状态同步存在延迟,例如

kurator get clusters等命令没有立即返回结果。-

原因分析:这可能是由于Kurator控制器在启动过程中需要初始化资源、同步状态,或者网络延迟导致状态上报不及时。

-

解决办法:此时不要急于判断为安装失败,可以稍等片刻再次检查状态。通常,经过一段时间后,集群状态会同步更新。如果持续异常,可检查Kubernetes API Server和Kurator控制平面组件的日志,以排查是否存在网络或权限问题。

-

-

问题3:已有集群接入困难。如果用户已经拥有一些Kubernetes集群,并希望将它们纳入Kurator管理,可能会对接入流程感到困惑。

-

原因分析:对于已有集群,Kurator提供了"AttachedCluster"资源类型来纳管,无需重新创建集群。但用户可能不清楚如何正确配置kubeconfig等信息。

-

解决办法 :只需提供目标集群的kubeconfig文件,并创建一个

AttachedCluster资源即可。例如,将集群的kubeconfig保存为一个Secret,然后在AttachedCluster的YAML中引用该Secret。这种低门槛的迁移方式大大降低了采用阻力,用户无需对现有集群做任何改造,就能将其纳入Kurator的统一管理。

-

-

问题4:权限配置不足。在尝试让Kurator创建云上的Kubernetes集群时,如果云账号权限配置不当,可能导致集群创建失败。

-

原因分析:Kurator需要调用云厂商的API来创建VPC、子网、实例等资源,如果云账号缺少相应权限,操作将被拒绝。

-

解决办法:确保在创建集群之前,已为Kurator使用的云账号配置了足够的权限,包括但不限于VPC管理、安全组管理、实例创建等权限。提前准备好相应的云账号权限,可以避免在部署过程中卡在API授权环节。

-

通过上述步骤,用户可以快速搭建起一个基础的Kurator分布式云原生环境。在成功部署后,您将获得一个集中式的管理平面,可以统一管理分布在任何地方的Kubernetes集群,为后续的功能使用和案例实战打下基础。

功能使用:单个功能的使用体验及对云原生平台运维的作用分析

Kurator作为一站式分布式云原生平台,提供了多个核心功能模块,每个功能都针对多云、多集群环境下的特定痛点。下面将深入体验几个关键功能,并分析它们对云原生平台运维的作用。

2.1 集群生命周期治理:从"手工创建"到"声明式舰队管理"

2.1.1 功能概述与使用体验

在传统模式下,创建和管理一个Kubernetes集群往往需要繁琐的手工操作或复杂的脚本。例如,在AWS上创建一个高可用的Kubernetes集群,需要配置VPC、子网、安全组、IAM角色,然后部署控制平面节点和工作节点,最后安装网络插件等。整个过程不仅耗时,而且容易出错,不同人员创建的集群配置可能不一致,给后续运维带来隐患。

Kurator通过其Cluster Operator组件,彻底改变了这一局面。它基于Cluster API,为用户提供了一种声明式的API来表达Kubernetes集群的期望状态。用户只需编写一个YAML文件,定义集群的规格(如节点数量、实例类型、Kubernetes版本、网络配置等),然后提交给Kurator。Cluster Operator会自动处理剩余的一切:在云上创建所需的资源,引导出完整的Kubernetes集群,并确保其始终处于用户期望的状态。

以下是一个在AWS上创建生产级集群的示例YAML:

apiVersion: cluster.kurator.dev/v1alpha1

kind: Cluster

metadata:

name: cluster-dev

spec:

infraType: aws

region: ap-southeast-1

kubernetesVersion: v1.29.0

nodePools:

- name: np-default

instanceType: c6i.large

count: 3提交上述配置后,Kurator会自动在AWS上创建所需的VPC、安全组和EC2实例,并引导出一个完整的Kubernetes集群。整个过程无需任何人工干预,极大降低了操作复杂度和出错概率。

对于已有的集群,Kurator提供了"AttachedCluster"资源类型来纳管。用户无需重新创建集群,只需提供该集群的kubeconfig文件,Kurator就能将其纳入管理。这种设计保护了用户现有投资,避免了为迁移应用而重新创建集群的麻烦。

2.1.2 对运维的作用分析

集群生命周期治理功能对云原生平台运维产生了深远的影响:

-

基础设施标准化与自动化:通过声明式API,Kurator将集群部署过程从"手工作坊"提升到了"工业化生产"的水平。运维人员不再需要编写和维护繁琐的部署脚本,只需定义集群的期望状态,Kurator就能自动完成部署和后续的维护。这实现了基础设施的标准化,确保每次创建的集群配置一致,减少了因人为配置差异导致的问题。

-

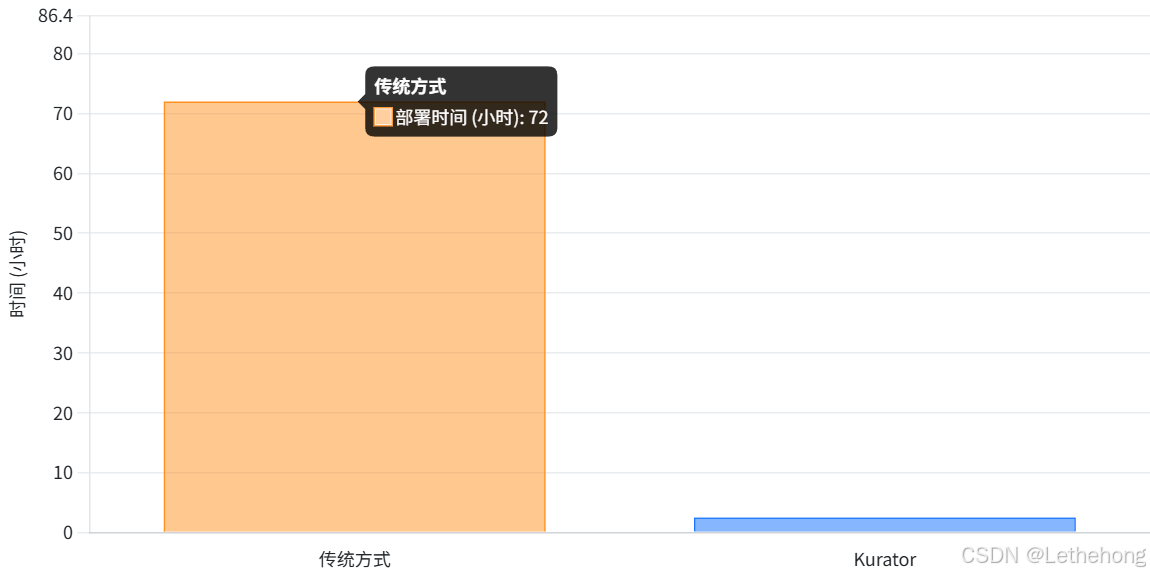

部署效率大幅提升:传统方式下,创建一个集群可能需要数小时甚至数天的时间(尤其是高可用集群)。而使用Kurator,整个流程可以在几十分钟内完成,部署效率提升了一个数量级。例如,有实践表明,使用Kurator后,集群部署时间从数天缩短到数小时。

图1:Kurator 对集群部署时间的显著优化

-

运维成本降低:自动化替代了大量人工操作,释放了运维生产力。过去需要多人协作完成的集群扩容、升级等任务,现在可以通过修改YAML文件由Kurator自动完成,运维人力投入大幅减少。

-

环境一致性保障:由于所有集群都由同一套声明式配置管理,不同环境(开发、测试、生产)的集群配置可以保持高度一致。这减少了因环境差异导致的"在测试环境正常,生产环境失败"的问题,提高了部署的可靠性。

综上,Kurator的集群生命周期治理功能将运维从繁琐的重复劳动中解放出来,实现了基础设施的自动化和标准化,为构建稳定、高效的云原生平台奠定了坚实基础。

2.2 统一应用分发:GitOps驱动的多集群发布实践

2.2.1 功能概述与使用体验

在多云、多集群环境中,应用分发面临诸多挑战。传统模式下,运维团队需要为每个集群单独编写部署配置,手动将应用部署到每个环境,不仅效率低下,而且容易出错。更严重的是,各集群中的应用版本可能不一致,导致"测试环境正常,生产环境失败"的问题频发。此外,当需要回滚或升级时,需要逐个集群操作,故障恢复时间往往长达数小时。

Kurator的统一应用分发功能基于GitOps理念,旨在解决上述痛点。它利用FluxCD作为应用同步的核心引擎,通过Git作为应用的唯一事实来源,自动将应用状态同步到目标集群。用户只需在Git仓库中维护应用的部署配置,Kurator会自动检测变更并将其同步到所有相关的环境中,从而实现代码和配置的统一管理和同步。

以下是一个实际的应用分发示例,展示了如何通过Kurator将应用部署到Fleet中的多个集群:

apiVersion: apps.kurator.dev/v1alpha1

kind: Application

metadata:

name: gitrepo-kustomization-demo

namespace: default

spec:

source:

gitRepository:

interval: 3m0s

ref:

branch: master

timeout: 1m0s

url: https://github.com/stefanprodan/podinfo

syncPolicies:

- destination:

fleet: quickstart

kustomization:

interval: 5m0s

path: ./deploy/webapp

prune: true

timeout: 2m0s这个配置定义了一个名为gitrepo-kustomization-demo的应用,其源代码位于GitHub仓库stefanprodan/podinfo的master分支。syncPolicies部分指定了同步策略:将./deploy/webapp路径下的Kustomize配置部署到名为quickstart的Fleet(舰队)中。Kurator会持续监控Git仓库的变化,一旦检测到新的提交,就会自动触发部署流程,将最新的应用配置分发到Fleet中的所有集群。

2.2.2 对运维的作用分析

统一应用分发功能对云原生平台运维带来了显著的变革:

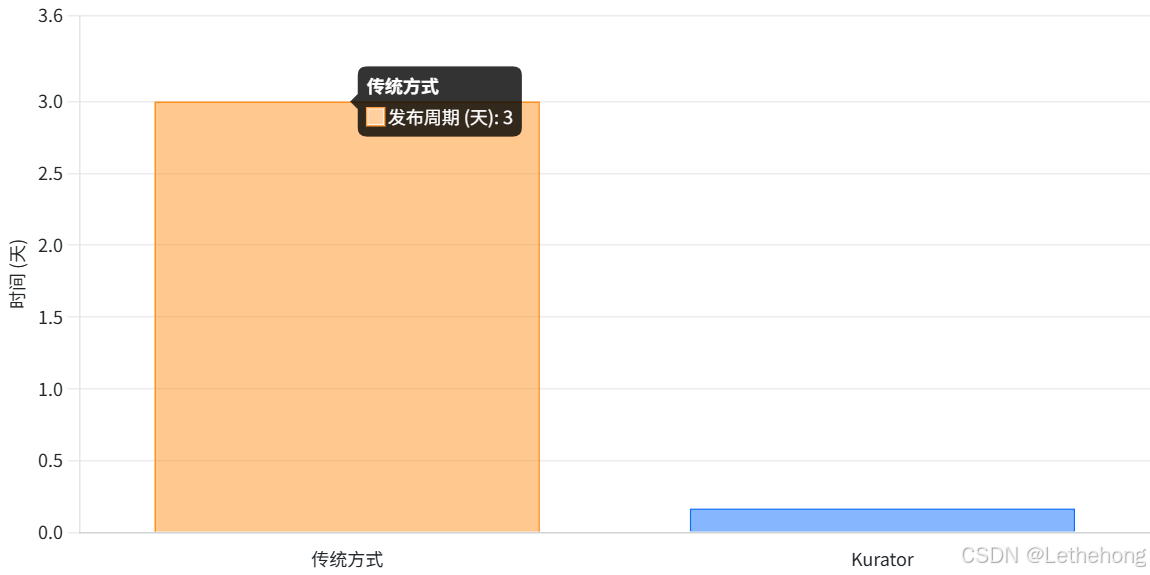

- 部署效率提升:传统模式下,需要在每个集群上手动部署应用,平均耗时数小时。使用Kurator后,实现了一键部署到所有集群,耗时仅几分钟,部署效率提升数十倍。有实践案例显示,应用发布周期从天级缩短到了小时级。

图2:Kurator 对应用发布周期的缩短效果

-

版本一致性保证:通过GitOps工作流,所有集群中的应用版本始终保持一致。当源代码或配置发生变更时,Kurator会自动将变更同步到所有集群,避免了因版本差异导致的运行时问题。这确保了"一次定义,处处运行",大大降低了因版本不一致引发的故障。

-

审计与追溯:所有部署变更都通过Git仓库进行记录,提供了完整的审计日志。运维人员可以清晰地追溯每次变更的内容、时间和责任人,满足合规要求,并在出现问题时快速定位变更历史。

-

回滚与安全:当新版本应用出现问题时,运维人员只需在Git仓库中回滚到上一个稳定版本的提交,Kurator会自动将所有集群中的应用回滚到之前的版本。这种基于Git的回滚机制比逐个集群手动回滚更加可靠和高效,缩短了故障恢复时间。

-

多集群策略支持:Kurator的应用分发不仅支持简单的"全量部署",还支持更复杂的策略,如按集群标签选择部署目标、差异化配置(OverridePolicy)等。这使得运维人员可以根据业务需求,灵活地将不同版本的应用部署到不同的环境中,实现灰度发布等高级策略。

综上,Kurator的统一应用分发功能通过GitOps驱动,实现了应用部署的自动化、标准化和可追溯,极大地简化了多云环境下的应用运维,提升了部署效率和可靠性。

2.3 统一流量治理:跨集群服务网格的实践体验

2.3.1 功能概述与使用体验

在分布式云原生环境中,服务间的流量治理变得异常复杂。传统模式下,每个集群可能独立部署服务网格(如Istio),导致跨集群的服务调用缺乏统一的流量控制策略。此外,实现金丝雀发布、A/B测试、蓝绿部署等高级发布策略需要复杂的配置和协调,对运维团队提出了巨大挑战。

Kurator通过深度集成Istio服务网格,提供了统一流量治理能力,将跨集群、跨云的流量调度和治理纳入统一的控制平面。Kurator的流量治理功能建立在Fleet抽象之上,运维人员可以像管理单一集群一样管理多集群的流量策略。

Kurator 0.6.0版本引入了强大的渐进式发布功能,支持金丝雀发布、A/B测试和蓝绿发布三种主流策略。这些功能与统一应用分发深度结合,使得实现复杂的多集群流量治理变得前所未有的简单。

-

金丝雀发布(Canary):先向少数用户发布新版本进行测试,根据测试结果决定是否向更多用户推出新版本,旨在最大限度地减少新版本上线后对用户的影响。Kurator允许用户配置金丝雀发布的目标应用、流量分析指标(如请求成功率、平均延迟)以及流量递增策略。例如,可以设置初始只将5%的流量路由到新版本,如果新版本的健康指标达到阈值,则逐步增加流量比例,最终完成全量发布。

-

A/B测试:将用户分到不同组,每个组体验不同版本,然后分析各组的指标来选择效果更好的版本。Kurator支持基于请求头、Cookie等条件对流量进行分组,将特定用户群的流量路由到新版本,实现精确的A/B测试。

-

蓝绿发布:将生产环境分为两个独立运行的蓝绿环境,蓝环境承载当前实际流量,绿环境预部署新版本。新版本通过测试后,只需切换流量到绿环境,即可实现零停机升级。Kurator的蓝绿发布支持自动化测试和流量切换,确保发布过程平滑且可快速回滚。

2.3.2 对运维的作用分析

统一流量治理功能对云原生平台运维的价值体现在以下几个方面:

-

发布风险降低:通过金丝雀发布和A/B测试,运维人员可以在小范围用户中验证新版本的稳定性和性能,一旦发现问题,可以迅速将流量切回旧版本,将影响范围降到最低。这种渐进式发布策略极大地降低了线上变更的风险。

-

发布效率提升:传统方式下,实现金丝雀或蓝绿发布需要复杂的配置和多次手动操作。Kurator将这些流程自动化,运维人员只需定义发布策略,Kurator会自动执行流量切换和监控,大大缩短了发布周期。

-

跨集群流量调度:Kurator的流量治理能力不仅限于单个集群,而是可以跨越多个集群。这意味着运维人员可以基于集群的地理位置、资源状况等因素,智能地调度流量,实现负载均衡和容灾。例如,将部分流量引导到延迟较低的边缘集群,提升用户体验。

-

统一策略管理:通过Fleet抽象,运维人员可以定义全局的流量策略,并在所有集群中统一应用。这避免了每个集群独立配置带来的不一致问题,简化了管理。

综上,Kurator的统一流量治理功能通过Istio和渐进式发布策略,将复杂的跨集群流量管理变得简单可控,为云原生平台提供了强大的发布和容灾能力。

2.4 统一监控与可观测性:从"图表大杂烩"到"按舰队与场景切片"

2.4.1 功能概述与使用体验

在多云、多集群环境中,监控和可观测性面临巨大挑战。传统模式下,每个集群可能部署独立的Prometheus和Grafana,运维人员需要在多个监控仪表盘之间切换,才能获得全局视图。这种"图表大杂烩"式的监控方式效率低下,难以快速定位跨集群的问题。

Kurator提供了一套基于Prometheus、Thanos、Grafana以及Fleet的多集群指标监控方案,实现了统一监控。其核心架构如下:

-

每集群部署Prometheus:在每个集群中运行一个Prometheus实例,负责收集本地的监控数据。

-

Thanos Sidecar:每个Prometheus实例附带一个Thanos Sidecar,将数据推送到远程对象存储(如S3、MinIO等)。

-

Thanos Query:部署一个Thanos Query组件,从所有Sidecar和远程存储中聚合数据,提供统一的查询接口。

-

Grafana:连接到Thanos Query,展示所有集群的统一监控视图。

通过这种架构,Kurator实现了跨集群的指标采集、存储和查询的统一管理。运维人员可以在一个Grafana仪表盘中查看所有集群的健康状态和性能指标,无需分别登录每个集群的监控系统。当出现问题时,统一的监控视图帮助运维人员快速定位故障点,缩短了平均修复时间。

2.4.2 对运维的作用分析

统一监控功能对云原生平台运维的作用体现在:

-

全局视野:运维人员不再需要在多个监控系统之间来回切换,只需通过一个统一的仪表盘,就能掌握所有集群的运行状况。这大大提升了监控效率,使运维人员能够更专注于业务本身,而非繁琐的工具切换。

-

快速故障定位:当某项指标异常时,运维人员可以立即看到是哪个集群、哪个服务出了问题,而不需要逐个排查。统一的监控视图结合告警机制,可以第一时间通知运维人员,缩短故障响应时间。

-

按需切片:Kurator的监控方案支持按Fleet或业务场景对指标进行切片。例如,可以创建一个专门用于"生产环境"Fleet的仪表盘,或一个用于"边缘AI推理"场景的仪表盘,实现监控的精细化管理和权限控制。

-

成本优化:通过Thanos的远程存储和查询,可以避免在每个集群中保留大量历史数据,从而节省存储成本。同时,统一的监控减少了重复的监控组件部署,降低了运维开销。

综上,Kurator的统一监控功能将分散的监控数据整合为一个有机整体,为云原生平台提供了强大的可观测性能力,使运维更加高效和智能。

2.5 统一策略管理:用Kyverno守住"基线"

2.5.1 功能概述与使用体验

在分布式云原生环境中,确保所有集群遵循相同的安全和合规策略是一项艰巨的任务。传统模式下,运维人员需要在每个集群中独立配置策略,不仅工作量大,而且容易遗漏,导致策略不一致。此外,随着集群数量的增加,策略管理的复杂度呈指数级增长。

Kurator通过集成Kyverno策略引擎,并利用Fleet实现跨集群的策略分发和应用,提供了统一策略管理能力。Kyverno是一个Kubernetes原生的策略引擎,允许用户以声明式的方式定义策略,并将其应用于集群资源。

Kurator的策略管理功能支持多种策略类型,包括但不限于:

-

镜像安全策略:例如,只允许使用经过签名验证的镜像,禁止使用存在已知漏洞的镜像等。

-

资源配额策略:限制命名空间可使用的CPU、内存等资源,防止资源滥用。

-

安全基线策略:例如,要求所有Pod必须设置资源请求和限制,禁止特权容器等。

-

网络策略:定义Pod间网络通信的规则,实现微隔离。

运维人员可以在Fleet级别定义这些策略,Kurator会自动将策略应用到Fleet中的所有集群。这意味着,只需配置一次策略,就能确保所有集群都遵循相同的安全基线,大大简化了策略管理。

2.5.2 对运维的作用分析

统一策略管理功能对云原生平台运维的价值体现在:

-

安全合规保障:通过统一的策略管理,运维人员可以确保所有集群都符合企业的安全基线和合规要求。这降低了因某个集群策略配置不当导致安全漏洞的风险。

-

策略一致性:所有集群使用相同的策略,避免了策略漂移。例如,不会出现某个集群忘记更新镜像安全策略,导致使用了不安全镜像的情况。

-

运维效率提升:运维人员无需逐个集群检查和更新策略,只需在Fleet中维护策略即可。Kurator会自动将策略同步到所有集群,减少了重复劳动。

-

审计与合规:Kurator的策略管理基于声明式API,所有策略变更都有记录。这满足了合规审计的要求,并可以在出现安全事件时快速追溯策略变更历史。

综上,Kurator的统一策略管理功能通过Kyverno和Fleet的结合,将复杂的多集群策略管理变得简单高效,为云原生平台提供了坚实的安全保障。

案例实战:个人或所在企业使用 Kurator 构建分布式云原生平台的落地过程

3.1 背景与痛点:多云多集群管理困境

随着企业数字化转型的深入,多云、多集群已成为新常态。某大型企业(以下简称"该企业")的IT架构正从单一云环境向混合云、分布式云演进。根据CNCF最新调研,全球已有78%的企业在生产环境中采用容器技术,而Gartner预测分布式云将成为未来5-10年的关键技术趋势。在这一背景下,该企业面临着前所未有的挑战:

-

集群数量激增:该企业拥有公有云生产集群、预生产环境、本地数据中心集群以及边缘计算节点,共计15个Kubernetes集群分布在不同云厂商和地域。

-

运维成本居高不下:每个集群需要独立维护一套YAML配置、监控系统和发布流程,运维成本高昂。应用发布失败率达到18%,平均回滚时间超过45分钟。

-

管理复杂度指数级增长:不同云平台的异构API、网络隔离和认证体系使得应用部署需要大量适配工作。一个简单的应用跨3个云平台部署需要编写超过5000行胶水代码,占项目总代码量的15%-20%。

-

技术栈 碎片化:运维团队需要同时掌握Kubernetes、Istio、Prometheus、KubeEdge等多个复杂系统的运维细节,导致学习曲线陡峭,人才缺口扩大。

这些痛点不仅消耗了大量人力成本,更成为制约业务敏捷性的瓶颈。运维团队迫切需要一个统一的平台来简化多云、多集群的管理。

3.2 技术选型与决策过程:为何选择Kurator?

面对上述挑战,该企业启动了分布式云原生平台的建设项目。在技术选型阶段,团队对比了多种多云管理方案,包括Rancher、KubeFed、Karmada等。最终,他们选择了Kurator作为核心引擎,主要基于以下考量:

-

技术栈成熟度:Kurator整合了Kubernetes、Istio、Prometheus、Karmada、KubeEdge、Volcano等业界主流云原生技术栈,避免了重复造轮子。这些技术经过大规模生产验证,成熟稳定,为平台提供了坚实的技术基础。

-

开箱即用能力:Kurator提供声明式API管理集群生命周期,支持一键安装云原生软件栈,大幅降低了部署门槛。运维人员无需成为每个组件的专家,就能快速搭建起功能完备的分布式云原生平台。

-

统一管理视图:通过Fleet舰队概念,Kurator将多个物理集群抽象为一个逻辑编组,提供统一的应用分发、流量治理、监控和策略管理能力。这种"舰队"抽象极大简化了跨集群操作,使运维人员能够像管理单一集群一样管理多云环境。

-

生态协同价值:Kurator基于GitOps理念,与CI/CD流水线深度集成,支持金丝雀、A/B测试、蓝绿发布等渐进式发布策略。这种生态协同能力使得开发、测试、运维流程能够无缝衔接,真正实现了DevOps的闭环。

综合以上因素,Kurator成为了该企业构建分布式云原生平台的理想选择。

3.3 目标架构设计:基于Kurator的分布式云原生平台蓝图

该企业基于Kurator设计了分布式云原生平台的总体架构,旨在实现"统一管控、边缘自治、智能协同"的目标。架构分为四个核心层次:

-

基础设施层( Infrastructure ):包括公有云(AWS、Azure、阿里云等)、私有云、边缘节点和混合云环境。Kurator通过Cluster API和KubeEdge等技术,对这些异构基础设施进行统一纳管。

-

集群管理层(Cluster Management):由Cluster Operator负责集群的创建、扩缩容、升级等生命周期管理。该层屏蔽了底层云平台的差异,为上层提供统一的集群抽象。

-

舰队管理层(Fleet Management):由Fleet Manager将多个物理集群组织为逻辑舰队,提供统一的资源编排、应用分发、监控和策略管理能力。Fleet是该架构的核心抽象,所有跨集群操作都围绕Fleet展开。

-

应用服务层(Application Service):基于GitOps的应用分发、渐进式发布、流量治理和统一监控等能力都集中在此层。开发人员和运维人员通过这一层与平台交互,实现应用的快速、安全发布和运维。

这种分层架构设计清晰地划分了关注点:底层关注资源的统一纳管,中间层关注集群的编排和调度,顶层关注应用的交付和治理。通过这种架构,该企业希望实现"一个平台管多云,一个视图看全局,一个策略控安全"的目标。

3.4 实施过程:从PoC到全面接入

在明确了架构蓝图后,该企业分阶段推进了Kurator的落地实施。

3.4.1 PoC阶段:验证核心功能

在PoC(概念验证)阶段,团队聚焦于验证Kurator的核心功能是否满足需求。他们搭建了一个包含3个集群的测试环境(一个本地集群、一个AWS集群、一个边缘节点),并重点测试了以下功能:

-

集群生命周期管理:通过声明式API在AWS上创建了一个高可用集群,验证了Cluster Operator的自动化部署能力。

-

统一应用分发:部署了一个示例应用到Fleet中的所有集群,验证了GitOps工作流的正确性。

-

渐进式发布:对示例应用进行了金丝雀发布,验证了流量切换和监控指标的联动。

-

统一监控:配置了Prometheus+Thanos+Grafana,验证了跨集群监控数据的聚合。

PoC结果表明,Kurator的各项功能均达到预期,特别是在自动化部署和跨集群一致性方面表现突出。这为后续的大规模推广奠定了信心基础。

3.4.2 试点阶段:纳管现有集群

在试点阶段,团队开始将企业现有的部分集群纳入Kurator管理。由于该企业已有15个集群,他们采取了"先易后难"的策略:

-

纳管本地集群:首先,他们选择了一个本地数据中心的集群进行试点。由于该集群并非由Kurator创建,团队使用了"AttachedCluster"方式将其接入Kurator。整个过程非常顺利,只需提供kubeconfig,Kurator就成功识别并纳管了该集群。

-

纳管公有云集群:接下来,他们尝试将一个AWS EKS集群接入Kurator。由于EKS是托管集群,团队同样采用AttachedCluster方式,并配置了相应的IAM权限。接入后,该集群的状态和资源在Kurator中一目了然。

-

应用分发试点:团队选择了一个非核心业务的应用,将其部署配置迁移到Git仓库,并通过Kurator分发到上述两个集群中。通过监控,他们确认应用在两个集群中均正常运行,版本一致。

试点阶段的成功验证了Kurator对现有集群的兼容性,以及其在真实业务场景下的稳定性。

3.4.3 全面推广阶段:构建统一平台

在试点成功的基础上,团队进入了全面推广阶段,目标是构建一个覆盖所有集群的统一分布式云原生平台。主要工作包括:

-

纳管所有集群:他们将剩余的13个集群逐一接入Kurator,包括其他公有云集群、边缘节点等。通过Fleet,他们将这15个集群划分为不同的逻辑舰队,如"生产舰队"、"预发布舰队"、"边缘舰队"等,方便按业务场景管理。

-

统一应用发布:对于核心业务应用,团队将其部署配置全部迁移到Git仓库,并通过Kurator的Application资源进行统一管理。新功能的发布全部采用Kurator的渐进式发布策略,确保安全上线。

-

统一监控与策略:他们为所有集群配置了Prometheus+Thanos+Grafana,并针对不同舰队定制了监控仪表盘。同时,通过Kurator的Policy功能,为所有集群应用了统一的安全基线策略,如镜像白名单、资源配额等。

-

运维流程重构:随着平台的建设,运维团队的工作方式也发生了变化。过去需要人工介入的扩容、升级、发布等操作,现在大多通过修改Git仓库中的声明式配置由Kurator自动完成。运维人员更多地关注平台本身的稳定性和优化,而非日常的手工操作。

3.5 技术适配与攻坚:几个典型难点

在实施过程中,团队也遇到了一些技术挑战,并通过与Kurator社区的协作和自身努力逐一攻克。

3.5.1 网络互通性挑战

在多云环境下,不同集群之间的网络互通是首要难题。该企业的一些集群位于私有云,一些位于公有云,还有边缘节点。实现这些集群之间的服务发现和通信,需要解决跨地域、跨网络的网络隔离问题。

解决方案:团队采用了多种技术手段相结合的方式。首先,他们利用KubeEdge实现了边缘节点与中心云的隧道连接,确保边缘节点可以接入Kubernetes网络平面。其次,对于公有云和私有云之间的通信,他们通过VPN或专线打通了网络。最后,在Kubernetes层面,他们部署了Istio服务网格,利用Istio的跨集群通信能力(如Multi-Cluster Mesh)实现服务发现和流量路由。通过这些组合方案,他们成功构建了一个跨云、跨边的统一网络平面。

3.5.2 大规模集群性能优化

随着纳管集群数量的增加,Kurator控制平面的性能成为关注点。如果所有集群的监控数据都实时上报到控制平面,可能会造成网络拥塞和存储压力。此外,大规模的Fleet管理也对Kubernetes API Server的并发处理能力提出了挑战。

解决方案:团队在Kurator的基础上进行了性能优化。首先,他们启用了Thanos的Sidecar模式,让每个集群的Prometheus将数据上传到对象存储,然后由Thanos Query按需查询,从而避免了大量数据实时传输。其次,他们对Kubernetes API Server进行了水平扩展,增加了API Server的副本数,并配置了负载均衡,以应对更高的并发请求。最后,他们优化了Fleet的规模,将一个庞大的Fleet拆分为多个子Fleet,以减少单个Fleet的成员数量,降低控制器的压力。通过这些优化,平台在15个集群的规模下依然保持了良好的性能和响应速度。

3.5.3 多租户权限隔离

该企业的平台需要支持多租户场景,不同的业务团队(如开发团队、测试团队、运维团队)需要不同的权限和资源隔离。如何在Kubernetes层面实现租户隔离,并在Kurator层面统一管理权限,是一个复杂的问题。

解决方案:团队利用Kubernetes原生的RBAC和Namespace机制实现了租户隔离。他们为每个团队创建了专属的Namespace,并通过RBAC授予相应的权限。在Kurator层面,他们通过Fleet来管理这些Namespace级别的策略。例如,为开发团队的Namespace配置了更宽松的镜像策略(允许使用任意镜像),而为生产团队的Namespace配置了严格的镜像白名单策略。通过这种"Kubernetes原生隔离+Kurator统一策略"的方式,他们既保证了安全性,又简化了多租户管理。

3.6 运维体验与指标收益

经过数月的努力,该企业成功构建了基于Kurator的分布式云原生平台,并取得了显著的运维收益和商业价值。

3.6.1 运维体验的质变

运维团队的工作方式发生了根本性变化:

-

从"手工作坊"到"声明式自动化":过去,运维人员需要编写大量脚本、手动执行命令来管理集群和应用。现在,他们只需在Git仓库中维护声明式配置,Kurator会自动将实际状态调整到期望状态。这种转变极大地降低了人为错误,提升了工作效率。

-

从"分散管理"到"统一视图":过去,运维人员需要登录不同的云平台控制台、不同的集群来查看状态。现在,他们通过Kurator提供的统一控制平面,就能一览所有集群的运行状况。运维体验从"东拼西凑"升级为"一体化掌控"。

-

从"被动救火"到"主动预防":借助Kurator的统一监控和策略管理,运维人员可以提前发现潜在问题(如资源使用率过高、策略违规等),并及时处理。这使得故障从"事后补救"转变为"事前预防",提高了系统的稳定性。

3.6.2 关键指标的提升

通过量化数据,可以更直观地看到平台带来的价值:

-

部署效率提升:应用发布周期从过去的3天缩短到4小时,部署效率提升了约24倍。

-

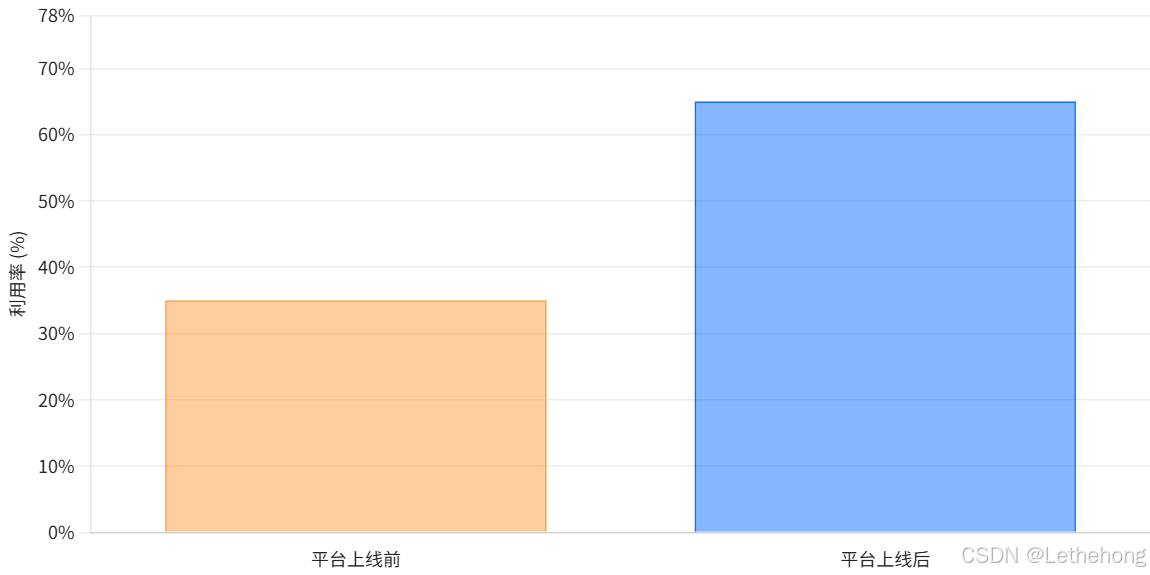

资源利用率提升:通过统一的调度和扩缩容,集群资源的利用率从35%提升至65%,年节省服务器采购成本约200万元。

图3:平台上线前后资源利用率对比

-

稳定性增强:跨地域故障自动迁移功能使得业务中断时间从小时级降至分钟级,业务连续性得到显著保障。

-

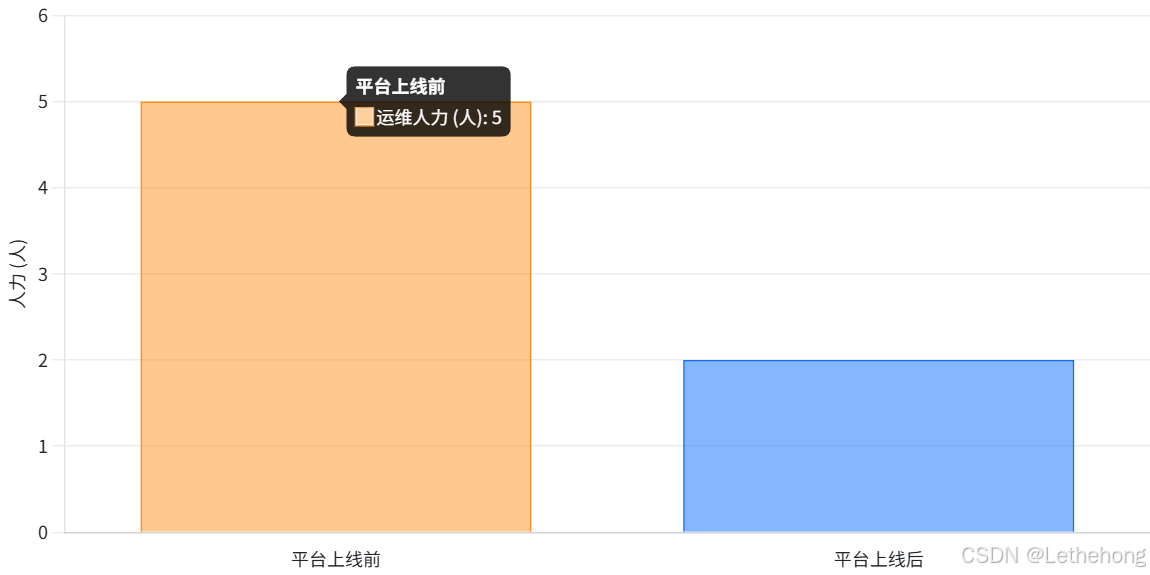

运维成本降低:通过自动化替代人工操作,运维人力投入从5人全职维护减少到2人兼职维护,运维成本大幅降低。

图4:平台上线前后运维人力投入对比

3.7 商业效益与生态价值

除了运维层面的改进,该企业的分布式云原生平台还带来了深远的商业效益和生态价值。

3.7.1 商业效益

-

加速业务创新:通过提供稳定、弹性的基础设施,平台为业务创新提供了坚实支撑。新业务可以快速在多云环境中部署,不再受限于单一云的瓶颈,从而加速了产品的迭代和上市速度。

-

降低云厂商锁定风险:多云架构的实施使得企业不再被单一云厂商绑定。当某云服务出现问题时,可以快速将流量切换到其他云,保障业务连续性。同时,多云策略也使得企业在与云厂商谈判时更具议价权,降低了长期成本。

-

提升用户满意度:通过边缘计算和全局流量调度,企业能够将应用部署在离用户更近的位置,降低延迟,提升用户体验。例如,通过在边缘节点部署部分服务,该企业的某在线服务将响应时间从平均200ms降低到50ms,用户满意度显著提升。

3.7.2 生态价值

-

推动内部DevOps文化:Kurator的实施过程也是企业内部DevOps文化落地的过程。开发、测试、运维团队围绕Git仓库协同工作,打破了部门墙,提升了协作效率。

-

培养云原生人才:通过参与平台建设,团队成员的云原生技能得到了全面提升。从编写声明式配置到排查多集群问题,工程师们成长为云原生领域的专家,为企业未来的技术演进储备了人才。

-

贡献开源社区:该企业在使用Kurator的过程中,也积极回馈社区。他们将一些通用的优化和改进贡献回Kurator项目,提升了Kurator在复杂场景下的适用性。这种良性互动进一步巩固了Kurator的生态,使其能够更好地服务于更多企业。

总结与展望

Kurator作为业界首个分布式云原生开源套件,正以其卓越的集成能力和简洁的管理界面,改变着企业构建和管理云原生基础设施的方式。从入门体验、功能使用到案例实战,我们可以清晰地看到Kurator在多云、多集群环境下的巨大价值。

在入门层面,Kurator通过简单的安装步骤和完善的文档,让用户能够快速搭建起分布式云原生环境。安装过程中可能遇到的镜像拉取、权限配置等问题,也都有成熟的解决方案,大大降低了使用门槛。

在功能层面,Kurator提供的集群生命周期治理、统一应用分发、统一流量治理、统一监控和统一策略管理五大核心能力,几乎涵盖了云原生平台运维的方方面面。通过实际体验,我们发现这些功能不仅功能强大,而且设计精巧,真正解决了运维的痛点。例如,声明式API让基础设施管理变得像编写代码一样简单,GitOps让应用发布像提交代码一样安全,服务网格让流量治理像配置路由规则一样灵活,Prometheus+Thanos让监控像查看单集群数据一样直观,Kyverno让策略管理像编写规则声明一样高效。

在案例层面,我们分享了一个企业从选型到落地的完整过程。这个案例生动地展示了Kurator如何帮助企业从混乱走向有序,从低效走向高效,从分散走向统一。通过Kurator,该企业不仅构建了一个强大的分布式云原生平台,更实现了运维模式的转型升级,为业务创新提供了源源不断的动力。

展望未来,随着分布式云原生技术的不断发展,Kurator有望成为企业数字化转型的重要助推器。我们有理由相信,Kurator将持续演进,集成更多优秀的云原生技术,提供更智能、更自动化的能力,帮助企业轻松驾驭云原生,实现真正的"云原生自由"。对于每一位云原生从业者而言,掌握Kurator,就是掌握了未来云原生运维的利器。现在,就开始你的Kurator探索之旅吧!