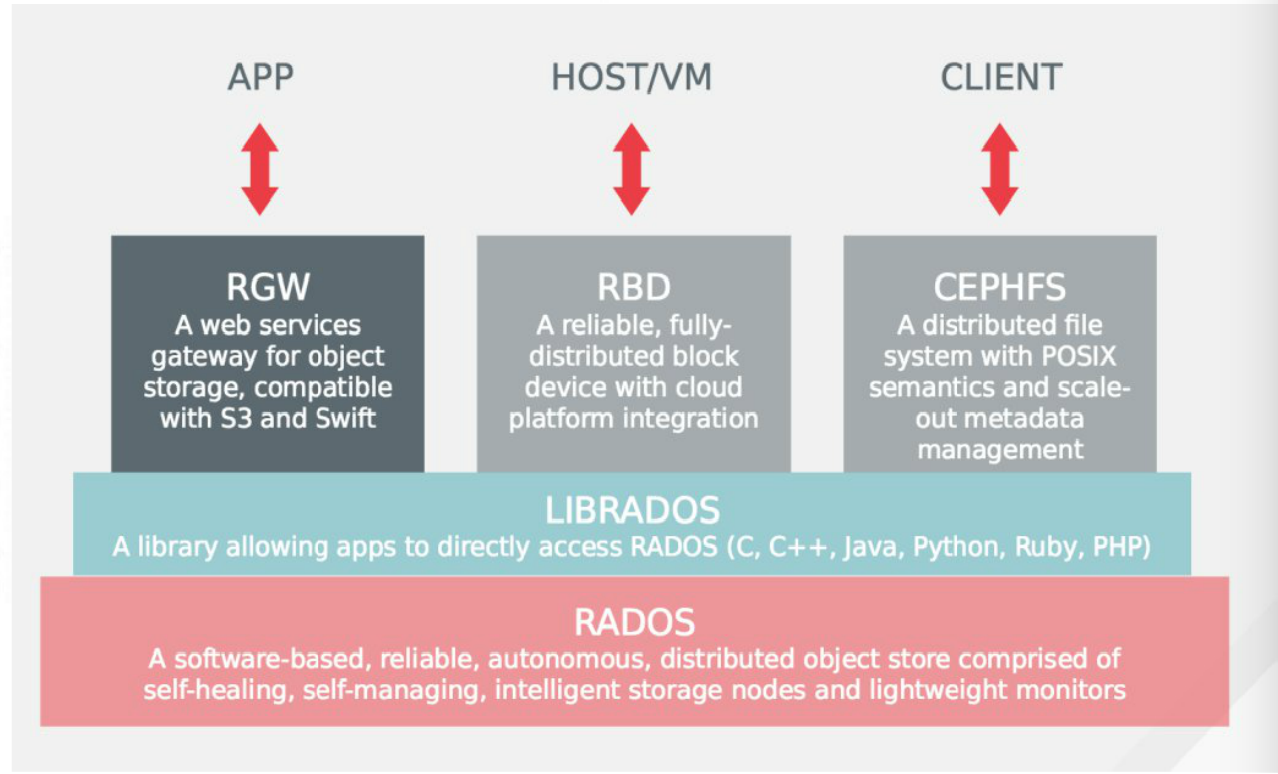

1、Ceph存储架构

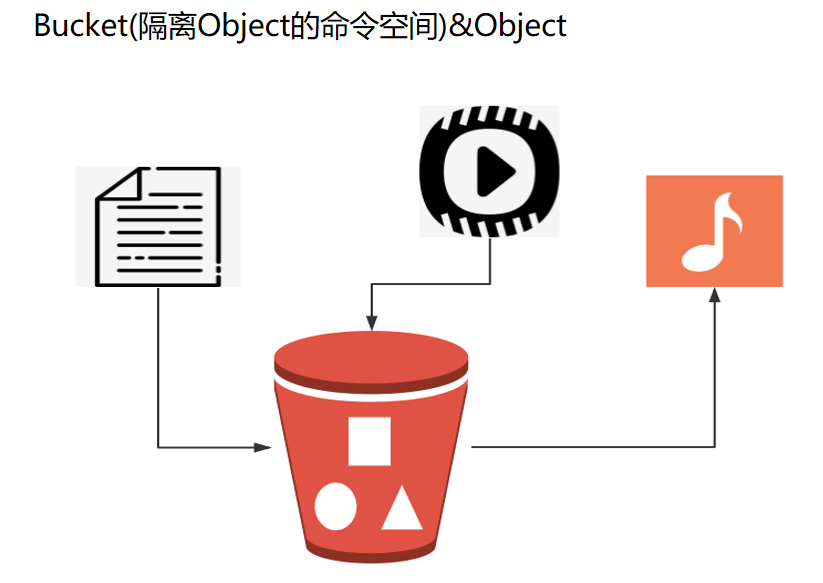

2、Radosgw层

2.1 Bucket & Object

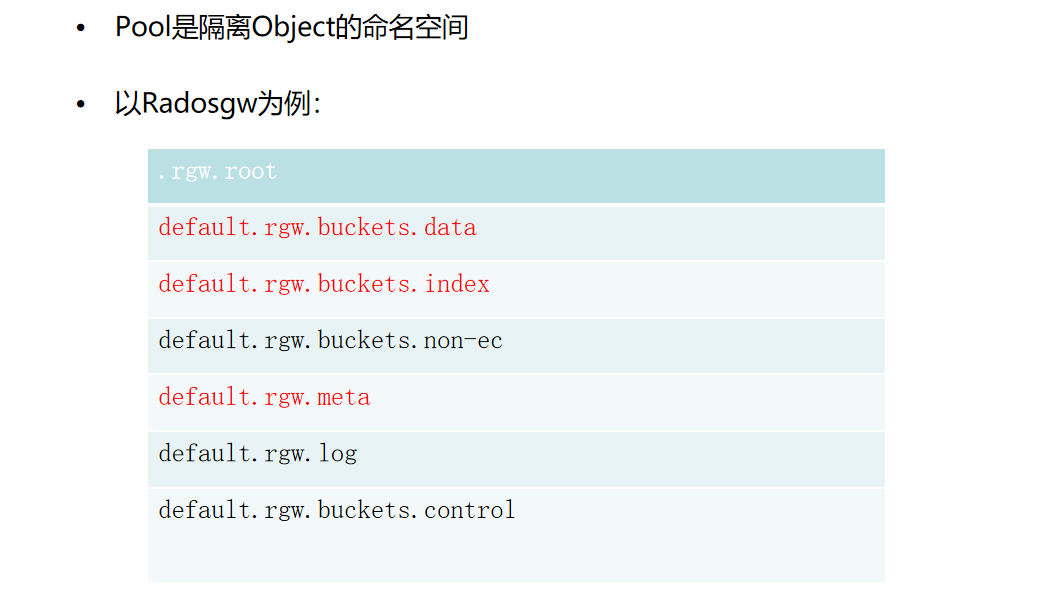

3、Rados层

3.1 重要成员

3.2 Pool & Object

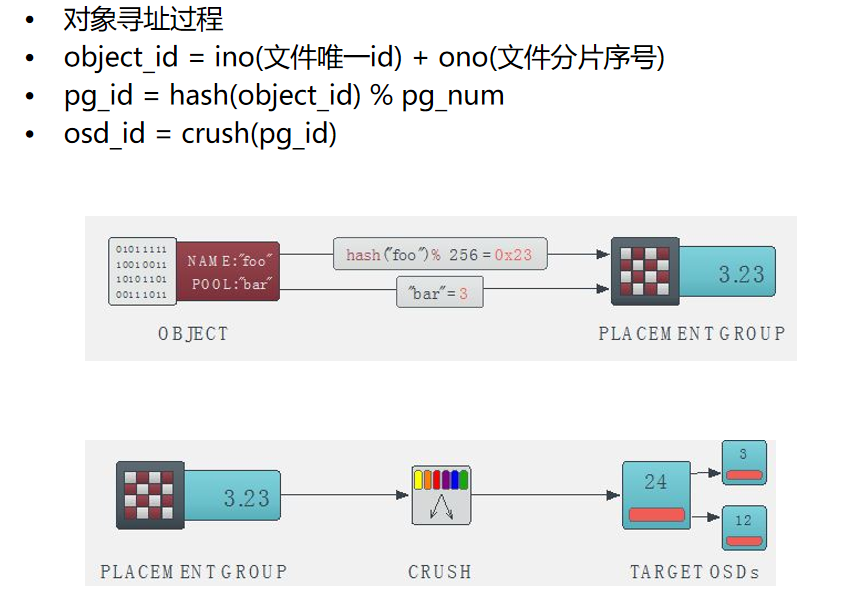

3.3 Object 对象寻址

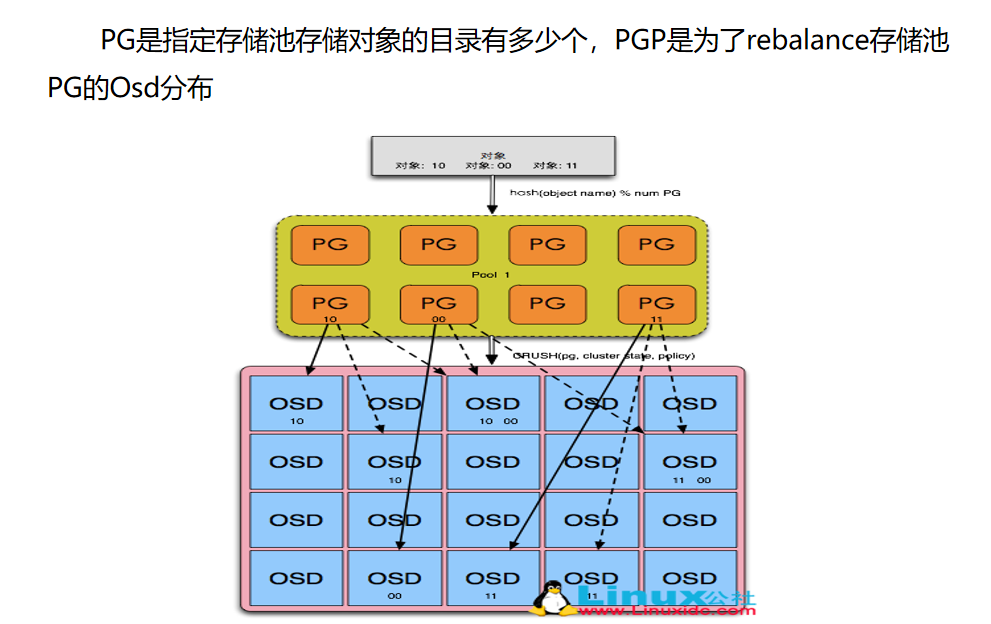

3.4 PG PGP

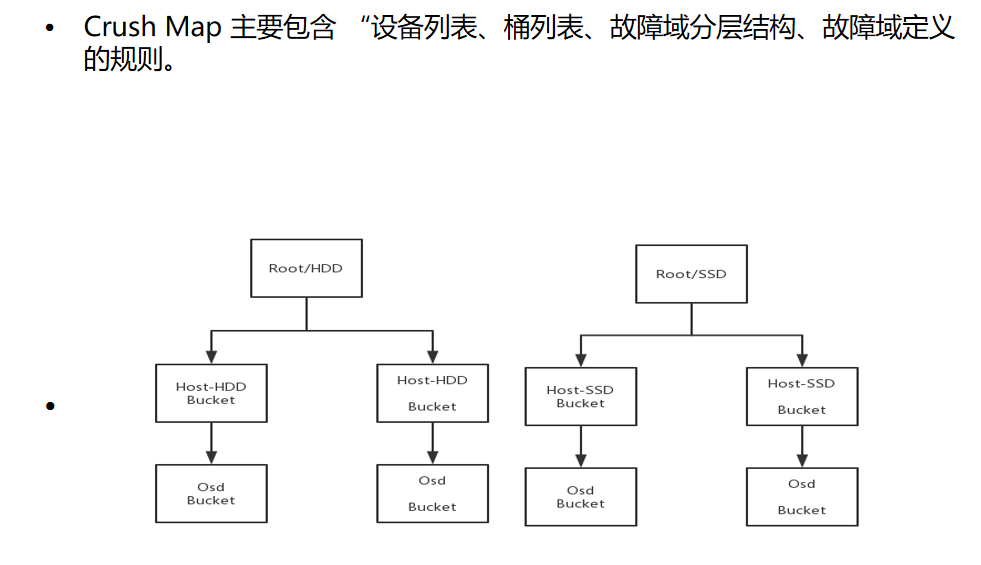

3.5 Crush Map

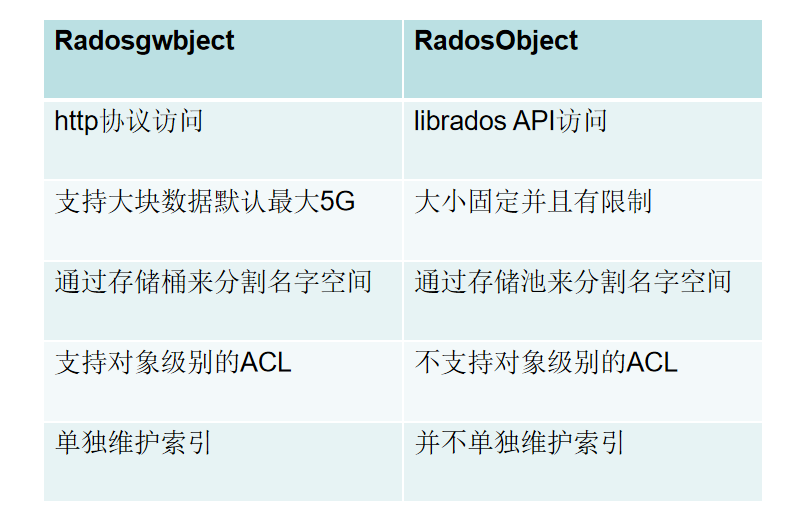

4、RadosgwObject VS RadosObject

- Ceph调优配置

a.PG和PGP分配 参考https://ceph.com/pgcalc/

b.建议取消分片功能

rgw_dynamic_resharding = false

注:目前开源社区功能不稳定,建议提前预估数据量,对bucket进行手动分片

c.给指定Pool设置SSD

ceph osd crush set-device-class ssd osd.0

ceph osd crush rule create-replicated rule-ssd default host ssd

ceph osd pool create default.rgw.buckets.index 4 4 rule-ssd

d.Radosgw GC参数配置调优

rgw_gc_max_objs是控制每次GC任务可处理的最大对象数,高速存储设备可以适当扩大,当底层存储设备比较慢并且负载较高的时候,可适当缩小。

rgw_gc_processor_max_time是控制每次GC任务最多能够执行的时长,高速存储设备可以适当缩小,当底层存储设备比较慢并且负载较高的时候,可适当调大。

rgw_gc_obj_min_wait 是控制删除数据以后多久以后开始真正的底层数据回收,默认是2小时,如果线上对空间资源利用率比较敏感,可以适当缩短。

rgw_gc_processor_period 是控制多久时长以后GCworker开始下一轮的GC操作,如果单次GC需要操作的列表条目数较少,可以适当缩短这个参数。