【前瞻创想】Kurator云原生实战:从入门到精通,打造分布式云原生新生态

- 【前瞻创想】Kurator云原生实战:从入门到精通,打造分布式云原生新生态

-

- 摘要

- 一、Kurator:分布式云原生的新时代

-

- [1.1 什么是Kurator](#1.1 什么是Kurator)

- [1.2 Kurator的创新价值](#1.2 Kurator的创新价值)

- [1.3 Kurator与竞品对比](#1.3 Kurator与竞品对比)

- 二、环境搭建与快速入门

-

- [2.1 基础环境准备](#2.1 基础环境准备)

- [2.2 Kurator源码获取与安装](#2.2 Kurator源码获取与安装)

- [2.3 验证安装结果](#2.3 验证安装结果)

- 三、Kurator核心架构深度解析

-

- [3.1 架构概览](#3.1 架构概览)

- [3.2 组件交互流程](#3.2 组件交互流程)

- [3.3 关键设计思想](#3.3 关键设计思想)

- 四、Fleet舰队管理:统一资源编排的艺术

-

- [4.1 Fleet概念与架构](#4.1 Fleet概念与架构)

- [4.2 身份与命名空间相同性](#4.2 身份与命名空间相同性)

- [4.3 服务相同性与跨集群通信](#4.3 服务相同性与跨集群通信)

- [4.4 外部资源访问的身份管理](#4.4 外部资源访问的身份管理)

- 五、GitOps实践:FluxCD与自动化流水线

-

- [5.1 GitOps核心理念](#5.1 GitOps核心理念)

- [5.2 FluxCD Helm应用部署示意图](#5.2 FluxCD Helm应用部署示意图)

- [5.3 Kurator CI/CD流水线设计](#5.3 Kurator CI/CD流水线设计)

- [5.4 自动化部署与回滚机制](#5.4 自动化部署与回滚机制)

- 六、边缘计算与跨集群调度:KubeEdge与Volcano

-

- [6.1 KubeEdge架构深度解析](#6.1 KubeEdge架构深度解析)

- [6.2 Karmada跨集群弹性伸缩](#6.2 Karmada跨集群弹性伸缩)

- [6.3 Volcano调度架构](#6.3 Volcano调度架构)

- [6.4 边缘-云协同调度策略](#6.4 边缘-云协同调度策略)

- 七、Kurator未来展望与技术演进

-

- [7.1 当前挑战与机遇](#7.1 当前挑战与机遇)

- [7.2 技术演进路线](#7.2 技术演进路线)

- [7.3 社区建设与开源生态](#7.3 社区建设与开源生态)

- [7.4 分布式云原生的未来思考](#7.4 分布式云原生的未来思考)

- 结语

【前瞻创想】Kurator云原生实战:从入门到精通,打造分布式云原生新生态

摘要

在云原生技术迅猛发展的今天,企业面临着多云、混合云、边缘计算等复杂场景的挑战。Kurator作为一款开源的分布式云原生平台,站在众多优秀开源项目的肩膀上,为用户提供了一站式解决方案。本文将深入解析Kurator的核心架构、关键组件及实践应用,从环境搭建到高级特性,从理论到实战,全方位展示Kurator如何帮助企业构建强大的分布式云原生基础设施。通过多个深度实践案例,包括Fleet舰队管理、Karmada跨集群调度、KubeEdge边缘计算集成、GitOps自动化流水线等,为读者呈现一个完整的Kurator技术生态。同时,结合行业趋势,探讨分布式云原生技术的未来发展方向。

一、Kurator:分布式云原生的新时代

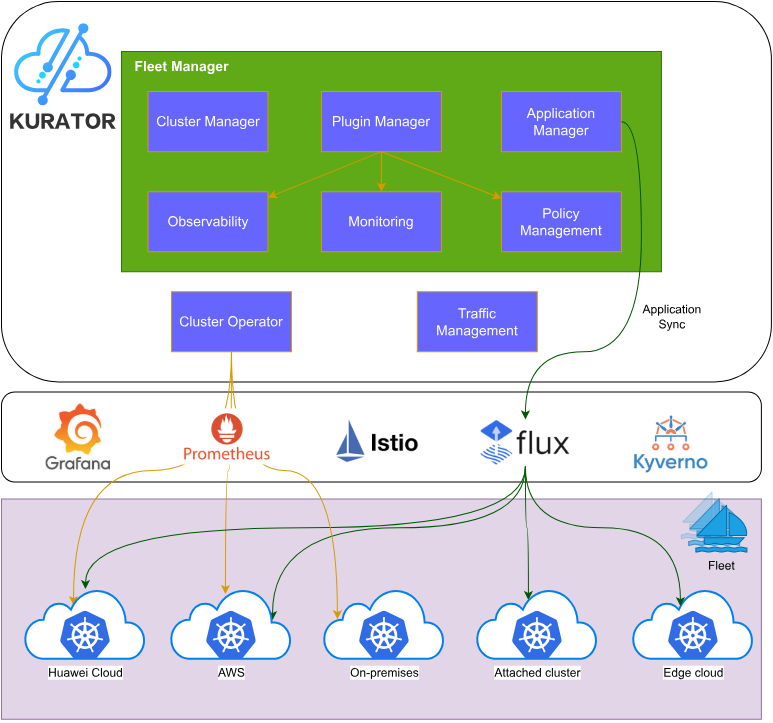

1.1 什么是Kurator

Kurator是一个开源的分布式云原生平台,旨在帮助用户构建自己的分布式云原生基础设施,加速企业数字化转型。它不是从零开始的全新项目,而是站在众多优秀开源项目的肩膀上,包括Kubernetes、Istio、Prometheus、FluxCD、KubeEdge、Volcano、Karmada、Kyverno等,通过深度整合与创新,提供统一的管理体验。

1.2 Kurator的创新价值

传统云原生解决方案往往聚焦于单一集群或单一场景,而Kurator致力于解决分布式环境下的核心痛点:

- 统一管理复杂度:将多云、边缘云、边缘-边缘等多种场景统一纳入管理

- 资源编排一致性:提供跨集群的统一资源调度和编排能力

- 运维体验一致性:统一监控、日志、告警等运维体验

- 开发体验一致性:通过GitOps等模式,提供一致的开发和部署体验

1.3 Kurator与竞品对比

相比其他多集群管理方案,Kurator的独特优势在于其"组合拳"策略:

- 不是简单封装,而是深度整合各组件

- 既提供开箱即用的便捷性,又保留了底层组件的灵活性

- 专注于分布式场景,而非简单多集群管理

- 开源免费,避免厂商锁定

二、环境搭建与快速入门

2.1 基础环境准备

在开始Kurator之旅前,需要准备以下基础环境:

- Kubernetes集群(建议1.20+版本)

- Helm 3.x

- kubectl 1.20+

- 至少16GB内存和4核CPU的机器(用于测试环境)

bash

# 检查基础环境

kubectl version --client --short

helm version --short2.2 Kurator源码获取与安装

首先,我们需要获取Kurator的源代码:

bash

git clone https://github.com/kurator-dev/kurator.git

cd kurator

Kurator提供了多种安装方式,推荐使用Helm Chart安装:

bash

# 添加Kurator Helm仓库

helm repo add kurator https://kurator-dev.github.io/kurator

helm repo update

# 安装Kurator核心组件

helm install kurator kurator/kurator --namespace kurator-system --create-namespace2.3 验证安装结果

安装完成后,验证各组件是否正常运行:

bash

# 检查Kurator核心组件

kubectl get pods -n kurator-system

# 检查CRD是否正确安装

kubectl get crd | grep kurator正常情况下,应该看到kurator-controller-manager、kurator-webhook等核心Pod处于Running状态。

三、Kurator核心架构深度解析

3.1 架构概览

Kurator的架构分为几个关键层次:

- 基础设施层:支持公有云、私有云、边缘节点等多种基础设施

- 集群管理层:基于Karmada实现多集群统一管理

- 应用管理层:通过FluxCD实现GitOps,支持Helm、Kustomize等多种部署方式

- 服务治理层:集成Istio提供统一的服务网格能力

- 调度层:集成Volcano提供高级批处理调度

- 边缘计算层:集成KubeEdge支持边缘场景

- 策略层:通过Kyverno等实现统一策略管理

3.2 组件交互流程

Kurator的核心在于各组件的协同工作。例如,当用户通过GitOps方式更新应用时:

- FluxCD检测到Git仓库变更

- Kurator控制器根据变更内容,通过Karmada API进行跨集群分发

- Volcano调度器根据资源需求和策略进行调度决策

- Istio控制面更新服务网格配置

- Prometheus收集各集群指标,实现统一监控

3.3 关键设计思想

Kurator的设计遵循几个核心原则:

- 声明式API:所有资源都通过声明式API管理,符合云原生设计哲学

- 可组合性:各组件可独立使用,也可组合成完整解决方案

- 可扩展性:通过插件机制支持新功能扩展

- 无状态设计:核心控制器无状态,保证高可用性

四、Fleet舰队管理:统一资源编排的艺术

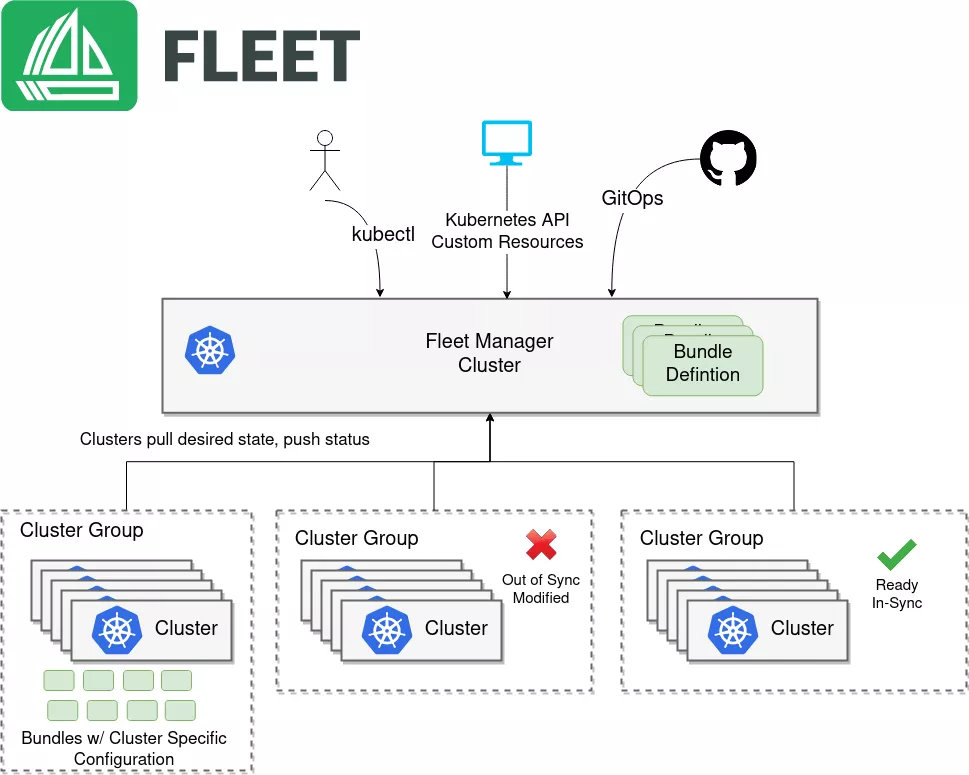

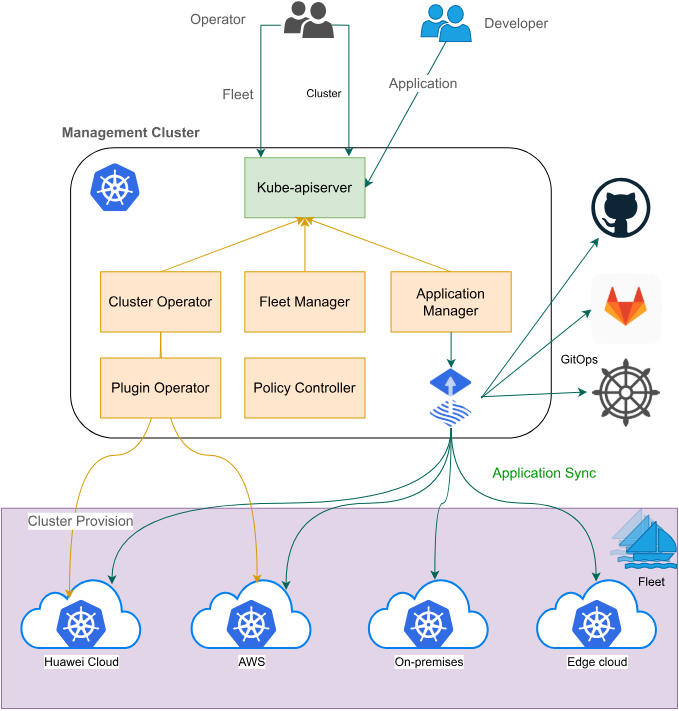

4.1 Fleet概念与架构

Fleet是Kurator的核心抽象,代表一组逻辑上相关的集群。Fleet不仅是一个集合,更是一个管理单元,提供:

- 集群注册与注销

- 应用跨集群同步

- 身份与命名空间一致性

- 服务发现与通信

- 指标聚合

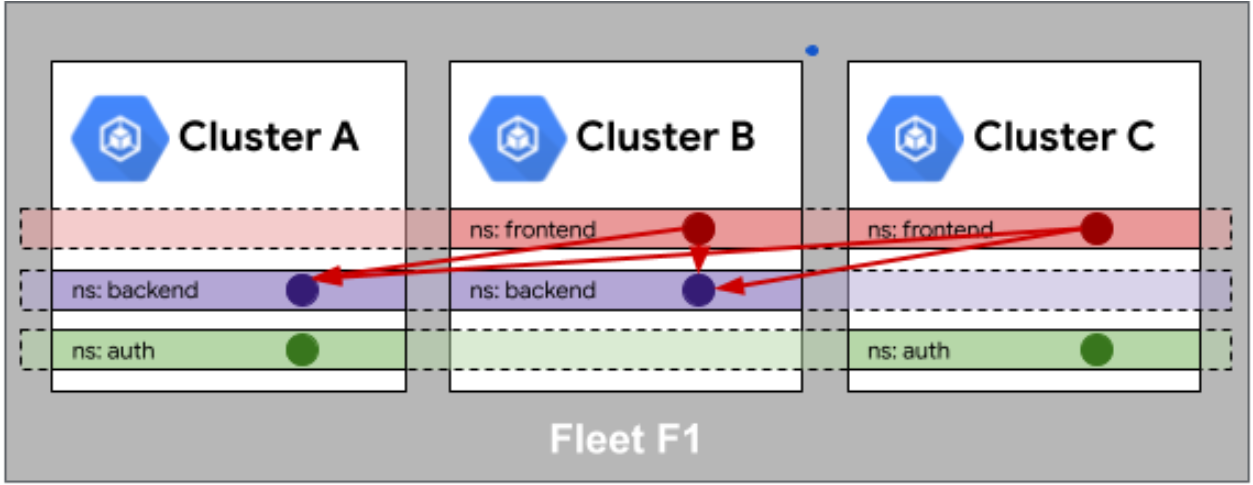

4.2 身份与命名空间相同性

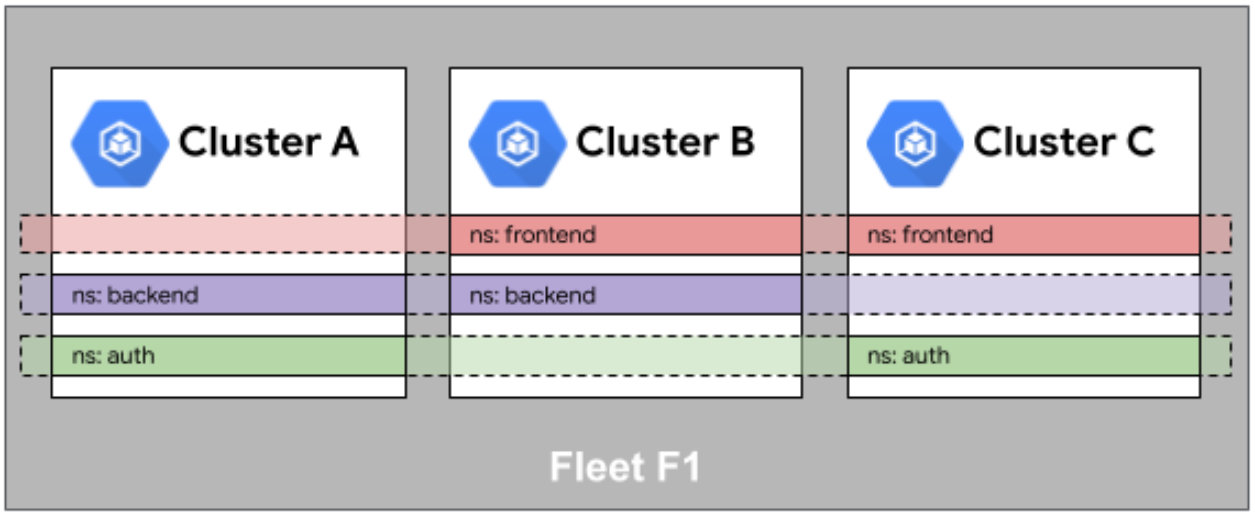

Fleet 队列中的身份相同性如图:

Fleet 舰队中的命名空间相同性如图:

在多集群环境中,保持身份和命名空间的一致性至关重要。Kurator通过Fleet实现:

yaml

apiVersion: fleet.kurator.dev/v1alpha1

kind: Cluster

meta

name: cluster-member1

namespace: kurator-system

spec:

kubeconfigSecretRef:

name: cluster-member1-kubeconfig

---

apiVersion: fleet.kurator.dev/v1alpha1

kind: Fleet

meta

name: production-fleet

namespace: kurator-system

spec:

clusters:

- cluster-member1

- cluster-member2

identityManagement:

serviceAccountPropagation: true

namespacePropagation: true这段配置确保ServiceAccount和命名空间在Fleet中的所有集群保持一致。

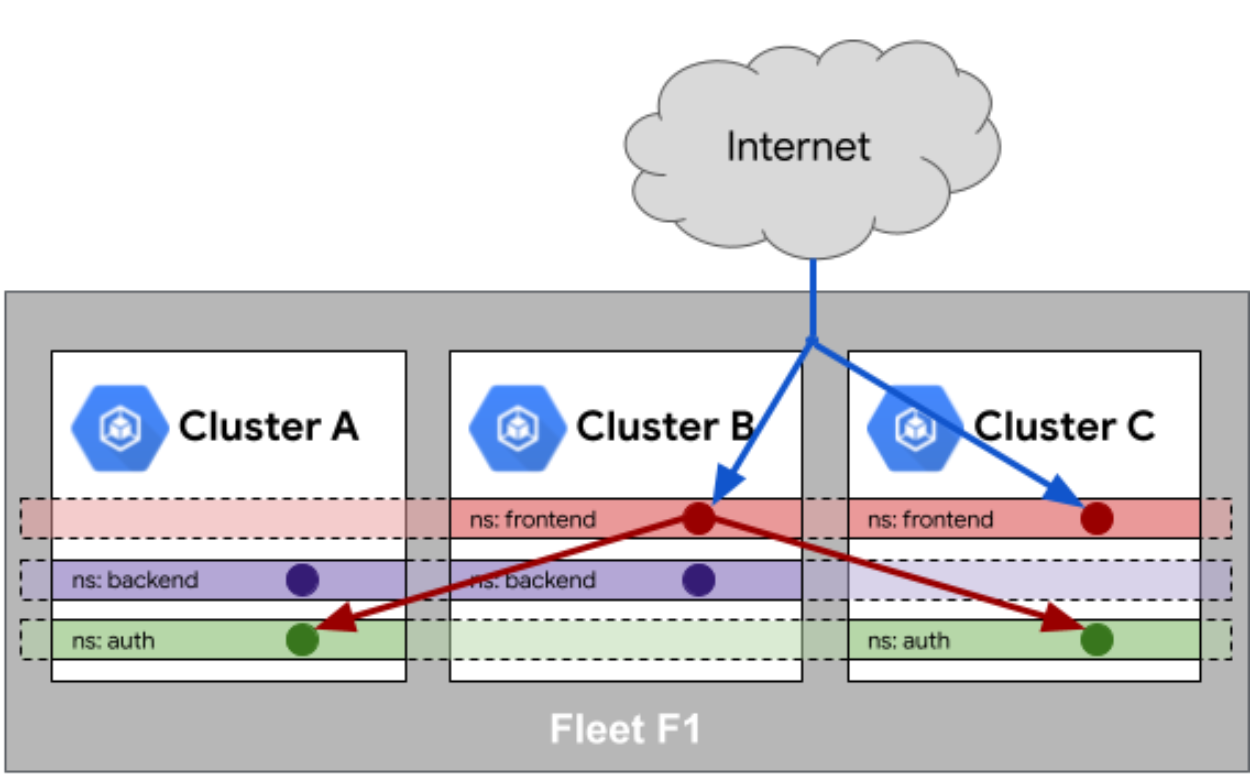

4.3 服务相同性与跨集群通信

Fleet 队列中的服务相同性如图:

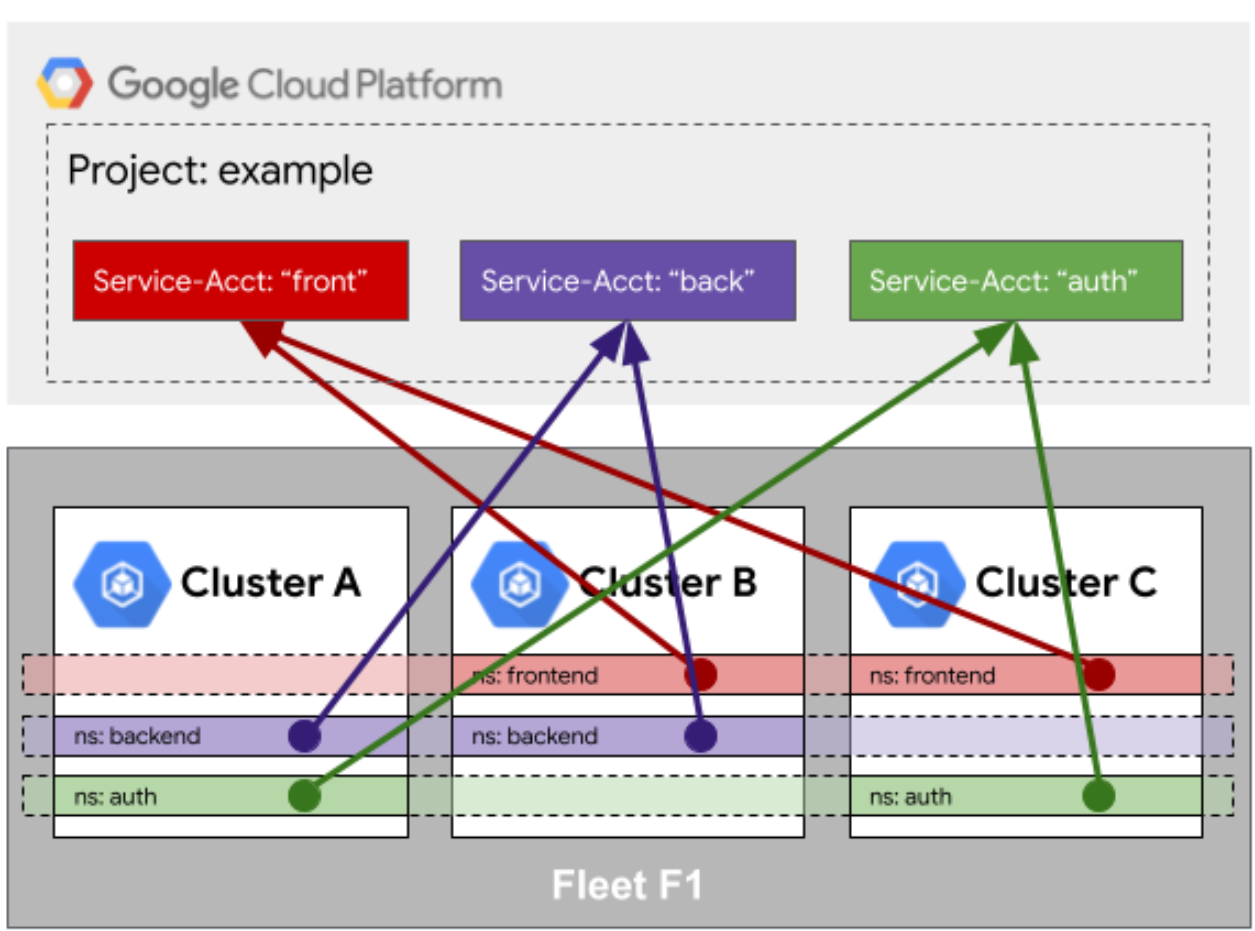

Fleet访问队列外部资源的身份相同性如图:

Fleet还提供服务相同性(Service Sameness)能力,使服务在不同集群中具有相同的身份:

yaml

apiVersion: apps.kurator.dev/v1alpha1

kind: ServiceExport

meta

name: my-service

namespace: default

spec:

selector:

app: my-app通过ServiceExport资源,服务可以被导出到Fleet中的其他集群,实现跨集群服务发现和调用。

4.4 外部资源访问的身份管理

当Fleet中的应用需要访问集群外资源时,Kurator提供统一的身份管理:

yaml

apiVersion: apps.kurator.dev/v1alpha1

kind: ExternalSecret

meta

name: db-credentials

namespace: default

spec:

secretStoreRef:

name: production-secrets

kind: ClusterSecretStore

target:

name: db-creds

data:

- secretKey: username

remoteRef:

key: production/db

property: username这种方式确保不同集群中的应用使用相同的身份访问外部资源,简化了权限管理。

五、GitOps实践:FluxCD与自动化流水线

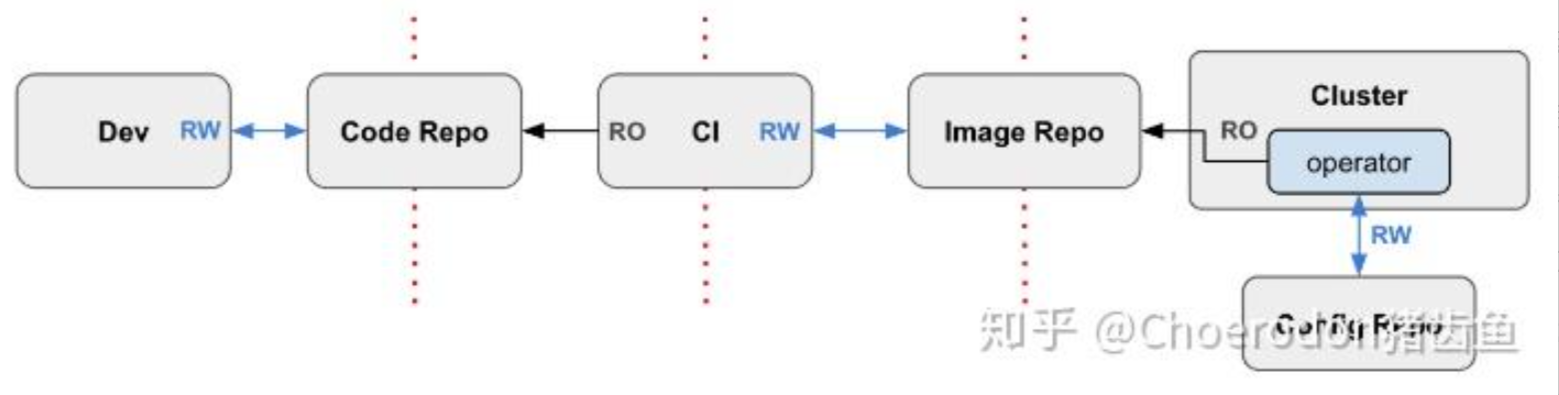

GitOps工作流如图:

5.1 GitOps核心理念

GitOps是一种以Git为唯一可信源的运维模式,Kurator深度集成了FluxCD作为其GitOps引擎。核心理念包括:

- 声明式基础设施

- 版本控制与变更追踪

- 自动同步与修复

- 审计与合规

5.2 FluxCD Helm应用部署示意图

┌─────────────┐ ┌─────────────┐ ┌─────────────┐

│ Git Repo │───▶│ FluxCD │───▶│ Kubernetes │

│ (Declarative│ │ Controller │ │ Clusters │

│ Config) │◀───│ (Source & │◀───│ (Multi-clus)│

└─────────────┘ │ Kustomize)│ └─────────────┘

└─────────────┘

│

▼

┌─────────────┐

│ Helm Charts │

│ & Manifests │

└─────────────┘这个架构展示了FluxCD如何从Git仓库获取配置,并同步到多个Kubernetes集群。

5.3 Kurator CI/CD流水线设计

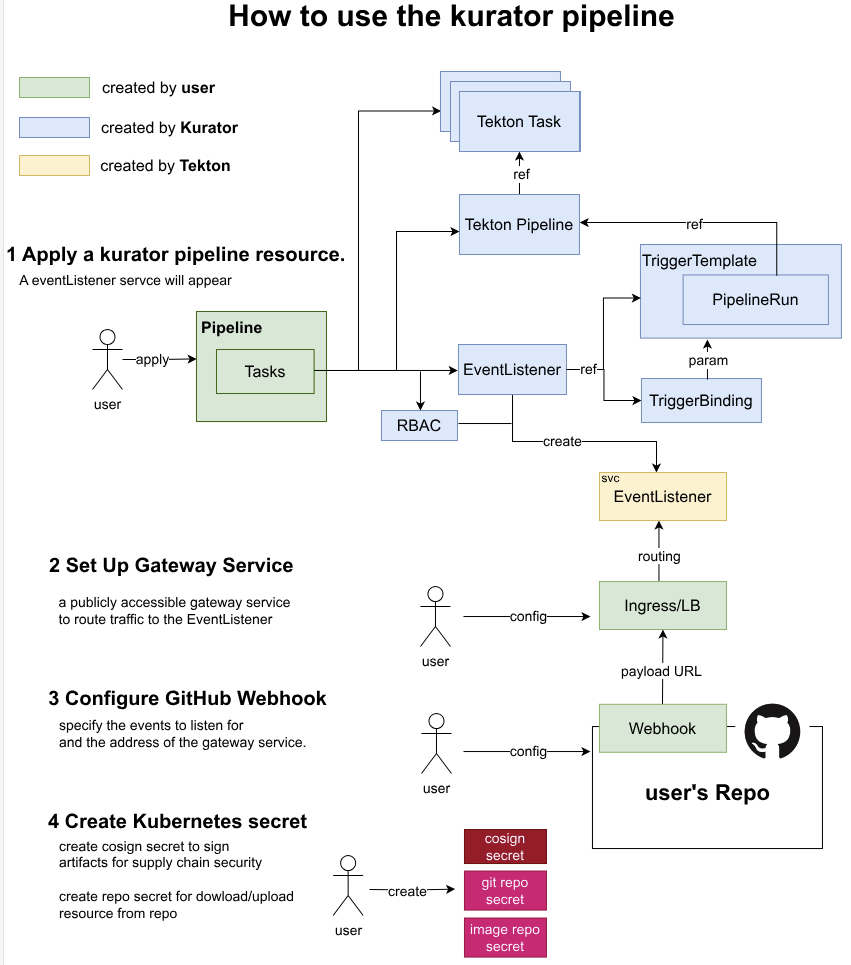

Kurator流水线:

Kurator的流水线通常包含以下阶段:

yaml

# kurator-pipeline.yaml

apiVersion: tekton.dev/v1beta1

kind: Pipeline

metadata:

name: kurator-app-pipeline

spec:

tasks:

- name: git-clone

taskRef:

name: git-clone

- name: build-image

taskRef:

name: build-docker-image

runAfter: [git-clone]

- name: push-image

taskRef:

name: push-docker-image

runAfter: [build-image]

- name: update-gitops

taskRef:

name: update-gitops-repo

runAfter: [push-image]这个流水线展示了从代码到GitOps仓库的完整流程。

5.4 自动化部署与回滚机制

Kurator结合FluxCD和Flagger,提供自动化部署与回滚:

bash

# 触发金丝雀发布

kubectl apply -f canary.yaml

# 监控发布过程

kubectl get canary -w

# 手动批准发布

kubectl patch canary frontend -p '{"spec":{"progress":{"manualConfirmation":true}}}' --type=merge

# 自动回滚(当指标不达标时)

# FluxCD会自动回滚到之前的Git提交这种机制确保了发布的安全性和可靠性。

六、边缘计算与跨集群调度:KubeEdge与Volcano

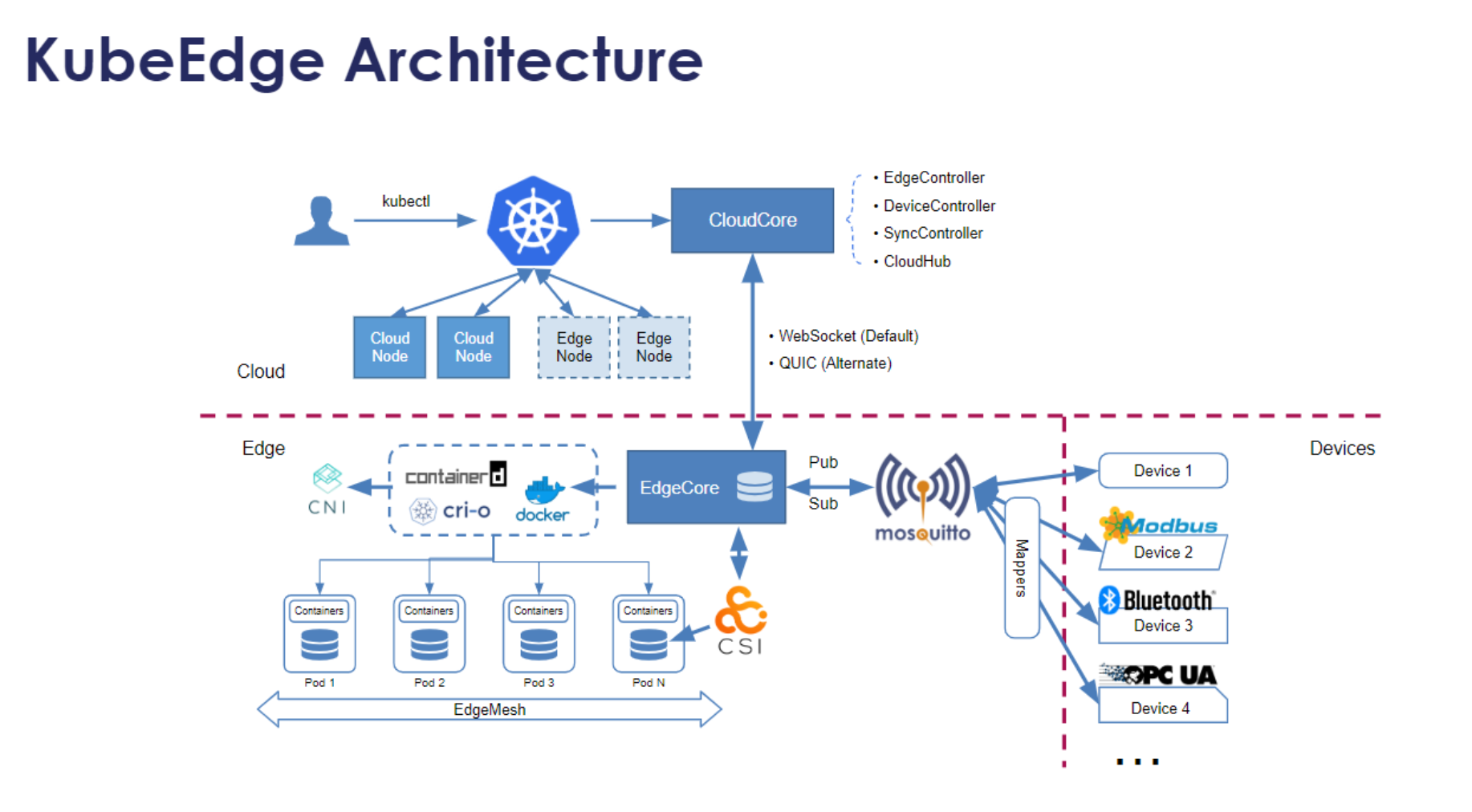

6.1 KubeEdge架构深度解析

KubeEdge是Kurator集成的边缘计算解决方案,其架构包括:

- CloudCore:云侧组件,负责与Kubernetes API Server交互

- EdgeCore:边缘侧组件,负责在边缘节点运行应用

- EdgeMesh:边缘服务网格,提供服务发现和通信

- DeviceTwin:设备孪生,管理边缘设备状态

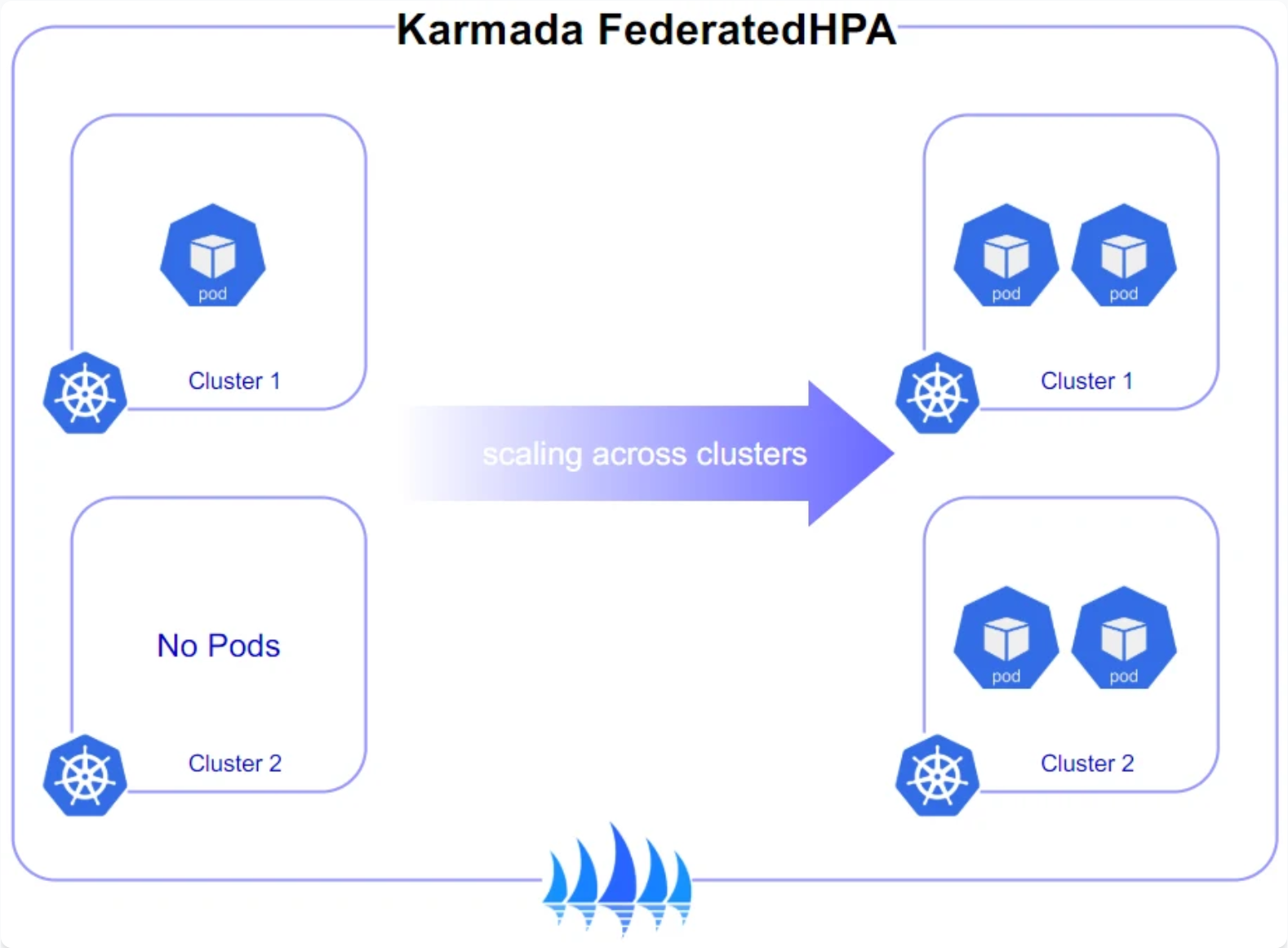

6.2 Karmada跨集群弹性伸缩

Karmada是Kurator的多集群调度核心,提供跨集群弹性伸缩能力:

yaml

apiVersion: autoscaling.karmada.io/v1alpha1

kind: PropagationPolicy

meta

name: frontend-policy

namespace: default

spec:

resourceSelectors:

- apiVersion: apps/v1

kind: Deployment

name: frontend

placement:

clusterAffinity:

clusterNames:

- cluster-east

- cluster-west

replicaScheduling:

replicaDivisionPreference: Weighted

replicaSchedulingType: Divided

weightPreference:

staticWeightList:

- targetCluster:

clusterNames:

- cluster-east

weight: 70

- targetCluster:

clusterNames:

- cluster-west

weight: 30这个策略将前端应用70%的副本部署在东部集群,30%在西部集群,实现地理分布的负载均衡。

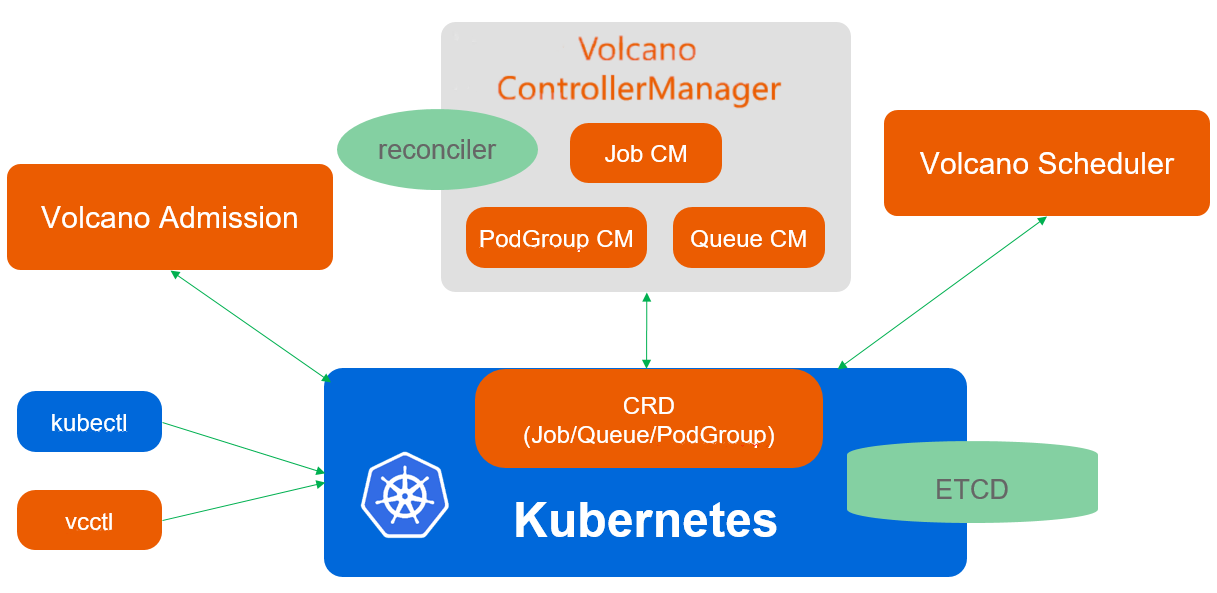

6.3 Volcano调度架构

Volcano是Kurator集成的批处理调度器,特别适合AI/ML、大数据等场景。核心概念包括:

- Queue:资源队列,用于资源隔离和配额管理

- PodGroup:一组需要协同调度的Pod

- VolcanoJob:批处理作业的抽象

yaml

apiVersion: scheduling.volcano.sh/v1beta1

kind: Queue

meta

name: high-priority

spec:

weight: 10

capability:

cpu: 100

memory: 500Gi

---

apiVersion: batch.volcano.sh/v1alpha1

kind: Job

meta

name: tensorflow-training

spec:

minAvailable: 8

schedulerName: volcano

tasks:

- replicas: 4

name: ps

template:

spec:

containers:

- image: tensorflow/tensorflow:2.5.0-gpu

name: tensorflow

resources:

limits:

nvidia.com/gpu: 1

- replicas: 4

name: worker

template:

spec:

containers:

- image: tensorflow/tensorflow:2.5.0-gpu

name: tensorflow

resources:

limits:

nvidia.com/gpu: 1这个例子展示了如何在Volcano中定义一个TensorFlow训练作业,包含参数服务器和工作节点。

6.4 边缘-云协同调度策略

Kurator支持边缘-云协同调度,例如将推理任务调度到边缘,训练任务调度到云端:

yaml

apiVersion: apps.kurator.dev/v1alpha1

kind: Placement

meta

name: ai-workload-placement

namespace: default

spec:

clusterSelector:

labelSelector:

matchLabels:

kurator.dev/location: edge

resourceSelector:

apiVersion: batch.volcano.sh/v1alpha1

kind: Job

name: inference-job

policy:

type: Spread

spreadConstraints:

- maxGroups: 10

topologyKey: kubernetes.io/hostname这种策略确保推理作业被分散到多个边缘节点,提高可用性和性能。

七、Kurator未来展望与技术演进

7.1 当前挑战与机遇

尽管Kurator已经取得了显著进展,但仍面临一些挑战:

- 复杂性管理:随着功能增加,系统复杂度上升

- 性能优化:大规模集群下的性能和延迟问题

- 安全增强:零信任架构与精细权限控制

- 生态整合:与更多开源项目的深度集成

这些挑战也带来了机遇,特别是在边缘计算、AI工程化、Serverless等领域。

7.2 技术演进路线

Kurator的技术演进将聚焦以下几个方向:

- 智能化调度:结合AI/ML实现更智能的资源调度和预测

- 多租户增强:提供更精细的多租户隔离和计费能力

- Serverless集成:无缝集成Knative等Serverless框架

- Wasm扩展:通过WebAssembly扩展插件能力

7.3 社区建设与开源生态

Kurator的成功离不开活跃的社区。未来将加强:

- 开发者体验:简化贡献流程,完善文档

- 用户社区:建立用户组,分享最佳实践

- 合作伙伴:与云厂商、ISV建立深度合作

- 标准化:推动相关标准的制定,如多集群API、边缘计算规范等

7.4 分布式云原生的未来思考

作为云原生从业者,我对分布式云原生的未来有以下思考:

- 统一抽象:需要更高层次的抽象,屏蔽底层基础设施差异

- 数据流动:数据与计算的协同调度将成为关键

- 绿色计算:能效优化将成重要考量因素

- 人机协作:AI辅助运维将改变运维模式

Kurator作为分布式云原生的先锋,将在这些领域持续探索,推动整个行业向前发展。

结语

Kurator代表了云原生技术的新方向------分布式、多场景、统一管理。通过本文的深入探讨,我们看到了Kurator如何整合优秀开源项目,为用户提供强大的分布式云原生能力。从环境搭建到高级特性,从理论到实践,Kurator展现出巨大的潜力和价值。

作为云原生从业者,我们应当拥抱这种变化,积极参与到Kurator等开源项目的建设中,共同推动分布式云原生技术的发展。未来已来,让我们携手共建云原生新生态!