核心场景与技术挑战

业务场景

基础流量:20万QPS的稳定业务流量

峰值预期:具备平滑扩展至100万QPS的能力

数据特性:存在热点数据风险,可能出现单一Key承载10万+QPS的情况

可用性要求:99.99%的可用性,数据强一致性要求

技术挑战

单点瓶颈:传统Redis集群可能因热Key导致单实例过载

扩展限制:线性扩展能力在热Key场景下失效

延迟敏感:跨网络访问的延迟成为性能瓶颈

数据一致:多级缓存架构下的数据一致性保障

常规解决方案分析

基础架构设计

┌─────────────────────────────────────────────────────┐

│ 应用集群 (N个节点) │

├─────────────────────────────────────────────────────┤

│ 负载均衡层 │ 本地缓存层 │ 业务逻辑层 │ 数据访问层 │

└─────────────────────────┬───────────────────────────┘

│ HTTP/GRPC

┌─────────────────────────▼───────────────────────────┐

│ Redis分布式集群 │

│ 6主6从架构 (可扩展) │

│ ├─────────────┬─────────────┤ │

│ 主1(3w QPS) 主2(3w QPS) ... │

│ 从1(备份) 从2(备份) ... │

└─────────────────────────────────────────────────────┘方案优势

容量扩展:通过增加Redis节点线性扩展存储容量

读写分离:主节点承担读写,从节点保障高可用

数据共享:应用层无状态,缓存数据全局共享

故障转移:主从切换机制保障服务连续性

方案局限性

热Key问题分析:

假设:Redis集群有6个主节点,每个节点设计容量3万QPS

正常场景:20万QPS均匀分布 → 每个节点约3.3万QPS(可接受)

热Key场景:某个Key突然承载10万QPS

问题出现:该Key通过哈希分片固定到某个Redis节点

→ 单个节点承载13.3万QPS

→ 远超设计容量3万QPS

→ CPU 100%,响应延迟飙升,服务雪崩热Key问题深度解决方案

多级缓存架构设计

整体架构

┌─────────────────────────────────────────────────────────┐

│ 应用层 (N个实例) │

│ ┌────────────┐ ┌────────────┐ ┌────────────┐ │

│ │ 实例1 │ │ 实例2 │ │ 实例N │ │

│ │ ┌────────┐ │ │ ┌────────┐ │ │ ┌────────┐ │ │

│ │ │本地缓存│ │ │ │本地缓存│ │ │ │本地缓存│ │ │

│ │ │Caffeine│ │ │ │Caffeine│ │ │ │Caffeine│ │ │

│ │ └────────┘ │ │ └────────┘ │ │ └────────┘ │ │

│ └────────────┘ └────────────┘ └────────────┘ │

└───────────────────────────┬─────────────────────────────┘

│ 缓存未命中

┌───────────────────────────▼─────────────────────────────┐

│ 分布式缓存层 (Redis集群) │

│ ┌──────────────┐ │

│ │ 热Key检测 │ │

│ │ 与分发系统 │ │

│ └──────┬───────┘ │

│ ┌────────────┼────────────┐ │

│ ▼ ▼ ▼ │

│ Redis主1 Redis主2 Redis主N │

│ Redis从1 Redis从2 Redis从N │

└─────────────────────────────────────────────────────────┘本地缓存优势分析

| 对比维度 | 本地缓存 (Caffeine/Guava) | 远程缓存 (Redis) |

|---|---|---|

| 延迟 | 纳秒级 (10-100ns) | 毫秒级 (0.5-2ms) |

| 吞吐 | 百万级OPS | 万级QPS |

| 网络 | 无网络开销 | RTT延迟+序列化开销 |

| 单点压力 | 分散到应用实例 | 集中到缓存服务器 |

| 成本 | 利用已有内存 | 需要独立集群资源 |

热Key检测与处理机制

实时热Key探测

public class HotKeyDetector {

// 滑动窗口统计

private final ConcurrentHashMap<String, AtomicLong> keyCounter;

private final ScheduledExecutorService scheduler;

public HotKeyDetector() {

this.keyCounter = new ConcurrentHashMap<>();

this.scheduler = Executors.newSingleThreadScheduledExecutor();

// 每10秒统计一次热Key

scheduler.scheduleAtFixedRate(this::detectHotKeys, 10, 10, TimeUnit.SECONDS);

}

public void recordAccess(String key) {

keyCounter.computeIfAbsent(key, k -> new AtomicLong(0)).incrementAndGet();

}

private void detectHotKeys() {

long threshold = 10000; // 10秒内访问超过1万次

keyCounter.forEach((key, count) -> {

if (count.get() > threshold) {

notifyHotKey(key, count.get());

count.set(0); // 重置计数器

}

});

}

private void notifyHotKey(String key, long count) {

// 1. 通知所有应用实例预热该Key到本地缓存

// 2. 在Redis端标记为热Key,启用特殊处理策略

// 3. 记录监控告警

}

}热Key缓存复制策略

public class HotKeyReplicationStrategy {

// 热Key多副本存储

public String generateReplicaKey(String originalKey, int replicaId) {

return originalKey + "_replica_" + replicaId;

}

// 请求分发算法

public String getRoutingKey(String originalKey) {

if (isHotKey(originalKey)) {

// 热Key采用轮询或一致性哈希分发到不同副本

int replicaCount = getReplicaCount(originalKey);

int hash = originalKey.hashCode() & Integer.MAX_VALUE;

int replicaId = hash % replicaCount;

return generateReplicaKey(originalKey, replicaId);

}

return originalKey;

}

}多级缓存一致性保障

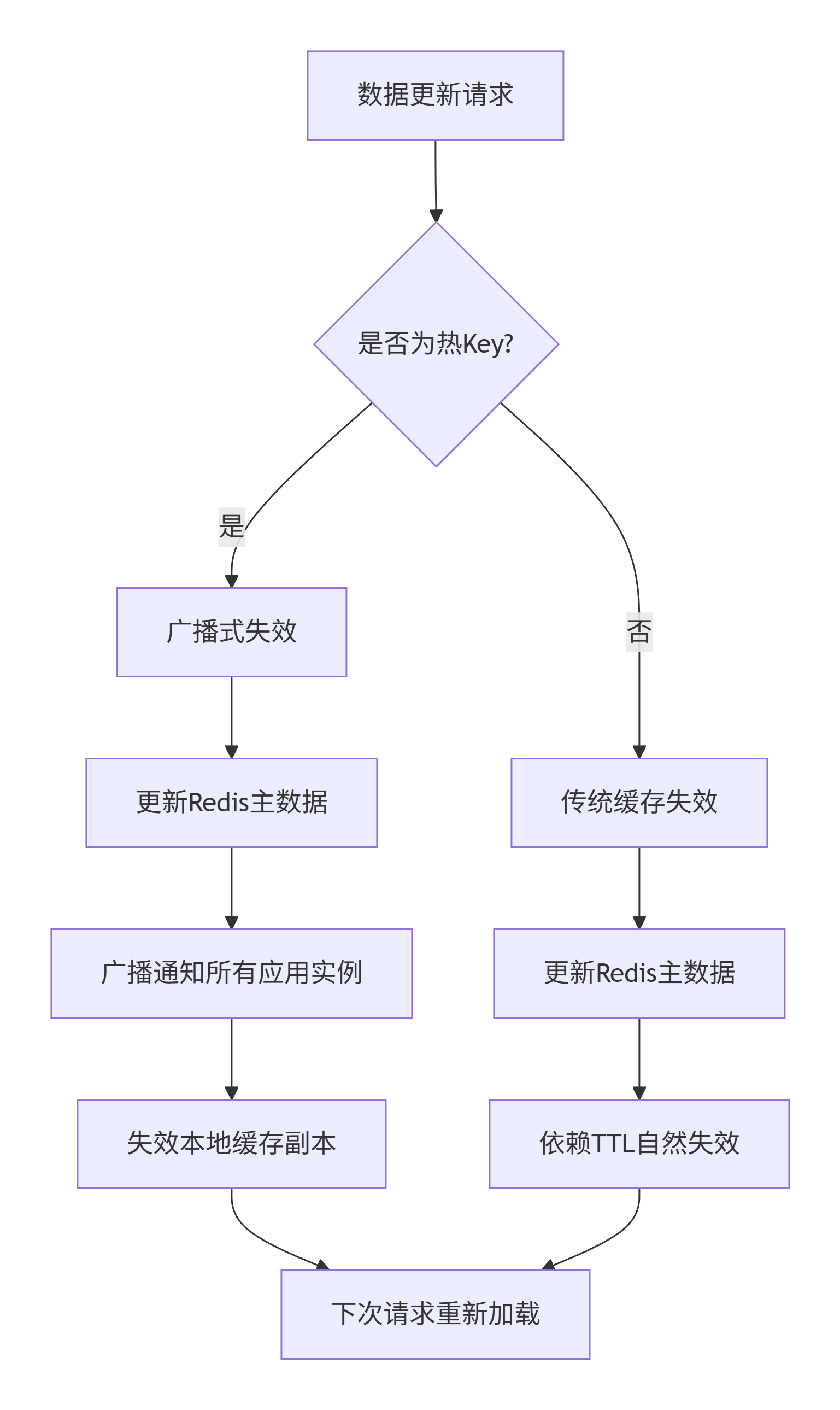

缓存更新策略

本地缓存配置策略

# 本地缓存配置示例

caffeine:

# 热Key专用缓存

hot-key-cache:

maximum-size: 1000

expire-after-write: 30s

refresh-after-write: 10s

record-stats: true

# 普通数据缓存

normal-cache:

maximum-size: 10000

expire-after-write: 5m

record-stats: true

# 只读数据缓存

read-only-cache:

maximum-size: 5000

expire-after-write: 1h

record-stats: true完整技术方案架构

┌─────────────────────────────────────────────────────────┐

│ 接入层 │

│ ┌────────────────────┐ │

│ │ 四层/七层负载均衡 │ │

│ │ (Nginx/LVS) │ │

│ └─────────┬──────────┘ │

└───────────────────────┬───────────────────────────────┘

│ 流量分发

┌───────────────────────▼───────────────────────────────┐

│ 应用服务层 │

│ ┌─────────────┬─────────────┬─────────────┐ │

│ │ 服务实例1 │ 服务实例2 │ 服务实例N │ │

│ │┌──────────┐ │┌──────────┐ │┌──────────┐│ │

│ ││ 本地缓存 │ ││ 本地缓存 │ ││ 本地缓存 ││ │

│ ││ L1 Cache │ ││ L1 Cache │ ││ L1 Cache ││ │

│ │└──────────┘ │└──────────┘ │└──────────┘│ │

│ │┌──────────┐ │┌──────────┐ │┌──────────┐│ │

│ ││ 业务逻辑 │ ││ 业务逻辑 │ ││ 业务逻辑 ││ │

│ │└──────────┘ │└──────────┘ │└──────────┘│ │

│ └─────────────┴─────────────┴─────────────┘ │

└───────────────────────┬───────────────────────────────┘

│ 缓存未命中/数据更新

┌───────────────────────▼───────────────────────────────┐

│ 缓存服务层 │

│ ┌─────────────────────────────────────┐ │

│ │ Redis Proxy集群 │ │

│ │ (Codis/Twemproxy/自研代理) │ │

│ └──────────────────┬──────────────────┘ │

│ ┌─────────────┼─────────────┐ │

│ ▼ ▼ ▼ │

│ Redis集群1 Redis集群2 Redis集群N │

│ (6主6从) (6主6从) (按业务隔离) │

└─────────────────────────────────────────────────────┘演进思路

1、增加发布Redis Pub/Sub消息(缓存失效/更新通知):本地应用集群作为消息订阅者,接受消息后,删除本地缓存,C端流量请求打过来的时候,如果本地缓存不存在,则将r2m中缓存加载到本地缓存。

2、定时任务是防止极端情况下,缓存失效,将数据重新加载到缓存。

架构图调整

┌─────────────────────────────────────────────────────────────────────────┐

│ 运营管理后台 │

│ ┌─────────────────────────────────────────────────────┐ │

│ │ 数据更新操作 → 写入Redis集群 → 发布缓存变更消息 │ │

│ └─────────────────────────────┬───────────────────────┘ │

└───────────────────────────────────┼─────────────────────────────────────┘

│ 发布消息

┌───────────────────────────────────▼─────────────────────────────────────┐

│ Redis Pub/Sub 消息系统 │

│ ┌─────────────────────────┐ │

│ │ 缓存更新消息通道 │ │

│ └─────────────┬───────────┘ │

└─────────────────────────────────────┼───────────────────────────────────┘

┌─────────────┼─────────────┐

│ │ │

┌─────▼─────┐ ┌─────▼─────┐ ┌─────▼─────┐

│ 应用实例1 │ │ 应用实例2 │ │ 应用实例N │

│ ┌───────┐ │ │ ┌───────┐ │ │ ┌───────┐ │

│ │消息订阅│ │ │ │消息订阅│ │ │ │消息订阅│ │

│ │处理器 │ │ │ │处理器 │ │ │ │处理器 │ │

│ └───┬───┘ │ │ └───┬───┘ │ │ └───┬───┘ │

│ │ │ │ │ │ │ │ │

│ ┌───▼───┐ │ │ ┌───▼───┐ │ │ ┌───▼───┐ │

│ │本地缓存│ │ │ │本地缓存│ │ │ │本地缓存│ │

│ │Caffeine│ │ │ │Caffeine│ │ │ │Caffeine│ │

│ └───┬───┘ │ │ └───┬───┘ │ │ └───┬───┘ │

└─────┼─────┘ └─────┼─────┘ └─────┼─────┘

│ │ │

└─────────────┼─────────────┘

│ 缓存未命中/数据同步

┌─────────────────────────────────────▼───────────────────────────────────┐

│ Redis集群层(6主6从) │

│ ┌─────────────────────────────────────┐ │

│ │ 定时补偿机制 │ │

│ │ 检测Redis缓存有效性 │ │

│ │ 重新加载失效数据 │ │

│ └─────────────┬──────────────────────┘ │

│ ┌─────────────┐ │ ┌─────────────┐ ┌─────────────┐ │

│ │ 主节点1 │ │ │ 主节点2 │ │ 主节点N │ │

│ │ (热Key副本) │ │ │ (热Key副本)│ │ (热Key副本)│ │

│ │ 从节点1 │ │ │ 从节点2 │ │ 从节点N │ │

│ └─────────────┘ │ └─────────────┘ └─────────────┘ │

└──────────────────────────────┼─────────────────────────────────────────┘

│ 极端情况:Redis缓存失效

┌──────────────────────────────▼─────────────────────────────────────────┐

│ 数据源层 │

│ ┌─────────────────────┐ │

│ │ 数据库/持久化存储 │ │

│ └─────────────────────┘ │

└───────────────────────────────────────────────────────────────────────┘核心工作机制

数据更新流程(运营后台触发)

数据写入:运营后台 → 写入数据库 → 同步写入Redis集群

消息发布:运营后台 → 发布Redis Pub/Sub消息(缓存失效/更新通知)

实时同步:所有应用实例订阅消息 → 收到消息后失效本地缓存

请求响应:C端请求到达 → 本地缓存未命中 → 从Redis集群加载 → 更新本地缓存

定时补偿机制

定期扫描:定时任务周期性检查Redis中关键数据的有效性

失效检测:发现Redis中数据缺失或即将过期

自动修复:从数据库重新加载数据到Redis集群

广播通知:发布消息通知所有应用实例更新本地缓存

热Key处理策略

多副本存储:热Key在Redis集群中存储多个副本

请求分发:通过Key后缀或路由算法将请求分散到不同副本

本地缓存:热Key优先缓存在本地,减少Redis访问压力

Redis发布订阅模式

核心特点(推模式 )

- 推模式本质

主动推送:消息发布后立即推送给所有订阅者

实时性强:消息到达即推送,无等待间隔

被动接收:订阅者无需主动查询,等待消息到达即可

- 异步特性

非阻塞:客户端不会阻塞等待消息

高并发:服务端可以同时处理大量推送请求

资源高效:仅在消息到达时消耗资源# 两版方案对比分析

热Key场景

传统方案问题:

- 轮询模式:每个实例都需要查询Redis,加剧单点压力

- 查询风暴:10万QPS集中到单个Redis节点,CPU打满

- 延迟扩散:实例轮询时间不一致,数据更新不同步

Pub/Sub方案优势:

- 单次发布:运营更新只需发布一次消息

- 批量推送:Redis同时推送给所有应用实例(100个实例)

- 压力分散:实例收到消息后更新本地缓存,后续请求直接命中本地

- 实时同步:所有实例几乎同时失效本地缓存,避免数据不一致方案对比

| 对比维度 | 第一版方案(基础版) | 第二版方案(增强版) | 优势分析 |

|---|---|---|---|

| 数据一致性 | 依赖TTL自然失效,存在延迟 | Pub/Sub实时通知 + 定时补偿,秒级一致性 | 大幅提升数据实时性 |

| 运营支持 | 需要重启或等待缓存过期 | 后台直接更新,实时生效 | 提升运营效率,支持快速变更 |

| 故障恢复 | 依赖Redis主从切换 | 定时补偿 + 多级容错 | 更强的系统自愈能力 |

| 热Key处理 | 仅依赖本地缓存分散 | 本地缓存 + Redis多副本 + 智能路由 | 更完善的热点防护体系 |

| 监控能力 | 基础性能监控 | 全链路监控 + 消息追踪 + 一致性检查 | 更全面的可观测性 |

| 复杂度 | 较低,易于实施 | 中等,需要维护消息系统 | 功能更完整,但实施成本略高 |

| 适用场景 | 数据变更不频繁,对一致性要求不高 | 数据频繁变更,要求强一致性 | 满足更严格的业务需求 |

性能对比

延迟对比

读取延迟对比:

- 第一版:本地缓存命中(0.1ms) / Redis访问(1-2ms) / 数据库访问(10-50ms)

- 第二版:本地缓存命中(0.1ms) / Redis访问(1-2ms,热Key访问减少)

写入/更新延迟对比:

- 第一版:写入Redis(1-2ms) + 等待TTL过期(分钟级)

- 第二版:写入Redis(1-2ms) + 发布消息(0.5ms) + 广播失效(10-100ms)可靠性对比

数据一致性保障

第一版方案:

- 一致性策略:最终一致性(依赖TTL)

- 同步延迟:分钟级到小时级

- 风险点:运营变更无法及时生效,可能影响业务

第二版方案:

- 一致性策略:准实时一致性(秒级)

- 同步机制:消息广播 + 主动失效

- 额外保障:定时补偿 + 版本检查部署与维护

第一版方案:

- 组件:应用集群 + Redis集群

- 配置:相对简单,主要是Redis和本地缓存配置

- 监控:基础指标监控(QPS、命中率、延迟)

第二版方案:

- 组件:应用集群 + Redis集群 + 消息系统 + 定时任务

- 配置:较复杂,需要协调多个组件

- 监控:全链路监控(消息、缓存、一致性、任务执行)20万QPS容量规划

应用层规划:

- 服务实例数量:50个 (按4核心8G配置)

- 单个实例能力:4,000 QPS (本地缓存命中后)

- 总处理能力:200,000 QPS

缓存层规划:

- Redis主节点:10个 (考虑到热Key复制)

- 单个主节点容量:20,000 QPS (预留Buffer)

- 热Key副本数:3-5个 (根据热度动态调整)

- 内存容量:主数据200GB + 副本400GB

网络规划:

- 内网带宽:10Gbps

- 连接数限制:每实例最大5000连接方案优势与风险控制

核心优势

热Key免疫:本地缓存天然分散热Key压力

超低延迟:内存级访问延迟,提升用户体验

弹性扩展:多层次扩展能力,应对流量波动

成本优化:减少Redis集群规模,降低运维成本

高可用性:多级容错,单点故障不影响整体

风险与应对措施

数据一致性风险

风险:本地缓存与Redis数据不一致

应对:

业务能接受短暂数据的不一致,更适用于读场景业务层容忍内存溢出风险

风险:本地缓存占用过多JVM内存

故不能进行大数据量存储,需要进行缓存大小评估。

应对:

1. 严格控制本地缓存大小 (按实例内存比例)

2. 实施LRU/LFU淘汰策略

3. 监控JVM内存使用率,设置阈值告警

4. 关键数据压缩存储冷启动压力

风险:服务重启后大量请求穿透到Redis

应对:

1. 实现缓存预热机制

2. 分批启动应用实例

3. 启动初期降低本地缓存TTL

4. 使用灰度流量逐步验证