0. 引言:人形机器人正在走出实验室

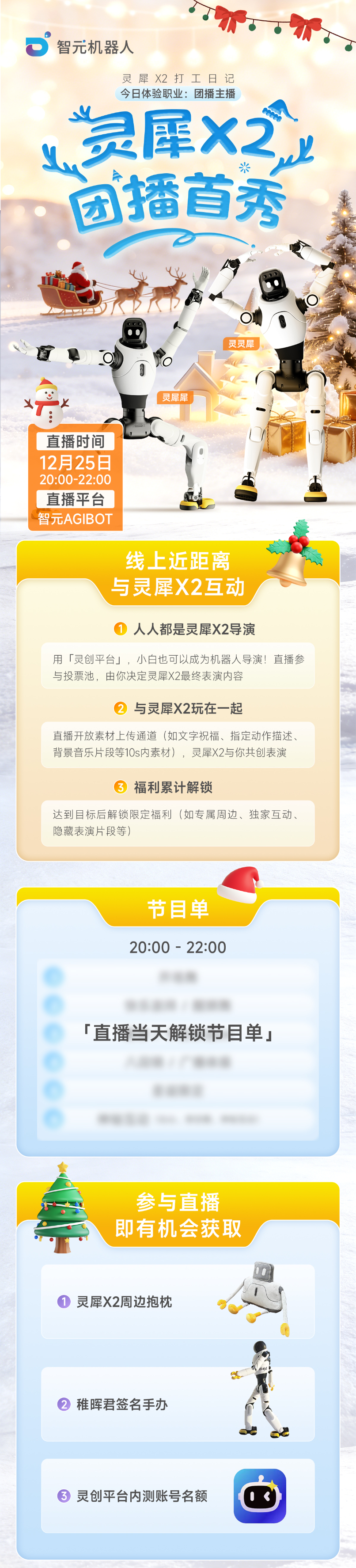

2025年蛇年央视春晚,一群人形机器人在舞台上整齐划一地表演东北秧歌,完成转手绢、抛接等高难度动作。这场由宇树科技Unitree H1机器人完成的表演,标志着人类历史上首次大型全AI驱动的全自动集群人形机器人表演的成功实现。从2024年到2025年,人形机器人正以前所未有的速度从实验室走向公众视野,从工业场景延伸至文娱表演、科研教育、情感陪伴等多元领域。

然而,一个核心问题始终困扰着这个行业:普通人如何让机器人按照自己的想法动起来?传统的机器人动作开发需要专业的编程能力、控制理论知识和动作设计背景,这道技术门槛将绝大多数创作者拒之门外。如何降低这道门槛,让机器人内容创作真正大众化,成为具身智能商业化落地的关键命题。

资料申请链接在这里> https://agirobot.feishu.cn/share/base/form/shrcnQMfq0vDEYIDWwX8eKtW01D

灵创的使用手册> https://agirobot.feishu.cn/wiki/IOAdwbPc3i0o8YkLOz0c2sgTn63

1. 技术背景:动作捕捉与AI如何让机器人"学会"动作

1.1 从遥控到自主:机器人动作生成的技术演进

早期的机器人动作控制主要依赖两种方式:一是工程师逐帧编写动作指令,精确控制每个关节的角度和时序;二是通过遥控器实时操控机器人完成动作。前者开发周期长、成本高,后者则难以实现复杂连贯的动作序列。随着计算机视觉和深度学习技术的成熟,基于动作捕捉的模仿学习方法逐渐成为主流。

动作捕捉技术的核心原理是将人体运动数据转化为计算机可处理的格式。目前主流的技术路线包括惯性动作捕捉(如Xsens、诺亦腾)和视觉方案(如基于RGB摄像头的姿态估计)。特斯拉、智元机器人、小鹏鹏行等头部企业均采用惯性动作捕捉作为首选方案,其优势在于数据采集不受遮挡影响,环境适应性强。

斯坦福大学ALOHA团队开发的HumanPlus系统则展示了视觉方案的潜力:仅使用单个RGB摄像头即可实时将人类运动映射到人形机器人,通过40个左右的演示样本,机器人就能以60%-100%的成功率自主完成穿鞋站立、折叠衣物等任务。这种"少样本学习"能力大大降低了数据采集的成本。

1.2 从模仿到创造:AI算法的关键突破

2024年以来,人形机器人技术实现了从"模仿动作"向"创造动作"的跨越。以春晚表演为例,宇树机器人通过AI强化学习技术,将舞蹈演员的动作捕捉数据转化为程序指令,实现19个关节的精准协调和复杂动作的流畅衔接。优必选科技的熊猫机器人更进一步,通过"任意动作任意学"的算法升级获得了自主编舞能力,既能快速模仿人类舞者的复杂动作,还能通过AI与真人精准同步。

这些技术突破的背后是三个核心能力的提升:一是姿态估计算法的精度提升,能够从视频中准确提取人体骨骼关键点;二是运动重定向技术的成熟,能够将人体动作映射到不同构型的机器人身上;三是强化学习算法的进步,使机器人能够在仿真环境中学习并优化动作执行策略。

2. 灵犀X2:理解内容创作平台的硬件基础

2.1 产品定位与技术规格

2025年3月,智元机器人发布了灵犀X2人形机器人,这款身高约1.3米、体重33.8公斤的机器人被定位为"硅基少年"。与工业场景下的人形机器人不同,灵犀X2的设计目标是成为一款"充满亲和力、灵动有生命"的全智能机器人,主要面向文娱表演、展厅讲解、科研教育、情感陪伴等场景。

从技术规格来看,灵犀X2全身配备28个自由度,小脑控制器、域控制器、智能电源管理系统、核心关节模组均为自研。在机械结构上,该机器人未采用任何并联结构,这使得动作表现更加灵活多样,能够完成跳舞、奔跑、踩滑板车、骑自行车等高难度动作。

值得关注的是灵犀X2的软件架构:它搭载了基于Diffusion的生成式动作引擎和定制的多模态交互大模型,具备毫秒级交互反应能力。ENFP的人格设定(外向、直觉、情感、感知)使其在情感表达上更加自然。这些软硬件能力的结合,为后续的内容创作平台奠定了基础。

2.2 产品版本与市场定位

灵犀X2目前提供三个版本:X2交互版、X2 Pro探索版和X2 Ultra旗舰版,整机标配25-31个自由度。智元机器人预计明年底灵犀X2交付量有望接近万台。这一商业化目标的实现,不仅需要硬件的规模化生产能力,更需要一个能够快速产出内容的创作工具链来支撑。

3. 灵创平台:零门槛机器人内容创作的技术实现

3.1 平台定位与核心理念

2025年10月24日程序员节,智元机器人正式推出灵创平台(LinkCraft),这是全球首个面向大众创作者的零代码机器人内容创作平台。平台的核心理念可以概括为三点:降低门槛、兼容多形态硬件、AI与艺术融合。

传统的机器人动作开发流程涉及设计、控制、同步、调试等多个复杂环节,通常需要专业团队耗费数周甚至数月才能完成一套完整的表演方案。灵创平台通过将这些流程抽象化、可视化,使用户无需编程能力即可在几分钟内完成一套机器人表演脚本的创作。

智元机器人联合创始人兼CTO彭志辉在发布会上表示:"机器人正从实验室走向生活和产业,但交互表达仍是瓶颈。灵创平台的愿景是让机器人像人一样自然表达,让创作者像导演一样自由编排。"

3.2 五大核心功能模块解析

灵创平台围绕"机器人内容创作与演绎"目标,构建了五个可独立使用也可组合的功能模块:

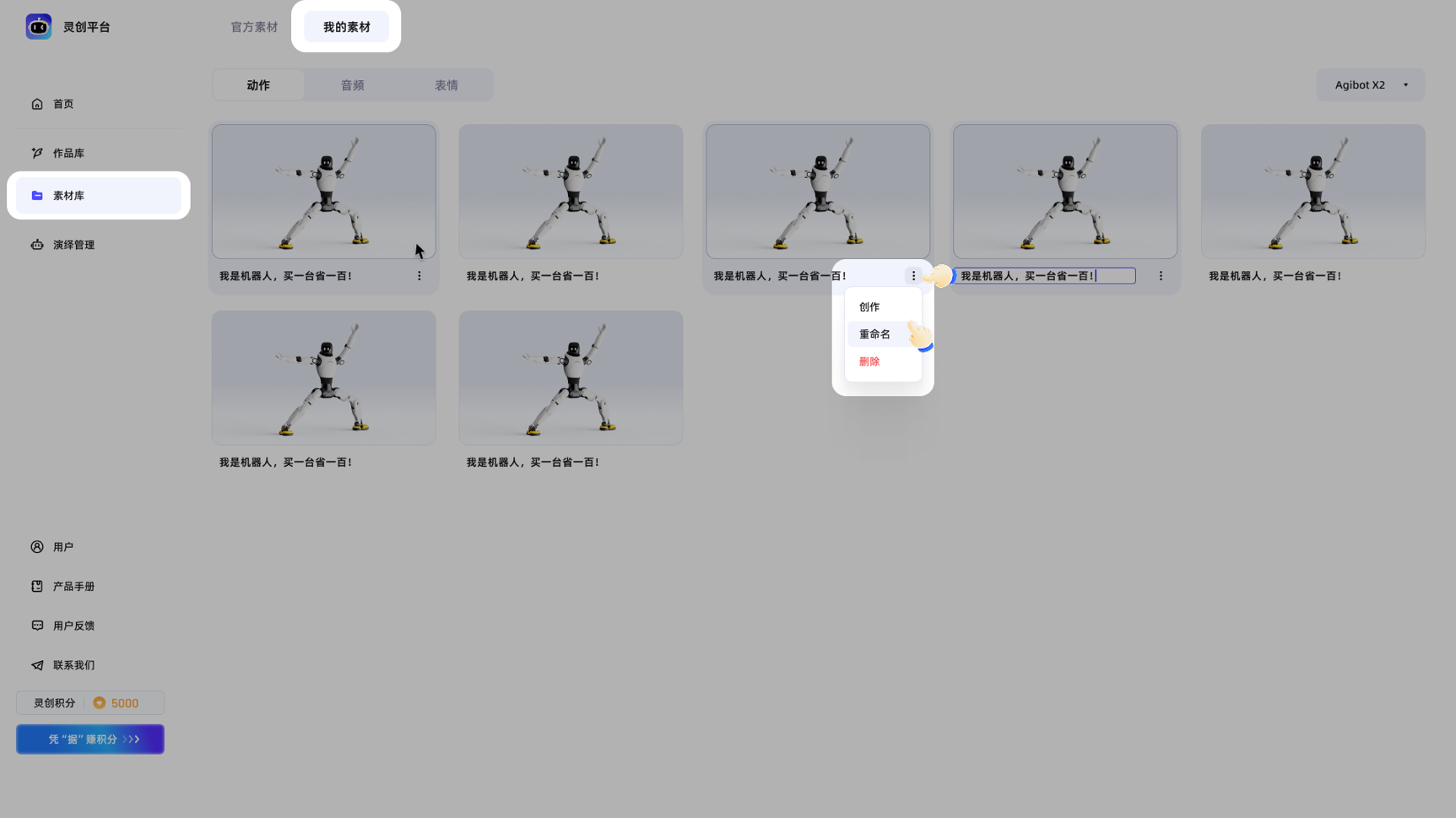

官方素材库:平台内置涵盖11类场景的180套标准化动作模板和140套表情模板。用户可直接调用这些模板参与创作,无需从零建模。这种"模板化"的设计思路类似于视频剪辑软件中的预设效果,大大降低了入门门槛。

动作模仿模式:这是平台最具技术含量的功能。用户上传一段人类动作视频后,系统会自动识别人体姿态并转换为机器人可执行的动作脚本。普通模式适用于上肢和原地动作,要求视频中下半身站立、双脚不离地;Pro模式则支持高精度、高动态的全身动作捕捉,能够处理更复杂的动作序列。

音频编排与语音合成:用户可以输入文本生成语音,或上传已有音频文件。系统会自动识别语义内容并匹配相应的动作与表情,实现语音内容与机器人表演的同步。这一功能的技术基础是多模态语义理解和动作-语义映射算法。

动作混剪与故事线编排:平台支持多段动作的自由拼接和顺滑过渡,用户可以将多个动作组合成完整的故事或场景演出。时间轴编辑界面与主流视频剪辑软件的操作逻辑类似,便于有剪辑经验的用户快速上手。

设备联动与群控管理:平台支持多设备任务下发与同步表演,单个账号最多可绑定10台机器人,实现多台机器人的协同演绎或批量控制。这一功能对于舞台演出、活动展示等场景尤为重要。

4. 动作模仿技术的深度解析

4.1 技术原理:从视频到机器人动作的转换流程

动作模仿功能的技术实现可以分解为四个主要步骤:

姿态估计:系统首先使用计算机视觉算法从上传的视频中提取人体骨骼关键点。这一步骤的精度直接决定了最终动作的还原质量。平台要求视频分辨率不低于720P,且人物全身(头脚均完整)出现在画面中,人物比例不宜过小,这些要求都是为了保证姿态估计的准确性。

运动重定向:人体与机器人在关节配置、自由度数量、肢体比例等方面存在差异,因此需要将人体动作"翻译"为机器人可执行的关节角度序列。这一步骤需要考虑机器人的运动学约束,避免生成超出关节限位的非法姿态。

动作优化:原始的动作序列可能存在抖动、不连续等问题,需要通过滤波和平滑算法进行优化。对于Pro模式,系统还会进行基于强化学习的动作策略训练,使机器人能够更稳定地执行复杂动作。

脚本生成:最终将优化后的动作序列转换为机器人可执行的控制脚本,保存至动作素材库供后续调用。

4.2 普通模式与Pro模式的技术差异

两种模式的核心区别在于对动作复杂度的支持程度:

普通模式采用基座运控支撑的方案,适用于上肢和原地动作。由于下半身保持稳定站立,系统只需要处理上半身的动作生成,计算复杂度相对较低。这种模式的优势是生成速度快(通常1-3分钟),适合快速迭代和初学者使用。

Pro模式 采用单动作单策略训练的方案,支持高精度高动态的全身动作模仿。系统需要为每个复杂动作训练专门的运动策略,确保机器人在执行时能够保持平衡和稳定。这一过程涉及在仿真环境中的大量迭代训练,因此生成时间较长(可能需要数小时),但能够处理跳跃、转体等高难度动作。

4.3 视频上传的技术规范与原因分析

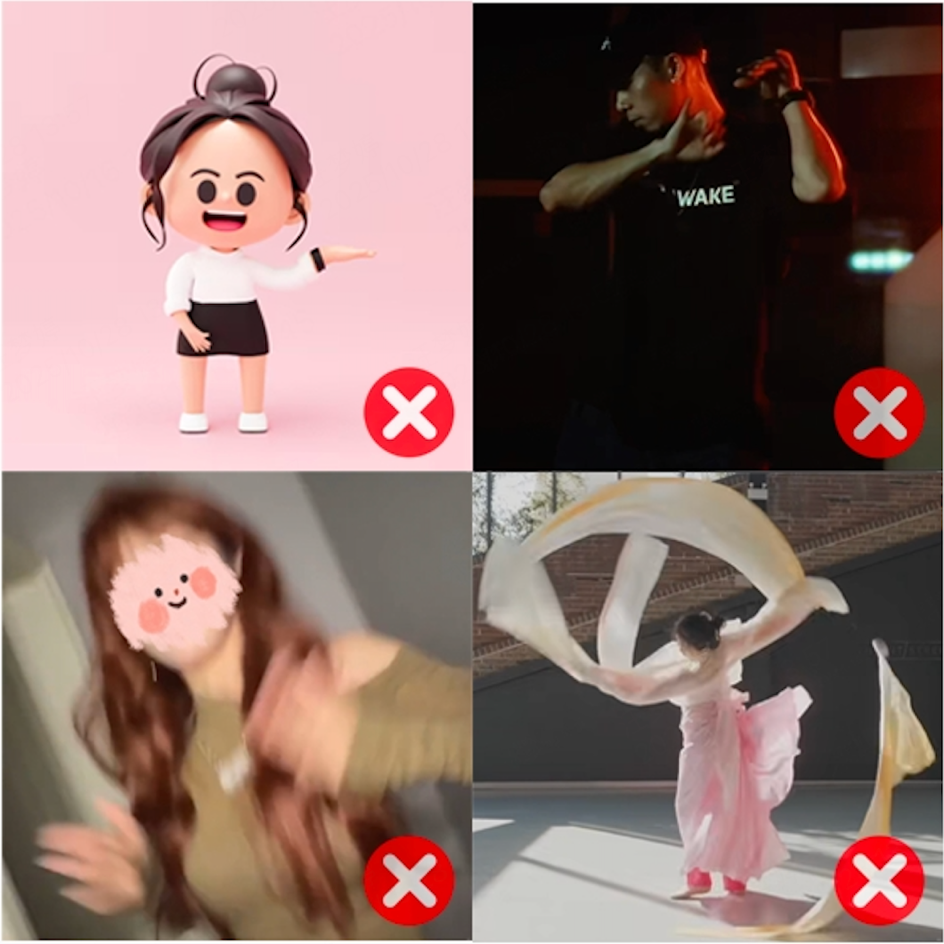

平台对上传视频提出了详细的技术规范,这些规范背后都有明确的技术原因:

清晰的背景和人物:复杂的背景可能导致人体检测算法误识别,背景与人物颜色接近时更容易出现边界模糊的问题。

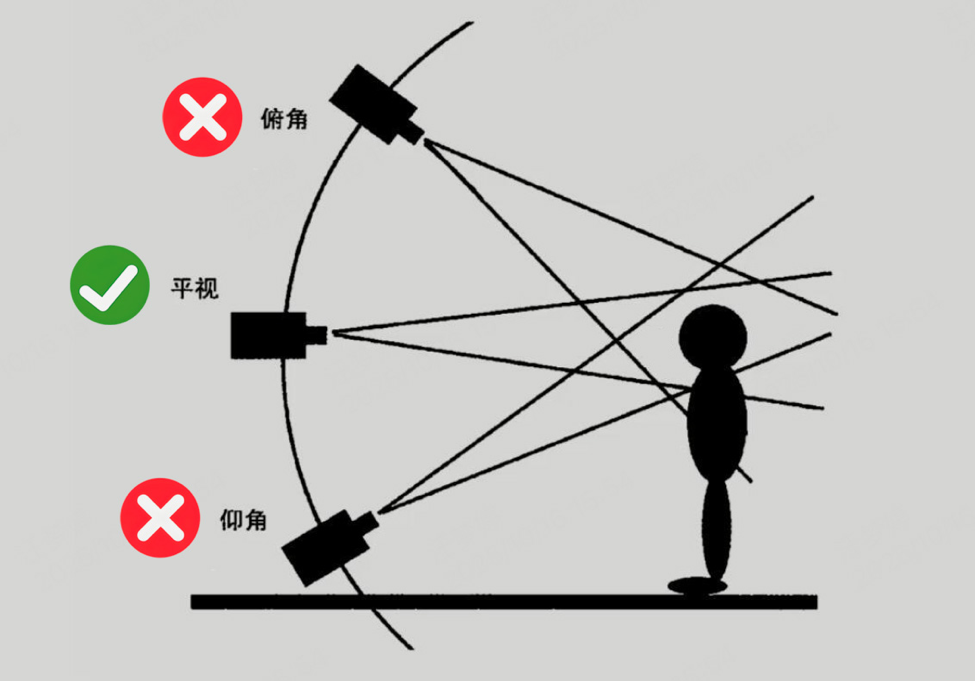

稳定的镜头:频繁的镜头切换或缩放会导致姿态估计的参考坐标系不断变化,增加重定向的难度。平视拍摄可以获得更自然的姿态捕捉效果,俯视或仰视角度会引入透视畸变。

适当的服装:长袍、宽袖等服饰会遮挡身体关键部位(如肘部、腰部),影响关键点检测的准确性。

真人视频:动漫、虚拟角色等非真人视频的骨骼结构与真人存在差异,现有的姿态估计模型主要针对真人训练,对非真人内容的泛化能力有限。

五、语音演绎功能的技术架构

5.1 语音合成与多模态融合

语音演绎功能的技术架构可以分为语音层和动作层两个部分:

语音层:用户输入文本后,系统调用语音合成(TTS)模型生成语音。平台提供多种音色(成熟男性、成熟女性等)和情绪(开心、严肃等)选项,通过调节声学参数实现不同的表达效果。用户也可以直接上传音频文件,系统会使用语音识别(ASR)技术将音频转换为文本。

动作层 :基于识别的文本内容,系统使用语义理解模型提取关键语义信息,然后通过语义-动作映射算法为每段语音匹配相应的动作和表情。这一过程可以自动完成(智能编排),也可以由用户手动指定(自由编排)。

5.2 自由编排与智能编排的使用场景

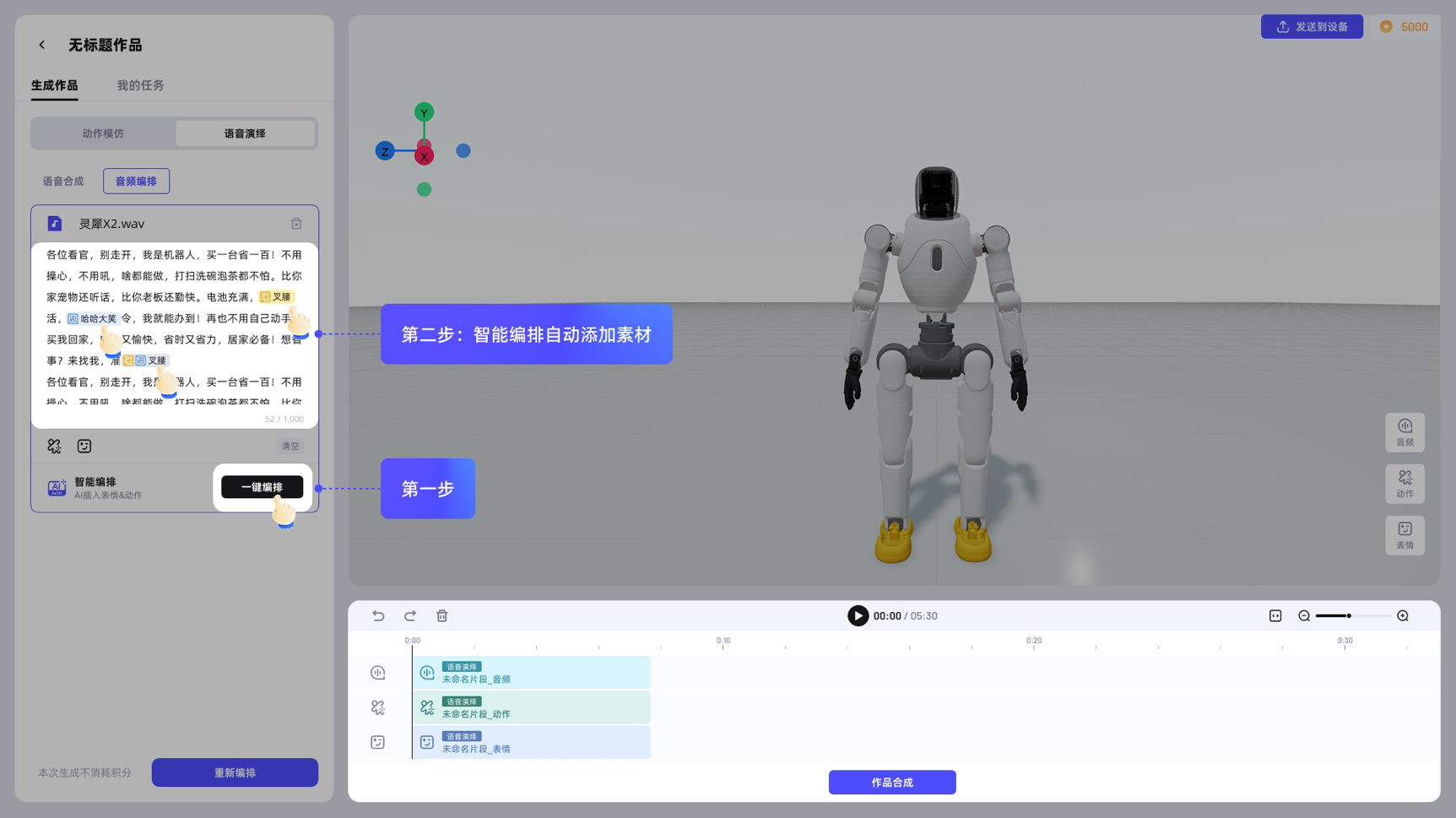

自由编排适合对最终效果有明确预期的用户。在文本编排框中,用户可以在任意位置插入动作或表情素材,实现精细化的时序控制。这种方式的优势是灵活度高,但需要用户投入更多的编辑时间。

智能编排适合希望快速产出内容的用户。系统会根据语音的语义内容自动匹配动作和表情,用户只需审核和微调即可。这种方式的技术基础是大规模语义-动作对齐数据的训练,模型能够学习到"开心时应该配合什么动作"这类隐性知识。

六、完整操作流程指南

6.1 账号注册与平台进入

第一步:访问平台

打开浏览器(推荐使用Chrome),访问 linkcraft.agibot.com

第二步:账号登录

支持手机号+验证码或邮箱+验证码两种方式,首次登录自动完成注册。当前平台处于公测阶段,新用户需先提交申请表通过审核后方可使用。

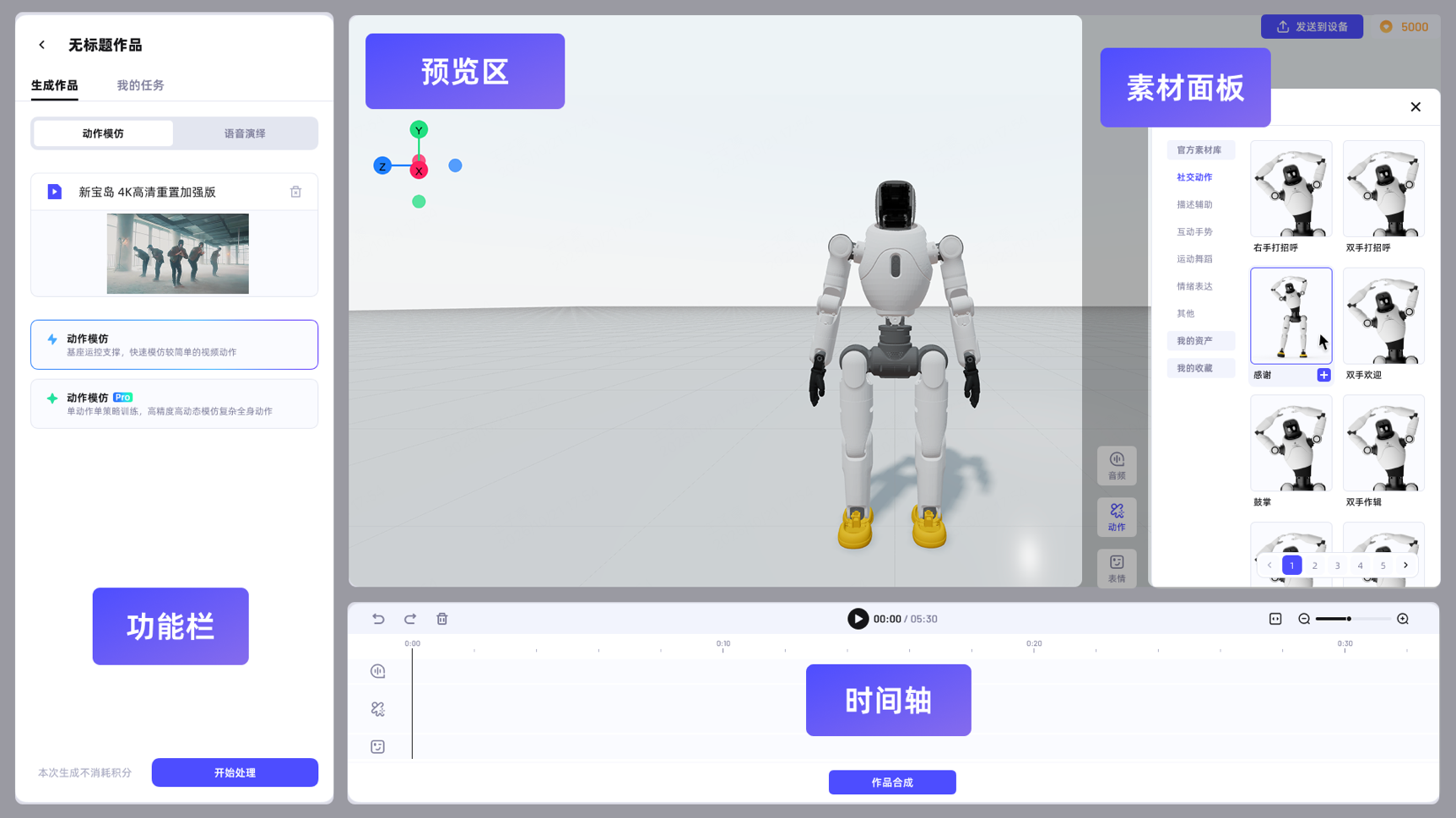

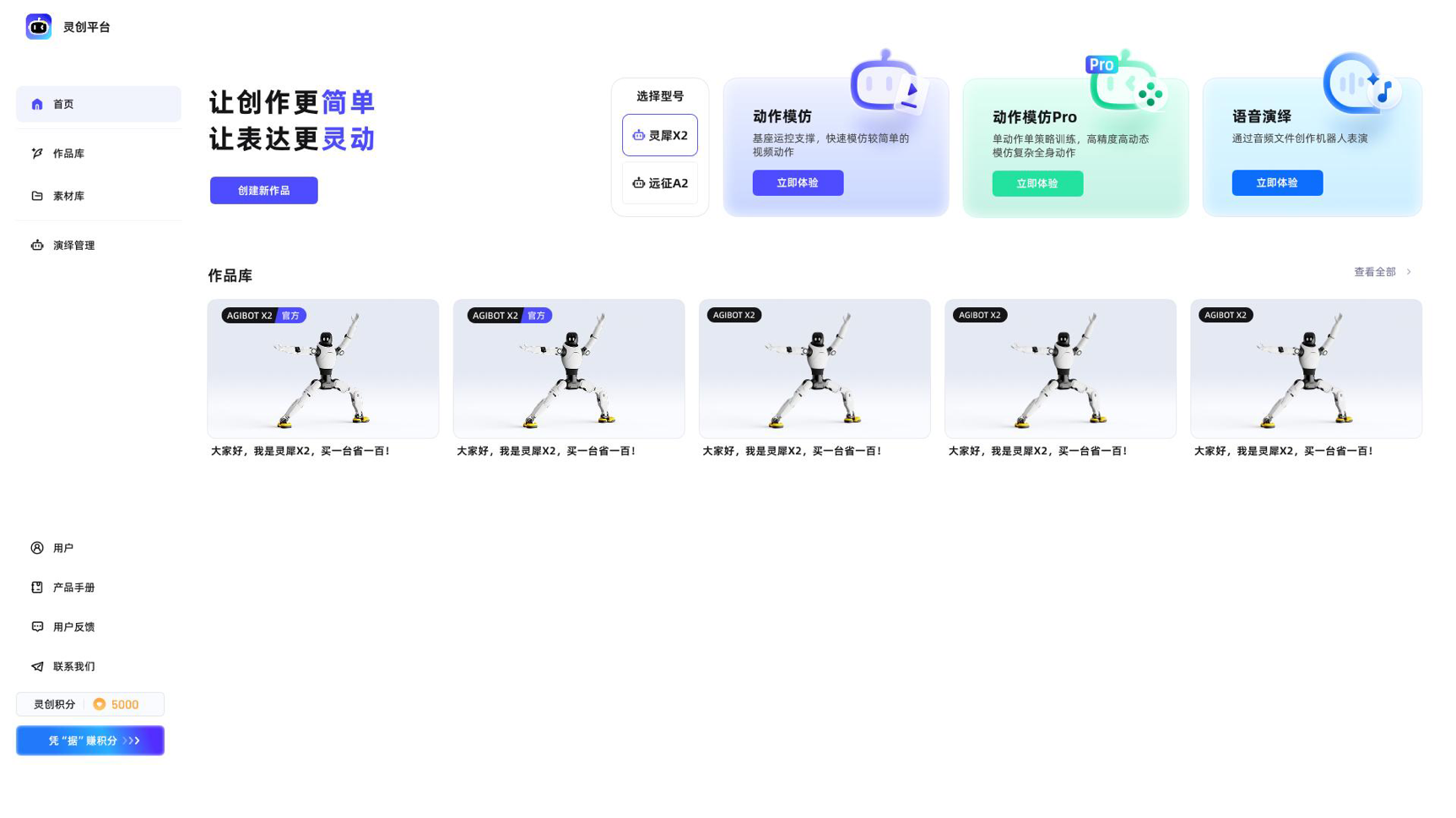

第三步:了解界面布局

进入首页后,界面分为几个主要区域:

- 创建空白作品入口

- 动作模仿/动作模仿Pro/语音演绎三个快速创作入口

- 作品库(个人作品与官方示例)

- 左侧导航栏(素材库、演绎管理等)

6.2 创作第一个作品:动作模仿流程

步骤一:进入创作页面

点击首页"动作模仿"卡片的"立即尝试"按钮,进入创作主页面。页面分为四个区域:左侧功能栏、中间预览区、右侧素材面板、底部时间轴。

步骤二:准备并上传视频

根据技术规范准备视频:分辨率不低于720P,时长建议30秒以内,人物全身可见,背景简洁,镜头稳定。在功能栏的动作模仿区域点击"拖拽至此或点击上传视频文件"。

步骤三:选择模式并生成

根据动作复杂度选择普通模式或Pro模式,点击"开始生成"。普通模式约1-3分钟完成,Pro模式可能需要数小时。生成过程中可在"我的任务"查看进度。

步骤四:编排与调整

生成完成后,动作素材会自动保存至素材库。将素材添加至时间轴,可以与其他动作、表情、音频素材组合。通过拖动调整播放顺序,在预览区实时查看效果。

步骤五:保存与发送

点击"作品生成"完成合成,系统自动保存为已完成作品。点击"发送到设备"可将作品推送至已绑定的机器人。

6.3 语音演绎创作流程

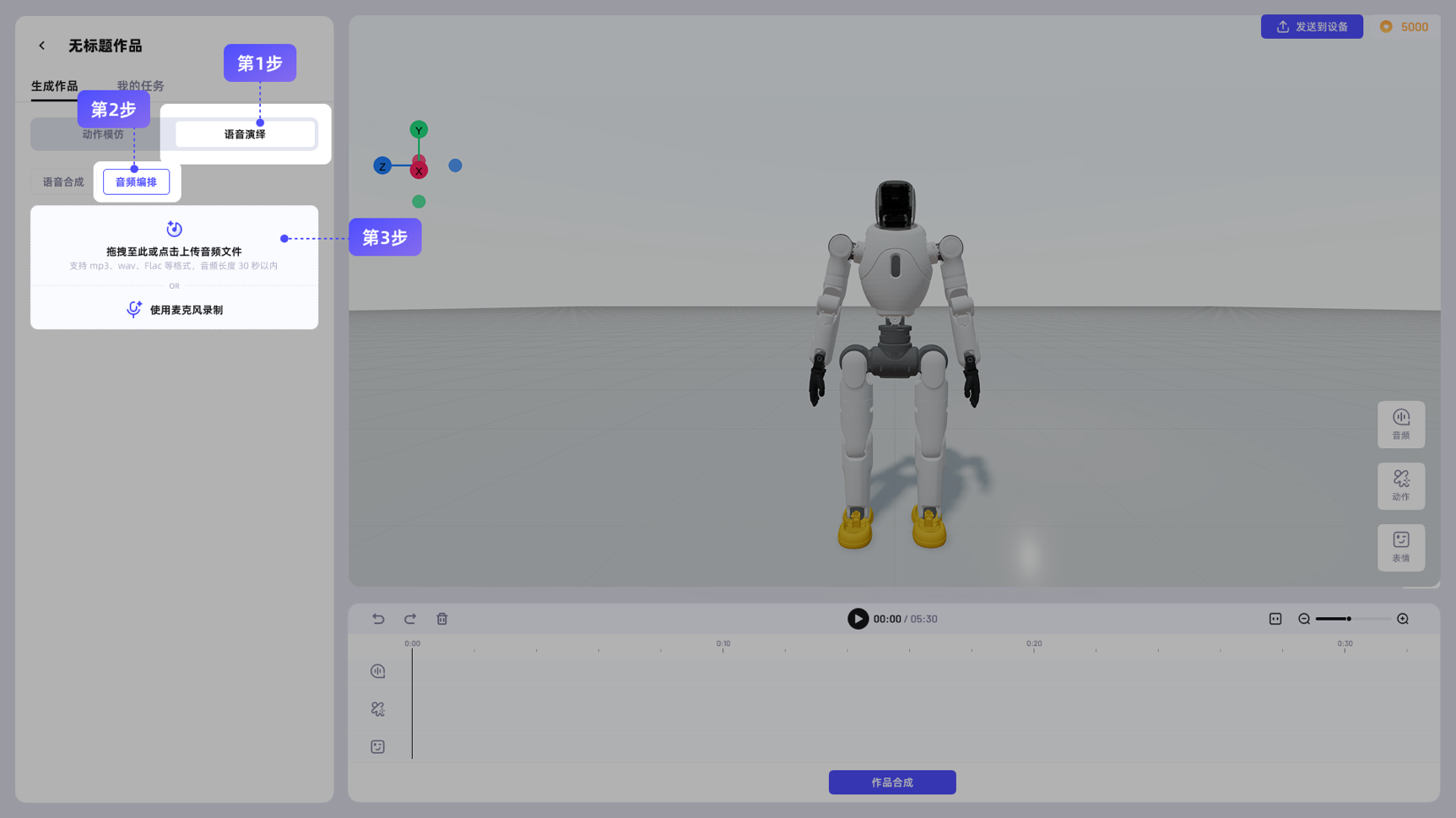

步骤一:语音准备

两种方式可选:

- 语音合成:输入文本,选择音色和情绪,点击生成

- 音频编排:上传本地音频文件(mp3/wav/flac格式,30秒以内)或使用麦克风录制

步骤二:文本识别

点击"开始识别",系统自动将音频转换为文本并保存至音频素材库。

步骤三:动作编排

在文本编排框中选择编排方式:

- 自由编排:手动在文本位置插入动作、表情素材

- 智能编排:点击"一键编排",系统自动匹配

步骤四:预览与合成

在预览区查看效果,确认无误后点击"作品合成"。

6.4 设备绑定与作品下载

设备要求

- 机器人固件版本需升级至v0.8.0及以上(通过Agibot Go App进行OTA升级)

- 当前仅支持装配假手或不带手的灵犀X2版本

- 设备需处于联网在线状态

绑定流程

进入"演绎管理"-"作品下载"页面,点击"+添加新设备",输入机器人语音播报的验证码完成绑定。单个账号最多绑定10台设备。

作品下载与播放

选择目标设备,点击"已安装作品"查看列表,或点击"下载新作品到机器人"下载新内容。播放前需将机器人切换至站立模式(通过遥控器或Agibot Go App),确保周围有足够安全空间。

6.5 群控管理配置

创建群控任务

进入"演绎管理"-"群控管理",点击"+创建新任务",输入任务名称,选择需要下发的作品和设备(最多10台),点击保存。

注意事项

- 所有参与群控的设备需处于同一局域网内

- 下发前确保所有设备满足固件版本和运行状态要求

7. 总结:机器人内容创作的新范式

灵创平台的发布代表了人形机器人产业发展的一个重要节点。它试图解决的核心问题是:如何将复杂的机器人控制技术转化为普通人可以使用的创作工具。

从技术架构上看,平台整合了计算机视觉(姿态估计)、强化学习(动作优化)、语音合成与识别、多模态语义理解等多项AI技术,形成了从视频/音频输入到机器人动作输出的完整pipeline。这种"端到端"的设计降低了用户的学习成本,但也意味着用户对中间过程的可控性有限。

从产品设计上看,平台采用了"素材库+时间轴"的编辑范式,这与主流视频剪辑软件的交互逻辑一致,有利于用户迁移已有的操作经验。积分系统的引入则为平台的长期运营和社区建设提供了基础。

从行业意义上看,灵创平台的出现可能加速人形机器人从"硬件产品"向"内容平台"的转型。当机器人内容创作的门槛足够低、效率足够高时,机器人就有可能像手机、无人机一样成为大众创作的新媒介。

对于关注人形机器人领域的读者,灵创平台提供了一个观察具身智能商业化路径的窗口。无论你是技术研究者、内容创作者还是潜在的行业从业者,理解这类平台的技术原理和产品逻辑,都有助于更好地把握这个快速发展的领域。