架构梳理和治理是针对一个现有的业务,从技术,资源 ,业务层面进行拆解及梳理 ,识别现架构中隐藏的风险及性能瓶颈 ,资源瓶颈,并根据风险进行防范与治理的质量保障动作,其核心是 "从架构层面规避风险、从治理层面控制风险、从保障层面兜底风险",通过 "系统化梳理架构风险->分层治理优化→全流程质量管控→持续验证迭代" 的闭环,实现系统从 "被动救火" 到 "主动防御" 的转型。

1、第一步:稳定性质量架构系统化梳理(摸清家底,定位风险)

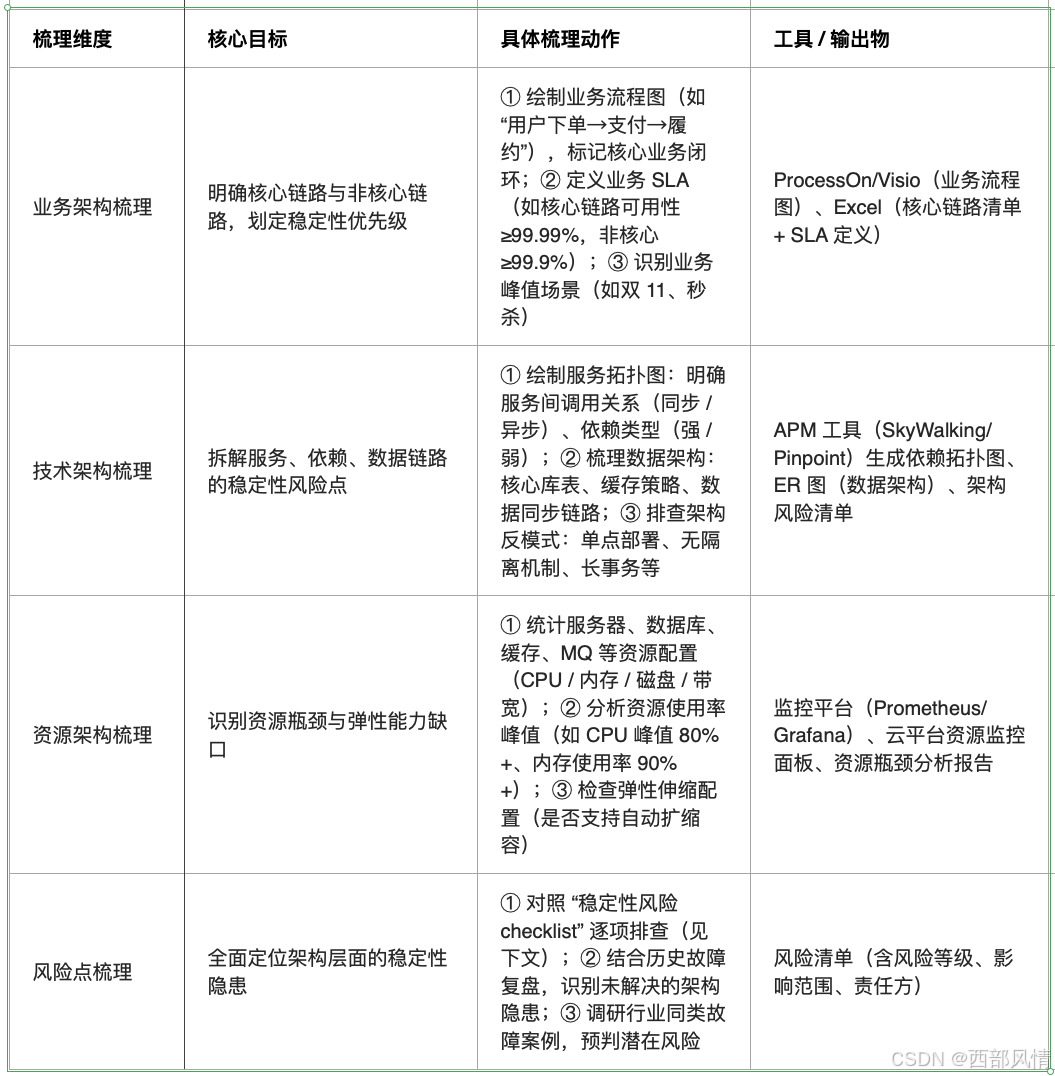

架构梳理的核心是 "穿透式拆解",覆盖业务、技术、资源三个维度,明确架构设计中的稳定性隐患(如单点依赖、无降级方案、资源瓶颈等),为治理提供精准靶点。

1.1 梳理核心维度与落地方法

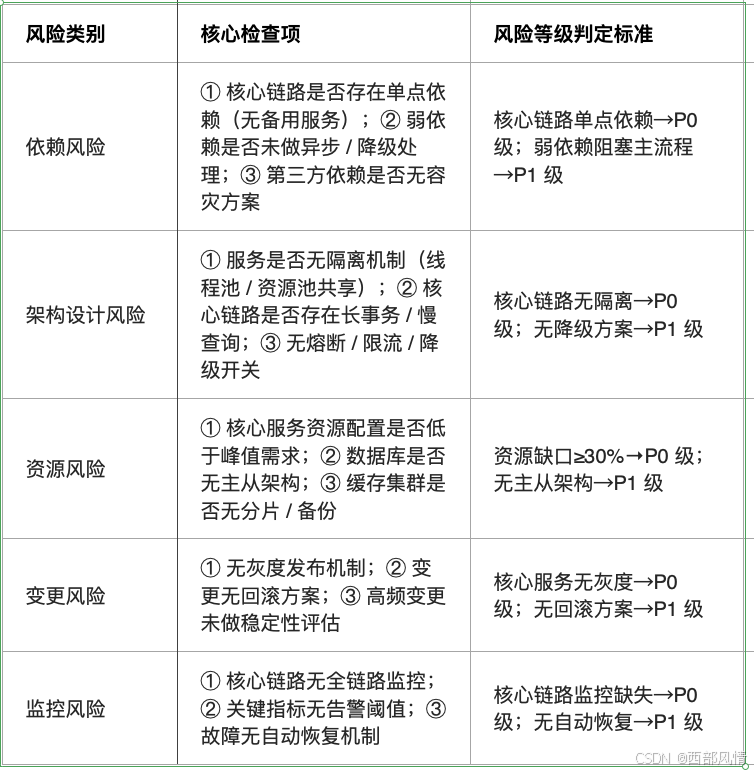

1.2 稳定性风险

2 第二步:分层架构治理优化(靶向施策,化解风险)

架构治理的核心是 "分层拆解、差异化施策",针对业务、技术、资源三层架构的风险点,落地 "核心链路加固、依赖风险隔离、资源弹性扩容、变更安全管控" 四大治理策略。

2.1 业务架构治理:聚焦核心链路,优先保障关键体验

a. 核心链路收敛

梳理 "最小可用业务集"(如电商仅保留 "下单 - 支付 - 履约" 核心流程,关闭非核心功能如营销弹窗、个性化推荐),在峰值或故障时快速切换至 "极简模式",降低系统负载。

b.业务降级策略

按 "核心→次核心→非核心" 定义降级优先级,为每个层级设计降级方案:

- 核心层(支付 / 下单):仅保留必需字段,关闭非必要校验(如非关键信息的格式校验);

- 次核心层(商品详情):返回缓存数据,关闭实时库存更新(允许短暂不一致);

- 非核心层(评论 / 分享):直接关闭功能,返回 "服务暂不可用" 提示。

c. 业务峰值管控

针对秒杀、促销等峰值场景,设计流量削峰机制(如预约报名、验证码限流、阶梯释放库存),避免瞬间流量压垮系统。

2.2 技术架构治理:从设计层面规避稳定性风险

(1)服务架构治理:隔离、熔断、降级三位一体

隔离机制落地:

- 线程池隔离:核心服务(如支付、订单)单独分配线程池,避免因非核心服务阻塞导致主流程不可用;

- 资源隔离:通过 K8s 命名空间、物理机分区,将核心服务与非核心服务隔离部署,防止资源抢占;

- 数据隔离:核心业务数据与非核心数据分库存储,敏感数据(如支付信息)单独加密存储。

熔断降级治理:

- 核心依赖:部署 Sentinel/Resilience4j,设置熔断阈值(错误率≥50%、响应时间 P95≥1s),触发后自动切换至备用依赖或返回默认值;

- 弱依赖:全部改造为异步调用(RabbitMQ/RocketMQ),设置超时时间(≤500ms),失败则静默日志,不影响主流程。

冗余容灾设计:

- 服务冗余:核心服务至少部署 3 个节点,跨可用区部署(如阿里云华东 1 区 + 华东 2 区),通过负载均衡实现故障自动切换;

- 数据容灾:核心数据库采用 "主从复制 + 异地备份" 架构,主库故障 30 秒内自动切换至从库;缓存采用 Redis 集群(主从 + 哨兵),避免单点故障。

(2)数据架构治理:保障数据一致性与可用性

读写分离

核心数据库实现读写分离,读请求路由至从库,减轻主库压力;

缓存优化

- 热点数据缓存:将高频访问数据(如商品详情、用户信息)缓存至 Redis,设置合理过期时间(避免缓存雪崩);

- 缓存降级:缓存失效时,返回本地缓存的默认数据或降级为只读模式,避免穿透至数据库;

数据一致性保障

- 分布式事务:核心业务(如订单 - 库存 - 支付)采用 TCC/SAGA 模式,非核心业务采用 "本地消息表 + MQ" 实现最终一致性;

- 数据校验:关键数据写入时做完整性、一致性校验(如订单金额与支付金额匹配),避免脏数据引发故障。

2.3 资源架构治理:弹性扩容,应对流量波动

资源扩容策略

- 垂直扩容:核心服务升级硬件配置(如 CPU 从 8 核→16 核,内存从 16G→32G),满足峰值性能需求;

- 水平扩容通过 K8s 实现自动扩缩容,基于 CPU 使用率(如阈值 70%)、QPS(如阈值 5000)触发扩容,峰值时快速增加节点;

- 资源预留:为核心服务预留 30% 以上的资源冗余,避免流量突增时资源耗尽。

资源监控与优化

- 定期分析资源使用率(CPU、内存、磁盘 IO、网络带宽),识别资源瓶颈(如数据库磁盘 IO 过高→优化索引);

- 清理无效资源(如闲置服务器、过期缓存、冗余数据),提高资源利用率。

2.4 变更架构治理:安全变更,避免故障引入

灰度发布机制

核心服务变更采用 "金丝雀发布→灰度发布→全量发布" 流程,按用户比例(1%→10%→50%→100%)逐步放量,实时监控指标,异常则快速回滚;

变更管控流程

- 变更前:提交变更申请(含风险评估、回滚方案),通过架构评审和测试验证;

- 变更中:关闭非必要功能,减少并发变更(同一核心服务单日变更≤1 次);

- 变更后:观察 15-30 分钟,确认无异常后再结束变更;

回滚机制保障

所有变更必须预留回滚方案(如代码版本回退、数据库备份恢复),回滚时间≤5 分钟。

3 第三步:全流程质量保障机制(兜底风险,确保治理效果)

架构治理后,需通过 "监控告警、故障演练、应急响应、持续迭代" 四大机制,确保架构稳定性持续达标,避免治理流于形式。

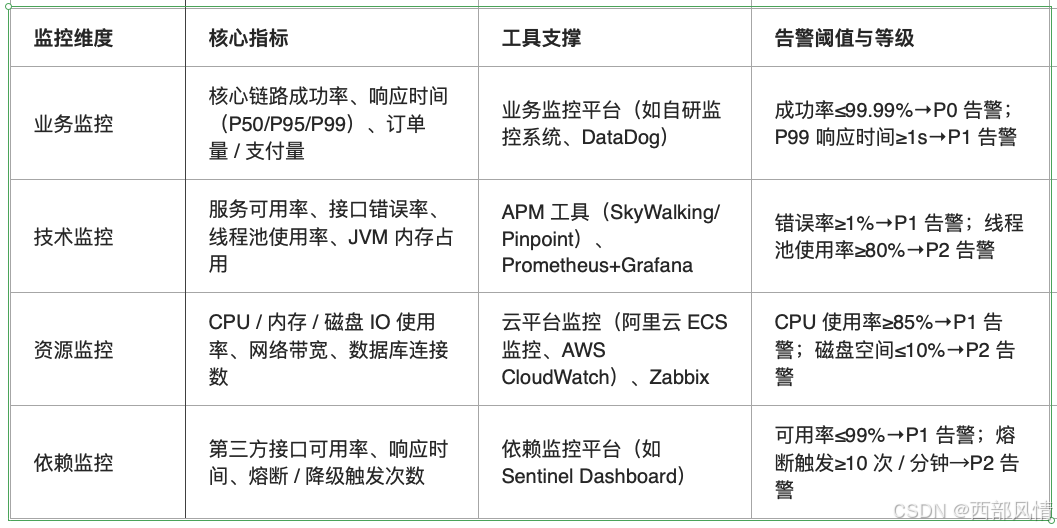

3.1 全链路监控告警:实时感知风险

监控维度全覆盖

告警机制优化

- 分级告警:按 P0(核心业务中断)、P1(核心链路波动)、P2(非核心功能异常)分级,不同等级对应不同响应渠道(P0:电话 + 短信 + 企业微信;P1:企业微信 + 邮件;P2:邮件);

- 告警降噪:合并重复告警、设置告警抑制(如主服务宕机导致的下游告警自动抑制),避免告警风暴。

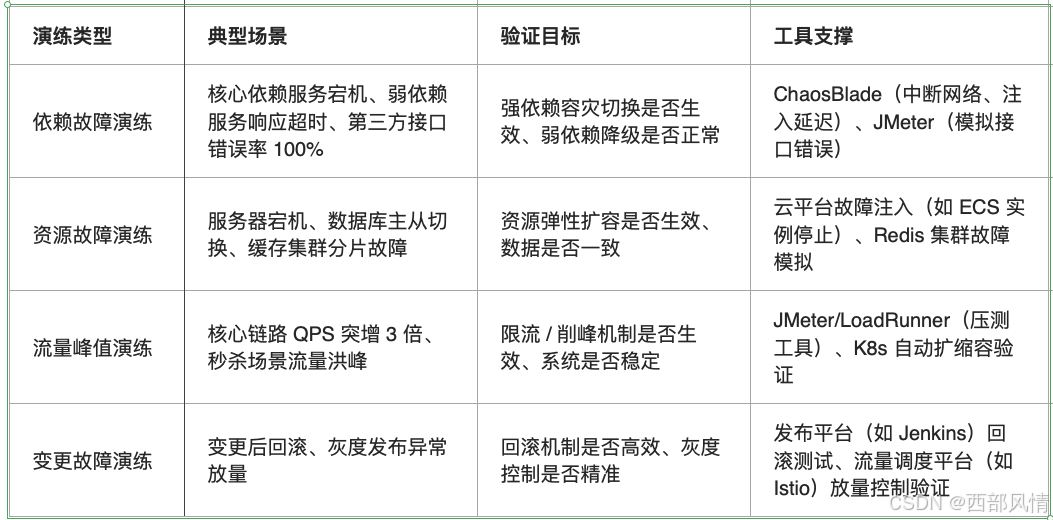

3.2 故障演练:验证架构韧性(避免 "纸上谈兵")

-

演练场景设计:聚焦架构治理的关键环节,模拟真实故障场景,验证治理效果:

-

演练流程:制定演练方案→屏蔽告警→执行演练→监控指标→恢复环境→复盘优化,频率为核心架构每季度 1-2 次,重大变更后必做 1 次。

3.3 应急响应:快速处置故障

应急响应流程

明确 "发现故障→定位根因→执行预案→恢复服务→复盘优化" 的标准化步骤,每个环节设定时间阈值(如定位根因≤10 分钟,恢复服务≤30 分钟);

应急资源准备:

-

预案库:针对常见故障(如依赖宕机、资源耗尽、缓存雪崩)制定标准化预案,明确操作步骤、责任人、工具;

-

应急团队:组建跨团队应急小组(开发、测试、SRE、业务),明确 24 小时值守机制;

-

故障复盘:所有 P0/P1 级故障必须在 24 小时内复盘,输出 "故障根因、整改措施、责任人、完成时间",并纳入架构优化清单。

3.4 持续迭代:架构稳定性常态化优化

- 定期架构评审:每季度开展 1 次全链路架构评审,结合故障复盘、业务变化(如新增功能)、技术演进(如引入新中间件),优化架构设计;

- 指标持续跟踪:建立稳定性质量看板,实时跟踪核心指标(如核心链路可用率、故障次数、回滚成功率),每月输出质量报告,识别优化空间;

- 技术债务清理:定期清理架构层面的技术债务(如老旧系统重构、冗余依赖剔除、未使用的降级开关删除),避免债务累积引发稳定性风险。

4 第四步落地保障:组织、制度、工具三位一体

4.1 组织保障:明确责任分工

成立 "稳定性架构治理专项小组":架构师(负责架构设计与优化)、开发负责人(治理落地)、测试负责人(质量验证)、SRE 负责人(监控与故障演练)、业务负责人(需求优先级与 SLA 定义),QA架构师;

建立 RACI 责任矩阵:每个架构模块、治理策略明确 "责任人、执行人、咨询人、知会人",避免责任推诿。

4.2 制度保障:纳入质量考核

制定《稳定性质量架构治理规范》:明确架构梳理、治理、监控、演练的标准流程和要求;

纳入 KPI 考核:将 "核心链路可用率≥99.99%""故障演练覆盖率 100%""变更回滚成功率 100%" 纳入团队和个人 KPI,确保治理落地。

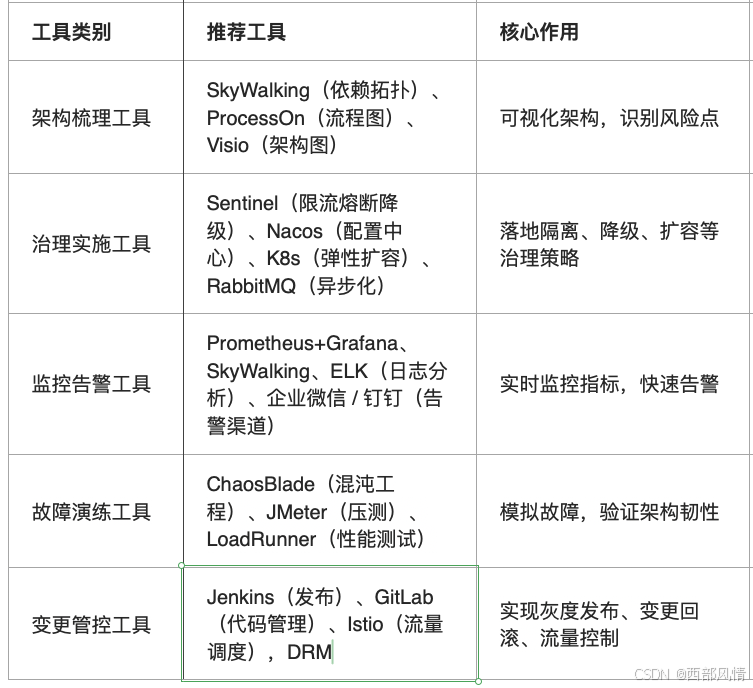

4.3 工具支撑:提升治理效率

核心工具栈推荐(开源 + 商用结合):

5 总结

稳定性质量架构的梳理与治理,核心是 "系统化梳理风险、分层化治理优化、全流程保障兜底"。落地时需遵循 "先摸清家底(梳理)→ 再靶向治理(优化)→ 后持续保障(监控 + 演练 + 应急)" 的逻辑,结合组织、制度、工具的支撑,将稳定性要求嵌入架构设计、开发、测试、发布、运维全流程。

最终目标是构建 "韧性架构"------ 即使面临流量波动、依赖故障、资源瓶颈等风险,核心业务仍能保持可用,实现从 "故障不可避免" 到 "故障可控可治" 的质量保障闭环。