前言

当前我在有网环境使用Docker的方式部署Ollama,使用Ollama部署大模型,之后导出镜像和数据在无网的内网环境使用。

拉取镜像

bash

# 拉取官方镜像

docker pull ollama:ollama运行启动容器

这一步骤需要注意的是需要设置数据挂载目录,考虑到后期连同ollama的数据一起迁移。

我的数据目录是:/data2/app/ai/ollama/data

bash

# 创建数据挂载目录

/data2/app/ai/ollama/data

# 运行启动容器

docker run -d --name ollama \

-p 11434:11434 \

-v /data2/app/ai/ollama/data:/root/.ollama \

-e OLLAMA_HOST=0.0.0.0:11434 \

--gpus=all \ # 若机器带 NVIDIA GPU

ollama/ollama:latest下载模型

执行以下命令进行下载模型

bash

# 下载模型

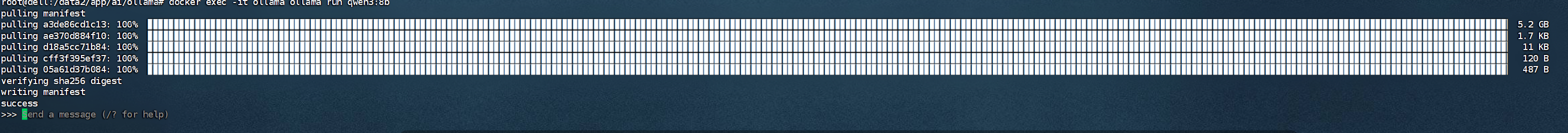

docker exec -it ollama ollama run qwen3:8b模型下载完成后,可直接使用,如下图:

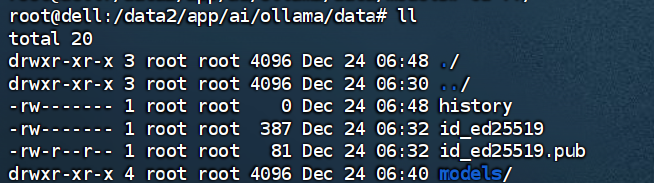

下载完确认

查看模型是否下载到自己设置的挂载目录

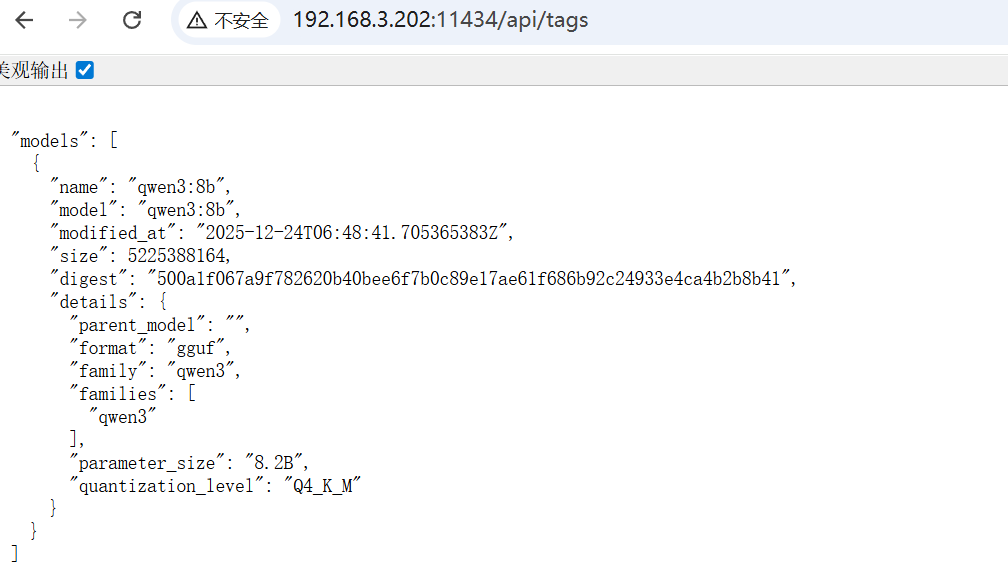

Ollama服务确认

访问地址http://[IP]:11434/api/tag,我当前的服务地址: http://192.168.3.202:11434/api/tags,如下图:

下一步将进行整体容器和数据迁移。