docker安装部署lobechat

参考lobe https://github.com/lobehub/lobe-chat/blob/main/README.zh-CN.md

docker run -d -p 3210:3210 -e OPENAI_API_KEY=sk-xxxx -e ACCESS_CODE=lobe66 --name lobe-chat lobehub/lobe-chat

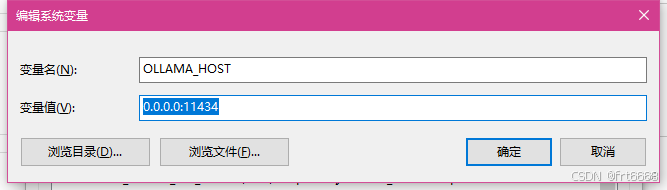

安装成功后 ollama设置环境变量

重启ollama服务,在cmd终端执行ollama serve

这样局域网其它设备也能访问ollama服务了

lobe模型设置中启用ollama

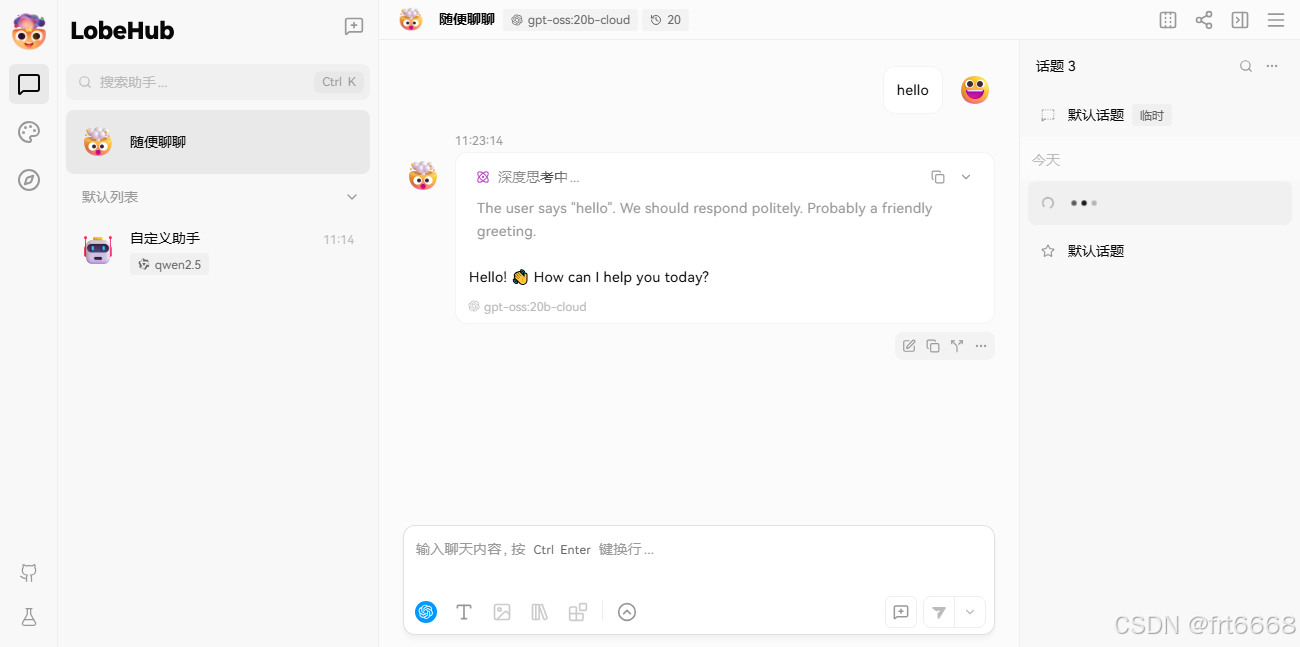

测试

成功!

PS:笔记本太辣鸡,内存也不够,qwen2几个G,调入内存后基本跑不动,一个hello几个token的简短提示词都得反应几分钟