背景与挑战 📌

在开发室内骑行应用时,最核心的需求是将用户的踏频/速度 实时映射到全景视频的播放进度上。初看这是一个简单的线性映射问题,但在实际工程中,我遇到了两个极其破坏体验的"拦路虎":

- ⚠️ 数据抖动导致的眩晕感:传感器上报的数据是离散且抖动的,直接驱动视频会导致画面剧烈顿挫,产生严重的"3D 眩晕"。

- ⚠️ 低速下的视觉卡顿:当播放倍速低于 0.3x 时(模拟爬坡或低速骑行),30fps 的视频等效帧率会降至个位数,画面变成"幻灯片"。

本文将分享如何通过控制理论(Control Theory) 算法和 WebGL 着色器(Shader) 技术,在 Web 端解决这两个问题。

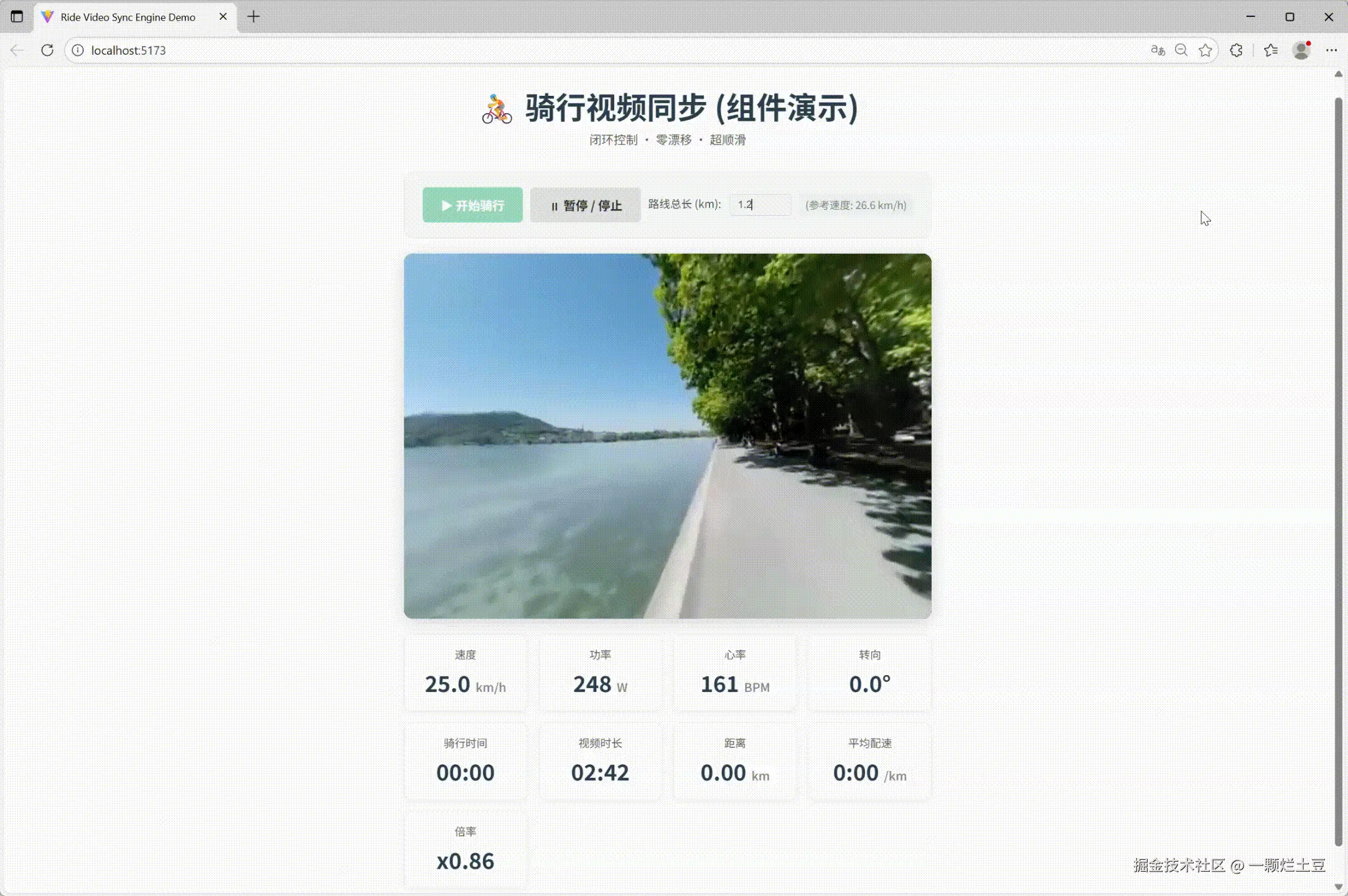

一、 核心算法:构建"超平滑"同步引擎 🔄

直接修改 video.playbackRate 是无法获得良好体验的。我们需要在传感器数据和视频播放器之间,构建一个中间层------UltraSmoothRideSync。

它的核心职责不再是简单的"传值",而是模拟一个具备物理惯性的运动系统。

1. 建立基准模型(Base Rate)📏

首先,我们需要一个锚点来连接"虚拟"与"现实"。

假设视频拍摄时的平均速度是 V_rec,总时长 T,总路程 S。

则基准倍速系数 BaseRate = T / S。

这意味着:目标倍速 = 用户当前速度 × BaseRate。

2. 引入闭环控制:漂移校正(Drift Correction)🎯

单纯的速度映射是"开环控制",时间久了必然产生积分误差(里程漂移)。用户骑行了 5km,视频可能只播放了 4.8km。

为了解决这个问题,我引入了类似 PID 控制 中的 P(比例)环节来消除误差。

以下是核心同步逻辑的代码实现:

💻 核心代码:闭环控制逻辑

js

// src/ride-player-sdk/engine/core.ts

public processRideData(timestamp: number, speed: number): void {

// ... 前置数据清洗 ...

// 1. 计算理论应达到的时间点 (Target Time)

// accumulatedDistance 是根据用户历史速度积分算出的理论里程

const expectedTime = this.accumulatedDistance * this.baseRate;

// 2. 获取实际播放时间 (Process Variable)

const actualTime = this.player.getCurrentTime();

// 3. 计算漂移误差 (Error)

// drift > 0 表示视频播快了,drift < 0 表示视频播慢了

this.currentDrift = actualTime - expectedTime;

// 4. 计算基础目标倍速

let targetRate = effectiveSpeed * this.baseRate;

// 5. 负反馈调节 (Correction)

// 引入 P 控制器,根据误差反向微调倍速

const Kp = 0.5;

const correction = -this.currentDrift * Kp;

// 限制校正幅度,防止倍速突变

const maxCorrection = 0.8;

const clampedCorrection = Math.max(-maxCorrection, Math.min(correction, maxCorrection));

targetRate += clampedCorrection;

// 6. 最终倍速限制

const clampedRate = Math.max(this.minRate, Math.min(targetRate, this.maxRate));

// ... GSAP 平滑处理 ...

}通过这个闭环系统,无论用户的速度如何波动,视频的累积播放里程 始终会收敛于用户的实际骑行里程。

3. 惯性平滑(Inertia Simulation)⚡

为了消除传感器数据的噪点,不能直接应用 targetRate。

我使用了 GSAP 库来对倍速变化进行插值处理。这本质上是一个低通滤波器,它过滤掉了高频的抖动信号,保留了速度变化的趋势,模拟出真实的物理惯性。

💻 核心代码:惯性平滑逻辑

js

// src/ride-player-sdk/engine/core.ts

// 根据速度变化幅度动态计算过渡时间

// 模拟物理惯性:急停要快,缓加速要慢

const rateDiff = Math.abs(clampedRate - this.currentRate);

let duration = 0.5;

if (rateDiff > 1.0) {

duration = 0.8; // 大幅变化平滑过渡

} else if (rateDiff < 0.1) {

duration = 0.2; // 微小变化快速响应

}

// 使用 GSAP 更新倍速

gsap.to(this, {

currentRate: clampedRate,

duration: duration,

ease: "power2.out", // 缓出曲线

overwrite: true,

onUpdate: () => {

this.player.setPlaybackRate(this.currentRate);

}

});二、 渲染优化:基于 Shader 的帧插值 🎨

解决了速度同步,下一个难题是低速下的流畅度 。

当倍速为 0.2x 时,原视频帧率不足。传统的解决思路是使用光流法(Optical Flow)生成中间帧,但在浏览器端实时计算光流开销太大。

我采用了一种性价比极高的方案:基于 WebGL 的帧混合(Frame Blending) 。

1. FBO 双缓冲架构 🖼️

在 ThreeScene.vue 中,我利用 Three.js 的 WebGLRenderTarget (FBO) 实现了一个双缓冲系统:

- Buffer A (Current) : 实时渲染视频的当前帧。

- Buffer B (Last) : 缓存上一帧的纹理。

2. 自定义片元着色器 (Fragment Shader) 🔍

通过自定义 ShaderMaterial,我们将这一帧和上一帧传入 GPU,并根据时间增量计算混合比例。

💻 核心代码:片元着色器实现

js

// src/ride-player-sdk/ThreeScene.vue

shaderMaterial = new THREE.ShaderMaterial({

uniforms: {

uCurrentFrame: { value: texture },

uLastFrame: { value: lastFrameTarget?.texture },

uMixRatio: { value: 0.0 } // 0 = 上一帧, 1 = 当前帧

},

vertexShader: `

varying vec2 vUv;

void main() {

vUv = uv;

gl_Position = projectionMatrix * modelViewMatrix * vec4(position, 1.0);

}

`,

fragmentShader: `

uniform sampler2D uCurrentFrame;

uniform sampler2D uLastFrame;

uniform float uMixRatio;

varying vec2 vUv;

// 简单的线性混合 (Linear Interpolation)

// 视觉效果类似动态模糊 (Motion Blur),能有效掩盖低帧率卡顿

void main() {

vec4 tex1 = texture2D(uLastFrame, vUv);

vec4 tex2 = texture2D(uCurrentFrame, vUv);

gl_FragColor = mix(tex1, tex2, uMixRatio);

}

`,

side: THREE.DoubleSide

});3. 时间驱动的渲染循环 🔄

关键在于,uMixRatio 的更新不依赖视频的帧更新,而是依赖 requestAnimationFrame 的时间增量(Delta Time)。

💻 核心代码:渲染循环逻辑

js

// src/ride-player-sdk/ThreeScene.vue

function animate() {

// ...

// 检查视频帧是否更新

if (video.currentTime !== lastVideoTime) {

// 检测到新帧,重置过渡进度

transitionProgress = 0.0;

lastVideoTime = video.currentTime;

}

// 核心逻辑:基于时间推进混合进度

// transitionDuration 为过渡时长 (如 0.15s)

// 即使视频本身不动,渲染循环依然在计算中间态

if (transitionProgress < 1.0) {

transitionProgress += delta / transitionDuration;

if (transitionProgress > 1.0) transitionProgress = 1.0;

}

shaderMaterial.uniforms.uMixRatio.value = transitionProgress;

// 1. 渲染主场景

renderer.setRenderTarget(null);

renderer.render(scene, camera);

// 2. 更新 'LastFrame' FBO (为下一帧做准备)

if (transitionProgress >= 1.0) {

renderer.setRenderTarget(lastFrameTarget);

renderer.render(copyScene, copyCamera); // 将当前帧复制到 FBO

renderer.setRenderTarget(null);

}

}即使视频每秒只跳动 5 次,Shader 依然会以 60fps 的频率,在这一帧和下一帧之间计算出平滑的过渡态。虽然这只是像素级的 Alpha Blending,但在全景视频的运动场景中,它能极好地骗过人眼,将"卡顿"转化为"动态模糊(Motion Blur)"般的流畅感。

三、 总结 📝

这个项目的核心价值在于展示了前端工程能力的边界拓展:

- 🚀 从"UI 开发"到"算法实现" :前端不仅仅是写界面,通过引入控制理论,我们可以解决复杂的物理同步问题。

- 🚀 从"调用 API"到"图形学编程" :通过 Shader 深入 GPU 渲染管线,我们能以极低的成本解决传统 API 无法解决的性能/体验瓶颈。

最终,我们用不到 500 行的核心代码,在 Web 端实现了一个接近原生 3A 游戏体验的骑行播放器。